WebWatcher y el nuevo paradigma de agentes de investigación multimodal

En el ámbito de los agentes inteligentes capaces de navegar la web, ejecutar razonamientos complejos y coordinar acciones con múltiples herramientas, el paper WebWatcher representa una inflexión clave. No es solo otro intento de crear un navegador potenciado por IA, sino una propuesta integral para una nueva generación de agentes que no se limitan a leer o buscar, sino que ven, infieren, prueban, actúan y optimizan sus decisiones. El enfoque que propone este trabajo del Tongyi Lab, filial de Alibaba, combina de forma estratégica componentes que hasta ahora aparecían fragmentados: visión por computadora, comprensión de lenguaje, planificación jerárquica, búsqueda en internet, lectura visual y textual, ejecución de código y aprendizaje por refuerzo.

Desde el inicio, los autores dejan en claro que la ambición es profunda. No se trata de hacer más eficiente la lectura web, ni de agregar visión a modelos lingüísticos como extensión secundaria. Se trata de redefinir lo que significa investigar en la web, en un entorno donde la información no es solo textual, sino visual, estructurada, contextual y dinámica. En ese sentido, WebWatcher no es solo un sistema. Es, en rigor, una hipótesis tecnológica sobre cómo podrían operar los agentes del futuro que estudian, exploran y resuelven problemas complejos en entornos abiertos.

Un agente que observa, piensa y actúa en la web real

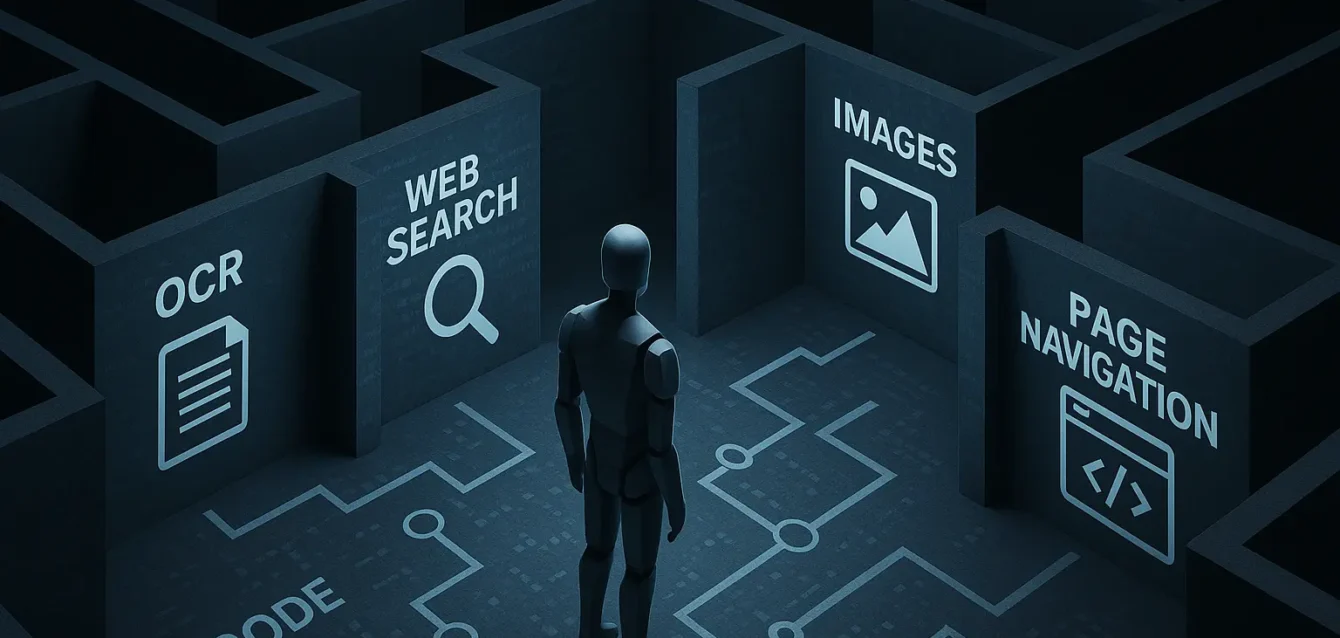

El agente WebWatcher combina una arquitectura de planificación con herramientas explícitas que le permiten navegar, ejecutar y razonar en entornos abiertos. Estas herramientas son cinco, cada una integrada como un módulo autónomo que puede ser invocado por el modelo central según la planificación del agente:

-

Búsqueda de texto web: el agente puede realizar queries y analizar los resultados devueltos por motores de búsqueda.

-

Búsqueda de imágenes: permite realizar búsquedas visuales y utilizar imágenes reales como contexto informativo.

-

Visita de páginas web: habilita una lectura atenta y selectiva de contenidos específicos.

-

Ejecución de código: una herramienta crítica para tareas que requieren cálculos, procesamiento numérico o validación mediante scripts.

-

OCR (reconocimiento óptico de caracteres): imprescindible para extraer información de imágenes complejas como gráficos o diagramas.

Este conjunto convierte a WebWatcher en un agente verdaderamente multimodal, pero además multiactivo: no solo observa y comprende, sino que decide qué herramientas usar, en qué secuencia, y cómo combinar los resultados para generar respuestas útiles.

Entrenamiento desde tareas sintéticas realistas

Uno de los grandes méritos del paper es su aproximación innovadora al entrenamiento. A diferencia de otros enfoques que usan datasets estáticos o tareas simplificadas, WebWatcher se entrena en lo que podríamos llamar tareas sintéticas realistas. Los investigadores diseñan un pipeline donde recorren sitios reales (como Wikipedia, Reddit, foros técnicos, etc.), extraen entidades clave y enmascaran parte de la información para forzar al modelo a razonar. Luego, emparejan esas preguntas con imágenes relacionadas, aplican filtros automáticos y humanos para asegurar relevancia, y construyen así ejemplos complejos que simulan desafíos de investigación genuina.

Este enfoque genera un corpus más exigente, más diverso y más alineado con las necesidades reales de los agentes de razonamiento profundo. Además, permite escalar el entrenamiento sin depender exclusivamente de datasets humanos, lo que resuelve el cuello de botella habitual en estos modelos.

ReAct como base y GRPO como refuerzo

El modelo sigue un enfoque dual de entrenamiento. Primero, se aplica supervised fine tuning (SFT) con trazas generadas bajo el esquema ReAct: think → act → observe. Esta metodología, introducida originalmente para modelos que aprenden a razonar en pasos, permite enseñar al agente cómo pensar en términos de acciones, cómo decidir el siguiente paso, y cómo observar el resultado para ajustar su comportamiento.

Luego, WebWatcher se entrena con Group Relative Policy Optimization (GRPO), una técnica de aprendizaje por refuerzo que compara diferentes trayectorias de acción y selecciona aquellas que obtienen mejores recompensas. A diferencia de otros enfoques, GRPO no evalúa solo acciones individuales, sino secuencias completas, lo que resulta más adecuado para entornos donde el éxito depende de una planificación acertada a largo plazo.

Sin embargo, el aprendizaje por refuerzo no funciona por sí solo. El paper muestra claramente que si no hay una base sólida construida con SFT, GRPO fracasa. Este hallazgo es relevante porque confirma que, en entornos multimodales, el aprendizaje profundo requiere fases progresivas, donde cada capa construye sobre cimientos estables.

BrowseComp-VL: benchmark de navegación y visión profunda

Para medir el rendimiento de WebWatcher, los autores crean un benchmark propio llamado BrowseComp-VL. Este benchmark simula tareas de navegación en páginas web reales que requieren razonamiento visual y textual simultáneo. Los ejemplos están divididos en dos niveles:

-

Nivel 1: Las entidades clave están explícitamente nombradas, pero requieren razonamiento multihop para ser utilizadas correctamente.

-

Nivel 2: Las entidades están ocultas o difuminadas, por lo que el agente debe deducirlas a partir del contexto y de pistas indirectas.

Este benchmark resulta más exigente que otros estándares como MMSearch o LiveVQA, ya que obliga al modelo a planificar, inferir y verificar en contextos ambiguos. El desempeño de WebWatcher en este entorno es notable, superando ampliamente a modelos como GPT-4o y agentes especializados como OmniSearch.

Resultados que marcan una diferencia

En los benchmarks presentados, WebWatcher logra cifras sobresalientes:

-

LiveVQA: 58.7% pass@1 (respuestas correctas al primer intento)

-

MMSearch: 55.3%

-

BrowseComp-VL: 27.0%

-

HLE-VL: 13.6%

Estas cifras son especialmente relevantes porque no solo muestran precisión, sino adaptabilidad. El agente logra buenos resultados en tareas diversas, que requieren distintos grados de razonamiento visual, planificación, búsqueda o ejecución de código. El análisis interno revela, además, que el uso de herramientas varía dinámicamente según el benchmark. Por ejemplo, en LiveVQA y MMSearch predomina la búsqueda visual, mientras que en BrowseComp-VL el agente privilegia lectura textual y planificación por pasos.

Limitaciones y posibilidades de expansión

El paper reconoce algunas limitaciones actuales del sistema:

-

La escalabilidad hacia entornos web dinámicos y en tiempo real aún es limitada. WebWatcher funciona bien en entornos conocidos o semi-estructurados, pero necesita mejoras para adaptarse a sitios altamente interactivos o con comportamiento no determinista.

-

El uso de herramientas externas depende de APIs y mecanismos controlados. En contextos abiertos o con restricciones de acceso, la eficacia puede disminuir.

-

No se ha explorado aún la capacidad del agente para tareas de largo alcance, como síntesis de múltiples fuentes dispares o comparación crítica de argumentos.

A pesar de esto, el potencial de expansión es claro. WebWatcher podría integrarse con sistemas como LangChain, AgentScope o incluso entornos de razonamiento matemático para tareas avanzadas. También podría servir como asistente académico, lector automatizado de papers, o explorador de datasets abiertos.

Reflexión final: el verdadero comienzo de la investigación autónoma

El desarrollo de WebWatcher marca un punto de inflexión. Ya no estamos ante modelos que simplemente generan texto a partir de una prompt, sino ante sistemas capaces de ejecutar investigaciones estructuradas en entornos visuales y textuales reales. Es un paso decisivo hacia agentes científicos, asesores legales automatizados, curadores de información o incluso diseñadores de experimentos computacionales.

Lo más valioso del paper es su enfoque integral. No se limita a mostrar buenos resultados, sino que construye una arquitectura coherente, un sistema de entrenamiento riguroso y un conjunto de herramientas conectadas que reflejan cómo podría trabajar un investigador humano: mirar, pensar, buscar, probar, corregir y concluir.

WebWatcher no es perfecto, pero representa un arquetipo emergente. Uno que combina visión, lenguaje y acción como partes inseparables de un nuevo paradigma cognitivo artificial.