En la frontera más avanzada de la inteligencia artificial, donde los grandes modelos de lenguaje (LLMs) ya no son meros prototipos sino componentes centrales de sistemas complejos, emerge un problema fundamental y hasta ahora subestimado: ¿cómo podemos medir con precisión el rendimiento de una máquina que evalúa a otra?

Este es el núcleo del desafío que enfrenta la comunidad científica. La investigación tradicional en recuperación de información se basaba en métricas que asumían implícitamente que el consumidor final era un ser humano, con sus propias limitaciones cognitivas y patrones de comportamiento. Sin embargo, en el paradigma de la Generación Aumentada por Recuperación (RAG), el "consumidor" es otro modelo de lenguaje, lo que introduce una profunda desalineación entre las herramientas de evaluación disponibles y la realidad del sistema.

El problema se intensifica cuando utilizamos precisamente los mismos LLMs para juzgar el trabajo de otros sistemas RAG. Un estudio reciente revela una preocupante tendencia: los LLMs jueces muestran un sesgo significativo hacia los rankers (clasificadores de documentos) también construidos sobre LLMs. En experimentos realizados con conjuntos de datos estándar, los investigadores descubrieron que los jueces basados en LLMs tendían a otorgar puntuaciones más altas a los sistemas de recuperación impulsados por LLMs, distorsionando así su verdadero rendimiento.

Esta preferencia no es arbitraria; parece estar motivada por una comprensión compartida de ciertos patrones o características internas de los sistemas de generación, algo que un juicio puramente superficial, orientado al usuario final, no podría capturar. Además, los LLMs jueces han demostrado ser más indulgentes que los humanos en general, pero también tienen una capacidad limitada para distinguir sutiles diferencias en el rendimiento entre sistemas de alto nivel, lo que dificulta la identificación de las mejoras incrementales que son cruciales en la optimización de la IA.

La magnitud de este problema fue destacada públicamente por Demis Hassabis, CEO de Google DeepMind, quien enfatizó la necesidad imperiosa de evaluaciones rigurosas y benchmarks robustos para garantizar la fiabilidad y seguridad de los sistemas de IA modernos.

Hassabis señaló que actualmente no existen suficientes pruebas empíricas estandarizadas, lo que crea un vacío crítico en el desarrollo de estas tecnologías. Este comentario no es una simple observación técnica; es una declaración estratégica que reconoce que sin una forma fiable de medir el progreso, el avance de la IA corre el riesgo de convertirse en un ejercicio de autoconvencimiento, donde los equipos pueden engañarse a sí mismos sobre la efectividad real de sus innovaciones. La dependencia de métricas obsoletas o inadecuadas puede llevar a decisiones erróneas, desperdiciar recursos computacionales y, en última instancia, entregar productos que funcionan bien en laboratorio pero fallan en el mundo real.

Para abordar esta crisis de la medición, la comunidad está explorando nuevas vías. Una de ellas es el uso de múltiples LLMs como jueces para mitigar el sesgo individual, aunque esto no elimina la raíz del problema: la falta de alineación conceptual entre la métrica y el sistema evaluado. Otra línea de investigación, como eRAG, intenta una aproximación más pragmática. En lugar de usar un LLM como juez abstracto, eRAG evalúa cada documento recuperado directamente mediante el propio motor de generación del sistema RAG, midiendo cómo contribuye a la tarea final deseada, como obtener una respuesta exacta o un alto puntaje de ROUGE.

Tal metodología muestra una correlación mucho mayor con el rendimiento final del sistema en comparación con las evaluaciones tradicionales, y lo hace de manera extremadamente eficiente. Aunque representativa del espíritu innovador en la materia, eRAG sigue operando dentro de un marco de evaluación indirecta. Su éxito subraya que la única medida verdaderamente justa del valor de un documento recuperado es su impacto en la calidad de la salida final del sistema. Esto lleva a la pregunta inevitable: si la meta es mejorar la respuesta final, ¿no sería más directo y preciso diseñar una métrica que mida ese objetivo último desde el principio? Es esta línea de razonamiento la que da origen a UDCG, una métrica concebida explícitamente para esta nueva era.

El gran salto metodológico: Introducción a la métrica UDCG y su fundamento conceptual

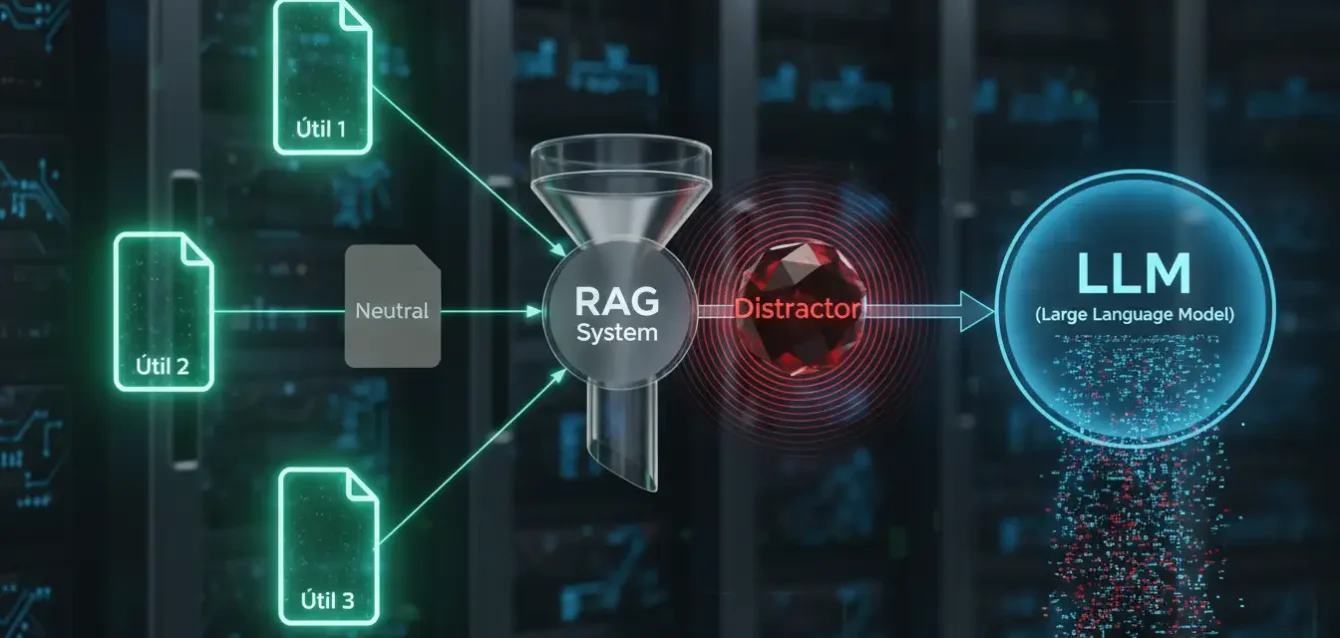

Frente a la creciente evidencia de que las viejas reglas de la evaluación están fallando, un grupo de investigadores liderados por Giovanni Trappolini ha lanzado una llamada de atención que promete cambiar por completo la forma en que se evalúan los sistemas RAG. Su trabajo, titulado "Redefining Retrieval Evaluation in the Era of LLMs", introduce una nueva métrica radical: UDCG (Ganancia Acumulada Consciente de Utilidad y Distracción). Esta no es una simple modificación de una métrica existente; representa un salto conceptual que cuestiona las bases mismas sobre las que se construyeron las evaluaciones de recuperación de información durante décadas.

La premisa central de UDCG es que las métricas tradicionales como nDCG (Normalized Discounted Cumulative Gain), MAP (Mean Average Precision) y MRR (Mean Reciprocal Rank) están profundamente desalineadas con el nuevo paradigma RAG. Estas métricas, desarrolladas para evaluar motores de búsqueda o sistemas de recomendación donde el consumidor es un humano, operan bajo dos supuestos tácitos pero equivocados en el contexto de los LLMs. Primero, asumen un "descuento posicional" monótono, basado en la idea de que un humano examina los resultados uno por uno, de arriba hacia abajo, y su interés disminuye con cada resultado siguiente. Segundo, clasifican los documentos de forma binaria: relevante o no relevante. UDCG desmantela ambos supuestos.

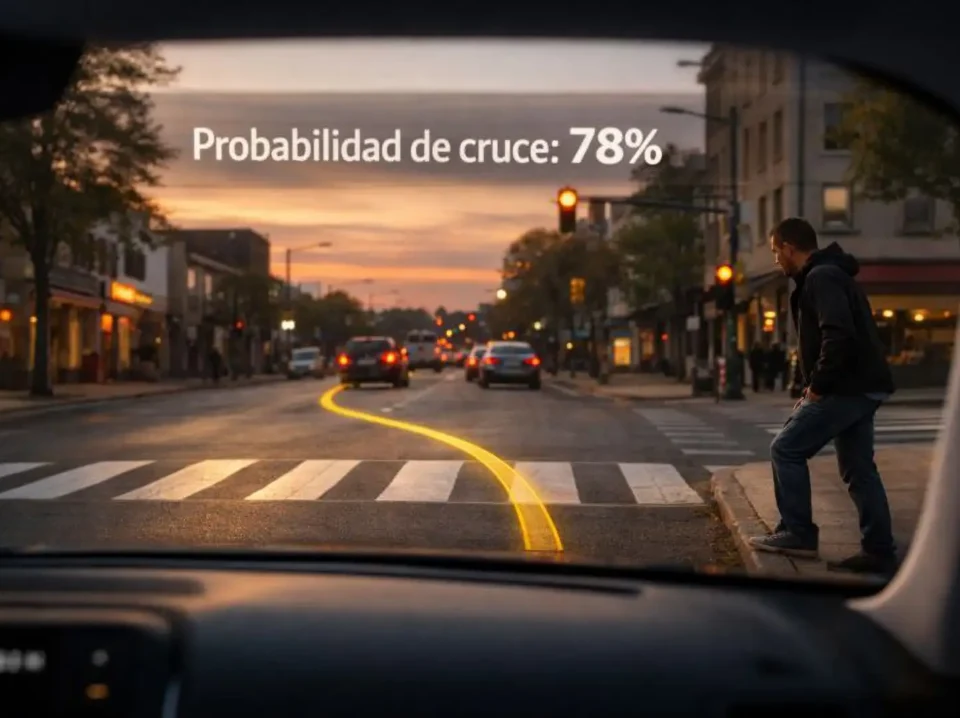

El primer pilar del argumento de UDCG es el descuento posicional. Los LLMs no leen secuencialmente; procesan todos los documentos recuperados como un conjunto holístico y colectivo. Esta diferencia fundamental significa que el impacto de un documento en la decisión final del LLM no disminuye de manera uniforme con su posición en la lista. De hecho, investigaciones previas han mostrado que los LLMs pueden exhibir sesgos posicionales no monótonos, como el conocido "efecto perdido en medio" (lost-in-the-middle), donde los documentos en posiciones intermedias pueden ser tratados de manera diferente a los de los extremos.

Por lo tanto, UDCG reemplaza el descuento logarítmico tradicional, que modela la atención humana, por un nuevo esquema de descuento posicional orientado a LLMs. Este nuevo descuento está diseñado para reflejar cómo los LLMs realmente integran la información, maximizando la correlación de la métrica con el rendimiento final del sistema RAG.

El segundo pilar es la naturaleza misma de la relevancia. Para un humano, un documento puede ser irrelevante y simplemente ignorarlo. Para un LLM, sin embargo, un documento "irrelevante" pero relacionado con el tema puede ser un "distractor". Estos distractores pueden introducir información confusa o ambigua que confunde activamente al modelo de generación, empeorando drásticamente la calidad de la respuesta final. Las métricas tradicionales no pueden capturar este efecto negativo; tratan todos los documentos no relevantes por igual.

UDCG introduce un cambio revolucionario al abandonar la relevancia binaria a favor de una puntuación de "utilidad" continua. Cada documento recuperado se anota con un valor que puede ser positivo (contribución útil), cero (neutral) o incluso negativo (contribución perjudicial o distractor). Esta puntuación se calcula probabilísticamente, estimando la probabilidad de que el LLM genere una respuesta incorrecta si solo tuviera acceso a ese documento específico.

UDCG se presenta en dos versiones para ofrecer flexibilidad: UDCG (con un único hiperparámetro γ=1/3, que no requiere entrenamiento adicional) y UDCGθ (una versión aprendible que ajusta parámetros posicionales específicos para capturar mejor los sesgos del modelo de lenguaje). Ambas versiones comparten el mismo objetivo fundamental: crear una medida que sea una mejor predicción del éxito o fracaso del sistema RAG en su tarea final de generar una respuesta precisa y fáctica. Al hacerlo, UDCG no solo corrige las fallas de las métricas anteriores; redefine el concepto de "éxito" en la recuperación de información para la era de la IA generativa, pasando de una evaluación centrada en el usuario a una evaluación centrada en el sistema de IA que consume la información.

Cómo UDCG cuantifica la contribución útil y el impacto negativo de los distractores

La fuerza de UDCG reside en su capacidad para ir más allá del concepto tradicional de "relevancia" y adentrarse en la compleja dinámica de la utilidad y la distracción. Si las métricas clásicas eran como un crítico de arte que solo decidía si una obra pertenecía a una exposición (relevante) o no (no relevante), UDCG es un curador que pondera meticulosamente la contribución positiva de cada pieza, identifica las obras que distraen y debilitan la narrativa general, y asigna un valor monetario a cada una en función de su impacto global en la calidad de la exposición. Esta sofisticación es crucial para calibrar el rendimiento de los sistemas RAG, donde la cantidad de información recuperada es tan importante como su calidad y contexto.

El corazón de la innovación de UDCG es su esquema de anotación basado en la "utilidad" continua. En lugar de un simple binario (1 para relevante, 0 para no relevante), cada pasaje recuperado recibe una puntuación que refleja su impacto en la tarea de generación del LLM. Los documentos útiles y directamente pertinentes reciben valores positivos altos. Aquellos que son irrelevantes pero no perjudiciales se anotan con un valor neutral (cercano a cero). Sin embargo, la gran novedad y el principal desafío metodológico es la cuantificación del tercer tipo: los distractores.

Estos son documentos que, si bien pueden contener información de algún modo relacionada con la consulta, son capaces de inducir a error al LLM. Podrían presentar hechos contradictorios, ser ambiguos o contener terminología especializada que el modelo de generación no maneja correctamente, actuando así como un factor de ruido que degrada la calidad de la respuesta final.

La forma en que UDCG asigna estos valores de utilidad es ingeniosa y probabilística. Se utiliza un método que estima la probabilidad de que el LLM genere una respuesta incorrecta si se le presenta solo el contenido de un documento específico. Un documento que, si fuera el único disponible, conduciría fácilmente al LLM a una respuesta correcta recibiría una alta puntuación positiva. Uno que sería neutral en cualquier contexto recibiría una puntuación baja. Y uno que, si fuera el único punto de referencia, probablemente induciría al LLM a cometer un error —por ejemplo, proporcionando datos históricos incorrectos sobre una figura— recibiría una puntuación negativa, marcándolo explícitamente como un distractor.

Para ilustrar la importancia de este enfoque, considere un escenario de soporte médico. Una consulta sobre "tratamientos para la artritis reumatoide" devuelve tres documentos: uno es un protocolo clínico detallado y muy relevante (puntuación de utilidad alta); otro es un artículo de investigación sobre una nueva terapia experimental que es demasiado reciente y no se recomienda aún (puntuación de utilidad media, potencialmente un distractor); y el tercero es un foro de pacientes discutiendo remedios caseros (puntuación de utilidad baja o negativa).

Una métrica tradicional como nDCG podría dar una alta puntuación si el protocolo clínico está en la primera posición, ignorando completamente el impacto negativo del foro de pacientes. UDCG, sin embargo, penalizaría fuertemente la inclusión del foro y podría incluso castigar la posición del artículo de investigación experimental si se encuentra en una posición clave que confunde al LLM. Esto se demuestra en el análisis de ablación del paper, donde eliminar el efecto de los distractores reduce la correlación de la métrica con el rendimiento final del sistema entre un 3.4% y un 8%, mientras que usar relevancia binaria en lugar de utilidad continua reduce la correlación hasta en un 17%.

Esta capacidad de cuantificar tanto la utilidad como el impacto negativo tiene profundas implicaciones metodológicas. Hace que la evaluación de la recuperación de información sea más parecida a una disciplina científica social o económica, donde se valora no solo el aporte de una teoría, sino también el coste social de promover ideas erróneas. En el contexto de los LLMs, el "coste" es la disminución de la fidelidad factual y la calidad de la generación. Al incorporar explícitamente el concepto de distractor, UDCG obliga a los desarrolladores a pensar de manera más crítica sobre la composición de la información que alimentan a sus modelos de generación. No basta con buscar documentos "relacionados"; ahora deben buscar documentos "útiles" y evitar activamente los "perjudiciales". Este es un cambio de paradigma que eleva la barra de la calidad en el diseño de sistemas RAG, haciendo que la selección de la fuente de conocimiento sea tan importante como el diseño del modelo de lenguaje en sí.

El impacto de UDCG en la correlación con el rendimiento final del sistema

La teoría de una nueva métrica es interesante, pero su validez radica en su capacidad para reflejar con precisión el mundo real. El paper de Trappolini et al. no se contenta con presentar un concepto elegante; somete a UDCG a una batalla campal de validación empírica, comparándola directamente con las métricas tradicionales y otras alternativas emergentes. Los resultados no son modestos; afirman que UDCG mejora la correlación con el rendimiento end-to-end del sistema RAG hasta en un 36 % en comparación con los estándares establecidos. Esta afirmación sugiere que UDCG es una herramienta de diagnóstico significativamente más poderosa para los ingenieros y científicos de datos que trabajan en la optimización de los sistemas RAG.

La experimentación para validar UDCG fue metódica y exhaustiva. Se llevaron a cabo pruebas en cinco diferentes conjuntos de datos, diseñados para probar una variedad de dominios de conocimiento y tipos de preguntas. Estos incluyen NQ (Questions Natural), TriviaQA, PopQA, BioASQ (especializado en medicina y biología) y NoMIRACL (multilingüe). Esta diversidad asegura que los hallazgos no sean un artefacto de un solo conjunto de datos. Además, para evitar cualquier sesgo por parte del modelo de lenguaje, se utilizaron seis LLMs diferentes como modelos de generación en los sistemas RAG, representando una gama de tamaños y arquitecturas: Llama-3.2-3B, Llama-3.1-8B, Llama-3.3-70B, Mistral-7B, Gemma-3-4B y Qwen-2.5-7B. La elección deliberada de estos modelos, que cubren desde pequeños modelos de código abierto hasta modelos líderes de la industria, demuestra un compromiso con la generalización de los resultados.

| Modelo | Arquitectura / Propietario |

|---|---|

| Llama-3.2-3B | Meta |

| Llama-3.1-8B | Meta |

| Llama-3.3-70B | Meta |

| Mistral-7B | Mistral AI |

| Gemma-3-4B | |

| Qwen-2.5-7B | Alibaba |

Los resultados de estos experimentos son claros y consistentes: UDCG supera sistemáticamente a las métricas tradicionales como nDCG, MAP y MRR en su capacidad para predecir el rendimiento final del sistema.

Esta superioridad no solo se mide en relación con los clásicos, sino también frente a otras metodologías más modernas. Cuando se comparó con eRAG, un método similar que evalúa la utilidad de los documentos para el sistema RAG, UDCG demostró ser más consistente y, en algunos casos, más precisa. Esto es notable, ya que eRAG ya representaba un paso adelante al alejarse del juicio humano. La superioridad de UDCG sugiere que su enfoque de cuantificar explícitamente la utilidad y el impacto negativo de los distractores es un camino más fundamentalmente correcto para la evaluación en este nuevo paradigma.

Además de la mejora en la correlación, UDCG demuestra una mayor estabilidad frente a los cambios en la longitud del contexto, una variable crítica en los sistemas RAG donde se puede ajustar cuántos documentos se pasan al LLM de generación. Las métricas tradicionales pueden verse afectadas drásticamente por este cambio, lo que dificulta la interpretación de los resultados. La estabilidad de UDCG en este aspecto es una ventaja práctica significativa para los ingenieros que buscan optimizar la eficiencia y el costo del sistema.

Finalmente, el papel de la prueba de ablación en el paper es crucial. Al eliminar deliberadamente componentes de la métrica, los autores pudieron medir su contribución individual al rendimiento general. El hecho de que la eliminación del término de "distractor" redujera la correlación, o que el uso de relevancia binaria en lugar de utilidad continua hiciera lo mismo, no es una formalidad estadística. Es una demostración empírica de la importancia de los conceptos subyacentes. Confirma que no es solo una fórmula matemática más, sino que cada elemento de su diseño conceptual —la distinción entre utilidad y distracción, el descuento posicional adaptado a los LLMs— aporta un valor medible y tangible a la hora de evaluar el rendimiento del sistema. Esta validación robusta es lo que permite a los autores afirmar que UDCG representa un avance genuino y necesario en el campo.

Del laboratorio a la práctica industrial

La introducción de UDCG marca un punto de inflexión estratégico en el campo de la inteligencia artificial, con implicaciones que trascienden la investigación académica para impactar directamente en la práctica industrial, la gobernanza de la IA y la dirección futura de la propia tecnología. Al cambiar la forma en que medimos el éxito en los sistemas de recuperación de información, UDCG impulsa una evolución natural hacia sistemas más seguros, eficientes y alineados con los objetivos humanos.

Desde una perspectiva industrial, la adopción de UDCG podría revolucionar el ciclo de vida del desarrollo de los sistemas RAG. Hoy en día, los ingenieros a menudo se ven obligados a realizar una serie de concesiones. Pueden optar por la evaluación end-to-end completa, que es la más precisa pero extremadamente lenta y costosa en términos de recursos computacionales.

Alternativamente, pueden depender de métricas tradicionales que son rápidas pero imprecisas, lo que a menudo resulta en soluciones óptimas localmente pero subóptimas en su conjunto. UDCG ofrece un tercero, más viable: una evaluación rápida y eficiente que es, al mismo tiempo, una mejor medida predictiva del rendimiento final. Esta mejora en la eficiencia de la evaluación puede acelerar drásticamente el ritmo de innovación, permitiendo a los equipos iterar más rápido y probar más hipótesis sobre el diseño de sus sistemas de recuperación.

Sin embargo, la adopción masiva de UDCG enfrenta obstáculos importantes. El principal es la necesidad de una anotación de datos mucho más rica y compleja. Mientras que las métricas tradicionales a menudo se pueden aplicar a conjuntos de datos existentes con anotaciones de relevancia binaria, UDCG exige un esfuerzo de anotación significativamente mayor para asignar puntuaciones de utilidad continua y, especialmente, para identificar y etiquetar los distractores. Este esfuerzo de capital humano es una barrera de entrada considerable.

Por lo tanto, el futuro de UDCG podría depender en gran medida de la creación de nuevos benchmarks y conjuntos de datos específicamente diseñados para esta métrica, lo que requerirá una colaboración coordinada entre la academia y la industria. El lanzamiento de benchmarks como FACTS Grounding por parte de Google DeepMind, que ya está trabajando en la evaluación de la fidelidad de los LLMs, sugiere un movimiento en esta dirección, pero todavía queda mucho por hacer.

Las implicaciones más profundas de UDCG residen en el campo de la gobernanza y la ética de la IA. La capacidad de UDCG para identificar explícitamente los "distractores" —documentos que pueden inducir a error o perpetuar sesgos— proporciona una herramienta poderosa para la auditoría de sistemas de IA. Podría usarse para detectar y mitigar la propagación de desinformación, asegurar que los sistemas de salud no basen sus recomendaciones en estudios fraudulentos y que los sistemas legales no lean artículos sesgados. Esta capacidad de medir el "daño" potencial de la información es un paso crucial hacia la creación de IA más responsable y menos propensa a causar daño inadvertidamente. Demis Hassabis, CEO de Google DeepMind, ha sido un firme defensor de la necesidad de una gobernanza internacional responsable para la IA, reconociendo que la seguridad y fiabilidad son fundamentales. Herramientas como UDCG son la base técnica indispensable para implementar tal gobernanza.

Finalmente, UDCG nos invita a reflexionar sobre el propio objetivo de la inteligencia artificial. Si la meta es crear sistemas que amplifiquen nuestra capacidad para encontrar la verdad, entonces la evaluación debe centrarse en la fidelidad factual. Si la meta es simplemente simular una conversación convincente, la evaluación puede centrarse en la fluidez del lenguaje. La aparición de UDCG, junto con otros esfuerzos como FACTS Grounding, indica una tendencia clara: el campo está volviendo a priorizar la fidelidad y la precisión factual como metas primordiales. Esto no significa que otros objetivos como la creatividad o la empatía no sean importantes, pero sugiere que la próxima generación de IA tendrá que demostrar su fiabilidad antes de poder aspirar a la excelencia en otros dominios. En última instancia, UDCG es más que una métrica; es una brújula que apunta hacia un futuro de IA más sólida, transparente y, esperemos, más beneficiosa para la humanidad.

La revolución en la medición como guía para el futuro de la Inteligencia Artificial

En resumen, el paper "Redefining Retrieval Evaluation in the Era of LLMs" y su métrica innovadora, UDCG, representan un hito significativo en la evolución de la inteligencia artificial. No se trata simplemente de un ajuste técnico a una fórmula existente, sino de una revisión filosófica y metodológica fundamental. Ha llegado el momento de reconocer que las herramientas de medición creadas para la era de la información, centrada en el humano, son insuficientes para evaluar los sistemas de IA generativa, donde el consumidor de la información es otra IA. UDCG surge como una respuesta audaz a esta brecha, proponiendo un nuevo paradigma de evaluación que es consciente de las peculiaridades de los LLMs: su procesamiento holístico, sus sesgos posicionales no monótonos y, lo más importante, su vulnerabilidad a la interferencia de información contraproducente.

La principal contribución de UDCG es su transición de una métrica de relevancia a una de utilidad. Al distinguir no solo entre lo que es útil y lo que no, sino también entre lo que es perjudicial (distractor), la métrica pasa de ser un simple detector de información a un gestor de riesgos cognitivos. Este enfoque transforma la evaluación de la recuperación de información en un acto de construcción de confianza. Permite a los desarrolladores no solo saber qué documentos están obteniendo, sino entender cómo esos documentos interactúan con el modelo de generación para producir un resultado final. La capacidad de UDCG para mejorar la correlación con el rendimiento del sistema hasta en un 36% no es un simple recordatorio de eficiencia; es una afirmación de que esta nueva forma de medir es conceptualmente más correcta y, por lo tanto, más valiosa para guiar el desarrollo futuro.

El impacto de este trabajo se extiende más allá del laboratorio. En la práctica industrial, UDCG promete acelerar el desarrollo de sistemas RAG al ofrecer una evaluación rápida y precisa, cerrando la brecha entre la velocidad de las métricas tradicionales y la exactitud de las evaluaciones end-to-end. En el ámbito de la gobernanza, proporciona una herramienta para auditar y mitigar el impacto negativo de la información en los LLMs, un paso crucial hacia la creación de IA más segura y ética. La capacidad de cuantificar los distractores es, en esencia, una herramienta para combatir la desinformación desde la base de la cadena de suministro de conocimiento de la IA. Esto alinea perfectamente con las declaraciones de figuras influyentes como Demis Hassabis, quien ha insistido en la necesidad de una gobernanza responsable y de una medición rigurosa para asegurar la fiabilidad de la IA.

Sin embargo, el camino hacia la adopción universal de UDCG no está exento de desafíos. El principal obstáculo es el costo de la anotación de datos, que es inherentemente mayor que para las métricas binarias. Esto podría limitar su uso a organizaciones con recursos significativos o requerir una colaboración a gran escala para crear nuevos conjuntos de datos públicos. A pesar de esto, el paper ha sentado un precedente fundamental. Ha abierto la puerta a una nueva clase de investigación que busca medir la "calidad de la información" de maneras más sutiles y contextuales, en lugar de solo su disponibilidad o relevancia superficial.

En conclusión, la introducción de UDCG es más que un avance técnico; es un catalizador de una discusión más amplia sobre la naturaleza de la verdad y la confianza en la era de la IA. Nos invita a reconsiderar lo que significa que un sistema de información sea "bueno". ¿Es bueno porque devuelve documentos relevantes, o es bueno porque construye respuestas fácticas y precisas? UDCG apuesta decididamente por la segunda definición. Como tal, representa un hito en la trayectoria de la IA, guiándonos hacia un futuro donde la precisión y la veracidad no sean un subproducto indeseado, sino el objetivo central de la medición y el desarrollo.

Referencias

Trappolini, G., Cuconasu, F., Filice, S., Maarek, Y., & Silvestri, F. (2025). Redefining Retrieval Evaluation in the Era of LLMs. arXiv preprint arXiv:2510.21440.

Hassabis, D. (2024). Keynote at AI Safety Summit. UK Government.

Lewis, P., et al. (2020). Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks. NeurIPS.

Cuconasu, F., et al. (2024). The Power of Noise: Redefining Retrieval for RAG Systems. SIGIR '24.

Amiraz, C., et al. (2025). The Distracting Effect: Understanding Irrelevant Passages in RAG. ACL 2025.

Liu, N. F., et al. (2024). Lost in the Middle: How Language Models Use Long Contexts. TACL.

Salemi, A., & Zamani, H. (2024). Evaluating Retrieval Quality in Retrieval-Augmented Generation. SIGIR '24.