Vivimos un renacimiento de la inteligencia artificial que desafía nuestra percepción de lo posible. Cada pocas semanas, somos testigos de demostraciones asombrosas: sistemas que generan videos fotorrealistas a partir de una simple frase, asistentes que conversan con una fluidez y emotividad…

Physical Intelligence alcanza los $5.600 millones para estandarizar la mente robótica

Respaldada por CapitalG de Alphabet, la startup rompe con el paradigma del código personalizado. Su propuesta de un modelo fundacional único capaz de controlar cualquier cuerpo robótico —desde brazos industriales hasta asistentes domésticos— promete resolver el problema de la fragmentación…

SIMA 2: El agente de Google DeepMind que razona y aprende en mundos virtuales

La integración de Gemini transforma a SIMA de un seguidor de instrucciones básico a un compañero de juego que piensa, explica sus razonamientos y se mejora a sí mismo, marcando un hito crucial en el camino hacia la Inteligencia Artificial…

El punto de inflexión: cuándo más datos se vuelven un problema

Durante más de una década, un evangelio ha unificado el campo de la inteligencia artificial: más es más. El camino hacia una inteligencia de máquina más poderosa, más capaz y más matizada se consideraba pavimentado con una cantidad de datos simplemente…

Por qué los modelos de lenguaje siempre inventarán algo

Durante años, las alucinaciones en los modelos de lenguaje grande (LLMs) se han tratado como una falla de ingeniería, un error corregible que surge de imperfecciones en el entrenamiento o la arquitectura. Sin embargo, un conjunto creciente de investigaciones…

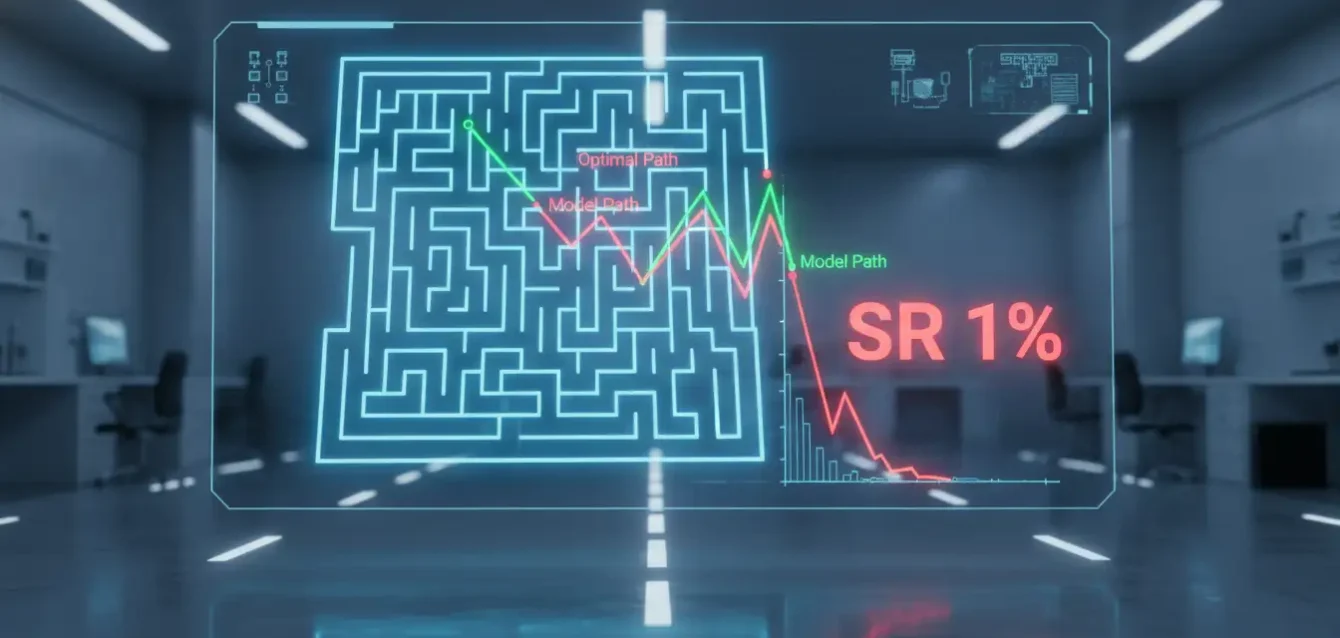

¿Es el Razonamiento en Cadena de Pensamiento de los LLM una Ilusión?

El espejismo del razonamiento en cadena: lo que el nuevo estudio revela sobre los LLM Durante los últimos años, el Chain-of-Thought (CoT) se ha convertido en la técnica favorita para mejorar la capacidad de los grandes modelos de lenguaje. La idea…

Un modelo fundamental para predecir y capturar la cognición humana

El Espejo de la Mente: ¿Puede la Inteligencia Artificial Descifrar Nuestras Decisiones? Cada día, desde el momento en que nos levantamos hasta que nos vamos a dormir, nuestra vida es una sinfonía ininterrumpida de decisiones. Algunas son triviales: ¿qué ropa me…