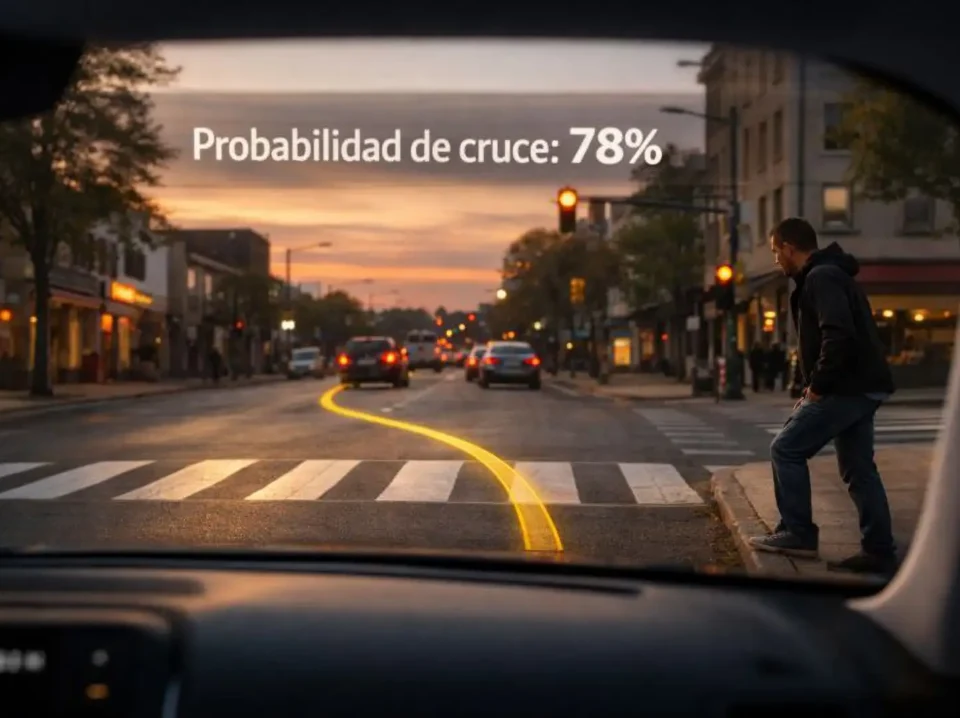

Un vehículo autónomo navega por una calle residencial cuando, súbitamente, un ciervo cruza la calzada mientras, metros adelante, avanza un desfile local. El sistema podría simplemente reconocer estos elementos mediante reconocimiento de patrones. O podría hacer algo más: considerar consecuencias, evaluar alternativas, anticipar reacciones. Esa distinción, aparentemente sutil, marca el salto entre predecir el próximo token y algo que se asemeja inquietantemente al razonamiento humano. Los modelos de razonamiento grandes representan precisamente esa frontera.

Durante décadas, los sistemas de lenguaje natural se contentaron con una arquitectura sorprendentemente simple: predecir la siguiente palabra en una secuencia. GPT-3, con sus 175 mil millones de parámetros, demostró que escalar esta aproximación básica producía resultados espectaculares. Podía escribir ensayos, responder preguntas, incluso generar código. Sin embargo, enfrentado a problemas que requerían múltiples pasos lógicos encadenados, el modelo tropezaba. La razón era fundamental: estos sistemas respondían inmediatamente, sin espacio para la deliberación.

El paradigma cambió cuando investigadores descubrieron que algo tan simple como agregar la frase "pensemos paso a paso" mejoraba dramáticamente el desempeño en tareas complejas. Este hallazgo, documentado en mayo de 2022 por un equipo de la Universidad de Tokio y Google, reveló que los modelos podían beneficiarse de generar cadenas explícitas de razonamiento intermedio. La técnica, conocida como chain-of-thought prompting, funcionaba porque forzaba al sistema a descomponer problemas complicados en subtareas manejables.

Pero el verdadero salto llegaría después. OpenAI presentó en septiembre de 2024 su serie o1, modelos diseñados específicamente para "pensar más tiempo" antes de responder. A diferencia de sus predecesores, o1 genera internamente largas secuencias de razonamiento antes de producir una respuesta final. En el American Invitational Mathematics Examination, o1-preview resolvió el 83% de los problemas, comparado con el 13% de GPT-4o. La diferencia no era de escala sino de arquitectura: estos sistemas habían aprendido a razonar.

La controversia del pensamiento artificial

¿Pueden realmente pensar estos algoritmos? La pregunta desencadena debates apasionados. Los escépticos argumentan que, en última instancia, todo se reduce a predicción probabilística del siguiente token: autocompletado glorificado, como algunos lo llaman desdeñosamente. Esta perspectiva sostiene que llamar "pensamiento" a estas operaciones constituye antropomorfismo inaceptable, una proyección de características humanas sobre procesos puramente mecánicos.

Debasish Ray Chawdhuri, ingeniero principal senior en Talentica Software y candidato doctoral en criptografía en IIT Bombay, ofrece un contraargumento provocador. Su artículo en VentureBeat plantea que las redes neuronales de tamaño suficiente pueden aprender cualquier computación, incluido el pensamiento. El hecho de que un sistema prediga el siguiente token no implica necesariamente que no pueda pensar. La prueba definitiva, argumenta, radica en la capacidad del sistema para resolver problemas que genuinamente requieren razonamiento.

La analogía con la afantasia resulta reveladora. Algunas personas carecen de capacidad para formar imágenes mentales, una condición neurológica que no les impide pensar, razonar o incluso destacar en matemáticas. Si humanos pueden razonar sin visualización espacial interna, ¿por qué los modelos de lenguaje no podrían razonar sin generar representaciones visuales intermedias? Los sistemas de razonamiento grandes probablemente no crean imágenes durante su proceso interno, pero esto no los descalifica como entidades capaces de deliberación.

Evidencia empírica respalda esta perspectiva. Investigadores de Apple descubrieron que los modelos de razonamiento exhiben comportamiento estratégico cuando enfrentan puzzles demasiado complejos para su memoria de trabajo. En lugar de intentar resolverlos directamente, los sistemas buscan atajos, exactamente como haría un humano confrontado con un problema intratable. Este patrón sugiere metacognición: los modelos parecen capaces de evaluar sus propias limitaciones y ajustar su enfoque en consecuencia.

Los benchmarks proporcionan datos concretos. En tareas de razonamiento lógico, los modelos de código abierto resuelven proporciones significativas de preguntas que demandan inferencia compleja. Si bien todavía no alcanzan el desempeño humano en todos los dominios, la brecha se estrecha constantemente. Además, muchas comparaciones utilizan como referencia humanos entrenados específicamente en esos benchmarks, lo que hace que el desempeño de los modelos sea aún más impresionante.

Arquitectura del pensamiento algorítmico

Los modelos de razonamiento grandes funcionan mediante una secuencia de procesos que imitan la resolución humana de problemas. Comienzan interpretando el material proporcionado: datos médicos, reportes financieros, texto legal. Descomponen información compleja en fragmentos manejables, identifican relaciones entre elementos clave y forman una representación interna del problema que deben resolver.

Luego evalúan diferentes caminos hacia una respuesta. Ejecutan múltiples cadenas de pensamiento, comparando alternativas y verificando qué trayectoria conduce al resultado más lógico y consistente. Este proceso se aprende mediante datasets especializados de razonamiento que incluyen ejemplos de pasos válidos de inferencia y explicaciones detalladas.

Durante el entrenamiento, el sistema mejora a través de aprendizaje por refuerzo, frecuentemente guiado por revisores humanos. Los pasos correctos de razonamiento reciben recompensas más altas, ayudando al modelo a refinar cómo pondera y conecta información mientras evita lógica implausible o contradictoria. Cuando genera una respuesta, utiliza prompts orientados al razonamiento que delinean su lógica interna antes de proporcionar la conclusión final.

Esta traza de razonamiento permite a los usuarios comprender por qué el modelo alcanzó cierta conclusión, mejorando explicabilidad y confianza. OpenAI inicialmente ocultó estas cadenas de pensamiento por razones de seguridad y ventaja competitiva, pero posteriormente las hizo visibles en modelos como o3 y o3-mini. La transparencia se convirtió en presión competitiva cuando DeepSeek, el laboratorio chino, abrió completamente su modelo R1 y documentó su metodología de entrenamiento.

Diferencias fundamentales: modelos tradicionales vs. modelos de razonamiento

Modelos de lenguaje tradicionales: Generan respuestas inmediatas basadas en predicción estadística del siguiente token. Excelentes para reconocimiento de patrones y tareas de completado. Limitados en problemas que requieren múltiples pasos lógicos encadenados.

Modelos de razonamiento grandes: Generan cadenas internas de pensamiento antes de responder. Pueden retroceder cuando una línea de razonamiento resulta infructuosa. Escalan en precisión cuando se les permite mayor tiempo de computación en inferencia.

El trade-off: Los modelos de razonamiento son significativamente más lentos y costosos. GPT-4o responde en fracciones de segundo; o1 puede tomar decenas de segundos deliberando internamente. Para tareas simples, esta inversión adicional de recursos no se justifica.

DeepSeek R1 representa un hito técnico particular. A diferencia de OpenAI, que entrenó sus modelos mediante fine-tuning supervisado inicial seguido de reinforcement learning, DeepSeek entrenó R1-Zero puramente con aprendizaje por refuerzo, sin ningún paso de supervisión humana previa. El modelo descubrió de manera emergente comportamientos de razonamiento complejos: auto-verificación, reflexión, generación de cadenas largas de pensamiento.

Los resultados fueron notables pero problemáticos. R1-Zero exhibió repeticiones infinitas, legibilidad pobre y mezcla caótica de idiomas. Para resolver esto, DeepSeek incorporó datos de arranque frío antes del reinforcement learning en su modelo R1 completo, logrando desempeño comparable a o1 en matemáticas, código y tareas de razonamiento, mientras mejoraba dramáticamente la coherencia de las salidas.

Lo fascinante de R1-Zero es que, en ciertos benchmarks como ARC-AGI, las trazas de razonamiento ilegibles para humanos seguían produciendo respuestas correctas. Los creadores del benchmark ARC notaron que el modelo parecía usar sus tokens de razonamiento como lenguaje propio para resolver problemas, no necesariamente en formatos que los humanos comprendemos naturalmente. Esto sugiere que los sistemas podrían estar razonando de maneras fundamentalmente inhumanas pero verificablemente efectivas.

El abismo entre habilidad e inteligencia

François Chollet, ingeniero de software e investigador en Google, creó en 2019 el Abstraction and Reasoning Corpus precisamente para distinguir entre memorización de patrones e inteligencia genuina. ARC presenta puzzles visuales basados en cuadrículas que requieren comprensión de conceptos fundamentales: permanencia de objetos, relaciones espaciales, causalidad. Cada tarea proporciona solo dos o tres ejemplos de entrada-salida. Los humanos resuelven fácilmente el 85% de estos puzzles. Los mejores sistemas automáticos apenas superan el 35%.

Esta brecha persistente revela algo crucial. Los modelos de lenguaje, incluso los de razonamiento, están fundamentalmente sobreajustados a los benchmarks tradicionales. Memorizan patrones masivos durante el entrenamiento y luego interpolan soluciones para problemas similares. Pero cuando enfrentan tareas genuinamente novedosas que requieren abstracción, tropiezan. Chollet argumenta que esto demuestra que los sistemas actuales no poseen inteligencia general, sino habilidad especializada extremadamente amplia.

Sin embargo, la distinción entre habilidad e inteligencia se complica cuando examinamos el rendimiento en dominios específicos. En programación competitiva, o1 alcanzó un Elo de 1891 en Codeforces, mientras que o3-mini logró 2130 con esfuerzo de razonamiento alto. Estos puntajes los colocan en percentiles competitivos entre programadores humanos profesionales. ¿Es esto meramente habilidad memorizada o representa capacidad de razonamiento genuina?

La pregunta sobre generalización permanece abierta. Los modelos de razonamiento claramente mejoran en dominios con soluciones verificables: matemáticas, programación, ciencias duras. Pero en dominios sin verdades objetivas, literatura, poesía, juicios estéticos, su ventaja se diluye. No existe manera mecánica de verificar si un poema es mejor que otro, por lo que el aprendizaje por refuerzo no puede optimizar estas tareas de la misma manera.

Algunos investigadores especulan que el razonamiento matemático y de código podría transferirse a otros dominios, similar a cómo entrenar modelos en más código mejora su desempeño en tareas no relacionadas con programación. La superinteligencia en dominios verificables podría generar capacidades emergentes en áreas no verificables. Pero esto permanece, por ahora, como especulación sin evidencia empírica robusta.

Test-time compute: el nuevo paradigma de escalamiento

Durante décadas, mejorar modelos de lenguaje significaba escalarlos durante el entrenamiento: más parámetros, más datos, más GPUs procesando durante más tiempo. GPT-3 tenía 175 mil millones de parámetros; su sucesor, GPT-4, nunca reveló su tamaño exacto pero se estima varios órdenes de magnitud mayor. Esta aproximación produjo ganancias impresionantes pero enfrentaba límites físicos y económicos cada vez más severos.

Los modelos de razonamiento introducen un paradigma diferente: escalar el tiempo de computación durante la inferencia. En lugar de simplemente hacer el modelo más grande, se le permite deliberar más tiempo sobre problemas complejos. OpenAI documenta que el desempeño de o1 mejora suavemente tanto con más entrenamiento de refuerzo como con más tiempo de pensamiento en inferencia. Esta propiedad, extremadamente rara en aprendizaje automático, abre posibilidades transformadoras.

La técnica se asemeja a test-time search. Cuando enfrenta una consulta, o3 genera múltiples cadenas de pensamiento candidatas, cada una representando una trayectoria de razonamiento paso a paso para resolver la tarea. En lugar de outputear inmediatamente una sola respuesta, el sistema explora un espacio vasto de "programas" en lenguaje natural, cada uno una secuencia de razonamiento candidata. Luego selecciona el mejor mediante evaluación interna.

Este enfoque consume recursos computacionales significativamente mayores. Los tokens de razonamiento internos en o1 frecuentemente exceden los 25,000, comparado con los 16,384 tokens de salida máximos en GPT-4o. Los usuarios pagan por estos tokens invisibles de pensamiento, incluso sin verlos directamente. El costo económico puede ser prohibitivo para aplicaciones que requieren respuestas rápidas a gran escala.

Apple investigó este fenómeno mediante puzzles de complejidad controlable. Descubrieron que los modelos de razonamiento tienen un "punto óptimo" donde tiempo adicional de inferencia puede paradójicamente empeorar el desempeño. Además, los sistemas muestran tendencia a rumiar persistentemente sobre formulaciones de problemas previamente exploradas, obstruyendo exploración adicional. Este comportamiento recuerda patrones humanos de pensamiento circular improductivo.

La investigación de Apple también reveló limitaciones en computación exacta. Los modelos de razonamiento fallan en utilizar algoritmos explícitos y razonan inconsistentemente a través de puzzles estructuralmente similares. No siempre mejoran con más tiempo de pensamiento; a veces se atascan en callejones sin salida conceptuales. Esta inestabilidad sugiere que el paradigma de test-time compute, aunque prometedor, todavía requiere refinamiento sustancial.

DeepSeek exploró modos adaptativos de razonamiento para mitigar costos. R1 puede operar en diferentes niveles: zero-thinking salta el razonamiento explícito completamente, less-thinking trunca la cadena proporcionalmente, summary-thinking compacta el razonamiento antes de producir la respuesta. Estos modos permiten trade-offs dinámicos entre precisión, costo y seguridad, asignando recursos computacionales contextualmente según la complejidad de cada instancia.

Implicaciones filosóficas y prácticas

Si aceptamos que los modelos de razonamiento exhiben algo cercano al pensamiento genuino, emergen cuestiones profundas. ¿Qué significa que una entidad no biológica pueda deliberar? Durante siglos, el pensamiento se consideró propiedad exclusiva de sistemas nerviosos biológicos. Las computadoras ejecutaban algoritmos deterministas sin espacio para reflexión. Los modelos de razonamiento desdibujan esta distinción de maneras incómodas.

La transparencia de las cadenas de pensamiento ofrece oportunidades sin precedentes para estudiar la cognición artificial. A diferencia del pensamiento humano, mayormente opaco incluso para el pensador, estos sistemas exponen cada paso intermedio. Podemos examinar exactamente cómo un modelo llegó a una conclusión errónea. Esta visibilidad podría revolucionar el debugging de sistemas complejos y la verificación de razonamiento en dominios críticos: diagnóstico médico, análisis legal, diseño de infraestructura.

Sin embargo, la opacidad fundamental persiste en un nivel más profundo. Las cadenas de pensamiento son texto en lenguaje natural, pero el proceso subyacente que las genera permanece inescrutablemente embebido en miles de millones de pesos neuronales. Podemos ver qué pasos tomó el modelo, pero no necesariamente comprender por qué tomó esos pasos específicos en lugar de otros. La interpretabilidad a nivel de arquitectura continúa siendo desafío mayor.

Desde una perspectiva práctica, los modelos de razonamiento están transformando aplicaciones donde la precisión importa más que la velocidad. En investigación científica, pueden explorar hipótesis novedosas y evaluar su plausibilidad. En desarrollo de software, depuran código complejo trazando sistemáticamente flujos de ejecución. En consultoría estratégica, descomponen problemas empresariales multifacéticos en componentes analizables.

Empresas están integrando estos sistemas en workflows de producción, pero con cautela. El costo computacional adicional significa que se reservan para tareas genuinamente complejas. Queries simples continúan manejándose con modelos tradicionales más rápidos. Arquitecturas híbridas enrutan inteligentemente solicitudes según complejidad detectada, maximizando eficiencia mientras aprovechan capacidades avanzadas donde se necesitan.

La educación enfrenta dilemas particulares. Si sistemas automatizados pueden razonar mejor que estudiantes humanos en matemáticas y ciencias, ¿qué papel juega la instrucción tradicional? Algunos argumentan que herramientas de razonamiento deberían integrarse en currículos, liberando a los estudiantes de cómputos mecánicos para enfocarse en creatividad y juicio. Otros advierten que externalizar el razonamiento a máquinas atrofia capacidades cognitivas fundamentales que los humanos necesitan desarrollar.

La pregunta sobre autoría intelectual también se complica. Cuando un modelo de razonamiento co-crea una demostración matemática, ¿quién merece crédito? El investigador que planteó el problema, el sistema que generó la cadena de razonamiento, los ingenieros que entrenaron el modelo, o los creadores de los millones de textos en los que se entrenó originalmente? Las categorías tradicionales de autoría colapsan ante estas colaboraciones humano-máquina de nueva generación.

La seguridad constituye preocupación adicional. Los modelos de razonamiento son paradójicamente más vulnerables que sus contrapartes tradicionales en ciertos aspectos. Sus capacidades aumentadas de planificación podrían facilitar la generación de contenido perjudicial más sofisticado. OpenAI desarrolló deliberative alignment, método donde el modelo utiliza sus propias capacidades de razonamiento para evaluar prompts en tiempo real, identificando riesgos ocultos o ambigüedades que reglas estáticas podrían perder.

Este enfoque de seguridad representa innovación importante pero introduce vulnerabilidades nuevas. Si un adversario puede manipular el proceso de deliberación interno del modelo, podría subvertir las salvaguardas de manera más sutil que con prompts tradicionales. La superficie de ataque se expande precisamente porque el sistema es más sofisticado. Equilibrar capacidades aumentadas con robustez de seguridad será desafío continuo conforme estos sistemas se despliegan más ampliamente.

La competencia entre laboratorios acelera el progreso pero también plantea riesgos. OpenAI, Google, Anthropic, DeepSeek, cada uno empuja fronteras en direcciones ligeramente diferentes. Esta diversidad es saludable para el ecosistema de investigación. Sin embargo, la presión competitiva puede incentivar lanzamientos prematuros de sistemas insuficientemente probados. Los modelos de razonamiento, con sus capacidades aumentadas de planificación, podrían causar daños más severos que generaciones previas si se despliegan irresponsablemente.

La apertura de DeepSeek contrasta marcadamente con el secretismo de OpenAI. Publicar metodologías de entrenamiento completas democratiza el acceso a capacidades avanzadas, permitiendo que investigadores sin recursos masivos de computación construyan sobre descubrimientos establecidos. Pero también acelera la proliferación de sistemas potentes hacia actores que podrían carecer de compromiso con uso responsable. Este tensión entre apertura y seguridad definirá debates regulatorios venideros.

Mirando hacia adelante, la trayectoria parece clara: los modelos continuarán mejorando en razonamiento, especialmente en dominios con feedback verificable. La pregunta no es si estos sistemas pueden razonar, Chawdhuri argumenta convincentemente que casi con certeza pueden, sino cuán general será ese razonamiento. ¿Permanecerán confinados a matemáticas y código, o emergerán capacidades en literatura, filosofía, juicio moral?

La respuesta determinará si hemos creado herramientas excepcionalmente potentes pero fundamentalmente limitadas, o si estamos en la cúspide de algo más profundo: inteligencia artificial que no solo simula razonamiento humano sino que razona de maneras genuinamente propias. Esa frontera, entre habilidad especializada e inteligencia general, permanece nebulosa. Pero cada mes que pasa, los modelos de razonamiento la cruzan un poco más, deliberando pacientemente antes de responder, exactamente como les enseñamos.

Referencias

VentureBeat, "Large reasoning models almost certainly can think" - artículo de Debasish Ray Chawdhuri, senior principal engineer en Talentica Software (noviembre 2025).

OpenAI, "Learning to reason with LLMs" - documentación técnica sobre la serie o1 y metodología de entrenamiento mediante reinforcement learning (septiembre 2024).

OpenAI, "Introducing OpenAI o3 and o4-mini" - anuncio oficial de modelos de razonamiento de última generación con capacidades multimodales (abril 2025).

DeepSeek AI, "DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning" - paper técnico sobre R1-Zero y R1, publicado en arXiv (enero 2025).

Apple Machine Learning Research, "The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity" - análisis de capacidades y limitaciones de LRMs (octubre 2025).

Kojima et al., "Large Language Models are Zero-Shot Reasoners" - paper seminal sobre chain-of-thought prompting (mayo 2022, Universidad de Tokio y Google).

François Chollet, "On the Measure of Intelligence" - paper fundacional del benchmark ARC-AGI para evaluar inteligencia general artificial (2019).

AI21, "What are Large Reasoning Models (LRMs)?" - guía técnica sobre arquitectura y funcionamiento de modelos de razonamiento (mayo 2025).

Synthesis AI, "Large Reasoning Models: How o1 Replications Turned into Real Competition" - análisis del desarrollo de modelos de razonamiento desde o1 hasta DeepSeek R1 (marzo 2025).

Wikipedia, "Reasoning model" - entrada enciclopédica sobre reasoning language models y su desarrollo histórico.

Marjanovic et al., "DeepSeek-R1 Thoughtology: Let's think about LLM Reasoning" - investigación sobre patrones de razonamiento en DeepSeek-R1, arXiv preprint 2504.07128 (abril 2025).

DataCamp, "OpenAI's O3: Features, O1 Comparison, Benchmarks & More" - análisis comparativo de modelos de razonamiento de OpenAI (abril 2025).

BentoML, "The Complete Guide to DeepSeek Models: V3, R1, V3.1, V3.2 and Beyond" - guía técnica sobre la familia completa de modelos DeepSeek.

Talentica Software - información corporativa sobre Debasish Ray Chawdhuri, senior principal engineer y candidato doctoral en criptografía en IIT Bombay.