En el corazón de los centros de datos que impulsan la revolución de la inteligencia artificial, se libra una batalla silenciosa contra la ineficiencia. Mientras la industria celebra la potencia bruta de los nuevos procesadores y la escala monumental de los modelos de lenguaje, una fricción invisible devora gran parte de esa capacidad de cómputo. El entrenamiento de sistemas de razonamiento complejo, aquellos diseñados para pensar paso a paso antes de emitir una respuesta, se ha topado con un muro logístico conocido como la "latencia de cola". Este fenómeno provoca que superordenadores con un coste operativo de miles de dólares por hora permanezcan ociosos durante la mitad de sus ciclos de trabajo, rehenes de una minoría de tareas computacionales excepcionalmente lentas que paralizan el flujo de datos.

La raíz de este desperdicio estructural reside en la naturaleza impredecible del pensamiento sintético. Cuando un modelo de vanguardia se entrena mediante aprendizaje por refuerzo, debe generar miles de respuestas posibles a un mismo problema para aprender de sus aciertos y errores. Sin embargo, la longitud de estas respuestas varía de forma salvaje: una solución puede ser concisa y directa, mientras que otra, generada bajo el mismo estímulo, puede embarcarse en una derivación lógica kilométrica. Los sistemas de gestión tradicionales, ciegos ante esta variabilidad, tratan todas las tareas como iguales, asignando recursos de manera monolítica y estática. El resultado es un atasco digital donde los procesos rápidos deben esperar a los lentos, quemando energía sin producir avance.

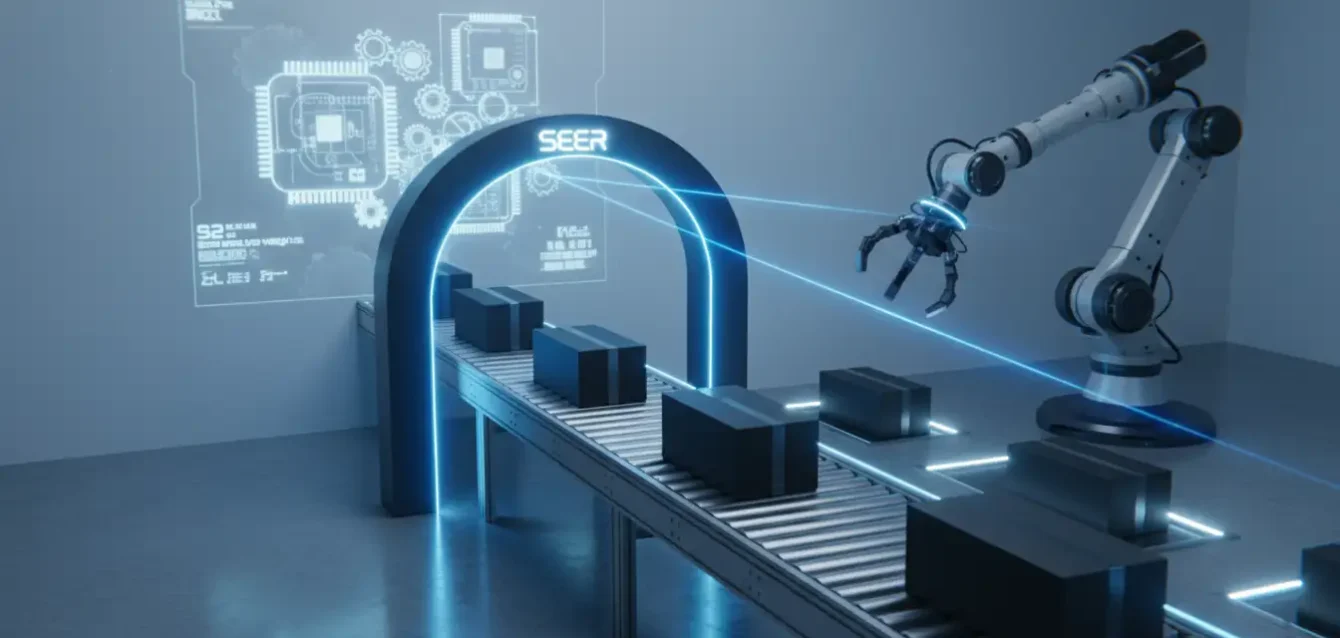

Ante este escenario de ineficiencia masiva, un equipo conjunto de la Universidad de Tsinghua y la firma tecnológica Moonshot AI ha presentado una solución que redefine la orquestación de recursos. Bautizado como Seer (el vidente), este nuevo sistema propone un cambio de paradigma radical: abandonar la gestión reactiva para adoptar una postura predictiva. En lugar de tratar cada tarea de generación como una caja negra cuyo peso se desconoce hasta que finaliza, Seer utiliza la "intuición" estadística para identificar qué procesos consumirán más tiempo antes siquiera de que comiencen. No se trata de acelerar los transistores, sino de dotar al director de orquesta digital de una capacidad de anticipación casi humana para reorganizar la sinfonía de datos en tiempo real.

Desmantelando los bloques de hormigón

La primera innovación de Seer es puramente logística pero brillante en su ejecución técnica. Tradicionalmente, el entrenamiento de una IA implica enviar paquetes de preguntas agrupadas a un procesador, una estrategia rígida que deja numerosos huecos de inactividad si el paquete no encaja perfectamente en la capacidad de memoria disponible. Seer introduce el concepto de "despliegue dividido" (Divided Rollout), una técnica que pulveriza la rigidez de la asignación de tareas. En lugar de enviar bloques inamovibles, el sistema fragmenta cada proceso de pensamiento en trozos dinámicos y manejables que pueden fluir libremente entre diferentes unidades de procesamiento.

Esta fluidez operativa se sustenta en una gestión de memoria compartida que actúa como un cerebro colectivo para el clúster de computación. Normalmente, cada chip funciona como una isla con recursos limitados; si su memoria se satura, el proceso se detiene o colapsa. Seer interconecta estas islas mediante un repositorio global, permitiendo que la carga de trabajo de una tarea excesivamente compleja se derrame hacia otros procesadores que se encuentren libres. Es una redistribución hidráulica del esfuerzo computacional que asegura una ocupación de recursos casi perfecta, eliminando los tiempos muertos donde el silicio descansa mientras hay trabajo pendiente en la cola.

Sin embargo, la verdadera sofisticación de Seer no reside en su capacidad para mover la carga, sino en su inteligencia para decidir qué mover y cuándo hacerlo. Aquí entra en juego la "planificación consciente del contexto". El sistema ha internalizado una verdad estadística fundamental sobre los modelos de lenguaje: las respuestas alternativas a una misma pregunta tienden a poseer características similares. Si se le pide a la IA que resuelva una ecuación diferencial compleja, es altamente probable que todas las soluciones correctas requieran una longitud de desarrollo comparable. Seer explota esta correlación enviando una "sonda" exploratoria: ejecuta una de las respuestas del grupo con prioridad absoluta para medir su coste computacional.

🔮 Anticipación estratégica

Con el dato obtenido por la sonda, el sistema estima instantáneamente la dificultad del resto del grupo y reorganiza la cola de ejecución. Al aplicar una política de "lo más difícil primero", Seer evita el error clásico de dejar las tareas pesadas para el final de la cola, lo que causaría retrasos en cascada. Al procesar los bloques más grandes al principio, los huecos restantes se rellenan naturalmente con las tareas breves, optimizando el tiempo total de ciclo como un jugador experto de Tetris que nunca deja espacios vacíos.

Escritura colaborativa a velocidad luz

El tercer pilar de esta arquitectura aborda la velocidad de generación misma mediante una técnica de decodificación especulativa. Los modelos de lenguaje escriben secuencialmente, palabra por palabra, un proceso intrínsecamente lento. Las técnicas modernas intentan acelerar esto "adivinando" los siguientes términos y verificándolos en bloque, pero en el contexto del entrenamiento, donde el modelo cambia constantemente, estas predicciones suelen fallar. Seer soluciona este obstáculo implementando una estrategia colaborativa: dado que está generando múltiples respuestas simultáneas a la misma pregunta, utiliza el progreso de un proceso para asistir a los demás.

Si una variante de la respuesta ha encontrado una estructura lógica eficiente para explicar un concepto, el sistema comparte ese fragmento de "borrador" con las otras variantes que intentan articular una idea similar. Se crea así un árbol de conocimiento compartido en tiempo real (Compressed Suffix Tree) que permite a los procesos rezagados aprovechar el trabajo de los adelantados. Esta sinergia convierte la generación de texto en un esfuerzo de equipo, donde el hallazgo de un hilo de ejecución acelera a todos los demás, incrementando la velocidad global sin comprometer la originalidad o la independencia de cada respuesta individual.

Esta capacidad predictiva es dinámica y se ajusta a la presión del sistema. En las fases iniciales del ciclo, cuando la incertidumbre es alta, Seer actúa de manera conservadora. Pero en la crítica fase final, cuando quedan pocas tareas pendientes y el riesgo de cuello de botella es máximo, el sistema se vuelve agresivo, lanzando múltiples hipótesis de escritura en paralelo. Esta elasticidad permite convertir los momentos de baja actividad, que anteriormente eran puro desperdicio, en una carrera de velocidad final que cierra el ciclo de entrenamiento en tiempo récord.

La democratización de la eficiencia

Podría parecer que ahorrar unos segundos en un proceso de computación es un detalle técnico menor, reservado para la optimización de márgenes, pero las implicaciones económicas y científicas son profundas. Los resultados empíricos muestran que Seer reduce el tiempo desperdiciado por latencia de cola en más de un 90%. En un ecosistema donde entrenar un modelo fundacional de vanguardia implica facturas de electricidad y hardware de decenas de millones de dólares, recuperar ese tiempo perdido equivale a democratizar el acceso a la tecnología. Proyectos de investigación que antes eran económicamente inviables ahora entran en el terreno de lo posible.

Además, Seer logra esta eficiencia sin recurrir a atajos teóricos. Existen métodos alternativos que consiguen velocidad sacrificando la calidad matemática del aprendizaje (métodos asíncronos), utilizando datos ligeramente desactualizados para mantener la maquinaria en movimiento. Seer demuestra que no es necesario elegir entre la velocidad y la pureza algorítmica. Al optimizar la logística subyacente en lugar de recortar el rigor matemático, ofrece un camino sostenible para escalar la inteligencia artificial, reduciendo la huella de carbono por cada unidad de "inteligencia" producida.

⚠️ El límite de la predicción

La única vulnerabilidad teórica de este "vidente" digital reside en su dependencia de patrones reconocibles. Seer asume que existe una coherencia estructural entre las respuestas a una misma pregunta. Si la evolución futura de la IA nos lleva hacia modelos cuyo pensamiento sea radicalmente caótico o divergente, donde no exista correlación entre intentos, la bola de cristal estadística podría nublarse. La magia de Seer depende de que exista un orden oculto en el caos; si el caos se vuelve absoluto, la ventaja predictiva desaparece.

En última instancia, Seer nos ofrece una lección valiosa sobre la naturaleza del progreso en la era digital. A menudo asumimos que el avance proviene únicamente de construir motores más grandes o redes más densas, pero a veces el salto cualitativo más importante surge simplemente de una mejor organización. Al enseñar a las máquinas a anticipar y gestionar sus propias cargas de trabajo, no solo las hacemos más rápidas; las dotamos de una forma primitiva de autoconciencia operativa, un paso pequeño pero crucial hacia sistemas verdaderamente autónomos.

Referencias

Qin, R., et al. (2025). "Seer: Online Context Learning for Fast Synchronous LLM Reinforcement Learning". Análisis técnico sobre la arquitectura de predicción de carga.

Moonshot AI Team. (2025). Reportes técnicos sobre el modelo Kimi k2 y los desafíos del razonamiento lógico en IA.

Wei, J., et al. (2022). "Chain-of-Thought Prompting Elicits Reasoning in Large Language Models". Investigación fundamental sobre el razonamiento paso a paso.

Shao, Z., et al. (2024). "DeepSeekMath: Pushing the limits of mathematical reasoning". Estudio sobre la variabilidad en la longitud de generación.