Durante años, el gran desafío de la visión por ordenador ha sido su propia rigidez. Los sistemas de percepción visual estaban condenados a un catálogo estático: podían identificar una "persona" o un "coche" con precisión quirúrgica, pero solo porque esos términos habían sido predefinidos en un inventario de etiquetas cerrado. Si un usuario buscaba algo más matizado, como "un patinete eléctrico de color verde metálico" o "el reflejo en la ventana de una nube", la máquina se quedaba muda. Meta ha dinamitado esta limitación con la presentación de su Segment Anything Model 3, un sistema de visión unificado que no solo localiza, segmenta y rastrea conceptos, sino que lo hace basándose en un lenguaje natural y abierto. Esta es la prometedora propuesta de la empresa: pasar de un vocabulario limitado de objetos a una capacidad de descripción y búsqueda esencialmente ilimitada.

El predecesor del modelo, ampliamente reconocido como una herramienta fundamental para la industria, ya había democratizado la segmentación de objetos mediante clics. Sin embargo, esta nueva iteración, conocida como SAM 3, incorpora una funcionalidad transformadora: la segmentación de conceptos basada en prompts flexibles. Ya no se trata de pedir a la máquina que identifique la clase general "paraguas"; ahora, el usuario puede especificar "paraguas rojo a rayas". El sistema, demostrando una comprensión composicional avanzada, se esfuerza por demarcar en la imagen o el vídeo todas las instancias que cumplan simultáneamente con esas condiciones de color y patrón. Esta capacidad no es solo un avance técnico, sino un cambio paradigmático que alinea la visión artificial con la flexibilidad intrínseca del lenguaje humano.

Esta innovación significa que el sistema ya no está sujeto a una lista inmutable de denominaciones de objetos, un conjunto preestablecido de clases como "perro", "bicicleta" o "árbol", cuyo repertorio quedaba fijo en el momento del entrenamiento. En su lugar, el usuario puede introducir cualquier frase corta que desee, y la tecnología se moviliza para localizar las regiones visuales que encajen con esa descripción. Lo más notable es que la capacidad del modelo para realizar esta tarea persiste incluso si la frase específica ("paraguas rojo a rayas") nunca fue categorizada explícitamente como una etiqueta durante su etapa de formación. El modelo aprende a componer conceptos a partir de sus atributos, liberando el proceso de percepción visual de las restricciones taxonómicas del etiquetado tradicional. Este desarrollo marca la transición de un sistema de clasificación rígida a uno de interpretación semántica fluida, reflejando una comprensión más cercana a la cognición humana.

Para medir el impacto real de esta funcionalidad, los ingenieros de la compañía desarrollaron el SA-Co benchmark, una referencia de evaluación diseñada específicamente para la detección y segmentación de conceptos con grandes vocabularios en medios tanto estáticos como en movimiento. Las pruebas en este riguroso estándar arrojaron resultados categóricos a favor del nuevo modelo. La tecnología de Meta alcanzó aproximadamente el doble de rendimiento en la segmentación de conceptos complejos en comparación con referencias sólidas del sector, incluyendo competidores de alto calibre como Gemini 2.5 Pro y OWLv2. Este rendimiento superior subraya no solo una mejora incremental, sino un salto cualitativo en la comprensión visual composicional de los sistemas de percepción.

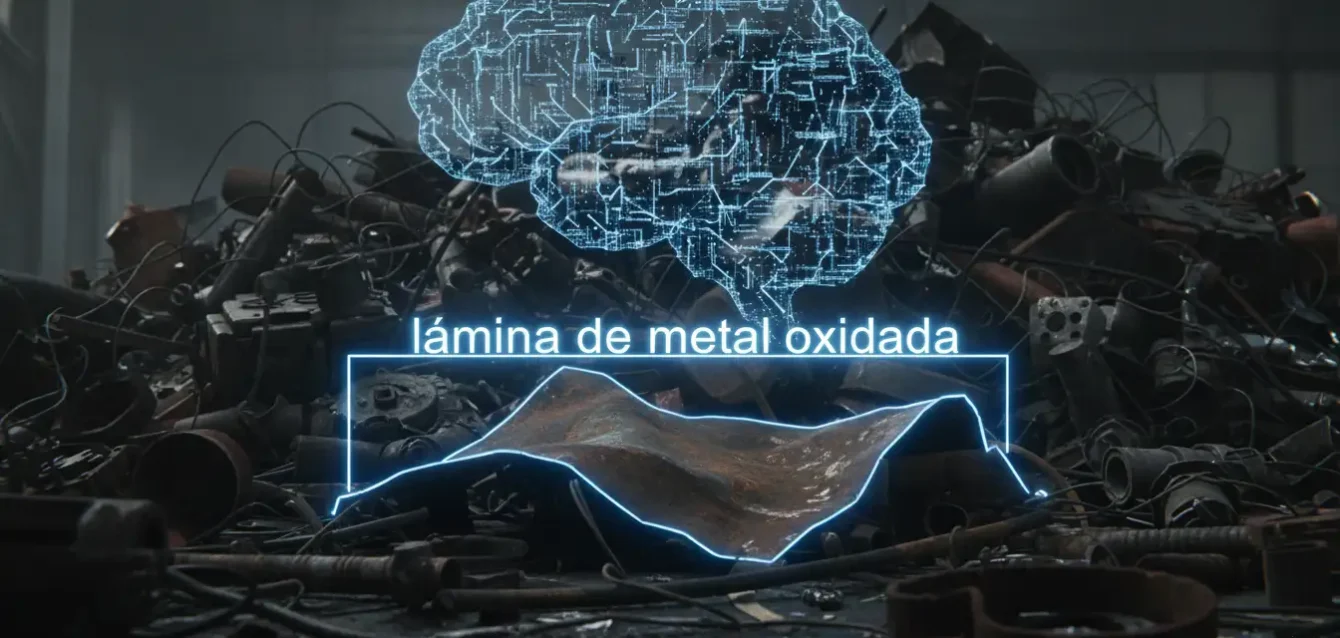

El significado de este doble rendimiento en el SA-Co benchmark es profundo, ya que valida la premisa central del diseño de SAM 3: que la visión artificial debe ser programable mediante el lenguaje, no solo clasificable mediante categorías. Mientras que modelos anteriores se basaban en la robustez de sus bases de datos de etiquetas fijas (por ejemplo, el modelo estaba optimizado para reconocer una "bicicleta" o un "perro"), SAM 3 sobresale en la recombinación de atributos. Cuando se le pide encontrar "el brillo metálico en la parte izquierda del vehículo", supera a sus competidores porque su entrenamiento no depende de una etiqueta única, sino de una comprensión granular de la textura, el color y la ubicación, haciendo irrelevante la rigidez de las listas de clases predefinidas. La victoria de SAM 3 en esta métrica es una victoria para la flexibilidad lingüística en la interacción hombre-máquina.

Ingeniería del dato y eficiencia operativa

La gesta técnica detrás del rendimiento mejorado de este sistema radica en una ingeniería de datos innovadora y una arquitectura de modelo unificada. La clave fue la creación de un motor de datos de ciclo cerrado, donde la propia tecnología de Meta desempeñó un papel central. El proceso comenzaba con el autoetiquetado: SAM 3 operaba en conjunto con un subtitulador basado en Llama y anotadores visuales Llama 3.2v para preetiquetar cantidades masivas de medios. Este primer paso automatizado permitía generar un borrador de etiquetas y segmentaciones a una velocidad sin precedentes.

Posteriormente, este vasto conjunto de datos era sometido a una etapa de limpieza por parte de verificadores humanos y sistemas automáticos. El motor de datos no solo aceleró la recopilación, sino que optimizó el proceso de corrección. Los ingenieros reportaron que este método de auto-etiquetado y verificación logró una detección de "negativos" (datos incorrectos o inútiles) aproximadamente cinco veces más rápida y una identificación de "positivos" (datos correctos) un 36 por ciento más veloz que los métodos manuales anteriores. El resultado final de esta factoría de datos es una colección de entrenamiento masiva, enriquecida con más de cuatro millones de conceptos etiquetados de forma compleja.

En el plano arquitectónico, el sistema de percepción unificado representa una consolidación maestra de tecnologías preexistentes, logrando que un solo modelo cubra tres funciones esenciales de la visión artificial: detección, segmentación y seguimiento. Bajo el capó, SAM 3 emplea el Meta Perception Encoder para procesar y codificar tanto el texto de entrada como la información de la imagen. La detección inicial de objetos se gestiona mediante un detector basado en la arquitectura DETR, un método conocido por su eficacia en la localización de instancias. Finalmente, la función de rastreo utiliza el SAM 2 tracker, complementado con un banco de memoria para mantener la coherencia temporal de los objetos en secuencias de vídeo. Esta unificación no es trivial; simplifica la cadena de procesamiento y elimina los cuellos de botella de latencia que surgían al tener que coordinar tres modelos especializados diferentes.

Este diseño sinérgico no solo es potente en sus capacidades, sino notablemente eficiente. En términos de rendimiento bruto, el modelo demuestra una velocidad impresionante: puede procesar una sola imagen en aproximadamente 30 milisegundos, incluso cuando debe identificar y segmentar más de cien objetos distintos en la escena. Esta rapidez es crucial para las aplicaciones en tiempo real, como la realidad aumentada o la robótica. En secuencias de vídeo, la tecnología mantiene una velocidad cercana al tiempo real, gestionando alrededor de cinco objetos segmentados y rastreados por fotograma, todo operando en una única GPU H200. Esta eficiencia lo posiciona como un bloque constructivo ideal para sistemas a gran escala que requieren precisión inmediata.

El impacto de esta eficiencia operativa no puede subestimarse. Al ofrecer detección, segmentación y rastreo en una única arquitectura y con pesos abiertos, la compañía tecnológica no solo está publicando una herramienta, sino que está impulsando la estandarización de componentes fundamentales para la visión artificial global. Los desarrolladores e investigadores pueden ahora integrar rápidamente capacidades sofisticadas de percepción en sus propios productos y experimentos, sin incurrir en la costosa y lenta tarea de entrenar y mantener múltiples modelos especializados. Esto es particularmente relevante en campos como la medicina diagnóstica o la vigilancia ambiental, donde la detección de patrones específicos y complejos es vital.

La combinación de velocidad y precisión convierte a SAM 3 en un catalizador para la próxima generación de robótica. En un entorno de fábrica o en vehículos autónomos, la capacidad de identificar instantáneamente un objeto (detección), trazar sus límites exactos (segmentación) y predecir su trayectoria a lo largo del tiempo (rastreo) son funciones que deben ejecutarse en milisegundos. La eficiencia del modelo en una GPU de uso relativamente común hace que la robótica de percepción avanzada sea mucho más accesible económicamente, permitiendo a los robots interactuar con el mundo no solo en términos de objetos fijos, sino de conceptos dinámicos y relacionales, por ejemplo, "la herramienta que el humano acaba de soltar" o "el reflejo del peligro inminente en el espejo".

El agente multimodal y las aplicaciones del bloque abierto

La verdadera trascendencia de SAM 3 se manifiesta a través del Agente Multimodal que lo acompaña. Este componente permite que un gran modelo de lenguaje (LLM) invoque las capacidades de SAM 3 para resolver consultas visuales composicionales de alta complejidad. En lugar de limitarse a describir una imagen, el LLM puede ahora preguntar: "Encuentra todas las mesas que tienen una taza de café azul encima". El LLM traduce la instrucción lingüística compleja en una solicitud para SAM 3, que ejecuta la tarea de segmentación y detección con precisión. Este mecanismo es el motor detrás del Segment Anything Playground, una interfaz simple que permite a usuarios y científicos interactuar directamente con estas capacidades unificadas.

Esta integración de lenguaje y visión permite la creación de sistemas de búsqueda y asistencia notablemente más inteligentes. Un ejemplo práctico se encuentra en la documentación técnica: si un ingeniero necesita encontrar todos los componentes de un tipo específico en una serie de diagramas o vídeos de ensamblaje, el agente multimodal puede identificar esos conceptos de forma instantánea y rastrearlos a lo largo del material. Esto trasciende la simple búsqueda de texto y lleva el concepto de "búsqueda" a la dimensión visual, permitiendo a las máquinas ejecutar tareas compuestas que hasta ahora requerían la intervención manual o sistemas dedicados mucho más lentos.

El carácter de "pesos abiertos" de SAM 3 subraya una estrategia deliberada por parte de Meta para convertir su innovación en un estándar de la industria. Al hacer accesible el modelo, la compañía fomenta su adopción masiva, lo que a su vez impulsa el desarrollo de aplicaciones y herramientas científicas basadas en su tecnología. La visión es clara: SAM 3 está diseñado para ser el bloque constructivo abierto y eficiente que cimenta los futuros sistemas de "encuentra este concepto y rastréalo". Este enfoque de código abierto garantiza que la tecnología no solo beneficie a las grandes empresas, sino que se convierta en una plataforma de innovación para la comunidad global de desarrolladores e investigadores. La implicación a largo plazo es una aceleración dramática en la forma en que se diseñan la robótica, los sistemas de navegación autónoma y las interfaces de usuario multimodales.

El impacto del sistema se extiende a la investigación pura. La liberación del SA-Co benchmark establece un nuevo nivel de exigencia para todos los futuros modelos de visión. Al demostrar que es posible alcanzar el doble de rendimiento que los modelos de la competencia en el reconocimiento de vocabulario abierto, Meta ha trazado un nuevo horizonte para la investigación en el campo. Los investigadores pueden ahora enfocar sus esfuerzos en la optimización de los modelos para superar esta nueva marca, acelerando la evolución de la tecnología de percepción visual más allá de los límites previamente aceptados.

La decisión de publicar el modelo con "pesos abiertos" es un movimiento estratégico que consolida la posición de Meta como un actor clave en la infraestructura de la inteligencia artificial. Mientras otros gigantes tecnológicos optan por mantener sus modelos de visión más avanzados en entornos cerrados, la apertura de SAM 3 asegura que cualquier desarrollador pueda descargar, modificar y utilizar el núcleo de la tecnología. Esto crea un efecto de red donde el ecosistema de aplicaciones construidas sobre esta base crece exponencialmente, cimentando el modelo como el estándar de facto. La comunidad se convierte en co-desarrolladora, encontrando fallos, optimizando el rendimiento y extendiendo las capacidades del sistema a dominios especializados, desde la arqueología visual hasta el control de calidad industrial.

La promesa de la segmentación conceptual abierta

El avance más significativo de SAM 3 reside en la segmentación conceptual abierta, que rompe con la restricción histórica de los modelos de visión a un vocabulario fijo de etiquetas predefinidas. En lugar de limitarse a identificar categorías amplias ("silla", "botella"), el sistema puede entender y segmentar conceptos compuestos y descriptivos solicitados por el usuario ("silla de madera tallada con cojín rojo"). Este salto permite que la interacción con el mundo visual sea tan matizada como el lenguaje humano, transformando la máquina de un simple catalogador a un intérprete conceptual activo. La implementación de esta funcionalidad abre puertas a una personalización y precisión sin precedentes en aplicaciones industriales, médicas y de consumo masivo.

En retrospectiva, la unificación lograda por SAM 3 (detección, segmentación y rastreo en un solo modelo eficiente) es un hito que simplificará radicalmente la arquitectura de software en la percepción por ordenador. Anteriormente, estos tres componentes requerían módulos separados, a menudo entrenados con datos dispares, lo que introducía latencia y complejidad en el diseño del sistema. Al consolidar las tres capacidades bajo una arquitectura coherente y eficiente en hardware estándar, Meta no solo ofrece un rendimiento superior, sino que reduce significativamente la barrera de entrada para la creación de productos de visión sofisticados. Esto beneficia especialmente a las pequeñas empresas y a los equipos de investigación que operan con recursos limitados, al ofrecerles un bloque funcional de alto nivel sin la necesidad de una infraestructura computacional masiva.

La eficiencia demostrada por el sistema tiene implicaciones directas en la sostenibilidad de los proyectos de visión. Al requerir solo una GPU H200 para el procesamiento en tiempo casi real de secuencias de vídeo, la necesidad de infraestructuras de clúster masivas se reduce para muchas aplicaciones. Esta optimización energética no solo abarata el desarrollo, sino que también minimiza la huella de carbono de los sistemas de visión a gran escala. Es un ejemplo de cómo los avances algorítmicos, complementados con una arquitectura de modelo refinada, pueden proporcionar ganancias significativas en eficiencia que se traducen en un ahorro de recursos tangible, haciendo la tecnología más viable para su implementación global en la periferia de la red y en dispositivos con recursos limitados.

En esencia, SAM 3 no es solo un modelo más rápido o más preciso; es la materialización de un cambio filosófico en la forma en que las máquinas interactúan con el entorno visual. Ya no solo "ven" objetos; ahora pueden "comprender" los conceptos y atributos que componen esos objetos, y hacerlo a la velocidad de la luz. Este avance consolida el liderazgo de Meta en el impulso de la tecnología de visión artificial abierta y unificada, marcando el inicio de una nueva era donde la percepción visual de las máquinas finalmente puede seguir el ritmo de la complejidad y el matiz del lenguaje humano.

Referencias

Meta AI Research. Anuncio oficial y documentación técnica de Segment Anything Model 3 (SAM 3). (Noviembre, 2025).

SA-Co Benchmark. Documento de investigación detallando el nuevo estándar para la detección de conceptos con gran vocabulario. (Meta AI, 2025).

Análisis comparativo de rendimiento: SAM 3, Gemini 2.5 Pro y OWLv2 en tareas de segmentación visual. (Datos de la publicación oficial de Meta, 2025).

Publicación sobre la arquitectura DETR y su rol en los sistemas de detección de objetos. (Facebook AI Research).

Detalles técnicos sobre el entrenamiento del Llama 3.2v annotator y el Meta Perception Encoder.