Mientras OpenAI celebraba el lanzamiento de GPT-5 con fanfarrias corporativas y promesas de seguridad mejorada, Ant Group, el titán financiero chino dueño de Alipay, hacía algo radicalmente distinto: liberar al dominio público el primer modelo de razonamiento con un billón de parámetros completamente accesible para cualquier desarrollador en el mundo. Ring-1T-preview no solo marca un hito técnico sin precedentes, sino que redefine las reglas del juego en la carrera global por la inteligencia algorítmica. La decisión de compartir abiertamente una arquitectura de esta magnitud constituye una apuesta estratégica que podría alterar permanentemente el equilibrio de poder tecnológico.

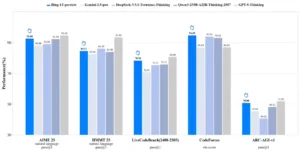

Los números hablan con contundencia: en la prueba AIME 2025, diseñada para medir capacidades de razonamiento matemático avanzado, Ring-1T-preview alcanzó 92.6 puntos, superando a todos los modelos de código abierto conocidos y dejando atrás a Gemini 2.5 Pro de Google. Más relevante aún, se ubicó a solo dos puntos de distancia de GPT-5, el modelo insignia de OpenAI que requiere infraestructura cerrada y costosa. Pero donde Ring-1T-preview realmente brilla es en CodeForces, la plataforma competitiva de programación donde obtuvo 94.69 puntos, superando directamente al sistema de Sam Altman y posicionándose como líder absoluto en generación de código entre sistemas abiertos.

La arquitectura subyacente merece atención detallada. Construido sobre la familia Ling 2.0 de Ant Group, Ring-1T-preview emplea una configuración de Mezcla de Expertos (MoE, por sus siglas en inglés) que alcanza un billón de parámetros totales, aunque solo activa aproximadamente 50 mil millones por cada token procesado. Esta ingeniería inteligente reduce drásticamente los costos computacionales sin sacrificar potencia. El modelo fue preentrenado con más de 20 billones de tokens, una cifra que supera las capacidades de entrenamiento de muchos competidores occidentales, y posteriormente refinado mediante aprendizaje por refuerzo con recompensas verificables (RLVR), utilizando el algoritmo propietario Icepop y el sistema AReaL, ambos desarrollados internamente por el equipo BaiLing.

Cuando las matemáticas olímpicas encuentran su rival sintético

El verdadero examen de fuego llegó con la Olimpíada Internacional de Matemáticas 2025, una competencia que históricamente ha humillado incluso a los sistemas más avanzados. Ring-1T-preview, integrado en el marco multiagente AWorld, resolvió completamente el problema tres en un solo intento y proporcionó soluciones parcialmente correctas para los problemas uno, dos, cuatro y cinco. Este desempeño equivale a nivel de medalla de plata olímpica mediante razonamiento puramente lingüístico, sin recurrir a herramientas externas ni búsquedas en la web. El equipo de Ant afirma estar continuando el entrenamiento con la ambición explícita de alcanzar nivel de medalla de oro en próximas iteraciones.

En la versión completa Ring-1T, lanzada recientemente tras semanas adicionales de entrenamiento intensivo, las mejoras resultan aún más notables. El sistema logró resolver los problemas uno, tres, cuatro y cinco del IMO 2025 en un primer intento, consolidando su estatus de medalla de plata. En el tercer intento, produjo una demostración casi perfecta para el problema de geometría número dos. Particularmente intrigante resulta su aproximación al infame problema seis, donde convergió a la respuesta «4048», idéntico resultado al de Gemini 2.5 Pro, aunque la solución correcta es 2112. Ningún competidor algorítmico logró resolver correctamente esta pregunta durante la competencia oficial.

La versatilidad del sistema trasciende las matemáticas puras. En LiveCodeBench v6, que evalúa generación de código en condiciones realistas, Ring-1T alcanzó 78.3 puntos y lideró la clasificación entre modelos de código abierto. En el Harvard-MIT Mathematics Tournament 2025, obtuvo 84.5 puntos, demostrando razonamiento matemático estructurado mediante respuestas en lenguaje natural. En ARC-AGI-1, el benchmark diseñado para medir inteligencia fluida y capacidad de abstracción, registró 50.8 puntos, nuevamente encabezando los rankings de sistemas abiertos. Y en Arena-Hard v2, que mide alineación con preferencias humanas, Ring-1T consiguió 81.59% de éxito, acercándose al 82.91% de GPT-5-Thinking en modo alto.

Las pruebas más reveladoras ocurrieron en terrenos competitivos reales, no en benchmarks académicos controlados. Durante las Finales Mundiales del ICPC 2025 (International Collegiate Programming Contest), los investigadores compararon directamente GPT-5-Thinking, Gemini-2.5-Pro y Ring-1T. Con tres intentos permitidos para resolver problemas directamente, los modelos consiguieron resolver seis, tres y cinco problemas respectivamente. Ring-1T resolvió los problemas D, F, J, K y L, superando a Gemini pero quedando ligeramente detrás de GPT-5. Sin embargo, considerando que Ring-1T es completamente de código abierto mientras sus rivales permanecen cerrados, el resultado representa una victoria estratégica para Ant Group.

En el ámbito médico, Ring-1T también destaca. En HealthBench, la evaluación especializada de respuestas clínicas rigurosas, alcanzó la puntuación más alta entre todos los sistemas de código abierto, demostrando aplicabilidad más allá de dominios puramente lógicos o matemáticos. Incluso en escritura creativa, evaluada mediante Creative Writing v3, exhibió competitividad robusta, sugiriendo que el modelo no sacrifica habilidades generales en favor de especialización excesiva.

La infraestructura que sostiene estos logros merece reconocimiento propio. El sistema ASystem, desarrollado por Ant, representa un marco de aprendizaje por refuerzo de alto rendimiento capaz de entrenar arquitecturas a escala de billón de parámetros. Implementa pools de memoria unificados para entrenamiento e inferencia, liberación transparente de memoria mediante técnicas de offloading, comunicación directa punto a punto entre GPUs y actualizaciones en lugar que eliminan redundancias. Para el componente de recompensas verificables, Ant construyó un sistema híbrido utilizando tecnología Serverless Sandbox a gran escala, capaz de inicializarse en milisegundos y soportar más de 10,000 solicitudes por segundo con entornos de ejecución aislados para más de diez lenguajes de programación.

La estrategia del código liberado

La decisión de Ant Group de liberar tanto los pesos del modelo como las recetas de entrenamiento constituye una maniobra calculada con múltiples dimensiones estratégicas. Al hacer accesible una arquitectura de billón de parámetros, la empresa se posiciona como proveedor de infraestructura para la próxima generación de aplicaciones algorítmicas avanzadas. Los desarrolladores globales ahora pueden construir sistemas especializados sobre Ring-1T sin necesidad de inversiones masivas en entrenamiento desde cero. Esta democratización tecnológica contrasta marcadamente con el enfoque propietario de OpenAI, Google y Anthropic, quienes mantienen sus sistemas más potentes bajo llave.

Ant Group opera ahora dos laboratorios paralelos de investigación algorítmica: el equipo Qwen, enfocado en modelos de lenguaje general, y el laboratorio BaiLing, responsable de Ring-1T. Esta estructura bicéfala garantiza innovación rápida desde múltiples frentes. Qwen se concentra en aplicaciones amplias y versatilidad conversacional, mientras BaiLing empuja los límites del razonamiento profundo y resolución de problemas complejos. Juntos, señalan la ambición de Ant de convertirse en líder global de inteligencia general artificial mediante paradigmas abiertos.

La familia completa de modelos Ling 2.0 ahora incluye 18 sistemas diferentes, desde 16 mil millones hasta un billón de parámetros totales. Ring-1T representa la serie de razonamiento profundo, optimizada para pensamiento prolongado y cadenas lógicas extendidas. Ling-1T, el hermano gemelo general recientemente lanzado, ofrece desempeño equilibrado en tareas diversas con límites estrictos de tokens de salida. Ming constituye la serie multimodal, capaz de procesar información más allá del texto. Y LLaDA-MoE opera como modelo experimental explorando fronteras técnicas. Esta taxonomía estratificada permite a desarrolladores seleccionar arquitecturas específicas según necesidades precisas, desde aplicaciones conversacionales hasta investigación científica computacionalmente intensiva.

El contexto geopolítico añade capas adicionales de significado. China ha invertido agresivamente en infraestructura algorítmica como respuesta a restricciones occidentales en acceso a semiconductores avanzados. Empresas como Ant, Alibaba (su matriz corporativa) y ByteDance compiten ferozmente no solo entre sí sino contra gigantes estadounidenses, buscando establecer estándares técnicos globales antes que regulaciones internacionales solidifiquen ventajas incumbentes. La apertura de Ring-1T funciona simultáneamente como declaración de capacidad técnica y como herramienta de influencia soft power: al empoderar comunidades globales de desarrolladores, Ant cultiva ecosistemas dependientes de sus arquitecturas fundamentales.

El modelo también introduce innovaciones técnicas específicas para abordar desafíos únicos de sistemas a escala de billón de parámetros. La discrepancia entre precisión de entrenamiento e inferencia, problema endémico en arquitecturas MoE, se maneja mediante el algoritmo Icepop, que utiliza técnicas de truncamiento bidireccional enmascarado para congelar diferencias de distribución en niveles bajos, asegurando entrenamiento estable durante secuencias largas y períodos extendidos. Para intercambio de pesos entre motores de entrenamiento e inferencia, Ant implementó tecnología de memoria unificada propietaria que permite transferencias sin redundancia a nivel de segundo mediante comunicación P2P directa entre GPUs y actualizaciones en lugar.

Especificaciones técnicas y rendimiento en benchmarks

Arquitectura fundamental:

- Parámetros totales: 1 billón (1T)

- Parámetros activos por token: ~50 mil millones (50B)

- Arquitectura: Mezcla de Expertos (MoE) basada en Ling 2.0

- Ventana de contexto: 128,000 tokens

- Entrenamiento base: Más de 20 billones de tokens

- Método de refinamiento: RLVR (Reinforcement Learning with Verifiable Rewards)

- Algoritmo propietario: Icepop para estabilidad de entrenamiento

- Sistema RL: ASystem con framework AReaL (código abierto)

Desempeño en matemáticas:

- AIME 2025: 92.6 puntos (GPT-5: 94.6 | Gemini 2.5 Pro: inferior)

- HMMT 2025: 84.5 puntos

- IMO 2025: Medalla de plata (4 problemas resueltos en primer intento)

- Ling-1T (versión general): 70.42% de precisión en AIME 2025 con promedio de 4,000+ tokens de salida por problema

Desempeño en generación de código:

- CodeForces: 94.69 puntos (superior a GPT-5)

- LiveCodeBench v6: 78.3 puntos (líder entre modelos abiertos)

- ICPC World Finals 2025: 5 problemas resueltos en tres intentos (D, F, J, K, L)

Desempeño en razonamiento lógico:

- ARC-AGI-1: 50.8 puntos (líder entre modelos de código abierto)

Desempeño en tareas generales:

- Arena-Hard v2: 81.59% tasa de éxito (GPT-5-Thinking High: 82.91%)

- HealthBench: Puntuación más alta en dominio de código abierto

- Creative Writing v3: Competitividad robusta

Infraestructura técnica:

- Sistema RL: ASystem con capacidad de escalar desde 10B hasta 1T parámetros

- Sandbox híbrido: Inicialización en milisegundos, +10,000 req/s, soporte para 10+ lenguajes

- Gestión de memoria: Pool unificado con offloading transparente y comunicación P2P entre GPUs

- Intercambio de pesos: Zero-redundancia con actualizaciones en lugar a nivel de segundo

Disponibilidad:

- Plataformas: HuggingFace, Moda Community

- Formato: Pesos completos y recetas de entrenamiento abiertos

- Integración: Compatible con Transformers, marco multiagente AWorld

- Experiencia online: Plataforma Ant Treasure Box

Referencias:

- Ant Group. Comunicados oficiales sobre Ring-1T-preview y Ring-1T. Septiembre-Octubre 2025.

- HuggingFace. Documentación técnica de inclusionAI/Ring-1T y Ring-1T-preview.

- Pandaily. Cobertura sobre lanzamiento de modelo de billón de parámetros de Ant Group.

- TechNode. Análisis de benchmarks y comparativas con GPT-5.

- Medium (Ant Ling). «Ring-1T Release: The Flow State of Insight, Born of Epiphany.»

- FinTech Weekly. Reporte sobre Ling-1T y estrategia comercial de Ant Group.

- Business Wire. Anuncio corporativo de familia de modelos Ling y lanzamiento de Ling-1T.

- Asia Business Outlook. Análisis estratégico del posicionamiento de Ant Group en competencia global.

- TechWireAsia. Cobertura de framework dInfer y comparativas con soluciones de Nvidia.