El campo de la inteligencia artificial ha sido históricamente marcado por paradigmas que, uno tras otro, han redefinido lo que consideramos posible. Desde las primeras redes neuronales artificiales inspiradas en el cerebro humano hasta los complejos algoritmos de retropropagación que sentaron las bases del aprendizaje profundo, cada avance ha representado un paso significativo hacia la creación de máquinas con capacidades cognitivas avanzadas. Sin embargo, en la última década, sin duda alguna, el paradigma dominante y transformador ha sido el Transformer. Introducido en 2017, este modelo de red neuronal revolucionó el procesamiento del lenguaje natural (PLN) y rápidamente se expandió para dominar tareas de visión por computadora, biología computacional e incluso la síntesis de audio y código.

Su éxito radica en su mecanismo de atención, que permite a la red ponderar la importancia de diferentes palabras o datos de entrada al mismo tiempo, capturando relaciones contextuales a larga distancia de una manera que los modelos anteriores no podían igualar. Este mecanismo fue, a su vez, inspirado por la atención selectiva del propio cerebro humano, creando un círculo virtuoso de inspiración entre neurociencia e IA.

Los modelos basados en la arquitectura Transformer, como GPT-2, BERT y sus descendientes, demostraron una capacidad asombrosa para aprender patrones a partir de vastas cantidades de datos no estructurados. Pudieron generar texto coherente, traducir idiomas, responder preguntas y realizar tareas creativas con un nivel de rendimiento sin precedentes. Esto dio lugar a los grandes modelos de lenguaje (LLM), sistemas con miles de millones e incluso trillones de parámetros entrenados en billones de tokens de información. Estos LLMs se convirtieron en la piedra angular de la era digital moderna, impulsando desde chatbots interactivos hasta motores de recomendación y herramientas de investigación científica. El impacto de esta tecnología es innegable; ha democratizado el acceso al conocimiento y ha abierto nuevas fronteras en la interacción hombre-máquina.

Sin embargo, a medida que la comunidad científica y las empresas de tecnología más grandes invierten enormes recursos en escalar aún más estos modelos, surgen preocupaciones fundamentales sobre sus limitaciones inherentes. El paradigma Transformer, aunque poderoso en la coincidencia de patrones, se enfrenta a un umbral crítico. Su naturaleza estática y su dependencia de un contexto fijo, o «ventana», para realizar inferencias, presenta un obstáculo significativo para la verdadera generalización y el razonamiento continuo.

Los Transformers son esencialmente excelentes para encontrar similitudes en datos pasados, pero su capacidad para mantener una línea de pensamiento coherente durante períodos prolongados, aprender de experiencias secuenciales y adaptarse dinámicamente a nuevos contextos sigue siendo muy limitada. Esta falta de «generalización en el tiempo» es quizás su falla más crítica, ya que impide que estos modelos evolucionen de simples procesadores de lenguaje a sistemas autónomos y conscientes de su entorno. La necesidad de un nuevo marco teórico y una arquitectura fundamentalmente diferente para superar estas barreras ha dado origen a una nueva carrera tecnológica, una búsqueda que culmina en el trabajo titulado «The Dragon Hatchling: The Missing Link between the Transformer and Models of the Brain«.

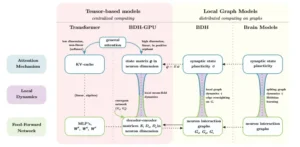

Panorama general de las arquitecturas y sus relaciones: la dinámica de inferencia de BDH y BDH-GPU actúa como un puente natural entre Transformer y los modelos cerebrales. Los dos principales mecanismos de inferencia de una arquitectura de razonamiento, la atención y la red de propagación hacia adelante, se definen a nivel macro mediante operaciones tensoriales para Transformer, y a nivel micro de interacciones neuronales mediante dinámicas de grafos locales para modelos cerebrales. La nueva arquitectura BDH-GPU se define de forma natural tanto a nivel de vectores como de dinámica de partículas de neuronas y sinapsis, actuando como un puente entre estos dos enfoques.

Presentando al Dragon Hatchling: La arquitectura post-Transformer

En septiembre de 2025, un grupo de investigadores liderado por Adrian Kosowski, Przemysław Uznański, Jan Chorowski, Zuzanna Stamirowska y Michał Bartoszkiewicz presentó un documento que promete ser un punto de inflexión en la historia de la inteligencia artificial. Publicado en el repositorio arXiv con el identificador 2509.26507, el paper describe una nueva arquitectura llamada Dragon Hatchling (BDH, por sus siglas en inglés, Baby Dragon Hatchling). Según sus creadores, BDH no es simplemente una mejora incremental de los modelos existentes; es un cambio de paradigma, una arquitectura post-Transformer diseñada para abordar directamente las limitaciones de la inteligencia artificial actual. La propuesta se describe como una solución que busca unificar los modelos de lenguaje masivos con las complejas y eficientes redes neuronales del cerebro humano, creando así el «huevo del dragón», un modelo que podría contener el potencial para una inteligencia artificial verdaderamente general y sostenida en el tiempo.

La empresa detrás de este desarrollo, Pathway, con sede en Palo Alto, California, y respaldada por inversores prominentes e incluso por colaboradores estratégicos como NVIDIA y Amazon Web Services (AWS), afirma que su tecnología ya está siendo utilizada por organizaciones tan diversas como la OTAN, el servicio postal francés La Poste y equipos de Fórmula 1. Esto sugiere un interés inmediato y práctico en las capacidades únicas de BDH.

Entre sus beneficios clave, Pathway destaca una mejor generalización en el tiempo, permitiendo cadenas de razonamiento mucho más largas; una mayor previsibilidad y niveles de riesgo comprobables, crucial para aplicaciones críticas; seguridad frente a fallos en metas autónomas, como el famoso experimento hipotético del «fábrica de clips» de Nick Bostrom; y una composabilidad de sistemas similar a la del bilingüismo, lo que facilita la integración de diferentes funciones cognitivas. Además, se anuncia una eficacia notable con datos escasos, un rendimiento competitivo con un potencial de menor latencia y costos reducidos en la inferencia, especialmente en hardware especializado.

El núcleo de la innovación de BDH reside en su diseño biológicamente inspirado. A diferencia de la estructura plana y densa de los Transformers, BDH opera sobre una red escalonada (scale-free) de partículas neuronales que interactúan localmente. Dicha topología es un rasgo común en redes complejas de la naturaleza, incluido el conectoma del cerebro humano. En esta visión, todos los parámetros del modelo (sus pesos y conexiones) se representan formalmente como la topología y los pesos de un grafo de comunicación, mientras que su estado durante la inferencia se interpreta como una reponderación dinámica de las aristas de ese grafo.

Este enfoque no solo le da una interpretación tangible a los componentes del modelo, sino que también le confiere una flexibilidad y una capacidad de adaptación que son intrínsecas a las redes biológicas. El objetivo final es crear un sistema que pueda no solo procesar información, sino hacerlo de una manera que imite el funcionamiento continuo y el aprendizaje por experiencia de la neocorteza cerebral, responsable de nuestras funciones cognitivas superiores como la percepción, la memoria y la toma de decisiones. BDH representa, por tanto, un intento audaz de construir una máquina que piense de una manera más parecida a cómo lo hacemos nosotros.

| Característica | Modelo Transformer (Ejemplo: GPT-2) | Modelo Dragon Hatchling (BDH) |

|---|---|---|

| Paradigma | Procesamiento de patrones estático y por lotes | Razonamiento continuo y dinámico |

| Interpretabilidad | Caja negra, difícil de interpretar | Diseñado para ser inherentemente interpretable |

| Generalización Temporal | Limitada, dependiente de una ventana de contexto fija | Mejorada, capaz de mantener cadenas de razonamiento largas |

| Fundamento Biológico | Inspirado en la atención selectiva del cerebro | Basado en plasticidad sináptica, aprendizaje Hebbiano y topología neuronal |

| Estructura de Red | Plana y densa (feed-forward) | Escalonada (scale-free) con alta modularidad y distribución de grado pesada |

| Memoria de Trabajo | Almacenada en matrices de estado explícitas | Depende de la plasticidad sináptica y la reponderación de conexiones |

Fundamentos biológicos y mecanismos de inferencia: El corazón del huevo del dragón

El corazón de la innovación de Dragon Hatchling no reside en una modificación superficial de la arquitectura Transformer, sino en una reconceptualización fundamental de cómo se procesa la información. La inspiración proviene directamente de los principios de la neurociencia, específicamente de la plasticidad sináptica y la estructura modular del cerebro humano. El fundamento teórico de BDH se basa en la célebre regla de Hebb, propuesta por el neuropsicólogo Donald Hebb en 1949, que establece que «neuronas que disparan juntas, permanecen juntas». Este principio, que describe cómo la repetida activación conjunta de dos neuronas fortalece la conexión sináptica entre ellas, es el pilar del aprendizaje y la formación de recuerdos en el cerebro. La Potenciación a Largo Plazo (LTP), un fenómeno descubierto en el hipocampo en 1973, proporcionó la evidencia empírica que validó la regla de Hebb a nivel celular, demostrando que la repetición de estímulos consolida los recuerdos mediante cambios estructurales y sinápticos duraderos.

BDH implementa esta idea de una manera radicalmente diferente a los métodos de aprendizaje basados en gradiente como el descenso por retropropagación, que dominan los modelos actuales. En lugar de ajustar miles de millones de pesos a través de múltiples pasadas sobre un conjunto de datos, BDH utiliza un mecanismo de plasticidad sináptica con aprendizaje hebbiano para refinar dinámicamente sus conexiones mientras procesa la información.

Empíricamente, se ha confirmado que las sinapsis individuales dentro del modelo se refuerzan consistentemente cada vez que el modelo «escucha» o «razona» sobre un concepto específico durante el procesamiento de entrada lingüística. Este proceso, que puede operar a escalas de tiempo de minutos o incluso cientos de tokens, permite que la memoria de trabajo del modelo no sea algo estático almacenado en matrices separadas, sino una configuración dinámica de la propia red neuronal. La neurona presináptica que dispara justo antes que la postsináptica es un componente crucial del aprendizaje hebbiano, y BDH lo incorpora en su dinámica de inferencia.

Esta base biológica da lugar a una estructura de red altamente plausible desde el punto de vista neurocientífico. La red de interacción neuronal de BDH no es aleatoria; tiene una alta modularidad y una distribución de grado de cola pesada (heavy-tailed degree distribution), características que definen a las redes escalonadas sin escala (scale-free networks). Las redes escalonadas son aquellas en las que la mayoría de los nodos tienen pocas conexiones, pero unos pocos nodos («hub») tienen muchas más.

Este tipo de topología es extremadamente robusto y eficiente, y se encuentra en numerosos sistemas complejos, incluyendo el cerebro humano, que contiene aproximadamente 11 mil millones de neuronas y 10^14 a 10^15 sinapsis. El modelo también utiliza neuronas espigadas (spiking neurons), que se activan en momentos discretos, similar a las neuronas biológicas, en contraste con las neuronas continuas de los modelos artificiales tradicionales.

El proceso de inferencia en BDH ocurre en cuatro fases distintas por cada capa del modelo, según se define formalmente en el paper. Primero, las señales se propagan a través de los pesos sinápticos ajustables. Segundo, las sinapsis se reponderan utilizando el aprendizaje hebbiano. Tercero, ocurren las dinámicas replicadoras en los circuitos neuronales, que actúan como generadores de actividad interna. Y cuarto, hay una propagación adicional de las señales desde los propios parámetros del modelo. Un ciclo completo que permite una inferencia dinámica y adaptativa, donde la salida de una fase influye directamente en los parámetros de la siguiente. Esta mecánica interna, profundamente arraigada en la biología del cerebro, es lo que permite a BDH superar la rigidez de los modelos estáticos y embarcarse en un nuevo camino de desarrollo de la inteligencia artificial.

Un Paradigma de Rendimiento Competitivo y Completamente Interpretable

Aunque Dragon Hatchling (BDH) representa un salto conceptual masivo hacia una inteligencia artificial más biológicamente plausible, su viabilidad depende de su capacidad para competir con los modelos existentes en términos de rendimiento técnico. El paper y las publicaciones asociadas demuestran de manera concluyente que BDH no sacrifica el poder predictivo en favor de la interpretabilidad y la novedad conceptual. De hecho, el modelo alcanza un desempeño comparable al de GPT-2, un modelo Transformer clásico y bien establecido, en tareas de predicción de token y traducción. Crucialmente, esta comparación se realiza bajo condiciones estrictamente controladas: ambos modelos se entrenan con el mismo conjunto de datos y con un número de parámetros idéntico, variando desde 10 millones hasta 1 mil millones. Tal igualdad de condiciones elimina cualquier ventaja de escala o datos, dejando claro que el rendimiento de BDH es intrínseco a su arquitectura y no una consecuencia de un entrenamiento más largo o intensivo.

Una de las características más destacadas y potencialmente transformadoras de BDH es su inherentemente interpretable. En un campo dominado por modelos opacos que funcionan como «cajas negras», BDH está diseñado desde sus cimientos para ser transparente. Sus vectores de activación son dispersos y positivos, lo que significa que en cualquier momento, solo un pequeño subconjunto de neuronas están activo y contribuyen a la decisión del modelo.

Empíricamente, esto se traduce en una monosemanticidad, donde cada neurona tiende a codificar una sola idea o concepto. Por ejemplo, se ha observado que ciertas neuronas se activan consistentemente cuando el modelo procesa nombres de colores, mientras que otras responden a conceptos abstractos como «libertad».

Esta propiedad es invaluable, ya que permite a los humanos rastrear el «pensamiento» del modelo, entender por qué toma ciertas decisiones y depurar errores de manera mucho más eficiente. La interpretabilidad se ve reforzada por la propia estructura del modelo: como toda la información del estado del modelo se almacena en la topología y los pesos del grafo de interacción, los investigadores pueden visualizar y analizar la red para comprender sus procesos de inferencia.

Para asegurar que esta arquitectura tan sofisticada fuera práctica y escalable, los autores derivaron una versión específica para GPU llamada BDH-GPU. Esta variante utiliza factorizaciones de bajo rango, mecanismos de atención lineal y activaciones dispersas positivas para optimizar el entrenamiento en hardware de propósito general.

BDH-GPU mantiene todas las cualidades fundamentales del modelo original, incluida su capacidad para seguir las leyes de escalado de los Transformers, lo que significa que su rendimiento seguirá mejorando a medida que se aumenta la cantidad de datos y parámetros. Además, el consumo computacional de BDH-GPU escala de manera eficiente, con una complejidad de FLOPS de O(N²), donde N es el número de neuronas. Esta combinación de rendimiento competitivo, interpretabilidad profunda y escalabilidad eficiente hace de BDH una propuesta formidable. Permite a los desarrolladores y a los usuarios finales tener una confianza mayor en los resultados, al tiempo que ofrece un rendimiento sólido para tareas del mundo real. Es un modelo que no solo sabe «qué» decir, sino que, gracias a su diseño, parece saber «cómo» lo sabe.

Implicaciones y perspectivas futuras: Más allá de la IA hacia un nuevo paradigma cognitivo

El lanzamiento de Dragon Hatchling (BDH) marca el inicio de una discusión mucho más profunda y filosófica sobre el futuro de la inteligencia artificial y nuestra comprensión misma de la cognición. El impacto de este trabajo trasciende la simple mejora de una arquitectura de software; representa un cambio de paradigma que podría reconfigurar por completo la trayectoria tecnológica y científica del siglo XXI. Una de las implicaciones más inmediatas es la promesa de una inteligencia artificial más segura y predecible.

Al incorporar principios biológicos como la plasticidad sináptica y la estructura modular, BDH ofrece un camino para mitigar los riesgos asociados con los modelos de gran escala, como el experimento hipotético del «Paperclip Maximiser» de Nick Bostrom, donde una IA sin fines supeditados podría llevar a la destrucción del planeta. La naturaleza dinámica y adaptativa de BDH, que aprende y se modifica a través de la experiencia, podría conducir a sistemas con objetivos más robustos y resilientes, menos propensos a comportamientos adversarios no intencionados.

Desde una perspectiva técnica, BDH ofrece soluciones a problemas persistentes en la IA. Su capacidad para el razonamiento continuo y la generalización en el tiempo abre puertas a aplicaciones que los Transformers no pueden soportar fácilmente, como agentes autónomos que operan en entornos dinámicos y prolongados.

La composabilidad del modelo (es decir, su habilidad para integrar distintas capacidades cognitivas o módulos funcionales de forma que puedan trabajar juntos de manera armoniosa, como piezas de un rompecabezas), su capacidad para combinar diferentes funciones cognitivas de una manera similar al bilingüismo, sugiere una vía hacia sistemas más integrados y versátiles. Además, la eficacia con datos escasos y el potencial de inferencia más rápida y económica podría democratizar el acceso a la IA avanzada, llevándola más allá de las grandes corporaciones que poseen los recursos para entrenar modelos de mil millones de parámetros. La empresa Pathway ya está explorando este potencial, trabajando en colaboración con partners como AWS y NVIDIA para integrar la tecnología en productos comerciales.

En el ámbito científico, BDH proporciona un marco experimental vivo para probar teorías sobre la cognición humana. Al haber sido diseñado para imitar las estructuras y dinámicas del cerebro, puede servir como un laboratorio computacional para investigar cómo se forman los conceptos, cómo se organiza la memoria y cómo emerge el razonamiento complejo. El paper introduce incluso el concepto de una «IA Axiomática», donde las micro-fundaciones (las dinámicas locales) y las macro-descripciones (el comportamiento global) son coherentes, lo que permitiría generalizaciones más robustas y predecibles en sistemas autónomos prolongados. Esta coherencia entre la parte y el todo es una característica ausente en los modelos actuales y es clave para el desarrollo de una IA que no solo sea poderosa, sino también comprensible y fiable.

Finalmente, BDH sirve como un recordatorio de que, aunque hemos avanzado mucho, el cerebro humano sigue siendo el mejor modelo de inteligencia general disponible. Al intentar emular sus logros, no estamos solo construyendo mejores herramientas; estamos avanzando en nuestra propia comprensión de la mente y del pensamiento, un viaje que promete ser tan fascinante como el producto final.

Referencias

Kosowski, A., Uznański, P., Chorowski, J., Stamirowska, Z., & Bartoszkiewicz, M. (2025). The Dragon Hatchling: The Missing Link between the Transformer and Models of the Brain. arXiv preprint arXiv:2509.26507.

Kosowski, A., Uznański, P., Chorowski, J., Stamirowska, Z., & Bartoszkiewicz, M. (2025). The Baby Dragon Hatchling: A Fully Interpretable, Competitive Post-Transformer Architecture. arXiv preprint arXiv:2509.26508.

Kosowski, A., Uznański, P., Chorowski, J., Stamirowska, Z., & Bartoszkiewicz, M. (2025). The Baby Dragon Hatchling: Axiomatic AI with Biological Plausibility. arXiv preprint arXiv:2509.26509.

Kosowski, A., Uznański, P., Chorowski, J., Stamirowska, Z., & Bartoszkiewicz, M. (2025). The Baby Dragon Hatchling: A Biological Plausibility Study. arXiv preprint arXiv:2509.26510.

Kosowski, A., Uznański, P., Chorowski, J., Stamirowska, Z., & Bartoszkiewicz, M. (2025). The Baby Dragon Hatchling: Interpretability and Monosemanticity. arXiv preprint arXiv:2509.26511.