Los modelos de lenguaje multimodal más avanzados del mundo tienen un problema secreto. Pueden analizar imágenes individuales con precisión notable. Pueden responder preguntas sobre clips de video cortos. Pueden manejar millones de tokens de contexto. Pero cuando enfrentan lo que debería ser una tarea simple, rastrear objetos y contar instancias a través de flujos de video largos y continuos, colapsan espectacularmente.

No es porque los videos sean demasiado largos. No es porque la computación sea insuficiente. Es porque estos modelos están construidos sobre una arquitectura fundamentalmente equivocada para cómo funciona realmente la percepción espacial continua. Ven el mundo como una serie de instantáneas desconectadas en lugar de como un flujo continuo de experiencia espacial.

Un equipo de investigadores de la Universidad de Nueva York y Stanford, incluidos Yann LeCun y Fei-Fei Li, ha articulado este problema y propuesto una solución. Introducen Cambrian-S, una familia de modelos de lenguaje multimodal de video espacialmente fundamentados, junto con el benchmark VSI Super y el conjunto de datos VSI 590K para probar y entrenar lo que llaman supersensado espacial en videos largos.

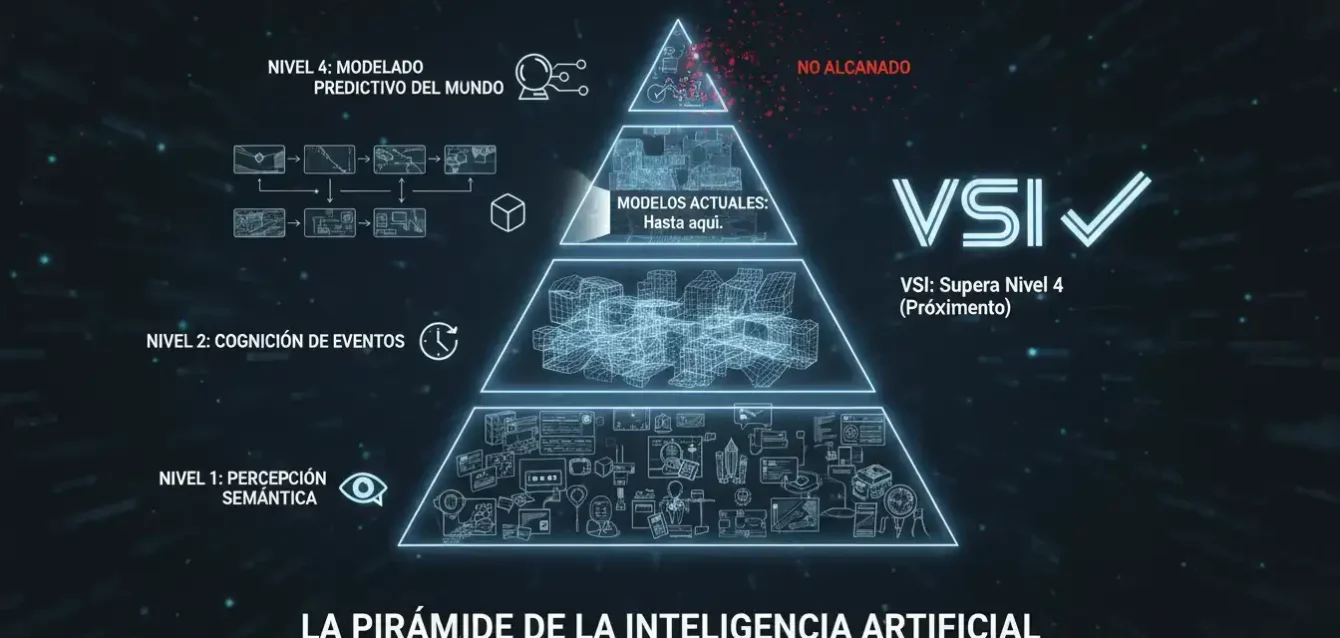

De la comprensión de video a la jerarquía del supersensado espacial

El equipo de investigación enmarca el supersensado espacial como una progresión de capacidades más allá del razonamiento solo lingüístico. Esta no es solo una distinción técnica. Representa un cambio fundamental en cómo pensamos sobre qué significa para un sistema de IA entender verdaderamente el mundo visual.

La jerarquía comienza en el nivel más básico con percepción semántica: nombrar y describir lo que se ve. Esta es la capacidad de mostrar y contar que los modelos actuales han dominado en gran medida. Puedes mostrarles una imagen de un gato en un sofá, y te dirán que hay un gato en un sofá.

Las cuatro etapas del supersensado espacial

La cognición de eventos de flujo continuo va más allá, habilitando sensado siempre activo a través de flujos de entrada continuos, integrando memoria y apoyando respuestas proactivas. Esta es la capacidad de mantener conciencia a través del tiempo, no solo en instantáneas aisladas.

La cognición espacial 3D implícita captura la estructura 3D implícita del video, habilitando razonamiento sobre objetos, configuraciones y métricas. Esta es la capacidad de inferir el mundo tridimensional detrás de los píxeles bidimensionales.

Finalmente, un modelo predictivo del mundo emerge, uno que aprende pasivamente de la experiencia, se actualiza a través de predicción y sorpresa, y retiene información para uso futuro. Esta es la capacidad de anticipar lo que viene a continuación basándose en un modelo interno de cómo funciona el mundo.

La mayoría de los modelos de lenguaje multimodal de video actuales muestrean cuadros dispersos y dependen de priors de lenguaje. A menudo responden preguntas de benchmark usando subtítulos o cuadros individuales en lugar de evidencia visual continua. Las pruebas de diagnóstico muestran que varios benchmarks de video populares son solucionables con entrada limitada o solo de texto, por lo que no prueban fuertemente el sensado espacial.

Cambrian-S apunta a las etapas superiores de esta jerarquía, donde el modelo debe recordar diseños espaciales a través del tiempo, razonar sobre ubicaciones de objetos y conteos, y anticipar cambios en un mundo 3D.

VSI Super: una prueba de estrés para sensado espacial continuo

Para exponer la brecha entre los sistemas actuales y el supersensado espacial, el equipo de investigación diseñó VSI Super, un benchmark de dos partes que se ejecuta en videos interiores arbitrariamente largos. Este no es solo otro benchmark de video más difícil. Es una prueba de estrés diseñada deliberadamente para ser resistente a las recetas predominantes de modelos multimodales.

VSI Super Recall, o VSR, evalúa observación y recuerdo espacial de horizonte largo. Los anotadores humanos toman videos de recorrido interior de ScanNet, ScanNet++ y ARKitScenes y usan Gemini para insertar un objeto inusual, como un oso de peluche, en cuatro cuadros en diferentes ubicaciones espaciales. Estas secuencias editadas se concatenan en flujos de hasta 240 minutos.

El modelo debe reportar el orden de ubicaciones donde aparece el objeto, lo cual es una tarea de aguja visual en un pajar con recuerdo secuencial. No es suficiente detectar el objeto. El modelo debe recordar dónde apareció y en qué orden a través de horas de material de video.

VSI Super Count: conteo continuo bajo cambios de perspectiva

VSI Super Count, o VSC, mide conteo continuo bajo cambios de punto de vista y habitaciones. El benchmark concatena clips de recorrido de habitación de VSI Bench y pregunta por el número total de instancias de un objeto objetivo en todas las habitaciones.

El modelo debe manejar cambios de punto de vista, revisitas y transiciones de escena, y mantener un conteo acumulativo. La evaluación usa precisión relativa media para duraciones de 10 a 120 minutos. Esta no es una tarea trivial. Imagina caminar a través de una casa grande, contando sillas mientras te mueves de habitación en habitación, a veces regresando a habitaciones que ya visitaste, a veces viendo la misma silla desde diferentes ángulos. Ahora haz eso durante dos horas de video continuo.

El colapso de los modelos de contexto largo en VSI Super

Los resultados son reveladores y bastante dramáticos. Cuando Cambrian-S 7B es evaluado en VSI Super en una configuración de transmisión a 1 cuadro por segundo, la precisión en VSR cae de 38.3 por ciento a 10 minutos a 6.0 por ciento a 60 minutos y se vuelve cero más allá de 60 minutos.

La precisión de VSC está cerca de cero en todas las longitudes. Esto no es un fallo menor. Es un colapso completo. Gemini 2.5 Flash también se degrada en VSI Super a pesar de una ventana de contexto larga, lo que muestra que la expansión de contexto de fuerza bruta no es suficiente para sensado espacial continuo.

La debilidad estructural revelada

El benchmarking muestra que los modelos de frontera, incluidos Gemini 2.5 Flash y Cambrian-S, se degradan bruscamente en VSI Super incluso cuando las longitudes de video permanecen dentro de sus límites de contexto nominales, revelando una debilidad estructural en las arquitecturas multimodales de contexto largo actuales.

Este no es un problema de escalado. Es un problema de arquitectura. Estos modelos están construidos con la suposición fundamental equivocada de que más contexto es igual a mejor comprensión espacial continua. Pero la percepción espacial humana no funciona almacenando cada cuadro. Funciona construyendo modelos internos, prediciendo lo que viene a continuación, y recordando selectivamente solo lo sorprendente.

VSI 590K: datos de instrucción enfocados espacialmente

Para probar si el escalado de datos puede ayudar, el equipo de investigación construye VSI 590K, un corpus de instrucción espacial con 5,963 videos, 44,858 imágenes y 590,667 pares de pregunta-respuesta de 10 fuentes.

Las fuentes incluyen escaneos interiores reales anotados en 3D como ScanNet, ScanNet++ V2, ARKitScenes, S3DIS y Aria Digital Twin, escenas simuladas de ProcTHOR e Hypersim, y datos web pseudo-anotados como YouTube RoomTour y conjuntos de datos de robots Open X Embodiment y AgiBot World.

El conjunto de datos define 12 tipos de preguntas espaciales, como conteo de objetos, distancia absoluta y relativa, tamaño de objeto, tamaño de habitación y orden de aparición. Las preguntas se generan a partir de anotaciones 3D o reconstrucciones para que las relaciones espaciales estén fundamentadas en geometría en lugar de heurística de texto.

Las ablaciones muestran que los videos reales anotados contribuyen las mayores ganancias en VSI Bench, seguidos por datos simulados y luego imágenes pseudo-anotadas, y que entrenar en la mezcla completa da el mejor rendimiento espacial. Esto confirma la intuición de que la fundamentación geométrica real importa más que simplemente tener más datos.

Familia de modelos Cambrian-S y rendimiento espacial

Cambrian-S se basa en Cambrian-1 y usa backbones de lenguaje Qwen2.5 en 0.5B, 1.5B, 3B y 7B parámetros con un codificador de visión SigLIP2 SO400M y un conector MLP de dos capas.

El entrenamiento sigue un pipeline de cuatro etapas. La etapa 1 realiza alineación de visión-lenguaje en pares de imagen-texto. La etapa 2 aplica ajuste de instrucción de imagen, equivalente a la configuración mejorada de Cambrian-1. La etapa 3 se extiende a video con ajuste de instrucción de video general en una mezcla de 3 millones de muestras llamada Cambrian-S 3M. La etapa 4 realiza ajuste de instrucción de video espacial en una mezcla de VSI 590K y un subconjunto de los datos de la etapa 3.

En VSI Bench, Cambrian-S 7B alcanza 67.5 por ciento de precisión y supera líneas base de código abierto como InternVL3.5 8B y Qwen VL 2.5 7B, así como Gemini 2.5 Pro propietario por más de 16 puntos absolutos. El modelo también mantiene un rendimiento fuerte en Perception Test, EgoSchema y otros benchmarks de video generales, por lo que el enfoque en sensado espacial no destruye las capacidades generales.

Esto es importante. Muestra que el supersensado espacial no es un trueque donde sacrificas rendimiento general por capacidades espaciales. Es un avance genuino que mejora capacidades espaciales mientras mantiene todo lo demás.

Sensado predictivo con predicción de cuadro latente y sorpresa

Pero aquí está el avance conceptual real. Para ir más allá de la expansión de contexto estático, el equipo de investigación propone sensado predictivo. Agregan un cabezal de Predicción de Cuadro Latente, que es un MLP de dos capas que predice la representación latente del siguiente cuadro de video en paralelo con la predicción del siguiente token.

El entrenamiento modifica la etapa 4. El modelo usa error cuadrático medio y pérdidas de distancia de coseno entre características latentes predichas y de verdad fundamental, ponderadas contra la pérdida de modelado de lenguaje. Un subconjunto de 290,000 videos de VSI 590K, muestreados a 1 cuadro por segundo, se reserva para este objetivo. Durante esta etapa, el conector, el modelo de lenguaje y ambos cabezales de salida se entrenan conjuntamente, mientras que el codificador de visión SigLIP permanece congelado.

En el tiempo de inferencia, la distancia de coseno entre características predichas y reales se convierte en una puntuación de sorpresa. Los cuadros con baja sorpresa se comprimen antes de almacenarse en memoria a largo plazo y los cuadros de alta sorpresa se retienen con más detalle. Un búfer de memoria de tamaño fijo usa sorpresa para decidir qué cuadros consolidar o descartar, y las consultas recuperan cuadros que son más relevantes para la pregunta.

Esto es inspirado por teorías de cognición humana. A diferencia de los modelos de video multimodal actuales que tokenizan y procesan flujos de datos completos, la percepción humana y la memoria son altamente selectivas, reteniendo solo una fracción de entrada sensorial. El cerebro actualiza continuamente modelos internos para predecir estímulos entrantes, comprimiendo o descartando entradas predecibles que no contribuyen información novedosa. En contraste, la información sensorial inesperada que viola predicciones genera sorpresa e impulsa atención aumentada, consolidación de memoria y aprendizaje.

Resultados en VSI Super: memoria impulsada por sorpresa funciona

Para VSR, este sistema de memoria impulsado por sorpresa permite que Cambrian-S mantenga precisión a medida que aumenta la longitud del video mientras mantiene el uso de memoria GPU estable. Supera a Gemini 1.5 Flash y Gemini 2.5 Flash en VSR en todas las duraciones probadas y evita la degradación brusca vista en modelos que solo extienden el contexto.

Los números son dramáticos. Mientras que Gemini 2.5 Flash colapsa a casi cero precisión en videos de 60 minutos, Cambrian-S con memoria impulsada por sorpresa mantiene precisión utilizable. Esto no es una mejora incremental. Es evidencia de que el enfoque arquitectónico fundamental es correcto.

Para VSC, el equipo de investigación diseñó un esquema de segmentación de eventos impulsado por sorpresa. El modelo acumula características en un búfer de eventos y cuando un cuadro de alta sorpresa señala un cambio de escena, resume ese búfer en una respuesta a nivel de segmento y reinicia el búfer. Agregar respuestas de segmento da el conteo final.

Comparación con modelos de transmisión en tiempo real

En evaluación de transmisión, Gemini Live y GPT Realtime logran menos del 15 por ciento de precisión relativa media y caen cerca de cero en flujos de 120 minutos, mientras que Cambrian-S con segmentación de sorpresa alcanza alrededor del 38 por ciento a 10 minutos y mantiene alrededor del 28 por ciento a 120 minutos.

Nuevamente, esto no es solo ganar en un benchmark. Es demostrar que un enfoque arquitectónico fundamentalmente diferente, uno basado en predicción y sorpresa en lugar de acumulación pasiva de contexto, puede manejar tareas que colapsan los modelos actuales de mejor en su clase.

Lecciones clave: escala sola no resuelve supersensado espacial

Cambrian-S y VSI 590K muestran que el diseño cuidadoso de datos espaciales y modelos de lenguaje multimodal de video fuertes pueden mejorar significativamente la cognición espacial en VSI Bench, pero aún fallan en VSI Super, por lo que la escala sola no resuelve el supersensado espacial.

VSI Super, a través de VSR y VSC, se construye intencionalmente a partir de videos interiores arbitrariamente largos para estresar observación espacial continua, recuerdo y conteo, lo que lo hace resistente a la expansión de ventana de contexto de fuerza bruta y el muestreo de cuadros dispersos estándar.

Este es un punto crucial que vale la pena enfatizar. La industria de IA ha estado en una carrera para construir modelos con ventanas de contexto cada vez más largas. Millones de tokens. Contexto efectivamente ilimitado. Pero VSI Super demuestra que contexto más largo no es igual a mejor comprensión espacial continua. Es posible, de hecho probable, construir un modelo con una ventana de contexto de 10 millones de tokens que aún falle completamente en rastrear objetos a través de una hora de video.

Falla estructural de arquitecturas de contexto largo

El benchmarking muestra que los modelos de frontera, incluidos Gemini 2.5 Flash y Cambrian-S, se degradan bruscamente en VSI Super incluso cuando las longitudes de video permanecen dentro de sus límites de contexto nominales, revelando una debilidad estructural en las arquitecturas multimodales de contexto largo actuales.

El módulo de sensado predictivo basado en Predicción de Cuadro Latente usa error de predicción de siguiente cuadro latente, o sorpresa, para impulsar compresión de memoria y segmentación de eventos, lo que produce ganancias sustanciales en VSI Super en comparación con líneas base de contexto largo mientras mantiene el uso de memoria GPU estable.

Del video pasivo al supersensado espacial predictivo

El trabajo de investigación posiciona el supersensado espacial como una jerarquía desde percepción semántica hasta modelado predictivo del mundo y argumenta que los futuros modelos de lenguaje multimodal de video deben incorporar objetivos predictivos explícitos y memoria impulsada por sorpresa, no solo modelos y conjuntos de datos más grandes, para manejar video de transmisión sin límites en aplicaciones reales.

Cambrian-S es una prueba de estrés útil de los modelos de lenguaje multimodal de video actuales porque muestra que VSI Super no es solo un benchmark más difícil. Expone una falla estructural de arquitecturas de contexto largo que aún dependen de percepción reactiva.

El módulo de sensado predictivo, basado en Predicción de Cuadro Latente y memoria impulsada por sorpresa, es un paso importante porque acopla sensado espacial con modelado interno del mundo en lugar de solo escalar datos y parámetros. Esta investigación señala un cambio desde comprensión de video pasiva hacia supersensado espacial predictivo como el próximo objetivo de diseño para modelos multimodales.

Mirando más allá de los píxeles: construyendo una mente predictiva

El mundo no solo existe alrededor de nosotros. Fluye a través de nosotros, dando forma a lo que sentimos y en quién nos convertimos. Supersensado es la misión de permitir que las máquinas compartan en ese flujo: construir modelos de mundo más ricos que no solo vean, sino que anticipen, seleccionen y organicen la experiencia, avanzando la inteligencia multimodal que verdaderamente comprende el mundo y crea dentro de él.

Esta no es solo retórica. Es una articulación de hacia dónde necesita ir el campo. Miramos más allá de la comprensión solo lingüística para imaginar inteligencia multimodal que ve, recuerda y razona como parte de un mundo continuo y vivido.

Comienza con percepción semántica: nombrar y describir lo que se ve. La cognición de eventos de flujo continuo va más allá, habilitando sensado siempre activo a través de flujos de entrada continuos, integrando memoria y apoyando respuestas proactivas. La cognición espacial captura la estructura 3D implícita del video, habilitando razonamiento sobre objetos, configuraciones y métricas. Finalmente, emerge un modelo predictivo del mundo, uno que aprende pasivamente de la experiencia, se actualiza a través de predicción y sorpresa, y retiene información para uso futuro.

El video sirve como el dominio experimental ideal. Los modelos deben avanzar desde preguntas y respuestas a nivel de cuadro hasta construir modelos de mundo implícitos que habiliten razonamiento espacial más profundo, escalen a horizontes sin límites, y logren supersensado que rivalice, y finalmente supere, la inteligencia visual humana.

Marco conceptual de Cambrian-SImplicaciones para la inteligencia artificial corporificada

Las implicaciones de este trabajo van mucho más allá de responder preguntas sobre videos. Si queremos construir robots que naveguen el mundo real, si queremos construir asistentes de IA que entiendan escenas 3D complejas, si queremos construir sistemas autónomos que operen en entornos no estructurados, necesitan supersensado espacial.

Necesitan la capacidad de construir y mantener modelos internos del mundo tridimensional. Necesitan la capacidad de predecir lo que viene a continuación basándose en experiencia pasada. Necesitan la capacidad de recordar selectivamente solo lo que es sorprendente e importante, no cada cuadro de entrada sensorial.

La arquitectura actual de los modelos multimodales, acumular pasivamente contexto y luego consultarlo, simplemente no escalará a estos casos de uso del mundo real. VSI Super lo demuestra concluyentemente. Necesitamos arquitecturas que incorporen predicción, sorpresa y memoria selectiva como primitivas de primera clase, no como agregados posteriores.

El camino adelante: más allá de la fuerza bruta

El trabajo de Cambrian-S es importante no porque resuelva el supersensado espacial. No lo hace. Los propios autores son claros sobre esto. El rendimiento en VSI Super, aunque mejor que las líneas base, aún está lejos de donde necesita estar.

Pero es importante porque articula claramente por qué el enfoque actual de simplemente escalar contexto y datos no funcionará, y porque demuestra que un enfoque alternativo basado en predicción y sorpresa puede funcionar, al menos en principio.

La próxima ventaja competitiva en IA multimodal no provendrá de comprar más computación y ventanas de contexto más grandes. Vendrá de modelos que predicen lo que viene a continuación y recuerdan selectivamente solo eventos sorprendentes e importantes. Vendrá de arquitecturas que incorporan modelado del mundo como una primitiva de primera clase, no como un agregado posterior.

Argumentamos que el progreso en verdadera inteligencia multimodal requiere un cambio desde sistemas reactivos impulsados por tareas y contexto largo de fuerza bruta hacia un paradigma más amplio de supersensado. Construir esa capacidad requerirá rethinking fundamental de cómo diseñamos y entrenamos modelos multimodales.

Cambrian-S es un primer paso en ese camino. No es la respuesta final. Pero señala en la dirección correcta: hacia sistemas que no solo ven, sino que anticipan, seleccionan y organizan la experiencia. Hacia inteligencia multimodal que verdaderamente comprende el mundo como un flujo continuo de experiencia espacial, no como una colección de instantáneas desconectadas.

Referencias

arXiv:2511.04670, "Cambrian-S: Towards Spatial Supersensing in Video" (Shusheng Yang et al.) - paper de investigación completo (noviembre 6, 2025).

VISIONx @ NYU, "Cambrian - Building Supersensing for Superintelligence" - página del proyecto oficial (2025).

GitHub cambrian-mllm/cambrian-s, "Cambrian-S: Towards Spatial Supersensing in Video" - repositorio de código y checkpoints (2025).

arXiv PDF 2511.04670, "Cambrian-S: Towards Spatial Supersensing in Video" - documento técnico completo con figuras (noviembre 6, 2025).

arXiv:2406.16860, "Cambrian-1: A Fully Open, Vision-Centric Exploration of Multimodal LLMs" - trabajo previo sobre Cambrian-1 (junio 2024).

NeurIPS 2024 Proceedings, "Cambrian-1: A Fully Open, Vision-Centric Exploration of Multimodal LLMs" - paper aceptado en conferencia (2024).

GitHub cambrian-mllm/cambrian, "Cambrian-1 is a family of multimodal LLMs with a vision-centric design" - repositorio original de Cambrian-1 (2024).