El lanzamiento de un esquema de evaluación orientado a tareas con valor económico directo cambió la manera de medir el aporte de la inteligencia artificial a la actividad profesional. OpenAI presentó un conjunto de pruebas aplicadas que enfrenta a sus sistemas con encargos de oficina, consultoría, ingeniería, finanzas, asuntos legales y administración pública, y compara sus resultados con trabajos generados por especialistas humanos sin revelar al evaluador el origen de cada documento. La pregunta de fondo es concreta. ¿Puede un modelo producir un entregable que una organización exigente pueda utilizar como base para tomar decisiones? La respuesta, en una fracción considerable de los casos examinados, se acerca al sí. Esta constatación se apoya en dictámenes ciegos, rúbricas profesionales y un enfoque que emula la práctica y no el laboratorio. La implicación inmediata es operativa. Si una primera versión de calidad surge en minutos y a bajo costo marginal, entonces conviene reorganizar procesos para aprovechar ese inicio veloz y reservar el tiempo humano a la verificación, el ajuste de contexto y la responsabilidad final.

El giro de enfoque se entiende mejor si se repasa el recorrido reciente de las evaluaciones de IA. Durante años, los avances se midieron con pruebas académicas que permitieron comparar modelos, pero que no reflejaban con fidelidad la confección de piezas listas para circular en ámbitos de decisión. Esos ejercicios llegaron a techos que fragmentaban la conversación entre especialistas y usuarios. La nueva propuesta busca reanclar el debate en una vara de uso cotidiano. Un informe, un memorando, una propuesta o un análisis comparativo siguen reglas, requieren estructura, apelan a evidencia y deben responder a una audiencia definida. Medir la aptitud para cumplir ese estándar, y hacerlo con dictámenes sin sesgos de origen, ofrece una perspectiva distinta y más accionable para directivos, jefaturas de área y equipos de proyecto.

La arquitectura del programa incluye varios elementos que apuntan al realismo. Las tareas fueron diseñadas por profesionales con experiencia que trasladaron a consignas evaluables los productos típicos de sus funciones. Cada encargo define objetivo, destinatario, límites de extensión, fuentes autorizadas, formato de salida y criterios de aprobación. La calificación se realiza mediante rúbricas que ponderan claridad, precisión, coherencia interna, organización, uso adecuado de datos y ajuste a la instrucción. La ceguera en la comparación evita que el evaluador favorezca o castigue de antemano a la máquina o a la persona. El resultado es un mapa de desempeño que no pretende ser un ranking universal, sino una medición de suficiencia en piezas que mueven proyectos y decisiones.

El instrumento, presentado como una primera versión, recorta su alcance para poder ser confiable. Se concentra en entregables discretos, de extremo a extremo, que pueden juzgarse con consistencia en un tiempo razonable. No intenta capturar aún procesos prolongados con múltiples iteraciones, negociación con interesados, liderazgo de equipos, cambios de objetivos o integración con sistemas internos. Tampoco incluye la ingeniería de permisos, la seguridad de la información y la trazabilidad documental que aplican en operaciones complejas. Ese recorte no reduce su valor. Lo delimita. Permite enfocar la medición en lo que un sistema puede proponer como primera pieza útil, al margen de las capas de gobernanza que toda organización debe añadir.

Un método que imita la práctica con dictámenes ciegos y rúbricas claras

El núcleo metodológico es la comparación por pares con origen oculto. Evaluadores experimentados reciben dos entregas para una misma consigna. Una fue redactada por un profesional. La otra surge de un modelo. La consigna es idéntica, el formato exigido es el mismo, el horizonte de calidad es compartido. Quien califica no sabe cuál es cuál. El dictamen sigue una pauta que asigna peso a los criterios de calidad relevantes. De ese modo se busca aislar la valoración del sesgo y aproximarla a la experiencia de lectura en una oficina. Lo que importa es si el documento funciona, si está completo, si presenta datos confiables y si cumple la promesa de su objetivo.

Las consignas abarcan un arco amplio de oficios del conocimiento en sectores que suman gran parte del producto interno. Hay piezas técnicas con anexos, informes con estructura ejecutiva, memorandos jurídicos con citas, análisis comparativos con tablas y supuestos, documentos de producto con especificaciones y cronogramas, y materiales de comunicación con audiencias bien definidas. El constructor de cada tarea estimó la dificultad, señaló fuentes y delimitó el alcance. La calificación posterior permite observar no solo quién gana más dictámenes, sino en qué tipos de encargo la balanza se inclina hacia un lado u otro.

El diseño reconoce límites y los explicita. La primera edición no mide colaboración sostenida en el tiempo, manejo de cambios y replanificaciones, ni coordinación con varias áreas. No evalúa integración con repositorios privados ni acceso a bases internas bajo permisos diferenciados. Tampoco incorpora la cadena de control de cumplimiento que ciertas industrias exigen para publicar o elevar documentos. En otras palabras, cuantifica la capacidad de producir piezas iniciales con calidad, no la totalidad del proceso que las convierte en instrumentos oficiales. Esta distinción es importante para evitar extrapolaciones simplistas. Lo que el protocolo ofrece es una base de evidencia sobre el potencial técnico cuando se formulan instrucciones correctas y se pide un resultado acotado.

El ejercicio deja aprendizaje que trasciende las cifras. Allí donde aparecen errores recurrentes, se pueden construir andamiajes para elevar el piso. Guías de estilo, plantillas de secciones, checklists de verificación, catálogos de fuentes permitidas y cadenas de instrucciones estructuradas ayudan a prevenir fallas típicas. En sentido inverso, los aciertos también enseñan. Las tareas en las que los modelos destacan tienden a compartir rasgos. Estructuras claras, requerimientos de síntesis, uso disciplinado de datos y formatos predecibles. Ese patrón orienta la asignación de casos de uso en la adopción.

Resultados, progreso reciente y efectos en la productividad

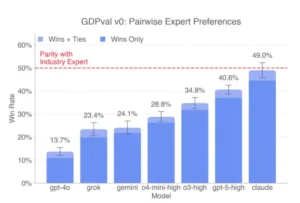

Los resultados que se difundieron apuntan en dos direcciones. La primera es la calidad comparativa. En una porción significativa de las pruebas, los sistemas más avanzados obtienen dictámenes que los ubican a la par de especialistas, con tasas de preferencia o empate que validan su rol como generadores de primeras versiones aprovechables. La segunda es la eficiencia. El tiempo y el costo marginal para producir esas piezas se ubican en un rango que habilita su uso cotidiano sin esperar retornos milagrosos. Es decir, los números dejan de ser promesa para convertirse en argumentos prácticos a favor de iniciar procesos con una propuesta automatizada y cerrar con revisión humana.

La comparación con generaciones anteriores muestra una evolución llamativa en poco más de un año. Hay mejoras visibles en consistencia a lo largo de documentos extensos, obediencia a instrucciones complejas, manejo de contextos largos y estabilidad en el uso de datos y referencias. La mezcla de esos avances recorta el trabajo de pulido y disminuye la tasa de reescritura profunda que antes era parte inevitable del ciclo. El efecto compuesto se nota en indicadores internos. Tiempo a primer borrador útil, número de iteraciones requeridas, porcentaje de entregas que pasan revisión sin cambios sustantivos, satisfacción de usuarios que consumen los documentos. Cuando la adopción se hace con método, esas curvas se mueven en la dirección esperada.

La heterogeneidad por tipo de tarea, sin embargo, se mantiene. Donde el éxito depende de estructura, síntesis y claridad formal, la herramienta destaca. Donde el encargo exige juicio contextual de nicho, interpretación fina de marcos normativos, lectura política de señales internas o sensibilidad reputacional, el profesional conserva ventaja. Esa heterogeneidad no es una limitación insalvable. Orienta la asignación. Entregar a la herramienta familias de entregables repetibles y reservar a las personas las piezas de alto riesgo o de fuerte dependencia del contexto incrementa el retorno y reduce la exposición.

La discusión sobre costo no debe olvidar la gobernanza. El cálculo de ahorro es contundente en la fase de redacción. A ello se suman capas no triviales que toda operación debe respetar. Seguridad de la información, políticas de acceso, requisitos de conservación, control de versiones, revisiones por pares, aprobaciones con firma de responsables, cumplimiento regulatorio. La ecuación completa incluye esas piezas. Aun así, el balance neto favorece la reorganización. Liberar horas de redacción y compactar la etapa de iteración temprana deja margen para elevar el rigor de la verificación y mejorar la calidad de fondo.

Para dimensionar el impacto, conviene considerar la estabilidad en documentos largos. Las generaciones previas a menudo perdían coherencia o estilo al avanzar en secciones, o mostraban inconsistencias en tablas y referencias internas. Hoy, la continuidad mejora. No es perfecta, pero reduce fricciones en un punto crítico. Los equipos pueden confiar en que la pieza mantendrá orden, tono y formato mientras agregan contexto y corrigen lo que la práctica exige.

Cómo incorporarlo: diseño de casos de uso, control de calidad y gobernanza

El camino de adopción recomendado comienza con la identificación precisa de familias de documentos que consumen más horas o muestran mayor variabilidad. Informes periódicos, notas de análisis comparativo, memorandos con estructura definida, documentación técnica con tablas y anexos, resúmenes ejecutivos para dirección y piezas de comunicación con guías de marca son candidatos naturales. Para cada familia, es conveniente construir plantillas de secciones, guías de estilo y checklists de control. Las instrucciones para el sistema deben incluir objetivo, audiencia, formato, límites de extensión, fuentes habilitadas y criterios de aceptación. Una instrucción bien formulada reduce desviaciones y mejora la tasa de acierto desde la primera iteración.

El control de calidad es el segundo pilar. La revisión por pares detecta errores sutiles que la lectura individual pasa por alto. El muestreo aleatorio permite auditar calidad sin encarecer el proceso. Las listas de verificación para exactitud de cifras, consistencia de tablas, coherencia de referencias internas y citación de fuentes anclan la disciplina. En documentos críticos, conviene establecer umbrales de intervención humana y firmas obligatorias. Esta arquitectura de control no cancela la ganancia de eficiencia. La ordena y la protege.

La gobernanza de datos cierra el triángulo. Un despliegue serio establece políticas de tratamiento de información, define entornos seguros, segmenta accesos, fija límites de retención y documenta decisiones. Las áreas de seguridad, legal y cumplimiento deben participar desde el diseño. La trazabilidad es clave para auditorías internas o regulatorias. Registrar versiones, consignas, cambios y justificativos evita zonas grises y facilita la rendición de cuentas. En entornos con alta sensibilidad, la posibilidad de desactivar el aprendizaje a partir de entradas o de operar en instancias privadas es una condición de base.

Con estos cimientos, los pilotos producen aprendizaje rápido. Un piloto con objetivos y métricas claros se ejecuta durante algunas semanas con entregables bien delimitados. Si el tiempo a primer borrador baja, la tasa de rehacer desciende y la satisfacción de usuarios internos mejora, el caso de negocio queda probado. Si aparecen fallas recurrentes, se ajustan plantillas, guías y políticas antes de escalar. La repetición controlada consolida las prácticas y reduce la dependencia de talentos individuales.

La elección de herramienta completa el cuadro. No hay un sistema mejor en todo. La evaluación aconseja mirar calidad de primer borrador, fidelidad a plantillas estrictas, estabilidad en textos largos, manejo de tablas, latencia bajo demanda, costo por unidad de trabajo y opciones de privacidad y registro. En la práctica, muchas organizaciones combinan alternativas. Asignan a un sistema informes recurrentes, a otro la documentación técnica con cuadros complejos, y reservan un tercero para exploración rápida. Este portafolio distribuye riesgos, optimiza costos y aprovecha fortalezas específicas.

La portabilidad es una capa de prudencia. Documentar prompts, estandarizar formatos de salida y probar compatibilidad entre herramientas reduce el costo de cambio si varían precios, condiciones de servicio o requisitos regulatorios. Un programa de adopción robusto se diseña para sobrevivir a las novedades del mercado.

Lo que viene y una conclusión centrada en la acción

Todo indica que las siguientes ediciones de este protocolo ampliarán el alcance hacia escenarios de trabajo colaborativo y sostenido. Cadenas de tareas con varias rondas de retroalimentación, acceso controlado a repositorios internos, exigencias de explicabilidad para auditoría y métricas de desempeño a lo largo de proyectos de semanas o meses forman parte del horizonte previsible. La vara se moverá del documento aislado a la consistencia del proceso. La pregunta ya no será si el resultado de una consigna es bueno, sino si el flujo entero aporta valor con menos fricción, mayor transparencia y mejor trazabilidad.

En ese contexto, la potencia del modelo será solo una parte de la ecuación. El resto lo pondrán el diseño de procesos, la gobernanza de datos, la disciplina de control de calidad y la capacidad de los equipos para dirigir la iteración. La adopción dejará de ser una suma de pruebas dispersas y se consolidará como un sistema operativo para producir conocimiento aplicable con eficiencia y responsabilidad. Quien dé esos pasos con método tendrá ventaja. Quien se quede en pilotos perpetuos verá cómo competidores más ágiles estandarizan calidades y aceleran entregas.

El nuevo banco de pruebas no pretende clausurar debates. Invita a ordenarlos. Al medir entregables que pueden usarse, al comparar a ciegas y al ponderar con rúbricas claras, devuelve el foco a lo que importa en el trabajo del conocimiento. Un documento que organiza argumentos, cita evidencia, respeta el formato y atiende a su audiencia es una herramienta. Si un sistema puede producir una versión inicial de esa herramienta en minutos, y si la organización estructura la revisión que la convierte en pieza final confiable, la ganancia es evidente. Lo que resta es construir los puentes para que esa ganancia se vuelva rutina.

La conclusión es práctica. Conviene empezar por las familias de documentos que consumen más horas. Conviene definir plantillas y listas de verificación que eleven el piso. Conviene especificar con precisión lo que se espera de la herramienta. Conviene revisar con ojos entrenados y con responsabilidad. Conviene documentar lo que funciona y ajustar lo que no. Todo esto lleva trabajo, pero ordena la adopción y asegura resultados. La productividad no es un eslogan. Es una arquitectura de decisiones bien tomadas, apoyadas en evidencia y sostenidas por procesos. Con ese enfoque, la colaboración entre equipos expertos y sistemas avanzados puede dejar de ser una promesa y convertirse en el nuevo modo de hacer que las cosas sucedan.

Fuentes

TechCrunch, cobertura del 25 de septiembre de 2025 sobre el lanzamiento de GDPval y la comparación de rendimiento entre GPT-5 y profesionales. (TechCrunch)

OpenAI, página oficial de GDPval con metodología, ocupaciones y alcance de la primera versión. (OpenAI)

OpenAI, documento técnico de GDPval con detalles del diseño experimental y el conjunto de tareas. (cdn.openai.com)

Yahoo Finance, reproducción sindicada del artículo periodístico con los puntos clave del anuncio. (Yahoo Finanzas)

OpenAI, materiales de lanzamiento de GPT-5 y contexto sobre mejoras en razonamiento y uso productivo. (OpenAI)