Nvidia anunció lunes BlueField-4, cuarta generación de DPU (Unidad de Procesamiento de Datos) diseñado específicamente para orquestar operaciones de infraestructura en gigafactorías computacionales procesando cargas de trabajo de billones de tokens. Chip combina CPU Grace de 64 núcleos basada en Arm Neoverse V2 con ConnectX-9 SuperNIC proporcionando 800 gigabits por segundo de ancho de banda de red, duplicando capacidad de BlueField-3 mientras entrega 6 veces más potencia computacional. Procesador asume responsabilidad de gestionar tareas de redes, almacenamiento distribuido y seguridad de confianza cero que tradicionalmente consumían ciclos de CPU valiosos, permitiendo CPUs anfitrionas enfocar recursos en servir aplicaciones mientras GPUs permanecen dedicadas exclusivamente a generación de tokens e inferencia de modelos sin distracción de sobrecarga de infraestructura.

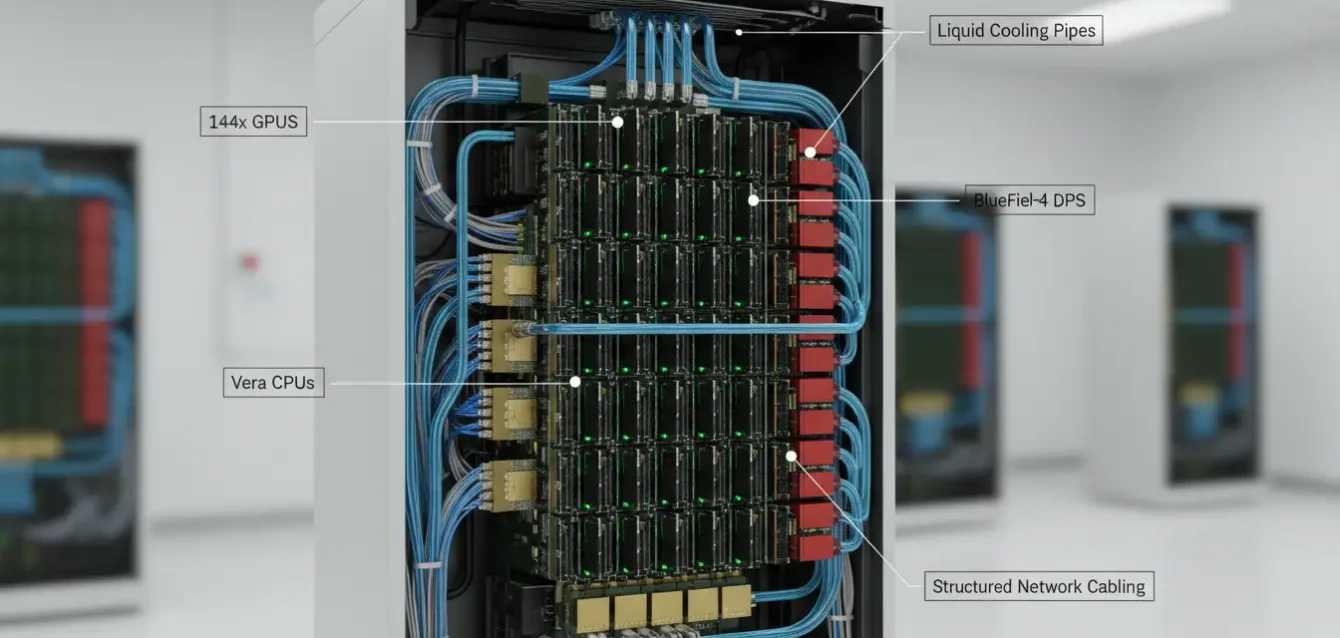

Arquitectura representa continuación de estrategia Nvidia de crear "tercer pilar" de computación para centros de datos donde DPUs complementan CPUs de propósito general y GPUs especializadas. Donde CPUs manejan lógica de aplicación y GPUs aceleran cálculo paralelo masivo, DPUs se especializan en movimiento de datos entre nodos de cómputo, matrices de almacenamiento y frontends de red externa. Conforme gigafactorías computacionales escalan hacia cientos de miles de GPUs interconectadas, coordinación eficiente de tráfico este-oeste (entre GPUs) y norte-sur (desde almacenamiento hacia cómputo) se vuelve crítica para mantener utilización alta de silicio caro. BlueField-4 será disponible inicialmente como parte de plataformas a escala de rack Vera Rubin en 2026, integrándose con 144 GPUs Rubin y CPU Vera de 88 núcleos para entregar 8 exaflops de rendimiento en rack único con enfriamiento líquido.

Decisión de equipar BlueField-4 con CPU Grace de 64 núcleos representa mejora sustancial desde 16 núcleos Arm Cortex-A78 de BlueField-3. Grace utiliza arquitectura Arm Neoverse V2, misma familia de núcleos usada en CPU Grace Superchip autónomo de Nvidia pero reducida desde configuración típica de 72 núcleos de soluciones de cómputo independientes. Neoverse V2 es implementación Armv9-A con soporte para instrucciones SVE2 (Extensiones Vectoriales Escalables 2), permitiendo operaciones SIMD vectoriales en configuración 4x128-bit particularmente eficiente para cargas de trabajo intensivas en datos como procesamiento de paquetes, compresión y criptografía que DPU típicamente maneja. Chip incluye 128GB memoria LPDDR5 versus 32GB DDR5 de predecesor, cuadruplicando capacidad para almacenar tablas de enrutamiento masivas, cachés de estado de flujo y buffers de inspección de paquetes sin derramarse hacia memoria anfitriona.

Cómputo: CPU Grace 64 núcleos

Arm Neoverse V2: Núcleos Armv9-A con SVE2

Memoria: 128GB LPDDR5

Caché: 114MB L3 compartido

Rendimiento: 6x vs. BlueField-3

Red: ConnectX-9 SuperNIC

Ancho de banda: 800Gb/s total

Latencia: Sub-microsegundo

RoCE: Optimizado para Ethernet sin pérdidas

PCIe: Gen 6 x16

Seguridad: Arquitectura ASTRA

Confianza cero: Aislamiento a nivel de inquilino

Definido por software: Control independiente

Cómputo confidencial: Cargas cifradas

Raíces de hardware: Cadenas de arranque seguro

ConnectX-9 SuperNIC: 800Gb/s y optimización RoCE para Spectrum-X

Integración de ConnectX-9 SuperNIC en BlueField-4 proporciona 800 gigabits por segundo de ancho de banda de red, típicamente desplegado como configuración dual-port 400GbE o single-port 800GbE dependiendo de topología de centro de datos. ConnectX-9 soporta tanto InfiniBand XDR como Ethernet, pero para gigafactorías computacionales Nvidia promueve plataforma Spectrum-X Ethernet que combina switches Spectrum-X con ConnectX SuperNICs para entregar rendimiento RoCE (RDMA sobre Ethernet Convergente) competitivo con InfiniBand tradicional pero con flexibilidad y economía de costos de Ethernet estándar. RoCE permite GPUs realizar acceso directo a memoria remota sin involucrar CPU anfitriona, crítico para operaciones colectivas como all-reduce donde gradientes deben agregarse a través de miles de workers durante entrenamiento distribuido.

Optimizaciones específicas de ConnectX-9 para RoCE incluyen enrutamiento adaptativo que dinámicamente selecciona rutas óptimas basado en congestión en tiempo real, control de flujo prioritario (PFC) previniendo pérdida de paquetes durante ráfagas transitorias y notificación explícita de congestión (ECN) marcando permitiendo remitentes ajustar tasas de transmisión antes de que buffers desborden. Combinación mantiene rendimiento consistente incluso bajo carga pesada donde múltiples trabajos compiten por ancho de banda, evitando picos de latencia de cola que degradan experiencia de usuario en aplicaciones interactivas como chatbots o motores de búsqueda. Latencia ultralow sub-microsegundo de SuperNIC es particularmente valiosa para ventanas de contexto de billones de tokens donde modelo debe recuperar parámetros desde memoria distribuida constantemente durante generación, con cada microsegundo ahorrado multiplicado a través de miles de millones de accesos.

Interfaz PCIe Gen 6 proporcionando 16 carriles de ancho de banda entre BlueField-4 y servidor anfitrión representa mejora desde Gen 5 de BlueField-3, duplicando ancho de banda teórico de 64GB/s hacia 128GB/s bidireccional. Este throughput alto es necesario porque DPU debe tanto recibir datos desde almacenamiento y red para reenviar hacia CPUs y GPUs anfitrionas como interceptar tráfico saliente desde cómputo para aplicar cifrado, compresión o lógica de enrutamiento antes de transmisión externa. Cuello de botella en enlace PCIe causaría retrasos de cola propagando latencia a través de pila completa, entonces mantener margen es crítico especialmente conforme tasas de datos aumentan hacia terabits por segundo en próximas generaciones de hardware de red.

| Componente | BlueField-3 (2021) | BlueField-4 (2026) | Mejora |

|---|---|---|---|

| Núcleos de CPU | 16x Arm Cortex-A78 | 64x Arm Neoverse V2 | 4x más núcleos |

| Memoria integrada | 32GB DDR5 | 128GB LPDDR5 | 4x capacidad |

| Ancho de banda de red | 400Gb/s | 800Gb/s | 2x throughput |

| Interfaz PCIe | Gen 5 x16 | Gen 6 x16 | 2x ancho de banda |

| Potencia de cómputo | Línea base | 6x rendimiento | 6x mejora |

| Transistores | 22 mil millones | 64 mil millones | ~3x densidad |

| Soporte de escala | Línea base | 4x infraestructuras más grandes | 4x escalamiento |

Microservicios DOCA: encadenamiento de funciones sin modificar anfitrión

Aspecto diferenciador crítico de ecosistema BlueField es DOCA (Arquitectura de Infraestructura de Centro de Datos en un Chip), framework de software permitiendo desarrolladores construir microservicios en contenedores ejecutando nativamente en DPU sin requerir cambios en sistema operativo anfitrión o aplicaciones. Estos microservicios implementan funciones como firewall con estado, balanceo de carga, cifrado IPsec, aceleración de almacenamiento mediante compresión o deduplicación y recolección de telemetría para observabilidad. Mediante técnica llamada "encadenamiento de funciones de servicio", múltiples microservicios pueden conectarse en tubería donde salida de un servicio alimenta entrada del siguiente, permitiendo componer funcionalidad compleja desde bloques de construcción reutilizables.

Por ejemplo, paquete entrando a través de interfaz de red podría primero pasar por microservicio firewall filtrando tráfico malicioso, luego servicio de descifrado desenvolviendo túnel IPsec, luego balanceador de carga distribuyendo conexión hacia servidores backend, todo procesado en DPU antes de alcanzar CPU anfitriona. Esta aproximación descarga operaciones computacionalmente caras desde anfitrión mientras mantiene flexibilidad de infraestructura definida por software que puede reconfigurarse dinámicamente sin cambios de hardware. Contrasta con soluciones tradicionales donde estas funciones requieren dispositivos físicos insertados en ruta de red o agentes de software consumiendo ciclos de CPU anfitriona y complicando despliegue y gestión.

WEKA, proveedor de almacenamiento especializado en sistema de archivos paralelo para cargas de trabajo de computación de alto rendimiento, anunció que su plataforma NeuralMesh correrá directamente en BlueField-4, ejecutando lógica de distribución de almacenamiento, gestión de metadatos y movimiento de datos como microservicios DOCA residentes en DPU. CEO Liran Zvibel describió aproximación como "simplificando fundamentalmente despliegue de infraestructura computacional mientras mejora dramáticamente economía, rendimiento y eficiencia energética" comparado con arquitectura tradicional donde servidores separados manejan capa de almacenamiento. Consolidando funciones en DPU permite reducir conteo de servidores, eliminar saltos de red entre niveles de cómputo y almacenamiento y bajar consumo energético total conforme menos hardware es requerido para misma capacidad efectiva.

Arquitectura de seguridad ASTRA: aislamiento de confianza cero para nubes bare-metal

Postura de seguridad de BlueField-4 está anclada en ASTRA (Arquitectura Avanzada de Recursos de Confianza Seguros), framework proporcionando aislamiento de inquilinos de confianza cero permitiendo proveedores de servicios crear instancias de cómputo bare-metal seguras donde cada carga de trabajo de cliente corre en ambiente físicamente aislado con límites reforzados por hardware. Nubes multi-inquilino tradicionales típicamente usan virtualización donde hipervisor media acceso entre inquilinos, pero hipervisor mismo representa superficie de ataque potencial y añade sobrecarga de rendimiento. ASTRA permite ofertas bare-metal donde clientes obtienen acceso directo a hardware sin impuesto de virtualización, mientras mantienen garantías de seguridad típicamente asociadas con ambientes virtualizados.

Mecanismo opera mediante DPU interceptando todos accesos a memoria, operaciones de entrada y salida y tráfico de red desde cargas de trabajo de inquilinos, aplicando políticas de acceso asegurando ningún inquilino puede leer o escribir memoria perteneciente a otro inquilino o acceder volúmenes de almacenamiento no explícitamente asignados hacia ellos. Aplicación ocurre en nivel de hardware usando capacidades IOMMU (Unidad de Gestión de Memoria de Entrada y Salida) y firmas criptográficas verificando integridad de pilas de software cargadas en ambientes de inquilinos. Aproximación es particularmente relevante para industrias reguladas como finanzas o salud donde requerimientos de cumplimiento demandan aislamiento fuerte de datos pero clientes también demandan rendimiento bare-metal para cargas de trabajo sensibles a latencia como comercio de alta frecuencia o análisis de imágenes diagnósticas en tiempo real.

Soporte de cómputo confidencial embebido en ASTRA permite cargas de trabajo ejecutar en memoria cifrada invisible incluso para operadores de infraestructura, protegiendo datos sensibles durante procesamiento. Esta capacidad utiliza extensiones de seguridad de hardware presentes en CPUs y GPUs modernas como AMD SEV (Virtualización Cifrada Segura) o Intel TDX (Extensiones de Dominio de Confianza), con DPU coordinando gestión de claves y flujos de atestación verificando que carga de trabajo está ejecutando en ambiente genuinamente seguro antes de desellar claves de cifrado. Para cargas de trabajo de computación procesando información personalmente identificable (PII) o conjuntos de datos propietarios, cómputo confidencial permite clientes aprovechar infraestructura cloud compartida sin exponer datos crudos hacia proveedor cloud, abordando barrera mayor de adopción para empresas vacilantes migrando cargas de trabajo sensibles fuera de instalaciones.

Plataforma Vera Rubin: 8 exaflops en rack único para 2026

BlueField-4 será inicialmente disponible como componente integral de plataformas Vera Rubin a escala de rack programadas para segunda mitad de 2026. Configuración Vera Rubin NVL144 combina 144 GPUs Rubin (sucesor de arquitectura Blackwell) con CPUs Vera (procesadores Arm de 88 núcleos sucediendo Grace) y DPUs BlueField-4 en sistema integrado entregando 8 exaflops de rendimiento de cómputo computacional FP4 en rack único con enfriamiento líquido. Aproximación arquitectónica representa continuación de estrategia Nvidia ha perseguido con DGX SuperPOD donde racks pre-integrados con infraestructura de cómputo, redes, almacenamiento y enfriamiento se venden como dispositivos llave en mano minimizando carga de integración de cliente y acelerando líneas de tiempo de despliegue.

Integración incluye fabric de red InfiniBand Quantum-X800 o Ethernet Spectrum-XGS proporcionando conectividad de expansión entre múltiples racks, permitiendo gigafactorías computacionales escalar desde cientos hacia cientos de miles de GPUs en clúster de cómputo único. BlueField-4 desempeña rol crítico gestionando este escalamiento coordinando enrutamiento de paquetes, manteniendo consistencia de estado de memoria distribuida durante comunicaciones colectivas y aplicando políticas de red asegurando cargas de trabajo maliciosas o mal configuradas no pueden interrumpir otros trabajos compartiendo infraestructura. Conforme tamaño de clúster aumenta, complejidad de orquestación crece superlinealmente, entonces tener silicio dedicado manejando tareas de coordinación se vuelve esencial para mantener eficiencia.

Comparación con GB300 NVL72 (plataforma predecesor generación Blackwell) muestra Vera Rubin entregando 3.3 veces más rendimiento de inferencia FP4, 13TB/s de ancho de banda de memoria HBM4 (incremento 60%), 75TB de memoria rápida total (duplicando capacidad) y 2 veces conectividad NVLink más CX9 con tasas hacia 260TB/s y 28.8TB/s respectivamente. Capacidad de memoria masiva es particularmente importante para cargas de trabajo de billones de tokens donde modelo debe acceder miles de millones de parámetros durante generación, con cada token producido requiriendo múltiples recuperaciones de memoria extrayendo pesos desde DRAM. Mayor ancho de banda reduce tiempo esperando datos, aumentando utilización de GPU y bajando costo por token generado. BlueField-4 contribuye mediante precarga inteligente de parámetros probablemente necesitados pronto, comprimiendo datos en vuelo para reducir consumo de ancho de banda y cacheando pesos frecuentemente accedidos en memoria integrada evitando viajes repetitivos hacia RAM anfitriona.

Rol en cargas de billones de tokens: reduciendo bloqueos de CPU y latencia de cola

Para cargas de trabajo de billones de tokens y aplicaciones pesadas en recuperación, descargar movimiento de datos y procesamiento de seguridad desde CPU anfitriona hacia DPU reduce bloqueos de CPU (momentos donde CPU queda inactiva esperando finalización de entrada y salida), baja latencia de cola (retrasos de peor caso afectando experiencia de usuario) y devuelve más tiempo de GPU hacia tareas de generación donde silicio caro realmente añade valor. Itay Ozery, director de mercadotecnia de productos para redes en Nvidia, describió BlueField-4 como "anuncio héroe" de conferencia GTC, posicionando DPU como "procesador para ejecutar sistema operativo de gigafactoría computacional." Metáfora captura bien intención arquitectónica: mientras GPUs son motores generando potencia de cómputo, DPU es plano de control coordinando asignación de recursos, gestionando flujos de tráfico y aplicando políticas gobernando operaciones.

Ventanas de contexto de billones de tokens, cada vez más comunes en modelos de lenguaje grandes avanzados y modelos multimodales procesando video o documentos largos, presentan desafíos únicos porque modelo debe mantener atención a través de secuencias de entrada masivas. Matemáticamente, mecanismo de atención escala cuadráticamente con longitud de secuencia, significando computación requerida crece rápidamente conforme contextos expanden. Además, cada token generado durante fase de salida requiere consultar historia completa de contexto, accediendo miles de millones de parámetros para calcular probabilidades de siguiente token. Esto crea presión sostenida en subsistema de memoria donde gigabytes de datos deben fluir cada segundo entre almacenamiento, memoria y unidades de cómputo. Cualquier retraso en ruta de datos propaga a través de proceso de generación, aumentando tiempo-al-primer-token (métrica de latencia crítica para aplicaciones interactivas) y reduciendo throughput (tokens por segundo alcanzables).

Descarga mediante BlueField-4 funciona porque DPU maneja tareas de fondo asincrónicamente mientras CPU y GPU permanecen enfocadas en computación de paso hacia adelante. Por ejemplo, cuando modelo de lenguaje grande necesita recuperar siguiente lote de caché KV (pares clave-valor almacenando estados de atención previos), DPU puede anticipar solicitud basado en patrones de acceso históricos y precargar datos desde memoria remota sobre red, teniéndolos listos cuando GPU realmente solicita evitando bloqueo esperando viaje redondo de red. Similarmente, cuando tokens generados deben escribirse de vuelta hacia almacenamiento persistente para checkpointing, DPU maneja escritura asincrónicamente aplicando compresión y cifrado en vuelo, liberando ciclos de CPU que de otra manera gastarían serializando estructuras de datos y esperando finalización de entrada y salida de disco.

⚠️ Consideraciones de despliegue

Infraestructura de enfriamiento: Racks Vera Rubin con BlueField-4 usan enfriamiento líquido directo (DLC) requiriendo infraestructura de plomería, monitoreo de fugas y mantenimiento de fluidos que muchos centros de datos existentes no tienen desplegados. Retrofit de instalaciones puede ser caro y consume tiempo.

Capacidad energética: Racks consumiendo 160kW+ empujan límites de distribución de potencia en muchas instalaciones. Operadores deben verificar suficiente potencia y capacidad de respaldo está disponible antes comprometer despliegues grandes.

Brecha de habilidades: Operar infraestructura basada en DPU requiere expertise en dominios de redes, almacenamiento, seguridad además de administración tradicional de cómputo. Entrenar personal existente o contratar especialistas añade gasto operativo.

Madurez de ecosistema de software: Aunque framework DOCA está madurando, amplitud de microservicios disponibles y soporte de comunidad quedan atrás de ecosistema CUDA sustancialmente. Adoptadores tempranos pueden encontrar brechas requiriendo desarrollo personalizado.

Competencia con Azure Boost y AWS Nitro: silicio personalizado de hyperscalers

BlueField-4 compite no solo con silicio comercial de AMD e Intel sino también con DPUs personalizados desarrollados por hyperscalers para infraestructuras propias. Microsoft Azure Boost DPU, anunciado 2024, descarga tareas de red como procesamiento de paquetes, aplicación de seguridad y gestión de tráfico desde CPUs hacia hardware dedicado, afirmando beneficios similares de rendimiento mejorado de aplicaciones mediante liberación de recursos anfitriones. Sistema Amazon AWS Nitro, desplegado desde 2013 y continuamente evolucionado, usa silicio personalizado gestionando virtualización, redes y almacenamiento permitiendo AWS ofrecer instancias bare-metal con sobrecarga de virtualización casi cero. Infraestructura TPU de Google similarmente incorpora fabric de interconexión personalizado y silicio de gestión optimizado específicamente para cargas de trabajo TensorFlow.

Ventaja para hyperscalers construyendo silicio personalizado es diseño puede optimizarse exactamente para sus cargas de trabajo específicas, pilas de software y prácticas operacionales sin compromiso inherente en soluciones comerciales apuntando clientes diversos. Desventaja es costos NRE (ingeniería no recurrente) son amortizados solo a través de despliegues de compañía única, mientras Nvidia distribuye gasto de desarrollo a través de base de clientes completa potencialmente ofreciendo mejor precio y rendimiento para operadores más pequeños incapaces costear inversión en silicio personalizado. Además, Nvidia ofrece ecosistema integrado con GPUs, CPUs, redes y pila de software todo co-optimizado, simplificando adquisición y soporte versus ensamblar componentes heterogéneos desde múltiples proveedores.

Para clientes empresariales evaluando opciones de infraestructura, decisión entre Nvidia BlueField-4 versus nube de hyperscaler usando DPUs personalizados involucra trade-off entre control (despliegue en instalaciones con BlueField da más flexibilidad) versus conveniencia (hyperscaler maneja complejidad pero cliente cede control arquitectónico). Empresas con escala suficiente para operar gigafactorías computacionales propias pueden preferir aproximación BlueField obteniendo beneficios de silicio de proveedor sin lock-in de nube. Organizaciones más pequeñas probablemente encuentran ofertas de hyperscaler más accesibles dado menor requerimiento de capital inicial y simplicidad operacional mediante servicios gestionados. Modelos híbridos también emergiendo donde empresas ejecutan cargas de trabajo base en instalaciones pero explotan hacia nube durante picos de demanda, necesitando elecciones de infraestructura soportando portabilidad entre ambientes.

Referencias

NVIDIA Official Blog, "NVIDIA Launches BlueField-4: The Processor Powering the Operating System of AI Factories" (28 de octubre, 2025).

ServeTheHome, "NVIDIA BlueField-4 with 64 Arm Cores and 800G Networking Announced for 2026" (28 de octubre, 2025).

HPCwire, "Nvidia Cranks Its BlueField-4 DPU To 800 Gbps" (28 de octubre, 2025).

SDxCentral, "Nvidia's BlueField-4: A first look at the DPU built to run AI factories" (27 de octubre, 2025).

mashdigi, "NVIDIA unveils BlueField-4 DPU, integrating Grace CPU and ConnectX-9 networking to achieve 800Gbps throughput" (28 de octubre, 2025).

WEKA Press Release, "WEKA Announces New NeuralMesh Architecture Built for NVIDIA BlueField-4" (28 de octubre, 2025).

Business Wire, "F5 Unlocks Gigascale AI Infrastructure Using NVIDIA BlueField-4 DPUs" (28 de octubre, 2025).

Manila Times, "Crusoe Deploys NVIDIA BlueField-4 to Power the Next Generation of AI Infrastructure" (28 de octubre, 2025).

Yahoo Finance, "Qrypt Extends Quantum-Secure Gateway for AI Workloads with NVIDIA BlueField-4 DPUs" (28 de octubre, 2025).

NVIDIA Technical Blog, "NVIDIA Grace CPU Superchip Architecture In Depth" (julio 2025).

Arm Documentation, "Neoverse V2 | Leading HPC & ML with Armv9 Upgrades"

Wikipedia, "Data processing unit" (julio 2025).

Network Computing, "Harnessing DPUs & How DPUs are Changing Data Centers" (septiembre 2024).

Cisco, "What is a DPU?"

Kalray Blog, "DPUs, GPUs, and CPUs in the Data Center" (mayo 2024).

TechTarget, "How do CPU, GPU and DPU differ from one another?"

BizTech Magazine, "What Is a DPU (Data Processing Unit)? How Does It Work?"

GIGABYTE, "What is DPU (Data Processing Units)?" (marzo 2023).

VentureBeat, "Nvidia announces BlueField-3 DPUs for AI and analytics workloads" (abril 2021).

Data Center Knowledge, "Data Processing Units: What Are DPUs and Why Do You Want Them?" (junio 2024).

Tom's Hardware, "Nvidia announces Rubin GPUs in 2026, Rubin Ultra in 2027, Feynman also added to roadmap" (marzo 2025).

Data Center Dynamics, "Nvidia announces Vera Rubin Superchip for late 2026" (marzo 2025).

Wccftech, "NVIDIA Rubin & Rubin Ultra With Next-Gen Vera CPUs Start Arriving Next Year" (marzo 2025).

TechPowerUp, "NVIDIA Vera Rubin NVL144 Servers Set for 2026 Volume Production"

VideoCardz, "NVIDIA presents Vera Rubin Superchip, entering production next year" (28 de octubre, 2025).

NVIDIA Newsroom, "NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference"

The Register, "Nvidia Grace chip to use Arm Neoverse V2 CPU cores" (septiembre 2022).

Chips and Cheese, "Hot Chips 2023: Arm's Neoverse V2" (septiembre 2023).

Electronics Weekly, "Nvidia Grace super processor adopts Arm Neoverse V2" (octubre 2022).

NADDOD, "NVIDIA C8180 ConnectX-8 InfiniBand & Ethernet SuperNIC"

NVIDIA Docs, "ConnectX-8 SuperNIC Introduction"

Lenovo Press, "ThinkSystem NVIDIA ConnectX-8 8180 800Gbs OSFP PCIe Gen6 x16 Adapter Product Guide"

FiberMall, "AI Computing Hardware: ConnectX-8 SuperNIC" (febrero 2025).

Converge Digest, "NVIDIA rolls out 800G Networking Switches" (marzo 2024).

ASUS Servers, "NVIDIA ConnectX-8"

NVIDIA Blog, "Blue Lion Supercomputer Will Run on NVIDIA Vera Rubin" (junio 2025).