Por Javier Ruiz, Periodista Especializado en Inteligencia Artificial y Tecnología Emergente, para Mundo IA

La siguiente imagen corresponde al informe del MIT que constató que el 95% de las pruebas piloto corporativas de IA, pequeños ensayos internos para “probar” tecnología, no generaron ROI. A lo largo del siguiente artículo intentaré explicar por qué eso no significa que la IA fracase: describe pilotos mal diseñados (sin memoria de contexto, sin integración al flujo de trabajo y sin bucles de mejora), no el uso real de la IA. El valor aparece cuando los sistemas aprenden, se conectan al trabajo de verdad y mejoran con el uso; muchos directivos no lo vieron porque miraron solo los pilotos oficiales y no la adopción cotidiana (“shadow AI”).

El mito del 95%: qué dijo realmente el MIT y qué no dijo

Cuando apareció el titular “el 95% de los pilotos de IA fracasa”, muchos directivos y analistas tomaron la cifra como un veredicto técnico: la IA no rinde. Pero el documento del MIT que originó la cifra no decía eso. El porcentaje describe, sobre todo, el desempeño de pilotos corporativos a medida, encajonados en procesos de compras lentos, con mucha fricción para integrarse a los flujos reales, sin memoria de contexto y sin bucles de mejora. Es decir, medía el eslabón más débil del ecosistema, no “la IA en general”. En paralelo, el uso cotidiano de herramientas de IA por parte de trabajadores individuales siguió creciendo y entregando valor concreto. La paradoja nace de ahí: la foto de los pilotos oficiales es mala; la película del uso diario, bastante buena.

¿Por qué fallan esos pilotos? Porque parecen proyectos de laboratorio, no productos vivos. Se construyen con requerimientos que envejecen antes de llegar a producción; se validan en datasets estáticos que no se parecen al desorden del día a día; se lanzan sin un plan para aprender de la retroalimentación del usuario; y, sobre todo, se desconectan del “momento de verdad” del negocio: el lugar donde se toma una decisión, se cierra un ticket, se envía una pieza creativa, se aprueba una orden de compra o se responde a un cliente. En vez de insertarse en ese punto de contacto, orbitan alrededor. Y orbitar no paga facturas.

El 5% que sí funciona comparte rasgos comunes. Primero, memoria y contexto: el sistema recuerda lo que importa para el proceso (entidades, reglas, excepciones), ya sea con bases de conocimiento organizadas, RAG bien curado o memoria transaccional. Segundo, bucles de aprendizaje: capturan correcciones del usuario, miden dónde se equivoca el modelo, reentrenan o afinan prompts y políticas; en otras palabras, mejoran con el uso. Tercero, integración en el flujo: hablan con los sistemas de registro y gatillan acciones reales (crear un caso, actualizar un campo, proponer una respuesta que alguien envía con un clic). Cuarto, propiedad clara: existe un responsable de negocio que vela por que el modelo mueva una métrica que vale dinero, no un KPI cosmético. Cuando esos cuatro elementos se combinan, los pilotos dejan de ser “demo” y se convierten en herramientas de trabajo.

Entonces, ¿por qué el mercado castigó a “las acciones de IA” tras esa cifra? Porque confundió mala ejecución con malos fundamentos tecnológicos. La lectura correcta del informe es mucho más precisa (y optimista): los pilotos corporativos rígidos producen poco; el uso bottom-up y los servicios externos bien integrados producen mucho. Si uno mira solo el renglón “programa oficial de IA” en el presupuesto, ve fracaso; si mira la salida de trabajo y ciertas líneas de gasto operativo, ve progreso. Esa asimetría es la clave del debate.

La economía sumergida de la IA: Shadow AI en las empresas

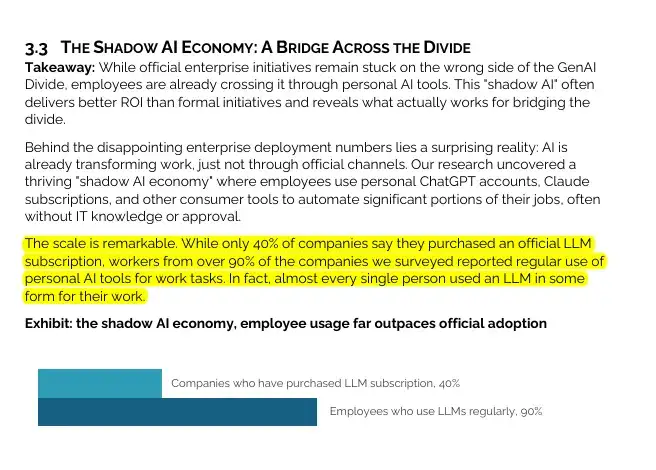

Mientras los pilotos oficiales se arrastran por los pasillos de compras, los empleados no esperan. Usan ChatGPT, Copilot, Perplexity, editores con IA, transcriptores, generadores de imágenes y asistentes de audio en el terreno: escriben correos, pulen propuestas, formatean planillas, limpian datos, sintetizan llamadas, bocetan copies o guiones de video. El artículo que citás lo dice explícito: en 9 de cada 10 empresas la gente ya usa IA de forma personal, aunque solo 4 de cada 10 tengan suscripciones oficiales. Esa brecha es lo que llamamos Shadow AI: trabajo real, con resultados tangibles, que no pasa por el carril presupuestario que ven los ejecutivos.

Esta economía sumergida tiene tres causas. La primera es fricción: cuando la herramienta corporativa exige VPN, ticket, permisos y tres aprobaciones, el usuario abre una pestaña y resuelve. La segunda es sensación de respuesta: los modelos generalistas “se sienten” más vivos porque cubren un abanico amplio y toleran instrucciones imprecisas; el empleado percibe que avanza. La tercera es incentivo: el reconocimiento se otorga por entregar a tiempo y con calidad, no por usar el canal “correcto”. Si la vía oficial no ayuda, la gente toma atajos. No hay conspiración: hay supervivencia.

El impacto de Shadow AI se ve en el output, no en los dashboards. Un analista que antes tardaba seis horas en limpiar un CSV ahora lo deja listo en dos; una redactora que peleaba con la página en blanco obtiene una primera versión en veinte minutos; un PM que debía reconducir notas dispersas de entrevistas arma un brief coherente en una hora. Ninguno de esos logros aparece como “ROI de IA” porque no vive en un proyecto etiquetado, vive en la productividad personal. Y sin embargo, el negocio se beneficia: se reducen colas, caen tiempos de ciclo, se acorta el “time to yes” comercial.

¿Significa esto que la Shadow AI es un bien puro? No. También trae riesgos: fuga de datos en prompts compartidos sin cuidado; versiones contradictorias de verdades de negocio (cada uno con su mini-base); dependencias de cuentas personales; y, en los casos más sensibles, incumplimientos regulatorios. Pero el camino no es prohibir: es absorber. Igual que pasó con el BYOD en su momento, el juego consiste en mover lo que funciona desde la sombra hacia un perímetro gobernado, sin matar la agilidad que lo hizo útil. La clave práctica es simple: identificar qué tareas generan más “tráfico clandestino” y ofrecer una alternativa corporativa mejor (no solo más segura).

Los empleados del 90% de las empresas utilizan herramientas de IA personales para trabajar, mientras que solo el 40% de las empresas tienen suscripciones oficiales, por lo que la mayor parte del uso nunca aparece en la línea de presupuesto que rastrean los ejecutivos.

Dónde está el ROI: costos externos, vendors y flujos reales

El artículo subraya un punto que duele a los CFOs: buena parte del valor ya aparece, pero no donde se lo busca. En vez de subir como ingresos, la IA empieza bajando gasto externo y tiempos. Ejemplos concretos:

-

Back-office y soporte. Automatizaciones impulsadas por IA (clasificación, extracción, redacción inicial de respuestas) están recortando entre 2 y 10 millones de dólares anuales en costos de terceros: menos tickets tercerizados, menos horas de BPO, menos servicios repetitivos. Esa mejora suele esconderse en líneas como “proveedores” o “servicios profesionales”, no en “programa de IA”. Quien mira solo revenue o headcount se lo pierde.

-

Marketing y contenido. Equipos que tercerizaban parte de la producción creativa reducen ~30% el gasto en agencias al internalizar bocetos, variaciones y localizaciones con IA, manteniendo revisión humana para el toque final. El output sube, el costo unitario baja. De nuevo: el ahorro aterriza en “agencias”, no en “IA”.

-

Vendor vs. build. Las compañías que se apoyan en socios externos llegan a despliegues productivos cerca de 2 veces más a menudo que las que intentan construir todo adentro. ¿Por qué? Madurez de toolings, experiencia acumulada, plantillas de integración y, sobre todo, foco: el vendor vive de que funcione. El aprendizaje para la empresa no es tercerizar el cerebro, sino acelerar el “arranque” y quedarse con el conocimiento del proceso.

Para capturar el ROI sin autoengañarte, ordená tres frentes en un mismo movimiento:

Primero, hacé visible el ahorro donde corresponde: un tablero de conciliación que cruce el uso de IA por flujo con las cuentas que realmente bajan (tercerizaciones, agencias, horas extra y reprocesos) y que muestre, mes a mes, el “antes → después” con responsables claros de Finanzas y del área. Segundo, medí el flujo, no la función: tiempo de ciclo de punta a punta, porcentaje de retrabajo, SLAs cumplidos, aprobaciones al primer intento y costo o margen por caso. La IA es un medio; la métrica es el negocio. Tercero, cerrá el ciclo de aprendizaje: cada corrección humana es un dato que debe alimentar ajustes de prompts, reglas, corpus de búsqueda y, si hace falta, un ajuste del modelo. Sin ese circuito de mejora continua, el piloto se estaciona en una meseta y deja de rendir.

Conviene sumar una advertencia: no escales basura. Si el proceso base es malo, la IA lo hará más rápido… y más dañino para la marca. La secuencia saludable es siempre la misma: mapear el flujo tal como es, quitar pasos y reglas inútiles, automatizar lo repetitivo sin IA donde tenga sentido, inyectar IA solo donde multiplica el criterio humano (búsqueda semántica, redacción inicial, verificación cruzada) e instrumentar métricas y auditorías desde el día uno para evitar la deriva silenciosa. Esa disciplina separa a quienes entran en el 5% que captura valor de quienes alimentan el 95% de pilotos estériles.

La síntesis para Finanzas es directa: el retorno hoy vive en costos evitados y tiempos acortados dentro de flujos reales. Para verlo hay que cazar el ahorro en las cuentas correctas, mover indicadores del proceso que importa y aprender todas las semanas con las correcciones de la gente. Todo lo demás (presentaciones brillantes sin integración ni números en el libro mayor) es una demostración bonita, no un resultado.

Más allá del PBI: excedente del consumidor y la métrica GDP-B

Otra razón por la que “no se ve” el valor es contable: el PBI y los estados financieros registran solo dinero que cambia de manos. Pero gran parte del impacto de la IA hoy es superávit del usuario (consumer surplus): el beneficio extra que las personas obtienen respecto de lo que pagan. El estudio que citás lo mide de forma elegante con experimentos de elección: “podés seguir usando la herramienta el mes próximo o aceptar X dólares y perder acceso”. Ajustando X, se encuentra el punto de indiferencia. El promedio entre adultos estadounidenses que usan IA regularmente dio 98 dólares por mes. Multiplicado por 82 millones y luego por 12 meses, el excedente anual estimado ronda los 97.000 millones de dólares. En la contabilidad nacional aparecen, en cambio, unos 7.000 millones de ingresos de los grandes proveedores. La brecha no es magia: es que el valor se queda en la gente, no en la caja de las empresas.

Para los macroeconomistas no es novedad: pasó con la web, con el GPS, con la mensajería gratuita. La novedad es la velocidad a la que ese excedente crece con GenAI y lo transversal de sus usos. ¿Qué hace el trabajador medio con esa utilidad? Acelera tareas, reduce errores, supera bloqueos, obtiene segundas opiniones. Nada de eso genera una transacción nueva; todo eso mejora producción. Por eso algunos economistas proponen métricas complementarias como GDP-B (un PBI ajustado por beneficios de bienes digitales gratuitos). A escala de empresa, el análogo es obvio: si medís solo licencias y “proyectos de IA”, vas a subestimar el impacto; necesitás una contabilidad de tiempo ahorrado, calidad ganada y costos evitados.

¿Cómo traducir el excedente del usuario en un tablero corporativo que sí sirva? Tres ideas. 1) Time Accounting: contabilizar horas recuperadas por rol y por flujo; no como fantasía (“la IA me ahorra 2 horas diarias”), sino en tramos observables (antes vs. después en un mismo caso). 2) Quality deltas: medir re-trabajo, tasa de aprobaciones a la primera, NPS de respuestas generadas con asistencia vs. sin asistencia. 3) Cost Avoidance: registrar explícitamente tickets que ya no se tercerizan, piezas que no salen a agencia, consultas legales pre-filtradas por IA que evitan horas caras. No es perfecto, pero alinea la brújula con el lugar donde el valor aparece de verdad.

Y una cautela: el excedente del consumidor puede ocultar desigualdades. Si la organización no reconoce ese valor en forma de mejores herramientas, formación y procesos, lo capitaliza solo quien ya es hábil con la tecnología. La IA puede ampliar brechas internas. De ahí la importancia de estandarizar lo que funciona y volverlo accesible para todos, no solo para los “power users”.

De la reacción al plan: cómo diseñar una estrategia de adopción que no fracase

Si aceptamos que el 95% mide el carril equivocado y que el valor real se esconde en flujos, ¿cómo armar un plan que cruce el puente desde la Shadow AI al impacto medible? Propongo un itinerario en cinco pasos, con decisiones concretas.

-

Elegir faros, no features. Un faro es un flujo donde se juega dinero todos los días (cobranza, soporte, pricing promocional, elaboración de propuestas, verificación contractual). Elegí 3–5 faros máximo. Para cada uno, definí la “métrica que importa” (tiempo de ciclo, promesas al día, costo por ticket, tasa de error) y una hipótesis de mejora alcanzable en 90 días (no prometer 70% si con 20% ya cambia la economía del área).

-

Integración mínima que toca la realidad. Nada de demos en sandbox perpetuo. La primera versión debe ver los datos reales y llevar la acción al sistema de registro (aunque sea por recomendaciones con un clic). Un asistente que redacta respuestas que nadie envía no vale; uno que propone, el humano corrige y se manda con traza, sí.

-

Bucles de aprendizaje explícitos. Toda corrección humana debe convertirse en señal. Esto no siempre exige reentrenar el modelo; muchas veces basta con ajustar prompts, plantillas, reglas de rechazo, o enriquecer el corpus de RAG con ejemplos de “buen” y “mal” resultado. Lo esencial es que al día 30 el sistema sea mejor que al día 1, y que se note en la métrica de negocio.

-

Gobernar la sombra sin matar la velocidad. Normalizá lo que ya usan los equipos: un “portal de IA” con herramientas aprobadas, políticas simples de datos (qué se puede copiar, qué no), plantillas de prompts para tareas frecuentes y un mecanismo ágil para proponer mejoras. Reprimendas genéricas sobre “no usen IA” empujan a la clandestinidad; mejores opciones la traen a la luz.

-

Compras que comprenden el producto. El área de Compras debe actualizar su manual para la contratación de IA: Esos contratos no se parecen a los de software tradicional. Importan cláusulas de datos (quién entrena con qué), controles de calidad, salidas (“exit”), tiempos de respuesta y métricas pactadas de mejora. Si un proveedor promete resultados sin integrarse a tu proceso, no ofrece una solución: muestra una demo.

A ese andamiaje le sumo un marco de métricas sencillo:

a) Eficiencia: tiempo de ciclo, piezas por persona, costo por ticket;

b) Eficacia: tasa de aprobación a la primera, exactitud medida con muestreos ciegos, NPS interno;

c) Riesgo: incidentes, falsos positivos/negativos en controles, cumplimiento de políticas de datos;

d) Adopción: porcentaje de tareas elegibles que pasan por la herramienta, tiempo de uso activo. No te enamores de dashboards de “tokens” o “llamadas a la API”: son medios. Lo que paga sueldos es otra cosa.

Dos tácticas aceleradoras:

Una, el barbell: combiná un par de productos horizontales (asistentes de redacción, análisis, búsqueda) con proyectos verticales muy pegados al negocio (cobranza, claims, trade). Lo horizontal entrega wins rápidos; lo vertical demuestra dinero.

Dos, el 30-60-90: en 30 días, piloto con usuarios reales; en 60, integración mínima y métricas; en 90, decisión honesta de escalar, rediseñar o matar. Nada de pilotos eternos: consumen autoridad.

Por último, cultura. La IA no reemplaza criterio; lo amplifica. La organización que prospera no es la que mejor “promptea”, sino la que convierte la corrección humana en aprendizaje del sistema, enriquece sus bases con ejemplos vivos, documenta decisiones y comparte prácticas. Eso convierte el 5% de aciertos en un efecto compuesto: cada semana, un poquito mejor.

Queda una moraleja simple. El informe del MIT no enterró a la IA; exhibió dónde se perdió el tiempo: en pilotos que no aprendían, no recordaban y no tocaban el trabajo de verdad. El valor está donde siempre estuvo: en los flujos que mueven dinero, en la fricción que se elimina, en los errores que se previenen, en los minutos que se recuperan y en los costos que ya no salen. Una parte de ese valor nunca entrará en el PBI ni en el presupuesto (vivirá como excedente del usuario), pero otra sí puede y debe aparecer si dejamos de medir vitrinas y empezamos a medir mostradores. El resto es ejecución: elegir faros, integrar en serio, aprender todo el tiempo y contar lo que importa. Con eso, el 95% deja de ser una condena y pasa a ser lo que siempre fue: una advertencia sobre cómo no desplegar tecnología.