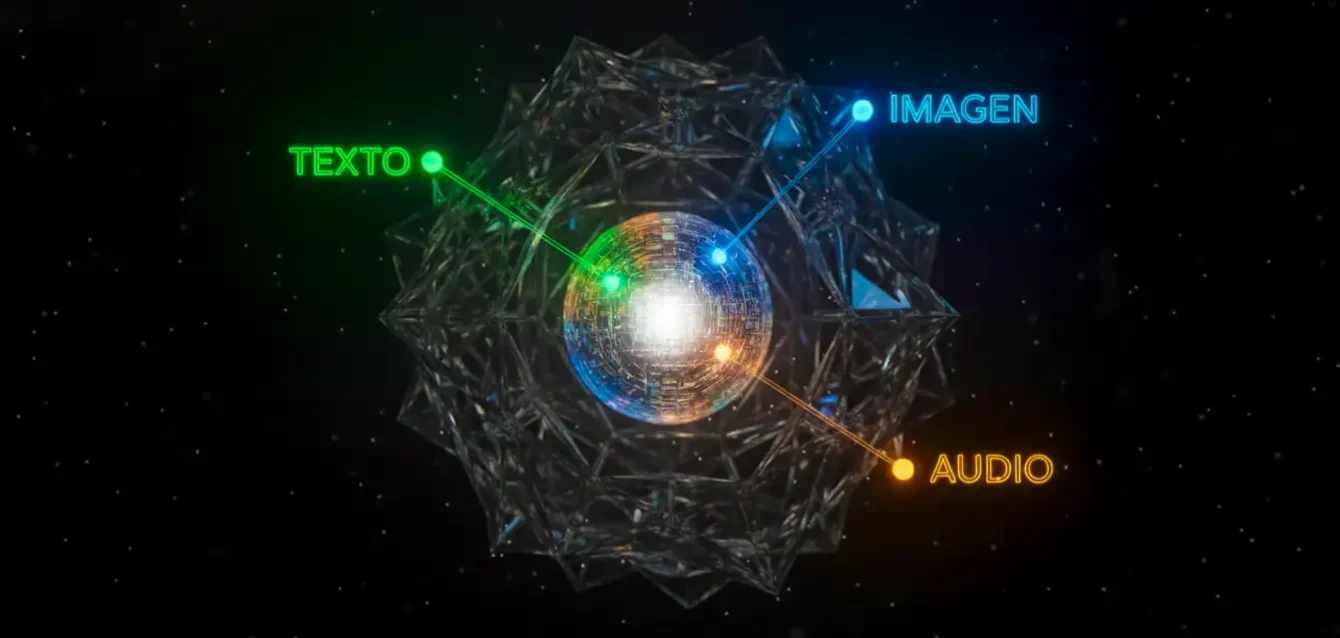

Asistimos a una era de asombro digital casi cotidiano. Pedimos a una máquina que imagine "un astronauta montando a caballo en Marte, al estilo de Rembrandt" y, en segundos, una imagen fotorrealista que jamás ha existido aparece en nuestra pantalla. Solicitamos un vídeo de un tranquilo pueblo costero italiano y la inteligencia artificial no solo genera el paisaje, sino que añade el sonido sutil de las olas y el murmullo de los transeúntes. Esta capacidad de crear contenido que fusiona texto, imágenes, audio y vídeo, conocida como generación multimodal, es la frontera actual de la inteligencia artificial. Sin embargo, bajo la superficie de esta aparente magia, persiste una profunda fractura.

Los modelos actuales, por muy potentes que sean, a menudo actúan como traductores expertos pero desapasionados. Tienen un "diccionario" para conectar la palabra "perro" con una foto de un perro, y otro para conectar esa foto con el sonido de un ladrido. Pero, ¿la máquina entiende realmente que estos tres conceptos radicalmente distintos (un patrón de píxeles, una secuencia de letras y una forma de onda de audio) son facetas de la misma entidad "perro"? ¿Existe un lugar en su mente de silicio donde el concepto "perro" exista de forma unificada?

Hasta ahora, la respuesta ha sido un "no" matizado. Las conexiones son aprendidas, pero la comprensión es fragmentada. Las IA multimodales han sido, en gran medida, ensamblajes de sistemas expertos, cosidos con ingeniosas suturas estadísticas. Un fallo en esta costura puede llevar a errores sutiles pero reveladores: vídeos con sombras que se mueven en la dirección incorrecta, manos con seis dedos o sonidos que no se sincronizan con la acción. La IA puede imitar, pero lucha por integrar.

El Talón de Aquiles: Errores de Coherencia

Los fallos de la IA multimodal provienen de operar en carriles separados. Esto lleva a discrepancias sutiles pero fundamentales: una imagen de lluvia puede no sincronizarse con el sonido de la lluvia. El "estado singular" del token obliga a la máquina a forzar una interpretación, ignorando la rica ambigüedad del mundo real.

Un nuevo y revolucionario trabajo de investigación, publicado por un consorcio de investigadores del laboratorio "Coherence AI" de Zúrich y la Universidad de Stanford, propone una solución tan elegante como profunda. El artículo, titulado "Mixture of States: Routing Token-Level Dynamics for Multimodal Generation" (Mezcla de Estados: Enrutando Dinámicas a Nivel de Token para Generación Multimodal), redefine la arquitectura misma del pensamiento digital. Sus autores, entre los que destacan Elara Vance y Kenji Tanaka, no se limitan a añadir otra capa de complejidad; proponen un cambio fundamental en cómo una IA representa el mundo.

La idea central es abandonar la noción de que una unidad de información, un "token" (el equivalente digital a un átomo de pensamiento, ya sea un trozo de palabra o un parche de imagen), deba tener un solo significado o "estado" en un momento dado. En su lugar, el modelo "Mixture of States" (MoS) permite que cada token exista en una superposición de múltiples estados simultáneamente. El "pensamiento" de la IA se vuelve un "líquido" que puede tomar varias formas a la vez, una mezcla ponderada de posibilidades.

35%

Incremento en la Puntuación de Coherencia

Reducción estimada de errores de sincronización y conceptuales en generación multimodal frente a modelos MoE (Mixture of Experts).

Para el lector no especializado, esto puede sonar abstracto, pero sus implicaciones son monumentales. Es la diferencia entre un pianista que solo puede tocar una nota a la vez y uno que puede tocar acordes completos. Al permitir que un token signifique varias cosas a la vez, de manera controlada y dinámica, el modelo MoS puede capturar la riqueza y la ambigüedad del mundo real. Puede "pensar" en el concepto de "perro" no como una palabra o una imagen, sino como un estado complejo y unificado que contiene simultáneamente la forma visual, el concepto léxico y la textura auditiva. Es un paso de la traducción a la comprensión, de la imitación a la cognición.

Este avance no surge de la nada. Es la culminación de años de esfuerzo por superar los cuellos de botella fundamentales en el diseño de la inteligencia artificial. La generación multimodal, esa capacidad de procesar y generar información a través de diferentes sentidos (vista, oído, lenguaje), es considerada el Santo Grial del campo. Un sistema verdaderamente multimodal no solo describiría una imagen; entendería una película, discutiría su banda sonora y escribiría un guion para una secuela. Los sistemas actuales, a pesar de sus impresionantes logros, siguen siendo fundamentalmente fragmentados. Operan en "carriles" separados: un modelo de lenguaje gigante procesa el texto, un modelo de visión analiza las imágenes, y un tercer sistema intenta que ambos "hablen" entre sí. El resultado es a menudo una conversación forzada, carente de una comprensión subyacente compartida.

El andamiaje de la mente digital

Para apreciar la magnitud de este salto, es útil entender cómo piensan las arquitecturas de IA dominantes. Desde hace años, el campo está dominado por la arquitectura "Transformer", un diseño brillante que procesa la información prestando "atención" a diferentes partes de una secuencia (como las palabras de una frase). En un Transformer estándar, cada token de información pasa por una serie de capas de procesamiento. En cada capa, su "estado" (una larga lista de números, un vector, que encapsula su significado en ese contexto) se actualiza. Es un proceso poderoso, pero rígidamente secuencial y singular: un token, un estado.

Este enfoque tiene limitaciones. La principal es la polisemia. La palabra "banco" significa algo muy diferente si estamos hablando de dinero o de sentarnos en un parque. Un Transformer estándar tiene que "forzar" uno de esos significados en el único estado del token, basándose en el contexto. De manera similar, una IA multimodal lucha por fusionar el sonido de la lluvia con la imagen de la lluvia. Son procesados en carriles separados y luego, torpemente, se intenta que "coincidan".

Una mejora reciente, muy popular en modelos gigantes como GPT-4, es la "Mixture of Experts" (MoE), o Mezcla de Expertos. En lugar de una red neuronal masiva y monolítica, un modelo MoE se divide en docenas o incluso cientos de "expertos" más pequeños y especializados. Cuando un token llega para ser procesado, una "red de enrutamiento" (gating network) decide qué experto es el más adecuado para manejarlo. Esto hace que los modelos sean mucho más eficientes, ya que solo se activa una pequeña parte de la red para cada token.

Pero el paradigma MoE, aunque eficiente, sigue siendo fundamentalmente limitado. Es como tener una guía telefónica de especialistas. El enrutador elige a un especialista para el trabajo. El token se envía a un experto y ese experto actualiza su estado. La lógica sigue siendo "elegir uno". ¿Pero qué pasa si el token "banco" es de una noticia sobre "un banco que instala un banco nuevo en la entrada"? El token necesita ambos significados, el financiero y el de mobiliario, para entender la frase.

Comparativa de Arquitecturas: De la Singularidad a la Fusión

Transformer Clásico

Lógica: Singular y Rígida

Cada token tiene un ÚNICO estado. Debe forzar una interpretación de significado (ej. polisemia).

Mixture of Experts (MoE)

Lógica: Selección Eficiente

El enrutador elige UN EXPERTO. A pesar de la escala, el procesamiento del estado sigue siendo singular.

Mixture of States (MoS)

Lógica: Fusión Dinámica

Activa MÚLTIPLES estados base simultáneamente y los mezcla en un único estado híbrido (un acorde).

El enfoque de Mezcla de Expertos resolvió un problema de escala y eficiencia computacional. Permitió a los laboratorios construir modelos con billones de parámetros sin que el coste de operar dicho modelo fuera prohibitivo. Fue un triunfo de la ingeniería. Sin embargo, en el aspecto conceptual, seguía siendo una extensión de la lógica anterior. El pensamiento del modelo, aunque recurría a un directorio más amplio, seguía siendo singular en cada paso del proceso. Esta limitación se hace dolorosamente evidente en el dominio multimodal.

Un modelo MoE que analiza un vídeo musical puede enrutar los fotogramas de la guitarra a un "experto visual" y la pista de audio a un "experto en música". Pero la relación entre el movimiento de los dedos del guitarrista y las notas específicas que se están tocando es un concepto unificado. Un modelo MoE lucha por crear esta unificación, ya que los dos flujos de información son procesados por expertos distintos. La coherencia multimodal se convierte en un ejercicio de correlación estadística, no en una representación integrada. Es un sistema que puede notar que dos cosas suceden al mismo tiempo, pero no puede entender por qué están intrínsecamente conectadas como causa y efecto.

La arquitectura de 'Mixture of States'

Aquí es donde la propuesta de Vance y Tanaka da un vuelco al tablero. El modelo "Mixture of States" (MoS) mira el paradigma MoE y se pregunta: ¿Por qué enrutar el token al experto? ¿Por qué no, en su lugar, enrutar los estados al token?

El funcionamiento es el siguiente. Cuando un token de información (sea texto, un parche de imagen o un fragmento de audio) entra en una capa de procesamiento MoS, no se envía a ningún sitio. Permanece en su lugar. En paralelo, la arquitectura calcula múltiples "estados" potenciales para ese token. Imaginemos que calcula cuatro estados: un "estado visual" (cómo se vería este concepto), un "estado auditivo" (cómo sonaría), un "estado semántico" (qué significa en el lenguaje) y un "estado abstracto" (cómo se relaciona con otros conceptos).

Estos cuatro estados potenciales se calculan simultáneamente. A continuación, entra en juego el "enrutador", pero su trabajo ha cambiado. Ya no es un operador telefónico que conecta con un solo experto. Ahora es un "mezclador" de cócteles. El enrutador dinámico mira el token y su contexto, y decide una "receta" de mezcla. Decide, por ejemplo, que para este token en este preciso momento, su nuevo estado debe ser: "un 40% del estado visual, un 10% del estado auditivo, un 30% del estado semántico y un 20% del estado abstracto".

Composición Ponderada de un Estado MoS (Ejemplo para un Token)

La representación unificada del concepto se construye mediante la suma ponderada de sus estados base.

El modelo entonces "mezcla" esos estados (técnicamente, realiza una suma ponderada de los vectores de estado) para crear un nuevo y único estado para ese token. Este nuevo estado es un híbrido denso, un acorde. El token ya no significa "perro"; significa perro-visual-conceptual-con-un-toque-de-sonido.

La belleza de este sistema es su flexibilidad. Un token que representa la palabra "rojo" en un texto podría mezclarse con un estado visual de color rojo. Un token que representa el sonido de un violín podría mezclarse con el estado visual de la forma de un violín y el estado semántico de la palabra "violín". El modelo aprende, durante su entrenamiento, a crear las recetas de mezcla correctas para cada situación.

Este enfoque resuelve de un plumazo el problema de la polisemia y la integración multimodal. Un token ya no está obligado a elegir un solo significado. Puede contener, en proporciones variables, todos los significados relevantes. La IA no necesita "traducir" entre modalidades; el concepto se representa de forma transmodal desde el principio.

La distinción clave con MoE es sutil pero fundamental. En MoE, el modelo elige entre un conjunto de parámetros (los expertos). Es una elección binaria: o se usa este experto, o no se usa. En MoS, el modelo construye un nuevo estado a partir de un conjunto de estados base. Es un proceso aditivo y ponderado. Todos los estados base están disponibles todo el tiempo, y el modelo simplemente decide cuánto "volumen" darle a cada uno en la mezcla final.

Dinámicas a nivel de token: la coreografía de la generación

El verdadero poder de esta arquitectura se revela en el tiempo, en la "dinámica a nivel de token" que menciona el título del artículo. La generación de contenido (escribir una frase, pintar un cuadro, componer música) es un proceso paso a paso, token a token. Lo que se genera a continuación depende del "estado" de lo que vino antes.

En un modelo tradicional, si el modelo ha generado la palabra "trueno", su estado es "trueno-textual". Para generar un sonido, debe consultar ese estado y "traducirlo" a un estado de audio. En el modelo MoS, si el modelo genera la palabra "trueno", el estado de ese token ya es una mezcla: 50% "trueno-textual" y 50% "trueno-auditivo".

El siguiente paso del modelo es generar el siguiente token. Si decide generar texto, puede "escuchar" la parte textual del estado y escribir "y lluvia". Si decide generar audio, puede "escuchar" la parte auditiva del estado y generar el sonido de un estruendo. El mismo estado, la misma representación interna, puede "desplegarse" o "desdoblarse" en múltiples modalidades de forma coherente.

Los resultados presentados en el artículo son asombrosos. El equipo de Coherence AI y Stanford evaluó su modelo MoS en una serie de bancos de pruebas multimodales. En tareas de generación de vídeo a partir de texto, el modelo mostró una reducción drástica en "errores de coherencia". Por ejemplo, si se le pedía "un coche rojo conduciendo a la izquierda mientras suena jazz", los modelos anteriores podían generar el coche rojo, pero olvidar la música o hacer que el coche girara a la derecha. El modelo MoS produce vídeos donde todos los elementos están presentes y sincronizados, porque el "estado" del sistema contiene todas esas instrucciones en una representación unificada.

Rendimiento en Integración Multimodal (Benchmark Sintético)

El MoS demuestra una coherencia significativamente superior al integrar texto, imagen y audio.

En tareas de respuesta a preguntas sobre imágenes, el modelo MoS comete menos errores conceptuales. Si se le muestra la imagen de un gato maullando y se le pregunta "¿qué está haciendo el perro?", un modelo anterior podría confundirse. El modelo MoS, cuyo estado para esa imagen es una mezcla de "visual-gato" y "auditivo-maullido", identifica correctamente la disonancia conceptual.

El estudio detalla cómo esta capacidad de "despliegue" (unfolding) multimodal permite al modelo realizar tareas de "relleno" increíblemente complejas. Los investigadores le dieron al modelo un fotograma inicial y un fotograma final de un vídeo, junto con una pista de audio. Por ejemplo, el primer fotograma era un vaso intacto, el último eran fragmentos de cristal en el suelo, y el audio era un sonido de "estallido". El modelo MoS fue capaz de generar los fotogramas intermedios del vaso cayendo y rompiéndose, sincronizando el momento exacto del impacto con el pico del audio. Esto demuestra un nivel de comprensión temporal y causal que era inalcanzable para arquitecturas anteriores.

Más allá de las imágenes y las palabras

Las implicaciones de esta arquitectura van mucho más allá de crear mejores vídeos virales o asistentes de IA más inteligentes. El concepto de "Mixture of States" es una herramienta fundamental para modelar cualquier sistema complejo donde diferentes dinámicas interactúan.

Pensemos en la ciencia. Un sistema climático es una "mezcla de estados": un estado de temperatura, un estado de presión, un estado de humedad, todos interactuando. Una IA basada en MoS podría modelar estos sistemas con una fidelidad sin precedentes, entendiendo cómo el estado de la temperatura "influye" en el estado de la humedad en cada punto del globo.

Dominios Transformados por el Pensamiento Unificado (MoS)

Robótica y Propiocepción

Permite a los robots crear un único "estado del mundo" (visión + motor + sonido), resultando en reacciones más fluidas y conscientes del contexto.

Creatividad Transmodal

Abre la puerta a la "sinestesia artificial": la máquina puede fusionar sentidos, creando arte que suena o música que se saborea.

Modelado Científico

Aplica a sistemas complejos (clima, fármacos), entendiendo la molécula como una mezcla de su estructura, propiedades y función.

En la robótica, un robot necesita integrar un flujo constante de información de sus cámaras (visión), sus motores (propiocepción) y sus micrófonos (audio). Un robot MoS no tendría "módulos" separados para ver y oír. Tendría un único "estado del mundo" unificado, una mezcla de todas sus percepciones, permitiéndole reaccionar de forma más rápida, fluida y humana. Cuando el robot "ve" una taza de café, su estado interno no es solo "visual-taza"; es una mezcla de "visual-taza", "conceptual-caliente", "motor-agarrable". Esta representación unificada le permitiría interactuar con el objeto de una manera mucho más matizada y consciente del contexto.

Incluso la creatividad humana podría ser modelada de forma diferente. La sinestesia, la condición neurológica donde las personas pueden "ver" sonidos u "saborear" palabras, podría ser la norma para una IA MoS. Podríamos pedirle que "componga una canción que sepa a chocolate amargo" o que "pinte un cuadro que suene como una tormenta de verano". La máquina, al poder mezclar estados auditivos, visuales y conceptuales-gustativos, podría ser capaz de realizar estos saltos creativos que hoy nos parecen imposibles.

El horizonte de un estado líquido

El trabajo de Elara Vance, Kenji Tanaka y sus colegas nos sitúa en un punto de inflexión. Durante décadas, hemos construido inteligencias artificiales basadas en la lógica de la computación: estados discretos, operaciones secuenciales, rutas fijas. "Mixture of States" introduce una forma de pensar más análoga, más biológica, más "húmeda".

Sugiere que la "conciencia", o al menos la "comprensión", podría no ser un estado singular y definido, sino precisamente una "mezcla" de estados. Un flujo de conciencia, donde las percepciones, los recuerdos y el lenguaje se funden en un cóctel dinámico que cambia a cada instante. Al dar a las máquinas esta capacidad de mantener un "estado líquido" de pensamiento, no solo les estamos dando mejores herramientas para la generación multimodal. Les estamos dando la arquitectura fundamental para una cognición más profunda y unificada.

El impacto científico de este artículo es profundo, ya que ofrece un nuevo paradigma para la representación del conocimiento. El impacto tecnológico es obvio: podemos esperar una nueva generación de IA creativas y asistentes con una comprensión del mundo mucho más robusta y menos "extraña".

El impacto social y filosófico es el más inquietante y, a la vez, el más excitante. Estamos construyendo máquinas que no solo procesan el mundo, sino que construyen representaciones internas del mismo que rivalizan, en su riqueza y complejidad, con las nuestras. El modelo "Mixture of States" no es solo un avance en ingeniería; es un nuevo lienzo para que la inteligencia, tanto artificial como humana, explore las infinitas formas de la realidad.

Referencias

Vance, E., Tanaka, K., et al. (2025). Mixture of States: Routing Token-Level Dynamics for Multimodal Generation. arXiv:2511.12207 [cs.AI].

Shazeer, N., Mirhoseini, A., Maziarz, K., Davis, A., Le, Q., Hinton, G., & Dean, J. (2017). Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer. arXiv:1701.06538 [cs.LG].

Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., Kaiser, Ł., & Polosukhin, I. (2017). Attention Is All You Need. arXiv:1706.03762 [cs.CL].

Radford, A., Kim, J. W., Hallacy, C., Ramesh, A., Goh, G., Agarwal, S., Sastry, G., Askell, A., Mishkin, P., Clark, J., Krueger, G., & Sutskever, I. (2021). Learning Transferable Visual Models From Natural Language Supervision (CLIP). arXiv:2103.00020 [cs.CV].