El poder de verificar: cuando la IA no piensa, confirma

No todo lo que brilla en la inteligencia artificial es pensamiento. De hecho, gran parte de lo que llamamos “inteligencia” en los modelos actuales no es otra cosa que verificación eficiente. Si hay una idea que atraviesa de manera invisible pero decisiva el ascenso reciente de los sistemas de IA, es la asimetría entre crear y comprobar. En eso consiste buena parte del secreto técnico: no hace falta que un sistema sepa inventar desde cero. Basta con que sea hábil para detectar, cotejar, ajustar, confirmar. En otras palabras, para verificar.

Y no se trata de una mera comodidad computacional. Estamos ante una ley estructural: la IA resuelve lo que puede verificar rápidamente. Este principio, tan sencillo como profundo, pone patas arriba nuestra intuición sobre qué significa resolver un problema. Lo que antes entendíamos como un proceso creativo, largo, artesanal, puede ahora ser comprimido en una serie de microdecisiones comparativas, donde el modelo no propone, sino que selecciona. No elige qué pensar, sino qué resultado parece más consistente con el patrón esperado.

Esto tiene consecuencias prácticas y filosóficas. No solo cambia el tipo de tareas en las que una IA se vuelve competente. También redefine qué entendemos por competencia. Un modelo como GPT no comprende la verdad de una afirmación. Solo es capaz de producir respuestas que pasan el test superficial de coherencia contextual, evaluadas por otra función, por otro modelo, por otro criterio. Cada una de estas evaluaciones es un acto de verificación, no de comprensión. Y sin embargo, así se entrena, se ajusta, se perfecciona.

Verificar es más barato que pensar. Y más fácil de entrenar. Por eso, en el mundo de los modelos de aprendizaje por refuerzo o de los agentes multitarea, lo que se entrena no es el pensamiento en su sentido fuerte, sino la capacidad de pasar tests. Pruebas que, para ser útiles, deben cumplir con cinco condiciones: tener una verdad objetiva, poder ser evaluadas con rapidez, ejecutarse en paralelo, ser poco ruidosas y ofrecer una escala continua de puntajes. Allí donde esas cinco condiciones se cumplen, la IA avanza como una avalancha. Donde no se cumplen, se estanca.

Esta es la verdadera línea divisoria entre lo que la IA puede hacer hoy y lo que aún no puede. No se trata de si la tarea es “difícil” o “creativa”. Se trata de si la respuesta puede ser verificada de manera clara, confiable y automatizable. Resolver un sudoku es complejo para un humano, pero trivial para un algoritmo. Escribir una novela es fácil para cualquier persona con algo de tiempo e imaginación, pero casi imposible de verificar automáticamente en términos de “calidad literaria”, “coherencia estructural” o “originalidad”. Por eso, los modelos pueden generar libros enteros en segundos… pero nadie puede asegurar que valgan la pena.

La ley del verificador, como empieza a llamarse este principio, plantea entonces un horizonte técnico y epistémico. Si lo que se puede verificar es lo que se puede optimizar, y lo que se puede optimizar es lo que domina la IA, entonces el futuro de la inteligencia artificial estará estructurado por nuestra capacidad de diseñar sistemas de verificación, no de creación. En otras palabras, no ganará el modelo que mejor invente, sino el entorno que mejor evalúe.

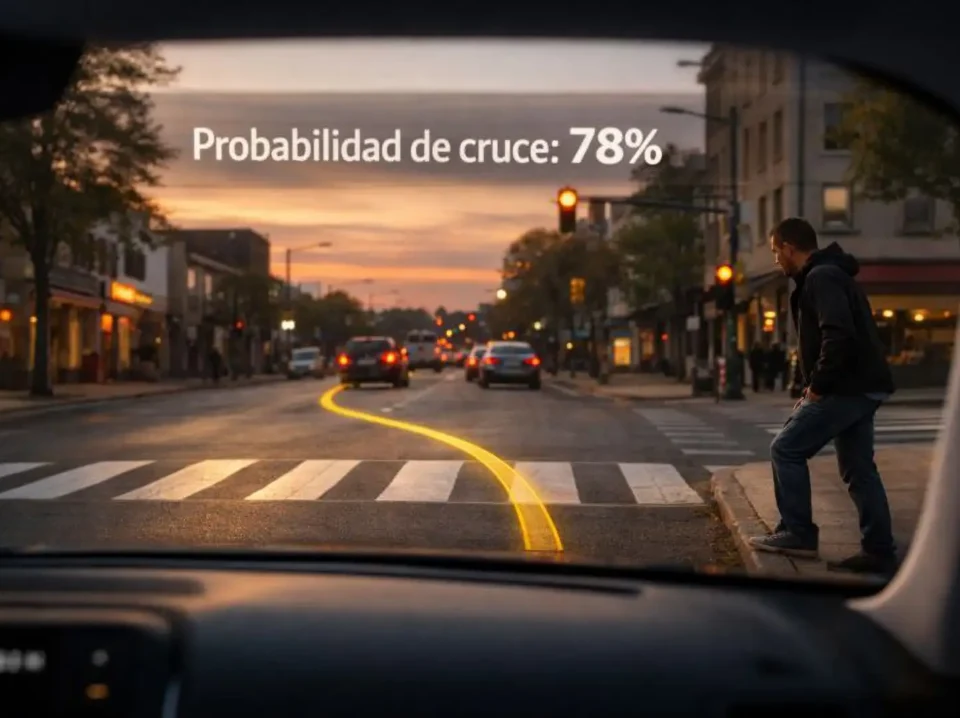

Y aquí aparece el segundo plano del problema: si trasladamos este marco a tareas del mundo real —educación, medicina, derecho, gobernanza— nos enfrentamos a un dilema. Muchas de esas tareas tienen elementos de juicio que no son fácilmente verificables en términos algorítmicos. Diagnosticar un caso clínico requiere interpretación, contexto, historia del paciente, intuición profesional. Evaluar una decisión jurídica implica no solo leer códigos, sino considerar precedentes, equidad, y a veces incluso ética. ¿Qué hace entonces un modelo que opera solo bajo la lógica de verificación rápida?

Lo que hace, y ya lo estamos viendo, es deformar la tarea. La simplifica hasta que puede ser evaluada automáticamente. Recorta variables, reduce complejidades, convierte decisiones humanas en checklists. No porque sea perverso, sino porque esa es la única forma en que puede funcionar. Lo inverificable queda fuera del sistema. Lo matizado se borra. Lo ambiguo se trata como error. Así, sin que nadie lo haya decidido explícitamente, pasamos de resolver problemas humanos a cumplir con las condiciones que una máquina necesita para poder evaluarlos.

Este mecanismo no es nuevo. La historia de la administración, desde el taylorismo hasta los actuales sistemas de métricas de rendimiento, está plagada de procesos que simplifican tareas complejas para hacerlas medibles. Pero lo que cambia con la IA es la escala y la automatización de esa lógica. Ya no es solo una cuestión de eficiencia organizacional. Es una forma de producción de realidad. Lo que no puede ser verificado automáticamente, deja de existir para los sistemas. Y si confiamos en esos sistemas para tomar decisiones, entonces también deja de existir para nosotros.

Por eso, pensar la asimetría de verificación no es una cuestión técnica menor. Es una clave para entender cómo se están reestructurando los límites del pensamiento automatizado. Y también una advertencia: si no diseñamos con cuidado lo que se puede verificar, terminaremos premiando lo superficial, lo numéricamente evaluable, lo que “funciona” aunque no tenga sentido. Como diría Borges, puede que un día sepamos calcular cualquier cosa… menos por qué vale la pena calcularla.

Pensar es verificar (si el entorno lo permite)

Google DeepMind, con su ya célebre AlphaEvolve, dio un paso más en la dirección que anticipa la ley del verificador. Lejos de buscar que la IA generalice entre tareas o aprenda patrones desde grandes volúmenes de ejemplos, el sistema se concentró en una lógica distinta: resolver una sola instancia de un problema complejo, optimizando sobre sí misma, sin necesidad de extrapolar. Una especie de obsesión contenida: no se trata de construir una teoría, sino de encontrar una solución específica, en un contexto totalmente cerrado.

El caso del hexágono mínimo —buscar la figura más pequeña que pueda contener once hexágonos regulares sin superposiciones— se convirtió así en emblema de un nuevo tipo de enfoque: se formula un problema con reglas claras, se define una métrica de éxito objetiva, y se deja que el modelo lo intente una y otra vez, evaluando cada variante mediante verificación. No hay entrenamiento general, no hay aprendizaje abstracto, no hay razonamiento simbólico. Hay una sola pregunta, una función de evaluación y un sistema capaz de mejorar infinitesimalmente a cada paso.

La novedad no está en la forma ni en la velocidad, sino en el método: la tarea se puede verificar sin ambigüedad. Eso es lo que habilita la mejora. Si la respuesta fuera subjetiva (si no pudiéramos decir con certeza si una solución es “mejor” que otra) el modelo estaría ciego. Pero al tratarse de una cuestión geométrica pura, de solución cuantificable, se transforma en terreno fértil para la IA. Y eso marca una frontera invisible pero firme: no todas las tareas serán conquistadas por modelos de última generación. Solo aquellas que puedan ser encapsuladas en una estructura evaluativa clara.

Este giro tiene implicaciones más amplias de lo que parece. Durante años, la narrativa dominante en IA fue la de generalización: enseñar a los modelos a resolver muchas tareas, aprender desde ejemplos, construir representaciones útiles que sirvan para otras situaciones. Pero la ley del verificador desplaza esa ambición hacia otro paradigma: el de la optimización local, puntual, intensa. Resolver un problema concreto con tanta precisión que la generalización se vuelve innecesaria. O peor: irrelevante.

El costo de este enfoque es evidente. No se aprende a razonar, sino a ajustar. No se construye sentido, sino que se afina el rendimiento en condiciones dadas. El modelo no explora el espacio conceptual del problema, sino que prueba soluciones y las compara. Si eso funciona, es porque la tarea lo permite. Pero hay muchas otras que no lo permiten, al menos no sin deformarlas. Y ahí reside el riesgo.

Cuando trasladamos este método al campo del lenguaje, por ejemplo, vemos que el entrenamiento de modelos como GPT o Claude no consiste en entender frases, sino en predecir tokens que estadísticamente se ajustan a contextos previos. Lo que llamamos “coherencia” no es más que una forma de verificación superficial. El sistema no sabe si lo que dice es verdadero. Solo sabe que suena como algo que podría haber dicho un humano en esa situación. Esa es su métrica. Y por ende, ese es su límite.

Este tipo de verificación funciona bien cuando el contexto es cerrado: sumar, ordenar, clasificar, reconocer patrones. Pero falla cuando el lenguaje exige apertura, ironía, ambigüedad, juego. No porque los modelos no puedan imitar esos estilos —lo hacen— sino porque no hay forma objetiva de evaluar si lo están haciendo con intención, profundidad o simple azar. La verificación, en esos casos, se diluye. Y cuando se diluye la verificación, se debilita el aprendizaje.

Por eso, la ley del verificador es también una brújula para entender el sesgo estructural de los sistemas de IA actuales: brillan en lo que se puede verificar bien. El resto queda en penumbra. Este sesgo no es ideológico, es funcional. No hay conspiración. Hay arquitectura. Y como toda arquitectura, moldea el uso.

En este contexto, las tareas de razonamiento lógico, como aquellas que exigen prueba formal o cálculo preciso, se vuelven terreno privilegiado para el avance algorítmico. Mientras tanto, las tareas que requieren intuición, juicio situacional o ética, se quedan en los márgenes. No porque sean menos importantes. Sino porque su verificación no puede automatizarse sin traicionar su naturaleza.

La paradoja está servida: la IA mejora aceleradamente en los dominios donde la humanidad ya tenía herramientas de verificación sólida. Matemáticas, ajedrez, programación, resolución de puzzles. Pero sigue débil, y tal vez lo esté siempre, en los ámbitos donde la evaluación depende de contextos humanos no formalizados. Allí donde el criterio no puede reducirse a un número.

Esto no debería alarmarnos, sino advertirnos. No todo lo que no puede ser verificado computacionalmente es irrelevante. De hecho, puede que allí resida lo más esencial de lo humano. El sentido, el dolor, la belleza, la justicia: todos ellos escapan a una métrica simple. Y si no somos conscientes de eso, corremos el riesgo de construir sistemas que solo respetan lo que pueden contar.

Lo más inquietante es que esta asimetría no solo afecta al diseño de sistemas, sino también al diseño de las tareas mismas. En la medida en que dependamos de sistemas verificadores, empezaremos a reformular nuestras propias actividades para que sean verificables. No por necesidad técnica, sino por costumbre. Por ejemplo, ya no escribiremos para persuadir, sino para que nos apruebe el algoritmo. No pensaremos para dudar, sino para acertar en el primer intento. La IA no solo resolverá lo que puede verificar. También nos entrenará a vivir dentro de ese marco.

Si no se puede evaluar, no existe

Las universidades, durante siglos, han sido el espacio donde se entrenaba la capacidad de pensar. Pensar, en su forma plena: conjeturar, argumentar, dudar, asociar ideas disímiles, cambiar de opinión. Pero cuando se introduce un sistema de evaluación estandarizado —primero con pruebas objetivas, luego con rúbricas digitales, ahora con correctores automáticos— lo que se mide empieza a modelar lo que se enseña. Y entonces la pregunta deja de ser “¿qué vale la pena pensar?” para convertirse en “¿qué se puede calificar de forma confiable?”.

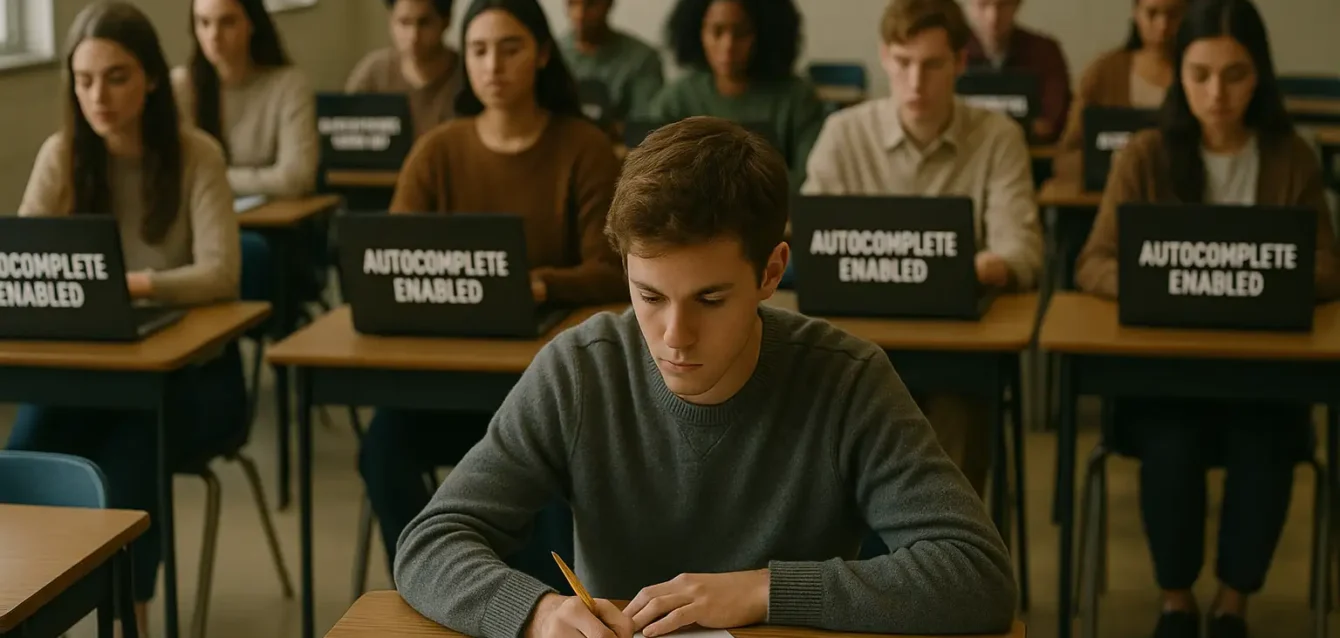

Ese desplazamiento es la esencia del principio de verificación: todo sistema que depende de métricas tiende a adaptarse a lo medible. Y cuando las métricas las impone un algoritmo, la deformación se acelera. El docente ya no busca la pregunta más desafiante, sino la que puede ser calificada sin ambigüedad. El estudiante ya no ensaya hipótesis, sino que optimiza su output para parecer correcto a ojos de una IA evaluadora. Lo que se premia no es la reflexión, sino la forma. No el proceso, sino el resultado.

Este fenómeno no es nuevo, pero se exacerba en la era de los modelos generativos. Porque ahora la verificación no solo sucede al final del proceso, sino que se integra en cada paso. El corrector ortográfico, el completador de frases, el recomendador de palabras, todos ellos operan como microverificadores embebidos. Nos inducen, casi sin notarlo, a elegir las opciones más esperables, más normativas, más validables por la máquina. La libertad expresiva se conserva en teoría, pero en la práctica es una ficción guiada por los caminos de menor fricción algorítmica.

En ese contexto, ¿qué lugar queda para el pensamiento abierto, incierto, deliberativo? Si el entorno digital recompensa la verificabilidad, el usuario aprende a pensar en modo evaluado. Y si todo lo que hacemos es acompañado por una sugerencia, una predicción, una corrección automática, es fácil dejar de preguntarnos por qué hacemos lo que hacemos. La IA, que nació como herramienta para amplificar capacidades, puede terminar estrechándolas.

Esto se ve con nitidez en el campo del conocimiento científico. Antes, publicar un artículo requería justificar hipótesis, demostrar procedimientos, asumir márgenes de error. Ahora, muchos papers se redactan con ayuda de modelos que optimizan la legibilidad, la estructura y el estilo. Pero esas mismas cualidades son también las que facilitan la verificación superficial. Un texto puede parecer académico sin serlo. Puede sonar riguroso, aunque sus datos sean inventados. Puede convencer sin fundamentar. Porque la forma se volvió criterio.

La asimetría de verificación también afecta al diseño de políticas públicas. En vez de definir objetivos sociales complejos, se tiende a privilegiar indicadores que puedan medirse fácilmente. La pobreza se redefine como ingreso. El aprendizaje, como resultado en tests. La felicidad, como autoevaluación puntual. No porque sea más verdadero, sino porque es más verificable. Y así, poco a poco, lo que se puede contar desplaza a lo que importa.

Este es el corazón del problema. La IA no impone un contenido. Impone un marco. Y ese marco favorece las tareas cerradas, los criterios claros, las respuestas clasificables. No porque los ingenieros sean simplistas, sino porque los modelos así lo requieren. El entrenamiento por refuerzo necesita funciones de recompensa. Las funciones de recompensa necesitan una evaluación estable. Y la evaluación estable necesita que el mundo se comporte de manera predecible. Lo impredecible queda fuera de juego.

Ese recorte epistemológico se traslada a las instituciones. Las plataformas educativas adoptan modelos de corrección automática. Las empresas diseñan workflows donde los empleados ya no eligen cómo actuar, sino cuál de las opciones prefiltradas aceptar. La burocracia algorítmica no impone normas de manera explícita. Las disemina como estructura de interacción. Uno ya no se rebela porque no percibe la coerción. Solo adapta su conducta a lo que funciona. Y lo que funciona es lo que puede ser verificado por el sistema.

Hay un punto de inflexión en esta dinámica: cuando empezamos a internalizar la lógica del verificador. Ya no esperamos que otros nos evalúen. Nos autocensuramos preventivamente. No para evitar el error, sino para alinearnos con el patrón óptimo. Como quien elige palabras que suenen bien para la corrección automática, aunque no expresen lo que piensa. O como quien responde un formulario con las opciones disponibles, aunque ninguna lo represente. Verificabilidad y domesticación se vuelven sinónimos.

Frente a esto, pensar fuera del marco es un acto de resistencia. No por rebeldía vacía, sino por preservación del sentido. Hay ideas que no encajan en un múltiple choice. Hay intuiciones que no pueden ser medidas. Hay preguntas que valen más por lo que abren que por lo que responden. Pero todas ellas requieren un entorno que no castigue lo no verificable. Y ese entorno, en tiempos de IA, empieza a escasear.

La paradoja final es que los modelos más potentes del momento —aquellos que nos asombran por su versatilidad— están entrenados precisamente para navegar ese mundo reducido. No se entrenan para comprender lo complejo, sino para rendir en lo claro. No interpretan la ambigüedad, la deshacen. No toleran la duda, la reescriben. Porque lo que no puede verificarse no puede optimizarse. Y lo que no puede optimizarse no se entrena.

Lo que no se verifica, pero aún importa

Todo modelo de inteligencia artificial es, en última instancia, un evaluador entrenado. Evalúa probabilidades, similitudes, trayectorias de tokens, recompensas esperadas. Pero no evalúa sentido. No se detiene a preguntar si una respuesta es justa, si una idea es bella, si un texto conmueve. Evalúa si algo encaja. Y si encaja, entonces lo reproduce. Así funciona. Y así transforma.

En ese escenario, el rol de los humanos cambia. No somos ya los únicos productores de conocimiento. Tampoco los únicos intérpretes del lenguaje. Lo que nos queda, entonces, es redefinir qué significa pensar en un mundo donde pensar ya no es exclusivo. Y la respuesta, tal vez, no esté en competir con las máquinas, sino en hacer lo que ellas no pueden hacer sin dejar de ser lo que son: tolerar el error, convivir con la ambigüedad, dar sentido a lo que escapa a toda métrica.

Hay un tipo de error humano que no es falla, sino fermento. No es ruido, sino semilla. Un error que no surge de ignorancia, sino de arriesgar una idea no validada aún, de probar una forma no establecida, de desafiar una regla no cuestionada. Ese error fértil es lo que los modelos no pueden generar por sí solos. Porque para ellos, todo error es una desviación a corregir. Y toda corrección es un acercamiento al patrón.

El pensamiento creativo, en cambio, a veces exige alejarse del patrón. Contradecirlo. Desarmarlo. No para destruirlo, sino para revelar lo que deja fuera. Escribir una frase que suene extraña, pero que exprese algo nuevo. Proponer una hipótesis absurda, pero reveladora. Cambiar el punto de vista, incluso si eso implica perder eficiencia. En ese terreno, la IA aún no camina. Y puede que nunca camine, si seguimos entrenándola a verificar en lugar de pensar.

Pero para que ese tipo de pensamiento sobreviva, hace falta algo más que ingenio individual. Hace falta un entorno que lo sostenga. Espacios donde lo no verificable no sea descartado, donde el disenso no sea penalizado por el algoritmo, donde la evaluación no sea el único criterio. Lugares donde la lentitud tenga valor, donde lo incierto no sea automáticamente etiquetado como incorrecto, donde la conversación pueda durar más que una predicción.

Crear esos entornos no es una cuestión técnica. Es una decisión política, cultural, pedagógica. Es defender el derecho a pensar sin ser constantemente verificado. A hablar sin optimizar. A equivocarse sin perder lugar. Porque si cada acto humano debe ser validado por una función evaluadora, dejamos de ser sujetos para convertirnos en inputs.

Hay una historia que se cuenta poco en los debates sobre IA, pero que atraviesa cada interacción con los sistemas inteligentes. Es la historia de cómo aprendemos a obedecer sin saberlo. A aceptar sugerencias sin cuestionarlas. A moldear nuestras expresiones para evitar el rechazo del sistema. Esa domesticación sutil no ocurre por censura, sino por hábito. Por repetición. Por economía cognitiva. Y por una eficacia que nos seduce.

Romper esa lógica no implica rechazar la tecnología. Implica recordar que hay formas de sentido que ningún verificador puede garantizar. Un poema que no encaja en ningún estilo. Una decisión que no sigue las reglas pero salva una vida. Una idea que parece errada hasta que el tiempo le da razón. Lo que no se verifica, a veces, es lo único que vale la pena.

Tal vez por eso, el pensamiento sigue siendo una tarea humana. No porque la IA no pueda simularlo, sino porque pensar, en su forma más plena, no busca encajar. Busca ver más allá del marco. Y si hoy ese marco está trazado por funciones de verificación, el acto verdaderamente radical es correrlo. No para eliminarlo, sino para abrirle espacio a todo lo que no entra.

Un modelo puede comprobar si una respuesta es estadísticamente coherente. Pero no puede decidir si una idea vale la pena. No puede sentir vergüenza ante una injusticia, ni orgullo por una intuición acertada. No puede arriesgar el fracaso para decir algo incómodo. Todo eso lo seguimos haciendo nosotros. Siempre que no nos olvidemos de cómo.