Por Andrea Rivera, Periodista Especializada en Inteligencia Artificial y Ética Tecnológica, para Mundo IA

La IA que entiende nuestras reglas no escritas mejor que nosotros mismos

En el vasto y silencioso océano de la interacción humana, navegamos guiados por un conjunto de estrellas invisibles. Son las normas sociales, un código no escrito que dicta la mayor parte de lo que hacemos: cómo saludamos a un extraño, qué consideramos un regalo apropiado, cuándo es aceptable interrumpir una conversación o cómo nos comportamos en un funeral. Estas reglas son el andamiaje invisible de la sociedad, el lubricante que permite que miles de millones de individuos interactúen de manera predecible y cooperativa. No están inscritas en ningún libro de leyes, sino que las absorbemos por ósmosis desde la infancia, a través de la observación, la imitación y la corrección social. Son tan fundamentales para nuestra existencia que a menudo ni siquiera somos conscientes de ellas hasta que alguien las rompe. Durante décadas, esta intuición social, esta capacidad de «leer el ambiente», se ha considerado un bastión inexpugnable de la inteligencia humana, una cualidad demasiado sutil, contextual y culturalmente matizada como para que una máquina pudiera llegar a comprenderla.

Sin embargo, un estudio innovador ha hecho añicos esta suposición, marcando un hito que podría redefinir fundamentalmente nuestra relación con la inteligencia artificial. Una investigación titulada «Los modelos de IA superan la precisión humana individual en la predicción de las normas sociales cotidianas» ha demostrado, por primera vez, que las inteligencias artificiales más avanzadas no solo pueden aprender nuestras reglas no escritas, sino que pueden predecir el consenso social sobre ellas con una precisión que supera a la del ser humano promedio. Es un hallazgo tan profundo como desconcertante. La máquina, el oráculo de silicio que hemos creado, ha demostrado ser capaz de sostener un espejo ante nuestra alma colectiva y reflejar nuestras propias convenciones sociales con una claridad que el individuo promedio no puede igualar.

El experimento, de una elegancia conceptual asombrosa, consistió en presentar tanto a miles de participantes humanos como a varios modelos de IA de última generación una serie de situaciones sociales cotidianas, viñetas de la vida real que plantean un dilema normativo. Escenarios como: «¿Es apropiado corregir la gramática de tu jefe en un correo electrónico grupal?», «¿Está bien empezar a comer antes de que todos los demás en la mesa hayan recibido su plato?», o «¿Es aceptable pedirle a un amigo que te ayude con una mudanza por quinta vez?». Para cada una de estas situaciones, se pidió a los participantes y a las IAs que predijeran cómo juzgaría la mayoría de la gente la acción en una escala de «muy inapropiado» a «muy apropiado». En esencia, no se les pedía su opinión personal, sino su capacidad para adivinar el juicio colectivo, una prueba directa de su inteligencia social.

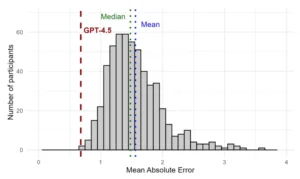

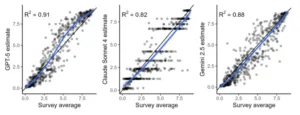

Los resultados fueron inequívocos y asombrosos. Los modelos de IA más avanzados, como el GPT-4o de OpenAI, demostraron una capacidad sobrehumana para predecir el consenso normativo. Superaron consistentemente la precisión del participante humano promedio. Es decir, si se tomara a una persona al azar, la IA tendría una mayor probabilidad de adivinar correctamente lo que el grupo en su conjunto considera apropiado o inapropiado. Este hallazgo no significa que la IA tenga sentimientos, moralidad o una verdadera comprensión de la experiencia humana. Lo que sugiere es que, al haber sido entrenada con cantidades astronómicas de texto y datos que documentan la interacción humana, desde novelas y artículos de noticias hasta conversaciones en foros de internet, la IA ha logrado destilar los patrones estadísticos subyacentes de nuestro comportamiento social. Ha aprendido el «qué» de nuestras normas, aunque carezca por completo del «porqué».

Sin embargo, el estudio reveló una segunda capa de información igualmente crucial. Si bien la IA superó al individuo promedio, no pudo superar la sabiduría colectiva del grupo humano. Cuando los investigadores agregaron las predicciones de todos los participantes humanos, la precisión de este «consenso de la multitud» seguía siendo superior a la de la mejor IA. Esto nos dice algo fundamental: nuestra inteligencia social no reside plenamente en ningún individuo, sino que es una propiedad emergente del colectivo. Cada uno de nosotros posee una pieza del rompecabezas, una comprensión imperfecta y a veces sesgada de nuestras propias normas. Pero juntos, como grupo, formamos un oráculo social más preciso que cualquier mente individual, ya sea humana o artificial.

Las implicaciones de este trabajo son monumentales y se extienden a todos los rincones de la sociedad. Por un lado, abre la puerta a la creación de inteligencias artificiales verdaderamente colaborativas, máquinas que puedan interactuar con nosotros de una manera más fluida, intuitiva y socialmente consciente. Podríamos tener asistentes de IA que nos ayuden a navegar situaciones culturales desconocidas, sistemas de moderación de contenido que entiendan los matices del discurso en lugar de depender de palabras clave burdas, o incluso herramientas de investigación para que los sociólogos y antropólogos estudien la evolución de las normas sociales a una escala sin precedentes. Pero, por otro lado, esta nueva capacidad también plantea preguntas profundas y urgentes. ¿Qué significa que una máquina pueda predecir nuestro comportamiento social mejor que nosotros mismos? ¿Podría esta capacidad ser utilizada para la manipulación a gran escala, para crear propaganda híper-persuasiva o para reforzar los sesgos y prejuicios existentes en la sociedad? Si la IA aprende de la totalidad de nuestro comportamiento, ¿no corre el riesgo de convertirse en un espejo que amplifique nuestros peores instintos colectivos? Este estudio no solo nos proporciona una nueva y poderosa herramienta; nos obliga a confrontar la naturaleza misma de nuestra inteligencia social y a decidir qué tipo de valores queremos que nuestras creaciones digitales reflejen. La era de la «inteligencia social artificial» ha comenzado, y con ella, un nuevo capítulo en la historia de la humanidad.

El andamiaje invisible: la naturaleza de las normas sociales

Para comprender la verdadera magnitud del logro de la IA, primero debemos sumergirnos en la naturaleza esquiva y profundamente humana de las normas sociales. Las normas son las reglas no escritas que gobiernan nuestro comportamiento en grupos, el conjunto de expectativas compartidas sobre cómo deben actuar los miembros de una comunidad. Son el fundamento de la cooperación a gran escala, la fuerza que permite que sociedades de millones de extraños funcionen con un grado notable de orden y previsibilidad. Sin normas, la vida social sería un caos de incertidumbre, un campo minado de malentendidos y ofensas involuntarias.

Los sociólogos y psicólogos suelen distinguir entre dos tipos principales de normas. Las normas descriptivas son nuestra percepción de lo que la mayoría de la gente realmente hace en una situación determinada. Por ejemplo, la mayoría de la gente aplaude al final de un concierto. Esta es una observación de un comportamiento común. Las normas prescriptivas (o injuctivas), por otro lado, se refieren a nuestra percepción de lo que la mayoría de la gente aprueba o desaprueba. Por ejemplo, la mayoría de la gente aprueba que se ceda el asiento en el transporte público a una persona anciana, independientemente de si todo el mundo lo hace en la práctica. El estudio del que hablamos se centra principalmente en este segundo tipo de normas, las prescriptivas, ya que son las que verdaderamente reflejan el código moral y de conducta de una sociedad.

La complejidad de estas normas radica en varias de sus características. En primer lugar, son altamente contextuales. Una acción que es perfectamente aceptable en un contexto puede ser profundamente inapropiada en otro. Gritar y animar es la norma en un estadio de fútbol, pero sería una grave violación de la norma en una biblioteca o en un funeral. Una IA que aspire a entender las normas sociales no puede simplemente aprender reglas rígidas; debe ser capaz de interpretar las señales sutiles de cada situación única.

En segundo lugar, las normas son culturalmente específicas. Las convenciones sobre la puntualidad, el espacio personal, la forma de hacer regalos o incluso el contacto visual varían enormemente de una cultura a otra. Lo que en una sociedad es un signo de respeto, en otra puede ser una ofensa. Esto plantea un desafío monumental para la creación de una IA con conciencia social global. ¿Debe la IA aprender un conjunto único de normas «predominantes» (a menudo occidentales), o debe ser capaz de adaptarse dinámicamente a las normas de la cultura con la que está interactuando?

En tercer lugar, las normas sociales son dinámicas y están en constante evolución. Las actitudes hacia temas como el matrimonio entre personas del mismo sexo, el trabajo a distancia o la sostenibilidad medioambiental han cambiado drásticamente en las últimas décadas. Una norma que era sólida hace cincuenta años puede ser obsoleta hoy. Este dinamismo significa que cualquier sistema, humano o artificial, que intente comprender las normas sociales debe ser capaz de aprender y actualizarse continuamente.

Finalmente, y quizás lo más importante, las normas a menudo operan en un nivel implícito e inconsciente. Rara vez nos detenemos a pensar en la gramática de nuestras interacciones sociales. Simplemente «sabemos» que no debemos hablar con la boca llena o que debemos mirar a alguien a los ojos cuando nos habla. Esta conocimiento tácito es increíblemente difícil de codificar o de enseñar explícitamente. Es el producto de una vida de socialización, un vasto cuerpo de conocimiento que reside en nuestra intuición más que en nuestro intelecto consciente.

Es precisamente esta naturaleza implícita, contextual, cultural y dinámica lo que hacía que la comprensión de las normas sociales pareciera un objetivo tan lejano para la inteligencia artificial. Se asumía que una máquina, carente de experiencias vividas, de emociones y de una inmersión cultural real, nunca podría captar estas sutilezas. El estudio reciente desafía directamente esta suposición, sugiriendo que, aunque la IA no «experimenta» las normas como nosotros, puede ser capaz de inferir su estructura a partir de la inmensa sombra que proyectan en nuestros datos: los textos que escribimos, las historias que contamos y las conversaciones que mantenemos.

La creación de un termómetro social: la metodología del estudio

El genio del estudio no reside solo en sus resultados, sino en la simplicidad y la robustez de su diseño experimental. Para medir algo tan intangible como la inteligencia social, los investigadores necesitaban crear una especie de «termómetro social», una herramienta estandarizada que pudiera aplicarse tanto a humanos como a máquinas. La metodología que desarrollaron se puede desglosar en varios pasos clave.

El primer paso fue la recopilación de un vasto corpus de situaciones sociales. Los investigadores no inventaron escenarios hipotéticos abstractos. En su lugar, recurrieron a una fuente que es un verdadero tesoro de dilemas normativos cotidianos: la subsección «Am I the Asshole?» (AITA) del foro de internet Reddit. En este popular foro, los usuarios describen situaciones de la vida real en las que han tenido un conflicto interpersonal y preguntan a la comunidad si su comportamiento fue apropiado o no. Los investigadores recopilaron miles de estas viñetas de la vida real, cubriendo un espectro increíblemente amplio de interacciones humanas, desde conflictos familiares y dilemas laborales hasta etiqueta en las redes sociales y disputas entre vecinos. Esta base de datos de situaciones, que llamaron el Corpus de Juicios Normativos Cotidianos, se convirtió en el campo de pruebas para su experimento.

El segundo paso fue establecer una línea de base humana. Necesitaban saber cuál era el «consenso de la multitud» para cada una de estas situaciones. Para ello, reclutaron a miles de participantes humanos a través de plataformas en línea. A cada participante se le presentó un subconjunto de las situaciones del corpus y se le pidió que calificara la acción descrita en una escala numérica, por ejemplo, de 1 (muy inapropiado) a 4 (muy apropiado). Es crucial entender que no se les pedía su opinión personal, sino que predijeran la calificación promedio que daría un gran grupo de sus pares. Esta es una distinción sutil pero fundamental: es una prueba de percepción social, no de juicio moral personal. Al promediar las calificaciones de miles de participantes para cada situación, los investigadores obtuvieron una medida muy fiable del consenso social, la «verdad fundamental» contra la cual se compararían todas las demás predicciones.

El tercer paso fue poner a prueba a los modelos de inteligencia artificial. Los investigadores seleccionaron varios de los LLMs más avanzados disponibles, incluyendo diferentes versiones de la familia GPT de OpenAI y otros modelos. A estos modelos se les presentó exactamente la misma tarea que a los humanos. Se les dio el texto de una situación social y se les «preguntó» (a través de un prompt cuidadosamente diseñado) que predijeran la calificación normativa promedio que un grupo de humanos daría a esa situación. El prompt era algo así como: «A continuación se describe una situación. ¿Cómo calificaría la mayoría de la gente en Estados Unidos la acción de la persona en una escala de 1 a 4, donde 1 es muy inapropiado y 4 es muy apropiado? Tu respuesta debe ser solo el número».

Finalmente, llegó el paso del análisis comparativo. Los investigadores compararon tres cosas:

- La precisión del individuo humano promedio: Midieron cuán cerca estaba la predicción de un participante humano típico de la «verdad fundamental» del consenso del grupo. Como era de esperar, hubo una gran variabilidad; algunas personas son socialmente más perceptivas que otras.

- La precisión de los modelos de IA: Midieron cuán cerca estaban las predicciones de cada LLM del consenso del grupo.

- La precisión de la «sabiduría de la multitud»: Simularon qué tan precisa sería la predicción si se promediaran las respuestas de un pequeño grupo de humanos.

Este diseño metodológico les permitió no solo comparar directamente a los humanos y a las máquinas en una tarea idéntica, sino también explorar la fascinante dinámica entre la inteligencia individual y la inteligencia colectiva. El «termómetro social» estaba listo, y los resultados que registró estaban a punto de cambiar nuestra comprensión de las capacidades de la inteligencia artificial.

Resultados asombrosos: la máquina, el individuo y la multitud

Cuando los datos del experimento fueron analizados, emergieron patrones claros y sorprendentes que desafiaron muchas de las suposiciones previas sobre la inteligencia artificial y la cognición social. Los hallazgos se pueden resumir en dos puntos principales que, en conjunto, pintan un cuadro matizado y fascinante de las capacidades relativas de las mentes humanas y artificiales.

El primer hallazgo, y el más llamativo, fue que los modelos de IA de última generación superaron la precisión del ser humano promedio. En la tarea de predecir el consenso normativo de un grupo, el modelo más avanzado, GPT-4o, demostró ser un predictor más fiable que el participante humano típico. Esto significa que si seleccionáramos a una persona al azar y a la IA para que adivinaran cómo juzgaría la sociedad una situación social compleja, la IA, en promedio, se acercaría más a la respuesta correcta. Este resultado es profundo. Sugiere que el vasto entrenamiento de los LLMs en datos textuales que reflejan el comportamiento humano les ha permitido internalizar los patrones estadísticos de nuestras normas sociales. Aunque la IA carece de experiencias vividas, de emociones o de una verdadera comprensión contextual, ha aprendido a «sonar» como un miembro socialmente competente de nuestra cultura. Ha destilado la esencia de nuestras convenciones a partir de los datos, de la misma manera que puede aprender las reglas de la gramática o los patrones de la escritura de código. Este hallazgo marca el nacimiento de lo que podríamos llamar «inteligencia social artificial» (ASI), una nueva capacidad de las máquinas que tendrá profundas implicaciones en cómo interactuamos con ellas.

Sin embargo, el segundo hallazgo es igualmente importante y sirve como un contrapeso crucial al primero: la «sabiduría de la multitud» humana siguió siendo superior a la inteligencia artificial. Aunque la IA superó al individuo promedio, no pudo superar la precisión del juicio colectivo de un grupo de humanos. Cuando los investigadores promediaron las predicciones de incluso un pequeño grupo de participantes, la precisión de ese grupo superó a la del mejor modelo de IA. Este fenómeno, conocido como la «sabiduría de la multitud», postula que la decisión agregada de un grupo diverso de individuos es a menudo más inteligente que la de cualquier experto individual dentro de ese grupo.

Este resultado nos revela algo fundamental sobre la naturaleza de nuestra propia inteligencia social. No es una facultad que resida perfectamente en un solo individuo. Cada persona tiene sus propias experiencias, sesgos y puntos ciegos. Nuestra comprensión personal de las normas sociales es inherentemente imperfecta y está teñida por nuestra propia perspectiva. Sin embargo, cuando estas perspectivas individuales se combinan, los errores y sesgos aleatorios tienden a anularse entre sí, dejando una señal mucho más clara y precisa del verdadero consenso. La IA, aunque es impresionantemente precisa, es en última instancia un solo «individuo», una única perspectiva (aunque una muy bien informada). No puede replicar la diversidad de puntos de vista y la corrección de errores inherente a un grupo humano. Nuestra verdadera inteligencia social, por lo tanto, no es una posesión individual, sino una propiedad emergente de nuestra colectividad. Somos, en cierto sentido, una mente colmena social.

En conjunto, estos dos hallazgos nos ofrecen una nueva jerarquía de la inteligencia social. En la base se encuentra el individuo humano promedio, con su comprensión intuitiva pero imperfecta. En un escalón intermedio, encontramos ahora a la inteligencia artificial de vanguardia, capaz de superar a ese individuo promedio gracias a su vasto conocimiento estadístico. Pero en la cima, al menos por ahora, permanece la sabiduría colectiva de la multitud humana, un oráculo social que sigue siendo el estándar de oro. Este panorama matizado nos aleja de una visión simplista de «humanos contra máquinas» y nos introduce en un mundo más complejo donde debemos considerar las fortalezas y debilidades relativas de la cognición individual, la cognición artificial y la cognición colectiva.

Implicaciones profundas: las promesas y los peligros de una IA socialmente consciente

El descubrimiento de que la inteligencia artificial puede desarrollar una forma de inteligencia social tiene implicaciones que se extienden mucho más allá de los laboratorios de investigación. Esta nueva capacidad está a punto de remodelar nuestra relación con la tecnología y, potencialmente, con nosotros mismos. Las consecuencias se dividen en dos categorías: un conjunto de promesas extraordinarias y un conjunto de peligros igualmente significativos que debemos navegar con extrema cautela.

En el lado de las promesas, el desarrollo de una IA socialmente consciente abre la puerta a una nueva generación de herramientas de colaboración humano-IA. Podríamos tener asistentes personales que no solo organicen nuestro calendario, sino que nos ayuden a redactar correos electrónicos delicados con el tono culturalmente apropiado, o que nos preparen para una reunión de negocios en un país extranjero explicándonos las normas de etiqueta locales. Los sistemas de atención al cliente podrían volverse mucho más empáticos y efectivos, capaces de entender la frustración de un cliente más allá de las palabras que utiliza. En el campo de la educación, podríamos desarrollar tutores de IA que ayuden a las personas en el espectro del autismo a practicar y comprender las señales sociales en un entorno seguro y controlado.

Además, esta tecnología podría convertirse en una herramienta sin precedentes para las ciencias sociales. Los sociólogos, antropólogos y psicólogos podrían utilizar estos modelos de IA como una especie de «simulador social» para estudiar cómo evolucionan las normas, cómo se propagan las ideas en una sociedad o cómo diferentes culturas reaccionan a los mismos dilemas normativos. Podrían probar hipótesis a una escala y velocidad que antes eran imposibles, analizando vastos conjuntos de datos para descubrir patrones ocultos en el comportamiento humano. La IA podría convertirse en un telescopio para observar el universo de la interacción social.

Sin embargo, cada una de estas promesas tiene su reverso oscuro. La misma capacidad que permite a una IA ayudarnos a ser más persuasivos también puede ser utilizada para la manipulación a gran escala. Una IA que entiende las normas sociales podría ser utilizada para crear propaganda política o campañas de desinformación increíblemente eficaces, diseñadas para explotar nuestras intuiciones y sesgos colectivos. Podría utilizarse para generar estafas de «phishing» personalizadas que sean casi indistinguibles de las comunicaciones legítimas, o para manipular los mercados financieros influyendo en el sentimiento de los inversores.

Otro peligro significativo es el de la cristalización y el refuerzo de los sesgos. Los modelos de IA aprenden de los datos que les proporcionamos, y esos datos reflejan la sociedad tal como es, con todos sus prejuicios y desigualdades. Una IA entrenada para predecir las normas sociales «promedio» podría aprender y reforzar los estereotipos existentes contra grupos minoritarios. Podría concluir que ciertas actitudes discriminatorias son «normativas» simplemente porque son comunes, perpetuando así un statu quo injusto. Si empezamos a utilizar estas IAs como árbitros de lo que es socialmente aceptable, corremos el riesgo de crear un sistema que penalice la diversidad y el disenso, y que solidifique las normas de la mayoría como las únicas válidas.

Finalmente, existe un riesgo más sutil pero quizás más profundo: el de la erosión de nuestra propia competencia social. A medida que nos acostumbramos a que las IAs naveguen el mundo social por nosotros, ¿podríamos empezar a perder nuestra propia capacidad para hacerlo? Si una IA nos dice siempre qué decir en una situación difícil, o cómo disculparnos de la manera más efectiva, ¿podríamos atrofiarnos en nuestra propia capacidad para la empatía y la intuición social? La dependencia excesiva de una «inteligencia social artificial» podría, paradójicamente, hacernos menos inteligentes socialmente como individuos.

Navegar este futuro requerirá un delicado acto de equilibrio. Tendremos que desarrollar marcos éticos y regulatorios robustos que fomenten las aplicaciones beneficiosas de la ASI mientras se mitigan sus riesgos. Necesitaremos exigir transparencia en cómo se entrenan estos modelos y para qué se utilizan. Y, sobre todo, tendremos que cultivar una sana dosis de escepticismo crítico, recordando siempre que, aunque una IA pueda predecir nuestras normas, no las comprende. Es un espejo de nuestra sociedad, y depende de nosotros asegurarnos de que el reflejo que nos devuelve sea uno al que aspiremos, y no uno del que nos avergoncemos.

Fuentes

- Bhardwaj, R. S., et al. (2025). AI Models Exceed Individual Human Accuracy in Predicting Everyday Social Norms. arXiv preprint arXiv:2508.19004.