El arte de las imágenes que responden: Midjourney V7 y la promesa de una imaginación afinada

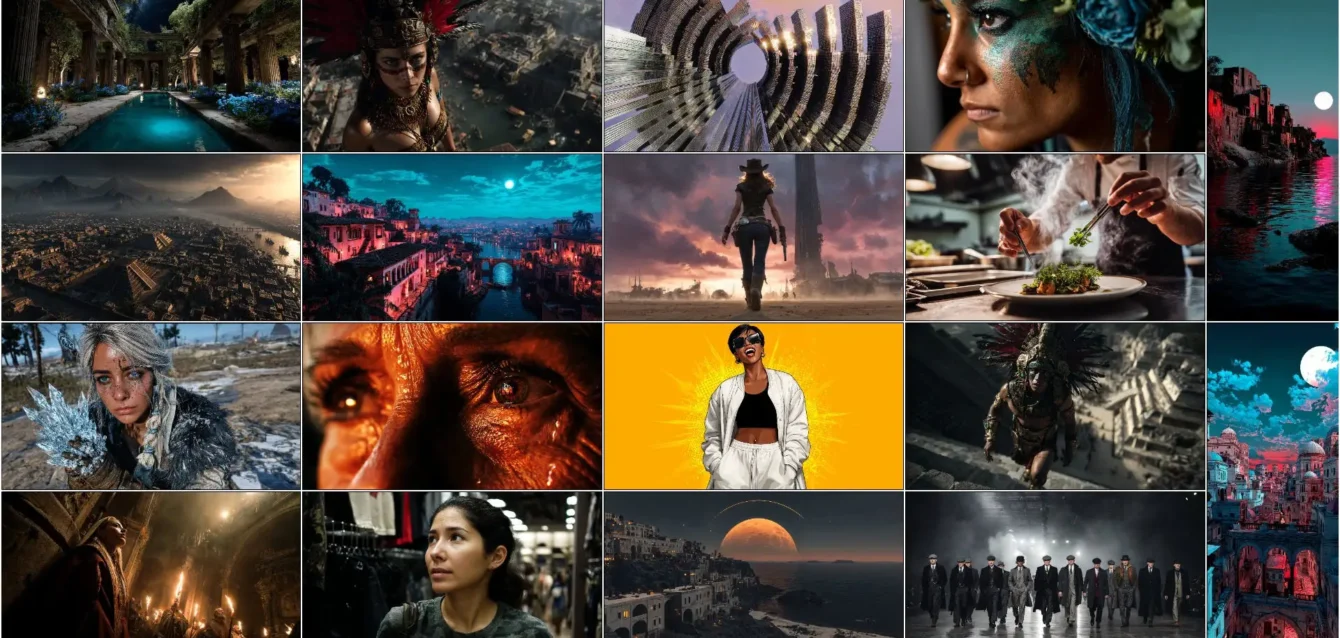

Cuando la inteligencia artificial empezó a generar imágenes, lo hacía como un autómata servicial pero torpe: líneas confusas, proporciones vacilantes, ojos asimétricos, manos con más dedos que lógica. Con el tiempo, estos defectos se volvieron parte del chiste —una marca de estilo, incluso—, hasta que comenzaron a desaparecer. Pero lo que estamos viendo ahora es un cambio de orden superior. Midjourney no solo mejoró la anatomía: empezó a entender matices, atmósferas, intenciones. Y con su séptima versión en etapa alfa, se asoma a un nuevo umbral de relación entre imaginación y código.

No es solo una actualización técnica. Es un rediseño de cómo se dialoga con una máquina visual. Porque lo que V7 pone en juego no es únicamente la calidad de la imagen final, sino el proceso mismo de creación: más rápido, más personal, más responsivo. Ya no se trata de dominar un lenguaje enigmático de prompts: ahora se trata de conversar con una entidad capaz de escuchar nuestra voz —literalmente— y aprender nuestro estilo con sorprendente plasticidad.

El salto anatómico es evidente. Por fin, las manos tienen forma humana. Los rostros han dejado de fundirse en simetrías abstractas. La composición se organiza con una lógica que recuerda no al arte digital, sino al ojo entrenado de un fotógrafo, a la mirada que sabe dónde cortar, dónde dejar respirar la escena. Y sin embargo, lo más fascinante no es lo que ya logra, sino cómo lo logra: escuchando, adaptando, iterando.

Una voz que dibuja

Una de las novedades más llamativas de esta versión experimental es la posibilidad de editar imágenes mediante comandos de voz. No es un truco de interfaz, sino un cambio profundo en la interacción. En lugar de tipear instrucciones precisas, el usuario puede hablarle a la IA, decirle que haga un cielo más nublado o que borre un objeto que distrae, y el sistema intentará ajustarse a ese pedido.

Esto no implica aún una comprensión semántica total —sabemos que no estamos ante una conciencia—, pero sí una notable capacidad de traducir instrucciones orales en cambios visuales coherentes. Es como tener un asistente gráfico que no necesita pausas, que recuerda tus últimas elecciones, y que entiende la diferencia entre “ligeramente más oscuro” y “totalmente en penumbra”. Es, en algún sentido, un retorno a la oralidad. Pero no como un retroceso, sino como una expansión de lo posible. Porque hay ideas que solo salen bien dichas, no escritas. Hay matices que se articulan mejor con la voz que con comandos estructurados. Midjourney lo intuye. Y empieza a responder.

Este nuevo modo de control tiene implicancias que van más allá de la comodidad. Abre la puerta a una accesibilidad inédita: personas con dificultades motrices, usuarios sin experiencia en prompts, artistas que piensan en imágenes pero se traban al escribir… todos ellos encuentran aquí una herramienta que escucha y responde. No a la perfección. Pero lo suficiente como para transformar el proceso creativo en algo más parecido a un taller y menos a una sala de control.

Estilo en tiempo real: borradores y perfiles

Otra función que redefine la experiencia es el Draft Mode. Este modo de bosquejo permite generar versiones rápidas de una imagen, con tiempos de respuesta mucho más cortos, pensadas no para el resultado final sino para explorar ideas. Como si uno pudiera hacer miniaturas visuales de su intención, pulirlas, y luego pasar al detalle fino.

La lógica detrás de este mecanismo es simple pero poderosa: en vez de generar una imagen definitiva en cada intento, el sistema ofrece opciones más crudas, más veloces, que sirven como base para iteraciones futuras. De este modo, se reduce la frustración de tener que rehacer todo desde cero cuando un detalle no convence. Se puede corregir en el camino, como haría cualquier artista frente a un boceto.

Pero eso no es todo. La verdadera revolución viene del sistema de personalización por perfiles. A partir de ahora, cada usuario puede crear uno —o varios— perfiles estilísticos, que funcionan como una especie de memoria visual del sistema. Se trata de entrenar al modelo para que entienda las preferencias estéticas del usuario: colores dominantes, composición, iluminación, estilo gráfico, tipo de enfoque, entre otros parámetros.

Para construir ese perfil, el sistema propone una serie de pares de imágenes. El usuario debe elegir cuál prefiere. En cinco minutos —literalmente— la IA comienza a detectar patrones, gustos, inclinaciones. No se trata de entrenamiento en el sentido técnico estricto, sino de una calibración personalizada del modelo. Y lo mejor es que ese perfil puede activarse o desactivarse en cualquier momento, combinarse con otros, o incluso duplicarse para explorar diferentes sensibilidades gráficas.

Lo que se inaugura con esta opción es una estética algorítmica individualizada. Ya no basta con pedirle una escena medieval al estilo de una pintura barroca. Ahora se le puede pedir que lo haga “a mi manera”, con mis filtros implícitos, con mis obsesiones cromáticas. Y eso, para cualquier persona que haya intentado definir su identidad visual en un mundo saturado de imágenes, es un regalo inmenso.

La voz como identidad y no como ruido

En este punto, la experiencia se vuelve más íntima. Ya no estamos frente a un generador de imágenes anónimo, sino ante una entidad que reconoce un patrón personal. Esa sensibilidad es lo que hace que Midjourney V7 empiece a parecer más una extensión de nuestra percepción que una simple herramienta.

¿Puede una IA tener estilo? No en el sentido humano. Pero puede adaptarse al nuestro, y eso es lo que convierte esta personalización en algo más que una comodidad. Es una forma de retroalimentación estética. Una manera de entrenar la mirada, no solo la máquina. Porque al ver cómo la IA responde a nuestras elecciones, aprendemos también cómo miramos, qué buscamos, qué repetimos.

Este bucle entre deseo visual y respuesta algorítmica no está exento de riesgos. Puede cristalizar clichés, reforzar manías, encerrarnos en zonas de confort estético. Pero también puede abrir caminos. Puede ayudarnos a ver lo que todavía no sabemos nombrar. Porque cuando un sistema es lo suficientemente flexible como para cambiar con nosotros, entonces se convierte en compañero de búsqueda, no solo en ejecutor.

Más allá del prompt: el nuevo umbral de lo visual

La promesa implícita en Midjourney V7 es ambiciosa: convertir la generación de imágenes en una conversación sensible, en una sinergia entre intención y síntesis. La clave está en cómo reduce la distancia entre pensamiento visual y resultado final. Ya no hay que traducir tanto. Ya no hay que luchar con frases ambiguas o comandos interminables. La voz, los perfiles, los borradores rápidos… todo confluye en una interfaz que empieza a parecerse más a una conversación fluida que a un acto de programación.

Esta transformación no es solo tecnológica. Es conceptual. Porque redefine lo que entendemos por creación digital. Hasta hace poco, era necesario asumir cierto dominio técnico, cierta familiaridad con los lenguajes ocultos del sistema. Hoy, esa barrera se difumina. No desaparece, pero se vuelve más porosa. Más dispuesta a dejar entrar formas distintas de pensar lo visual.

Y esto afecta también al campo profesional. Diseñadores, publicistas, ilustradores, editores… todos ellos encuentran aquí una herramienta que no compite con su creatividad, sino que la amplifica. No porque resuelva todo mágicamente, sino porque reduce el tiempo muerto, acelera los descartes, refina la dirección artística sin agotar al operador.

Pero tal vez su mayor virtud esté en otro lugar. En esa extraña sensación de que la imagen generada ya no es solo una traducción de lo que dijimos, sino un eco de lo que no sabíamos que queríamos. Un espejo parcial de nuestra intuición. Una forma nueva de pensar en colores, encuadres, texturas.