Hemos aprendido a hablar con las máquinas a través de un lenguaje fracturado, una suerte de dialecto digital lleno de pausas incómodas y turnos rígidamente definidos. Es una conversación de monólogos. Hablamos, nos detenemos, esperamos. La máquina procesa, piensa en silencio y finalmente responde. Si cambiamos de idea a mitad de una frase o intentamos interrumpir, el delicado hilo de la comunicación se rompe. Esta interacción, aunque funcional, siempre ha sido un pálido reflejo de la fluidez y la superposición dinámica del diálogo humano. Hasta ahora. En un movimiento que promete disolver esta barrera fundamental, Google ha desvelado una de las innovaciones más significativas en la historia de la inteligencia artificial conversacional: la API Live para su modelo Gemini. No se trata de una simple actualización o de una mejora en la velocidad de respuesta, sino de un rediseño radical de la propia naturaleza de la interacción entre humanos y máquinas. Es la transición del monólogo al diálogo, del intercambio de datos por turnos a una conversación verdaderamente viva y simultánea.

Este nuevo sistema, ahora disponible para desarrolladores de todo el mundo, se aleja del paradigma tradicional de «petición y respuesta» que ha definido la informática durante décadas. En lugar de enviar un paquete completo de información, esperar a que se procese y recibir una respuesta final, la API Live establece una conexión persistente y bidireccional. La mejor analogía para entender este salto conceptual es la diferencia entre enviar una carta y mantener una llamada telefónica. El modelo antiguo era epistolar: una comunicación asíncrona con un retraso inherente. El nuevo modelo es una línea abierta, un flujo constante de información en ambas direcciones que permite a la inteligencia artificial procesar el mundo tal y como ocurre, en tiempo real. Esta capacidad de transmisión continua, o streaming, es el corazón de la revolución. Permite que la IA no solo escuche nuestra voz mientras hablamos, sino que también vea a través de una cámara y lea texto simultáneamente, fusionando estas corrientes de información en una única comprensión coherente del contexto.

Para lograr esta hazaña, la API Live se sustenta sobre varios pilares conceptuales que redefinen lo que esperamos de un asistente digital. El primero es la multimodalidad en tiempo real. Gemini no solo es capaz de entender texto, audio e imágenes de forma aislada, sino que ahora puede procesar flujos de vídeo y audio en vivo al mismo tiempo. Esto transforma a la IA de un analista estático a un participante activo. Puede observar un evento mientras se desarrolla, escuchando el diálogo y viendo la acción, y razonar sobre la totalidad de la experiencia. El segundo pilar es la baja latencia, un término técnico para describir un retraso casi imperceptible. La respuesta de la IA no llega en un bloque, sino que comienza a generarse y a transmitirse de vuelta casi instantáneamente, creando la ilusión de una conversación natural y sin interrupciones.

Quizás el avance más profundo, sin embargo, es la introducción de un modelo de audio nativo diseñado para capturar la esencia del habla humana. Este sistema no solo transcribe palabras, sino que es capaz de entender el tono y la emoción, un concepto que Google denomina «diálogo afectivo». Puede diferenciar entre una pregunta genuina y un comentario sarcástico, o entre una declaración confiada y una vacilante. Además, esta nueva arquitectura permite a Gemini gestionar las complejidades del diálogo real: puede ser interrumpido, puede pausar su respuesta si detecta una conversación secundaria y puede reanudar el hilo sin perder el contexto. Es una IA que ha aprendido a escuchar no solo lo que decimos, sino cómo lo decimos, y a respetar el ritmo y el flujo desordenado de una conversación auténtica. Este artículo se adentrará en la arquitectura de esta tecnología transformadora, explorará las aplicaciones que cambiarán la industria y reflexionará sobre las profundas implicaciones de crear una inteligencia artificial que, por primera vez, no solo habla, sino que verdaderamente conversa.

El motor de la fluidez: decodificando la arquitectura en tiempo real

Para apreciar la magnitud de la innovación que representa la API Live, es necesario comprender la rigidez de los sistemas que la precedieron. La inteligencia artificial conversacional tradicional ha funcionado como un sistema de turnos. El usuario habla, el sistema convierte el audio en texto, envía ese texto al modelo de lenguaje, el modelo genera una respuesta en texto, un segundo sistema convierte ese texto en audio y finalmente lo reproduce. Cada paso de esta cascada introduce un retraso, creando esa latencia palpable que nos recuerda constantemente que estamos hablando con una máquina. La API Live de Gemini demuele esta estructura en favor de un enfoque integrado y continuo, posible gracias a una tecnología de comunicación conocida como WebSockets, que mantiene un canal de datos abierto entre el usuario y el modelo.

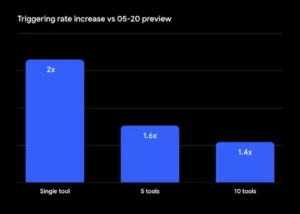

Dentro de esta nueva arquitectura, Google ofrece a los desarrolladores dos caminos, cada uno con sus propias fortalezas. El primero, más robusto y probado, utiliza una arquitectura de «media cascada». En este enfoque, el audio del usuario se transmite en tiempo real y es entendido de forma nativa por el modelo, pero la respuesta se genera como texto y luego se convierte en voz mediante un sistema de texto a voz (TTS). Esta opción es ideal para aplicaciones que requieren una alta fiabilidad, especialmente aquellas que necesitan interactuar con herramientas externas, como reservar una cita o consultar una base de datos. Ofrece una mejora sustancial en la fluidez de la entrada, aunque la salida todavía conserva un pequeño vestigio del proceso en dos pasos.

El segundo camino, disponible en versión preliminar, es el verdaderamente revolucionario: el modelo de audio nativo. Aquí, tanto la entrada como la salida son gestionadas por un único sistema neuronal diseñado desde cero para el habla. Gemini no solo entiende el audio entrante, sino que genera la respuesta directamente como una onda de audio, sin pasar por una fase intermedia de texto. Este enfoque holístico es lo que permite las capacidades más avanzadas y de apariencia humana. Al operar directamente en el dominio del sonido, el modelo puede capturar y replicar los matices de la prosodia humana: el ritmo, el tono, el énfasis y la emoción. La respuesta no suena como un texto leído por un robot, sino como una voz que parece comprender el contexto emocional de la conversación.

Esta arquitectura de audio nativo es la que desbloquea la capacidad de gestionar interrupciones de forma inteligente. En un sistema tradicional, cualquier sonido del usuario mientras la IA está hablando se pierde o causa un error. Con la API Live, el modelo está escuchando constantemente. Si un usuario dice «espera, en realidad quise decir…», el modelo puede detener su respuesta a mitad de camino, procesar la nueva información y adaptar su curso de acción. Esta habilidad, conocida como barge-in, es fundamental para que una conversación se sienta natural. Del mismo modo, el sistema incorpora una detección de actividad de voz avanzada, lo que le permite diferenciar entre una pausa reflexiva del usuario y el final de su turno, evitando así las interrupciones prematuras que plagan a los asistentes actuales. Es una arquitectura diseñada no solo para la eficiencia, sino para la cortesía conversacional.

El mundo a través de los ojos y oídos de Gemini: aplicaciones que cobran vida

La verdadera medida de una tecnología no reside en su elegancia arquitectónica, sino en las nuevas realidades que hace posibles. La capacidad de la API Live para procesar flujos multimodales en tiempo real no es una mejora incremental, es un catalizador para una clase completamente nueva de aplicaciones que transforman a la IA de una herramienta pasiva a un colaborador activo y consciente del contexto. Las posibilidades son tan vastas como nuestra imaginación, pero ya están emergiendo casos de uso que redefinirán industrias enteras.

Pensemos en el control de calidad en una línea de fabricación. Hoy en día, esta es una tarea que a menudo requiere inspección humana o sistemas de visión por computadora muy especializados y costosos. Con la API Live, un desarrollador podría apuntar una simple cámara a una cinta transportadora. Gemini podría «ver» los productos pasar, leer sus códigos de barras para identificarlos, detectar defectos visuales como arañazos o abolladuras, clasificar la gravedad del defecto y generar un informe estructurado, todo en una fracción de segundo. Si detecta un problema crítico, podría activar una alerta instantánea, enviando un correo electrónico o un mensaje a un supervisor con un resumen conciso del problema. Esta aplicación, que Google ya ha destacado, demuestra cómo la IA puede actuar como un vigilante incansable y preciso, integrando visión y razonamiento en un único flujo de trabajo.

En el ámbito de la accesibilidad, el potencial es aún más conmovedor. Una persona con discapacidad visual podría usar la cámara de su teléfono para explorar su entorno. La IA no solo describiría los objetos, como hacen las aplicaciones actuales, sino que podría narrar una escena en desarrollo. Podría advertir de un obstáculo en movimiento, leer un menú en un restaurante mientras describe el ambiente del lugar, o guiar al usuario a través de una estación de tren concurrida, interpretando señales visuales y anuncios de audio simultáneamente. La conversación sería fluida, permitiendo al usuario hacer preguntas de seguimiento o interrumpir con nuevas consultas sin romper la experiencia. Sería menos como usar una aplicación y más como tener un compañero vidente y atento.

El sector educativo también está al borde de una transformación. Un tutor de IA podría ir más allá de los problemas de texto. Un estudiante de física podría mostrarle un experimento casero a través de la cámara, y la IA podría analizarlo, hacer preguntas y guiar al estudiante para corregir errores en tiempo real. Un estudiante de arte podría recibir comentarios sobre su técnica de dibujo mientras trabaja, con la IA observando su trazo y ofreciendo sugerencias. La capacidad de recibir retroalimentación instantánea y contextual, en un formato conversacional y natural, podría democratizar el acceso a una tutoría personalizada de alta calidad, adaptándose al ritmo y al estilo de aprendizaje de cada individuo. Desde la telemedicina, donde un médico podría guiar a un paciente a través de un autoexamen, hasta la seguridad en el lugar de trabajo, donde la IA podría monitorear en tiempo real para prevenir accidentes, la API Live está preparada para sacar a la inteligencia artificial de las pantallas y situarla firmemente en el mundo físico y dinámico.

La conversación afectiva: más allá de las palabras

Quizás el aspecto más profundamente transformador de la nueva API Live de Gemini es su capacidad para comenzar a comprender y responder no solo al contenido literal de nuestras palabras, sino a la música que las acompaña: la emoción, la intención y el sentimiento. Esta incursión en el «diálogo afectivo», posible gracias al modelo de audio nativo, representa el primer paso hacia una inteligencia artificial con algo parecido a la inteligencia emocional. Es la habilidad de discernir la diferencia entre un «sí» entusiasta y un «sí» resignado, una distinción que cambia por completo el significado de una conversación y que hasta ahora había sido un dominio exclusivamente humano.

El diálogo afectivo permite que las interacciones sean más empáticas y efectivas. Imaginemos un agente de servicio al cliente impulsado por IA. Si un cliente llama con un tono de voz frustrado y ansioso, el modelo podría reconocer esa emoción y adaptar su respuesta, adoptando un tono más tranquilizador y priorizando la resolución del problema de manera más directa. Por el contrario, si un usuario está explorando opciones con un tono curioso y abierto, la IA podría ofrecer más detalles y sugerencias creativas. Esta capacidad de ajustar la respuesta a la estado emocional del usuario puede ser la diferencia entre una experiencia de cliente exasperante y una que se siente genuinamente útil y comprensiva.

Complementando esta habilidad está lo que Google llama «audio proactivo». Esta es la inteligencia contextual para saber cuándo hablar y, lo que es más importante, cuándo permanecer en silencio. Los modelos han sido entrenados para filtrar el ruido irrelevante. Si el usuario está en un entorno ruidoso o si hay una conversación secundaria en el fondo, la IA puede discernir que esos sonidos no están dirigidos a ella y abstenerse de responder. De manera similar, puede reconocer cuando un usuario se interrumpe a sí mismo para pensar o buscar una palabra, evitando la necesidad de llenar cada segundo de silencio. Esta es una habilidad social sutil pero crucial que hace que la conversación se sienta menos como una transacción y más como una colaboración.

Finalmente, la API introduce la capacidad de «pensar». En los sistemas actuales, si una pregunta requiere un procesamiento más profundo, el resultado suele ser un silencio prolongado y frustrante, seguido de una respuesta completa. Con los nuevos modelos, la IA puede indicar que necesita un momento para procesar una consulta compleja. Podría emitir un sonido sutil o una frase corta como «déjame pensar en eso un momento», antes de entregar la respuesta. Este simple gesto gestiona las expectativas del usuario y hace que la interacción sea mucho más natural, imitando el ritmo del pensamiento humano. El diálogo afectivo, el audio proactivo y la capacidad de pensar en voz alta no son meros adornos. Son características fundamentales que construyen la confianza y el entendimiento, sentando las las bases para interacciones más ricas y significativas entre humanos y máquinas.

El umbral de la interacción natural

La introducción de la API Live de Gemini no es simplemente el lanzamiento de un nuevo producto para desarrolladores, es la señal de un cambio fundamental en nuestra relación con la tecnología. Durante décadas, hemos sido nosotros quienes hemos tenido que adaptarnos a las limitaciones de las máquinas, aprendiendo a interactuar a través de clics, comandos de texto y conversaciones por turnos. Ahora, por primera vez, estamos presenciando el surgimiento de una tecnología que comienza a adaptarse a nosotros, aprendiendo el lenguaje no estructurado, superpuesto y emocionalmente rico del diálogo humano. Estamos cruzando el umbral de la interacción artificial para entrar en la era de la colaboración natural.

La relevancia de este avance es profunda y multifacética. Para los desarrolladores, abre un universo de posibilidades para crear aplicaciones que antes eran relegadas a la ciencia ficción. Para las industrias, promete optimizar procesos, mejorar la seguridad y crear experiencias de cliente radicalmente nuevas y empáticas. Para los usuarios, significa la posibilidad de interactuar con la tecnología de una manera más intuitiva, eficiente y, en última instancia, más humana. Sin embargo, como toda tecnología poderosa, también plantea preguntas cruciales que debemos abordar con previsión y responsabilidad. La creación de sistemas capaces de interpretar la emoción y participar en conversaciones fluidas exige un estándar aún más alto de seguridad, privacidad y diseño ético.

La capacidad de mantener una conversación ininterrumpida con una inteligencia artificial que ve y oye el mundo a nuestro lado es una herramienta de un poder inmenso. Puede ser un instrumento de empoderamiento sin precedentes, ofreciendo asistencia, educación y compañía de formas que apenas comenzamos a imaginar. El desafío, como siempre, no reside en la tecnología en sí, sino en nuestra sabiduría para guiarla. Con el lanzamiento de la API Live, Google no solo nos ha dado un motor de conversación más potente, sino que nos ha extendido una invitación a todos para empezar a diseñar, de manera consciente y reflexiva, el futuro de la colaboración entre humanos y máquinas.

Fuentes

Google AI for Developers. (2025). Get started with Live API | Gemini API. Disponible en: https://ai.google.dev/gemini-api/docs/live

Google Cloud Blog. (2025). Gemini Live API: Real-time AI for Manufacturing.

The Economic Times. (2025). Google launches native audio model in Gemini Live API.

Google. (2025). Gemini Live — get real-time voice assistance from Gemini.