La promesa de la inteligencia artificial generativa en el campo del video ha sido tan seductora como frustrante durante los últimos años. Hemos sido testigos de una explosión de creatividad visual, con modelos capaces de evocar paisajes oníricos, criaturas imposibles y escenas fotorrealistas a partir de una simple frase de texto. Sin embargo, esta magia digital siempre ha venido con una advertencia en letra pequeña referida a su brevedad. La inmensa mayoría de estas herramientas funcionan como generadores de clips, produciendo fragmentos de apenas unos segundos que, si bien son impresionantes, carecen de la continuidad narrativa necesaria para contar una historia completa. Al intentar extender estos videos más allá de un minuto, los personajes suelen perder su identidad, los fondos se distorsionan y la lógica de la escena se desmorona, como si la IA sufriera de una amnesia repentina o un agotamiento creativo.

Esta limitación no es un capricho del diseño, sino una barrera técnica fundamental arraigada en cómo estos modelos perciben el tiempo. La mayoría de los sistemas actuales utilizan una especie de "mapa temporal" fijo y finito, conocido técnicamente como incrustación posicional, que les dice en qué momento del video se encuentra cada fotograma. Cuando la generación supera el límite de este mapa, el cual suele establecerse en unos pocos segundos durante el entrenamiento, el modelo se pierde en un territorio desconocido y se vuelve incapaz de mantener la coherencia. A esto se suma la dificultad de dirigir la acción en tiempo real; intentar cambiar lo que hace un personaje a mitad de una generación suele resultar en transiciones torpes o en una falta de respuesta, ya que el sistema está demasiado anclado en lo que ya ha generado para aceptar nuevas direcciones.

Ante este panorama de estancamiento temporal, una nueva investigación titulada "Infinity-RoPE" emerge como una solución elegante y transformadora. Desarrollada por un equipo conjunto de Virginia Tech y la firma tecnológica Fal, esta propuesta no busca simplemente entrenar modelos más grandes con más datos, lo cual sería prohibitivamente costoso, sino que replantea la manera en que la inteligencia artificial procesa el paso del tiempo y la memoria. La premisa central de Infinity-RoPE es que no necesitamos un mapa temporal infinito para crear un video infinito; solo necesitamos un sistema de referencia relativo que se mueva junto con la acción, permitiendo que la historia fluya indefinidamente sin que el narrador digital pierda el hilo.

🎬 Escenario: El Director de Cine Artificial

La Escena Continua: Imagina generar una película donde un detective entra en una habitación oscura, busca pistas con una linterna, encuentra un documento secreto y luego escapa por la ventana. Con los modelos anteriores, esto requeriría generar cuatro videos separados y editarlos juntos, probablemente con inconsistencias en el rostro del detective o la ropa.

La Magia de Infinity-RoPE: Con este nuevo sistema, el usuario puede escribir las instrucciones secuencialmente indicando que el detective entra, luego que enciende la linterna y después que lee el papel. El modelo genera un flujo de video continuo e ininterrumpido. El personaje mantiene su identidad perfectamente durante minutos y la transición entre acciones es fluida y natural, respondiendo al instante a cada nuevo comando.

El Corte Cinematográfico: Si la narrativa exige un cambio brusco, como un salto temporal o un cambio de ubicación a un exterior, el sistema puede ejecutar un corte limpio, reiniciando el contexto visual pero manteniendo la coherencia temática, imitando el lenguaje del montaje cinematográfico real.

La relatividad del tiempo en la generación de video

El corazón de esta innovación reside en un concepto que los autores han denominado "RoPE Relativista por Bloques". Para entenderlo, imaginemos cómo los humanos recordamos nuestra propia vida. No necesitamos saber exactamente cuántos segundos han pasado desde nuestro nacimiento para saber quiénes somos o qué estamos haciendo ahora; operamos con una memoria relativa al presente y un archivo semántico de nuestro pasado. Infinity-RoPE aplica una lógica similar. En lugar de asignar una etiqueta temporal absoluta a cada fotograma, lo que limitaría el video a la cantidad de etiquetas disponibles, el sistema trata el tiempo como una ventana deslizante. Los nuevos fotogramas se generan en relación con los inmediatamente anteriores, mientras que los eventos pasados se van archivando en una memoria semántica que conserva el contexto general sin ocupar el espacio activo de la generación.

Este enfoque relativista tiene implicaciones profundas. Permite que un modelo entrenado originalmente para crear clips de solo cinco segundos pueda, de repente, generar secuencias de minutos o incluso horas sin degradarse. Al rotar las coordenadas temporales de los bloques de memoria antiguos hacia atrás, el sistema mantiene la geometría relativa del tiempo intacta. Los experimentos mostraron que, mientras otros modelos colapsan en ruido estático o repeticiones absurdas después de un minuto, Infinity-RoPE mantiene la nitidez, la consistencia del sujeto y la fluidez del movimiento indefinidamente. Es la diferencia entre memorizar un guion corto palabra por palabra y aprender a improvisar una historia sin fin basándose en el contexto inmediato y la memoria a largo plazo.

Más allá de la duración, el desafío de la interactividad fue abordado con una técnica ingeniosa llamada "Lavado de KV" o KV Flush. En los modelos tradicionales, la memoria acumulada actúa como un lastre; si el video muestra a una persona corriendo, el modelo tiende a seguir generándola corriendo por inercia, incluso si el usuario pide que se detenga. El mecanismo de Lavado de KV soluciona esto limpiando selectivamente la memoria a corto plazo del modelo justo cuando se introduce una nueva instrucción, manteniendo solo los anclajes esenciales para la identidad del sujeto. Esto permite cambios de acción instantáneos y precisos, como pasar de correr a saltar o de saltar a sentarse, sin los extraños periodos de transición o fantasmas de movimiento que plagaban a las generaciones anteriores.

El montaje invisible: cortes y transiciones

Cualquier cineasta sabe que una película no es solo una toma continua; el arte del cine reside en el montaje, en la capacidad de saltar de una escena a otra para avanzar la narrativa. Los modelos de video generativo hasta ahora han luchado con este concepto, tratando de fusionar extrañamente una escena con la siguiente en lugar de cortar limpiamente. Infinity-RoPE introduce una herramienta específica para esto llamada "Corte RoPE". Esta función permite al sistema introducir una discontinuidad controlada en la línea de tiempo matemática del modelo. Al hacerlo, le indica a la inteligencia artificial que, aunque la generación de video es continua como flujo de datos, el contexto visual ha cambiado drásticamente.

Esta capacidad habilita transiciones narrativas complejas dentro de una sola sesión de generación. Un usuario puede crear un video donde la cámara sigue a un personaje caminando por una calle de Nueva York y, con un simple comando, realizar un corte directo a ese mismo personaje entrando en una cafetería o incluso un flashback a su infancia. El sistema gestiona la discontinuidad temporal manteniendo la coherencia de la identidad del personaje, incluyendo su rostro, su estilo y su ropa, a través del corte. Esto representa un paso gigante hacia la generación de películas completas, donde la IA actúa no solo como cámara, sino también como editora en tiempo real, entendiendo la gramática visual del cine.

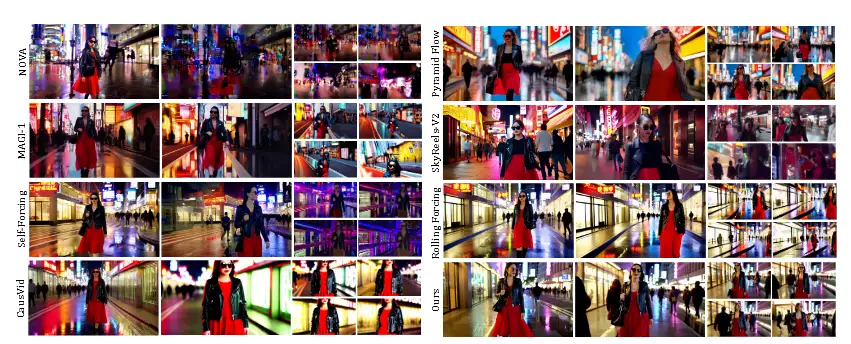

La validación de estas capacidades no se quedó en la teoría. El equipo sometió a Infinity-RoPE a pruebas exhaustivas utilizando VBench, un estándar de la industria para evaluar calidad de video, y realizó estudios con usuarios humanos. Los resultados fueron contundentes: en videos de larga duración de 60, 120 y 240 segundos, el nuevo sistema superó sistemáticamente a competidores establecidos en métricas de consistencia de fondo, suavidad de movimiento y calidad estética. Los usuarios humanos, al evaluar la capacidad de respuesta a las instrucciones y la estabilidad visual, prefirieron los videos de Infinity-RoPE por márgenes significativos, destacando su capacidad para mantener la historia encaminada sin las alucinaciones visuales que suelen arruinar las generaciones largas.

✅ Ventajas clave para creadores de contenido

Narrativa sin límites: La eliminación de la barrera de tiempo permite a los creadores pensar en escenas completas y desarrollos de personajes complejos, no solo en fragmentos breves.

Control de dirección preciso: La capacidad de cambiar la acción al instante otorga al usuario el rol de un verdadero director, capaz de corregir y guiar la actuación del modelo fotograma a fotograma.

Eficiencia de recursos: Al ser una solución que no requiere reentrenamiento masivo, permite aprovechar modelos de código abierto existentes, democratizando el acceso a herramientas de producción de video de alta gama.

Coherencia de identidad: El mantenimiento de la apariencia del sujeto a lo largo de cortes y cambios de escena resuelve uno de los dolores de cabeza más grandes en la continuidad visual generada por IA.

⚠️ Limitaciones actuales y futuro

Herencia del modelo base: Dado que Infinity-RoPE es una técnica que se aplica sobre modelos existentes, hereda sus defectos fundamentales. Si el modelo base no entiende bien la física de los fluidos o la anatomía de las manos, Infinity-RoPE no corregirá esos errores, simplemente los extenderá en el tiempo.

Artefactos de transición: En cortes de escena muy drásticos que caen fuera del horizonte de entrenamiento original, pueden aparecer ocasionalmente bordes visuales extraños o parpadeos menores, aunque el sistema está diseñado para minimizarlos.

Dependencia del texto: La calidad de la generación sigue dependiendo en gran medida de la precisión y claridad de las instrucciones textuales proporcionadas por el usuario.

Hacia una nueva era de medios sintéticos

La llegada de tecnologías como Infinity-RoPE marca un punto de inflexión en la evolución de los medios sintéticos. Estamos pasando de una etapa de novedad y experimentación lúdica a una fase de utilidad profesional y narrativa. La capacidad de generar video infinito y controlable no solo tiene implicaciones para el entretenimiento y el cine, sino también para la creación de entornos virtuales, simulaciones de entrenamiento y experiencias educativas personalizadas. Imaginemos videojuegos que generan sus cinemáticas en tiempo real adaptándose a las decisiones del jugador, o herramientas educativas que crean visualizaciones históricas continuas y detalladas a petición de un estudiante.

Este avance también plantea preguntas fascinantes sobre la naturaleza de la creatividad y la autoría. Cuando la herramienta permite una fluidez tan grande entre la imaginación y la visualización, la barrera técnica de entrada para la producción cinematográfica se derrumba. El rol del creador se desplaza desde la gestión logística de cámaras, actores y escenarios hacia la pura dirección creativa y narrativa. Infinity-RoPE, al eliminar las fricciones técnicas de la duración y la continuidad, acerca la generación de video a la velocidad del pensamiento, permitiendo que las ideas fluyan hacia la pantalla con una libertad sin precedentes.

En conclusión, Infinity-RoPE no es solo una mejora incremental en las métricas de un benchmark, sino una reimaginación de cómo las máquinas pueden soñar visualmente. Al enseñar a la IA a olvidar lo irrelevante y enfocarse en el presente relativo, paradójicamente le hemos otorgado la capacidad de crear un futuro visual sin fin. Mientras los modelos anteriores se quedaban sin aliento después de unos segundos, esta nueva arquitectura promete un horizonte donde la única limitación para la duración de una historia sea la imaginación del usuario que la está contando. El cine infinito ya no es una teoría de ciencia ficción; es un archivo ejecutable en nuestro presente.

Referencias

Yesiltepe, H., Meral, T. H. S., Akan, A. K., Oktay, K., & Yanardag, P. (2025). Infinity-RoPE: Action-Controllable Infinite Video Generation Emerges From Autoregressive Self-Rollout. arXiv preprint arXiv:2511.20649.

Team Wan. (2025). Wan: Open and advanced large-scale video generative models. arXiv preprint arXiv:2503.20314.

Huang, X., et al. (2025). Self-Forcing: Bridging the train-test gap in autoregressive video diffusion. arXiv preprint arXiv:2506.08009.

Liu, K., et al. (2025). Rolling Forcing: Autoregressive long video diffusion in real time. arXiv preprint arXiv:2509.25161.

Huang, Z., et al. (2024). VBench: Comprehensive benchmark suite for video generative models. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.