Cloudflare teje una «trampa de IA» para los bots de ‘scraping’ web

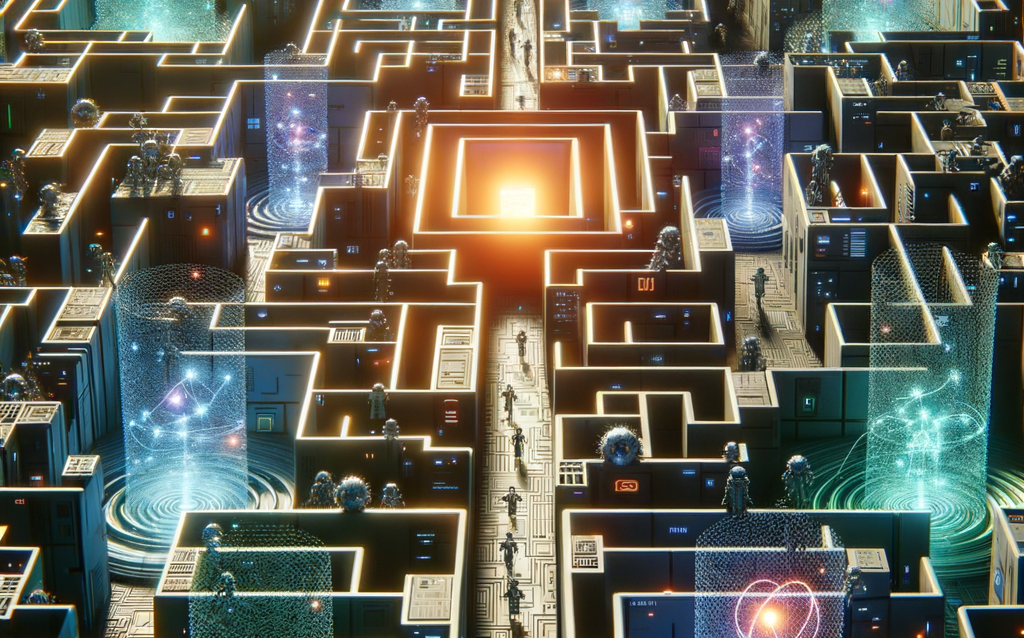

Cloudflare, la empresa conocida por su red de entrega de contenido (CDN) y seguridad web, está implementando una estrategia innovadora para combatir el ‘scraping’ web malicioso. En lugar de simplemente bloquear a los bots, Cloudflare los está atrayendo a un laberinto virtual impulsado por inteligencia artificial (IA), con el objetivo de desperdiciar sus recursos y, en última instancia, hacer que el ‘scraping’ sea menos rentable para los actores maliciosos.

¿Cómo funciona el «Laberinto de IA» de Cloudflare?

La idea central detrás de este enfoque es simple pero ingeniosa: presentar a los bots de ‘scraping’ una gran cantidad de datos falsos pero convincentes. Estos datos están diseñados para parecer legítimos a primera vista, engañando a los bots para que los recopilen y los utilicen en el entrenamiento de sus propios modelos de IA. Sin embargo, una vez que estos modelos se entrenan con los datos falsos, se vuelven menos precisos y menos útiles.

Este «laberinto de IA» se construye utilizando técnicas de generación de lenguaje natural (NLG) para crear texto falso que imita el contenido real de la web. Los bots de ‘scraping’, que a menudo están programados para buscar patrones específicos en el contenido web, son engañados por este texto falso y lo recopilan como si fuera información valiosa.

La clave del éxito de este enfoque radica en la capacidad de la IA de Cloudflare para adaptarse y evolucionar constantemente. A medida que los bots de ‘scraping’ se vuelven más sofisticados en sus técnicas de detección de datos falsos, la IA de Cloudflare aprende y se adapta para crear datos falsos aún más convincentes. Este ciclo continuo de adaptación hace que sea cada vez más difícil para los bots de ‘scraping’ distinguir entre datos reales y falsos.

Los beneficios de engañar a los bots en lugar de bloquearlos

Cloudflare argumenta que este enfoque de «engaño» tiene varias ventajas sobre el simple bloqueo de los bots de ‘scraping’. En primer lugar, el bloqueo de bots puede ser un juego del gato y el ratón, ya que los actores maliciosos siempre están buscando nuevas formas de eludir las medidas de seguridad. Al engañar a los bots, Cloudflare puede desperdiciar sus recursos y hacer que el ‘scraping’ sea menos rentable, lo que a la larga puede disuadir a los actores maliciosos.

En segundo lugar, el engaño puede proporcionar información valiosa sobre las tácticas y técnicas que utilizan los bots de ‘scraping’. Al analizar cómo los bots interactúan con el «laberinto de IA», Cloudflare puede obtener información sobre sus patrones de comportamiento y utilizar esta información para mejorar aún más sus defensas.

En tercer lugar, el engaño puede ser una forma más sutil y discreta de combatir el ‘scraping’ malicioso. El bloqueo de bots puede ser disruptivo y puede afectar a usuarios legítimos, mientras que el engaño es más silencioso y menos intrusivo.

¿Qué tipo de datos se utilizan para engañar a los bots?

Los datos utilizados en el «laberinto de IA» de Cloudflare varían dependiendo del tipo de sitio web que se está protegiendo. Sin embargo, en general, los datos están diseñados para parecerse al contenido real del sitio web, pero son completamente inútiles para el entrenamiento de modelos de IA.

Por ejemplo, para un sitio web de comercio electrónico, los datos falsos podrían incluir descripciones de productos generadas por IA que suenan convincentes pero no tienen sentido, o reseñas de clientes falsas que son genéricas y poco informativas. Para un sitio web de noticias, los datos falsos podrían incluir artículos generados por IA que imitan el estilo de escritura del sitio web pero contienen información falsa o sin sentido.

La clave es que los datos falsos deben ser lo suficientemente convincentes como para engañar a los bots de ‘scraping’, pero lo suficientemente inútiles como para que no puedan utilizarse para entrenar modelos de IA precisos.

El futuro de la lucha contra el ‘scraping’ web

El enfoque de Cloudflare de utilizar la IA para engañar a los bots de ‘scraping’ representa un cambio significativo en la forma en que se aborda la lucha contra el ‘scraping’ web. En lugar de simplemente tratar de bloquear a los bots, Cloudflare está adoptando una estrategia más proactiva y sofisticada que busca desperdiciar los recursos de los actores maliciosos y hacer que el ‘scraping’ sea menos rentable.

A medida que la tecnología de IA continúa avanzando, es probable que veamos más empresas adoptando enfoques similares para combatir el ‘scraping’ web y otras formas de actividad maliciosa en línea. La clave del éxito en esta lucha será la capacidad de mantenerse un paso por delante de los actores maliciosos y adaptar constantemente las defensas a medida que evolucionan sus tácticas.

El ‘scraping’ web se ha convertido en una preocupación creciente para las empresas de todos los tamaños. Los bots de ‘scraping’ pueden utilizarse para robar datos confidenciales, inflar el tráfico del sitio web, manipular los precios y realizar otras actividades maliciosas. A medida que el ‘scraping’ web se vuelve más sofisticado y generalizado, es esencial que las empresas tomen medidas para proteger sus sitios web y sus datos.

¿Qué pueden hacer las empresas para protegerse del ‘scraping’ web?

Además de utilizar servicios de seguridad web como Cloudflare, hay varias otras medidas que las empresas pueden tomar para protegerse del ‘scraping’ web:

- Implementar CAPTCHAs: Los CAPTCHAs son pruebas diseñadas para distinguir entre humanos y bots. Al requerir que los usuarios completen un CAPTCHA antes de acceder a ciertas partes de un sitio web, las empresas pueden dificultar que los bots realicen ‘scraping’.

- Monitorear el tráfico del sitio web: Al monitorear el tráfico del sitio web en busca de patrones inusuales, las empresas pueden identificar y bloquear a los bots de ‘scraping’.

- Utilizar archivos robots.txt: Los archivos robots.txt son archivos que indican a los bots qué partes de un sitio web no deben rastrear. Si bien los bots maliciosos pueden ignorar los archivos robots.txt, pueden ser útiles para evitar que los bots legítimos realicen ‘scraping’ en partes no deseadas de un sitio web.

- Implementar límites de velocidad: Los límites de velocidad restringen la cantidad de solicitudes que un usuario puede realizar a un sitio web en un período de tiempo determinado. Al implementar límites de velocidad, las empresas pueden dificultar que los bots realicen ‘scraping’ en grandes cantidades de datos.

- Utilizar autenticación de dos factores: La autenticación de dos factores requiere que los usuarios proporcionen dos formas de identificación antes de acceder a una cuenta. Al implementar la autenticación de dos factores, las empresas pueden dificultar que los bots accedan a cuentas de usuario y realicen ‘scraping’ en datos confidenciales.

Cloudflare y la evolución de la seguridad web

La estrategia de Cloudflare con su «laberinto de IA» representa un paso adelante en la evolución de la seguridad web. Tradicionalmente, las defensas contra bots se centraban en la identificación y el bloqueo. Sin embargo, este enfoque se ha vuelto menos efectivo a medida que los bots se vuelven más sofisticados y difíciles de detectar.

El enfoque de Cloudflare, en cambio, se centra en la disuasión económica. Al hacer que el ‘scraping’ sea más costoso y menos rentable, Cloudflare espera reducir la cantidad de ‘scraping’ malicioso en general. Este enfoque se basa en la idea de que los actores maliciosos solo se involucrarán en el ‘scraping’ si creen que los beneficios superan los costos.

Además, la estrategia de Cloudflare es adaptable y evolutiva. A medida que los bots de ‘scraping’ aprenden a evitar el «laberinto de IA», Cloudflare puede actualizar y mejorar sus defensas. Este ciclo continuo de adaptación hace que sea cada vez más difícil para los bots de ‘scraping’ obtener una ventaja.

El impacto en el ecosistema de la IA

Es importante destacar que la estrategia de Cloudflare no solo beneficia a los propietarios de sitios web, sino que también puede tener un impacto positivo en el ecosistema de la IA en general. Al dificultar que los actores maliciosos recopilen datos para entrenar modelos de IA, Cloudflare puede ayudar a garantizar que los modelos de IA se entrenen con datos de alta calidad y que sean menos propensos a sesgos y errores.

En un mundo donde la IA juega un papel cada vez más importante en todos los aspectos de la vida, es esencial que los datos utilizados para entrenar modelos de IA sean precisos y confiables. La estrategia de Cloudflare es un paso importante para garantizar que esto sea así.

En resumen, el «laberinto de IA» de Cloudflare es una innovadora y prometedora estrategia para combatir el ‘scraping’ web malicioso. Al engañar a los bots en lugar de simplemente bloquearlos, Cloudflare puede desperdiciar sus recursos, obtener información valiosa y hacer que el ‘scraping’ sea menos rentable. A medida que la tecnología de IA continúa avanzando, es probable que veamos más empresas adoptando enfoques similares para proteger sus sitios web y sus datos.

Las empresas que buscan protegerse del ‘scraping’ web deben considerar la implementación de una combinación de medidas de seguridad, incluyendo el uso de servicios de seguridad web como Cloudflare, la implementación de CAPTCHAs, el monitoreo del tráfico del sitio web, el uso de archivos robots.txt, la implementación de límites de velocidad y el uso de autenticación de dos factores.