Por Elena Vargas, Periodista de Ciencia y Tecnología, para Mundo IA

Nano-banana, leyes y delivery: la semana en que la IA dejó de improvisar

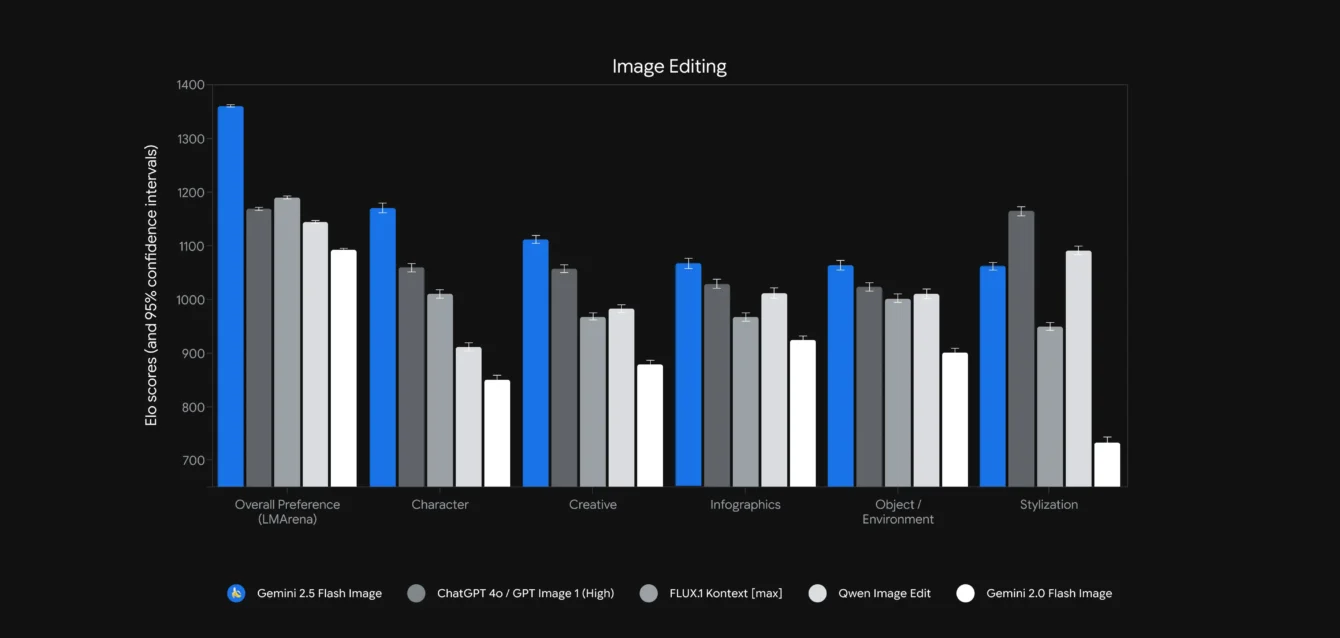

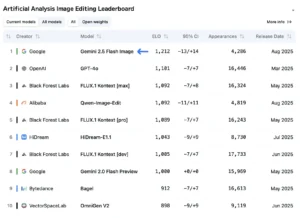

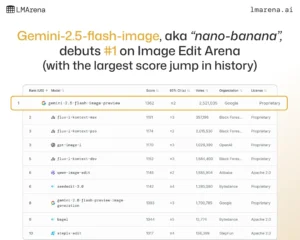

Gemini 2.5 Flash Image, apodado “nano-banana” puertas adentro, es, en pocas palabras, un editor de imágenes que entiende instrucciones en lenguaje natural y las ejecuta con precisión de cirujano. No es “hazme algo lindo”, sino “quitá a la persona del fondo”, “dos tonos más oscuro”, “reemplazá esta lámpara por esta otra” o “centrá el sofá bajo la ventana”, y que el resto de la foto quede intacto. A eso le suma dos habilidades que hasta ahora costaba combinar: mantener la identidad de una persona o un producto a lo largo de varias tomas, y escribir texto dentro de la imagen sin deformarlo. Por eso marca un punto alto: reduce los típicos tropiezos que obligaban a iterar una y otra vez o a volver a Photoshop para arreglos finos.

¿Por qué se considera “estado del arte”? Porque resuelve de manera conjunta tres dolores crónicos del sector. Primero, la edición localizada de verdad: cambia lo que pedís sin “derrames” inesperados en otras zonas del cuadro. Segundo, la consistencia de identidad: el mismo rostro, el mismo logo, la misma textura de producto, conservados a través de múltiples prompts y escenas. Tercero, la composición coherente a partir de varias fuentes: podés fusionar hasta tres imágenes (por ejemplo, colocar una lámpara concreta en una habitación) y el resultado no se ve como un collage improvisado. A esas tres, el modelo les agrega obediencia a plantillas (tarjetas de empresa, fichas inmobiliarias, diseños editoriales): respeta el layout, no inventa. Y si pedís un cartel con texto, el render mejora lo suficiente como para que la pieza sea publicable sin veinte reintentos.

Otra diferencia clave es que no “adivina” a ciegas: usa conocimiento del mundo. Entiende qué es una ventana, un sofá, una lámpara; cómo suelen convivir en una escena; qué proporciones y sombras son plausibles. Ese anclaje semántico permite dar órdenes compuestas (“oscurecé dos tonos y centrál el sofá bajo la ventana”) sin tener que describir coordenadas o pasos técnicos. Además, el editor es conversacional y soporta múltiples turnos: pedís un cambio, ves el resultado, afinás con un “subí un poco el contraste del fondo” o “probá el mismo encuadre con azul petróleo”, y el modelo responde sin perder el hilo de la sesión.

También hay un paso adelante en supervisión, algo cada vez más importante cuando el contenido generado circula por plataformas y campañas. Las salidas vienen con SynthID, una marca de agua invisible, y metadatos que señalan que la imagen fue generada o editada por IA. No es un candado infalible, si tu pipeline borra metadatos al exportar, perdés la pista, pero es un estándar mínimo que facilita moderación, auditoría y cumplimiento interno. En la misma línea, se bloquean casos obvios de abuso (como imágenes íntimas no consentidas) y se anima a operar dentro de guías claras de uso responsable.

En términos de acceso y coste, la propuesta es directa: está disponible en la app de Gemini, en la API, en AI Studio y en Vertex AI, lo que simplifica pasar del experimento a un flujo de trabajo real. El precio es transparente y, sobre todo, comparable con el resto del stack de IA porque se mide en tokens de salida: cada imagen consume un “presupuesto” fijo de tokens, que se traduce en centavos por pieza. Para equipos que viven de iterar versiones (marketing, e-commerce, editorial) esa previsibilidad vale oro: podés estimar cuánto cuesta llegar a la versión aprobada, con o sin “best-of-N”.

¿Qué la hace sobresaliente frente a alternativas? Más que un único golpe de efecto, es la suma de pequeños aciertos: edita donde corresponde sin romper lo demás; mantiene caras, logos y texturas a través de tomas; compone varias fuentes en una sola imagen sin costuras visibles; respeta plantillas; escribe texto legible; entiende bocetos y wireframes; conversa y recuerda el contexto de la sesión. Todo eso encaja en flujos de producción reales: actualizar un catálogo sin rehacer la sesión de fotos, adaptar piezas para mercados distintos con la misma identidad visual, probar composiciones de interiores antes de amoblar un set, o iterar banners sin pelearse con el kerning.

¿Tiene límites? Sí, y conviene decirlo sin rodeos: los rótulos muy largos o las tipografías “difíciles” pueden requerir retoque manual, y los detalles factuales ultra finos aún necesitan ojo humano. Pero la “sensación de uso” cambia: pasás menos tiempo peleándote con la herramienta y más tiempo decidiendo qué versión es la que mejor comunica. Por eso, más que una demo vistosa, se siente como un escalón en la dirección correcta: menos fricción entre una instrucción clara y una imagen publicable, con reglas de procedencia encendidas por defecto y un costo por iteración que se entiende a primera vista.

El modelo que deja de pelearse con el detalle

Gemini 2.5 Flash Image es, ante todo, un editor que no se asusta del zoom. Pide cambios con lenguaje natural y los aplica donde corresponde. Si la instrucción es “quitar a la persona del fondo”, desaparece esa persona sin desarmar luces y sombras del resto. Si la instrucción es “recolorear solo la mochila a bordo”, el resto de la imagen no se contamina. Si necesitás mantener a un personaje o a un producto como protagonista de varias tomas, el sistema cuida rasgos, colores, texturas, tipografías de marca y proporciones. Ese punto —consistencia de identidad— es el que históricamente hacía resoplar a los equipos: un set de fotos de zapatillas y, entre prompt y prompt, la puntera cambiaba de forma o el tramado del cuero se lavaba. La novedad de esta vista previa es que las identidades aguantan mejor las iteraciones.

La segunda pata es composición. Fusionar hasta tres entradas en una escena y que se vea “sin costuras” sirve para staging de interiores, variantes de producto y pruebas de layout. La tercera es obediencia a plantillas: tarjetas inmobiliarias, badges de empresa, diseños editoriales. Si la maqueta dice “logo aquí, nombre a 24 puntos, foto a la derecha”, el sistema intenta no inventar, y eso baja tiempo de producción en lote. Y sí, el texto dentro de la imagen mejora. No perfecto cuando el rótulo es largo o con tipografías complejas, pero lo suficiente para dejar de reintentar veinte veces un cartel simple.

El precio que entiende operaciones

Hay otro gesto que parece menor y no lo es: el precio es claro y medible con la misma vara que ya usamos para texto y audio. Treinta dólares por millón de tokens de salida. Cada imagen “pesa” alrededor de 1.290 tokens. La cuenta es directa: 0,039 dólares por imagen 1024×1024. Si tu pipeline genera cuatro variantes y se queda con la mejor, multiplicás por cuatro. Si haces “best-of-N” en cada paso, el costo crece, pero ahora lo podés presupuestar como parte de tu tablero de tokens, no como “minutos de GPU” nebulosos. Para un equipo de marketing, eso es aire en el Excel.

No es magia, es semántica aplicada

El truco no está en inventar la edición por texto. Eso existe desde instruct-pix2pix y los controladores tipo ControlNet. El salto está en juntar tres dolores que rara vez se resolvían a la vez: precisión local, consistencia de identidad y obediencia a plantillas. En el medio aparece algo que Google enfatiza y es más importante de lo que suena: conocimiento del mundo. El modelo entiende qué es un sofá, qué es una ventana, dónde suelen estar, cómo cae una sombra plausible. Esa semántica reduce el “prompt-juggling” y permite instrucciones compuestas. Decile “dos tonos más oscuro, centrar el sofá bajo la ventana” y el sistema no necesita que le des coordenadas. ¿Puede fallar? Sí. ¿Falla menos que antes? Esa es la apuesta, y la sensación en demos es que la tasa de “casi” se achicó.

La marca de agua como política explícita

Todas las salidas de este modelo llevan SynthID, una marca de agua invisible, más metadatos para que plataformas y revisores automáticos puedan detectar si una imagen fue generada o editada por IA. No es la panacea. Si tu canal de publicación borra metadatos, la trazabilidad se pierde. Si un tercero reencuadra y vuelve a guardar, esa huella puede debilitarse. Pero es un avance operativo: las organizaciones que publican en redes, marketplaces o sitios propios pueden exigir que “todo lo generado o editado con IA salga con watermark”. Es una barrera suave que, combinada con políticas internas, baja el riesgo de que un contenido sensible cruce la línea.

La noticia legal que ordena la cocina de datos

Mientras unos celebraban nuevas herramientas, otros leyeron un PDF con más impacto del que parece. Anthropic alcanzó un acuerdo con los autores que la demandaban por descargar millones de libros de bibliotecas en la sombra. La película judicial de los últimos meses dejó una foto nítida. Entrenar modelos con copias legales puede ser considerado uso justo. Construir y retener bibliotecas centrales con material pirateado es otra cosa. La clase de autores había sido certificada y los potenciales daños, en un escenario extremo, eran impagables. El acuerdo evita un juicio inminente, pero no borra el mensaje de fondo: la responsabilidad vive en la tubería de datos.

En términos operativos: tratá el corpus de entrenamiento como inventario con comprobantes. De cada archivo debés saber su origen, la licencia y la fecha de ingreso. Exigí a los proveedores una garantía escrita de que sus datasets no incluyen material de bibliotecas no autorizadas. Tu pipeline tiene que detectar huellas de ese contenido, poner en cuarentena lo sospechoso y eliminarlo con registro. Esto aplica a libros, letras, guiones y cualquier obra con derechos. Si tu negocio depende de modelos grandes, el cumplimiento no se posterga: es un costo fijo de operar.

Vibes, diversión y la realidad de producción

La otra conversación de la semana sonó en cabinas de producto y en foros de desarrolladores. Alguien contó cómo su equipo “vibe-codifica” con IA y llegó la pregunta inevitable: ¿es creatividad asistida o ingeniería seria? La respuesta más honesta es aburrida, pero útil. Vibes funciona genial para aprender, bocetar y armar prototipos. Te ayuda a explorar espacio de soluciones. No te firma un SLA. Cuando el código entra a la línea de producción, el patrón más sano se parece a esto: diseño técnico breve, revisión por alguien senior, notas de subsistemas, sprint con tests al frente, agente que propone pull requests, crítico automático que destapa problemas y dos revisores humanos que autorizan. El asistente acelera lo repetible. La arquitectura, los trade-offs y el merge final siguen siendo humanos.

No es un baño de agua fría contra la IA. Es una poda de expectativas. Incluso hubo un ensayo publicado este año que mostró un dato contraintuitivo: algunos desarrolladores open source, trabajando en sus propios repositorios, tardaron más con herramientas de IA “early-2025” que sin ellas. No porque la IA “sea mala”, sino porque encajarla sin método puede sumar fricción, malentendidos y reescrituras. ¿Dónde gana tiempo de verdad? En pruebas, andamios, diagnósticos estáticos, revisiones de estilo y seguridad. ¿Dónde todavía tropieza? Cuando pretende reemplazar criterio, contexto y diseño.

Qué cambia mañana si tenés que entregar

Para marketing y retail, la combinación de consistencia de identidad, plantillas y fusión multi-imagen baja la cantidad de re-shootings. Catálogos más parejos en menos iteraciones. Para medios y branding, un texto embebido que se comporta mejor reduce la lija del “otra vez”. Para producto, un editor conversacional que entiende bocetos y wireframes acelera exploraciones sin despertar a medio equipo de diseño. Para legales y datos, el acuerdo de Anthropic empuja una checklist que ya no se puede postergar: contratos de datasets con auditoría, filtros para bibliotecas no autorizadas, protocolo de cuarentena y borrado, bitácoras de ingestión.

En ingeniería, el patrón “agente propone, humanos aprueban” se impone por simple supervivencia. Un agente que abre PRs y un “critic” que revisa sus propios cambios antes del primer humano es la versión moderna del “dos pares de ojos”. No hace magia. Previene regresiones. Te avisa cuando la dependencia que tocaste en una capa le pegó a otra. Combinado con pruebas y staging, es la diferencia entre “va” y “rompimos checkout un viernes”.

Costos y decisiones que conviene destacar

Es tentador mirar 0,039 dólares por imagen y cerrar el Excel. No lo hagas. Sumá las variantes por paso y el “best-of-N” si lo usás. Medí cuánto tardás en llegar a “aprobado” por arte. Estimá cuántas veces te vas a apoyar en plantillas listas versus flujos manuales. Preguntate si el equipo prefiere un modo “todo en uno” o un lienzo con controles explícitos. Y, por favor, verificá que tus canales respetan metadatos para que la marca de agua llegue entera a donde importa. El modelo puede traer trazabilidad. Tu pipeline la puede romper sin querer.

Dónde todavía falta

Google reconoce puntos flojos en esta vista previa. Rótulos largos y tipografías raras no siempre quedan bien. Detalles factuales muy finos pueden patinar. Las versiones locales y el tratamiento de idiomas fuera del inglés todavía requieren pruebas. En infraestructura, queda por ver cómo respira a carga sostenida en Vertex y cómo se porta con proyectos grandes que exigen consistencia a lo largo de semanas. En lo legal, un acuerdo evita un veredicto con fuerza de precedente. La línea general es clara, pero el diablo de compliance vive en los detalles: logs, contratos, borrados, snapshots.

Hacia dónde va y bajo qué condiciones

De aquí a noviembre de 2025 la película es bastante concreta: equipos de contenido y retail van a pilotear Gemini 2.5 Flash Image, comparando plantillas automáticas contra flujos manuales y cerrando una política simple pero efectiva—toda imagen generada o editada por IA sale con marca de agua. Esto camina si la calidad de la vista previa se sostiene y los socios tecnológicos cumplen sus acuerdos de servicio.

Hasta mayo de 2026 el foco se mueve de la demo al sistema: integración con los DAM y CMS que ya existen, y un modo de edición con “perillas” por encima de la conversación para quienes necesitan control fino. En paralelo, los responsables de negocio empiezan a mirar números de conversión atribuibles a consistencia visual. Para que eso suceda, primero hay que limar los tropiezos con texto largo incrustado y documentar bien los límites por idioma y tipografía.

Hacia febrero de 2027 debería asomar la capa de procedencia estandarizada: SynthID conviviendo con firmas C2PA y registros de cada edición, datasets tratados como inventario con recibos por lote, y agentes de código que traen de fábrica un “critic” y reglas de merge sensatas en las plataformas más usadas. Ese cierre solo llega si la presión regulatoria y los acuerdos privados empujan la convergencia técnica y de políticas.

La ética como un tablero de mandos, no como un póster

Transparencia. Watermark y metadatos no equivalen a verdad absoluta, pero son un piso común. En campañas sensibles, debería ser obligatorio mantenerlos y auditar su presencia en destino. Privacidad. Si vas a editar fotos de personas, pedí consentimientos claros, guardá evidencia y evitá casos frontera como cambios no obvios de contextos íntimos. Propiedad intelectual. La lección de la semana es brutalmente práctica: entrenar puede ser legal si el origen lo es. La adquisición y el almacenamiento son la trampa. Seguridad de producto. Un pipeline con dos aprobadores y un crítico automático no es capricho. Es el equivalente moderno del “no empujes directo a producción”.

Qué queda sobre la mesa

La foto de esta semana despeja una confusión vieja. No se trata de “más IA” a secas. Se trata de IA mejor puesta. Un editor que entiende la escena y obedece plantillas reduce la fricción entre idea y entrega. Un fallo y un acuerdo que ordenan la cadena de datos evitan incendios legales de fin de año. Un proceso de ingeniería que prioriza diseño, pruebas y revisión humana convierte inspiración en confiabilidad. Si tu catálogo sale mejor y más rápido, si tu abogado duerme tranquilo y si tu despliegue no tiembla un viernes a las 18, entonces no eran vibes: era trabajo bien hecho con herramientas nuevas.

Glosario mínimo:

SynthID. Marca de agua invisible y metadatos que señalan que una imagen fue generada o editada por IA.

Edición por instrucciones. Cambios locales en una imagen definidos por lenguaje natural.

Consistencia de identidad. Mantener el mismo aspecto de una persona o producto a lo largo de múltiples imágenes.

Fusión multi-imagen. Componer hasta tres entradas en una sola salida coherente.

Plantillas. Diseños predefinidos que el modelo respeta para tarjetas, badges, layouts editoriales.

Vibe-coding. Programar con prompts de alto nivel y poca microgestión. Útil para prototipos. Riesgoso en producción sin QA y revisión.

Métricas y hechos clave

Precio por imagen 1024×1024. Aproximadamente 0,039 dólares, calculado como 1.290 tokens por imagen a 30 dólares por millón de tokens de salida.

Disponibilidad. Gemini app, API, Google AI Studio y Vertex AI. Integraciones en terceros.

Control. Ediciones locales por texto, fusión de hasta tres imágenes, adherencia a plantillas, consistencia de identidad y mejoras en texto embebido.

Governance. Watermark SynthID y metadatos. Bloqueos para usos obvios de abuso, como íntimas no consensuadas.

Legal. Entrenamiento con copias legales considerado uso justo por un juez federal; responsabilidad potencial por descargas masivas y cachés de material pirateado; acuerdo extrajudicial que evita juicio de fin de año.

Productividad. Evidencia reciente sugiere que, sin proceso, herramientas de IA pueden no acelerar a perfiles senior. Con proceso, el patrón de PRs con crítico automático y dos aprobadores es el que más repite mejora neta.

Fuentes

– Google Developers Blog: anuncio y detalles de Gemini 2.5 Flash Image. https://developers.googleblog.com