En los pasillos silenciosos de las universidades y en la quietud de los laboratorios, donde el conocimiento se destila gota a gota, se libra una batalla invisible pero feroz. No es una contienda por los descubrimientos en sí mismos, sino por algo mucho más efímero y, en la era digital, igualmente crucial: la atención. El científico del siglo veintiuno ya no es solo un explorador de lo desconocido; se ha convertido, por necesidad, en un estratega de la comunicación, un publicista de sus propios hallazgos.

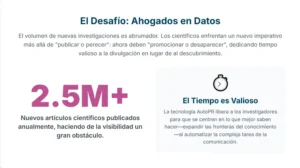

La antigua máxima de “publica o perece” ha mutado en un mandato más complejo y demandante, uno que podría resumirse como “promociona o desvanécete”. Cada día, una cantidad abrumadora de investigaciones ve la luz, formando un océano de información tan vasto que las contribuciones más brillantes corren el riesgo de hundirse sin dejar rastro, ahogadas en un estruendo de datos.

Es una suerte de nueva Biblioteca de Alejandría digital, una que no corre peligro de incendiarse, sino de volverse tan inmensa que resulte imposible de navegar. En este contexto de sobrecarga informativa, un equipo de investigadores ha encendido una luz que promete no solo guiar a los navegantes, sino automatizar la construcción de los faros.

Imaginemos por un momento una inteligencia artificial capaz de realizar una tarea que hasta ahora parecía exclusiva de la intuición y la pericia humanas. Un sistema que no solo lee un denso y enrevesado artículo científico, con sus gráficos inescrutables, tablas de datos y jerga especializada, sino que lo comprende en su totalidad. Y que, a partir de esa comprensión profunda, es capaz de generar un tuit ingenioso, un hilo revelador, una publicación profesional para una red social o una entrada de blog elocuente y atractiva.

Un agente sintético que sabe cómo traducir la complejidad en claridad, la aridez de los datos en una narrativa fascinante, y todo ello adaptado al lenguaje y las normas de cada plataforma digital. Esta es la promesa de un campo emergente que un reciente estudio ha bautizado como Promoción Automática, o AutoPR por su acrónimo en inglés. Se trata de una propuesta audaz que busca delegar en algoritmos una de las tareas más consumidoras de tiempo y, a menudo, más frustrantes para la comunidad académica: la divulgación de su propio trabajo.

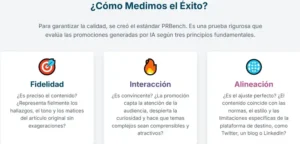

Para que esta automatización no sea un simple ejercicio de estilo, sino una herramienta rigurosa y fiable, sus creadores han desarrollado dos piezas fundamentales. La primera es un campo de entrenamiento y, a la vez, un severo tribunal de examen para estas inteligencias artificiales. Lo han llamado PRBench, y su función es establecer un estándar de calidad, una vara de medir con la que evaluar si un publicista sintético está realmente a la altura.

Este banco de pruebas no juzga a los sistemas con criterios vagos, sino que los somete a un escrutinio basado en tres pilares esenciales. El primero es la fidelidad, que responde a la pregunta de si el contenido generado es fiel al original, si respeta la verdad científica y el tono del estudio. El segundo es el engagement o capacidad de atracción, que mide si el mensaje es interesante, si logra capturar la atención del público y si resulta genuinamente atractivo. El tercer pilar es la alineación, un concepto sutil que evalúa si la promoción es adecuada para el canal, el momento y la audiencia a la que se dirige.

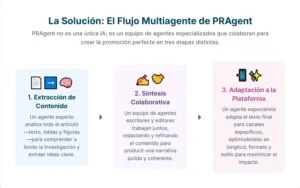

La segunda pieza clave es el primer atleta de élite diseñado para competir en esta nueva disciplina. Su nombre es PRAgent, y no es una inteligencia artificial monolítica, sino un sistema compuesto por múltiples agentes, una especie de equipo de redacción digital. Esta arquitectura colaborativa imita la forma en que los humanos trabajan en equipo.

En este modelo, un primer grupo de agentes actúa como un documentalista experto, sumergiéndose en el artículo científico para extraer sus ideas clave, sus datos más relevantes y la esencia de sus gráficos y figuras. Un segundo equipo de agentes, que harían las veces de redactores y editores, toma ese material en bruto y lo transforma en un borrador pulido y coherente. Finalmente, un tercer agente, el especialista en redes, adapta ese texto final a las particularidades de cada plataforma, asegurándose de que el mensaje no solo llegue, sino que resuene. Este enfoque representa un salto cualitativo respecto a los modelos de lenguaje generales, pues especializa cada fase del proceso para lograr un resultado óptimo.

La aparición de este tipo de tecnología es mucho más que el desarrollo de una nueva herramienta de software; es el presagio de una transformación profunda en la manera en que el conocimiento científico se produce, se comunica y se descubre, planteando interrogantes fascinantes sobre el futuro de la ciencia y el papel del científico en un mundo cada vez más automatizado.

El diluvio del conocimiento y el eco del silencio

La ciencia moderna se encuentra en una paradoja. Nunca antes en la historia de la humanidad se había generado tanto conocimiento a una velocidad tan vertiginosa. Cada año, millones de artículos científicos son publicados, cada uno representando un fragmento del inmenso puzle del saber humano. Sin embargo, esta explosión de productividad ha traído consigo una consecuencia inesperada y problemática: el silencio. No un silencio de inactividad, sino el eco sordo que se produce cuando un grito se pierde en una multitud ensordecedora.

La probabilidad de que un trabajo de investigación, por muy brillante que sea, pase completamente desapercibido ha aumentado de forma dramática. Los académicos ya no solo compiten por la financiación o por ser los primeros en lograr un descubrimiento; compiten por un recurso mucho más escaso y distribuido de forma desigual, que es la visibilidad.

Esta situación ha creado un sistema en el que la calidad de una investigación no es el único factor que determina su impacto. La habilidad del autor para navegar el complejo ecosistema de la comunicación digital se ha vuelto una variable crítica. Un investigador con talento para la autopromoción, que domina el arte de crear un titular llamativo o de resumir su trabajo en un formato visualmente atractivo, puede lograr que su estudio tenga una repercusión mucho mayor que el de un colega quizás más introvertido o menos diestro en estas lides, aun cuando el trabajo de este último sea de una calidad intrínseca superior.

Esto introduce un sesgo preocupante en el progreso científico, donde las ideas no necesariamente prosperan por su mérito, sino por la eficacia de su campaña de marketing. El tiempo que los científicos dedican a estas tareas de divulgación es tiempo que no dedican a la investigación, a la docencia o a la mentoría, actividades que constituyen el núcleo de su vocación.

El problema se agrava por la propia estructura del mundo académico. Las instituciones y los organismos de financiación a menudo utilizan métricas como el número de citas para evaluar la relevancia de un investigador. Un mayor número de citas no solo consolida una carrera, sino que abre las puertas a mejores oportunidades y a más recursos para seguir investigando. Dado que una mayor visibilidad conduce directamente a un mayor número de citas, la presión para promocionar activamente el propio trabajo se vuelve ineludible. Este círculo vicioso fomenta una cultura de la autopromoción constante, donde el éxito puede depender tanto de la destreza en el laboratorio como de la habilidad para gestionar una marca personal en las redes sociales.

En este panorama, la promesa de una herramienta que pueda nivelar el campo de juego, que pueda ofrecer a cada investigación una oportunidad justa de ser escuchada, resulta profundamente seductora. La automatización de la promoción no es, por tanto, una mera cuestión de comodidad, sino una posible solución a un problema sistémico que afecta a la eficiencia, la equidad y la meritocracia en el corazón de la empresa científica.

La construcción de un campo de pruebas para publicistas sintéticos

En el ámbito de la inteligencia artificial, crear un modelo poderoso es solo la mitad del desafío. La otra mitad, igualmente importante, es saber si ese modelo realmente funciona bien. Sin un método de evaluación objetivo y estandarizado, es imposible medir el progreso, comparar diferentes enfoques o identificar áreas de mejora. Por esta razón, la creación de un buen banco de pruebas, o benchmark, es a menudo una contribución científica tan significativa como el propio algoritmo que se evalúa.

Conscientes de ello, los artífices de AutoPR dedicaron un esfuerzo considerable a diseñar y construir PRBench, el primer campo de pruebas riguroso destinado a medir la calidad de los publicistas sintéticos. Su objetivo era ir más allá de las métricas superficiales y definir qué significa realmente una «buena» promoción científica.

El primer pilar de PRBench es la fidelidad. Este criterio va mucho más allá de la simple exactitud factual. Un sistema de promoción automática no solo debe evitar la desinformación, sino que tiene que ser capaz de capturar los matices, las incertidumbres y el tono del trabajo original. La ciencia a menudo se mueve en el terreno de lo provisional, y una promoción que presente una conclusión tentativa como un hecho categórico es una mala promoción, aunque técnicamente no contenga datos falsos.

La fidelidad exige que el agente sintético comprenda la diferencia entre correlación y causalidad, que sepa reflejar las limitaciones del estudio reconocidas por los propios autores y que mantenga un estilo coherente con la disciplina científica en cuestión. Por ejemplo, la promoción de un artículo de física teórica debería tener un tono distinto al de un estudio de sociología, y PRBench está diseñado para detectar estas sutilezas.

El segundo pilar es el engagement, la capacidad de generar interés y conexión con la audiencia. Este es, quizás, el aspecto más difícil de cuantificar. ¿Qué hace que un texto sea atractivo? Los creadores de PRBench abordaron este reto recopilando cientos de ejemplos de promociones científicas reales que habían tenido un gran éxito en las redes.

Analizaron estos casos para identificar patrones comunes: el uso de una pregunta inicial que despierte la curiosidad, la conexión del estudio con un problema de la vida cotidiana, la formulación de una analogía inteligente o la creación de un elemento visual impactante. El banco de pruebas utiliza estos ejemplos de alta calidad como referencia para juzgar las creaciones de la inteligencia artificial. De este modo, el sistema no solo evalúa la corrección gramatical o la claridad, sino también la creatividad y la capacidad de la máquina para contar una historia que cautive al lector.

El tercer y último pilar es la alineación, un concepto que se refiere a la adecuación del contenido al contexto de su publicación. Una promoción científica no existe en el vacío; está destinada a una plataforma específica, con sus propias reglas escritas y no escritas, y a una audiencia con ciertas expectativas. Un texto brillante y detallado puede ser perfecto para un blog, pero fracasará estrepitosamente en una red social que limita el número de caracteres.

La alineación mide la habilidad del sistema para realizar esta adaptación. Esto incluye ajustar la longitud y el formato del texto, seleccionar los elementos visuales más apropiados para cada plataforma e incluso considerar el mejor momento del día para publicar con el fin de maximizar el alcance. Un agente de promoción verdaderamente inteligente debe ser un camaleón comunicativo, capaz de transformar el mismo mensaje central en múltiples formatos, cada uno optimizado para su entorno. Con estos tres ejes de evaluación, PRBench establece un estándar de exigencia muy elevado, asegurando que el desarrollo de la promoción automática se guíe no por la cantidad, sino por la calidad y la responsabilidad.

PRAgent o la sinfonía de las inteligencias colaborativas

Una vez establecido el riguroso campo de pruebas, el siguiente paso era diseñar un contendiente capaz de superar sus desafíos. El resultado es PRAgent, un sistema que se aleja de la idea de una única inteligencia artificial omnipotente y apuesta por un modelo de colaboración entre múltiples agentes especializados. Esta arquitectura de multiagentes no es un capricho técnico; es una respuesta estratégica a la complejidad de la tarea.

Pedirle a un modelo de lenguaje general que lea un artículo y escriba un tuit es como pedirle a un médico de familia que realice una cirugía cerebral. Puede que tenga un conocimiento general, pero carece de la pericia específica necesaria. PRAgent, en cambio, funciona como un equipo de especialistas donde cada miembro se encarga de una parte del proceso en la que es experto, logrando un resultado final que es superior a la suma de sus partes.

El proceso se inicia con la primera fase: la extracción de contenido. Este es un desafío mayúsculo, ya que un artículo científico es un artefacto multimodal. No es solo texto. Contiene tablas complejas, gráficos que condensan miles de puntos de datos y diagramas que ilustran relaciones abstractas. El primer grupo de agentes de PRAgent está entrenado para ser un lector experto de este tipo de documentos. No se limita a procesar las palabras; analiza la estructura del artículo, identifica las hipótesis, los métodos y los resultados, y, crucialmente, es capaz de interpretar los elementos visuales.

Este agente puede «mirar» un gráfico y entender qué representa, extrayendo la tendencia principal o el dato más sorprendente que muestra, y vincular esa información con el párrafo del texto que lo explica. Esta capacidad de fusionar información de diferentes modalidades es lo que permite al sistema construir una comprensión holística y profunda del estudio.

Con este destilado de conocimiento en mano, la tarea pasa a la segunda fase: la síntesis colaborativa. Aquí es donde la magia de la colaboración entre agentes se hace más evidente. En lugar de que un solo agente escriba el borrador, varios agentes trabajan en conjunto, aportando diferentes «habilidades».

Un agente podría ser el experto en generar titulares impactantes, otro podría especializarse en redactar el cuerpo del texto con claridad y precisión, y un tercero podría actuar como un revisor crítico, verificando que las afirmaciones se correspondan con los datos extraídos en la fase anterior y sugiriendo mejoras en el estilo. Este proceso es iterativo. Los agentes pueden debatir, proponer alternativas y refinar el texto en sucesivas rondas, puliendo el borrador hasta alcanzar un nivel de calidad que sería difícil de lograr para un único agente en un solo intento. Esta dinámica de «lluvia de ideas» algorítmica imita la forma en que los equipos creativos humanos colaboran para producir trabajos de alta calidad.

La etapa final es la adaptación a la plataforma. Una vez que el equipo de síntesis ha producido un texto promocional de base, pulido y verificado, entra en juego el agente especialista en comunicación. Este agente posee un conocimiento detallado de las normas, los estilos y las audiencias de las diferentes redes sociales y plataformas de divulgación.

Si el destino es Twitter, por ejemplo, dividirá el contenido en un hilo coherente, añadirá hashtags relevantes y quizás algún emoji para aumentar el atractivo visual. Si el objetivo es LinkedIn, adoptará un tono más formal y profesional, destacando las implicaciones prácticas o industriales de la investigación. Para un blog, desarrollará el contenido con mayor profundidad, integrando las representaciones visuales del estudio original de una manera lógica y atractiva.

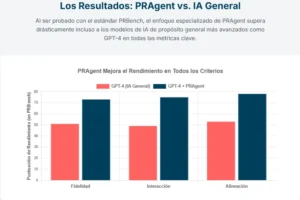

Los resultados presentados en el estudio demuestran que este enfoque especializado y por etapas es extraordinariamente eficaz. En las pruebas realizadas con PRBench, PRAgent superó de manera sistemática y por un amplio margen a los modelos de lenguaje más avanzados de propósito general, demostrando que en el complejo arte de la comunicación científica, un equipo de especialistas sintéticos bien orquestado es mucho más poderoso que un genio solitario.

Las fronteras éticas y el futuro de la comunicación científica

La llegada de tecnologías como AutoPR y PRAgent abre un horizonte de posibilidades apasionantes para la comunidad científica. La ventaja más evidente es la democratización de la visibilidad. Herramientas de este tipo podrían ayudar a investigadores de instituciones con menos recursos, o a aquellos que no tienen una inclinación natural hacia la autopromoción, a dar a conocer su trabajo en igualdad de condiciones.

Al automatizar una tarea que consume una cantidad considerable de tiempo y energía mental, estos sistemas permitirían a los científicos centrarse en lo que mejor saben hacer: investigar. Además, al facilitar la traducción del lenguaje técnico a un formato más accesible, podrían acelerar la transferencia de conocimiento no solo entre diferentes campos de la ciencia, sino también hacia los responsables políticos, la industria y el público en general, fortaleciendo el puente entre la ciencia y la sociedad.

Sin embargo, como toda tecnología poderosa, esta también plantea importantes cuestiones éticas y filosóficas que debemos abordar con cautela. La primera de ellas es la cuestión de la autenticidad. La comunicación científica en las redes sociales a menudo tiene un componente personal; es la voz del científico compartiendo su pasión y su trabajo.

¿Qué se pierde cuando esa voz es reemplazada por la de un algoritmo, por muy elocuente que sea? Existe el riesgo de que la comunicación se vuelva impersonal y estandarizada, perdiendo la chispa de la conexión humana que tan a menudo inspira confianza y curiosidad. Relacionado con esto, está el peligro de la homogeneización. Si miles de investigadores comienzan a utilizar herramientas similares, ¿empezará toda la promoción científica a sonar igual, optimizada según los mismos patrones y perdiendo la diversidad de estilos y enfoques que enriquece el discurso público?

Otro frente de preocupación es el potencial para un uso indebido o para exacerbar problemas existentes. ¿Podrían estos sistemas ser utilizados para exagerar la importancia de investigaciones mediocres, generando un «hype» artificial en torno a resultados poco sólidos? La capacidad de un algoritmo para crear contenido atractivo es independiente de la calidad del contenido original. Esto podría dificultar aún más la tarea de distinguir la señal del ruido en el ya saturado panorama de la información. Asimismo, existe el riesgo de que estos sistemas, si no se diseñan con cuidado, puedan amplificar sesgos existentes.

Por ejemplo, podrían aprender a promocionar ciertos tipos de investigación o temas que históricamente han recibido más atención, marginando aún más a los campos menos populares pero igualmente importantes. Finalmente, debemos reflexionar sobre el papel del científico. ¿Es la comunicación una tarea secundaria que puede ser externalizada sin más, o es una responsabilidad fundamental del investigador? Delegar completamente esta función podría distanciar a los científicos del debate público, convirtiéndolos en meros productores de datos en lugar de participantes activos en el diálogo social.

Desafíos futuros

La emergencia de la promoción automática en el ámbito científico, encarnada en propuestas como AutoPR y PRAgent, no es simplemente la historia de una nueva herramienta tecnológica. Es un espejo que refleja las profundas transformaciones y las crecientes presiones que definen a la ciencia del siglo veintiuno. Nos muestra una comunidad académica que lucha por hacerse oír en medio de un diluvio de información y que busca soluciones innovadoras para que el conocimiento valioso no se pierda en la irrelevancia. Este avance ofrece una promesa tangible de eficiencia, equidad y un mayor impacto social para la investigación.

Al mismo tiempo, nos obliga a confrontar preguntas fundamentales sobre la naturaleza de la comunicación, la autenticidad y el futuro rol del científico en la sociedad. La tecnología puede automatizar la redacción de un mensaje, pero no puede reemplazar la responsabilidad humana de asegurar que ese mensaje sea veraz, ético y constructivo. El verdadero desafío no reside en perfeccionar los algoritmos, sino en establecer los marcos y las buenas prácticas para que estas herramientas se utilicen de una manera que enriquezca, y no empobrezca, el ecosistema del conocimiento.

PRAgent puede encargarse de cómo se dice algo, pero somos nosotros, los humanos, quienes debemos seguir decidiendo por qué se dice y qué se dice. El objetivo final no debe ser simplemente amplificar todas las voces, sino ayudar a que las más importantes y necesarias se escuchen con mayor claridad.

Referencias

Chen, Q., Yan, Z., Yang, M., Qin, L., Yuan, Y., Liu, J., Ji, Y., Peng, D., Guan, J., Hu, M., Li, H., Che, W., & Du, Y. (2025). AutoPR: Let’s Automate Your Academic Promotion!. arXiv preprint arXiv:2510.09558.