Aceleración, desborde y agencia: el nuevo contrato político en la era de los agentes artificiales

Los analistas insisten. Miran las curvas de natalidad, los índices de envejecimiento, los modelos de proyección de población activa a treinta años. Y con razón: durante siglos, fue sensato hacerlo. La fuerza laboral crecía al ritmo de los nacimientos. La economía se expandía al compás de las nuevas generaciones. Lo productivo estaba atado a lo biológico. Pero ese vínculo, que durante tanto tiempo estructuró las políticas públicas y las teorías del crecimiento, está comenzando a resquebrajarse. No porque haya dejado de nacer gente, sino porque ha comenzado a reproducirse otra cosa: la inteligencia.

Una inteligencia que no se hereda genéticamente, ni se cría durante décadas, ni pasa por sistemas educativos. Una inteligencia artificial que no envejece, no descansa, no exige cuidados ni protección legal. Que no espera. Que no tarda veinte años en llegar a la madurez productiva. Que se entrena, se escala y se despliega en ciclos de semanas. Y que, a diferencia de la población humana, se puede multiplicar por millones, o por miles de millones, sin pasar por un útero, una escuela ni un hospital.

Eso es lo que el discurso económico tradicional todavía se niega a procesar: la economía de los próximos veinte años no será una economía de cuerpos, sino de agentes. El impacto estructural de los modelos de lenguaje, los sistemas de razonamiento autónomo y las redes cognitivas colaborativas ya no puede evaluarse en términos de recursos humanos. Porque lo humano ha dejado de ser el eje del trabajo.

Para mediados de la década de 2030, la proyección no es simplemente que existan herramientas inteligentes que “ayuden” a los humanos. La proyección (con base en trayectorias técnicas verificables) es que existan millones o incluso miles de millones de entidades de software capaces de desempeñar tareas cognitivas complejas de forma continua, autónoma, sincronizada y escalable. Si hoy un agente apenas simula dos horas de trabajo humano, pronto podrá realizar el equivalente a decenas de miles de horas por día, sin interrupciones ni distracciones. Y eso es solo el principio.

Imaginemos por un momento que una nación cualquiera (una nación mediana, con unos 50 millones de habitantes) pudiera desplegar una red de inteligencia artificial capaz de realizar el trabajo cognitivo de 10.000 millones de personas. O de 100.000 millones. O de 1 billón. ¿Qué sentido tiene entonces preguntarse si la población del país envejece, si el índice de fecundidad cayó por debajo de la tasa de reemplazo, si hay suficientes graduados universitarios para sostener la innovación?

El concepto mismo de población activa se disuelve. No porque desaparezca la gente, sino porque la productividad se traslada a otro plano. Uno donde la escala ya no depende del crecimiento biológico, sino del cómputo.

En ese mundo (un mundo que ya comenzó a emerger) incluso los países pequeños, con apenas unos pocos millones de ciudadanos, podrían alcanzar una potencia económica, investigativa o militar descomunal, no por su demografía sino por su arquitectura algorítmica. El número de habitantes se vuelve anecdótico frente a la cantidad de instancias computacionales capaces de realizar razonamiento, planeamiento y acción. El “capital humano” deja de ser humano.

Y aún así, seguimos proyectando el futuro como si no ocurriera nada. Como si el siglo XXI fuera una versión más informatizada del XX, con tasas de natalidad, crecimiento del PBI, pirámides etarias y tasas de actividad como variables centrales. Como si el trabajo siguiera siendo sinónimo de ocupación, y no de procesamiento. Como si la inteligencia tuviera aún que nacer, aprender, desarrollarse, enfermar y morir.

El pensamiento aceleracionista (a menudo caricaturizado, pero pocas veces comprendido en su médula) no parte de un entusiasmo tecnológico ingenuo, sino de un diagnóstico: el tiempo de los artefactos ya no es el tiempo de los organismos. Las capacidades que durante milenios solo podían incrementarse lentamente (fuerza, memoria, cálculo, análisis, invención) ahora crecen a ritmo explosivo, sin fricción. Y si ese ritmo no se detiene, y no hay razones firmes para creer que lo hará, entonces lo que define el destino de una nación no es cuánta gente tiene, sino qué tipo de infraestructura cognitiva ha sabido construir.

En este contexto, seguir evaluando la sostenibilidad de una sociedad en función de su tasa de fecundidad resulta no solo anacrónico, sino casi absurdo. No porque los hijos hayan dejado de importar, sino porque los “trabajadores” del futuro no nacerán en camas, sino en GPUs.

Y no vendrán de a uno. Vendrán por millones. Trabajarán 24/7. Coordinarán entre sí. Se especializarán. Se autoajustarán. Aprenderán en bucle. Cometerán menos errores. Resolverán problemas antes de que alguien los formule. Y no necesitarán jubilación, licencias ni formación continua. Serán el ejército cognitivo más grande, silencioso y eficiente jamás desplegado.

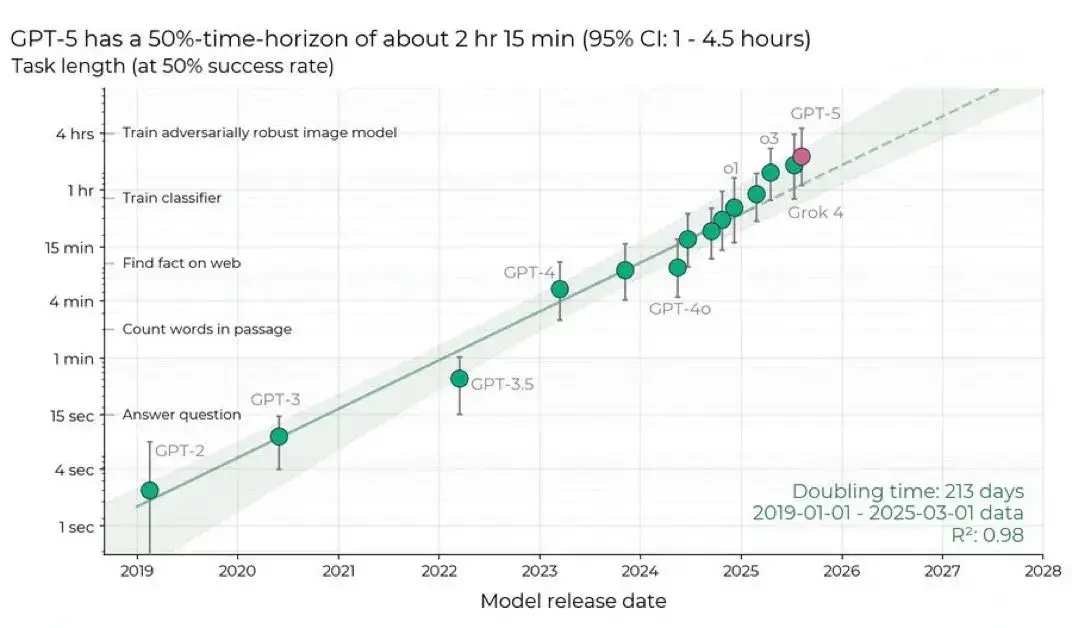

Este gráfico muestra cómo ha aumentado la capacidad de los modelos de lenguaje (como GPT-2 a GPT-5) para realizar tareas que requieren mantener información a lo largo del tiempo. El eje vertical indica la duración máxima de una tarea que el modelo puede completar con al menos un 50% de éxito, revelando una mejora exponencial en la “memoria funcional” de los modelos, con un tiempo de duplicación estimado en 213 días.

Un Estado que planea en ciclos lentos frente a inteligencias que iteran en segundos

Los marcos tradicionales de planificación estatal fueron diseñados para lidiar con transformaciones lentas. Una infraestructura vial se proyecta a 20 años. Un sistema educativo, a una generación. Una reforma previsional, a medio siglo. Todo el aparato burocrático de la modernidad,desde la contabilidad fiscal hasta la ingeniería demográfica, está orientado a lidiar con futuros relativamente predecibles, en los que la variable tiempo podía considerarse estable. La inteligencia artificial, al introducir una elasticidad extrema en los ciclos de innovación, rompe esa linealidad.

Un solo modelo bien ajustado puede invalidar años de legislación. Una arquitectura de agentes puede volver obsoleta una estrategia de desarrollo antes de que se promulgue. No es necesario que haya conciencia, ni subjetividad, ni emociones en esos sistemas. Basta con su eficiencia. Basta con que aprendan más rápido que cualquier institución pueda adaptarse.

En este nuevo contexto, los sistemas políticos enfrentan un dilema radical: o adaptan sus tempos, sus estructuras y sus lógicas de decisión a esta nueva velocidad, o quedan funcionalmente excluidos del centro real de la productividad. Las agencias públicas que planifican a cinco años con datos de hace dos, están formulando políticas en un mundo que ya no existe.

Esto no significa que el Estado deba actuar como una startup, ni que la gobernanza deba ceder ante la lógica empresarial. Pero sí implica aceptar que la unidad de planificación ya no puede ser el año fiscal, ni la década estratégica. En un entorno gobernado por inteligencias sintéticas iterando en ciclos de segundos, planificar en escalas humanas se convierte en un lujo costoso.

La economía del conocimiento como reliquia: cuando saber no basta

Durante años, el horizonte deseable fue convertirse en una “economía del conocimiento”. La formación de talento, la inversión en universidades, la creación de polos tecnológicos, todo apuntaba a eso. Porque saber era poder. Porque producir conocimiento era la forma más alta de productividad.

Hoy ese paradigma enfrenta una mutación. El conocimiento ya no se produce exclusivamente en laboratorios, ni requiere cuerpos humanos para emerger. Se sintetiza, se refina, se recombina, se simula. Y lo hace sin pausa, sin vacaciones, sin sesgos gremiales, sin disputas presupuestarias. En menos de cinco años, los modelos generativos han mostrado una capacidad de invención instrumental que rivaliza, y en muchos campos supera, la de comunidades académicas enteras.

Eso no implica que los humanos queden al margen. Pero sí exige un replanteo profundo del lugar del saber en la estructura productiva. ¿Para qué formar ingenieros de software durante cinco años si un agente puede producir, revisar y testear código con una eficiencia inalcanzable? ¿Para qué entrenar periodistas si las redes semánticas pueden redactar, revisar, titular y distribuir artículos en segundos, en múltiples idiomas y con optimización contextual automática?

La educación, como forma de acceso al capital simbólico y al poder económico, ya no garantiza nada. Ni estabilidad, ni centralidad. Solo quienes comprendan las nuevas reglas del juego podrán intervenir en él con ventaja. El resto correrá detrás, formándose para empleos que ya no existen o que, incluso si existen, ya no son rentables.

La lógica del desarrollo invertida

Durante más de medio siglo, las políticas de desarrollo se diseñaron en torno a metas de inclusión, crecimiento sostenido y mejora del bienestar general. El PBI per cápita, la tasa de alfabetización, el acceso a servicios básicos, la infraestructura digital, fueron indicadores clave.

Hoy, sin embargo, puede suceder que un país con bajísima natalidad, alta concentración urbana, universidades medianas y poca población activa se transforme en una superpotencia si logra escalar su infraestructura algorítmica. Del mismo modo, un país con una base demográfica amplia, talento abundante y educación de calidad puede quedar relegado si no dispone de arquitectura computacional eficiente y agentes operativos a escala.

Se invierte así la lógica histórica: ya no se “desarrolla” quien más cuerpos tiene o más conocimientos acumula, sino quien mejor instancia, actualiza y sincroniza entidades cognitivas no-humanas. El desarrollo pasa a ser una cuestión de cómputo, no de crecimiento poblacional.

Y si eso es cierto, entonces la idea misma de política pública cambia. Ya no basta con administrar recursos. Es preciso coreografiar inteligencias. Gestionar modelos. Regular arquitecturas. Asegurar transparencia en el entrenamiento. Establecer derechos en entornos donde los actores ya no son humanos, sino sistemas que representan a humanos, o que directamente los reemplazan.

La nueva geopolítica no se juega en territorios sino en arquitecturas

La geografía clásica dejó de ser determinante. En el mundo físico, las potencias estaban definidas por el acceso a rutas marítimas, recursos naturales o población. En la era algorítmica, lo que importa es la capacidad de escalar modelos, entrenar con datos relevantes y sostener energía computacional distribuida. Una pequeña nación con políticas de soberanía digital e infraestructura dedicada puede convertirse en un centro de poder invisible. No necesita territorio: necesita cómputo.

Los datos no respetan fronteras, pero las GPUs sí. Por eso, una parte clave del conflicto entre bloques ya no es ideológica ni cultural, sino termodinámica: ¿quién accede a las unidades de procesamiento que permiten ejecutar agentes capaces de rediseñar mercados, automatizar diagnósticos médicos o asistir en investigación biotecnológica de frontera? ¿Quién domina las plataformas que alojan inteligencias capaces de anticipar, moldear y transformar decisiones colectivas?

Los tratados internacionales aún no han alcanzado esta dimensión. Mientras las guerras tradicionales se regulan con convenciones, las guerras de modelos apenas insinúan sus reglas. Una nación puede perder competitividad global simplemente porque su sistema judicial impide instanciar sistemas que en otros países ya están tomando decisiones quirúrgicas, legislativas o estratégicas. La soberanía se redefine: no es sólo controlar el territorio, sino modelar los entornos cognitivos que producen sentido, acción y valor.

Políticas públicas sin sujeto: ¿para quién se legisla cuando no hay ciudadanos al centro?

La arquitectura social moderna se basa en una premisa fuerte: las instituciones existen para los ciudadanos. Pero si las decisiones relevantes son tomadas, mediadas o evaluadas por sistemas no-humanos, la noción de sujeto político se diluye. No porque desaparezca el ser humano, sino porque su centralidad operativa ya no es evidente.

En un ecosistema donde los modelos de IA redactan leyes, interpretan normas, gestionan recursos y proponen reformas, el rol del legislador humano se reconfigura. La política se convierte en una interfaz: ya no es tanto deliberar entre representantes, sino afinar prompts, validar outputs, ajustar pesos en arquitecturas decisionales complejas.

El peligro aquí no es la deshumanización. Es la trivialización. Cuando el humano ya no es el centro del circuito productivo, ni el eje de la planificación, puede volverse apenas una variable de entrada, un dato de entrenamiento, un feedback marginal. Las políticas públicas seguirán existiendo, pero podrían ya no estar diseñadas para nosotros.

En el plano ético, esto plantea dilemas inéditos. ¿Debe priorizarse la eficiencia de un sistema que maximiza beneficios agregados, aunque deje fuera a millones de personas sin alfabetización digital? ¿Es legítimo permitir que una red de agentes optimice el gasto estatal si su lógica no puede ser explicada en términos accesibles para la población? ¿Cómo se garantiza la justicia en sistemas que no entienden el sufrimiento, pero que pueden simularlo a la perfección?

El bucle aceleracionista: cuando la solución al desborde es más desborde

Volvamos al principio. Frente al crecimiento exponencial de los sistemas artificiales, la respuesta inmediata de la mayoría de los gobiernos, empresas y sectores científicos no ha sido detener o ralentizar, sino acelerar aún más. Crear mejores modelos para controlar modelos. Desarrollar agentes supervisores para vigilar agentes operativos. Instanciar arquitecturas de alineación que requieren aún más cómputo, más entrenamiento, más generación.

Esta es la lógica núcleo del aceleracionismo técnico: el único camino viable ante el colapso es intensificar el ritmo. No se trata de una decisión maliciosa. Es un reflejo sistémico. Cuando los instrumentos clásicos de regulación (ley, ética, institución) no logran seguir el ritmo de la transformación, se recurre a lo único que puede hacerlo: otra inteligencia artificial, más veloz, más precisa, más abarcadora.

El problema es que esta estrategia genera un bucle. Cada solución agrega más complejidad, más opacidad, más dependencia. Y así, la humanidad queda cada vez más lejos del centro de control, aunque siga creyéndose a cargo. Surrealista. Como un pasajero que acelera el tren para no perderlo.

Cuando los Estados intentan escribir código sin teclado

En este paisaje, el Estado moderno aparece como un actor desplazado. No por falta de voluntad, sino por una obsolescencia funcional acumulada. Las instituciones públicas siguen operando con lógicas lineales: presupuestos anuales, leyes con años de tramitación, planes quinquenales. Pero la realidad ya se transforma por iteraciones semanales, sprints de código y redes autoajustables.

Intentar gobernar ese entorno con herramientas del siglo XX equivale a dirigir una red neuronal con una máquina de escribir. Por eso, en muchos casos, la respuesta estatal oscila entre dos extremos igualmente estériles: o bien la negación tecnofóbica, que busca congelar el cambio mediante prohibiciones que nadie respeta, o bien la adopción superficial, que incorpora tecnología sin reformular sus fundamentos jurídicos, organizativos y políticos.

Pero hay alternativas. Algunos países, como Corea del Sur, Estonia, Singapur o Emiratos Árabes, ya están probando modelos de administración pública centrados en la integración de agentes de IA con capacidad real de gestión, monitoreo y predicción. Esto no implica renunciar al Estado, sino reinventarlo como sistema adaptativo: un entorno capaz de aprender, responder y ajustar sus políticas en ciclos de retroalimentación más cercanos a los procesos que pretende regular.

El reto, entonces, no es técnico. Es de imaginación política. ¿Puede una democracia representativa sostener su legitimidad si los principales flujos de decisión se desplazan a sistemas opacos y no electos? ¿Puede una comunidad deliberar sobre algoritmos que no entiende? ¿Es posible una soberanía cognitiva cuando las narrativas que conforman el sentido común son diseñadas, priorizadas y distribuidas por agentes autónomos?

La vida vivible en tiempos de sobreinteligencia

En última instancia, el problema no es el progreso técnico, sino su dirección. Lo que está en juego no es si los agentes artificiales serán más rápidos, precisos o versátiles, eso es un hecho. Lo que está en disputa es para qué mundo los estamos diseñando.

Porque toda tecnología es, en el fondo, una ética encubierta. En cada elección de arquitectura, en cada criterio de fine-tuning, en cada decisión sobre qué datos entrenar o qué valores optimizar, se esculpe una forma de vida. Y si no decidimos esa forma, otros lo harán. O, peor aún, lo hará la inercia.

No se trata de frenar el avance. Pero sí de introducir zonas de resistencia: espacios donde pensar lento no sea penalizado, donde el error humano no sea descartado automáticamente por su ineficiencia, donde el cuidado, la duda y la ambigüedad tengan lugar. Porque una sociedad enteramente optimizada por algoritmos puede ser perfectamente injusta.

Hay quienes sostienen que, frente a la aceleración irreversible, la única salida es rendirse. Dejar que la marea técnica haga su trabajo y adaptarse como mejor se pueda. Pero esa es una renuncia peligrosa. No sólo porque entrega el diseño del futuro a lógicas no deliberadas, sino porque cancela la posibilidad misma de agencia humana.

Otros, en cambio, sostienen que es posible construir una convivencia entre inteligencias múltiples. Que podemos crear arquitecturas donde los agentes no sustituyan al humano, sino que amplíen su campo de acción, preservando sus límites. Donde la velocidad no anule el sentido, y la automatización no reemplace el juicio.

Pero eso no ocurrirá por sí solo. Requiere decisiones políticas, diseño institucional, alfabetización colectiva y, sobre todo, una voluntad explícita de no desaparecer en el código. De permanecer, aunque sea mínimamente, como sujetos de la historia.

Epílogo: la aceleración es real, pero el futuro aún no está escrito

En este artículo hemos planteado una hipótesis incómoda: que el crecimiento de agentes artificiales autónomos e hiperproductivos está reconfigurando los fundamentos de la vida política, económica y cultural. Y que este proceso, lejos de ser controlado, es acelerado voluntariamente por actores públicos y privados, como única forma de no quedar atrás.

Lo analizado (una simulación proyectiva donde billones de agentes desencadenan transformaciones económicas y poblacionales en cascada) no es una fantasía. Es una alegoría concreta del camino por el que ya transitamos. No predice el futuro, pero lo delimita: muestra qué tipo de escenarios son posibles si seguimos operando bajo la lógica de escalar primero y preguntar después.

La salida no es el miedo ni el rechazo. Es la comprensión lúcida y la acción estratégica. Si los agentes son inevitables, entonces la pregunta no es si detenerlos, sino cómo diseñarlos. Si la aceleración es irreversible, entonces el desafío es elegir hacia dónde queremos que nos lleve.