Cuando un sistema inteligente sale del laboratorio y aterriza en el mundo, no lo hace solo. En logística, en energía, en tráfico urbano, en seguridad informática o en plataformas digitales, el funcionamiento descansa cada vez más en colectivos de agentes que aprenden y toman decisiones de manera distribuida. Es lo que se conoce como aprendizaje por refuerzo multiagente: conjuntos de entidades que perciben, actúan y mejoran su política con el paso del tiempo, ya sea cooperando, compitiendo o alternando entre ambos extremos. En ese escenario, una pregunta deja de ser teórica para volverse urgente: si parte del sistema falla, si algunos integrantes son atacados, saboteados o simplemente se degradan, ¿cuáles son los agentes cuya caída produce el mayor daño global?

El paper “Vulnerable Agent Identification in Large-Scale Multi-Agent Reinforcement Learning” propone una respuesta formal a esa pregunta. La idea es sencilla de exponer y exigente de ejecutar: en un enjambre con cientos o miles de componentes, encontrar qué subconjunto es el más crítico para la estabilidad y el rendimiento del conjunto. No se trata de una auditoría por intuición, ni de una enumeración exhaustiva imposible de costear, sino de transformar el problema en una tarea de decisión bien planteada y resoluble con garantías. En otras palabras, dotar al sistema de un espejo que revele sus puntos frágiles antes de que alguien más los descubra.

El texto introduce un marco novedoso para aislar a los agentes más vulnerables en entornos de gran escala. Lo hace con una formulación jerárquica que divide el problema en dos niveles: arriba, la selección combinatoria de los agentes cuya manipulación haría más estragos; abajo, el aprendizaje de políticas adversarias capaces de exprimir esos estragos. Este encastre, si se abordara directamente, sería inabordable en la práctica. La contribución central de la investigación es desacoplar ambos niveles sin perder la esencia de la solución óptima y convertir el corazón combinatorio en un proceso secuencial que se puede resolver con heurísticas codiciosas o con aprendizaje por refuerzo. El resultado, según muestran los autores, es una herramienta que escala, que preserva la calidad de la decisión y que, además, devuelve una función de valor útil para visualizar la vulnerabilidad de cada agente.

A continuación vamos a recorrer el paisaje conceptual para lectores no especialistas, reconstruir el planteo del problema y explicar con claridad la ingeniería matemática que permite dividirlo en piezas manejables. Después veremos qué dice la evidencia experimental y por qué todo esto importa más allá de los benchmarks: desde la seguridad de infraestructuras críticas hasta la planificación urbana o la operación de flotas. El objetivo es ofrecer un relato completo y accesible, sin perder precisión técnica ni sacrificar la pregunta que late detrás de toda innovación responsable: qué ganamos, qué arriesgamos y qué necesitamos medir mejor.

Una panorámica didáctica: de muchos agentes a pocos puntos frágiles

Para entender por qué identificar agentes vulnerables es tan complejo, conviene empezar por el principio. En aprendizaje por refuerzo, un agente interactúa con un entorno, recibe recompensas y aprende una política para maximizar su retorno esperado. En un escenario multiagente, ese juego se multiplica: cada integrante aprende mientras los demás también cambian, y la dinámica conjunta puede generar cooperación emergente, colisiones inesperadas, alianzas efímeras o guerras de desgaste. El espacio de estados crece con cada nuevo actor, las señales se vuelven más ruidosas y la interacción deja de ser un diálogo para convertirse en polifonía.

En sistemas reales, además, la perfección no existe. Los sensores fallan, los enlaces de comunicación se cortan, el hardware envejece, las políticas aprendidas quedan desfasadas frente a entornos que mutan. A esa degradación natural se suman los adversarios: entidades que buscan deliberadamente empujar el sistema hacia regiones mal calibradas, ya sea inyectando observaciones engañosas, perturbando acciones o secuestrando a unos pocos nodos clave. A medida que el sistema escala, la posibilidad de que “algo” se rompa deja de ser un caso borde y pasa a ser el estado normal de las cosas.

Con este telón de fondo, nace el problema de identificación de agentes vulnerables. En términos sencillos: dado un conjunto grande, elegir un subconjunto pequeño cuya corrupción hipotética cause el máximo deterioro del desempeño global. Si esto suena a problema combinatorio, es porque lo es. Enumerar todas las posibilidades es prohibitivo incluso para tamaños moderados. Peor aún, la “pérdida” que producen los agentes saboteados depende de cómo actúan los demás, que a su vez están aprendiendo. El efecto es doblemente acoplado: combinatorio y dinámico.

La literatura reciente ofrece piezas para el rompecabezas: enfoques de robustez multiagente, métodos mean-field para aproximar interacciones a gran escala, formulaciones de control descentralizado y técnicas de optimización que intercambian óptimos difíciles por equivalentes manejables. Lo que aporta este trabajo es un ensamblado coherente de esas piezas en una arquitectura jerárquica y, sobre todo, una prueba de que el desacople propuesto no descarrila la solución. Así, la tarea imposible se convierte en dos preguntas resolubles: cómo aprende el adversario en el nivel inferior y cómo decide el selector en el nivel superior.

Qué problema resuelve exactamente el paper

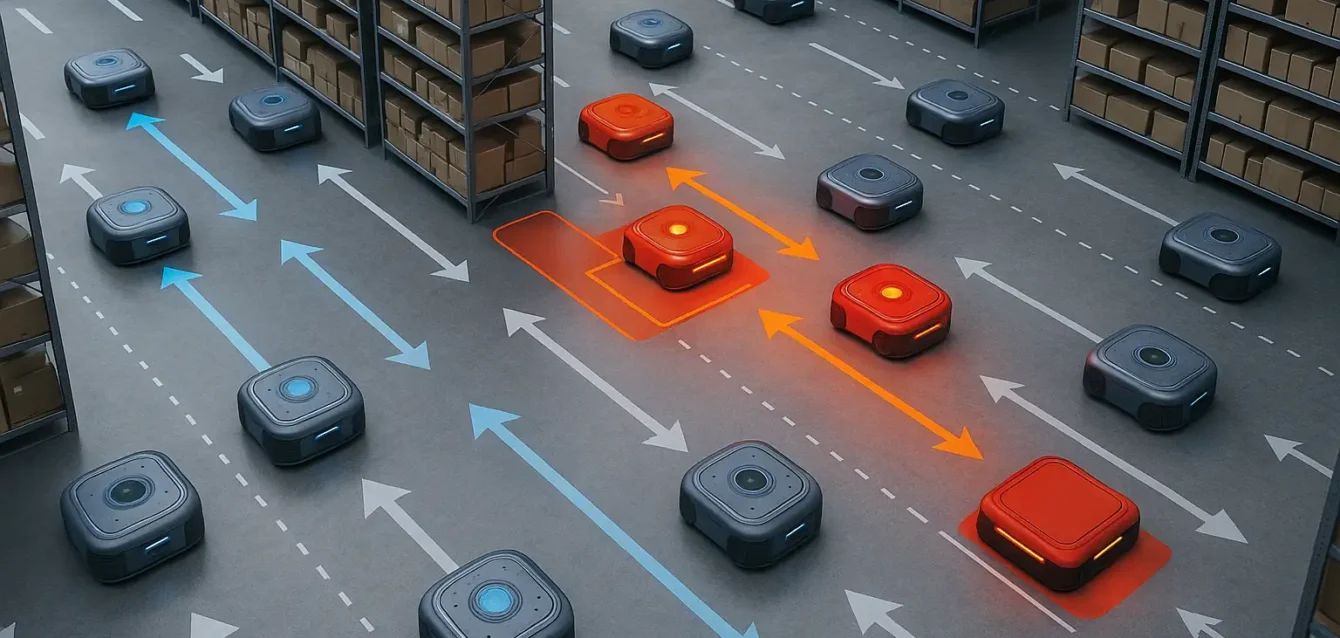

Los autores bautizan a su desafío Vulnerable Agent Identification, o VAI. Imaginemos una población extensa de agentes que comparten una tarea, por ejemplo coordinar el tráfico en una red de intersecciones, administrar el flujo de energía en una microred o gestionar la asignación de tareas en una flota de robots. El objetivo es seleccionar K agentes tales que, si fueran sometidos a una política adversaria, el rendimiento del sistema caiga lo máximo posible. No es un ejercicio hipotético: permite priorizar defensas, testear planes de contingencia y asignar presupuestos donde realmente marcan la diferencia.

El marco elegido para modelar esta interacción es el control mean-field descentralizado, una aproximación que reemplaza el seguimiento uno a uno de todos los pares por una estadística agregada del comportamiento de la población. En lugar de tener que llevar la cuenta de cada vecino, cada agente reacciona a una “media” de su entorno. Esta familia de métodos ha demostrado ser una vía eficaz para escalar decisiones cuando el número de actores es enorme y las interacciones, aunque locales, terminan generando patrones globales. Sobre ese terreno, el trabajo formula una estructura jerárquica: arriba, el selector elige qué agentes someterá al peor escenario; abajo, un adversario aprende políticas para esos agentes seleccionados, de modo de producir la máxima pérdida bajo el modelo mean-field. El acoplamiento entre niveles es natural: el selector necesita anticipar cuánto daño puede infligir el adversario, y el adversario responde a las decisiones del selector.

Matemáticamente, el nivel superior es un problema NP-duro de selección combinatoria y el inferior es un aprendizaje por refuerzo adversario en un contexto mean-field. Abordarlos de manera conjunta sería equivalente a resolver un juego bi-nivel inmenso. La novedad del artículo es mostrar que esta estructura puede transformarse en un par de problemas independientes mediante una técnica de optimización conocida como transformada de Fenchel-Rockafellar, que permite cambiar una expresión difícil por su dual y, al hacerlo, introducir un regularizador en el operador de Bellman que aparece en el nivel superior. El resultado práctico es que el selector del nivel alto puede aprender sobre una función de valor regularizada, mientras el nivel bajo entrena a su adversario mean-field, sin tener que estar acoplados paso a paso.

Cómo se transforma un problema intratable en dos procesos aprendibles

El corazón técnico del trabajo es el desacople. La transformada de Fenchel-Rockafellar, una herramienta clásica en optimización convexa, permite intercambiar maximización y minimización bajo ciertas condiciones y llevar términos regulares a un operador que, en RL, conocemos como Bellman. La consecuencia es importante: el nivel superior deja de depender explícitamente de la dinámica particular del adversario en cada paso y puede operar sobre una aproximación regularizada que captura el peor caso de manera estable y densa en recompensas. Dicho en plano: el selector ya no necesita explorar un espacio de combinaciones inmenso a ciegas, porque cuenta con una señal informativa que guía sus elecciones.

Una vez logrado ese cambio de variable conceptual, el segundo paso es reformular la selección combinatoria de vulnerables como un MDP independiente. En lugar de decidir de una sola vez qué K agentes son los más peligrosos, el selector avanza de manera secuencial: elige uno, observa la señal densa que proviene del operador de Bellman regularizado, actualiza su estimación y prosigue. Esto habilita dos familias de soluciones complementarias. La primera es un algoritmo codicioso que, paso a paso, incorpora el siguiente agente que genera la caída marginal más alta del valor global. La segunda es un aprendizaje por refuerzo en el espacio de elecciones, que entrena una política para escoger agentes de manera más astuta cuando las interacciones son sutiles o cuando la codicia miope no ve combinaciones sinérgicas. Lo relevante, enfatizan los autores, es que el desacople preserva el óptimo del problema bi-nivel original.

La contracara de este movimiento es que el nivel inferior sigue siendo exigente: hay que aprender políticas adversarias mean-field que exploren el peor escenario dentro de un conjunto plausible de perturbaciones. Sin embargo, esa dificultad es del tipo que el campo ya sabe manejar con bibliotecas y técnicas existentes: entrenamiento descentralizado con información agregada, aproximaciones de distribución de agentes, regularización para estabilidad y estimación de gradientes en espacios amplios. En suma, el trabajo no niega la complejidad, pero la coloca en compartimentos tratables y conectados por una señal bien diseñada.

Del pizarrón a los resultados: qué muestran los experimentos

El artículo evalúa el método en entornos multiagente de gran escala y lo contrasta contra alternativas razonables, incluidas reglas basadas en heurísticas y selecciones ingenuas sin guía de valor. El hallazgo consistentemente reportado es que el enfoque propuesto identifica con mayor eficacia los agentes cuya manipulación produce peores fallos, y lo hace con un costo computacional que habilita su uso en poblaciones extensas. Además, el aprendizaje converge hacia una función de valor que no solo cumple el rol instrumental de orientar la búsqueda, sino que sirve como radiografía de vulnerabilidad: un mapa que asigna a cada agente una medida de cuán crítico es para el todo.

Los autores sostienen que el sistema “engaña” a configuraciones basadas en reglas, en el sentido de que encuentra combinaciones de agentes que, cuando son atacados, derriban estrategias defensivas simplistas. Esa capacidad para revelar fallas no obvias se traduce en una ventaja práctica: en lugar de blindar de manera uniforme, el operador puede priorizar nodos, áreas o funciones cuyo resguardo evita cascadas de degradación. El experimento, aunque simulado, empata bien con la intuición operativa de quienes gestionan sistemas complejos: lo que importa no es cuántas piezas proteges, sino cuáles.

El trabajo dialoga con dos debates vigentes. El primero es la escalabilidad de sistemas multiagente. A medida que crecen, los enfoques que requieren modelar interacciones uno a uno se ahogan en su propia complejidad. La aproximación mean-field es un atajo con fundamento teórico y valor práctico: permite razonar sobre promedios y distribuciones sin seguir cada vínculo individual. El segundo debate es la robustez. La comunidad viene explorando formulaciones robustas que contemplan perturbaciones, incertidumbre o adversarios. La novedad aquí es aplicar ese lente robusto a la selección misma de objetivos: no solo prepararse para un adversario difuso, sino identificar en frío qué puntos harían más daño si fueran comprometidos. En términos de política tecnológica y gobernanza, esa diferencia es sustancial: facilita auditorías proactivas, pruebas de estrés y planes de mitigación con prioridades claras.

Explicar sin jerga: mean-field, Bellman, dualidad y por qué importan

Vale una pausa pedagógica para el lector que no vive en estos tecnicismos. El enfoque mean-field es similar a estudiar un gas sin seguir cada molécula: en vez de calcular cada choque, uno trabaja con densidades, temperaturas y presiones. En multiagente, las “moléculas” son políticas que toman acciones; la “presión” es el efecto agregado de la población. El operador de Bellman es una maquinaria matemática que, dada una política, te dice cuál es el valor esperado de actuar de cierta forma desde cada estado. Modificarlo con un término de regularización, como propone el paper, produce un valor más “suave” y menos ruidoso, que es más útil como brújula para decisiones de alto nivel.

La transformada de Fenchel-Rockafellar, por su parte, es una técnica de optimización que permite intercambiar problemas difíciles por otros equivalentes que se resuelven mejor. Imagínela como cambiar de perspectiva en un problema geométrico para medir con una regla lo que antes exigía un compás. Este intercambio no es gratuito: requiere condiciones y prueba que, en el artículo, se detallan para asegurar que el óptimo del problema original no se sacrifica en el proceso. Dicho con menos formalidad: el desacople no es un atajo que te aleja de la mejor solución, sino un cambio de coordenadas que te permite alcanzarla con menos fricción.

Por qué seleccionar vulnerables de forma secuencial mejora la búsqueda

La reformulación del nivel superior como un MDP con recompensas densas permite abandonar la explosión combinatoria. En lugar de intentar adivinar el mejor conjunto de K agentes de una sola vez, el selector elige uno por paso y recibe una señal informativa sobre el impacto marginal de esa elección. Con esa pista en la mano, puede optar por dos rutas. Una, codiciosa: quedarse siempre con el siguiente agente que más daño marginal causa. Otra, entrenada: aprender una política que entienda interacciones sutiles, donde la combinación de dos agentes medianamente críticos produzca un efecto mayor que la suma de sus partes. La segunda opción es especialmente útil cuando hay complementariedades o antagonismos entre roles, topologías o regiones del sistema.

Para salir del laboratorio, imaginemos cuatro dominios. En una microred eléctrica, los agentes pueden representar controladores locales de generación y almacenamiento. VAI señalaría cuáles nodos, si fueran alterados, precipitarían desbalances peligrosos. En una red de tráfico urbano, los agentes son intersecciones con control adaptativo; la identificación de vulnerables iluminaría qué cruces conviene blindar para evitar congestiones en cadena. En una flota de robots de almacén, los agentes son unidades móviles; encontrar los vulnerables revela qué zonas o roles necesitan redundancia. En plataformas digitales, los agentes pueden ser módulos de recomendación o filtrado; la selección informaría dónde una manipulación produce sesgos sistémicos que afectan la calidad del servicio. En todos los casos, el mismo principio: priorizar defensas donde la elasticidad del sistema es menor.

Ningún método serio llega sin advertencias. La primera es que el enfoque mean-field, aunque poderoso, introduce una abstracción: trata las interacciones a través de promedios. Si en un dominio particular las dependencias locales son decisivas, el modelo podría requerir extensiones que mezclen mean-field con grafos explícitos o atajos de atención que recuperen estructura. La segunda es que la elección de K, el tamaño del conjunto vulnerable, no es neutra. Un selector demasiado grande banaliza la priorización; uno demasiado pequeño puede omitir combinaciones peligrosas. La tercera es la fidelidad del adversario simulado: si el espacio de perturbaciones no cubre ataques realistas, la identificación puede ser complaciente. Dicho breve, el método reduce la complejidad y preserva el óptimo de su formulación, pero su poder predictivo depende de una buena ingeniería de entorno.

Otra cuestión es la relación con la defensa. Identificar vulnerables es el primer paso de un ciclo que debería continuar con mitigación y monitoreo. La traducción operativa sugiere políticas adaptativas: fortalecer nodos críticos, diversificar funciones, introducir redundancias selectivas, ajustar umbrales de alerta. También invita a pensar en contratos de desempeño más explícitos: métricas de resiliencia, acuerdos sobre tiempo de recuperación y pruebas periódicas de estrés. En regulación y cumplimiento, la herramienta podría integrarse a auditorías obligatorias de sistemas automatizados en sectores sensibles, con reportes que documenten qué se consideró, qué se encontró y qué se corrigió.

Cómo se compara con otras líneas de investigación

Hay trabajos que buscan robustez frente a incertidumbre y ataques escalando a muchos agentes. Otros exploran mecanismos de coordinación que resisten perturbaciones sin necesidad de identificar objetivos concretos. El aporte específico aquí es el foco en la selección secuencial de vulnerables con garantías teóricas de que la descomposición no empobrece la solución. Ese énfasis lo vuelve complementario a enfoques de robustez multiagente y a marcos de seguridad escalable que priorizan diseño preventivo. En un panorama donde la escala complica tanto el aprendizaje como la defensa, contar con un radar para señalar dónde pega más la adversidad es una pieza valiosa.

Una lectura crítica de los resultados

El artículo reporta mejoras claras frente a baselines. Aun así, toda validación en simulación deja preguntas. ¿Qué tan sensibles son los hallazgos a cambios en la distribución de agentes o a supuestos de observación parcial? ¿Cómo se comporta el selector cuando la topología cambia con el tiempo, como sucede en redes móviles o mercados con entrada y salida de participantes? ¿Qué pasa cuando el adversario no es homogéneo, sino que despliega tácticas heterogéneas sobre distintos agentes? El marco propuesto ofrece caminos para extenderse a varios de estos escenarios, pero la confirmación empírica requerirá más campañas y, sobre todo, colaboraciones con operadores reales.

También es interesante el valor comunicacional de la función de valor aprendida. Convertida en visualización, puede servir como mapa de calor de vulnerabilidad, útil para equipos técnicos y gestores no especializados. La transparencia de esa radiografía aporta un plus de gobernanza: las decisiones de priorización dejan de ser cajas negras y pasan a reposar en señales observables. Como toda métrica, exige contexto y límites: no es un juicio absoluto ni eterno, sino una fotografía bajo ciertas condiciones.

Más allá de lo técnico, identificar vulnerables en sistemas multiagente toca fibras políticas y éticas. Seleccionar puntos críticos para proteger es, en la práctica, distribuir recursos y aceptar compromisos. La herramienta puede facilitar decisiones informadas, pero no decide por nosotros qué valor priorizar cuando aparecen tensiones entre eficiencia y equidad, entre rendimiento y privacidad, entre continuidad de servicio y redundancia costosa. La buena noticia es que, al volver explícitas las fragilidades, ayuda a que esas discusiones sean más honestas y menos decorativas.

Hay otra capa: la cultura de la auditoría. Durante años, la promesa de la IA se vendió como autonomía indolora. La realidad es que la autonomía distribuye responsabilidades y, por lo tanto, necesita rastros, registros y explicaciones. VAI se inscribe en esa maduración: acepta que los sistemas fallan, que los adversarios existen y que la gestión de riesgos no es un accesorio, sino parte del diseño. En un tiempo donde la palabra confianza se usa con ligereza, no está mal volver a apoyarla en prácticas que la merezcan.

De la vulnerabilidad oculta al criterio operativo

El trabajo sobre identificación de agentes vulnerables aporta un criterio nuevo para sistemas multiagente de gran escala: detectar de manera eficiente qué piezas no pueden fallar sin consecuencias desproporcionadas. Lo hace con una construcción teórica sólida que desacopla un problema bi-nivel intratable y lo reemplaza por dos procesos aprendibles, sin perder el óptimo. En la práctica, esto habilita auditorías proactivas, priorización de defensas y visualizaciones que ponen la fragilidad sobre la mesa.

Quedan tareas: probar en dominios más diversos, incorporar estructuras de interacción más ricas, calibrar adversarios realistas y derivar recetas de mitigación acordes a cada sector. Pero el rumbo está claro. Si los sistemas que gobiernan partes esenciales de la vida contemporánea son, en mayor o menor medida, multiagente y aprendientes, conocer sus talones de Aquiles es una condición mínima para operarlos con responsabilidad. Este paper no cierra la discusión, pero ofrece una llave concreta para abrirla donde importa: en la intersección entre teoría, ingeniería y decisión pública y privada.

Referencias

Li, S., Yuwei, Z., Mao, Z., Wang, L., Xu, R., Ma, C., Yu, X., Ma, Y., Dou, Q., Wang, X., Luo, J., An, B., Yang, Y., Lv, W., & Liu, X. (2025). Vulnerable Agent Identification in Large-Scale Multi-Agent Reinforcement Learning. arXiv:2509.15103. (arXiv)

Shi, L., Gai, J., Mazumdar, E., Chi, Y., & Wierman, A. (2025). Breaking the Curse of Multiagency in Robust Multi-Agent Reinforcement Learning. ICML 2025. (icml.cc)

Du, H., et al. (2025). Scalable Safe Multi-Agent Reinforcement Learning for Multi-Unit Systems. arXiv:2501.13727. (arXiv)

Zhang, K., Yang, Z., & Başar, T. (2019). Multi-Agent Reinforcement Learning: A Selective Overview of Theories and Algorithms. arXiv:1911.10635. (arXiv)

Adjei, P. K., et al. (2025). A Graph Attention Network-Based Multi-Agent Reinforcement Learning for Vulnerability Identification in Smart Contracts. Scientific Reports. (Nature)

Jia, L., et al. (2025). Recent Advances in Multi-Agent Reinforcement Learning for Water Environmental Systems. Machines, 13(6), 503. (MDPI)

Rivas, E., et al. (2025). Multi-Agent Reinforcement Learning for Adversarial Drift in Intrusion Detection. In Proceedings of ICETE 2025. (SciTePress)

Behzadan, V., & Munir, A. (2017). Vulnerability of Deep Reinforcement Learning to Policy Induction Attacks. In ACSAC. (Discusión de adversarialidad en RL). (ACM Digital Library)

Zhang, Y., et al. (2023). Multi-Agent Reinforcement-Learning for Large-Scale Variable Speed Limits. arXiv:2310.12359. (arXiv)