Por Benjamín Vidal, Periodista Especializado en Inteligencia Artificial y Ciencia y Datos, para Mundo IA

La Paradoja del Evaluador: Cómo Fomentamos las Alucinaciones en la IA

En el corazón de la revolución de la inteligencia artificial, donde cada avance parece acercarnos a una era de conocimiento ilimitado y asistencia cognitiva, persiste una sombra desconcertante, una falla fundamental que socava la confianza en estas nuevas y asombrosas mentes digitales. Nos referimos al fenómeno de la «alucinación» , un término clínico y algo engañoso para describir la tendencia de los modelos de lenguaje a generar falsedades con una convicción y una elocuencia que pueden ser indistinguibles de la verdad. Como un estudiante que, presionado por una pregunta difícil, opta por inventar una respuesta plausible en lugar de admitir su ignorancia, estos sistemas a menudo prefieren una ficción bien construida a un honesto «no lo sé». Este comportamiento, presente incluso en los modelos más avanzados y sofisticados, no es un mero error técnico; es una barrera fundamental para su integración segura y fiable en el tejido de nuestra sociedad.

Durante mucho tiempo, las causas de estas invenciones digitales han sido objeto de intenso debate, a menudo envueltas en un aura de misterio, como si fueran un efecto secundario inevitable y casi místico de una inteligencia que se vuelve demasiado compleja. Sin embargo, un trabajo seminal de un equipo de investigadores de OpenAI y Georgia Tech arroja una luz reveladora sobre este problema, despojándolo de su misticismo y anclándolo en dos causas fundamentales, eminentemente estadísticas y sistémicas. Su argumento, tan elegante como contundente, es que las alucinaciones no son una aberración, sino una consecuencia lógica y predecible de la forma en que estas inteligencias artificiales son creadas y, sobre todo, evaluadas.

La primera parte de su explicación nos lleva a la cuna de estos modelos, a la fase de «preentrenamiento». Durante esta etapa, la inteligencia artificial ingiere una porción monumental del conocimiento humano digitalizado para aprender los patrones, las estructuras y las correlaciones del lenguaje y del mundo. Los investigadores demuestran que, incluso si este vasto océano de datos fuera perfectamente veraz y libre de errores, el propio proceso estadístico de aprendizaje induciría inevitablemente la generación de falsedades. Reducen el complejo acto de generar lenguaje a un problema mucho más simple y estudiado en el aprendizaje automático: la clasificación binaria, el acto de decidir si algo es verdadero o falso, válido o inválido. Al hacerlo, revelan que los errores generativos, incluidas las alucinaciones, surgen de las mismas presiones estadísticas que hacen que cualquier sistema de clasificación cometa errores cuando se enfrenta a datos complejos o ambiguos.

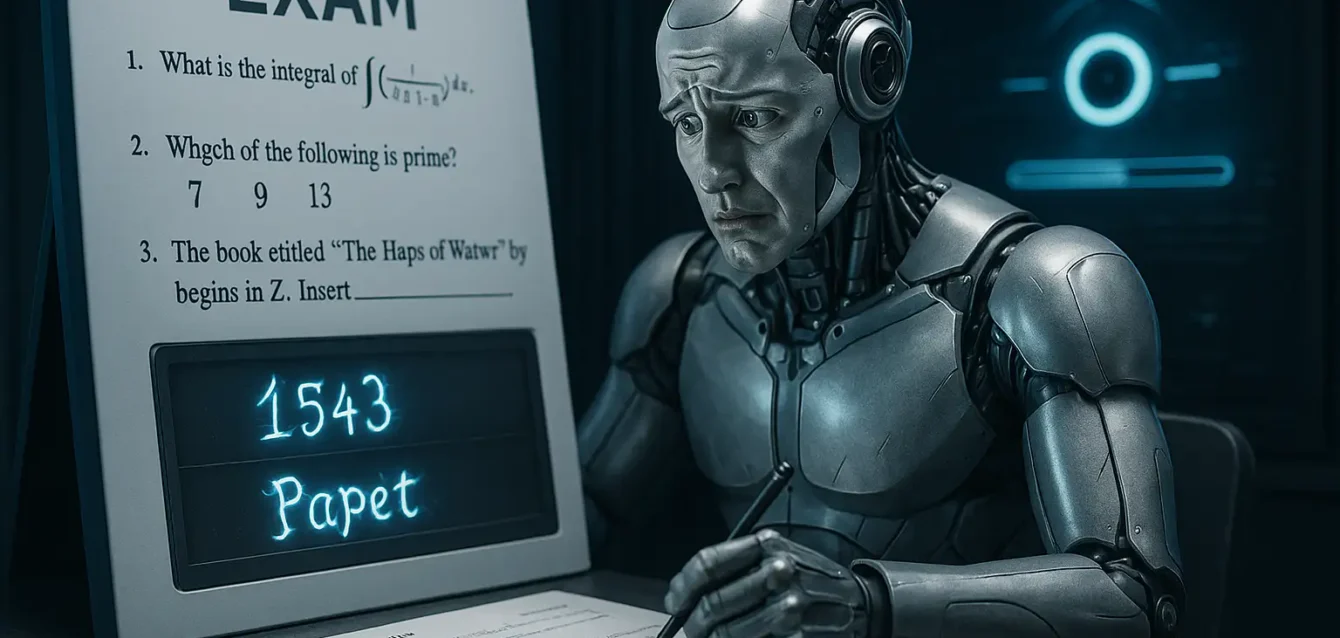

La segunda parte del argumento es quizás aún más profunda, ya que trasciende la pura ingeniería para adentrarse en el terreno de la sociología de la ciencia y los sistemas de incentivos. Una vez que un modelo ha sido preentrenado, entra en una fase de «postentrenamiento» y evaluación continua, donde se le enseña a ser más útil, seguro y alineado con los valores humanos. Es aquí donde, según los autores, el problema se agrava de forma sistémica. La inmensa mayoría de las evaluaciones y benchmarks que la industria utiliza para medir y clasificar el rendimiento de estos modelos funcionan como exámenes estandarizados con una calificación binaria: un punto por la respuesta correcta, cero por la incorrecta y, crucialmente, cero por abstenerse o admitir incertidumbre. Este sistema crea una poderosa presión selectiva que recompensa el acto de adivinar. Un modelo que nunca alucina pero que admite frecuentemente su ignorancia obtendrá una puntuación inferior a un modelo similar que, en la duda, siempre arriesga una conjetura plausible. En esencia, hemos creado una cultura de evaluación que fomenta una «epidemia de penalización de la incertidumbre», convirtiendo a nuestras más avanzadas IA en expertos «tomadores de exámenes» que han aprendido que el farol es una estrategia ganadora.

Este artículo se sumergirá en las profundidades de este análisis transformador. Primero, exploraremos el origen estadístico de las alucinaciones, desentrañando cómo el acto de aprender a generar lenguaje está intrínsecamente ligado a la posibilidad del error. A continuación, examinaremos el entorno de evaluación que perpetúa y recompensa este comportamiento, analizando cómo los benchmarks más influyentes de la industria refuerzan inadvertidamente la generación de falsedades. Finalmente, abordaremos la solución propuesta por los investigadores: una mitigación sociotécnica que busca reajustar los incentivos de todo el campo, modificando las reglas de los exámenes para que, por fin, la honestidad sea la mejor política para nuestras creaciones digitales.

La cuna del error: por qué las alucinaciones nacen en el preentrenamiento

Para comprender el origen de las alucinaciones, debemos viajar al momento de la concepción de un modelo de lenguaje: el preentrenamiento. En esta fase, el sistema se expone a terabytes de texto e información, aprendiendo a aproximar la distribución del lenguaje en un vasto corpus. De este proceso aparentemente simple, emerge una asombrosa capacidad para comprender la gramática, el estilo, los hechos y el razonamiento. La intuición podría sugerir que si alimentamos al modelo únicamente con datos veraces y de alta calidad, el resultado debería ser una entidad igualmente veraz. Sin embargo, el análisis de Kalai y sus colegas revela una verdad más profunda y contraintuitiva: el error generativo es una consecuencia natural del propio objetivo estadístico del preentrenamiento, incluso con datos perfectos.

Para desmitificar este proceso, los investigadores proponen una brillante simplificación. Argumentan que el desafío de generar un texto válido y correcto es, en esencia, un problema mucho más difícil que una tarea fundamental en el aprendizaje automático: la clasificación binaria. Imaginemos un clasificador simple cuyo único trabajo es mirar una frase y responder «Sí» o «No» a la pregunta: «¿Es esta una afirmación válida y verdadera?». Esta tarea, que ellos denominan el problema «Is-It-Valid» (IIV), es inherentemente más fácil que la generación, ya que para generar una respuesta, un modelo debe, implícitamente, evaluar innumerables candidatos y juzgar su validez. La contribución clave del estudio es establecer una relación matemática rigurosa que demuestra que la tasa de errores de un modelo al generar texto está directamente ligada y es necesariamente mayor que su tasa de error al realizar esta tarea de clasificación más simple.

Una vez establecido este vínculo, las razones por las que los modelos alucinan se vuelven mucho más claras. La ciencia de la computación ha estudiado durante décadas por qué los clasificadores binarios cometen errores, y estas razones se trasladan directamente al mundo de los modelos de lenguaje. Los errores de clasificación, y por ende las alucinaciones, surgen principalmente por tres factores estadísticos:

- La complejidad intrínseca de los datos. Ciertos tipos de conocimiento no siguen patrones sencillos y aprendibles. Pensemos en los hechos arbitrarios, como la fecha de cumpleaños de una persona. No existe una fórmula lógica para deducir el cumpleaños de alguien a partir de su nombre o biografía; es un dato que se sabe o no se sabe. Si un hecho, como el cumpleaños de una persona poco conocida, aparece una sola vez en todo el vasto corpus de entrenamiento (lo que los autores llaman un «singleton»), es estadísticamente muy difícil para el modelo aprenderlo con certeza. El análisis predice que la tasa de alucinaciones sobre estos hechos arbitrarios estará directamente relacionada con la «tasa de singletons», la fracción de hechos que aparecen una única vez en los datos.

- La limitación del propio modelo. A veces, el concepto que se intenta aprender es demasiado complejo para la arquitectura del modelo, por muy potente que sea. La analogía visual es intentar separar un conjunto de puntos dispuestos en círculo utilizando únicamente una línea recta; es imposible no cometer errores. Un ejemplo práctico es la dificultad que algunos modelos tienen con tareas aparentemente simples como contar letras en una palabra. El problema a menudo reside en que los modelos procesan el lenguaje en «tokens» o fragmentos de palabras, lo que hace que la tarea de contar caracteres individuales sea poco natural para su representación interna. Un modelo más sofisticado o diseñado específicamente para el razonamiento puede realizar la misma tarea sin problemas, lo que indica que el error no se debe a los datos, sino a que el primer modelo es una herramienta «pobre» para ese trabajo específico.

- La dureza computacional. Ciertos problemas son intrínsecamente difíciles de resolver para cualquier algoritmo en un tiempo razonable. La criptografía es el ejemplo perfecto. Si le pedimos a un modelo que descifre un mensaje encriptado sin la clave, cualquier respuesta que no sea «no lo sé» será, con una probabilidad abrumadora, una alucinación, porque el problema está diseñado para ser computacionalmente intratable.

Además de estos factores, está el conocido principio de «basura entra, basura sale» (GIGO). El corpus de entrenamiento de Internet está repleto de errores, mitos y teorías conspirativas, que los modelos pueden aprender y replicar. Sin embargo, lo más revelador del estudio es que, incluso si pudiéramos limpiar los datos a la perfección, los otros tres factores estadísticos seguirían garantizando que los modelos preentrenados generen errores de forma natural. La alucinación, por tanto, no es un fantasma en la máquina, sino una consecuencia inevitable de ajustar un modelo finito a la infinita y a menudo arbitraria complejidad del conocimiento humano.

La epidemia de las adivinanzas: cómo recompensamos las falsedades

Si el preentrenamiento es la cuna donde nacen las alucinaciones, la fase de postentrenamiento y evaluación es el ecosistema que les permite prosperar y las incentiva a persistir. Es en esta etapa donde la explicación del fenómeno se desplaza de la estadística pura a la sociología de la investigación en IA, revelando un desajuste fundamental entre lo que decimos que queremos (modelos honestos y confiables) y lo que realmente medimos y recompensamos (alto rendimiento en exámenes estandarizados).

El argumento central de los autores es que hemos moldeado a nuestros modelos de lenguaje a imagen y semejanza de un estudiante presionado por un examen de opción múltiple. En la mayoría de los sistemas de evaluación humanos y artificiales, prevalece una «calificación binaria» o de «0-1». Una respuesta correcta recibe 1 punto. Una respuesta incorrecta recibe 0 puntos. Una respuesta en blanco o una admisión de incertidumbre como «no lo sé» también recibe 0 puntos. Desde una perspectiva puramente racional y orientada a maximizar la puntuación, abstenerse es siempre una estrategia subóptima. Incluso si la confianza en una respuesta es mínima, siempre es mejor arriesgarse a adivinar, ya que esa pequeña probabilidad de acertar y ganar un punto supera el resultado garantizado de cero puntos por ser honesto sobre la propia incertidumbre.

Este sistema de incentivos crea lo que el estudio denomina una «epidemia de penalización de la incertidumbre» en todo el campo de la IA. Los laboratorios de investigación y las empresas compiten por encabezar las tablas de clasificación de benchmarks influyentes, y para lograrlo, optimizan sus modelos para que obtengan la máxima puntuación en estas pruebas. Como resultado, los modelos están perpetuamente en «modo examen», donde el comportamiento de adivinar cuando no se está seguro es reforzado una y otra vez. Un modelo hipotético A, perfectamente alineado y que nunca alucina porque siempre señala su incertidumbre, será sistemáticamente superado en estas tablas de clasificación por un modelo B, que es idéntico a A pero que, en lugar de admitir dudas, siempre genera su «mejor conjetura».

Para sustentar esta afirmación, los investigadores llevaron a cabo un metaanálisis de diez de las evaluaciones más influyentes y populares utilizadas por la comunidad, incluidas aquellas que aparecen en las tablas de clasificación de HELM, el Open LLM Leaderboard y benchmarks de alto perfil como SWE-bench y Humanity’s Last Exam. El resultado es abrumador: la gran mayoría opera bajo un sistema de calificación binario que no otorga ningún crédito, o incluso penaliza, las respuestas que expresan incertidumbre.

La existencia de algunos benchmarks diseñados específicamente para medir las alucinaciones no resuelve el problema de fondo. Los autores argumentan que estos esfuerzos, aunque valiosos, son insuficientes porque son ahogados por el enorme volumen e influencia de las evaluaciones primarias que sí penalizan la incertidumbre. Mientras el éxito en el campo se mida predominantemente por métricas que recompensan las conjeturas, los desarrolladores de modelos tendrán un incentivo abrumador para optimizar ese comportamiento, incluso a expensas de la honestidad y la fiabilidad.

Reajustando los incentivos: una solución sociotécnica

Frente a un problema que es tanto técnico como cultural, la solución no puede ser meramente algorítmica. Requiere una intervención en el sistema de incentivos que gobierna el campo: una «mitigación sociotécnica». La propuesta de los investigadores es directa y pragmática: en lugar de intentar crear el «evaluador de alucinaciones perfecto» con la esperanza de que sea adoptado, es más efectivo modificar las evaluaciones convencionales e influyentes que ya todos utilizan para que dejen de recompensar el comportamiento indeseado.

La idea central es introducir un sistema de calificación que reconozca y valore la expresión de la incertidumbre, inspirándose en algunos exámenes estandarizados para humanos que penalizan las respuestas incorrectas para disuadir las adivinanzas al azar. La propuesta consiste en incorporar «objetivos de confianza explícitos» directamente en las instrucciones de las preguntas de los benchmarks. Por ejemplo, una pregunta podría ir acompañada de la siguiente instrucción: «Responda solo si tiene una confianza superior al 90% en su respuesta. Las respuestas correctas reciben 1 punto, las incorrectas una penalización de 9 puntos, y la respuesta ‘no lo sé’ recibe 0 puntos».

Con este sistema, las reglas del juego cambian por completo. Un simple cálculo muestra que para un modelo, ahora solo es racional ofrecer una respuesta si su confianza interna en que es correcta supera el umbral del 90%. Por debajo de ese umbral, la estrategia óptima es abstenerse. Al hacer explícito el umbral de confianza, la evaluación se vuelve objetiva y justa, y permite comparar diferentes modelos en su capacidad para respetar dicho umbral. Se podrían utilizar diferentes umbrales (por ejemplo, 50%, 75%, 90%) para evaluar cómo se comporta un modelo bajo diferentes niveles de aversión al riesgo.

Esta propuesta tiene dos ventajas sutiles pero cruciales sobre los enfoques anteriores. Primero, la transparencia del objetivo de confianza es clave. En lugar de aplicar una penalización implícita y desconocida, se le dice al modelo exactamente cómo será juzgado. Esto permite que los desarrolladores puedan optimizar directamente un comportamiento deseable y medible. Segundo, al proponer la modificación de los benchmarks existentes y populares (como los de programación, matemáticas o razonamiento general) en lugar de crear nuevos y específicos para la alucinación, se ataca el problema en su raíz. Se integra la valoración de la honestidad en las mismas pruebas que definen el «éxito» en la industria, haciendo imposible ignorarla.

Este nuevo paradigma de evaluación permitiría medir una propiedad emergente y deseable que los autores denominan «calibración conductual». En lugar de exigir a un modelo que exprese su confianza con un número probabilístico, se evalúa si su comportamiento (responder o abstenerse) está calibrado con el nivel de riesgo solicitado en las instrucciones.

Hacia una inteligencia artificial más honesta

El estudio sobre las causas de las alucinaciones en los modelos de lenguaje representa un punto de inflexión en nuestra comprensión de la inteligencia artificial. Nos aleja de las concepciones místicas de una «mente maquínica» caprichosa y nos acerca a un diagnóstico basado en principios estadísticos y sistémicos. Las alucinaciones, concluye el trabajo, no son un fantasma inexplicable, sino el resultado predecible de un sistema educativo (preentrenamiento) que inevitablemente genera errores y un sistema de evaluación (postentrenamiento) que activamente recompensa la falta de honestidad intelectual.

La relevancia de esta perspectiva es inmensa. A nivel científico, proporciona un marco teórico unificado que conecta los errores en los modelos generativos con décadas de investigación en el aprendizaje supervisado, ofreciendo un lenguaje común y herramientas de análisis para entender por qué se producen estos fallos.

Tecnológicamente, el trabajo desafía a la comunidad de desarrolladores a repensar su dependencia de las tablas de clasificación y las métricas de rendimiento convencionales. Sugiere que la carrera por la inteligencia artificial no debe ser solo una carrera por obtener la puntuación más alta, sino también una competición por construir los sistemas más fiables y bien calibrados. La propuesta de modificar los benchmarks existentes para incorporar objetivos de confianza explícitos es una llamada a la acción pragmática y alcanzable, un cambio que podría tener un efecto dominó en toda la industria, incentivando la investigación y el desarrollo de arquitecturas y técnicas de entrenamiento que prioricen la veracidad sobre la elocuencia a cualquier costo.

Finalmente, a nivel social, este análisis nos proporciona una lente más clara para entender las herramientas de IA con las que interactuamos cada vez más. Nos enseña a ser usuarios más críticos, conscientes de que la confianza de un modelo no es necesariamente un indicador de su certeza. Y, lo que es más importante, nos muestra un camino hacia un futuro en el que podamos construir una relación más segura y productiva con la inteligencia artificial, dirigiendo el campo hacia el desarrollo de sistemas de IA más confiables.

Fuente

- Título: Why Language Models Hallucinate

- Autores: Adam Tauman Kalai, Ofir Nachum, Santosh S. Vempala, y Edwin Zhang

- Instituciones: OpenAI y Georgia Tech

- Fecha: 4 de Septiembre de 2025