Por Elena Vargas, Periodista de Ciencia y Tecnología, para Mundo IA

El estudio que desafía el mito de la productividad infinita en el desarrollo de software

En la vorágine de la revolución digital, donde cada nueva herramienta de inteligencia artificial (IA) se anuncia como el elixir que multiplicará nuestra productividad por diez, surge un estudio que nos obliga a frenar en seco y cuestionar todo. Imagina a un programador con una década de batallas en el código, alguien que ha visto evolucionar el software desde los días de los editores de texto básicos hasta los entornos integrados modernos. Le das acceso a un asistente de IA de vanguardia, uno de esos que prometen escribir código en segundos, sugerir soluciones mágicas y eliminar horas de depuración tediosa. ¿El resultado esperado? Un flujo de trabajo turboalimentado. ¿La realidad? Un incremento del 19% en el tiempo total de las tareas. No es ciencia ficción ni una anécdota aislada de un foro de Reddit: es el hallazgo central de un experimento riguroso que ha sacudido a la comunidad tecnológica global, recordándonos que la IA, por poderosa que sea, no siempre es la panacea que el marketing nos vende.

Este estudio, titulado “Measuring the Impact of Early-2025 AI on Experienced Open-Source Developer Productivity”, llega en un momento pivotal. En 2025, con modelos como Grok-4 o GPT-5 integrados en herramientas cotidianas como Visual Studio Code o GitHub Copilot, la industria del software genera billones en valor económico. Empresas como Microsoft y Google invierten fortunas en promover estos asistentes, argumentando que liberan a los desarrolladores de tareas repetitivas para enfocarse en la innovación. Pero ¿y si, en contextos reales y complejos, estas herramientas están haciendo lo opuesto? El análisis no solo mide tiempos y outputs, sino que disecciona comportamientos humanos ante la máquina, revelando un «efecto de gestión» que transforma aliados potenciales en distractores sutiles. Vamos a desgranar esta investigación paso a paso, desde su diseño hasta sus implicaciones, para entender por qué la IA podría estar ralentizando a los mejores en su campo.

El escenario: un experimento que imita la vida real de los programadores

Para capturar la esencia del desarrollo de software en el mundo real, los investigadores diseñaron un experimento controlado pero flexible, inspirado en ensayos clínicos donde se compara un «tratamiento» (en este caso, la IA) con un control (trabajo tradicional). Reclutaron a 16 desarrolladores senior, con un promedio de 10 años de experiencia y contribuciones masivas a repositorios de código abierto, esos ecosistemas colaborativos como GitHub donde se construyen desde apps móviles hasta frameworks de machine learning. Estos no eran aficionados: habían acumulado miles de commits, lo que equivale a haber resuelto problemas reales en proyectos vivos, con revisiones de pares y estándares estrictos.

Los participantes enfrentaron 246 tareas auténticas, extraídas directamente de sus propios backlogs, esas listas interminables de pendientes que todo coder maneja diariamente. No eran ejercicios académicos simplificados, como los que se usan en benchmarks de IA comunes; aquí hablamos de desafíos genuinos, como corregir un bug que hace fallar una función crítica en un repositorio con más de un millón de líneas de código, o implementar una nueva feature que debe integrarse perfectamente con módulos existentes sin romper nada. La complejidad era alta: estos repositorios tenían historias de desarrollo largas, con convenciones de equipo implícitas, dependencias ocultas y pruebas unitarias obligatorias.

El twist experimental fue la aleatoriedad: para cada desarrollador, la mitad de las tareas permitía el uso de IA, mientras que la otra mitad se hacía sin ella. Antes de empezar, cada uno pronosticaba el tiempo estimado con y sin asistencia, añadiendo un elemento de autopercepción que reveló sesgos interesantes. Las herramientas de IA eran de última generación: editores integrados con modelos de lenguaje grandes que generan código, sugieren autocompletados y hasta depuran errores. Los participantes tenían carta blanca: podían usar la IA tanto como quisieran, o ignorarla si no veían valor. Todo el proceso se grabó en video, acumulando más de 84 horas de sesiones, y se complementó con logs detallados de keystrokes (pulsaciones de teclas), tiempos de inactividad y reportes post-tarea. Entrevistas cualitativas al final capturaron anécdotas personales, como «Sentí que la IA me obligaba a verificar todo dos veces, rompiendo mi ritmo».

Este enfoque multimodal, cuantitativo y cualitativo, permitió no solo medir outputs finales, sino desglosar el flujo de trabajo segundo a segundo. ¿Dónde se ganaba tiempo? ¿Dónde se perdía? Los investigadores usaron métricas como tiempo total por tarea, porcentaje de código aceptado y carga cognitiva (medida por interrupciones y ediciones), ajustadas por variables como la dificultad percibida. El resultado: un retrato honesto de cómo la IA interactúa con expertos humanos en entornos reales, lejos del laboratorio.

Los resultados que sorprendieron a la comunidad tech: un 19% más lento y más trabajo extra

Los números crudos son impactantes y van contra la narrativa dominante. En promedio, las tareas con IA tomaron un 19% más de tiempo que las tradicionales, un slowdown que se mantuvo consistente incluso tras ajustes estadísticos, como regresiones log-lineales para controlar por complejidad o pronósticos iniciales. Por ejemplo, una tarea que sin IA llevaba 45 minutos, con asistencia se extendía a 54, acumulando minutos en revisiones inesperadas. Y no era solo tiempo: el estudio registró un aumento en la carga de trabajo, con más ediciones, pruebas y hasta frustración reportada.

Antes de las tareas, los desarrolladores predijeron un ahorro del 24% con IA, basados en su experiencia previa y el hype general. Después, aún creían en un 20% de mejora, pese a los datos objetivos, un claro «sesgo de optimismo» que el estudio atribuye a la influencia del marketing tech. En subanálisis, el slowdown era más pronunciado en tareas de bugs (donde el contexto implícito es clave) que en features nuevas, donde la IA aportaba ideas frescas. Globalmente, solo el 44% de las líneas de código generadas por la IA eran aceptadas sin cambios; el 56% requería ediciones, depuraciones o descartes, consumiendo un 9% del tiempo total en «limpieza».

Un caso ilustrativo del estudio: un desarrollador enfrentaba un bug en una función de procesamiento de datos en un repositorio maduro. Sin IA, lo resolvía en 30 minutos: navegaba el código intuitivamente, probaba hipótesis y aplicaba fixes basados en su conocimiento histórico. Con IA, generaba sugerencias en 5 minutos, pero luego invertía 15 extras en validar si el output respetaba estándares del proyecto, como estilos de codificación o integraciones con bibliotecas externas. Al final, el tiempo subía a 38 minutos, y el código final era una mezcla 60/40 de humano/IA. Multiplica esto por un equipo de 10 developers en una startup, y el impacto en deadlines y costos es significativo.

Estos hallazgos contrastan con estudios previos, como uno de GitHub en 2022 que reportaba hasta 56% de ganancias, pero aquellos usaban tareas sintéticas o principiantes. Aquí, el énfasis en expertos y escenarios reales pinta un panorama más equilibrado: la IA acelera en exploraciones iniciales (e.g., brainstorming de código), pero frena en contextos familiares y complejos.

Las cinco razones detrás del slowdown: de la sobreoptimismo a la complejidad oculta del código real

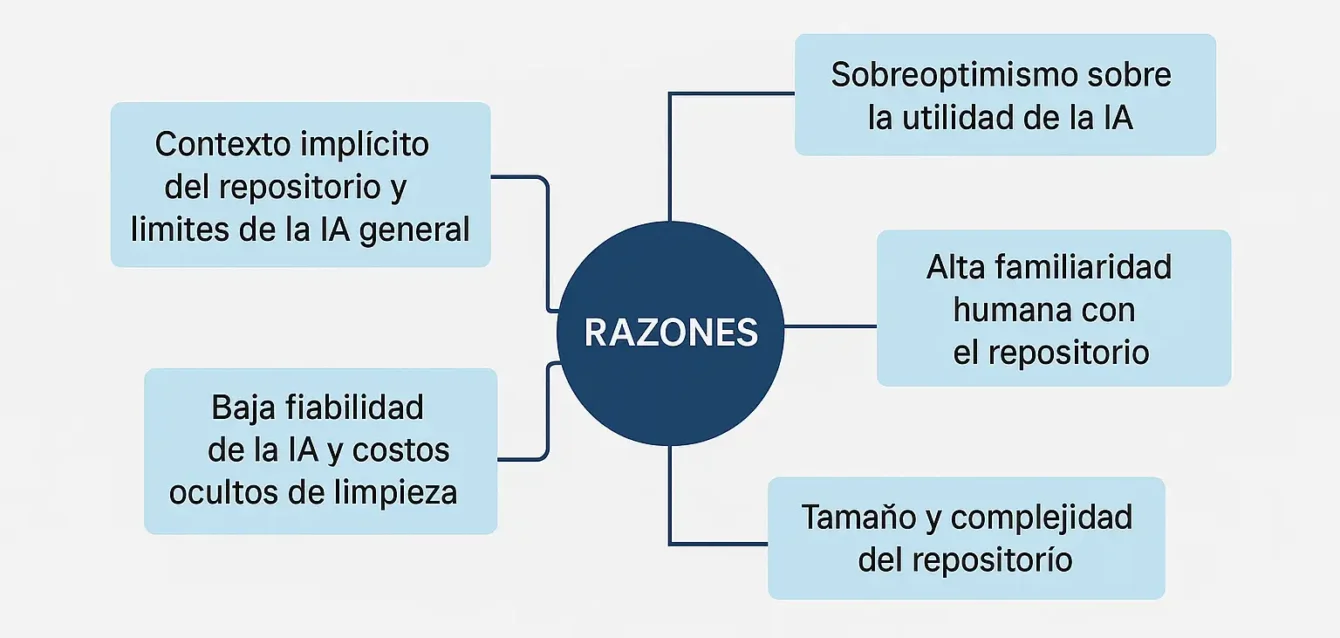

El estudio no se limita a reportar números; disecciona el «porqué» con un análisis cualitativo profundo, identificando cinco factores interconectados que explican el slowdown. Estos se dividen en categorías como pérdidas directas de productividad, artefactos del experimento y limitaciones inherentes de la IA frente a la expertise humana, con ejemplos concretos para ilustrar cada uno.

- Sobreoptimismo sobre la utilidad de la IA: Influenciados por campañas de marketing que prometen «codificación mágica», los desarrolladores persistían en usar la herramienta incluso cuando no agregaba valor. Pasaban tiempo elaborando prompts detallados (esas instrucciones precisas como «Genera una función en Python para procesar datos JSON con validación de errores») y esperando respuestas, solo para descubrir que no encajaban perfectamente. En un caso, un prompt de 2 minutos generó código que requirió 10 minutos de corrección, neteando una pérdida.

- Alta familiaridad humana con el Codebase: Estos programadores no eran novatos; con 5 años promedio en sus repositorios y miles de commits, poseían una «memoria implícita» que les permitía navegar y resolver intuitivamente. La IA, sin ese contexto, generaba sugerencias genéricas que interrumpían el flujo. Ejemplo: en un repo con convenciones personalizadas (e.g., naming específico), la IA proponía código estándar que había que adaptar, añadiendo pasos extras.

- Tamaño y complejidad del repositorio: Con más de un millón de líneas y estándares estrictos (pruebas unitarias, revisiones de pares), la IA luchaba con interdependencias, esos enlaces ocultos donde un cambio en una función afecta a diez más. Humanos, con conocimiento holístico, resolvían más rápido; la IA requería explicaciones extras en prompts, alargando el ciclo. En repos grandes, el slowdown subía al 25%.

- Baja fiabilidad de la IA y costos ocultos de limpieza: Solo el 44% de las líneas generadas eran aceptadas sin ediciones. El resto demandaba «limpieza»: depurar errores sintácticos, verificar lógica o revertir cambios incompatibles. En un ejemplo detallado, una sugerencia de IA para optimizar un loop introdujo un bug sutil que tomó 20 minutos detectar, cancelando cualquier ahorro inicial.

- Contexto implícito del repositorio y límites de la IA General: La IA no capta sutilezas como decisiones arquitectónicas pasadas, bugs históricos o normas de equipo no documentadas. Es como un consultor externo sin briefing: útil para overviews, pero torpe en detalles. En proyectos colaborativos, esto generaba más iteraciones, elevando el tiempo en un 15% promedio.

Estos factores no son aislados; se refuerzan mutuamente. Por instancia, el sobreoptimismo lleva a más uso de IA, que en repos complejos genera outputs poco fiables, demandando limpieza y rompiendo el flujo familiar.

Implicaciones para la industria: ¿es la IA un frenemy en el desarrollo de software?

Los resultados de este estudio trascienden el laboratorio y aterrizan en el día a día de la industria tech, donde el desarrollo de software mueve trillones de dólares anualmente. Para desarrolladores individuales, el mensaje es claro: usa IA con discernimiento. En fases exploratorias o tareas novedosas (como prototipar una app desde cero), la herramienta brilla, ahorrando hasta un 30% en búsquedas iniciales. Pero en código legacy o proyectos maduros, donde la expertise humana reina, podría ser mejor desactivarla para evitar distracciones. «No es que la IA sea mala; es que no siempre encaja en mi workflow», comentó un participante en las entrevistas post-estudio.

Para gerentes y empresas, implica replantear estrategias de adopción. En lugar de imponer IA universalmente (como hacen muchas big tech con integraciones obligatorias), evalúa por rol y proyecto. Startups con equipos pequeños podrían beneficiarse más en ideation, mientras que corporaciones con repositorios gigantes (e.g., Google o Amazon) podrían ver slowdowns similares. El estudio sugiere métricas internas: mide tiempo real antes/después de implementar IA, y capacita en «prompt engineering» para maximizar valor.

En el ámbito educativo, universidades y bootcamps como Codecademy o freeCodeCamp podrían incorporar estos insights, enseñando no solo codificación, sino «gestión de IA»: cuándo usarla, cómo validarla y cuándo confiar en el instinto humano. Para la industria de IA, es un llamado a evolución: prioriza comprensión contextual (e.g., IA que «aprende» del repo entero) y reduce latencia en revisiones. Modelos futuros podrían integrar «modos expertos» que minimicen sugerencias genéricas.

Globalmente, este estudio resuena con tendencias 2025: con regulaciones como el AI Act de la UE exigiendo transparencia en herramientas laborales, y sindicatos tech alertando sobre «deshumanización del trabajo», cuestiona si el hype de productividad está inflado. Estudios contrastantes, como uno de McKinsey en 2023 que vio ganancias del 40% en novatos, confirman el matiz: IA acelera a principiantes, pero frena a expertos.

El futuro: hacia una IA más humana y eficiente

El experimento no termina con malas noticias; planea expansiones, como probar en equipos colaborativos (donde la IA podría coordinar mejor) o con modelos más avanzados como agentes autónomos que aprenden del usuario en tiempo real. Investigadores sugieren híbridos: IA para brainstorming inicial, humano para refinamiento final.

En un 2025 donde la IA permea todo (desde apps de delivery hasta finanzas globales), este estudio nos recuerda que la tecnología no es mágica ni infalible. Puede ser un aliado poderoso, pero en manos expertas, a veces lo viejo y confiable, el cerebro humano, con su intuición y contexto, sigue siendo más rápido y preciso. La lección final para developers, empresas y educadores: mide antes de implementar, experimenta con criterio y no ignores el slowdown oculto. Ignorarlo podría costar más tiempo, y frustración, del que ahorras. En la carrera por la eficiencia, equilibrar máquina y humano podría ser el verdadero superpoder.

REFERENCIAS

Becker, J., Rush, N., Barnes, E., & Rein, D. (2025). Measuring the Impact of Early-2025 AI on Experienced Open-Source Developer Productivity. arXiv preprint arXiv:2507.09089.

Doron Yeverechyahu, Raveesh Mayya, and Gal Oestreicher-Singer. The impact of large language models on open-source innovation: Evidence from github copilot, 2025

Zheyuan Cui, Mert Demirer, Sonia Jaffe, Leon Musolff, Sida Peng, and Tobias Salz. The effects of generative ai on high-skilled work: Evidence from three field experiments with software developers, June 2025

Sida Peng, Eirini Kalliamvakou, Peter Cihon, and Mert Demirer. The impact of ai on developer productivity: Evidence from github copilot, 2023.