Los grandes modelos de lenguaje se han convertido en el símbolo de una época que aún estamos aprendiendo a habitar. Hablan con fluidez, resumen con solvencia, escriben código funcional y resuelven tareas con una velocidad prodigiosa. Sin embargo, cuando descendemos de la exhibición al terreno áspero de la práctica aparecen límites conocidos: razonamientos que se interrumpen, operaciones básicas que se equivocan, decisiones opacas que nadie puede auditar y una dificultad persistente para adaptarse sin rehacerlo todo desde cero. El artículo “Modular Machine Learning: An Indispensable Path towards New-Generation Large Language Models” propone una salida clara a esa tensión. Su tesis es directa y ambiciosa a la vez: la próxima generación de modelos no crecerá únicamente a fuerza de más parámetros y más datos, sino que emergerá de una arquitectura modular, capaz de separar, recombinar y razonar con piezas especializadas que colaboran entre sí. Ese cambio de enfoque, lejos de ser cosmético, toca el corazón mismo de cómo entendemos, entrenamos y desplegamos la inteligencia artificial a escala.

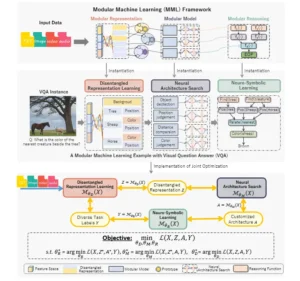

El trabajo plantea que la modularidad no es un capricho de diseño, sino una condición para alcanzar cuatro propiedades que la sociedad ya exige: explicabilidad, confiabilidad, adaptabilidad y extensibilidad. Explicabilidad para saber por qué un sistema responde lo que responde; confiabilidad para reducir errores sistémicos y aislar fallos; adaptabilidad para encarar tareas nuevas sin derribar la casa; extensibilidad para incorporar conocimiento y métodos recién aparecidos. Con ese objetivo, los autores formulan un marco unificado que descompone el problema en tres componentes interdependientes: representación modular, modelo modular y razonamiento modular. Cada pieza cumple un rol distinto y todas, en conjunto, aspiran a tender un puente entre el aprendizaje estadístico y el razonamiento formal.

Para que el lector no especializado tenga una imagen concreta, pensemos en una tarea de preguntas y respuestas visuales. El sistema recibe una imagen y una pregunta. El enfoque tradicional intentaría resolver todo con una única red, del primer píxel a la última palabra de la respuesta. La propuesta modular, en cambio, divide el problema: primero extrae factores independientes de la escena, luego selecciona una arquitectura adecuada para operar con esos factores y por último lleva a cabo un razonamiento explícito que encadena reglas simples en una conclusión. Separar no es fragmentar. Es construir una orquesta en la que cada instrumento aporta su timbre y su ritmo, y en la que el director puede cambiar una sección sin desarmar la sinfonía.

A partir de esta visión, el artículo ofrece un recorrido amplio por investigaciones relacionadas y termina delineando una implementación plausible para los tres módulos: aprendizaje de representaciones disentrelazadas para la parte de representación, búsqueda automática de arquitecturas para la parte de modelo, y aprendizaje neuro simbólico para la parte de razonamiento. El conjunto funciona como una receta general que puede adaptarse a problemas muy distintos. La clave está en la interacción entre módulos, que se optimizan de manera conjunta para que la solución final sea coherente y eficiente.

Por qué la modularidad cambia el juego

La historia de la ingeniería, desde los puentes hasta los sistemas operativos, avanza cuando aprendemos a construir con piezas. La inteligencia artificial no es la excepción. Un modelo monolítico concentra el poder, pero también la fragilidad. Si algo sale mal, no sabemos dónde. Si algo debe cambiar, hay que tocarlo todo. Si una disciplina aporta un método nuevo, no es sencillo integrarlo. La modularidad introduce separación de responsabilidades. Una pieza se ocupa de extraer información interpretable del mundo. Otra aprende a operar con esa información de manera eficiente. Una tercera procura que el resultado final siga una lógica que podamos leer y comprobar. Esa división aporta claridad conceptual y ventajas operativas que se traducen en ahorro de tiempo, reducción de costos de reentrenamiento y mejores garantías de seguridad.

En el artículo, la propuesta se condensa en tres conceptos sencillos. Primero, representar el dato de modo que sus factores principales queden separados, como quien desarma un acorde para escuchar sus notas por separado. Segundo, usar arquitecturas distintas para funciones distintas, en lugar de forzar un único bloque a cubrirlo todo. Tercero, escribir el razonamiento en una forma que pueda inspeccionarse, ya sea como reglas, como programas cortos o como cadenas de operaciones con significado. La combinación permite auditar resultados, hacer pruebas de estrés y, si algo falla, ubicar el origen con rapidez.

Taxonomía de métodos de aprendizaje automático modular.

Representación modular: separar para entender

El primer componente del marco es la representación modular. La idea es aprender descripciones del dato en las que los factores relevantes estén disentrelazados. En una imagen, por ejemplo, eso puede significar distinguir forma, color, posición y fondo, de modo que cada dimensión capture un aspecto y no una mezcla. En texto, algo análogo ocurre cuando separamos entidades, relaciones y tipos de hechos. Cuando un sistema trabaja con factores claros, gana transparencia y control. Es más fácil intervenir, corregir sesgos o incorporar una restricción externa. El artículo vincula esta línea con la tradición de aprendizaje de representaciones disentrelazadas y la sitúa como base de todo el edificio modular. Sin una buena separación, el resto se vuelve opaco.

En el ejemplo de preguntas y respuestas visuales, la representación modular actúa como filtro y organizador. A partir de la pregunta, identifica qué partes de la imagen importan, extrae objetos, segmenta regiones y compone una lista de rasgos que luego se vuelven la materia prima del proceso. En lugar de enviar a la red un torrente de píxeles, compone piezas con semántica. Ese cambio reduce el ruido y facilita la trazabilidad. Si la respuesta es incorrecta, podemos revisar qué objetos detectó o qué atributos asignó. La caja negra se aclara.

El segundo componente es el modelo modular, encargado de transformar esas representaciones en operaciones útiles. Aquí entra en escena la búsqueda automática de arquitecturas. En lugar de diseñar a mano una red para cada tarea, el sistema explora un espacio de modelos posibles y elige bloques optimizados para funciones concretas. La intuición es simple. No todo problema exige la misma herramienta. Hay submódulos que trabajan mejor con relaciones espaciales, otros que se orientan a secuencias, algunos que resuelven comparaciones y otros que cuentan o miden. La búsqueda automática permite combinar estas habilidades en un ensamblado flexible, que se adapta a la tarea sin reconstruir todo desde cero.

Esta decisión tiene un costado práctico poderoso. A medida que aparecen bloques novedosos, pueden incorporarse como candidatos en el buscador. El sistema, entonces, no deja de aprender con los datos. Aprende a escoger su propia arquitectura. Se vuelve, en cierto sentido, un artesano de sí mismo. Para industrias que necesitan desplegar modelos en contextos cambiantes, esta adaptabilidad arquitectónica abre una puerta valiosa. Permite experiencia acumulada sin pérdida de control y reduce el empuje a soluciones únicas que luego son difíciles de mantener.

El tercer componente es el razonamiento modular. Una gran parte de la crítica a los modelos actuales se concentra en su forma de razonar. Las cadenas de pensamiento pueden ser útiles, pero siguen siendo producto de un mecanismo estadístico que no garantiza coherencia. Los autores proponen integrar aprendizaje neuronal con procedimientos simbólicos. No se trata de volver atrás a los sistemas expertos, sino de aprovechar lo mejor de ambos mundos: que la red aprenda a interpretar y que un motor simbólico garantice que los pasos del razonamiento respeten reglas claras. Ese acoplamiento, conocido como neuro simbólico, permite auditar, explicar y corregir. También ayuda a detectar y mitigar sesgos, porque las reglas pueden incorporar restricciones explícitas.

Volvamos al ejemplo visual. Tras extraer factores y elegir bloques, el sistema debe responder una pregunta puntual. Para lograrlo, encadena operaciones simples. Identifica el objeto más cercano al árbol, consulta su color y produce la salida. Si el resultado es equivocado, podemos inspeccionar en qué paso falló. ¿La noción de cercanía estaba mal definida. ¿Se confundió el objeto. ¿El color fue mal identificado. La explicación ya no es un párrafo decorativo, sino un registro operativo.

La propuesta no se queda en el plano conceptual. El trabajo describe una implementación de referencia que alinea cada módulo con una técnica concreta. Para la representación, aprendizaje de factores disentrelazados. Para el modelo, búsqueda automática de arquitecturas con bloques tipo transformer adaptados a funciones. Para el razonamiento, integración neuro simbólica con reglas que guían el proceso y facilitan el control. Todo se entrena de forma coordinada con una función objetivo común que articula las tres piezas.

La elección de un ejemplo visual no es casual. En esas tareas se ven con nitidez los beneficios de separar. La escena se desarma en componentes, los módulos hacen su trabajo y las reglas conectan el resultado. Pero el alcance es más amplio. Procesamiento de documentos, análisis clínico, diagnóstico industrial, cumplimiento regulatorio o asistencia jurídica pueden beneficiarse de una caja de herramientas de este tipo. En cada dominio habrá que ajustar las piezas, pero la idea central permanece: modular para explicar, modular para adaptar, modular para extender.

Cómo se entrena un sistema con tres almas

Optimizar tres módulos distintos a la vez puede parecer un callejón complejo. El artículo propone una estrategia de entrenamiento conjunto que, en lugar de resolver cada pieza por separado, alinea la optimización para que el sistema aprenda a trabajar en equipo. La función de pérdida coordina la calidad de la representación, la elección arquitectónica y la corrección del razonamiento. La consecuencia es práctica. El sistema no solo aprende a hacerlo bien, también aprende a hacerlo de manera coherente, sin que una mejora local rompa un resultado global. Esta sintonía fina evita la tentación de pegar módulos por fuera con una integración débil.

La estrategia conjunta también permite incorporar métricas que importan fuera del laboratorio. Si un sector demanda trazabilidad, la función de pérdida puede incluir penalizaciones cuando los razonamientos se apartan de reglas aceptadas. Si otro sector exige eficiencia energética, puede introducirse un término que promueva arquitecturas de bajo consumo. La modularidad, así, se convierte en una forma de gobernanza técnica.

La discusión técnica se traduce en efectos concretos para quien opera sistemas. Un sistema modular es más auditable. Permite validar módulos por separado, someterlos a pruebas de caja blanca y reemplazarlos cuando aparecen alternativas mejores. También es más robusto. Un fallo en una pieza no arrastra de inmediato al conjunto, ya que la arquitectura favorece el aislamiento de errores y la recuperación controlada. Es más adaptable. Cambiar de tarea no exige reentrenar todo desde cero. Basta con ajustar la representación o el bloque que ejecuta la función nueva. Y es más extensible. La frontera entre investigación y producto se vuelve porosa. Un hallazgo puede incorporarse como módulo experimental sin detener la operación.

En sectores de alto impacto, estas virtudes no son lujo sino requisito. Salud, finanzas, energía, seguridad informática y administración pública necesitan sistemas que expliquen, que se dejen intervenir y que puedan certificarse. La arquitectura modular facilita auditorías, crea puntos de control y, sobre todo, vuelve visible lo que en un modelo gigantesco suele quedar escondido. En términos de confianza pública, ese cambio es significativo.

El artículo no oculta los escollos. El primero es la integración fluida entre procesos continuos, propios de las redes neuronales, y procesos discretos, propios del razonamiento simbólico. Ensamblar ambas naturalezas exige diseño cuidadoso para que la información fluya sin pérdidas ni ambigüedades. El segundo es la optimización conjunta a gran escala. Coordinar tres módulos con objetivos que a veces compiten requiere algoritmos estables y recursos de cómputo que no siempre están disponibles. El tercero es la escalabilidad. A medida que las tareas crecen y las arquitecturas se multiplican, la búsqueda del mejor ensamblado puede volverse costosa. El trabajo identifica estos puntos críticos y sugiere que la investigación deberá concentrarse en puentes cada vez más eficientes entre lo neuronal y lo simbólico, en estrategias de entrenamiento más económicas y en técnicas de selección arquitectónica que recorten el espacio de decisión sin perder calidad.

El marco MML unificado propuesto (Representación Modular, Modelo Modular y Razonamiento Modular) con una implementación factible (Aprendizaje de Representación Desenredada, Búsqueda de Arquitectura Neuronal y Aprendizaje Neurosimbólico) para resolver una tarea práctica. Para mantener la coherencia, tomamos nuevamente una tarea de respuesta visual a preguntas (VQA) como ejemplo para ilustrar la instanciación de MML. Utilizamos el ejemplo de VQA para demostrar cómo MML desenreda la entrada en componentes modulares, procesándola mediante una combinación secuencial de aprendizaje de representación desenredada, búsqueda de arquitectura neuronal y aprendizaje neurosimbólico. Específicamente, el componente de aprendizaje de representación desenredada es responsable de extraer un conjunto de características desenredadas de los datos de entrada, que posteriormente se introducen en el componente de búsqueda de arquitectura neuronal. Este componente identifica la arquitectura óptima que mejor captura las representaciones desenredadas. Posteriormente, el componente de aprendizaje neurosimbólico refina aún más el resultado mediante un razonamiento estructurado y lógico. En el ejemplo de VQA, la imagen de entrada, que contiene un árbol, un caballo y una oveja, es procesada por MML para extraer representaciones desenredadas que indican el fondo, la posición, el color, etc. Con base en estas representaciones desenredadas, MML descubre la arquitectura neuronal óptima para realizar diversas tareas, como la detección de objetos, la determinación de la posición, la comparación de distancias y la identificación de colores. Finalmente, el aprendizaje neurosimbólico integra los resultados mediante un razonamiento lógico para responder a la pregunta: «¿De qué color es la criatura más cercana al árbol?». La respuesta, «Marrón», identifica correctamente la criatura más cercana (la oveja) y su color, utilizando lógica simbólica para establecer la relación entre las entidades. Además, presentamos formalmente el proceso de optimización conjunta en la parte inferior de la figura, que implica la optimización simultánea de los tres módulos: aprendizaje de representaciones desenredadas, búsqueda de arquitectura neuronal y aprendizaje neurosimbólico. La función objetivo busca minimizar la pérdida L(X, Z, A, Y) mediante un proceso de aprendizaje integral coordinado. En concreto, los parámetros óptimos para cada módulo (θD, θM, θR) se determinan minimizando las respectivas funciones de pérdida de forma conjunta: primero optimizando el componente de aprendizaje neurosimbólico, luego el componente de búsqueda de arquitectura neuronal y, finalmente, el componente de aprendizaje de representación desenredada. Este marco de optimización conjunta permite la integración fluida de diferentes componentes modulares, logrando un proceso de aprendizaje más eficiente y eficaz, adaptable a diversas tareas.

Notaciones: L: función de pérdida (p. ej., pérdida de entropía cruzada, pérdida de MSE, etc.); X: datos de entrada; Z: representación desenredada; A: arquitectura de los módulos; Y: resultado objetivo, es decir, etiqueta; θD, θM, θR: parámetros de los módulos de representación, arquitectura y razonamiento, respectivamente.

Modularidad y sociedad: una ingeniería que abre la caja

Más allá de la matemática, la propuesta tiene una dimensión social. Si la inteligencia artificial ya interviene en la educación, el crédito, el diagnóstico médico o la asignación de recursos, necesitamos sistemas que se expliquen. La modularidad es una forma de rendición de cuentas. Permite mostrar cómo se llegó a una salida, identificar el bloque que pesa más en una decisión y probar variantes sin encender alarmas. También cambia la conversación sobre riesgos. En un modelo monolítico, los sesgos son objetos difusos. En un sistema modular, pueden rastrearse hasta una representación o una regla. Eso no los elimina, pero facilita políticas de mitigación.

La modularidad, además, abre la puerta a un ecosistema más diverso. Universidades, startups, organismos públicos y empresas pueden contribuir con módulos específicos. Un grupo de investigación puede publicar un extractor de entidades fiable para textos legales. Un hospital puede desarrollar reglas verificadas para razonamiento clínico. Una empresa puede aportar bloques eficientes para despliegue en móviles. El ensamblado permite combinar estas contribuciones sin forzar a nadie a rehacerlo todo.

Para aterrizar la propuesta en una escena cotidiana, imaginemos un asistente de documentación médica que resume historias clínicas. En el enfoque monolítico, el sistema “lee” y produce un texto. Si algo sale mal, no sabemos dónde tocó. En el enfoque modular, el proceso se divide. Un módulo extrae entidades relevantes como diagnósticos, tratamientos y fechas. Otro relaciona esas entidades con guías clínicas y valida inconsistencias. Un tercero redacta el texto final con estilo controlado y cita reglas aplicadas. Si el médico detecta un error, puede revisar el paso que lo generó. Puede sustituir el módulo de reglas por uno actualizado. Puede integrar un extractor entrenado con datos locales. Esa plasticidad cambia cómo se adoptan y se regulan estas herramientas.

La economía de la IA modular

Desde el punto de vista económico, la modularidad también importa. Entrenar y mantener modelos gigantes es caro. Si una organización solo puede crecer añadiendo capas y datos, la curva de costos se vuelve empinada. La arquitectura modular ofrece atajos. Reentrenar únicamente el extractor o el razonador permite iterar rápido y a menor costo. La búsqueda automática de arquitecturas elige bloques eficientes según las restricciones del entorno de despliegue. El razonamiento simbólico reduce al mínimo los reintentos cuando una respuesta no cumple una regla, lo que ahorra cómputo en producción. En un mundo donde los presupuestos no son infinitos y la energía cuenta, estas eficiencias marcan diferencias.

Otro frente de impacto es la interacción humano máquina. Los sistemas modulares favorecen interfaces más ricas porque pueden exponer estados intermedios con significado. Un operador puede ver los factores que la máquina usó para responder, ajustar un parámetro, bloquear una regla o solicitar una explicación alternativa. La colaboración se vuelve real. El usuario deja de ser un espectador que acepta o rechaza salidas opacas para convertirse en un supervisor que comprende el proceso. En sectores regulados, esta posibilidad se alinea con principios de auditoría y derecho a explicación que ya figuran en leyes y estándares.

Cómo medimos el progreso en un mundo modular

Los benchmarks clásicos nacieron para evaluar modelos que hacen todo a la vez. En un sistema modular, habrá que complementarlos con métricas nuevas. No bastará con la exactitud final. Necesitaremos medidas de transparencia, de trazabilidad, de facilidad de sustitución de piezas, de costo de adaptación a nuevas tareas y de cumplimiento de reglas. También habrá que medir el desempeño conjunto, porque una pieza sobresaliente puede fallar al coordinarse con las demás. Una ciencia de la evaluación modular permitirá comparar propuestas con criterio y evitar carreras que privilegian números vistosos por encima de sistemas confiables.

Posibles rutas de investigación

El panorama que abre la modularidad invita a explorar. Dos caminos, entre otros, asoman con fuerza.

- Integración profunda entre aprendizaje continuo y razonamiento simbólico. El objetivo es que las reglas no sean islotes fijos, sino que aprendan a partir de evidencia sin perder su carácter verificable.

- Selección arquitectónica guiada por objetivos sociales. La búsqueda de modelos podría priorizar explicaciones legibles, equidad entre grupos o eficiencia energética, además de precisión.

Estas rutas no se excluyen. Se refuerzan. La primera aporta plasticidad sin perder control. La segunda incorpora valores al núcleo técnico, de modo que la dirección de la innovación responda a necesidades públicas y no solo a récords en un tablero.

Quien trabaje en una organización puede preguntarse qué pasos concretos sacar de este marco. La respuesta, aunque depende del contexto, tiene una pauta común. Primero, inventariar las tareas y distinguir qué partes benefician de una representación más clara. Segundo, evaluar módulos existentes y decidir si conviene adoptarlos, adaptarlos o construirlos. Tercero, diseñar un flujo de razonamiento explícito, aunque sea simple, y someterlo a revisión. Cuarto, establecer métricas que no se limiten a la exactitud, sino que midan transparencia, estabilidad y costo de mantenimiento. Por último, adoptar una política de actualización gradual, que permita introducir mejoras módulo por módulo, sin rediseños bruscos.

El artículo acompaña su propuesta con ejemplos que ilustran los beneficios de la arquitectura modular, como el caso de preguntas visuales donde el sistema logra un resultado que el enfoque monolítico no consigue. Esa evidencia sugiere que la modularidad encaja mejor con tareas que requieren pasos diferenciados y reglas claras. Hacia adelante, será valioso ver más casos en dominios textuales complejos, donde el razonamiento jurídico, clínico o científico reclama fuentes, trazabilidad y cumplimiento de normas. En todos esos frentes, la promesa de la modularidad es especialmente atractiva: explica, corrige y extiende sin comenzar de cero.

Un puente necesario entre estadística y razón

El debate sobre el futuro de los grandes modelos no es un concurso de tamaños, sino una conversación sobre arquitectura. El trabajo analizado defiende una posición nítida. La modularidad no es un accesorio, es el camino para que los modelos sean explicables, confiables, adaptables y extensibles. Separar no es dividir. Es organizar. Es preparar a los sistemas para un mundo que cambia rápido y que exige responsabilidad. La propuesta de representación modular, modelo modular y razonamiento modular ofrece un mapa que cualquiera puede seguir, desde la investigación hasta la empresa, desde la administración pública hasta la sociedad civil.

Hay una promesa y hay un compromiso. La promesa es una inteligencia artificial que se pueda comprender y gobernar. El compromiso es desarrollar técnicas que hagan practicable esta visión a gran escala, con eficiencia y sin sacrificar rendimiento. Si lo logramos, los grandes modelos dejarán de ser cajas mágicas y se convertirán en infraestructuras de conocimiento que podemos auditar, reconfigurar y ampliar. Eso no solo es deseable. Es imprescindible para convivir con sistemas que ya influyen en decisiones que importan. La ingeniería modular, tal como la describe el artículo, se perfila como el puente más sólido entre el aprendizaje estadístico y el razonamiento que la vida cotidiana necesita.

Referencias

Wang, X., Li, H., Chen, H., Zhang, Z., & Zhu, W. (2025). Modular Machine Learning: An Indispensable Path towards New-Generation Large Language Models. arXiv:2504.20020. (arXiv)

Selección de material complementario: revisión de representaciones disentrelazadas, búsqueda automática de arquitecturas y aprendizaje neuro simbólico, y figuras del marco unificado de MML. (arXiv)