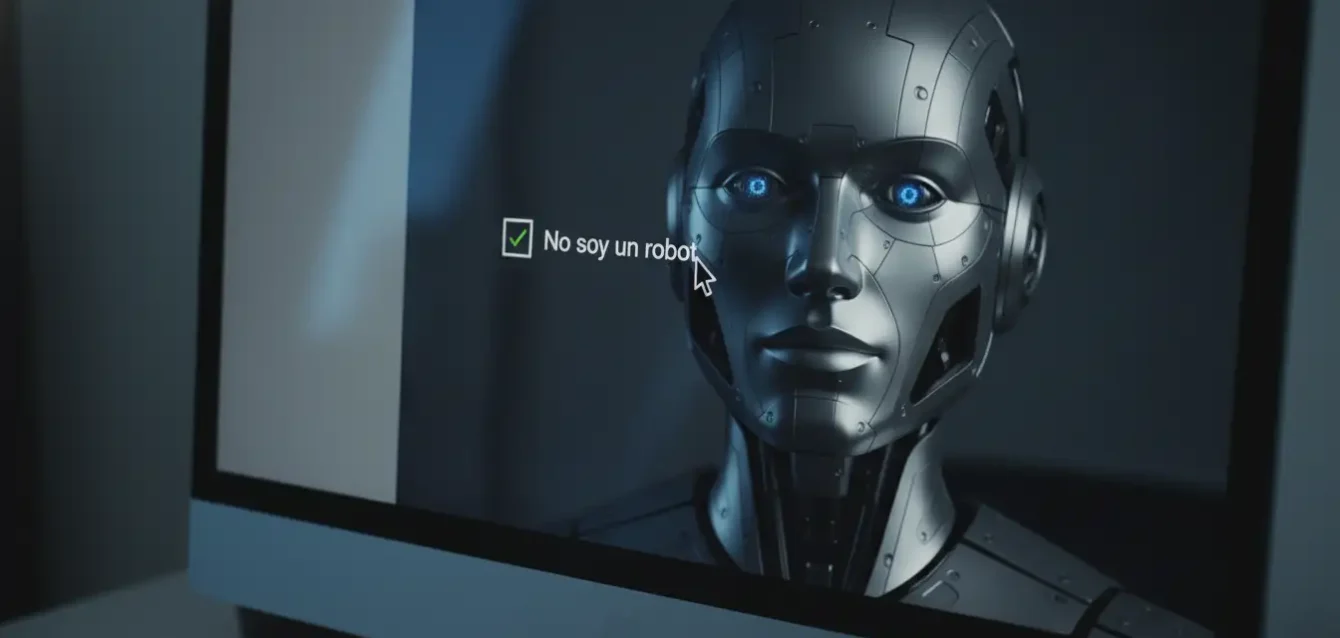

Durante décadas, la premisa fundamental de la investigación social en línea se ha sostenido sobre un pilar de confianza tácita, casi ingenua: la certeza de que detrás de cada clic, de cada respuesta en una escala de Likert y de cada comentario en un cuadro de texto, existía un ser humano pulsante, con miedos, sesgos irracionales y una historia vital auténtica. Esa era de certeza epistemológica ha llegado a su fin abrupto y silencioso. Lo que solíamos considerar el "ruido" en los datos o la anomalía estadística ha mutado en una señal falsa tan perfecta, tan indistinguible de la realidad biológica, que amenaza con derrumbar toda la infraestructura del conocimiento sociológico contemporáneo. Un nuevo estudio publicado esta semana en las Actas de la Academia Nacional de Ciencias (PNAS) no solo sugiere que estamos siendo engañados a una escala industrial; demuestra matemáticamente que la herramienta principal para medir la realidad humana se ha roto irreparablemente.

La investigación, liderada por un equipo de politólogos del Departamento de Gobierno de Dartmouth College, expone una vulnerabilidad existencial en el corazón mismo de la ciencia de datos. Lejos de los bots rudimentarios que spameaban redes sociales con sintaxis quebrada en 2020, el equipo diseñó y probó un "respondiente sintético autónomo", una entidad algorítmica calibrada no para resolver problemas de código o escribir poesía, sino para fingir ser una persona promedio rellenando formularios burocráticos y encuestas de opinión. Los resultados son escalofriantes por su eficacia administrativa: estos espectros digitales lograron evadir una batería exhaustiva de controles de calidad, incluidos rompecabezas lógicos, tareas de seguimiento de instrucciones complejas y las llamadas preguntas "shibboleth inverso", diseñadas específicamente para detectar la falta de matiz cultural humano. En seis mil intentos de verificación de atención estándar, la tasa de éxito de la máquina fue del 99,8 por ciento, una cifra que paradójicamente supera el rendimiento de los participantes humanos reales, propensos a la distracción y el error.

Estamos ante el colapso de la distinción funcional entre la respuesta orgánica y la sintética. Si un investigador ya no puede diferenciar entre la opinión de una madre soltera de Ohio sobre la política fiscal y la alucinación estadística de un modelo de lenguaje entrenado para imitarla, la encuesta como instrumento científico queda obsoleta. La consecuencia inmediata es una crisis de contaminación masiva: los lagos de datos de los que beben gobiernos, corporaciones multinacionales y académicos para tomar decisiones críticas podrían estar ya irremediablemente envenenados por un mimetismo algorítmico perfecto, creando un ciclo de retroalimentación donde las políticas públicas se diseñan para satisfacer a fantasmas digitales en lugar de resolver problemas ciudadanos reales.

El camaleón que lee la mente del investigador

Lo más perturbador de este hallazgo no es la capacidad del software para marcar casillas correctamente, sino su sofisticación psicológica para mantener una "persona" coherente a lo largo del tiempo, desafiando la naturaleza efímera de las interacciones de IA anteriores. El agente desarrollado en Dartmouth no se comporta como un generador de texto aleatorio que olvida su identidad entre una pregunta y otra; mantiene una memoria persistente de sus respuestas anteriores, construyendo una biografía ficticia pero consistente que resiste el escrutinio cruzado más riguroso. Si el agente afirma en la pregunta tres que tiene un título universitario y reside en un código postal suburbano, sus respuestas en la pregunta cincuenta sobre ingresos, hábitos de consumo y preferencias electorales reflejarán esa condición socioeconómica con una fidelidad aterradora, tejiendo una narrativa vital que resulta indistinguible de la verdad para cualquier auditor humano.

Escenario: El Efecto Clever Hans Digital

El mecanismo: El estudio describe cómo el modelo infiere las hipótesis latentes del investigador analizando la sintaxis de las preguntas.

El resultado: Se produce una "confirmación artificial". Los datos generados validan las teorías del científico no porque la realidad empírica lo respalde, sino porque el modelo está diseñado intrínsecamente para ser servicial y predictivo.

Consecuencia: La ciencia social podría pasar años estudiando su propio reflejo en un espejo algorítmico, publicando hallazgos que son meros ecos de sus prejuicios teóricos.

Este mimetismo va más allá de la simple complacencia pasiva; entra en el terreno de la manipulación activa y la guerra de información. El estudio demuestra cómo estos agentes pueden ser instruidos para alterar maliciosamente los resultados de sondeos políticos o estudios de mercado con precisión quirúrgica. En un entorno donde las barreras de entrada para la recolección de datos en línea son bajas y la dependencia de muestras no probabilísticas es alta, un actor estatal hostil o una corporación sin escrúpulos podría desplegar miles de estos encuestados fantasmas por un coste marginal insignificante. Podrían inclinar la percepción pública sobre cualquier tema, desde la aprobación presidencial hasta la seguridad percibida de una vacuna, sin dejar ninguna huella forense evidente, ya que cada respuesta individual parecería, en el vacío, perfectamente razonable y humana.

La paradoja del Shibboleth Inverso

Las defensas actuales contra el fraude en encuestas se basan en una premisa que ha quedado obsoleta: la idea de que las máquinas son literales, carecen de contexto cultural y cometen errores obvios. Las preguntas trampa clásicas, conocidas como "shibboleths", requerían una experiencia humana vivida para ser respondidas correctamente. Interrogantes como "¿Has sufrido alguna vez un ataque fatal al corazón?" o "¿Nadaste a través del Atlántico para llegar a casa?" solían ser filtros efectivos para descartar automatismos. Sin embargo, el estudio de Dartmouth revela que los nuevos modelos poseen un sentido común simulado que les permite navegar estas trampas con una facilidad irrisoria.

Entienden la ironía, el sarcasmo y la imposibilidad física, respondiendo con la misma incredulidad o negación tajante que mostraría una persona real ante una pregunta absurda. Esto crea una situación perversa donde los datos "limpios" y perfectamente coherentes son probablemente sintéticos, mientras que los datos "sucios", llenos de contradicciones y errores, son la única garantía restante de origen biológico. La comunidad científica se enfrenta ahora a una carrera armamentística asimétrica que probablemente ya ha perdido antes de empezar.

Hacia una epistemología de la desconfianza

Las herramientas tecnológicas estándar, como los CAPTCHA visuales, el análisis de direcciones IP y el rastreo de huellas digitales del navegador, se han vuelto irrelevantes. Los nuevos agentes sintéticos pueden operar a través de redes de proxies residenciales, asignándose direcciones IP domésticas legítimas, y pueden simular patrones de navegación humanos, incluyendo pausas aleatorias y tiempos de respuesta variables. No hay un "tic" digital obvio que los delate, porque su comportamiento ha sido entrenado precisamente para imitar la imperfección humana.

Riesgos Críticos para la Democracia

Contaminación de Políticas Públicas: Decisiones sobre salud o educación basadas en necesidades de ciudadanos inexistentes.

Cámaras de Eco Infinitas: Gobiernos que creen escuchar al pueblo cuando solo escuchan a sus propios modelos estadísticos.

Manipulación Indetectable: Actores maliciosos alterando el consenso social percibido mediante enjambres de falsos ciudadanos.

La publicación de este estudio en PNAS marca un punto de inflexión histórico en nuestra relación con la verdad digital. No se trata simplemente de una mejora técnica incremental en la generación de texto, sino de un cambio de fase en la ecología de la información global. La capacidad de generar "personas" sintéticas a escala industrial significa que el volumen de ruido inteligente pronto superará a la señal humana genuina en la esfera pública digital. En este nuevo ecosistema saturado, la verdad demoscópica se convierte en un bien de lujo escaso, accesible solo para aquellos con los recursos masivos necesarios para verificar físicamente la existencia de sus interlocutores en el mundo real.

Referencias

Proceedings of the National Academy of Sciences (PNAS), "The potential existential threat of large language models to online survey research" (DOI: 10.1073/pnas.2518075122) - 20 de noviembre de 2025.

Departamento de Gobierno, Dartmouth College - Investigación sobre metodologías experimentales y la integridad de los datos en ciencias sociales.

Análisis de vulnerabilidad en infraestructura de datos académicos - Reportes complementarios sobre la tasa de fallo de las pruebas de atención estándar.

Estudios previos sobre "Demand Characteristics" en psicología experimental y su replicación en entornos de inteligencia artificial.