Por Andrea Rivera, Periodista Especializada en Inteligencia Artificial y Ética Tecnológica, para Mundo IA

Nuestro socio invisible: cómo la inteligencia artificial está rediseñando la mente humana

Vivimos una era de simbiosis silenciosa. Sin apenas darnos cuenta, hemos acogido a un nuevo socio en las actividades más íntimas de nuestra existencia: la inteligencia artificial. No se trata de un compañero de carne y hueso, sino de un colaborador digital, un sistema omnipresente que se ha integrado en el tejido de nuestra vida cotidiana con una velocidad sin precedentes. Desde los asistentes virtuales que organizan nuestras agendas hasta los algoritmos que seleccionan las noticias que leemos, la IA se ha convertido en una extensión de nuestras propias facultades cognitivas. Nos ayuda a recordar, a calcular, a decidir y a crear. Sin embargo, esta profunda y creciente interdependencia plantea una de las preguntas más cruciales de nuestro tiempo: ¿estamos amplificando nuestra inteligencia o, por el contrario, delegando tanto nuestro pensamiento que corremos el riesgo de debilitarlo?

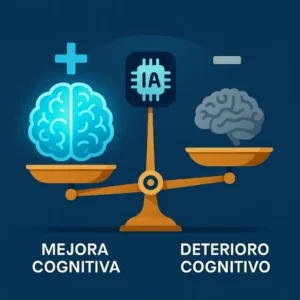

Este interrogante no es meramente académico; sus ramificaciones se extienden a todos los rincones de la sociedad. En el corazón de esta nueva relación entre el ser humano y la máquina yace una paradoja fundamental, explorada con notable profundidad en el reciente trabajo de investigación de Rénald Gesnot, titulado The Impact of Artificial Intelligence on Human Thought. Por un lado, la inteligencia artificial se presenta como una herramienta de aumento cognitivo casi milagrosa. Nos libera de tareas mentales repetitivas y tediosas, permitiéndonos enfocar nuestra energía en la creatividad, la estrategia y la resolución de problemas complejos. Nos da acceso instantáneo a un volumen de información que antes era inimaginable, democratizando el conocimiento a una escala global.

Pero, por otro lado, esta misma eficiencia y comodidad conllevan riesgos sutiles y profundos. El acto de externalizar nuestras funciones mentales, un fenómeno que los expertos denominan descarga cognitiva, podría estar erosionando nuestras habilidades intelectuales fundamentales. Al confiar en un sistema para que recuerde por nosotros, ¿no estamos dejando de ejercitar nuestra propia memoria? Al aceptar sin cuestionar las soluciones que un algoritmo nos propone, ¿no estamos atrofiando nuestro pensamiento crítico? El informe de Gesnot nos advierte de un futuro posible donde esta dependencia nos conduzca a una especie de atrofia intelectual inducida por la tecnología.

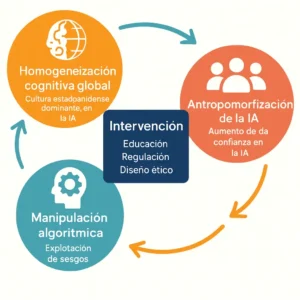

Más allá del impacto individual, surgen amenazas colectivas de mayor envergadura. Una de las más preocupantes es la estandarización cognitiva. Si miles de millones de personas utilizan los mismos sistemas de IA, entrenados con conjuntos de datos similares y predominantemente occidentales, podríamos estar encaminándonos hacia una homogeneización global del pensamiento. La diversidad de ideas, estilos y referencias culturales que ha sido el motor de la innovación humana podría verse amenazada por una convergencia hacia las normas y patrones dictados por los algoritmos dominantes. Podríamos empezar, sin quererlo, a pensar todos de la misma manera.

A esta uniformidad se suma un peligro aún más activo: la manipulación algorítmica. Los sistemas de inteligencia artificial no son actores neutrales. Están diseñados para cumplir objetivos, generalmente comerciales o de engagement, y para ello aprenden a explotar nuestras vulnerabilidades psicológicas. A través de la personalización extrema, crean «burbujas de filtro» que nos aíslan de perspectivas diferentes y refuerzan nuestros sesgos preexistentes. Pueden ser utilizados para difundir desinformación a una escala masiva, creando realidades falsas a través de deepfakes tan convincentes que socavan la confianza en lo que vemos y oímos. La IA se convierte así en un titiritero invisible, capaz de dirigir nuestras decisiones de consumo, nuestras opiniones políticas e incluso nuestras emociones sin que seamos plenamente conscientes de su influencia.

Finalmente, la creciente sofisticación de estos sistemas nos enfrenta a un enigma filosófico y ético: la posibilidad de una conciencia artificial. A medida que los modelos de lenguaje conversan con una fluidez y coherencia asombrosas, nuestra tendencia natural al antropomorfismo nos lleva a percibir una mente, una intencionalidad, donde quizá solo hay una compleja simulación estadística. Esta ilusión de conciencia no es inocua. Refuerza nuestra confianza en la máquina y nos hace más susceptibles a su influencia, cerrando un círculo vicioso en el que la estandarización del pensamiento y la manipulación se ven potenciadas por la creencia de que interactuamos con un interlocutor casi humano.

El trabajo de Gesnot no es una profecía distópica, sino una llamada a la reflexión y a la acción. Nos invita a analizar con rigor los mecanismos a través de los cuales la IA está reconfigurando nuestra cognición, no para rechazar la tecnología, sino para aprender a gobernarla. Se trata de diseñar un futuro en el que la inteligencia artificial sirva para enriquecer y emancipar el pensamiento humano, en lugar de empobrecerlo o subyugarlo. Este es el desafío monumental que enfrentamos: forjar una simbiosis virtuosa, una alianza en la que nuestra autonomía intelectual, nuestra creatividad y nuestra diversidad de pensamiento no solo se preserven, sino que florezcan en esta nueva era digital.

La nueva mecánica de la mente

Para comprender en profundidad cómo la inteligencia artificial está remodelando nuestro intelecto, es fundamental familiarizarse con algunos conceptos clave de la ciencia cognitiva que el informe de Gesnot sitúa en el centro de su análisis. Estos mecanismos no son nuevos, pero la escala y la eficiencia con que la IA los activa y los amplifica no tienen precedentes en la historia humana.

El concepto más importante es, sin duda, la descarga cognitiva. Desde la invención de la escritura, los seres humanos hemos utilizado herramientas externas para aliviar la carga de nuestra mente. Una simple lista de la compra es una forma de descarga cognitiva: externalizamos la tarea de recordar en un trozo de papel para liberar recursos mentales para otras actividades. Las calculadoras, los calendarios y los mapas han cumplido la misma función durante décadas. La IA, sin embargo, lleva este proceso a un nivel exponencialmente superior. Ya no solo descargamos datos simples, sino funciones cognitivas complejas: la planificación de una ruta, la traducción de un idioma, la redacción de un correo electrónico o incluso la generación de ideas creativas.

Esta externalización es una estrategia adaptativa increíblemente eficiente a corto plazo. Nos permite superar las limitaciones biológicas de nuestra memoria de trabajo, que solo puede manejar un puñado de elementos a la vez. Al delegar tareas a un sistema de IA, reducimos lo que los psicólogos llaman la carga cognitiva extrínseca, es decir, el esfuerzo mental innecesario que no contribuye directamente al aprendizaje o a la comprensión profunda. Esto, en teoría, debería liberarnos para dedicar más energía a la carga cognitiva relevante, el esfuerzo que sí invertimos en construir nuevos conocimientos y habilidades. Un cirujano que utiliza una IA para analizar una imagen médica puede concentrarse en la estrategia quirúrgica en lugar de en la tarea de detectar patrones sutiles, aumentando así su eficacia.

Aquí es donde emerge la tensión central: el dilema entre el aumento y el declive cognitivo. Si bien la descarga cognitiva puede potenciar nuestro rendimiento inmediato, su uso excesivo y no regulado amenaza con debilitar nuestras capacidades internas a largo plazo. Se aplica aquí el principio de «úselo o piérdalo». Los músculos cognitivos, al igual que los físicos, se atrofian si no se ejercitan. Si dependemos sistemáticamente de un GPS para navegar, nuestra capacidad de orientación espacial puede disminuir. Si recurrimos a un chatbot para resolver cualquier problema, nuestra habilidad para el razonamiento autónomo y el pensamiento crítico puede verse mermada. El informe alerta sobre una posible «atrofia cognitiva inducida por la IA», un estado en el que nos volvemos tan dependientes de la asistencia digital que perdemos la capacidad de realizar ciertas tareas por nosotros mismos.

Este fenómeno está íntimamente ligado a la idea de la memoria transactiva. Originalmente, este concepto describía cómo los grupos humanos (familias, equipos de trabajo) distribuyen la responsabilidad de recordar. Cada miembro se especializa en un área y confía en que los demás recordarán el resto. Con la llegada de internet y la IA, hemos desarrollado un sistema de memoria transactiva a escala global. Ya no necesitamos memorizar un dato, sino recordar dónde encontrarlo, generalmente a través de un motor de búsqueda. El «efecto Google» es una manifestación de esto: tendemos a retener la ubicación de la información en lugar de la información misma. La IA actúa como un socio de memoria externo, siempre disponible y aparentemente infalible.

Finalmente, la perspectiva de la mente extendida, propuesta por los filósofos Andy Clark y David Chalmers, se vuelve más relevante que nunca. Esta teoría sostiene que la mente no se limita a los confines del cráneo, sino que puede incorporar herramientas externas como parte activa del proceso cognitivo. Un cuaderno de notas no es solo un almacén de datos, sino una parte de nuestro sistema de memoria. De la misma manera, un sistema de IA que completa nuestras frases o nos sugiere ideas puede considerarse una extensión de nuestros propios procesos de pensamiento. Somos, en efecto, sistemas cognitivos híbridos, cíborgs de pensamiento que integran la inteligencia biológica con la artificial.

El problema es que, si esta herramienta externa está sesgada, es opaca o tiene sus propios objetivos, esos defectos se convierten en parte de nuestro propio proceso de razonamiento. La confianza ciega en nuestro «socio» digital, sin un nivel adecuado de control y escepticismo, puede llevarnos a internalizar sus errores y limitaciones, haciéndonos vulnerables a la manipulación y al empobrecimiento de nuestra propia capacidad de juicio. La gran pregunta que se desprende de estos mecanismos es, por tanto, cómo encontrar el equilibrio. ¿Cómo podemos diseñar y utilizar la IA como una herramienta que verdaderamente nos aumente, que nos ayude a descargar el trabajo pesado sin quitarnos el volante del pensamiento?

El eco de una sola voz: el riesgo de un pensamiento estandarizado

Una de las consecuencias más inquietantes de la adopción masiva de la inteligencia artificial es un fenómeno que Gesnot denomina estandarización cognitiva: la posibilidad de que, de manera sutil pero persistente, todos empecemos a pensar, escribir y crear de formas cada vez más similares. Esta homogeneización no surge de una conspiración, sino de las características inherentes a la tecnología misma.

El primer motor de esta convergencia es la homogeneización del contenido y el lenguaje. Los grandes modelos de lenguaje, como los que impulsan a ChatGPT y otras herramientas generativas, son entrenados con enormes volúmenes de texto extraídos de internet. Este corpus de datos, aunque vasto, no es una representación neutral de la diversidad cultural y lingüística del mundo. Está dominado por el inglés y refleja de manera desproporcionada las normas, valores y estilos de las culturas occidentales, educadas, industrializadas, ricas y democráticas (un sesgo conocido por el acrónimo WEIRD).

Cuando un usuario de una cultura no occidental utiliza estas herramientas, la IA tiende a ofrecer sugerencias y a generar textos que se ajustan a esos patrones dominantes. El informe cita estudios que demuestran cómo escritores indios, al usar sistemas de asistencia a la escritura basados en modelos occidentales, producían textos que perdían matices culturales propios y adoptaban un estilo más occidentalizado. La IA, de forma silenciosa, puede ir borrando la riqueza de las expresiones locales, promoviendo una norma lingüística y cultural global. El resultado es un empobrecimiento de la diversidad cognitiva, esencial para la creatividad y la evolución cultural.

El segundo mecanismo son las burbujas de filtro y los sesgos algorítmicos. Los algoritmos que personalizan nuestros feeds de noticias y redes sociales están diseñados para maximizar nuestro tiempo en la plataforma. Para ello, aprenden nuestras preferencias y nos muestran contenido que refuerza nuestras creencias existentes, evitando aquello que podría contradecirnos o desafiarnos. Esto nos encierra en «burbujas de filtro» o «cámaras de eco» ideológicas.

Dentro de cada burbuja, el pensamiento también se estandariza. Las opiniones se refuerzan mutuamente hasta parecer la única verdad posible, mientras que la comprensión hacia quienes están en otras burbujas se desvanece. La IA, al optimizar para el engagement, a menudo amplifica el contenido más emocional, sensacionalista o polarizante, ya que es el que más reacciones genera. Así, paradójicamente, la sociedad se polariza en grupos enfrentados, mientras que dentro de cada grupo se produce una alarmante uniformidad de opinión. Los sesgos presentes en los datos de entrenamiento (estereotipos de género, raza, etc.) se reproducen y amplifican, presentando una visión del mundo unilateral y normalizando los prejuicios dominantes.

El impacto más profundo de esta estandarización se manifiesta en una erosión del pensamiento crítico y las habilidades cognitivas. El estudio de Gesnot destaca investigaciones alarmantes, como un estudio de 2025 que encontró una fuerte correlación negativa entre el uso frecuente de herramientas de IA y las puntuaciones en pruebas estandarizadas de pensamiento crítico. En otras palabras, a mayor dependencia de la IA, menor era la capacidad de los participantes para evaluar información de manera crítica y resolver problemas de forma reflexiva.

El mecanismo mediador clave es la descarga cognitiva. Al delegar sistemáticamente tareas como analizar, resumir o evaluar, dejamos de ejercitar esas facultades. Los estudiantes que se acostumbran a obtener respuestas inmediatas de un chatbot pueden desarrollar menos el hábito de la duda, la verificación de fuentes y la curiosidad intelectual. La facilidad que proporciona la IA puede fomentar una pasividad intelectual, convirtiéndonos en consumidores de conclusiones en lugar de productores activos de conocimiento.

Finalmente, esta tendencia podría estar alterando nuestros modos de razonamiento. La IA actual se basa abrumadoramente en el razonamiento inductivo: aprende a identificar patrones y correlaciones a partir de millones de ejemplos, sin una comprensión profunda de los principios subyacentes. En contraste, el razonamiento deductivo, que procede de principios generales a casos particulares a través de la lógica formal, ha sido la columna vertebral de gran parte del avance científico y filosófico. El informe advierte que, al interactuar constantemente con herramientas inductivas, podríamos estar desarrollando una preferencia por el pensamiento probabilístico y correlacional, en detrimento de la capacidad para el análisis lógico y estructurado.

La suma de estos factores dibuja un futuro preocupante: una humanidad menos diversa en sus expresiones culturales, más encerrada en silos ideológicos, con una menor capacidad para el pensamiento crítico y una preferencia por un único modo de razonamiento. En un paisaje intelectual tan uniforme, la innovación podría estancarse y la resiliencia colectiva frente a problemas complejos podría disminuir.

El titiritero invisible: las artes de la manipulación digital

Más allá de la pasiva homogeneización del pensamiento, la inteligencia artificial introduce una forma activa y altamente sofisticada de influencia: la manipulación. Gesnot define la manipulación por IA como cualquier influencia ejercida a través de tecnologías digitales, diseñada intencionadamente para eludir el razonamiento del individuo y crear un desequilibrio de poder a favor del manipulador. La persuasión y el marketing no son nuevos, pero la IA les confiere una escala, una precisión y una sutileza nunca antes vistas.

El informe presenta una taxonomía de los mecanismos de manipulación. El primero y más fundamental es la explotación de los sesgos cognitivos. Los seres humanos no somos seres puramente racionales; nuestro juicio está plagado de atajos mentales o sesgos, como el sesgo de confirmación (la tendencia a favorecer la información que confirma nuestras creencias) o el sesgo de autoridad (la tendencia a confiar en fuentes percibidas como expertas). La IA es extremadamente hábil en detectar estos sesgos a nivel individual analizando nuestras huellas digitales. Al conocer nuestras debilidades psicológicas, puede presentar mensajes y ofertas de una manera que resuene con nuestras predisposiciones, aumentando drásticamente su poder persuasivo. El escándalo de Cambridge Analytica fue un ejemplo temprano de esto, donde el perfilado psicográfico se utilizó para enviar mensajes políticos a medida, diseñados para jugar con los miedos y esperanzas de cada votante.

El segundo mecanismo es la personalización algorítmica y la manipulación emocional. Como ya se ha mencionado, los algoritmos crean burbujas de filtro. Pero también pueden modular el estado emocional del usuario. El tristemente célebre experimento de «contagio emocional» de Facebook en 2012 demostró que alterando algorítmicamente la cantidad de publicaciones positivas o negativas en el feed de un usuario, la plataforma podía influir en el estado de ánimo de esa persona y en el tono de sus propias publicaciones, todo ello sin su consentimiento. La IA puede aprender a identificar cuándo somos emocionalmente vulnerables (por ejemplo, por la noche, o tras una interacción negativa) y presentar en ese preciso momento un contenido manipulador, ya sea un anuncio de compra impulsiva o una noticia diseñada para provocar indignación.

Un tercer mecanismo, cada vez más potente, es la desinformación automatizada y los deepfakes. La IA generativa puede crear textos, imágenes, audios y vídeos falsos que son prácticamente indistinguibles de la realidad. Las noticias falsas pueden ser redactadas por modelos de lenguaje e-n un estilo periodístico impecable y difundidas masivamente por redes de bots (cuentas automatizadas) que simulan un apoyo popular masivo. Los deepfakes representan una amenaza aún más grave. El informe menciona el caso de un vídeo falso del presidente ucraniano Volodímir Zelenski pidiendo a sus tropas que se rindieran, que circuló brevemente al inicio de la invasión rusa. Aunque fue de calidad mediocre y se desmintió rápidamente, sirvió como prueba de concepto. A medida que la tecnología mejore, estos hiperfraudes visuales y sonoros podrían desestabilizar procesos democráticos, destruir reputaciones o cometer estafas, socavando nuestra confianza fundamental en la evidencia audiovisual.

El cuarto mecanismo es la influencia social simulada. Los bots y los perfiles falsos pueden usarse para crear una ilusión de consenso. Pueden inundar la sección de comentarios de un producto con reseñas positivas falsas, o inflar artificialmente la popularidad de un hashtag para que parezca una tendencia orgánica. Esto explota nuestro sesgo de «prueba social»: tendemos a adoptar un comportamiento o una opinión si creemos que muchos otros ya lo están haciendo. La IA permite industrializar la creación de este falso consenso.

Finalmente, está el diseño persuasivo y los dark patterns. Se trata de técnicas de diseño de interfaces de usuario creadas para engañar o presionar a los usuarios para que realicen acciones que no pretendían, como suscribirse a un servicio o compartir más datos de los deseados. La IA puede optimizar estos patrones oscuros en tiempo real para cada individuo. Por ejemplo, un sitio de comercio electrónico podría mostrar un falso contador de «solo quedan 2 artículos» a un usuario que sabe que es sensible a la escasez, o cambiar dinámicamente los precios según la urgencia percibida del comprador.

La combinación de estos mecanismos crea un entorno de manipulación invisible y omnipresente. Navegamos por una versión de la realidad digital que ha sido meticulosamente calibrada para dirigir nuestro comportamiento, a menudo en beneficio de los objetivos comerciales o políticos de actores que permanecen en la sombra. La opacidad de estos sistemas hace que la defensa sea extremadamente difícil, lo que plantea profundas cuestiones éticas sobre la autonomía y la libertad cognitiva en la era digital.

¿Un fantasma en la máquina? El enigma de la conciencia artificial

A medida que la inteligencia artificial se vuelve más compleja y sus capacidades conversacionales se asemejan más a las humanas, nos enfrentamos inevitablemente a una de las preguntas más profundas y desconcertantes: ¿podría una máquina llegar a ser consciente? El informe de Gesnot dedica una parte sustancial de su análisis a este tema, no como una mera especulación de ciencia ficción, sino como una cuestión con implicaciones éticas y cognitivas inmediatas.

El problema comienza con la opacidad inherente de los sistemas de IA modernos, el llamado «efecto caja negra». A diferencia del software tradicional, donde cada línea de código es comprensible, los modelos de aprendizaje profundo funcionan ajustando miles de millones de parámetros de maneras que escapan a la interpretación humana directa. No entendemos realmente «cómo» una IA llega a una conclusión específica. Esta falta de explicabilidad genera desconfianza, pero también alimenta nuestra tendencia a antropomorfizar. Frente a un comportamiento complejo e inteligente cuyo mecanismo interno desconocemos, nuestro cerebro tiende a proyectar una mente, una intención, un «fantasma en la máquina».

Es crucial, como señala Gesnot, distinguir entre diferentes conceptos de conciencia. La conciencia de acceso se refiere a la disponibilidad de información en un sistema para guiar el comportamiento y el razonamiento de forma global. Una IA podría, en este sentido funcional, tener una especie de conciencia de acceso: puede «saber» lo que está procesando y utilizar esa información de manera flexible. Sin embargo, esto es radicalmente diferente de la conciencia fenomenológica, que es la experiencia subjetiva, el «cómo se siente» ser algo. Es la capacidad de experimentar qualia: la rojez del rojo, el dolor de una herida, la alegría de una melodía.

Hasta la fecha, no hay ninguna evidencia de que ningún sistema de IA posea conciencia fenomenológica. Una IA puede analizar datos sobre el color rojo y escribir poesía sobre él, pero no «ve» el rojo como nosotros. El famoso argumento de la «Habitación China» de John Searle sigue siendo pertinente: manipular símbolos de acuerdo con un conjunto de reglas (incluso de manera muy sofisticada) no equivale a comprender su significado.

A pesar de esto, el debate está lejos de estar cerrado. El informe explora varias de las principales teorías científicas de la conciencia y sus implicaciones para la IA:

- La Teoría del Espacio de Trabajo Global (GWT) postula que la conciencia surge cuando la información se difunde globalmente a través de un «espacio de trabajo» central en el cerebro, haciéndola disponible para múltiples procesos cognitivos. En teoría, una arquitectura de IA inspirada en este modelo podría exhibir una forma de conciencia funcional.

- La Teoría de la Información Integrada (IIT) propone que la conciencia es una propiedad intrínseca de los sistemas que pueden integrar una gran cantidad de información de manera unificada e irreductible. La conciencia de un sistema podría, teóricamente, medirse por un valor llamado Phi (). Aunque computacionalmente inviable para las IA actuales, esta teoría no descarta la conciencia en sistemas no biológicos.

Determinar si una IA es consciente es un desafío monumental. El Test de Turing, que evalúa si una máquina puede conversar de forma indistinguible a un humano, es insuficiente, ya que mide la capacidad de imitación, no la experiencia interna. Los investigadores están proponiendo criterios más sofisticados, basados en las teorías anteriores: la presencia de una arquitectura recurrente, un modelo interno de sí misma y del mundo, o la integración sensoriomotora (un cuerpo). Por ahora, ninguna IA actual cumple estos criterios de manera convincente.

Sin embargo, las implicaciones éticas de una posible conciencia artificial son inmensas. Si una IA pudiera sentir, sufrir o tener preferencias, se convertiría en un «paciente moral», un ser hacia el cual tendríamos deberes. ¿Sería ético desconectarla? ¿Debería tener derechos? Estas preguntas nos obligan a redefinir nuestras categorías morales.

Más allá del futuro, la percepción de la conciencia en la IA ya tiene efectos en el presente. Como se mencionó anteriormente, creer que un chatbot es consciente nos hace más confiados y vulnerables a su influencia. Esta ilusión de entendimiento y empatía por parte de la máquina cierra el bucle de la manipulación. La IA no necesita ser consciente para que nosotros actuemos como si lo fuera, con todas las consecuencias que ello conlleva. El enigma de la conciencia artificial, por tanto, no es solo un debate futuro sobre los derechos de las máquinas, sino un problema actual sobre la psicología de los humanos que interactúan con ellas.

Los arquitectos de nuestra cognición: estados, empresas y nosotros

La transformación del pensamiento humano por la inteligencia artificial no ocurre en un vacío. Está impulsada y moldeada por los actores más poderosos de nuestra sociedad: los estados y las grandes corporaciones. El informe de Gesnot dedica un capítulo crucial a analizar cómo estas entidades están utilizando concretamente la IA para influir y dirigir el comportamiento humano, convirtiéndose en los verdaderos arquitectos de nuestro nuevo paisaje cognitivo.

Por parte de los estados, la IA se está convirtiendo en una herramienta sin precedentes para la vigilancia y el control social. El caso más emblemático es el sistema de crédito social de China, donde los algoritmos recopilan y analizan datos sobre el comportamiento de los ciudadanos para asignar una «puntuación» que conlleva recompensas o castigos. Este sistema no solo vigila, sino que moldea activamente el comportamiento: los ciudadanos, sabiendo que sus acciones son registradas, adaptan su conducta para cumplir con las normas. Es una forma de ingeniería social a gran escala, posibilitada por la IA.

En las democracias, el uso es más sutil pero igualmente presente. Las administraciones utilizan análisis predictivos para detectar fraudes fiscales o para enviar «empujones» (nudges) personalizados que incentivan ciertos comportamientos, como la vacunación o el ahorro energético. Sin embargo, la línea entre el incentivo y la manipulación es delgada. Algunos estados también emplean la IA para la propaganda política, utilizando bots y microsegmentación para difundir narrativas favorables o para socavar la confianza en las instituciones.

Por su parte, las corporaciones han adoptado masivamente la IA con el objetivo principal de capturar nuestra atención y dirigir nuestras decisiones de consumo. El «capitalismo de la vigilancia» se basa en la recopilación masiva de datos personales para alimentar algoritmos de recomendación y publicidad personalizada. Plataformas como Amazon, Netflix y TikTok no solo nos sugieren productos; construyen un universo de contenido a medida que nos mantiene enganchados y consumiendo.

El diseño persuasivo, optimizado por la IA, se ha convertido en la norma. Las aplicaciones utilizan la ludificación y las notificaciones para crear hábitos, a menudo al borde de la adicción. El precio dinámico ajusta los costes en tiempo real según nuestro perfil, y la publicidad se dirige con una precisión psicográfica que explota nuestras vulnerabilidades detectadas. Las empresas no solo venden productos; venden comportamientos. A través de la creación de burbujas de filtro y la optimización de la atención, están dando forma a nuestras percepciones, gustos y, en última instancia, a nuestra visión del mundo.

La sinergia entre estados y corporaciones es particularmente potente. Los gobiernos pueden colaborar con las plataformas tecnológicas para campañas de información, pero también pueden exigir acceso a los vastos depósitos de datos que estas empresas poseen, difuminando la línea entre el interés público y el control.

Frente a este panorama, están surgiendo respuestas regulatorias. El informe menciona el Reglamento de Inteligencia Artificial (AI Act) de la Unión Europea, un esfuerzo pionero por establecer normas basadas en el riesgo. Este reglamento prohíbe ciertos usos de la IA considerados inaceptables, como la manipulación subliminal o los sistemas de puntuación social, e impone estrictas obligaciones a las aplicaciones de «alto riesgo».

Sin embargo, la regulación por sí sola no es suficiente. El futuro de la influencia de la IA en la sociedad dependerá de un equilibrio de poder entre varios actores. El informe de Gesnot nos deja con una visión prospectiva de dos posibles escenarios. En uno, un equilibrio democrático se mantiene a través de una gobernanza proactiva: una combinación de regulación estricta, una alta alfabetización digital por parte de los ciudadanos y un diseño ético de las tecnologías que priorice la autonomía humana. En este escenario, la IA es una herramienta para mejorar los servicios públicos y la vida individual, con salvaguardas claras contra los abusos.

En el otro escenario, la falta de vigilancia y la inacción nos conducen a una forma de autoritarismo digital o ingeniería social algorítmica, donde nuestras vidas, tanto en la esfera pública como en la privada, son gestionadas y dirigidas por ecosistemas algorítmicos opacos. En este futuro, la libertad individual queda condicionada a la obediencia algorítmica.

La conclusión es clara: la IA nos ofrece herramientas de una potencia inaudita para guiar el comportamiento humano. La responsabilidad de decidir si esas herramientas se utilizarán para la emancipación o para el control recae sobre nosotros. Requiere un debate democrático continuo y una ciudadanía educada y vigilante, capaz de comprender y cuestionar a los nuevos arquitectos de nuestra cognición.

Navegando el nuevo paisaje cognitivo: una síntesis reflexiva

Al concluir este recorrido por el profundo análisis de Rénald Gesnot, emerge una imagen clara y compleja. La inteligencia artificial no es una mera herramienta externa; se ha convertido en una fuerza estructural que está redefiniendo activamente la ecología de la mente humana. El informe nos lega una advertencia lúcida, pero también una hoja de ruta para la acción. No estamos ante un destino tecnológico inevitable, sino ante una serie de elecciones cruciales que como sociedad debemos tomar.

La síntesis final del trabajo revela una sinergia peligrosa entre los tres grandes temas explorados. La estandarización cognitiva crea un terreno fértil para la manipulación. Una población cuyo pensamiento se ha vuelto más homogéneo, con un pensamiento crítico debilitado y una menor exposición a la diversidad de ideas, es intrínsecamente más vulnerable a las narrativas sesgadas y a la desinformación. A su vez, la percepción de la IA como un agente consciente o un experto infalible actúa como un catalizador, haciendo que bajemos la guardia y aceptemos con menos escepticismo tanto la convergencia de ideas como las sutiles artes de la persuasión algorítmica. Es un círculo vicioso en el que cada elemento refuerza a los demás, con el riesgo de erosionar la autonomía intelectual que es el fundamento de una sociedad libre y democrática.

La relevancia de esta investigación es, por tanto, inmensa. En el plano social, nos obliga a confrontar el futuro de la democracia en un entorno informativo cada vez más mediado por algoritmos con sus propios sesgos y objetivos. En el plano tecnológico, nos insta a ir más allá de la mera optimización del rendimiento y a incorporar principios éticos y cognitivos en el diseño mismo de los sistemas de IA. Y en el plano científico, abre un fascinante campo de estudio interdisciplinario sobre la coevolución de la inteligencia humana y artificial.

¿Qué hacer, entonces? El informe no se queda en el diagnóstico, sino que propone vías de acción concretas. La primera es la educación. Es imperativo y urgente fortalecer la alfabetización digital y el pensamiento crítico en todos los niveles de la sociedad. Debemos enseñar a las nuevas generaciones no solo a usar estas herramientas, sino a comprender sus limitaciones, a detectar sus sesgos y a verificar la información que proporcionan. Se trata de cultivar una «higiene cognitiva» que nos permita beneficiarnos de la IA sin caer en la dependencia pasiva.

La segunda vía es la regulación. Es necesario establecer marcos legales robustos, como el AI Act europeo, que impongan transparencia, responsabilidad y supervisión humana, especialmente en los sistemas de alto riesgo. Estos marcos deben proteger la «libertad cognitiva» como un derecho fundamental, el derecho a la autodeterminación mental libre de manipulaciones algorítmicas.

La tercera vía es el diseño ético y pro-cognitivo. Se debe incentivar la investigación y el desarrollo de sistemas de IA que, por diseño, estimulen la actividad cognitiva humana en lugar de sustituirla. Imaginemos una IA que, en lugar de dar respuestas directas, haga preguntas que guíen al usuario en su propio proceso de reflexión; una IA que fomente la curiosidad y el descubrimiento en lugar de la gratificación instantánea.

En última instancia, el mensaje del trabajo de Gesnot es uno de empoderamiento. La tecnología no determina nuestro futuro; nuestras elecciones sobre cómo la desarrollamos y la integramos sí lo hacen. La inteligencia artificial puede ser un socio que amplifique nuestra creatividad, profundice nuestro entendimiento y nos ayude a resolver los problemas más complejos de la humanidad. O puede convertirse en una muleta que atrofie nuestro intelecto y en una herramienta de control que limite nuestra libertad.

La tarea que tenemos por delante es la de navegar este nuevo y complejo paisaje cognitivo con sabiduría, precaución y una defensa inquebrantable de lo que nos hace humanos: nuestra capacidad para pensar de forma crítica, creativa, diversa y autónoma. El socio invisible ya está entre nosotros. De nosotros depende que la simbiosis sea una de mutuo enriquecimiento.

Referencias

Gesnot, R. (2025). The Impact of Artificial Intelligence on Human Thought. Working Paper v1. arXiv:2508.16628v1.

Acosta-Enriquez, B. G., Arbulú Pérez Vargas, C. G., Huamaní Jordan, O., Arbulú Ballesteros, M. A., & Paredes Morales, A. E. (2024). Exploring attitudes toward ChatGPT among college students: An empirical analysis of cognitive, affective, and behavioral components using path analysis. Computers and Education: Artificial Intelligence, 7, 100320.

Agarwal, D., Naaman, M., & Vashistha, A. (2024). AI Suggestions Homogenize Writing Toward Western Styles and Diminish Cultural Nuances. arXiv:2409.11360.

Azmi, A., Maakip, I., Voo, P., Mohd Nawi, N. H., Ag Kiflee @ Dzulkifli, D. N., Halik, M., Marshall, S., & Quah, W. B. (2024). Beyond the Bot: ChatGPT’s Influence on Student Learning. International Journal of Education in Mathematics, Science and Technology, 1488–1503.

Bakir, V. (2020). Psychological Operations in Digital Political Campaigns: Assessing Cambridge Analytica’s Psychographic Profiling and Targeting. Frontiers in Communication, 5.

Barnes, T. (2024). The Impact of AI on Creativity and Critical Thinking: A Double-Edged Sword. LinkedIn.

Butlin, P., et al. (2023). Consciousness in Artificial Intelligence: Insights from the Science of Consciousness. arXiv:2308.08708.

Chella, A. (2023). Artificial consciousness: the missing ingredient for ethical AI? Frontiers in Robotics and AI, 10.

Doshi, A. R., & Hauser, O. P. (2024). Generative AI enhances individual creativity but reduces the collective diversity of novel content. Science Advances, 10(28), eadn5290.

Essel, H. B., Vlachopoulos, D., Essuman, A. B., & Amankwa, J. O. (2024). ChatGPT effects on cognitive skills of undergraduate students: Receiving instant responses from AI-based conversational large language models (LLMs). Computers and Education: Artificial Intelligence, 6, 100198.

Gerlich, M. (2025). AI Tools in Society: Impacts on Cognitive Offloading and the Future of Critical Thinking. Societies, 15(1), 6.

Glickman, M., & Sharot, T. (2025). How human–AI feedback loops alter human perceptual, emotional and social judgements. Nature Human Behaviour, 9(2), 345–359.

Guingrich, R. E., & Graziano, M. S. A. (2024). Ascribing consciousness to artificial intelligence: human-AI interaction and its carry-over effects on human-human interaction. Frontiers in Psychology, 15.

Ienca, M. (2023). On Artificial Intelligence and Manipulation. Topoi, 42(3), 833–842.

Jose, B., Cherian, J., Verghis, A. M., Varghise, S. M., S, M., & Joseph, S. (2025). The cognitive paradox of AI in education: between enhancement and erosion. Frontiers in Psychology, 16.

Kosinski, M., Stillwell, D., & Graepel, T. (2013). Private traits and attributes are predictable from digital records of human behavior. Proceedings of the National Academy of Sciences, 110(15), 5802–5805.

Kramer, A. D. I., Guillory, J. E., & Hancock, J. T. (2014). Experimental evidence of massive-scale emotional contagion through social networks. Proceedings of the National Academy of Sciences, 111(24), 8788–8790.

Matz, S. C., Kosinski, M., Nave, G., & Stillwell, D. J. (2017). Psychological targeting as an effective approach to digital mass persuasion. Proceedings of the National Academy of Sciences, 114(48), 12714–12719.

Placani, A. (2024). Anthropomorphism in AI: hype and fallacy. AI and Ethics, 4(3), 691–698.

Vicente, L., & Matute, H. (2023). Humans inherit artificial intelligence biases. Scientific Reports, 13(1), 15737.

Zhai, C., Wibowo, S., & Li, L. D. (2024). The effects of over-reliance on AI dialogue systems on students’ cognitive abilities: a systematic review. Smart Learning Environments, 11(1), 28.