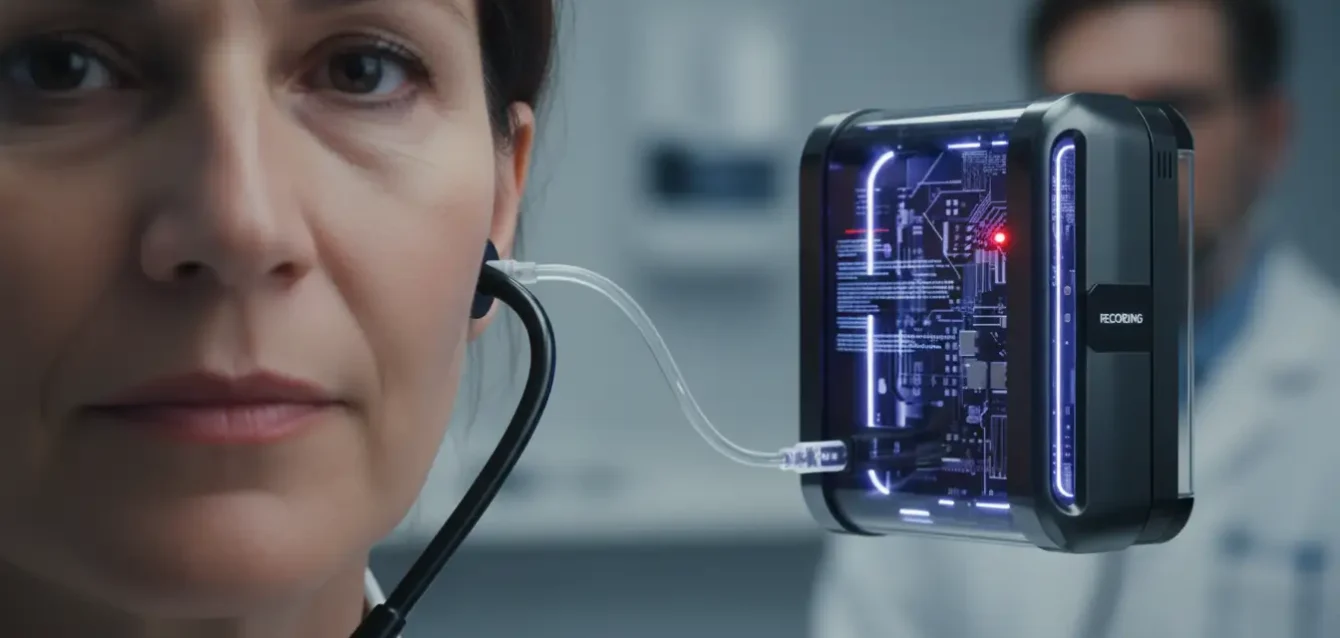

Caerwin Martin, músico y artista de Melbourne, Australia, reservó una cita con su periodoncista esperando el procedimiento habitual: evaluación clínica, diagnóstico, quizás una referencia a un especialista. No esperaba terminar la tarde siendo interrogada por oficiales de policía. El incidente comenzó cuando el doctor informó que usaría inteligencia artificial para tomar notas durante la consulta y generar documentos de referencia. Martin se negó. El médico insistió. Martin mantuvo su posición. El consultorio llamó a las autoridades.

La policía llegó, entrevistó a Martin y la dejó ir sin cargos después de un breve intercambio. Desde su perspectiva, no había ocurrido delito alguno. Pero el daño estaba hecho. Martin compartió su experiencia en Facebook, donde generó un debate intenso sobre derechos de pacientes, autonomía médica y los límites del consentimiento informado en la era de la automatización clínica. Su relato fue simple: se opone al uso de inteligencia artificial por razones éticas y no quiere que sistemas automatizados tengan acceso a su historial médico. El consultorio interpretó su negativa como algo suficientemente problemático para justificar una intervención policial.

El caso plantea una pregunta fundamental: ¿puede un paciente negarse al uso de inteligencia artificial en entornos médicos sin consecuencias? La respuesta, sorprendentemente, depende de dónde vivas, qué tipo de herramienta se use y si tu médico considera tu negativa como cooperación razonable o como obstrucción inaceptable. En la mayoría de jurisdicciones, incluyendo Estados Unidos, no existe ley federal que requiera a proveedores médicos informar explícitamente sobre el uso de inteligencia artificial durante las consultas. Esta ausencia de regulación clara crea una zona gris donde los derechos de pacientes y las prácticas clínicas colisionan sin un marco legal que arbitre el conflicto.

El silencio regulatorio sobre inteligencia artificial médica

Star Kashman, socio fundador de Cyber Law Firm, confirma que en Estados Unidos no existe ninguna regla federal general que obligue a los médicos a informar a los pacientes sobre el uso de inteligencia artificial durante las visitas clínicas. Esto no significa que los médicos puedan hacer lo que quieran sin consecuencias. Significa que las obligaciones de divulgación y consentimiento surgen indirectamente a través de otras normativas, creando un panorama legal fragmentado y confuso.

Por ejemplo, si la consulta es virtual y se graba en audio o video, leyes estatales sobre interceptación de comunicaciones y consentimiento de grabación pueden aplicarse. Pero estas leyes fueron diseñadas décadas antes de que la inteligencia artificial generativa existiera, por lo que su aplicación a sistemas automatizados de toma de notas es ambigua. La información sobre condiciones de salud, registros médicos e información personal de pacientes se considera información de salud protegida (conocida como PHI por sus siglas en inglés). Esta información está regulada principalmente por HIPAA, la Ley de Portabilidad y Responsabilidad de Seguros de Salud, que aborda indirectamente el uso de inteligencia artificial.

Bajo HIPAA, el uso de cualquier sistema de información o software para recolectar y almacenar PHI representa riesgos, porque típicamente la información es accesible por el proveedor del sistema, incluyendo a los proveedores de inteligencia artificial, explica Ron Harman King, director ejecutivo de Vanguard Communications Group. Si un proveedor de inteligencia artificial carece de cifrado doble y de un Acuerdo de Asociado de Negocios (conocido como BAA), que vincula al contratista a las mismas salvaguardas legales de privacidad que los proveedores de salud, su uso requiere que los pacientes firmen un formulario de divulgación y renuncia cuidadosamente redactado antes de usar la inteligencia artificial.

Marco regulatorio fragmentado de IA en salud

Situación federal en Estados Unidos: No existe ley federal que obligue a médicos a informar explícitamente sobre el uso de inteligencia artificial durante consultas clínicas. Las obligaciones surgen indirectamente a través de HIPAA y otras regulaciones.

Requisito de HIPAA: La información de salud protegida (PHI) debe estar resguardada. Si un proveedor de IA carece de cifrado doble y Acuerdo de Asociado de Negocios (BAA), se requiere consentimiento explícito del paciente.

Plataformas de IA para el consumidor: La mayoría de herramientas populares de IA para toma de notas no ofrecen BAAs ni protecciones de privacidad adecuadas para uso seguro por proveedores de salud con información de pacientes.

Regulación estatal emergente: California, Texas y Utah han promulgado reglas que requieren o fomentan la notificación cuando IA generativa se usa en comunicaciones con pacientes o apoyo de decisiones clínicas.

Adopción médica actual: Dos de cada tres médicos estadounidenses ahora usan inteligencia artificial, incluyendo tareas como escribir notas de visitas, instrucciones de alta o planes de cuidado.

La brecha entre adopción tecnológica y protección legal

King es directo en su evaluación: "Las plataformas de inteligencia artificial para consumidores rara vez ofrecen BAAs o protecciones de privacidad adecuadas para ser usadas de manera segura por proveedores de salud con la información de salud de los pacientes, incluyendo la toma de notas durante las citas". En otras palabras, muchos de los sistemas de inteligencia artificial que los médicos están usando actualmente no cumplen con los estándares de HIPAA, a menos que el proveedor médico haya adquirido una suscripción especial diseñada para entornos de salud. Las versiones estándar de ChatGPT, Claude, Google Gemini u otros sistemas generativos populares no están certificadas para manejar PHI sin configuraciones específicas.

Con las leyes federales rezagadas respecto al despliegue rápido de herramientas de inteligencia artificial, algunos estados están interviniendo. Aaron Maguregui, socio y experto en inteligencia artificial en Foley & Lardner LLP, señala que California, Texas y Utah han promulgado reglas que requieren o fomentan la notificación cuando inteligencia artificial generativa se usa en comunicaciones con pacientes o como apoyo de decisiones clínicas. "Principios más amplios de consentimiento informado y ética también pueden obligar a la divulgación cuando la inteligencia artificial influye significativamente en el cuidado. Las reglas permanecen fragmentadas pero se están endureciendo rápidamente", dice Maguregui.

Esta fragmentación crea problemas prácticos. Un paciente en California puede tener derecho legal a ser informado sobre el uso de inteligencia artificial. Ese mismo paciente, cruzando la frontera a Nevada, puede no tener una protección equivalente. Un médico que opera una red de clínicas en múltiples estados enfrenta un mosaico regulatorio donde las prácticas legales en una jurisdicción pueden violar requisitos en otra. La falta de un estándar nacional no solo confunde a proveedores y pacientes, sino que también crea incentivos perversos para que las clínicas operen en jurisdicciones con regulación más laxa.

La desconfianza de pacientes y la realidad de adopción médica

Los pacientes son generalmente cautelosos respecto a las aplicaciones de inteligencia artificial en el cuidado de la salud. Casi cuatro de cada diez estadounidenses creen que usar inteligencia artificial en salud comprometería la seguridad de los registros de pacientes, según una encuesta de 2023. Cuando se trata de tomar decisiones de salud, el escepticismo hacia la inteligencia artificial es aún más fuerte: casi 58% dice tener baja confianza en que sus sistemas de salud aseguren que una herramienta de inteligencia artificial no les dañe.

A pesar del escepticismo de los pacientes, la tecnología llegó para quedarse. Dos de cada tres médicos estadounidenses ahora usan inteligencia artificial, incluyendo tareas como escribir notas de visitas, instrucciones de alta o planes de cuidado. Esta adopción masiva ocurrió en una ventana de apenas dos años, sin que los marcos regulatorios correspondientes se establecieran primero. Los médicos justifican el uso citando eficiencia, la reducción de la carga administrativa y más tiempo con los pacientes. Pero los pacientes no necesariamente fueron consultados sobre si aceptan este intercambio.

El caso de Martin ilustra la tensión subyacente. Ella explicó a los medios que se opone al uso de inteligencia artificial por razones éticas y porque no quiere que tenga acceso a sus registros médicos. "Soy músico y me ofende que el gobierno haya tenido que intervenir para detener que la inteligencia artificial absorba todo nuestro material", dijo a DailyMail, haciendo referencia a debates sobre el entrenamiento de modelos con contenido protegido por derechos de autor sin consentimiento. Su objeción no fue caprichosa ni desinformada. Fue una posición ética deliberada sobre una tecnología que considera extractiva y potencialmente dañina.

Cómo los pacientes pueden proteger sus derechos

Lani M. Dornfeld, abogado de salud en Brach Eichler, enfatiza que en cada interacción con proveedores médicos, los pacientes deben ser diligentes y ser sus propios defensores de salud. Esto incluye hacer preguntas sobre el uso de herramientas de inteligencia artificial durante los encuentros médicos. Las preguntas clave incluyen: ¿Qué herramientas se están usando? ¿Por qué se usan dichas herramientas? ¿Cuáles son los riesgos y beneficios que ofrecen? ¿Se divulgará información del paciente a terceros? ¿Qué supervisión humana está involucrada?

Aunque los pacientes pueden solicitar límites en el uso de datos, los proveedores pueden negarse si las restricciones interfieren con el cuidado, advierte Maguregui. Esta advertencia es crítica. Significa que negarse al uso de inteligencia artificial no es un derecho absoluto. Un médico puede argumentar razonablemente que ciertas herramientas de inteligencia artificial son esenciales para brindar un nivel de cuidado apropiado. Si el sistema automatizado detecta interacciones medicamentosas potencialmente mortales que un humano podría pasar por alto, ¿tiene el paciente derecho a rechazarlo? Si el modelo de inteligencia artificial genera un plan de tratamiento más preciso que el juicio clínico humano por sí solo, ¿puede el paciente exigir que el médico ignore esa información?

Kashman recomienda que los pacientes que optan por rechazar herramientas de inteligencia artificial en un entorno médico documenten esa decisión en su historial clínico, y de no olvidar informar a recepción. Esta documentación protege tanto al paciente como al proveedor. Si surge una disputa posteriormente sobre si se obtuvo el consentimiento apropiado, el registro clínico proporciona evidencia de las preferencias del paciente. Pero esta recomendación también subraya una realidad incómoda: la carga de proteger los derechos de privacidad recae sobre pacientes individuales, no sobre marcos regulatorios que deberían establecer estándares claros.

Preguntas que todo paciente debe hacer sobre IA médica

¿Qué herramientas específicas se usan? Solicitar nombres y fabricantes de sistemas de IA que procesarán información médica personal durante la consulta.

¿Para qué se usa la IA? Entender si la herramienta toma notas, genera diagnósticos, recomienda tratamientos o analiza imágenes médicas.

¿Quién tiene acceso a los datos? Preguntar si la información médica se comparte con proveedores de IA externos, si se almacena en la nube y si se usa para entrenamiento de modelos.

¿Existe Acuerdo de Asociado de Negocios? Verificar si el proveedor de IA tiene un BAA que lo obliga a cumplir con los estándares de privacidad de HIPAA.

¿Qué supervisión humana existe? Confirmar que un médico humano revisa y aprueba todas las salidas de IA antes de que influyan en decisiones clínicas.

¿Puedo optar por no participar? Preguntar directamente si es posible recibir atención sin el uso de sistemas de IA, y si hay consecuencias por rechazarlos.

El futuro incierto del consentimiento automatizado

El caso de Martin permanece ante la junta médica australiana. Su resultado podría establecer un precedente sobre si los médicos pueden condicionar el tratamiento a la aceptación de herramientas de inteligencia artificial, o si los pacientes tienen un derecho absoluto a rechazar el procesamiento automatizado de información médica. Mientras tanto, la adopción de inteligencia artificial en medicina continúa acelerándose. Nuevos sistemas prometen diagnosticar enfermedades raras mediante análisis de imágenes, predecir complicaciones quirúrgicas antes de que ocurran y personalizar regímenes de medicamentos según la genómica individual.

Cada una de estas aplicaciones plantea preguntas similares sobre consentimiento, transparencia y control de pacientes. Si un modelo de inteligencia artificial analiza miles de biomarcadores en la sangre de un paciente y predice un riesgo elevado de enfermedad cardíaca, ¿debe el paciente ser informado de que un algoritmo, y no un humano, generó esa predicción? Si un sistema de inteligencia artificial revisa el historial médico completo de un paciente para detectar patrones que sugieren un diagnóstico erróneo previo, ¿tiene el paciente derecho a saber que una máquina cuestionó el juicio de sus médicos anteriores?

La respuesta legal sigue siendo turbia. La respuesta ética debería ser obvia: los pacientes tienen el derecho fundamental a saber cómo se toman decisiones sobre su salud y quién, o qué, tiene acceso a su información médica más sensible. Ese derecho no debe depender de la fragmentación geográfica de regulaciones estatales ni de la voluntad individual de los proveedores de divulgar el uso de tecnología. Requiere un marco federal claro que establezca estándares mínimos de transparencia, consentimiento y control de pacientes sobre el procesamiento automatizado de su información médica.

Referencias

Cybernews. (2025). Australian artist's protest against AI in dental appointment ends with police encounter. Reporte tecnológico, noviembre 2025.

DailyMail Australia. (2025). Melbourne artist Caerwin Martin speaks out after police called to dental clinic. Entrevista con paciente.

Kashman, Star. (2025). Legal analysis of AI disclosure requirements in healthcare settings. Cyber Law Firm, consultoría legal especializada.

King, Ron Harman. (2025). HIPAA compliance and AI tools in medical practice. Vanguard Communications Group, análisis regulatorio.

Maguregui, Aaron. (2025). State-level AI disclosure requirements in healthcare. Foley & Lardner LLP, análisis de política legal.

Dornfeld, Lani M. (2025). Patient advocacy and AI in healthcare settings. Brach Eichler, consultoría de derecho médico.

Survey on American attitudes toward AI in healthcare. (2023). Datos sobre confianza de pacientes en sistemas automatizados.