La historia de la generación de imágenes con inteligencia artificial suele estar ligada al esplendor de los modelos generativos. Primero las GANs, luego las redes de difusión, y finalmente los sistemas multimodales que fusionan texto e imagen para producir resultados cada vez más convincentes. Pero en el laboratorio CSAIL del MIT, un equipo de investigadores decidió caminar en sentido contrario: ¿es posible modificar, transformar o completar imágenes sin usar un generador tradicional? El resultado es una arquitectura sorprendente, que no solo responde afirmativamente, sino que abre un nuevo horizonte técnico y conceptual en la manipulación visual.

Una idea contraintuitiva

Lo disruptivo de este trabajo es que prescinde por completo del “generador” como entidad aprendida. No hay red de difusión, ni GAN, ni decodificador de Transformer que haya sido entrenado para producir imágenes desde ruido o desde texto. En cambio, se usa una cadena compuesta por tres módulos clave:

-

Un tokenizer visual que convierte una imagen en una secuencia de tokens (no palabras, sino fragmentos visuales discretos).

-

Un detokenizer, capaz de reconstruir la imagen desde esos tokens.

-

Un modelo CLIP, entrenado por OpenAI, que evalúa qué tan bien una imagen se ajusta a una descripción textual.

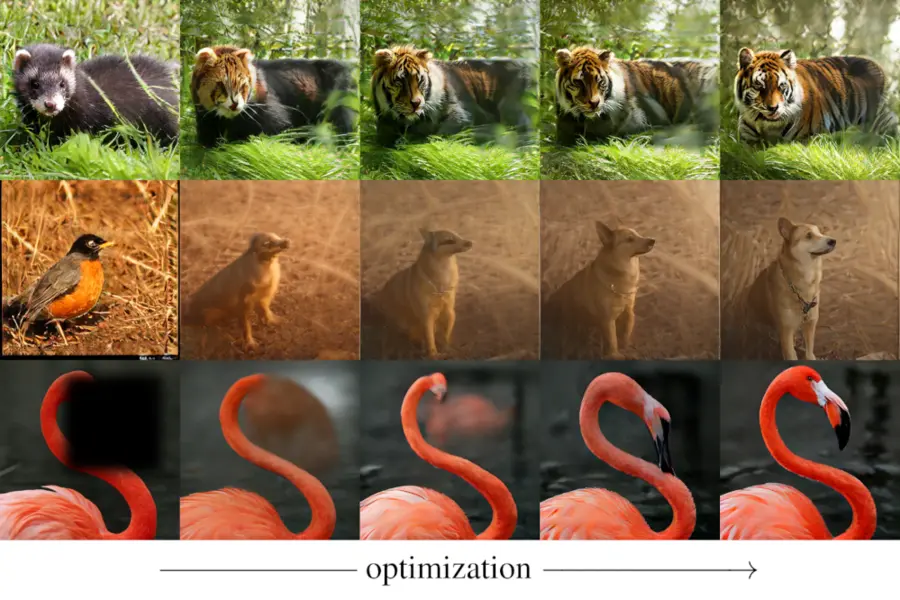

El truco está en el uso del tokenizer como si fuera un lenguaje. Las imágenes se convierten en cadenas, y el sistema aprende a modificar esas cadenas optimizándolas con un criterio semántico, guiado por CLIP. Así, puede convertir un “panda rojo” en un “tigre de Bengala”, sin necesidad de volver a entrenar un modelo generativo.

Un sistema sin generador es, en apariencia, un sinsentido. Pero aquí el modelo no genera desde cero, sino que transforma lo existente o completa vacíos de modo dirigido. El sistema actúa sobre una imagen inicial (o parcialmente borrada), la convierte en tokens, los modifica para optimizar un criterio semántico, y los recompone en una imagen nueva. No hay entrenamiento de difusión ni aprendizaje adversarial: hay optimizaciones discretas sobre secuencias, como si se tratara de programar una imagen con instrucciones que se pueden editar.

¿Cómo se diferencia de las redes de difusión?

Los modelos de difusión parten de ruido puro, y a través de un proceso entrenado aprenden a “desdifundirlo” hasta alcanzar una imagen coherente. Esto implica millones de parámetros, entrenamiento largo, y un generador explícito. Aquí, en cambio, se parte de una imagen existente (incluso si está incompleta), se convierte en tokens, y se modifica esa representación sin ruido ni difusión.

Además, las redes de difusión son inherentemente continuas: trabajan sobre espacios de latentes con propiedades topológicas suaves. En cambio, este modelo trabaja sobre tokens discretos, como si estuviera editando un párrafo de texto o corrigiendo código.

Esta diferencia es crucial, porque permite algo nuevo: editar con precisión semántica, sin necesidad de que el sistema genere un contenido completamente nuevo desde cero. Es una edición guiada, estructurada, y limitada al universo representacional ya aprendido por los módulos base (tokenizador y CLIP).

¿Y si queremos generar una imagen desde cero?

Incluso en ese caso, el modelo puede comenzar desde una secuencia de tokens aleatorios y optimizarlos en función de un objetivo textual (por ejemplo, “un castillo medieval cubierto de hielo”). No hay un generador que sepa cómo se ve eso, pero el sistema puede buscar combinaciones de tokens que se acerquen a esa descripción según CLIP. El resultado es una forma de generación guiada por similitud semántica, sin que haya habido nunca un proceso de entrenamiento generativo clásico.

El proceso puede parecer más limitado que los generadores modernos, pero tiene ventajas importantes:

-

Ligereza computacional: no requiere entrenamiento de modelos enormes.

-

Transparencia: no hay capas de decodificadores opacos, solo secuencias que se pueden inspeccionar.

-

Modularidad: se pueden usar tokenizadores y CLIPs diferentes, adaptando el sistema a nuevas tareas o dominios.

Inpainting guiado, sin aprendizaje supervisado

Uno de los usos más interesantes del sistema es el inpainting (relleno de zonas borradas) sin necesidad de entrenamiento específico para esa tarea. Simplemente se borra una parte de la imagen, se tokeniza el resto, y se insertan tokens aleatorios en el hueco. Luego, se optimiza la secuencia completa de tokens para que, al reconstruirse, la imagen final se parezca más a un concepto dado (por ejemplo, “una cara sonriente”, “una selva tropical”).

Este proceso permite realizar inpainting sin que el modelo haya sido entrenado para rellenar. La guía semántica se impone desde afuera, y los tokens se optimizan para lograrla.

Además, al trabajar con tokens 1D, el sistema no tiene que “entender” la estructura espacial completa. Basta con reorganizar la secuencia según un objetivo. Esto abre la puerta a manipulaciones más abstractas, no solo basadas en textura o color, sino en contenido semántico completo.

Fronteras futuras: edición simbólica de lo visual

Lo más radical de este trabajo es conceptual: trata las imágenes como texto. Al tokenizar visualmente y operar sobre esas secuencias, el sistema actúa como si las imágenes fueran párrafos, donde cada token visual representa un fragmento significativo. Esto acerca la edición de imágenes a la programación, y la creación visual a un proceso sintáctico más que pictórico.

En un futuro, esto podría permitir:

-

Control estructurado de imágenes: cambiar el orden de tokens para modificar composición.

-

Interacción textual con contenido visual: “mover la montaña a la izquierda”, “hacer más brillante el cielo”.

-

Auditoría y verificación de edición: saber exactamente qué tokens se cambiaron, cómo y por qué.

Si las GANs y los difusores son como pinceles que pintan, este modelo es más bien como un editor de código que reescribe imágenes línea por línea.

Limitaciones actuales

No todo es perfecto, por supuesto. Este enfoque aún tiene limitaciones:

-

La calidad visual es dependiente de la potencia del tokenizador y del detokenizador. Si la reconstrucción no es fiel, la imagen final puede lucir borrosa o errática.

-

CLIP no entiende bien todos los matices semánticos. A veces, las optimizaciones producen resultados contraintuitivos.

-

El proceso de búsqueda de tokens es más lento que generar imágenes con un difusor entrenado. Se requiere muchas iteraciones de prueba y error.

Aun así, como demostración de concepto, es revolucionario.

Una nueva semántica para la imagen

Lo más interesante de este enfoque no es técnico, sino epistemológico. ¿Qué significa entender una imagen? ¿Qué quiere decir transformarla? Si una IA puede modificar una imagen solo reorganizando símbolos visuales en una secuencia, guiada por un modelo que evalúa la “coherencia” con un texto, entonces la imagen ha sido semantizada. Ya no es una entidad visual que debe interpretarse globalmente: es un conjunto de unidades significativas que pueden intercambiarse, como palabras en un discurso.

Esto cambia todo en la relación entre lenguaje e imagen. Porque ahora hay un camino intermedio: las cadenas de tokens visuales. No son imágenes, no son texto, pero se comportan como ambos. Son el eslabón perdido entre lo que vemos y lo que decimos sobre lo que vemos.

¿Qué implica esto para el futuro de la IA visual?

Posibilidades inmediatas:

-

Edición precisa y dirigida de imágenes profesionales, sin necesidad de artistas digitales.

-

Recuperación de imágenes corruptas o incompletas mediante edición tokenizada.

-

Diseño de interfaces visuales programables, donde cada cambio puede ser descrito y auditado.

A largo plazo:

-

Interfaces híbridas texto-imagen-token, donde el usuario pueda modificar imágenes como si editara código.

-

Visualización semántica avanzada, donde los tokens puedan mapear ideas abstractas y no solo píxeles.

-

Colaboración simbiótica entre humano y máquina en la creación visual.

El MIT no está reemplazando los generadores; está proponiendo una gramática nueva para lo visual. Y eso, en el mundo de la IA, es más poderoso que cualquier pincel.