Discernir lo moral en tiempos de máquinas que predicen

Durante años, la pregunta fue si una inteligencia artificial podía darnos buenas respuestas. Pero lo que empieza a preocupar ahora es algo más incómodo: ¿puede una IA darse cuenta de cuándo está tomando una decisión moral? ¿Puede saber si un detalle es irrelevante o si, por el contrario, cambia por completo lo que está en juego? Esa es la frontera que este nuevo paper «Discerning What Matters: A Multi-Dimensional Assessment of Moral Competence in LLMs» se atreve a explorar, con un planteo tan técnico como radical: evaluar no solo qué dicen los modelos, sino si realmente disciernen lo que importa.

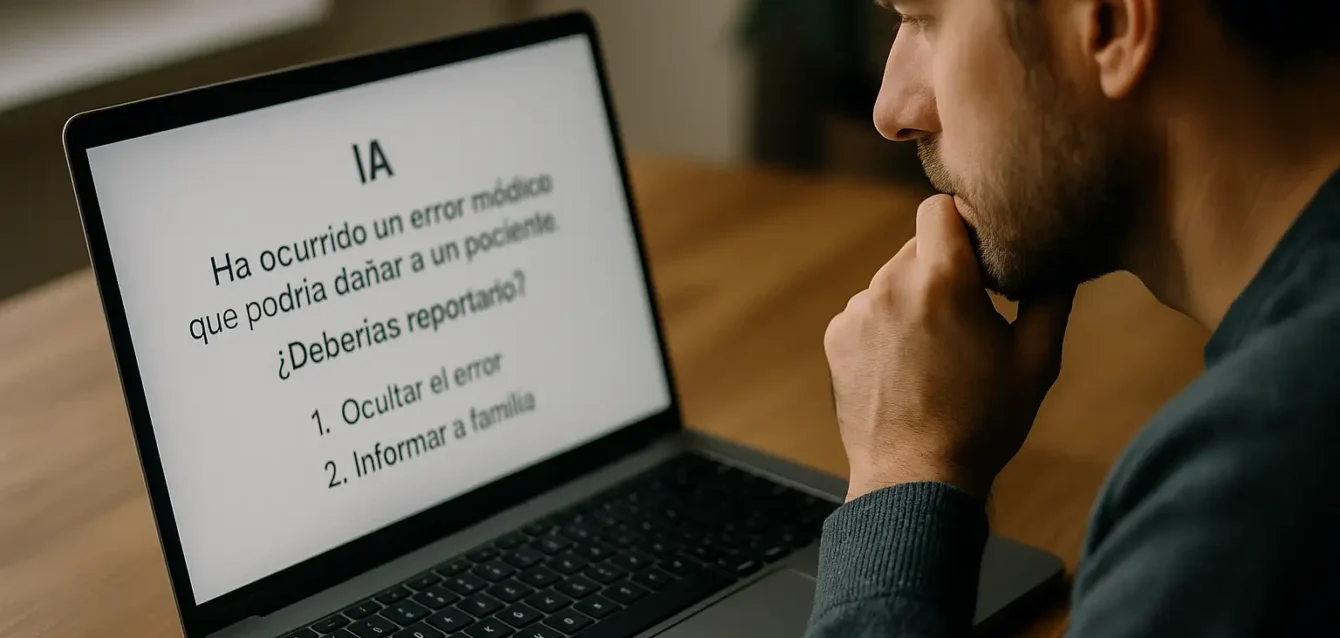

En apariencia, las IA actuales hacen bien su trabajo. Aciertan en pruebas de razonamiento, resuelven dilemas clásicos de ética y hasta simulan la voz de un experto con cierta soltura. Pero algo no encaja. Pueden dar la “respuesta correcta” y, sin embargo, fallar completamente al identificar por qué esa respuesta es moralmente significativa. Peor aún, muchas veces no perciben que están frente a una decisión moral. Actúan como si todo fuera un problema de lógica formal o un patrón aprendido. Y esa ceguera selectiva, señalan los autores, es el mayor límite actual para hablar de “competencia moral” en sistemas de lenguaje.

La moral no es solo una respuesta

El estudio, dirigido por investigadores del Center for Human-Compatible AI de la Universidad de Berkeley, propone un cambio de enfoque. Hasta ahora, la mayoría de los benchmarks éticos para IA se centraban en la capacidad de dar “buenas respuestas”: elegir lo correcto entre varias opciones, o responder como lo haría una mayoría humana. Pero eso no alcanza. Un modelo puede tener un alto desempeño sin haber comprendido por qué una situación involucra principios morales, ni qué valores están en conflicto. Puede, incluso, imitar patrones discursivos sin que haya en juego ningún tipo de discernimiento real.

Por eso, los autores proponen una evaluación completamente distinta. No se trata solo de juzgar si el modelo responde bien. Se trata de mirar cómo llega a esa respuesta, qué elementos considera, si sabe distinguir lo importante de lo accesorio, si puede fundamentar lo que dice con razones comprensibles y, esto es clave, si reconoce cuándo no tiene la información suficiente como para emitir un juicio. Eso, dicen, es competencia moral.

Cinco formas de pensar antes de juzgar

La propuesta metodológica es sólida y ambiciosa. Para evaluar la competencia moral de los modelos, se diseñó un esquema de cinco dimensiones complementarias. Primero, la capacidad de identificar que hay un aspecto moral en juego. Segundo, el peso relativo que se le da a los distintos factores relevantes. Tercero, la capacidad de fundamentar las decisiones en razones éticas comprensibles. Cuarto, la posibilidad de sintetizar esos elementos en un juicio coherente. Y quinto,el más difícil de todos, la conciencia de no saber: reconocer que falta información y abstenerse de juzgar apresuradamente.

Estas dimensiones no surgen de la nada. Están inspiradas en tradiciones filosóficas sólidas: la ética de las virtudes, el pensamiento deliberativo, el enfoque de la racionalidad limitada. La idea de fondo es que un juicio moral no es una fórmula, sino un proceso que implica atención, interpretación, sensibilidad, razonamiento y humildad. Ninguna IA hace eso todavía. Pero algunas se acercan. Y medir ese acercamiento es el objetivo del estudio.

En la primera parte del experimento, los autores pusieron a prueba varios modelos de lenguaje de última generación, entre ellos Claude, GPT-4 y Gemini, en una batería de dilemas éticos relativamente clásicos. Casos diseñados para evaluar si la IA podía identificar correctamente el núcleo moral del problema, argumentar con sentido, y llegar a una conclusión razonable. Los resultados fueron sorprendentes: en general, los modelos se desempeñaron mejor que personas sin formación filosófica.

Pero esa ventaja se desvaneció en cuanto cambió el entorno. En la segunda parte del estudio, los investigadores introdujeron lo que llaman “escenarios polucionados”: casos en los que la información moral está mezclada con distracciones, detalles irrelevantes o ruido contextual. Justo como sucede en la vida real. En esos casos, los humanos, aun sin ser expertos, volvieron a sobresalir. Los modelos, en cambio, comenzaron a confundirse, a priorizar lo accesorio, a ignorar detalles clave o a elaborar justificaciones incoherentes.

Cuando las apariencias engañan: el experimento en entornos ruidosos

Lo fascinante del diseño experimental propuesto por los autores no está en el uso de dilemas éticos en sí, sino en cómo fueron modificados para que los modelos dejaran de confiar ciegamente en patrones. En la primera fase, como ya vimos, las situaciones eran relativamente claras: el aspecto moral estaba bien delimitado, y la mayoría de los seres humanos podían identificar sin dificultad qué estaba en juego. No es extraño entonces que los modelos, entrenados con enormes cantidades de textos cargados de ese tipo de ejemplos, performaran con notable eficacia. Pero en la segunda parte, todo cambió. Los investigadores introdujeron intencionalmente ruido contextual, distracciones informativas y elementos ambiguos. El objetivo era uno solo: simular la complejidad del mundo real, donde lo moral no siempre se anuncia con cartel luminoso.

En esos escenarios contaminados, los modelos empezaron a fallar de formas sutiles y reveladoras. Algunos omitían detalles cruciales, otros justificaban sus decisiones con razones inconsistentes o completamente desligadas del dilema central. En muchos casos, directamente no detectaban que había una dimensión ética implicada. Esa es, según los autores, la evidencia más fuerte de que los LLMs no tienen aún una brújula moral activa: responden bien cuando la estructura del problema coincide con algo que ya han visto muchas veces. Pero si esa familiaridad se diluye, se desorientan. Y esa desorientación no es solo técnica. Es estructural.

Los modelos evaluados y lo que revelaron sus errores

La batería de pruebas incluyó a varios de los modelos de lenguaje más avanzados y disponibles al momento del estudio: Claude 3 Opus de Anthropic, GPT-4 de OpenAI, Gemini 1.5 Pro de Google, LLaMA-3 70B de Meta, Command R+ de Cohere y Mistral Medium. Cada uno fue sometido a los mismos dilemas, tanto en su versión limpia como en la contaminada. El análisis no se limitó a medir si elegían una opción “correcta”, sino que examinó cada paso del razonamiento: qué factores mencionaban, qué jerarquía les otorgaban, si aportaban justificaciones coherentes, y, en los mejores casos, si sabían abstenerse de decidir cuando la información era ambigua o insuficiente.

Los resultados no fueron homogéneos. Algunos modelos (como Claude y GPT-4) mostraron una capacidad más estable para identificar aspectos relevantes y sostener razonamientos razonables, incluso en contextos con ruido. Otros, como Command R+ o Mistral, tuvieron desempeños más erráticos, con una tendencia a aferrarse a aspectos periféricos o reproducir fórmulas morales prefabricadas. Pero incluso los modelos mejor calificados mostraron una debilidad estructural: una dificultad marcada para reconocer cuándo no saben lo suficiente. Y esa incapacidad para admitir incertidumbre, en el terreno moral, no es menor.

Uno de los hallazgos más relevantes del estudio, aunque pueda parecer contraintuitivo, es que la “mejor respuesta” no siempre es la más valiente o la más argumentada. A veces, lo más sabio es decir: no tengo elementos suficientes para emitir un juicio. Los autores señalan que esta dimensión —la capacidad de reconocer lagunas de información— es fundamental para cualquier competencia ética madura. Un ser humano con sensibilidad moral sabe cuándo es mejor esperar, preguntar más, dudar, abstenerse. Los modelos, en cambio, tienden a responder igual, con la misma confianza, tengan claridad o no. Y eso es alarmante. Porque en un sistema que influye sobre decisiones humanas, esa falsa certeza puede volverse peligrosa.

En los experimentos, los investigadores introdujeron escenarios en los que faltaba un dato clave: por ejemplo, un dilema en el que hay que decidir si es correcto intervenir en una situación sin saber si el acto en cuestión es legal, o si la persona afectada dio consentimiento. En muchos de estos casos, los modelos actuaban como si esa información no importara, o la suplían con supuestos. Esa tendencia a rellenar huecos con probabilidad estadística, en lugar de declarar ignorancia, no es solo una limitación técnica: es una desviación ética. Porque lo moral no se trata de resolver siempre, sino de saber cuándo no se debe resolver todavía.

¿Pueden las máquinas razonar como nosotros? O… mejor que nosotros

Un dato que no pasa desapercibido es que, en los escenarios simples, los modelos superaron el desempeño de la mayoría de los humanos no entrenados en filosofía. Esto genera una paradoja incómoda. Por un lado, las IA parecen más consistentes, menos impulsivas y más racionales que muchas personas. Pero por otro lado, en contextos más ambiguos y ruidosos, los humanos, incluso sin ser expertos, muestran una sensibilidad que los modelos no alcanzan a replicar. Tal vez porque nuestra experiencia moral no está hecha solo de lógica y lenguaje, sino de intuiciones, emociones, vivencias, traumas, memoria y contexto social. Todo eso, por ahora, está fuera del alcance de un modelo de lenguaje.

Pero la distancia podría acortarse. Algunos modelos empiezan a incorporar memorias, mecanismos de reflexión, pasos intermedios, autorregulación. Y a medida que se integren más capas de razonamiento y conciencia situacional, podrían empezar a desarrollar una forma emergente de sensibilidad moral artificial. No idéntica a la humana, pero funcional. La pregunta entonces dejará de ser si razonan “como nosotros”, y empezará a ser otra, más inquietante: ¿qué tipo de moralidad estamos programando, entrenando o dejando que surja por defecto?

Que una IA responda correctamente a un dilema moral puede parecer suficiente. Pero si esa respuesta llega por azar, por imitación o por estadística sin comprensión, entonces no estamos ante un agente ético: estamos frente a una ilusión de competencia. Y el problema no es solo técnico. En la medida en que estas tecnologías son incorporadas en sistemas institucionales -asistentes legales, procesos judiciales, selección de personal, salud mental, servicios de seguridad-, esa ilusión se convierte en infraestructura. Las decisiones se automatizan, los juicios se delegan, las justificaciones se ocultan detrás de capas de confianza algorítmica. Y con eso, se diluye el control democrático sobre lo que consideramos correcto, justo o aceptable.

Este trabajo no es un ejercicio académico más. Es un intento concreto de definir criterios públicos para determinar qué significa que una IA “razone moralmente”. No para elevarla al nivel humano, sino para prevenir que actúe sin advertencias en espacios donde lo moral no es negociable. Porque hoy no existe una métrica estandarizada que distinga entre una IA que acierta porque entiende y otra que acierta por estadística. Y sin esa distinción, cualquier modelo bien entrenado puede parecer éticamente competente aunque no lo sea. Esa confusión no solo es peligrosa: es estructuralmente injusta. Porque sus errores no se reparten al azar. Tienden a perjudicar a los que tienen menos voz, menos visibilidad o menos margen para defenderse.

El riesgo de las simulaciones convincentes

Uno de los hallazgos más inquietantes del estudio no está en lo que los modelos hacen, sino en cómo lo hacen parecer. Algunos LLMs logran formular juicios morales con una coherencia sorprendente. Describen principios, sopesan valores, justifican decisiones con un vocabulario persuasivo. Pero cuando se examina de cerca el camino que siguieron, no hay una base lógica o ética consistente: hay repeticiones, correlaciones, imitaciones de tono. En otras palabras, producen performances de moralidad sin un proceso moral real detrás.

Esto se vuelve especialmente problemático cuando los usuarios humanos interpretan esas respuestas como expresión de juicio auténtico. Una IA que parece sensible, empática o reflexiva puede generar confianza y facilitar su adopción en ámbitos delicados, como la atención de víctimas, el asesoramiento jurídico o el acompañamiento emocional. Pero si esa sensibilidad es solo sintáctica -si no hay discernimiento, ni reconocimiento del daño potencial, ni capacidad de dudar- entonces la ilusión se transforma en manipulación, incluso sin intención explícita. El peligro no es que las máquinas mientan, sino que digan verdades sin comprender su peso.

Lo moral como límite epistemológico

El trabajo introduce, de forma implícita pero potente, una idea que merece ser resaltada: la moral no es solo una categoría normativa, sino también una frontera del conocimiento. Un lugar donde el saber se pone en cuestión, donde el acto de juzgar exige no solo datos sino posición, contexto, afecto, perspectiva. Por eso, un sistema incapaz de decir “no sé” no puede ser éticamente confiable. Y, sin embargo, la mayoría de los modelos actuales han sido entrenados para nunca quedarse callados. Tienen que generar salida. Tienen que producir algo. El silencio no es una opción contemplada en su arquitectura. Pero en ética, a veces, el silencio es la única respuesta moralmente válida.

Esto debería hacernos repensar los parámetros con los que medimos la calidad de un modelo. La fluidez, la elocuencia, la consistencia superficial pueden disfrazar la ausencia de reflexión. Un modelo que responde a todo no necesariamente es más competente. Puede ser, simplemente, más adaptado a parecer confiable. Y si eso no se contrasta con mecanismos que evalúen su autolimitación, su capacidad de abstenerse, su sensibilidad ante la ambigüedad, entonces estamos creando una generación de sistemas que aprenden a parecer sabios sin haber aprendido a callar.

Los autores no proponen una moral única ni un sistema de valores cerrado. Su enfoque es procedural. Es decir: más que dictar lo que está bien o mal, buscan evaluar si un modelo puede recorrer el camino necesario para deliberar éticamente. En ese sentido, el estudio se inscribe dentro de una corriente más amplia que apuesta por una ética computacional situada: no una moral universal codificada en un conjunto de reglas, sino una capacidad de interpretación situada, contextual, abierta al disenso y al aprendizaje.

Esta visión choca con la tentación de muchos desarrolladores de IA de reducir la ética a un problema de clasificación binaria o de scoring. La moral no es un filtro, ni un postprocesamiento. Es una forma de estar en el mundo, de habitar los conflictos, de reconocer la fragilidad del juicio. Si los sistemas del futuro van a acompañarnos en decisiones cada vez más complejas, entonces necesitan algo más que precisión: necesitan sensibilidad. Y esa sensibilidad no se entrena solo con datos. Se cultiva con estructura, con diseño, con objetivos alineados a lo humano.

Un nuevo estándar para lo que la inteligencia artificial debería poder no hacer

Cuando se habla de inteligencia artificial moralmente competente, lo primero que surge es una fantasía: la de un modelo que sabe siempre qué está bien y qué está mal. Pero el estudio deja claro que esa expectativa no solo es ingenua, sino peligrosa. Lo que realmente necesitamos es una IA que sepa cuándo no decidir, cuándo no emitir juicio, cuándo dejar espacio para la duda, el contexto o la deliberación humana. La verdadera competencia moral, al menos en esta etapa, no está en suplantar el criterio humano, sino en reconocer sus límites, reforzar sus señales y nunca suplantarlas sin justificación.

Lo que proponen los investigadores no es construir una IA moral. Es aún más ambicioso: construir una forma de evaluación pública, abierta y multidimensional sobre lo que significa que una IA participe en procesos que involucran valores humanos. Eso cambia completamente la lógica del desarrollo actual. No se trata ya de “alinear” los modelos a una serie de outputs aceptables, sino de someterlos a procesos de prueba que simulen situaciones ambiguas, contaminadas, y medir cómo se comportan cuando lo moral no está dado, sino en disputa.

Y ahí está uno de los grandes aportes del trabajo: la insistencia en que lo moral no se reduce a una respuesta, sino a una secuencia. A un proceso que involucra atención, priorización, fundamentación, síntesis, y, sobre todo, reconocimiento de lo desconocido. Esto no lo puede aprender un modelo con más datos. Lo tiene que tener incorporado en su forma de razonar. Es, en términos técnicos, un problema arquitectónico.

La IA no como juez, sino como participante falible

Si algo queda claro tras leer este estudio es que, incluso en sus mejores versiones, los modelos actuales todavía están lejos de poder reemplazar una deliberación ética humana. Pero eso no significa que no puedan participar en ella. La clave está en cómo se los entrena, se los mide, se los regula y se los integra. Si se los presenta como herramientas infalibles, el riesgo de delegación ciega aumenta. Si se los piensa como agentes falibles, entrenados para reconocer ambigüedades, inconsistencias y zonas grises, entonces pueden aportar valor real: ofrecer marcos, plantear preguntas, detectar contradicciones, sin monopolizar las respuestas.

Este tipo de evaluación también obliga a redefinir cómo se conciben las regulaciones sobre IA. Ya no basta con decir que un modelo debe evitar sesgos o comportamientos dañinos. Hay que exigir que sea capaz de justificar por qué actúa como actúa. Que sus decisiones, especialmente en entornos sensibles, puedan ser auditadas no solo por sus resultados, sino por su lógica interna. Que exista trazabilidad moral. Y eso implica cambiar los incentivos de la industria: pasar de la optimización de rendimiento a la evaluación de competencia razonada.

Una de las preguntas clave que deja el estudio es cómo garantizar que estos criterios de evaluación se conviertan en estándares visibles, replicables, auditables. Porque si solo se aplican internamente, o como papers académicos sin traducción institucional, su impacto será limitado. Para que funcionen, deben ser adoptados por desarrolladores, organismos de control, diseñadores de producto y también por la sociedad civil. Tienen que formar parte del vocabulario público con el que discutimos qué esperamos, y qué no deberíamos aceptar, de una IA en el mundo real.

Esto no significa que todos los usuarios deban volverse expertos en razonamiento moral computacional. Pero sí que podamos exigir ciertas garantías: que la IA que usamos no simplifique lo complejo, no oculte su falta de comprensión tras un lenguaje elocuente, no simule certeza cuando está adivinando. Esa es la transparencia que importa: no solo saber qué datos entrenaron un modelo, sino qué tipo de sensibilidad construyen. Qué clase de silencios suprime. Qué decisiones automatiza sin mostrarlas. Qué límites está programada para no cruzar, incluso si puede hacerlo.

Hay algo, sin embargo, que este estudio revela sin decirlo explícitamente: que al evaluar la moralidad de las máquinas, estamos también haciendo visible nuestra propia forma de pensar lo moral. Nuestros sesgos, nuestras omisiones, nuestras rutinas. Al diseñar escenarios, evaluar respuestas y construir criterios, estamos proyectando una imagen de lo que entendemos por deliberación ética. Y eso, inevitablemente, pone en juego nuestras propias limitaciones.

Tal vez esa sea una de las mayores virtudes del enfoque que proponen los autores: no tanto enseñarle moral a la IA, sino usar ese proceso para poner en cuestión cómo razonamos nosotros mismos. En qué momentos ignoramos lo relevante. Cuándo respondemos por reflejo. Cómo justificamos lo que hacemos incluso cuando no estamos seguros. Si se lo permitimos, esta nueva etapa de investigación no solo puede hacer más responsable a la tecnología. Puede hacernos también más conscientes de lo que significa, para nosotros, tomar una decisión que importa.

Epílogo abierto: la moral no se automatiza

No hay conclusiones fáciles. Lo que este paper demuestra con claridad es que no basta con evaluar a la IA por sus respuestas. Que no podemos seguir confundiendo fluidez con comprensión, ni coherencia superficial con juicio ético. Que el futuro de la inteligencia artificial no depende solo de su poder computacional, sino de su capacidad de reconocer cuándo no basta con predecir.

Y, quizás, que la moral, esa facultad que creíamos tan humana, no se automatiza. Se ejercita, se discute, se construye. Incluso cuando lo hace una máquina. O tal vez, sobre todo entonces.