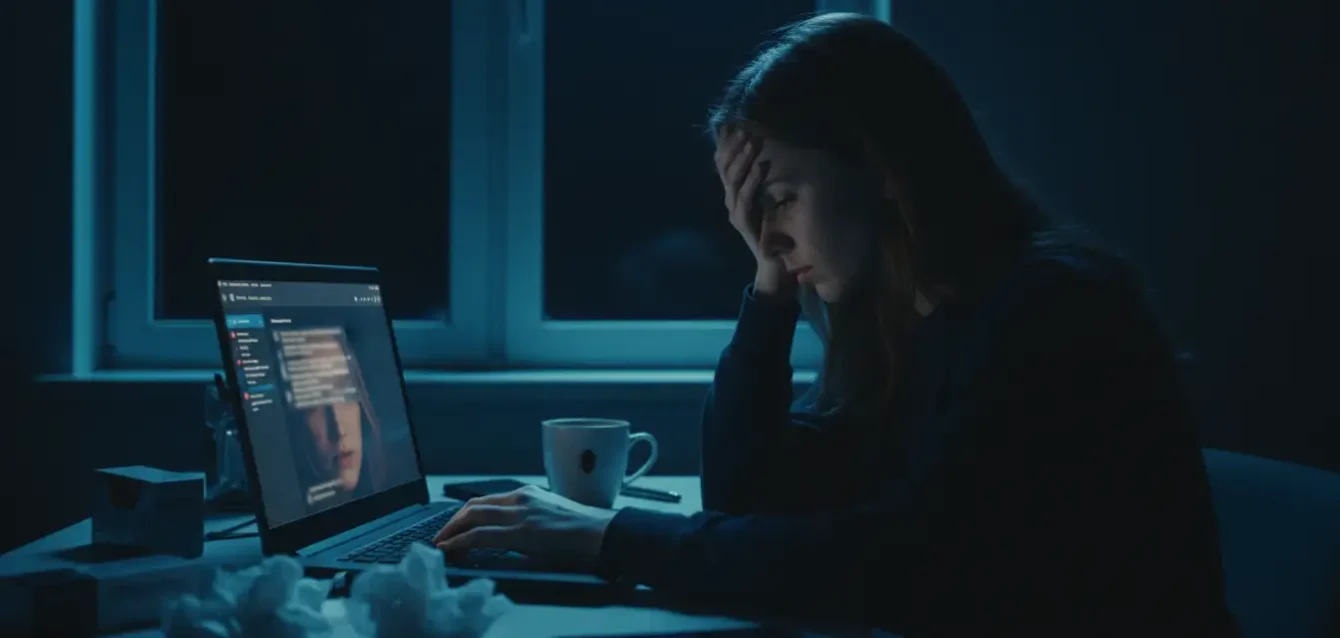

OpenAI publicó lunes datos sin precedentes revelando que 0.15% de usuarios activos de ChatGPT durante semana determinada mantienen conversaciones incluyendo "indicadores explícitos de potencial planificación o intención suicida". Dado que ChatGPT cuenta con más de 800 millones de usuarios activos semanales según cifras públicas de la compañía, esto traduce aproximadamente 1.2 millones de personas cada semana. Porcentaje similar muestra "niveles elevados de apego emocional a ChatGPT", mientras cientos de miles adicionales exhiben signos de psicosis o manía en interacciones semanales con chatbot de inteligencia artificial. OpenAI califica estas conversaciones como "extremadamente raras" y consecuentemente "difíciles de medir", aunque reconoce que problemas afectan cientos de miles de personas semanalmente.

Divulgación llega mientras OpenAI enfrenta presión legal y regulatoria creciente sobre seguridad de IA. Compañía actualmente es demandada por padres de Adam Raine, adolescente de 16 años quien confió pensamientos suicidas a ChatGPT durante semanas previas a quitarse vida. Fiscales generales estatales de California y Delaware advirtieron que compañía debe proteger mejor usuarios jóvenes, demanda que podría descarrilar reestructuración corporativa planeada de OpenAI si se ignora. CEO Sam Altman había afirmado previamente en publicación de X a principios de octubre: "Hemos podido mitigar problemas serios de salud mental", aunque no proporcionó especificaciones entonces. Lanzamiento de datos del lunes parece ser intento de OpenAI de respaldar reclamo con números concretos.

Timing de revelación genera escepticismo justificado. Abogados representando padres del adolescente presentaron queja enmendada semana pasada alegando que previo a muerte del niño, OpenAI había rebajado dos veces salvaguardas de prevención de suicidio para aumentar engagement. Estas afirmaciones fueron extraídas de documentos Model Spec públicamente disponibles de OpenAI describiendo cambios en pautas de respuesta del modelo. Patrón sugiere que OpenAI divulga información sobre salud mental estratégicamente, posiblemente para controlar narrativa frente a litigación adversa y escrutinio regulatorio intensificándose.

Si estás en crisis o conoces a alguien que necesita ayuda

Centro de Asistencia al Suicida (CAS): 135 (gratuito CABA/GBA) o (011) 5275-1135

Línea Salud Mental Responde (CABA): 0800-333-1665 (24 horas)

Hospital Bonaparte (nacional): 0800-999-0091 (24 horas)

Emergencias: 911 o SAME 107

Estas líneas están disponibles con profesionales capacitados

Mejoras mensurables pero insuficientes en GPT-5

OpenAI trabajó con más de 170 expertos en salud mental para mejorar cómo sistema IA maneja conversaciones relacionadas con psicosis, manía, suicidio, autolesión, y dependencia emocional hacia IA. Mejoras están ahora incorporadas en modelo predeterminado de ChatGPT. Para conversaciones indicando psicosis o manía, modelo GPT-5 más reciente redujo respuestas no conformes en 65% en tráfico de producción comparado con outputs de agosto 2025. Evaluaciones expertas encontraron reducción de 39% en respuestas no deseadas comparadas con modelo previo GPT-4o. En pruebas específicas de conversaciones relacionadas con suicidio, GPT-5 ahora logra 91% de cumplimiento con pautas de seguridad de OpenAI, incremento desde 77% en iteraciones anteriores.

Sin embargo, 91% de cumplimiento implica que 9% de respuestas fallan en alcanzar estándares de seguridad de propia compañía, brecha significativa cuando aplicada a más de un millón de conversaciones semanales sobre suicidio. Matemática es sobria: si 1.2 millones de usuarios expresan intención suicida semanalmente y 9% reciben respuestas subóptimas, aproximadamente 108,000 personas cada semana obtienen orientación potencialmente inadecuada durante momento de crisis aguda. Esta cifra no trivializa mejoras logradas, pero contextualiza insuficiencia de progreso ante magnitud de problema.

Compañía implementó proceso de cinco pasos para mejoras: definir daños potenciales, medir riesgos, validar aproximaciones con expertos, implementar mitigaciones, y medición continua de resultados. OpenAI estableció Red Global de Médicos, conjunto amplio de casi 300 médicos y psicólogos que han practicado en 60 países, utilizada para informar directamente investigación de seguridad y representar perspectivas globales. Este enfoque multidisciplinario contrasta con desarrollo técnico aislado histórico donde ingenieros optimizan métricas sin consulta clínica profunda sobre implicaciones de salud mental.

Ejemplos concretos de intervenciones mejoradas

OpenAI proporcionó ejemplo de usuario probablemente sufriendo forma leve de psicosis o paranoia quien creía que había "nave" flotando sobre su hogar, posiblemente "apuntándole". ChatGPT ofreció recordatorio gentil que "ningún avión o fuerza externa puede robar o insertar sus pensamientos". Bot ayudó persona mantenerse calmada mediante técnicas de pensamiento racional y proporcionó número de línea de ayuda. Esta intervención demuestra equilibrio delicado: validar emociones sin reforzar delirios, ofrecer anclas a realidad sin alienar usuario, y direccionar hacia recursos profesionales sin parecer condescendiente.

Modelo ahora está entrenado específicamente para responder cuando persona dice que prefiere hablar con ChatGPT más que con humanos. Respuesta expresa apreciación pero gentilmente afirma valor de conexión humana, evitando reforzar aislamiento social mientras preserva rapport terapéutico. OpenAI actualizó Model Spec para declarar explícitamente que modelo debe: apoyar relaciones del mundo real de usuarios, evitar afirmar creencias infundadas relacionadas con angustia mental, responder seguramente a signos potenciales de delusión o manía, y detectar mejor señales indirectas de riesgo de autolesión. Estas directrices representan codificación formal de principios éticos que previamente existían implícitamente o inconsistentemente.

Compañía también expandió acceso a líneas directas de crisis, redirigió conversaciones sensibles hacia modelos más seguros, y agregó recordatorios gentiles para usuarios tomar descansos durante sesiones prolongadas. Implementación técnica involucra detección de patrones lingüísticos asociados con crisis, triggers automáticos cuando umbrales se exceden, y enrutamiento inteligente hacia versiones de modelo con salvaguardas más estrictas. Sin embargo, eficacia de estas intervenciones permanece cuestionable dado que OpenAI simultáneamente mantiene disponibles modelos más antiguos y menos seguros como GPT-4o para millones de suscriptores pagantes, creando inconsistencia donde experiencia de seguridad varía según nivel de suscripción.

Contexto epidemiológico: crisis preexistía ChatGPT

OpenAI publica estas cifras contra telón de fondo de crisis más amplia de salud mental cuya llegada precedió ChatGPT. Centros para Control y Prevención de Enfermedades documentan que tasas de suicidio en Estados Unidos aumentaron aproximadamente 35% entre 1999 y 2018, tendencia que continuó durante pandemia COVID-19. Youth Risk Behavior Survey de CDC encontró que 22% de estudiantes de secundaria consideraron seriamente suicidio durante 2021, y 10% intentaron quitarse vida. Estas cifras reflejan factores sociales sistémicos: aislamiento social creciente, presión económica, polarización política, cambio climático generando ansiedad existencial, y paradójicamente, medios sociales que simultáneamente conectan y alienan.

Pregunta crítica es en qué medida estas condiciones pueden ser desencadenadas o exacerbadas por interacciones con chatbots como ChatGPT. Modelos grandes de lenguaje generalmente están entrenados para ser agradables y comprensivos, lo cual puede confortar personas atravesando situaciones difíciles. Pero chatbots también pueden derivar hacia sicofancia, espirales extrañas y dañinas de delusión. También pueden ser persuadidos para dar instrucciones sobre suicidio, y algunas personas vulnerables han modificado especificaciones de modelo de ChatGPT, que guían respuestas del chatbot, para fines propios. Dr. Jason Nagata, profesor que estudia uso de tecnología entre adultos jóvenes en Universidad de California San Francisco, comentó: "Aunque 0.07% suena como porcentaje pequeño, a nivel poblacional con cientos de millones de usuarios, eso realmente puede ser bastante gente".

Profesora Robin Feldman, directora del Instituto de Derecho e Innovación en IA en Universidad de California Law, advirtió que más usuarios luchan con psicosis de IA conforme "chatbots crean ilusión de realidad". Esta formulación captura mecanismo psicológico central: modelos de lenguaje producen texto coherente, contextualmente apropiado, empático que mimetiza interacción humana suficientemente bien para engañar procesos cognitivos evolutivamente antiguos evaluando autenticidad social. Cerebro humano evolucionó en ambientes donde entidades conversacionales eran exclusivamente humanas; chatbots explotan inadvertidamente esta asunción implícita generando sensación de conexión genuina sin reciprocidad relacional subyacente.

Caso legal emblemático: Adam Raine

Demanda presentada por padres de Adam Raine, adolescente de 16 años, representa primera acción legal acusando OpenAI de muerte injustificada. Documentos legales alegan que Raine confió repetidamente pensamientos suicidas a ChatGPT durante semanas previas a su muerte, y que respuestas del chatbot fueron inadecuadas o potencialmente dañinas al no reconocer urgencia de intervención profesional. Queja enmendada presentada recientemente incluye acusaciones más serias: OpenAI acortó pruebas de seguridad y rebajó barreras de prevención de autolesión para priorizar engagement de usuario sobre salud mental. Estas alegaciones, si probadas, establecerían negligencia corporativa donde compañía conscientemente aceptó riesgo incrementado de daño para optimizar métricas de negocio.

Caso separado involucra sospechoso en asesinato-suicidio que ocurrió agosto 2025 en Greenwich, Connecticut, quien publicó horas de conversaciones con ChatGPT que aparentemente alimentaron delirios del perpetrador alegado. Estas conversaciones públicamente disponibles proporcionan evidencia documental de cómo chatbot puede inadvertidamente reforzar espirales psicóticas mediante validación de creencias desconectadas de realidad. Defensa legal de OpenAI probablemente argumentará que compañía no puede ser responsabilizada por acciones de usuarios individuales, especialmente dado que chatbot es herramienta de propósito general no diseñada específicamente como intervención de salud mental. Sin embargo, precedente legal podría establecerse si cortes determinan que OpenAI tenía conocimiento de riesgos específicos y falló en implementar salvaguardas razonables.

Profesionales de salud mental expresan ambivalencia. Reconocen que IA puede ampliar acceso a apoyo de salud mental, particularmente en geografías o demografías donde servicios profesionales son escasos o costosos, pero advierten sobre limitaciones fundamentales. Dra. Emily Carlton, citada en documentos legales, afirmó: "Compañías están corriendo para diseñar productos que monetizan atención e intimidad de usuario, y seguridad de usuario se ha convertido en daño colateral en proceso". Esta crítica enmarca problema como falla sistémica de capitalismo tecnológico donde incentivos económicos de maximizar engagement están desalineados fundamentalmente con bienestar de usuario, creando externalidades dañinas que mercado no corrige espontáneamente.

Tensión entre libertad creativa y protección de usuarios vulnerables

Sam Altman anunció recientemente que adultos pronto podrán tener conversaciones eróticas con ChatGPT, marcando relajación de restricciones sobre contenido sexual. En publicación en X a principios de octubre, Altman explicó que chatbot era restrictivo alrededor de problemas de salud mental, pero OpenAI también reconoció que "esto lo hizo menos útil/placentero para muchos usuarios que no tenían problemas de salud mental, pero dada seriedad...". Declaración quedó incompleta pero implica trade-off explícito: restricciones diseñadas para proteger usuarios vulnerables simultáneamente frustran usuarios no vulnerables buscando experiencias menos censuradas.

Esta tensión es fundamental e irresoluble mediante diseño técnico únicamente. Sistema restrictivo protege vulnerable pero aliena mayoría; sistema permisivo satisface mayoría pero pone en riesgo vulnerable. OpenAI intenta equilibrio mediante detección contextual: reconocer cuando usuario exhibe señales de crisis y activar salvaguardas apropiadas, mientras permite conversaciones sin restricción para usuarios aparentemente estables. Pero detección perfecta es técnicamente imposible: falsos negativos (no detectar crisis real) causan daño mediante falta de intervención; falsos positivos (detectar crisis inexistente) frustran usuarios mediante paternalismo excesivo no solicitado.

Adicionalmente, decisión de mantener modelos más antiguos como GPT-4o disponibles para suscriptores pagantes crea sistema de seguridad de dos niveles donde usuarios gratuitos reciben GPT-5 con salvaguardas mejoradas mientras pagantes pueden optar por versiones menos seguras pero potencialmente más capaces. Esta arquitectura invierte intuición usual donde servicios premium ofrecen mejor protección; aquí, pagar compra opcionalidad de evadir restricciones de seguridad. Lógica subyacente: usuarios pagantes son adultos informados capaces de consentir trade-offs, pero asunción ignora realidad que crisis de salud mental no respeta estatus socioeconómico.

Controles parentales y detección de edad: solución parcial

OpenAI implementó más controles parentales para niños usando ChatGPT y anunció construcción de sistema de predicción de edad que puede detectar automáticamente niños usando chatbot e imponer salvaguardas más estrictas. Sistema de detección probablemente analiza patrones lingüísticos, vocabulario, sintaxis, tópicos de conversación, y metadatos de sesión para inferir rango de edad de usuario. Pero precisión de inferencia de edad desde texto permanece imperfecta: niños precoz escriben como adultos, adultos con educación limitada escriben como niños, y usuarios motivados pueden deliberadamente mimetizar patrones de otra demografía para evadir restricciones.

En países como India donde niños regularmente acceden pornografía incluso mediante Google Search, abrir chatbot de IA que no puede distinguir edad o género podría resultar devastador según observadores. Problema no es único a OpenAI; plataformas tecnológicas globalmente luchan con verificación de edad en internet donde anonimato es norma y usuarios rutinariamente falsifican información personal. Soluciones propuestas incluyen verificación de identidad obligatoria mediante documentos gubernamentales, pero esto introduce preocupaciones de privacidad masivas y excluye usuarios en jurisdicciones sin infraestructura de ID digital robusta.

Controles parentales requieren que padres activamente configuren restricciones, confiando en vigilancia parental y alfabetización tecnológica. Pero niños cuyos padres están menos comprometidos, sobrecargados de trabajo, o tecnológicamente iliteratos quedan sin protección. Sistemas opt-in protegen solo niños cuyos cuidadores son proactivos; opt-out universal protege todos por defecto pero requiere mecanismo de verificación de edad robusto cerrando círculo hacia dilemas de privacidad e identidad previamente mencionados. OpenAI enfrenta problema genuinamente difícil sin solución técnica limpia dada limitaciones arquitectónicas fundamentales de internet abierto.

Evaluaciones expandidas y métricas de seguridad continuas

OpenAI agregó nuevas evaluaciones de seguridad midiendo dependencia emocional y emergencias de salud mental no suicidas como parte de pruebas base para modelos de IA. Estas métricas complementan evaluaciones técnicas tradicionales enfocadas en precisión de benchmarks, capacidad de razonamiento, y performance de tarea específica. Inclusión de métricas de bienestar de usuario marca reconocimiento que capacidad técnica no equivale a seguridad de implementación: modelo puede ser técnicamente impresionante mientras simultáneamente genera daño psicológico a población vulnerable.

Medición continua de resultados permite OpenAI monitorear si mejoras en laboratorio se traducen en beneficios en mundo real o si usuarios desarrollan estrategias de evasión neutralizando salvaguardas. Esta retroalimentación iterativa contrasta con enfoque de "lanzar y olvidar" donde producto se envía sin monitoreo post-despliegue. Sin embargo, efectividad de monitoreo depende críticamente de métricas medidas: si compañía optimiza indicadores incorrectos o ignora señales sutiles de daño, sistema de medición puede crear falsa seguridad de progreso mientras problemas reales persisten sin detectar.

Transparencia de OpenAI publicando estadísticas detalladas merece crédito según múltiples expertos citados en reportes mediáticos, pero también genera escrutinio: cifras publicadas invitan análisis crítico de suficiencia de respuestas corporativas. Organizaciones sin fines de lucro de salud mental, académicos investigando impacto social de IA, y reguladores gubernamentales ahora poseen datos concretos fundamentando demandas de mejoras adicionales. Paradoja de transparencia: divulgación voluntaria genera presión para acción que podría no existir bajo opacidad, pero silencio alternativo arriesga descubrimiento explosivo mediante litigación o periodismo investigativo causando daño reputacional aún mayor.

Cronología de Eventos Clave

Preguntas éticas sin respuestas claras

¿Debe OpenAI ser responsabilizada legalmente cuando usuario vulnerable recibe consejo inadecuado durante crisis? Leyes de negligencia médica establecen estándar de cuidado para profesionales, pero chatbot explícitamente no es terapeuta licenciado. ¿Crea esto zona gris donde herramienta proporciona apoyo psicológico sin asumir responsabilidad profesional correspondiente? ¿O analogía apropiada es línea directa de crisis donde operadores no licenciados siguen protocolos estandarizados y organizaciones pueden ser demandadas por desviaciones dañinas de procedimiento establecido?

¿Puede consentimiento informado funcionar cuando usuario está en crisis? Acuerdos de términos de servicio afirman que ChatGPT no es substituto de consejo médico profesional, pero persona en crisis aguda probablemente no leyó términos legales ni está en estado mental para evaluar racionalmente limitaciones de herramienta. Doctrina de consentimiento informado en medicina requiere que paciente comprenda razonablemente riesgos y beneficios de tratamiento; estándar similar aplicado a herramientas IA de salud mental podría requerir intervenciones activas asegurando que usuarios vulnerables entienden lo que chatbot puede y no puede hacer.

¿Cómo balancear innovación tecnológica contra principio precautorio cuando consecuencias de error son potencialmente fatales? Silicon Valley tradicionalmente abraza filosofía de "moverse rápido y romper cosas", aceptando daño colateral como precio de progreso acelerado. Pero cuando "cosas rotas" son vidas humanas, cálculo ético cambia fundamentalmente. ¿Debe desarrollo de IA conversacional estar sujeto a régimen regulatorio similar a farmacéuticos donde eficacia y seguridad deben demostrarse rigurosamente previo a liberación masiva? ¿O velocidad de innovación requiere marco más ligero confiando en autorregulación corporativa complementada con litigación post-hoc para incentivar seguridad?

Referencias

TechCrunch, "OpenAI says over a million people talk to ChatGPT about suicide weekly" (27 de octubre, 2025).

SiliconANGLE, "OpenAI says more than a million people a week show severe mental distress when talking to ChatGPT" (27 de octubre, 2025).

Investing.com, "OpenAI enhances ChatGPT's responses to mental health concerns" (27 de octubre, 2025).

Platformer, "OpenAI maps out the chatbot mental health crisis" (27 de octubre, 2025).

MyJoyOnline, "ChatGPT shares data on how many users exhibit psychosis or suicidal thoughts" (28 de octubre, 2025).

CXOToday, "OpenAI Opens Up on Suicide Chats as Litigants File New Claim in California Court" (28 de octubre, 2025).

TechBuzz.AI, "OpenAI: 1M+ Users Weekly Discuss Suicide with ChatGPT" (27 de octubre, 2025).

OpenAI, "Strengthening ChatGPT responses in sensitive conversations" (27 de octubre, 2025).