El anuncio de Haiku 4.5 llega con un mensaje sencillo y contundente. Anthropic no intenta deslumbrar con un récord de laboratorio, intenta ganar la batalla de la adopción diaria. Presenta un modelo pequeño que promete latencias muy bajas, precio agresivo y un rendimiento que, según la compañía y sus socios, se acerca al de una gama media en tareas clave de programación, operación de computadoras y ejecución de agentes. El objetivo es claro. Si la experiencia es fluida, si cada respuesta llega antes de que el usuario pierda el hilo y si el costo por interacción queda en centavos, los pilotos se transforman en productos y los MVP se convierten en operaciones.

La lógica de producto se entiende en dos números. Un precio por millón de tokens de entrada que presiona a la baja el costo variable y una tarifa por salida que permite diseñar servicios de alto volumen sin sobresaltos presupuestarios. Esa combinación habilita un abanico de casos de uso que hasta hace poco quedaban en pruebas internas. Atención al cliente con picos estacionales, asistentes conversacionales en tiempo real, soporte técnico con lectura de imágenes y síntesis, workflows que llaman a herramientas varias veces por turno. En todos ellos, la fricción está donde más duele. Latencia y presupuesto.

La disponibilidad inmediata en proveedores de nube y plataformas de desarrollo cierra el círculo. Al aparecer en catálogos empresariales con soporte para visión y regiones múltiples, Haiku 4.5 reduce la distancia entre anuncio y uso. Equipos de ingeniería que ya trabajan con agentes y herramientas pueden sustituir un modelo intermedio sin reescribir integraciones. Un responsable de producto de una fintech regional, consultado para esta crónica, lo describe de forma pragmática. Si el tiempo de respuesta baja lo suficiente y la precisión se mantiene, el costo por ticket resuelto cae. Si además el modelo entiende capturas de pantalla y documentos, el flujo de resolución acelera. La promesa no es épica, es medible.

Qué cambia en la práctica con un modelo así

La novedad real está en el balance de tres variables. Costo, velocidad y calidad. La industria ya probó que modelos más grandes pueden razonar mejor en pruebas académicas. Lo que busca Haiku 4.5 es otra cosa. Que una consulta típica de soporte no se demore, que una sugerencia de código aparezca al ritmo de escritura, que un agente con varias llamadas a herramientas no se perciba torpe. Cuando el cuello de botella es la latencia, cada décima de segundo altera la percepción del usuario. Cuando la barrera es el presupuesto, cada punto de precio libera o frena el despliegue masivo.

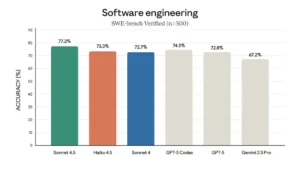

La comparación con modelos de la propia casa ordena el mapa. Haiku se posiciona por debajo de Sonnet en costo, pero compite de cerca en tareas aplicadas. Si en programación asistida, búsqueda de errores y refactorización la diferencia de calidad no se traduce en menos reescrituras, la balanza se inclina por el modelo más barato y veloz. En control de computadoras y agentes orientados a operaciones, la promesa es sostener cadenas de acciones con consistencia, administrar contexto sin sobresaltos y ofrecer resultados estables. El punto no es brillar en una tabla, es mantener un ritmo fiable durante miles de sesiones concurrentes.

Hay, además, un detalle operativo con impacto directo. La compatibilidad con visión. Para automatizar procesos del mundo real, la lectura de documentos, recibos, pantallas y señales visuales ya no es un plus. Es condición. Un agente que ve, interpreta y actúa reduce pasos manuales y acorta la distancia entre ingreso de información y decisión. En sectores como seguros, comercio electrónico y logística, esa capacidad se traduce en minutos menos por caso y en decisiones más homogéneas. Si la suma de latencia baja, precio contenido y visión aceptable se confirma en producción, el incentivo para mover cargas de trabajo a Haiku 4.5 es inmediato.

La infraestructura hace su parte. Las ventanas de contexto amplias en el ecosistema de Anthropic y la oferta de las nubes asociadas permiten absorber manuales, historiales de conversación y estados intermedios sin fracturar la tarea en segmentos. No se trata de buscar el récord de tokens, sino de sostener el hilo de una interacción compleja sin perder memoria. Para equipos que ya usan herramientas, ese detalle evita trampas silenciosas. Repeticiones innecesarias, pérdidas de estado, costos ocultos de volver a inyectar información.

Dónde encaja frente a la competencia y qué dudas persisten

Un modelo barato con rendimiento de gama media altera incentivos. Para ingeniería, habilita sustituciones en flujos de coding y pruebas unitarias sin tocar arquitectura. Para producto, elimina fricciones en asistentes que dependen de varias llamadas API por turno. Para finanzas, simplifica la proyección de gasto porque cada interacción consume pocos miles de tokens y los precios son claros. Este encuadre presiona a rivales que cobran más por tareas donde la mejora marginal de calidad no se traduce en valor tangible.

La integración temprana en plataformas populares acelera el ciclo. Cuando aparece en herramientas de desarrollo y suites empresariales, la discusión pasa de la curiosidad a la línea de producción. Un responsable de data en una cadena minorista lo resume en una frase seca. Si el modelo responde en medio segundo y cuesta la mitad, no necesito ver otro dashboard. Necesito un plan de migración. Esa mentalidad explica por qué las tasas de adopción de los últimos trimestres favorecieron a proveedores con catálogos claros y SLAs consistentes.

Persisten interrogantes técnicos que definirán el lugar de Haiku 4.5 en el mapa. La eficiencia de estrategias de caching para prompts repetidos puede reducir el costo efectivo de operación de forma significativa. La forma en que el modelo maneja contextos extensos con ruido real, como historiales largos con información contradictoria, también pondrá a prueba su consistencia. La estabilidad en tareas multimodales, cuando la imagen o la captura de pantalla trae artefactos y recortes, es otro punto de verificación. En producción, los matices importan. Un pequeño incremento en tasa de respuestas útiles por encima del umbral de aceptabilidad cambia la cuenta final.

La gobernanza del ciclo de vida de los prompts y herramientas es otro frente poco glamoroso, pero crítico. Cuando una organización construye agentes que consultan bases internas, ejecutan acciones y devuelven resultados, el modelo es una pieza en una cadena donde cualquier latencia extra o error de interpretación provoca cascadas. La pregunta de fondo es si Haiku 4.5 mantiene un comportamiento previsible bajo presión. Un ejecutivo de operaciones de una empresa de software empresarial lo explica sin metáforas. Prefiero un modelo que acierte sin sorpresas a uno que a veces brille y a veces se pierda. Si la variabilidad baja, el costo de control también.

El telón de fondo empresarial ofrece contexto adicional. Anthropic lleva meses empujando una narrativa de fiabilidad y foco corporativo. Acuerdos con grandes nubes, integraciones en herramientas de trabajo y una línea 4.5 que estandariza comportamientos apuntan al mismo lugar. La compañía quiere que sus clientes la recuerden por operaciones estables tanto como por avances de laboratorio. En ese marco, Haiku 4.5 es la llave de entrada. El caballo de batalla que hace posible que un área de negocio adopte IA sin convertir cada sprint en un experimento.

Qué significa para 2026 si las promesas se cumplen

Si los números de precio y latencia se verifican en producción, la consecuencia más inmediata será un corrimiento de cargas de trabajo hacia modelos pequeños y veloces. El patrón ya se vio en ciclos anteriores. Primero llega la fascinación con lo más grande, luego la disciplina de costos y, finalmente, el retorno a lo que resuelve el 80 por ciento de los casos con menos fricción. Haiku 4.5 encaja en ese tercer momento. No se vende como genio, se vende como confiable. La diferencia no es menor. Para quien planifica un presupuesto anual, previsibilidad gana.

La segunda derivada pasa por la arquitectura de producto. Con un modelo así, se vuelve más natural diseñar experiencias basadas en agentes que se reparten tareas, llaman herramientas y consultan bases especializadas. No hace falta escalar a un modelo gigantesco para cada paso. Un orquestador que decide y un motor rápido que ejecuta resuelven la mayoría de los flujos. El resultado son aplicaciones más ágiles, con costos controlados y con menos puntos de falla.

El tercer efecto toca la competencia. Si un actor ofrece respuestas suficientes a bajo costo y con latencia mínima, obliga a los demás a justificar su prima de precio. Lo harán con ventanas de contexto gigantes, con razonamiento más fino en dominios exigentes o con integraciones verticales. Habrá espacio para todo. Pero en el centro del mercado, donde viven las operaciones diarias, la vara quedará donde Haiku 4.5 la fija hoy. Rápido, barato y suficientemente bueno para no interrumpir el trabajo.

La conclusión no se sostiene en un efecto sorpresa. Se apoya en una ecuación que las áreas de producto conocen de memoria. Cuando cae la latencia, sube el uso. Cuando baja el precio, se habilitan más casos. Cuando la calidad se mantiene dentro de lo aceptable, la adopción se acelera. Si Haiku 4.5 cumple con esos tres puntos en entornos reales y los socios sostienen el servicio sin sobresaltos, el modelo tiene condiciones para convertirse en la opción por defecto para 2026 en empresas que buscan IA útil, previsible y barata. No es una promesa grandilocuente. Es una hoja de ruta para que la IA deje de ser demo y se convierta en rutina.