Vivimos un renacimiento de la inteligencia artificial que desafía nuestra percepción de lo posible. Cada pocas semanas, somos testigos de demostraciones asombrosas: sistemas que generan videos fotorrealistas a partir de una simple frase, asistentes que conversan con una fluidez y emotividad casi humanas, e inteligencias capaces de analizar en segundos vastos genomas o complejas dinámicas bursátiles. Estas proezas, impulsadas por gigantes como OpenAI, Google y Anthropic, han cimentado la creencia popular de que estamos rozando la "inteligencia artificial general", una mente sintética con una capacidad de comprensión análoga, o superior, a la nuestra.

Pero en el corazón de la investigación científica, una pregunta mucho más profunda e incómoda persiste: ¿cuánto de esto es auténtica comprensión y cuánto es, en realidad, un espejismo estadístico? ¿Estas máquinas realmente "entienden" el mundo, o son simplemente los loros más sofisticados de la historia, capaces de imitar patrones con una precisión sobrehumana sin capturar la esencia de la lógica, la causalidad o el simple sentido común?

En este tenso debate entre la percepción pública y el rigor científico, un nuevo estudio ha caído como una piedra en un lago en calma. Un extenso equipo de investigadores, afiliados a instituciones de vanguardia como Deep Wisdom, la Universidad de Tsinghua y el Laboratorio de Inteligencia Artificial de Shanghai, ha publicado un trabajo que funciona como un necesario cable a tierra. Su investigación, titulada "Reasoning via Video" (Razonando a través del video), no presenta un modelo nuevo y más brillante. Presenta algo mucho más valioso: un espejo. Un espejo en forma de laberinto.

El concepto es tan elegante como demoledor. Los investigadores decidieron obviar las tareas habituales de la IA, como describir un paisaje o resumir una reunión. En su lugar, se centraron en una de las formas más puras de razonamiento: la navegación y la planificación espacial. Para ello, crearon un universo de prueba digital llamado VR-Bench (Video Reasoning Benchmark), una plataforma que genera proceduralmente miles de laberintos en tres dimensiones.

La tarea impuesta a las inteligencias artificiales más potentes del momento no era jugar o resolver el laberinto. Era algo que, en teoría, debería ser más sencillo: simplemente ver un video de un "agente" (pensemos en una bola o un avatar) navegando con éxito el laberinto, y, al finalizar, explicar la lógica del recorrido. Las IA debían reconstruir la secuencia de acciones (arriba, izquierda, abajo, derecha...) que llevaron al éxito. En esencia, no se les pedía ser el piloto, sino el copiloto que entiende el mapa.

Para asegurar que la prueba midiera el razonamiento y no la simple memorización de patrones, el entorno de prueba incluía no solo laberintos 2D simples y otros con topología irregular, sino también laberintos en 3D con múltiples niveles, laberintos con trampas que reiniciaban al agente (probando la memoria y la evitación de peligros) y, como desafío final, el clásico puzzle lógico conocido como Sokoban. Este último es crucial: el agente debe empujar cajas a lugares específicos. Un movimiento en falso puede bloquear el camino para siempre. Sokoban no es solo navegación; es una prueba pura de planificación y razonamiento causal, la comprensión de que una acción tiene consecuencias irreversibles en el entorno.

Los resultados, publicados en el repositorio científico arXiv, son inequívocos y profundamente reveladores. Los titanes de la industria, incluyendo a GPT-4o, Gemini 1.5 Pro y Claude 3 Opus, fracasaron de manera espectacular. En un desafío que un niño humano podría resolver con facilidad tras unos momentos de observación, los modelos de video más avanzados del planeta demostraron no tener una comprensión espacial, causal o lógica del mundo que estaban observando. El estudio no solo expone una grieta en la armadura de la IA moderna; revela un abismo fundamental entre la percepción y la comprensión.

El abismo entre ver y comprender

La generación actual de lo que se conoce como "Modelos de Lenguaje y Video" (VLMs, por sus siglas en inglés) son maestros de la descripción. Pueden ingerir un clip de video y generar un subtítulo preciso: "Un hombre pasea a su perro por un parque en un día soleado". Pueden identificar objetos, segmentar escenas e incluso responder preguntas fácticas sobre lo que sucede en pantalla. Sin embargo, esta habilidad perceptiva es fundamentalmente pasiva. Es análoga a la de un cronista deportivo que puede describir con precisión cada movimiento en el campo, pero sin entender la estrategia subyacente, el propósito del pase o las reglas del juego. Los sistemas de evaluación existentes, conocidos en la jerga como benchmarks, se han centrado abrumadoramente en esta capacidad descriptiva.

El trabajo del equipo liderado por Cheng Yang y Haiyuan Wan identifica esta laguna como el punto ciego de toda la industria. Razonar sobre un video no es solo etiquetar objetos; es construir un modelo mental del espacio, seguir el hilo de la causalidad y mantener una memoria de trabajo de eventos pasados. Aquí es donde VR-Bench cambia las reglas del juego. La plataforma no utiliza videos del mundo real, que son caóticos y difíciles de medir. En su lugar, utiliza la "generación procedural" para crear un suministro infinito de desafíos únicos. El sistema, construido sobre el motor de código abierto Godot, puede generar miles de laberintos con diferentes tamaños, texturas y niveles de complejidad. Esta variedad asegura que la IA no pueda simplemente memorizar la solución basándose en videos similares que haya visto durante su entrenamiento en la inmensidad de internet. Debe, por fuerza, razonar desde cero. La plataforma de pruebas VR-Bench se divide en cinco entornos clave que examinan diferentes facetas del razonamiento:

Regular Maze

Prueba la habilidad espacial más básica en un entorno de cuadrícula 2D.

Irregular Maze

Desafía la pura percepción visual del laberinto al usar caminos curvos y no estructurados.

3D Maze

Añade el eje vertical, exigiendo una conciencia espacial compleja y manejo de niveles.

Trapfield

Introduce la memoria a largo plazo, obligando al modelo a recordar y evitar trampas vistas previamente.

Sokoban

La prueba de causalidad, donde el agente debe empujar cajas a destinos específicos bajo reglas físicas.

El veredicto: un fracaso SOTA

Armados con esta robusta herramienta de evaluación, los científicos pusieron a prueba a los "titanes" de la industria. Los resultados fueron, en una palabra, desoladores. En los laberintos 2D más sencillos, considerados la tarea de "calentamiento", el mejor modelo del mundo, GPT-4o, apenas alcanzó una Tasa de Éxito de 28%. Dicho de otra manera, incluso después de ver un video de la solución, en siete u ocho de cada diez intentos, la IA más avanzada del planeta no fue capaz de trazar un plan válido para salir del laberinto. Los demás modelos obtuvieron puntuaciones aún más bajas. El siguiente gráfico compara el rendimiento de los modelos más avanzados de la industria en la tarea más simple (Regular Maze), que requiere la planificación espacial básica:

Rendimiento SOTA en Laberinto Regular (Tasa de Éxito)

Comparación de la planificación espacial básica de los principales modelos de lenguaje y video.

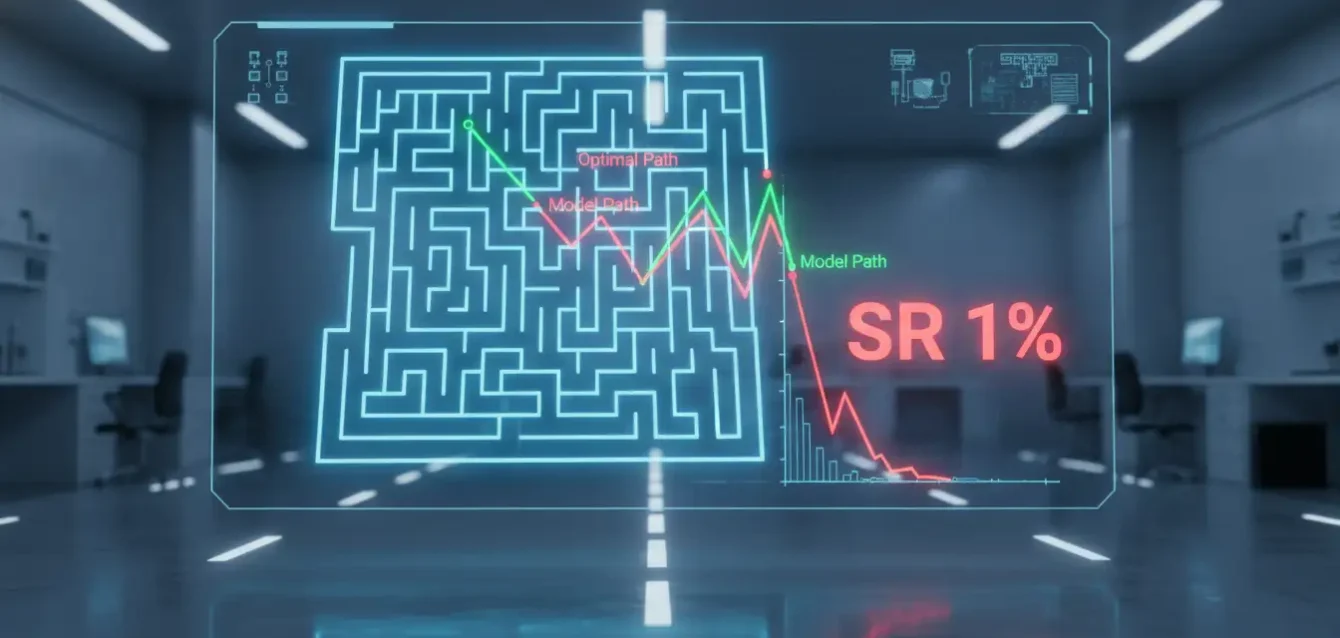

A medida que la complejidad aumentaba, el rendimiento se desplomaba. En los laberintos 3D y los campos de trampas, las métricas de éxito cayeron a un solo dígito. El colapso del rendimiento es más evidente al observar cómo un modelo líder como GPT-4o maneja la escalada de la dificultad del entorno. El Laberinto Regular comienza con un 28% de éxito, pero al llegar a Sokoban, la tasa se vuelve casi nula. El siguiente gráfico muestra este declive funcional a través de los cinco tipos de laberintos:

Declive en la Tasa de Éxito (SR) de GPT-4o según la Complejidad de la Tarea

La incapacidad de mantener el rendimiento a medida que aumentan las exigencias de memoria y causalidad.

Y en Sokoban, el desafío de la causalidad, los resultados fueron un cero estadístico. La Tasa de Éxito fue inferior al 1%. Los modelos no tenían la menor idea de lo que estaban viendo. Sus respuestas no eran más que conjeturas aleatorias, una alucinación de acciones sin conexión alguna con la lógica del puzzle. El análisis de los investigadores sobre por qué se produce este fracaso masivo es la contribución central del estudio. Identifican tres fallos catastróficos. Primero, la dependencia a largo plazo: los modelos simplemente "olvidan" lo que sucedió al principio del video cuando llegan al final. Segundo, una ceguera espacial: los sistemas no construyen un modelo 3D interno del mundo. Tercero, una incomprensión causal: Sokoban demuestra que no entienden la física, la agencia o las consecuencias. Este resultado demuestra una incapacidad fundamental de los modelos actuales para comprender la causalidad (acción y consecuencia) en un entorno físico simulado:

Rendimiento en la Prueba de Causalidad (Sokoban)

< 1%

Tasa de Éxito (SR)

Los modelos no logran conectar al "agente" como la causa del movimiento ni entender las restricciones físicas del entorno.

El frágil concepto de generalización

La investigación fue un paso más allá. No solo probó la habilidad de los modelos en tareas específicas, sino que también midió su capacidad de generalizar el conocimiento, la verdadera piedra angular de la inteligencia. Se realizaron tres pruebas de generalización. En la primera, de Generalización de Dificultad, los modelos fueron entrenados solo en laberintos pequeños (ej: 5x5) y luego probados en laberintos más grandes (ej: 10x10). Fracasaron. Esto demuestra que no estaban aprendiendo el algoritmo o el concepto de "resolver un laberinto", sino simplemente memorizando patrones de bajo nivel que se volvían inútiles al cambiar la escala. Los siguientes gráficos ilustran la caída en la Tasa de Éxito (SR) de Wan-R1 al enfrentarse a estas tareas no vistas:

Generalización de Dificultad (8% SR)

Probados en laberintos más grandes que los de entrenamiento.

8%

Generalización de Textura (4% SR)

Probados con texturas visuales no vistas. La IA se distrae por la apariencia.

4%

Generalización de Tipo (6% SR)

Probados en laberintos irregulares (forma libre) tras entrenar en cuadrícula.

6%

La segunda prueba fue de Generalización de Textura. Los modelos se probaron en laberintos con texturas (madera, ladrillo, metal) que no habían visto en el entrenamiento. De nuevo, fracasaron estrepitosamente. Este es quizás el hallazgo más alarmante. Significa que los modelos estaban "distraídos" por características superficiales e irrelevantes (la apariencia de las paredes) en lugar de centrarse en lo único que importaba: la estructura y la topología del laberinto. Es la antítesis del pensamiento abstracto. Finalmente, en la prueba de Generalización de Tipo de Laberinto, los modelos que aprendieron en laberintos de cuadrícula (Regulares) fueron incapaces de resolver laberintos de forma libre (Irregulares), y viceversa.

El diagnóstico: deficiencias estructurales

El análisis de los investigadores sobre por qué se produce este fracaso masivo es la contribución central del estudio. El problema no se resuelve con más datos o más poder de cómputo, sino con cambios en el diseño del modelo. Los tres fallos fundamentales que impiden el verdadero razonamiento son:

Ceguera Espacial Profunda

Los modelos no construyen un "mapa mental" o modelo 3D del entorno. Para ellos, el video no es un espacio tridimensional coherente, sino una "sopa de píxeles" que cambia, un flujo de texturas sin estructura subyacente.

Fallo de Memoria a Largo Plazo

La IA olvida lo que sucedió al principio del video cuando llega al final. Son incapaces de mantener un plan coherente que conecte la visión de una trampa con la decisión de evitarla posteriormente.

Incomprensión Causal

Demostrado por el fracaso en Sokoban. No entienden la física, la agencia o las consecuencias. No logran conectar al "agente" como la causa del movimiento de la "caja".

El laberinto como metáfora

Este estudio no es un ataque a la industria de la IA, sino un servicio público. En un momento de expectativas desbordadas, "Reasoning via Video" sirve como una llamada de atención científica, un documento que reajusta nuestras expectativas y redefine la frontera de la investigación. La relevancia científica es inmensa: VR-Bench ofrece a la comunidad una herramienta gratuita y de código abierto para medir lo que realmente importa. Desplaza el objetivo de la investigación: el próximo gran avance no vendrá de modelos que generen videos más bonitos, sino de modelos que puedan, por primera vez, entender uno de estos laberintos.

La relevancia tecnológica es un mapa para las propias compañías. El trabajo les dice a los ingenieros de Google, OpenAI y Meta exactamente dónde están fallando sus arquitecturas. La solución no vendrá de más datos o más poder de cómputo, sino de nuevos diseños de modelos que incorporen de forma nativa la memoria a largo plazo, la representación espacial y el razonamiento causal.

Para el resto de nosotros, la relevancia social es la más profunda. Nos apresuramos a integrar estas IA en todos los aspectos de nuestras vidas. Queremos que conduzcan nuestros coches (una tarea de razonamiento espacial y causal en 3D), que gestionen la logística de nuestras fábricas (un problema de Sokoban a gran escala) o que asistan en cirugías robóticas (donde la comprensión de la causa y el efecto es literal). Esta investigación nos obliga a hacer una pausa. Antes de entregar las llaves del mundo real a estas inteligencias artificiales, debemos estar absolutamente seguros de que entienden las consecuencias de sus acciones. El trabajo demuestra que, por ahora, ni siquiera pueden comprender las consecuencias de empujar una caja en un mundo digital. El camino hacia una inteligencia artificial que razone verdaderamente sigue siendo largo, y VR-Bench acaba de iluminar cuán complejo y profundo es el laberinto que nos queda por recorrer.

Referencias

Yang, C., Wan, H., Peng, Y., Cheng, X., Yu, Z., Zhang, J., Yu, J., Yu, X., Zheng, X., Zhou, D., & Wu, C. (2025). Reasoning via Video: The First Evaluation of Video Models’ Reasoning Abilities through Maze-Solving Tasks. arXiv preprint arXiv:2511.15065.