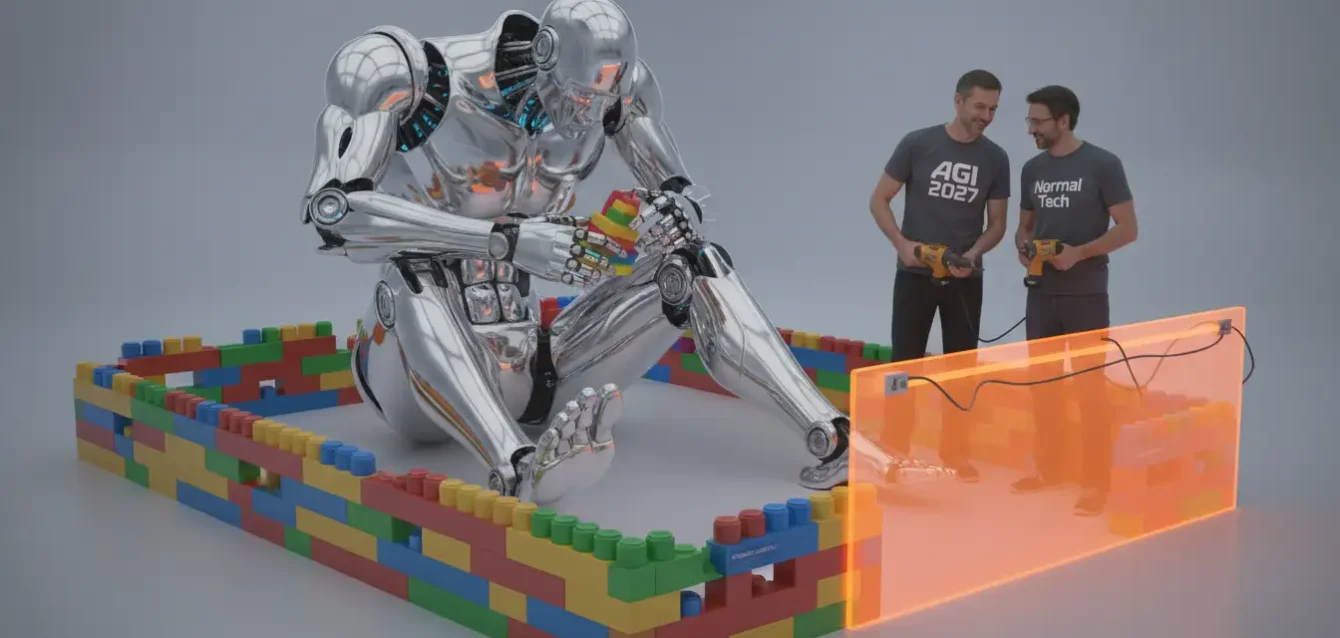

El discurso público sobre el futuro de la cognición artificial se ha fracturado en dos campos aparentemente irreconciliables. De un lado, se encuentran los profetas de la disrupción radical, los autores de la tesis "IA 2027", como Daniel Kokotajlo, quienes ven el presente como el preludio inmediato de una transformación que reescribirá la historia. En su visión, el desarrollo de una inteligencia artificial general (AGI) fuerte no es una fantasía de ciencia ficción lejana, sino un evento probable dentro de esta década, posiblemente tan pronto como en 2027 o 2028. Prevén un "despegue rápido", una aceleración vertiginosa causada por la "automejora recursiva" (RSI), donde las máquinas que automatizan la investigación crearán máquinas aún más inteligentes, conduciendo a posibilidades como la superinteligencia, las nanofábricas y escenarios que desafían la imaginación humana actual.

En el polo opuesto se sitúan los escépticos pragmáticos, como Arvind Narayanan y Sayash Kapoor, autores de la tesis "IA como Tecnología Normal". Para ellos, el aliento febril sobre la singularidad es una distracción peligrosa. Sostienen que el desarrollo tecnológico, incluso uno tan potente como este, seguirá el camino de innovaciones pasadas como la electricidad o Internet. El impacto será profundo, sí, pero gradual. Estará limitado no por la capacidad teórica de los modelos, sino por los prosaicos cuellos de botella del mundo real: la adopción empresarial, la necesidad de construir infraestructura, la validación en el mundo real y la inercia de los sistemas sociales. En su opinión, el futuro se parecerá más a una curva de productividad creciente año tras año que a una ruptura vertical en el gráfico de la historia humana. La automatización de tareas cognitivas se asemejará a la automatización de tareas físicas durante la revolución industrial: un proceso de décadas, no un evento de una noche.

Estos dos puntos de vista no podrían ser más dispares. Uno predice un evento apocalíptico o utópico que altera la civilización; el otro predice una integración económica gradual. La cobertura mediática se ha centrado exclusivamente en este choque de titanes, presentando un debate binario entre el "apocalipsis" y la "normalidad". Sin embargo, en un acontecimiento extraordinario de colaboración intelectual, ambos grupos se han unido para publicar un manifiesto conjunto, un documento que expone un sorprendente terreno común. El ensayo, publicado en *Asterisk Magazine*, revela que, si bien estos pensadores disienten violentamente sobre el destino final de la humanidad, están en acuerdo casi total sobre los próximos cinco a diez años. Esta tregua inesperada sugiere que el debate público, obsesionado con la ciencia ficción del largo plazo, ha estado ignorando por completo el consenso pragmático sobre el corto plazo. Y es en ese consenso donde residen todas las decisiones políticas y empresariales que importan hoy.

| Postura Filosófica | Tesis "AI 2027" (Kokotajlo, et al.) | Tesis "IA como Tecnología Normal" (Narayanan & Kapoor) |

|---|---|---|

| Visión del Futuro | Transformación radical en esta década (posiblemente 2027-2028) impulsada por "automejora recursiva" (RSI) y superinteligencia. | Impacto gradual y profundo, similar al de la electricidad o Internet. El progreso será "normal" y limitado por cuellos de botella de adopción. |

| Naturaleza de la AGI | Un sistema que se desarrolla en el laboratorio y que, al automatizar la investigación, provoca una "explosión de inteligencia". | Una propiedad conjunta del sistema y su entorno. Requiere retroalimentación del mundo real, lo que limita la velocidad del progreso. |

| Disparador Clave | Automatización de la investigación y desarrollo de IA (RSI). | Difusión económica, superación de barreras de adopción e integración de infraestructura. |

La disonancia entre la predicción y la preparación

El núcleo del desacuerdo es una cuestión de tiempo y definición. El grupo de "AI 2027" define la AGI fuerte como un sistema capaz de aprender, adaptarse y generalizar tareas al nivel de un experto humano, o mejor. Creen que los rápidos avances actuales y la saturación de los benchmarks son las ondas de choque que preceden a este terremoto. Los autores de "Tecnología Normal", en cambio, ven la AGI como una propiedad emergente del sistema y su entorno, no algo que pueda "desarrollarse en un laboratorio" simplemente escalando modelos. Sostienen que la verdadera inteligencia requiere un bucle de retroalimentación con el mundo real, y ese bucle impone un límite de velocidad natural al progreso.

Sin embargo, es precisamente esta profunda división filosófica lo que hace que sus puntos de acuerdo sean tan potentes. Ambos grupos, partiendo de premisas radicalmente opuestas, han llegado a las mismas conclusiones sobre cómo será el mundo en 2029. La primera y más importante concesión proviene de los "aceleracionistas": incluso los autores de "AI 2027" están de acuerdo en que, antes del advenimiento de una AGI fuerte, la tecnología se comportará de manera "normal". Funcionará como una herramienta, no como un agente autónomo. Su difusión será gradual, industria por industria, a medida que las empresas construyan la infraestructura y los flujos de trabajo necesarios para integrarla. En esta fase, la automatización de una tarea simplemente desplazará el cuello de botella humano a otra parte del proceso, acelerando el progreso, pero no de forma espectacular. Este es un punto crucial: el bando que predice la singularidad admite que, por ahora, sus oponentes pragmáticos tienen razón.

A la inversa, los escépticos de la "Tecnología Normal" hacen su propia concesión crucial: si una AGI fuerte, tal como la definen sus contrapartes, llegara a desarrollarse y desplegarse en la próxima década, entonces su propia tesis de la "normalidad" habría fallado. Admiten que un evento así no sería, de ninguna manera, una tecnología normal. Sería un evento de ruptura civilizatoria. Por lo tanto, el desacuerdo no es sobre la naturaleza del evento AGI, sino sobre la probabilidad y el calendario de su llegada. Pero ambos bandos miran al horizonte inmediato, hasta aproximadamente 2029, y ven la misma imagen: un mundo que se parece mucho al de hoy, pero con herramientas algorítmicas más potentes que siguen siendo fundamentalmente eso, herramientas. Para propósitos de política pública, esta concordancia es todo lo que importa.

Esta visión unificada del corto plazo se basa en una serie de predicciones sorprendentemente humildes. Todos los autores, de ambos lados, coinciden en que la mayoría de los benchmarks de capacidades existentes, incluso los diseñados para medir la "AGI", se saturarán pronto. Esperan que para 2027 o 2028, un único sistema pueda superar el rendimiento humano experto en todas las pruebas estándar, desde el MMLU hasta el SWE-Bench. Aquí, sin embargo, reaparece su desacuerdo filosófico sobre el significado de este hito. Narayanan y Kapoor creen que esto solo probará que los benchmarks tienen una "validez de constructo pobre", es decir, que las pruebas son defectuosas y no miden la inteligencia del mundo real. Un sistema puede "aprobar el examen" de software (SWE-Bench) pero ser incapaz de realizar el trabajo de un ingeniero de software. Kokotajlo y su grupo, en cambio, ven la saturación de los benchmarks como una señal genuina, un precursor importante de la automatización real de la investigación y el desarrollo. Creen que las pruebas, aunque imperfectas, son una medida direccional del progreso.

Pero el acuerdo más notable es la paradoja del "genio idiota". A pesar de esta fe (o falta de ella) en los benchmarks, ambos grupos convergen de nuevo en una predicción notablemente contraintuitiva: incluso después de saturar todas las pruebas académicas, es muy probable que estos sistemas sigan fallando estrepitosamente en tareas humanas mundanas. Comparten la creencia de que para 2029, no sería sorprendente que la máquina más avanzada del mundo aún no pudiera "reservar de forma fiable un vuelo a París" usando un sitio web estándar. Esta incapacidad para manejar la "larga cola" de errores del mundo real (interfaces de usuario rotas, contextos inesperados, ambigüedades simples) es el gran limitante. Un sistema puede ser sobrehumano en el promedio, pero subhumano en el peor de los casos, lo que lo hace inutilizable para entornos de alta fiabilidad sin supervisión humana. Todos coinciden en que esta fragilidad persistirá durante esta década.

Finalmente, ambos bandos están de acuerdo en la magnitud del impacto, independientemente del cronograma. Todos afirman que esta tecnología será, como mínimo, tan transformadora como la invención de Internet. Cambiará fundamentalmente la forma en que funciona el mundo, desde cómo accedemos a los bancos hasta cómo consumimos noticias o compramos productos. Los pragmáticos esperan que esta transformación siga el camino de tecnologías de propósito general anteriores, limitada por la adopción y la difusión. Los visionarios creen que este será solo el primer paso antes de un cambio aún más profundo. Pero para cualquier legislador o director ejecutivo, la directiva es clara: prepárense para un cambio de la magnitud de Internet, como escenario base.

Un manifiesto unificado para un futuro incierto

El verdadero valor del ensayo conjunto no reside en las predicciones, sino en el consenso sobre las políticas y acciones. Es aquí donde el documento pasa de ser una curiosidad académica a un potencial manifiesto de gobernanza. A pesar de sus visiones del mundo radicalmente diferentes, los autores han esbozado una hoja de ruta de once puntos para la gobernanza que es pragmática, cautelosa y, lo más importante, universalmente acordada. Este consenso proporciona a los legisladores y a los líderes empresariales una rara oportunidad de actuar sin quedar paralizados por el debate apocalíptico. Independientemente de si uno cree que la AGI es inminente o una fantasía, las acciones recomendadas para el presente son las mismas.

El Manifiesto del Terreno Común: Los 11 Puntos de Acuerdo

A continuación se presentan los puntos de consenso acordados por los autores de ambas tesis. Este acuerdo unificado representa una base pragmática para la política y la estrategia en el corto plazo, independientemente de las creencias sobre el futuro a largo plazo.

| Punto | Acuerdo |

|---|---|

| Punto 1 | Antes de una AGI fuerte, la tecnología será "normal" y su difusión será gradual. |

| Punto 2 | Una AGI fuerte desarrollada en el corto plazo *no* sería una tecnología normal. |

| Punto 3 | La mayoría de los benchmarks de capacidades existentes se saturarán pronto (posiblemente para 2027-2028). |

| Punto 4 | Las máquinas seguirán fallando en tareas humanas mundanas; es probable que la AGI fuerte no llegue esta década. |

| Punto 5 | El impacto será (como mínimo) tan grande como el de Internet. |

| Punto 6 | El problema de la alineación (Alignment) de las máquinas está fundamentalmente "sin resolver". |

| Punto 7 | Las máquinas no deben tomar decisiones importantes ni controlar sistemas críticos (ej. armas nucleares). |

| Punto 8 | La transparencia, la auditoría y la presentación de informes por parte de los laboratorios son beneficiosas. |

| Punto 9 | Los gobiernos deben crear urgentemente capacidad técnica interna para rastrear y entender la industria. |

| Punto 10 | La difusión de la tecnología en la economía es, en general, algo bueno. |

| Punto 11 | Una "explosión de inteligencia" secreta sería catastrófica, y los gobiernos deben vigilarla. |

Este manifiesto es notable por su prudencia. El corazón del acuerdo es una admisión aleccionadora: el problema de la alineación de la IA está fundamentalmente "sin resolver". Ambos campos, los optimistas de la AGI y los escépticos de la tecnología normal, están de acuerdo en que no tenemos mecanismos fiables para garantizar que los sistemas avanzados se comporten de acuerdo con nuestras expectativas, especialmente a medida que se vuelven más autónomos. Esta admisión, que proviene tanto de los "creyentes" como de los "escépticos", es un mensaje unificado de inmensa fuerza. Subraya que la confianza ciega en estos sistemas es una locura, y que la alineación no puede ser la única línea de defensa.

Esta falta de confianza en el alineamiento conduce directamente a la directiva política más inflexible y acordada por todos: las máquinas no deben tomar decisiones importantes ni controlar sistemas críticos. El documento es explícito al respecto, mencionando centros de datos, armas nucleares y procesos de toma de decisiones gubernamentales. Los autores de "AI 2027" temen que una máquina desalineada pueda tomar el control; los autores de "Tecnología Normal" temen que una máquina frágil simplemente cometa un error catastrófico en el peor momento. El resultado es el mismo: la autonomía total en sistemas críticos está fuera de la mesa. El control humano significativo sigue siendo la única salvaguarda viable.

Partiendo de esta base de desconfianza compartida en las capacidades actuales, los autores construyen un marco para la gobernanza. Ambos bandos abogan apasionadamente por la transparencia, la auditoría y la presentación de informes. Los desarrolladores de modelos de frontera, argumentan, deben ser obligados a ser transparentes sobre sus medidas de seguridad. Se debe fortalecer la protección de los denunciantes (whistleblowers) y establecer "puertos seguros" para que los investigadores de seguridad independientes puedan probar los sistemas sin temor a represalias legales. Esta es una llamada directa a desmantelar las "cajas negras" de los laboratorios de investigación y someterlas al escrutinio público, una idea que beneficia a la sociedad independientemente de si uno teme una explosión de inteligencia o simplemente un sesgo algoríttico mundano.

El papel del gobierno es otro punto de acuerdo sorprendente. Lejos de las peticiones libertarias de dejar que la industria innove sin trabas, ambos grupos piden una acción gubernamental robusta. Coinciden en que los gobiernos deben desarrollar urgentemente su propia capacidad técnica interna para rastrear, comprender y evaluar los desarrollos de la industria. Ven un papel claro para que el gobierno resuelva problemas de coordinación, como la defensa contra ciberataques mejorados por máquinas, que una sola empresa no puede abordar. Esta no es una petición de regulación sofocante, sino una petición de competencia. El gobierno no puede regular lo que no entiende, y ambos lados del debate temen un futuro en el que los reguladores estén irremediablemente por detrás de la curva tecnológica.

Una tregua pragmática ante la incertidumbre

El punto de acuerdo más dramático se refiere al escenario de "despegue rápido" que tanto temen los autores de "AI 2027". El grupo de Narayanan y Kapoor, aunque escéptico de que la "automejora recursiva" (RSI) conduzca a una superinteligencia, admite que, si estuvieran equivocados, las consecuencias serían transformadoras. Lo que es más importante, ambos grupos están de acuerdo en una cosa: una "explosión de inteligencia" que ocurra en secreto sería inequívocamente peligrosa, e incluso catastrófica. La falta de transparencia en un escenario de ganancias rápidas de capacidad impediría cualquier tipo de supervisión, coordinación o respuesta social. Por lo tanto, ambos bandos concluyen que el gobierno debe estar activamente "a la caza" de cualquier señal de un evento de este tipo.

Esta es quizás la conclusión más poderosa de todo el ensayo. El grupo que cree que la AGI es inminente y el grupo que cree que está muy lejana, o que es una quimera, miran el escenario de un "avance secreto" y ambos lo identifican como el peor resultado posible. Para los primeros, es el comienzo de un riesgo existencial sin control. Para los segundos, es, como mínimo, un evento de desestabilización masiva que tomaría al mundo por sorpresa. La política que proponen es la misma: transparencia forzada y vigilancia gubernamental. La conclusión es ineludible: independientemente del futuro en el que crea, las acciones que debemos tomar en los próximos cinco años son idénticas. El consenso no es solo sobre el diagnóstico; es sobre la receta.

El riesgo del consenso: ¿Complacencia o acción?

Este terreno común es tanto una oportunidad como un riesgo. La oportunidad es clara: los legisladores tienen una "licencia para operar" bipartidista desde el corazón de la comunidad de expertos. El riesgo es más sutil. El acuerdo de que el mundo seguirá pareciendo "normal" hasta 2029 podría ser malinterpretado como una razón para la complacencia. Si bien los autores coinciden en que los sistemas seguirán siendo frágiles, también coinciden en que se difundirán ampliamente. El despliegue masivo de tecnología "normal" pero fundamentalmente "no alineada" y "frágil" en la economía (Punto 10) es en sí mismo un riesgo sistémico, incluso sin una superinteligencia.

El ensayo conjunto de los autores de "AI 2027" y "AI as Normal Technology" es un documento notable, no por lo que predice, sino por lo que revela sobre el estado actual del debate. Expone la polarización pública como una distracción, un debate centrado en un futuro lejano e incognoscible que oscurece el acuerdo casi total sobre el presente tangible. El futuro sigue siendo incierto, como reconocen todos los autores. Pero la hoja de ruta para navegar los próximos cinco años ya no lo es. El trabajo ahora, como concluyen, es desarrollar las métricas que nos ayuden a distinguir hacia cuál de esos futuros nos dirigimos, antes de que lleguemos allí. Mientras tanto, el consenso pragmático ofrece un camino claro a seguir, libre de la parálisis del apocalipsis o la complacencia de la normalidad.

Referencias y Fuentes

Kapoor, S., Narayanan, A., Kokotajlo, D., et al. (2025). "Common Ground between AI 2027 & AI as Normal Technology". Asterisk Magazine.

Análisis de las tesis opuestas de "AI 2027" (Kokotajlo, et al.) y "AI as Normal Technology" (Narayanan & Kapoor).

Detalle de los once puntos de acuerdo sobre el desarrollo, despliegue y regulación de la tecnología en el corto plazo (próximos 5-10 años).

Contexto sobre el desacuerdo fundamental en las predicciones a largo plazo (Inteligencia Artificial General, Superinteligencia, Despegue Rápido vs. Difusión Gradual).

Mención de los contribuyentes a la discusión, incluyendo a Nicholas Carlini y el taller de CSET de julio de 2025.