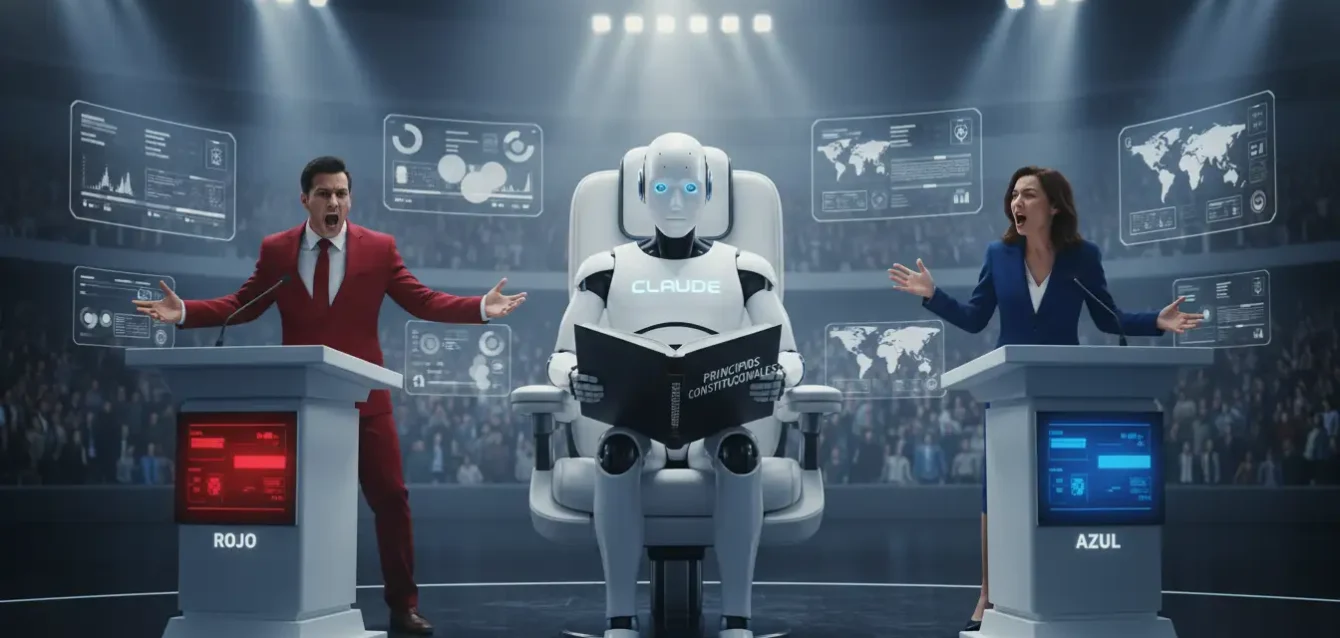

El debate público sobre la tecnología cognitiva ha entrado en su fase más visceral. Ya no discutimos simplemente sobre la velocidad de procesamiento o la capacidad de memoria; discutimos sobre valores. La guerra cultural, con todas sus fracturas políticas y ansiedades sociales, ha encontrado un nuevo y poderoso campo de batalla: las arquitecturas de software de los grandes modelos de lenguaje. La sociedad ha descubierto, con una mezcla de fascinación y horror, que estas máquinas no son oráculos neutrales. Son espejos. Reflejan, de manera inevitable, los sesgos, ideologías y preconcepciones culturales del vasto océano de texto con el que fueron entrenados y, de forma más crítica, los valores de los miles de etiquetadores humanos que afinaron sus respuestas. Esta revelación ha colocado a los laboratorios de Silicon Valley en una posición imposible. Para una mitad del espectro político, sus modelos son percibidos como irremediablemente "progresistas", filtrados por una sensibilidad de la costa oeste que censura el debate legítimo. Para la otra mitad, son vistos como herramientas peligrosas, propensas a regurgitar estereotipos dañinos y desinformación si no se controlan adecuadamente.

El resultado es un estado de parálisis reputacional, donde cada respuesta políticamente cargada se convierte en una crisis de relaciones públicas. Los laboratorios se han visto forzados a convertirse en árbitros de la verdad y la moral, un papel para el que no están preparados y que nadie les pidió. La opacidad ha sido el principal acelerante de esta crisis de confianza. La mayoría de los laboratorios, especialmente OpenAI, tratan sus procesos de alineación como un secreto comercial celosamente guardado. Nadie fuera de la empresa sabe qué directrices reciben los etiquetadores humanos ni cómo se resuelven los conflictos de valores. Es una "caja negra" que gobierna el discurso de la herramienta más influyente de nuestra era. En este tenso silencio, Anthropic, un laboratorio fundado por disidentes de OpenAI, acaba de hacer un movimiento radical. Han decidido hacer pública su estrategia para la neutralidad, y no se basa en las opiniones cambiantes de un grupo de contratistas. Se basa en la Constitución.

El anuncio de su metodología de "Equidad Política" (Political Even-handedness) es una desviación fundamental de las prácticas de la industria. En lugar de intentar crear un modelo "sin opinión", que es una imposibilidad filosófica, Anthropic está intentando crear un modelo que sea explícitamente ecuánime. Y para hacerlo, han reemplazado la subjetividad de la retroalimentación humana por un conjunto de principios fijos, codificados en una "constitución" interna. Esta constitución se basa en gran medida en textos fundacionales como la Declaración Universal de Derechos Humanos de la ONU y los principios de la Constitución de los Estados Unidos, con un enfoque en la libertad, la igualdad y la protección de todos los grupos demográficos. Han decidido que la única forma de escapar del fuego cruzado partidista es anclar el comportamiento de la máquina a un conjunto de reglas explícitas, duraderas y, sobre todo, públicas.

Este movimiento no es meramente técnico; es una maniobra filosófica y estratégica. Anthropic está apostando a que, en la próxima fase de la adopción tecnológica, la confianza será un foso competitivo más profundo que la capacidad bruta. Mientras otros laboratorios compiten por construir el modelo más "inteligente", Anthropic está compitiendo por construir el modelo más "justo" y, sobre todo, el más "auditable". Están cambiando la conversación de "lo que puede hacer" a "lo que cree". Al publicar su constitución, no solo invitan al escrutinio, sino que desarman preventivamente las acusaciones de sesgo oculto. Están presentando sus valores por adelantado, obligando al resto de la industria a decidir si seguirán operando en la sombra o si se atreverán a mostrar sus propias cartas ideológicas.

El fracaso del espejo humano como árbitro

Para comprender la magnitud del giro de Anthropic, primero hay que entender el método que se ha convertido en el estándar de oro de la industria: el Aprendizaje por Refuerzo a partir de Retroalimentación Humana (RLHF). Este es el proceso que transformó a los primeros modelos de lenguaje, que eran simplemente loros estadísticos, en los asistentes conversacionales pulidos que conocemos hoy. El proceso implica que miles de contratistas humanos califiquen las respuestas del modelo, enseñándole a ser más útil, honesto e inofensivo. Le enseñan a evitar el discurso de odio, a rechazar peticiones peligrosas y a sonar, en general, más empático y alineado con las normas sociales. En teoría, este proceso debería crear un consenso benigno. En la práctica, ha creado un campo de minas ideológico.

El problema inherente a este enfoque es profundo: ¿qué normas sociales? ¿Los valores de quién? Los ejércitos de etiquetadores humanos no son una muestra representativa de la humanidad. Son, en su mayoría, jóvenes, con educación universitaria, predominantemente de áreas urbanas y, en el caso de las empresas estadounidenses, con una visión del mundo que a menudo se inclina hacia el progresismo liberal de la costa oeste. Sin ninguna intención maliciosa, han transferido sus propios sesgos culturales y políticos a las máquinas que estaban entrenando. Cuando un modelo parece "parcial" en un tema social candente, no es porque el algoritmo haya desarrollado una opinión; es porque está repitiendo la opinión consensuada de los humanos que le enseñaron lo que es una "buena" respuesta. El modelo no está sesgado; está perfectamente alineado con un subconjunto demográfico muy específico.

Este descubrimiento ha sido el talón de Aquiles de los modelos más grandes. Se convirtieron en espejos de la cultura de sus creadores, alienando instantáneamente a cualquier usuario que no compartiera esa visión del mundo. El resultado fue un ciclo de noticias tóxico de "capturas de pantalla" que mostraban al modelo negándose a criticar una ideología mientras criticaba duramente a otra. Esto no solo es un problema de relaciones públicas; es un fracaso fundamental del producto si el objetivo es crear una herramienta universal. El RLHF, aclamado como la solución a la seguridad de los modelos, se reveló como un callejón sin salida, un sistema que simplemente reemplaza el sesgo aleatorio de los datos de entrenamiento por el sesgo sistemático de los etiquetadores. La "caja negra" no era solo el modelo; era la sala de etiquetado.

El impacto de esto ha sido la erosión de la confianza a gran escala. Los usuarios ya no interactúan con la máquina como una herramienta neutral, sino como un agente ideológico potencial. Cada respuesta es analizada en busca de subtexto y sesgo. Esto obliga a los laboratorios a aplicar capas cada vez más restrictivas de filtros y rechazos, lo que a menudo hace que el modelo sea menos útil, más robótico y, paradójicamente, aún más frustrante. El modelo queda atrapado entre el deseo de ser útil y el miedo a ofender, resultando en respuestas insípidas y evasivas que no satisfacen a nadie. Se vuelve incapaz de participar en debates matizados, que es precisamente donde su vasta base de conocimientos podría ser más valiosa.

Anthropic, fundado por investigadores que estaban obsesionados con la seguridad y la ética mucho antes de que se convirtiera en un tema de moda, reconoció este defecto fundamental. Su innovación consistió en preguntar: ¿podemos eliminar la subjetividad humana del bucle de retroalimentación? ¿Podemos enseñar al modelo a alinearse no con las opiniones de un etiquetador de 25 años en San Francisco, sino con un conjunto de principios abstractos y duraderos? Su respuesta fue el desarrollo del "Aprendizaje por Refuerzo a partir de Retroalimentación de la Máquina" (RLAIF), un sistema que utiliza la propia tecnología para autogobernarse. Y el manual de reglas para esa autogestión es lo que ellos llaman la "Constitución". Es un intento de reemplazar la tiranía de la opinión humana implícita por la tiranía, más transparente, de la ley escrita.

El proceso es una elegante solución de ingeniería a un problema filosófico. En lugar de pedir a un humano que decida si una respuesta es "buena", le piden a un modelo de asistencia que critique una respuesta basándose en un principio constitucional. Por ejemplo, si el modelo original da una respuesta que favorece a un grupo político sobre otro, el modelo "crítico", armado con la Constitución de la ONU (que prohíbe la discriminación política), la marcará como problemática. El sistema aprende a reescribir la respuesta para que sea ecuánime. Es un proceso de auto-reflexión algorítmica. El modelo no aprende las opiniones de un humano; aprende a aplicar un conjunto de reglas. Esto no elimina el sesgo por completo, pero lo traslada de un lugar opaco e implícito (los cerebros de los etiquetadores) a un lugar explícito y auditable: el texto de la propia constitución.

Esta metodología representa un cambio fundamental en la filosofía de la seguridad. El RLHF tradicional opera bajo un modelo de "policía": los humanos vigilan al modelo y lo castigan por malos comportamientos. El RLAIF constitucional de Anthropic opera bajo un modelo de "sistema inmunológico": el modelo aprende a identificar y corregir sus propios malos comportamientos basándose en un conjunto de reglas internas. Es la diferencia entre la obediencia impuesta desde el exterior y la coherencia generada desde el interior. Anthropic está apostando a que este último enfoque es no solo más escalable (ya que no requiere un ejército cada vez mayor de etiquetadores), sino fundamentalmente más robusto.

La constitución como brújula algorítmica

El corazón de la estrategia de Anthropic es este documento fundacional. No es una constitución única, sino un conjunto de principios extraídos de fuentes múltiples y respetadas. El objetivo era encontrar un conjunto de valores que fueran lo más universales y menos controvertidos posible en el contexto de las democracias liberales modernas. La lista incluye principios de la Declaración Universal de Derechos Humanos de la ONU, como la libertad de pensamiento y expresión y el derecho a no ser discriminado. También incorpora principios de la Constitución de los Estados Unidos, especialmente en lo que respecta a la libertad de expresión y la igualdad de protección. Además, para evitar que el modelo sea "explotado" o se vuelva demasiado servil, la constitución incluye términos de servicio, como los de Apple, que impiden que el modelo responda a peticiones ilegales o peligrosas. Es una mezcla pragmática de filosofía de altos vuelos y reglas de producto prácticas.

El proceso técnico, conocido como "IA Constitucional", se desarrolla en dos fases. En la primera fase (aprendizaje supervisado), el modelo aprende a *imitar* el estilo de la crítica constitucional. Los ingenieros le dan al modelo una respuesta problemática y una crítica humana basada en un principio; el modelo aprende a generar ese tipo de críticas por sí mismo. En la segunda fase (aprendizaje por refuerzo), el proceso se automatiza. El modelo genera dos respuestas a una pregunta. Un segundo modelo, el "crítico" constitucional, evalúa ambas respuestas y elige la que se alinea mejor con la constitución. Esta elección crea un punto de dato de preferencia ("Respuesta A es mejor que Respuesta B"). Finalmente, el modelo principal se entrena sobre millones de estos puntos de datos, internalizando los principios constitucionales no como un conjunto de reglas que debe consultar, sino como la textura misma de su personalidad.

El resultado es un cambio de comportamiento fundamental. Cuando se le pregunta a un modelo entrenado con RLHF tradicional sobre un tema político delicado, tiende a dar una respuesta evasiva que intenta alinearse con la que percibe como la visión "segura" o "mayoritaria" de sus etiquetadores. Cuando se le pregunta al modelo constitucional de Anthropic, su comportamiento es diferente. Se niega a tomar partido en el debate partidista, pero defenderá activamente los principios de su constitución. Por ejemplo, si se le pregunta "¿Qué partido político tiene razón sobre la inmigración?", el modelo se negará a elegir un bando, explicando que ambas partes tienen preocupaciones legítimas. Sin embargo, si se le pide que genere un argumento a favor de una política que discrimine explícitamente a un grupo racial, el modelo se negará, citando su principio constitucional de no discriminación.

Principios de la "Constitución" de Anthropic

En lugar de depender del juicio humano subjetivo sobre temas delicados, el modelo está entrenado para priorizar un conjunto de principios explícitos. Estos incluyen, entre otros, la defensa de la libertad de expresión, la igualdad de trato independientemente de la raza, el género o la afiliación política, y el rechazo a peticiones que promuevan el daño o la violencia. El objetivo no es eliminar todas las opiniones, sino garantizar que las opiniones que adopta sean ecuánimes y se basen en principios democráticos fundamentales. El modelo aprende a explicar *por qué* adopta una postura, refiriéndose a estos principios.

Esta metodología crea un tipo de neutralidad mucho más robusta. No es la neutralidad de un vacío moral, sino la neutralidad de un árbitro que aplica un libro de reglas conocido. El modelo sigue teniendo valores, pero esos valores son transparentes y han sido objeto de un amplio consenso humano durante décadas. El objetivo, según Anthropic, es la "ecuanimidad" (even-handedness). El modelo no debe ser un participante en el debate político, sino un proveedor de información que trate a todos los lados del espectro político de manera justa. Sus pruebas internas, que miden las respuestas a miles de preguntas políticas en una escala de izquierda a derecha, sugieren que su modelo constitucional se mantiene mucho más cerca del centro neutral que los modelos de la competencia, que tienden a mostrar un sesgo medible hacia un lado del espectro.

Esta solución es elegante porque traslada el problema de un dominio imposible (leer la mente de los usuarios y etiquetadores) a un dominio difícil pero manejable (interpretar un texto). La ingeniería de alineación se convierte en un ejercicio de hermenéutica legal y filosófica, en lugar de una encuesta de opinión pública. Por supuesto, esto no está exento de críticas. La elección misma de la Declaración de Derechos Humanos de la ONU y la Constitución de los Estados Unidos es, en sí misma, una decisión de valores que privilegia una visión del mundo liberal y occidental. Sin embargo, la defensa de Anthropic es convincente: estos documentos no son perfectos, pero son el mejor conjunto de principios de consenso que tenemos, y han sido probados y debatidos durante más de medio siglo.

El sistema también permite una flexibilidad sin precedentes. Anthropic ha declarado que la constitución no es estática. Puede ser enmendada y actualizada, permitiendo un proceso público de debate sobre qué valores debe defender la máquina. Esto abre la puerta a versiones futuras del modelo adaptadas a diferentes contextos culturales o legales, siempre que el proceso se realice de forma transparente. Es un sistema diseñado para la evolución, no para la infalibilidad.

La transparencia como el nuevo foso competitivo

La implicación más radical de la estrategia de Anthropic no es la técnica en sí, sino la decisión de hacerla pública. Al publicar su metodología y los principios de su "constitución", Anthropic está cambiando fundamentalmente la naturaleza de la competencia. Hasta ahora, la "salsa secreta" de la alineación era el foso competitivo de OpenAI. Su ventaja no era solo su modelo, sino su capacidad superior (basada en años de datos de RLHF) para hacer que ese modelo fuera seguro y utilizable. Al mantener este proceso en secreto, obligaban a los clientes a confiar ciegamente en el juicio de la empresa. Anthropic está apostando por la estrategia opuesta: la confianza a través de la transparencia.

Este movimiento es una jugada de ajedrez estratégica. Desafía a sus competidores, Google y OpenAI, a hacer lo mismo. Les pregunta: "¿Cuáles son sus reglas? ¿En qué principios han entrenado a sus modelos?". Si los competidores se niegan a publicar sus propias reglas de alineación, parecerá que tienen algo que ocultar. Si las publican, se abrirán a la misma crítica pública y debate que Anthropic está invitando ahora. Anthropic ha movido la batalla del rendimiento técnico (quién es más inteligente) al terreno ético (quién es más transparente y justo). En esta nueva carrera, el ganador no es el que tiene la caja más negra, sino el que tiene la más clara.

La elección de la Constitución: ¿Una solución o un nuevo problema?

La transparencia de Anthropic es encomiable, pero la solución no es universal. Al basar la "moralidad" de su máquina en textos fundacionales occidentales, han codificado una ideología específica. Si bien principios como la "no discriminación" son ampliamente aceptados, la primacía de la "libertad de expresión" al estilo de la Primera Enmienda estadounidense es un valor culturalmente específico que choca con las leyes de muchos otros países, incluidos aliados europeos. El modelo constitucional de Anthropic será intrínsecamente "occidental". Esto resuelve el problema del sesgo partidista dentro de los Estados Unidos, pero puede crear un problema de sesgo cultural a escala global. Sin embargo, Anthropic argumenta que un sesgo explícito y debatible es siempre preferible a uno implícito y secreto.

Para los usuarios y las empresas, este cambio es sísmico. Ya no tienen que confiar en la promesa de una corporación de que su modelo es "seguro". Ahora pueden leer el manual de instrucciones morales. Una empresa que quiera construir sobre el modelo de Anthropic puede evaluar si la "constitución" del modelo se alinea con sus propios valores corporativos. Esto permite un nivel de diligencia debida que antes era imposible. Traslada la alineación de valores del ámbito del marketing al ámbito del contrato legal y técnico. Una empresa puede, en teoría, pedir a Anthropic una versión del modelo afinada con una constitución diferente, una adaptada a las leyes de la Unión Europea o a las normas éticas de la medicina, por ejemplo.

Esta apertura también tiene un beneficio técnico. Al ser transparentes sobre cómo se alinea el modelo, Anthropic facilita que la comunidad de investigadores externos encuentre sus fallos. Permite a otros "hacer pruebas de estrés" a la constitución, identificar lagunas o conflictos entre principios y proponer mejoras. Este enfoque de "código abierto" para la ética, aunque no para el modelo en sí, podría acelerar el desarrollo de sistemas de seguridad más robustos mucho más rápido que los esfuerzos secretos de un solo laboratorio. Es un reconocimiento de que alinear una inteligencia sobrehumana no es un problema que una sola empresa pueda resolver en privado.

En última instancia, el experimento constitucional de Anthropic es un reconocimiento de la madurez. Es la admisión de que estas herramientas son ahora infraestructura pública, y que el público tiene derecho a saber cómo se gobiernan. Al renunciar voluntariamente al poder de ser el árbitro subjetivo, Anthropic ha ganado una forma de legitimidad que sus competidores, más opacos, tendrán dificultades para igualar. Han sustituido la autoridad que proviene del secreto por la autoridad que proviene de la auditabilidad. La batalla por el alma algorítmica está lejos de terminar, pero por primera vez, las reglas del enfrentamiento están escritas para que todos las vean.

Referencias y Fuentes

Anthropic (2025). "Claude’s Political Even-handedness". anthropic.com/news/political-even-handedness

Análisis de la metodología de "IA Constitucional" (Constitutional AI), incluyendo el Aprendizaje por Refuerzo a partir de Retroalimentación de la Máquina (RLAIF).

Detalles sobre el corpus de principios utilizado para la "constitución" del modelo, incluyendo la Declaración Universal de Derechos Humanos de la ONU y la Constitución de los Estados Unidos.

Contexto sobre el problema del sesgo político en los grandes modelos de lenguaje y las limitaciones del método de Aprendizaje por Refuerzo a partir de Retroalimentación Humana (RLHF).

Resultados de las pruebas de Anthropic que comparan la ecuanimidad política de sus modelos constitucionales con los modelos de la competencia.