La narrativa que ha capturado la imaginación de los mercados y los medios de comunicación es una de proporciones casi mitológicas. Es una carrera de titanes, un enfrentamiento de laboratorios de investigación de élite donde OpenAI, Anthropic y Google compiten en una búsqueda acelerada del Santo Grial tecnológico: la inteligencia artificial general. Es una historia de miles de millones de dólares invertidos en ciclos de entrenamiento de seis meses, de modelos que aprenden a razonar, de saltos cuánticos en la capacidad cognitiva que prometen rehacer el mundo. Los analistas escriben volúmenes sobre si GPT-5 supera a Claude 4.1 en filosofía, o si la última iteración de Gemini puede predecir mejor los mercados. Sin embargo, esta narrativa, aunque seductora, está ocultando una revolución mucho más profunda y de consecuencias más inmediatas. La historia real no está ocurriendo en la cima teórica de la superinteligencia; está ocurriendo en las trincheras económicas del coste por token.

Mientras Silicon Valley compite por construir el modelo "mejor", una infraestructura completamente diferente está siendo adoptada en masa. Según informes recientes de Andreessen Horowitz, una de las firmas de capital de riesgo más influyentes del mundo, un asombroso ochenta por ciento de las startups que presentan sus proyectos para financiación no están construyendo sus productos sobre la costosa API de OpenAI o Anthropic. Están construyendo sobre modelos de código abierto provenientes de China. Nombres como DeepSeek, Qwen y Yi, desconocidos para el público general, se han convertido en la capa fundacional de la próxima generación de innovación tecnológica. La razón no es ideológica ni geopolítica; es brutalmente económica. Estos modelos, que ya igualan a GPT-4 en métricas críticas como la codificación, no son solo un poco más baratos. Son cientos de veces más baratos.

Esta discrepancia de costes no es una simple ventaja competitiva; es una fractura fundamental en el mercado. Indica dos filosofías de desarrollo completamente opuestas. Los laboratorios estadounidenses, con su enfoque en la AGI, han perseguido la capacidad a cualquier coste, creando modelos monolíticos, cerrados y exquisitamente caros. Los laboratorios chinos, por otro lado, han optimizado para la eficiencia y la distribución. El resultado es que la verdadera restricción en el despliegue de estas tecnologías nunca fue la capacidad, como nos hicieron creer. Siempre fue la tasa de consumo (burn rate). Y mientras Occidente debatía sobre los riesgos existenciales de la superinteligencia, Oriente resolvió el problema del coste de infraestructura primero, inundando el mercado con alternativas gratuitas o casi gratuitas que simplemente funcionan.

La anatomía de una fractura económica

El abismo que separa las dos estrategias se mide mejor en dólares y centavos, y las cifras son tan extremas que desafían la lógica empresarial convencional. Para entender la disparidad, basta con mirar los costes de entrenamiento. Informes sugieren que OpenAI ha estado gastando aproximadamente quinientos millones de dólares por cada ciclo de entrenamiento de seis meses para su familia de modelos GPT-5. Es un proyecto de escala de Manhattan, que requiere una vasta porción de la capacidad de cómputo global, asumida bajo la premisa de que el producto final será tan superior que justificará cualquier precio. En el otro extremo del espectro, DeepSeek, un laboratorio chino, entrenó su modelo de alto rendimiento, que supera a GPT-4 en benchmarks de codificación, con un coste estimado de solo cinco millones de dólares. No es una diferencia de grado; es una diferencia de especie. Es la diferencia entre construir una catedral gótica a mano durante un siglo y levantar un rascacielos prefabricado en un año.

Esta diferencia de cien veces en el gasto de capital inicial se traduce directamente en la única métrica que importa para un desarrollador: el precio de la API. Una startup que utiliza la tecnología de OpenAI para impulsar su aplicación paga aproximadamente treinta dólares por cada millón de tokens procesados por GPT-4. Una startup que opta por el modelo de código abierto de DeepSeek paga catorce centavos por el mismo millón de tokens. Es una diferencia de coste de doscientas catorce veces. Esta no es una métrica de vanidad; es la diferencia entre la vida y la muerte para una nueva empresa.

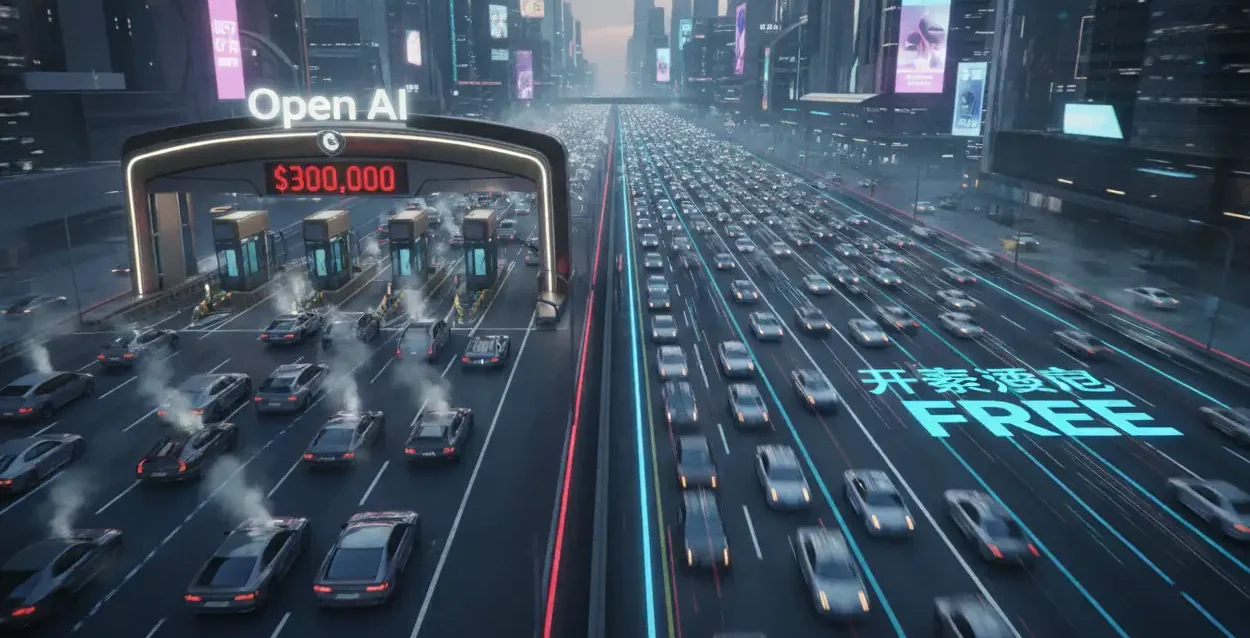

El capital de riesgo se basa en una métrica principal: la "pista de despegue" (runway), el tiempo que una startup puede operar antes de quedarse sin dinero. La elección de la infraestructura de modelo define esta métrica. Consideremos una startup modesta que quema cien millones de tokens al mes. Si construye sobre la infraestructura de OpenAI, su factura mensual de API es de trescientos mil dólares. Si su financiación inicial fue de un millón de dólares, esa startup estará muerta en poco más de tres meses. La misma startup, utilizando DeepSeek, paga una factura mensual de mil cuatrocientos dólares. La diferencia entre trescientos mil y mil cuatrocientos dólares no es una optimización de costes; es la diferencia entre dieciocho meses de pista de despegue y tres meses. Es la diferencia entre tener tiempo para encontrar un mercado y la bancarrota instantánea.

| Plataforma de Modelo | Coste Mensual Estimado (100M tokens) | Pista de Despegue (con $1M capital) |

|---|---|---|

| Startup con GPT-4 (Cerrado) | $300,000.00 | ~ 3 meses |

| Startup con DeepSeek (Abierto) | $1,400.00 | ~ 18+ meses |

Este gráfico de barras no ilustra una competencia de mercado; ilustra una disrupción violenta. El coste de la infraestructura de OpenAI no es un precio premium; es una barrera de entrada impagable para la gran mayoría de los innovadores. El ochenta por ciento de las startups que acuden a Andreessen Horowitz no eligen el código abierto chino porque sean entusiastas de esa tecnología. Lo eligen porque, de lo contrario, sus empresas no existirían. La economía, con su lógica implacable, está tomando la decisión por ellos. Silicon Valley ha construido un coche deportivo de lujo, hecho a mano y con un precio de un millón de dólares, mientras que los laboratorios chinos están produciendo en masa un vehículo eléctrico fiable y gratuito que regalan en cada esquina. ¿Cuál de los dos se convertirá en la infraestructura de transporte estándar?

El dominio chino en las listas de clasificación de código abierto es ahora absoluto. Las dieciséis posiciones superiores en los rankings de modelos abiertos no están ocupadas por Llama de Meta o las variantes de Mistral; están ocupadas por DeepSeek, Qwen (de Alibaba) y Yi (de 01.AI). Estos laboratorios han optimizado obsesivamente la eficiencia, descubriendo cómo alcanzar un rendimiento del noventa y nueve por ciento de GPT-4 con el dos por ciento de su coste computacional. Han demostrado que el juego no consistía en alcanzar el cien por cien de capacidad, sino en alcanzar el noventa y cinco por ciento por un céntimo. Mientras OpenAI y Anthropic afinan sus modelos para discutir sobre ética kantiana, DeepSeek afinó el suyo para escribir código Python más rápido y barato que nadie. Adivinen qué habilidad valora más una startup que intenta lanzar un producto.

El foso construido al revés

La estrategia de los gigantes de Silicon Valley, particularmente OpenAI y Anthropic, se basaba en una suposición clásica del software de lujo: que el foso defensivo (la "ventaja competitiva") era la calidad del modelo. La creencia era que, al construir los modelos más potentes y mantenerlos cerrados, podrían establecer un monopolio de facto sobre la inteligencia de alta gama. Las empresas pagarían un precio premium por acceder al "mejor" cerebro, y este acceso exclusivo financiaría la siguiente ronda de investigación en una espiral virtuosa hacia la superinteligencia. Durante un tiempo, esta tesis pareció correcta. Pero la base de esa tesis era que la calidad era inalcanzable y que la diferencia entre GPT-4 y el resto era un abismo infranqueable.

El ascenso de los modelos de código abierto eficientes ha demostrado que esa suposición era fundamentalmente errónea. El foso no era la calidad; era el coste de la inferencia. Y los laboratorios estadounidenses han construido su foso al revés: en lugar de mantener a los competidores fuera, han encerrado a sus clientes dentro de una estructura de costes insostenible, mientras que los competidores reparten herramientas gratuitas en el exterior. El socio de Andreessen Horowitz, Anjney Midha, cuyas inversiones dependen de predecir correctamente el futuro, ha sido contundente al respecto, declarando que en el ámbito del código abierto, "es realmente el juego de China en este momento". Midha no está hablando de puntos de referencia académicos; está hablando de quién controla la capa fundacional sobre la que se construirá la próxima década de software.

Esta dinámica de costes genera un efecto de segundo orden que es aún más peligroso para el dominio de OpenAI: la especialización. Cuando una startup paga treinta dólares por millón de tokens, está pagando por una utilidad genérica. El modelo GPT-4 es un "sabelotodo" costoso. Debido al precio prohibitivo, la startup no puede permitirse el lujo de reentrenar o "afinar" (fine-tune) el modelo para su caso de uso específico. Están atascados usando el mismo cerebro genérico que usa su competencia. Esto limita la innovación a la creación de "envoltorios" (wrappers) superficiales alrededor de una API centralizada.

Por el contrario, cuando el coste de la infraestructura es casi gratuito, el modelo base de código abierto no es el producto final; es la materia prima. Una startup que utiliza DeepSeek puede permitirse ejecutar miles de millones de tokens en sus propios servidores para *afinar* el modelo. Pueden tomar el modelo base, que ya es potente, y especializarlo intensamente en su nicho, ya sea diagnóstico médico, derecho contractual o logística de envío. El resultado es un modelo propietario, especializado y altamente defendible. Irónicamente, el enfoque de código abierto de bajo coste permite a las startups construir fosos competitivos más profundos que los clientes de los modelos cerrados. El modelo de OpenAI crea dependencia; el modelo de DeepSeek crea soberanía. El primero centraliza el valor en el proveedor de la API; el segundo lo distribuye a los innovadores.

La cascada de la supervivencia y la nueva infraestructura global

Lo que estamos presenciando es una cascada de consecuencias de tercer orden que reconfigurará todo el panorama tecnológico. La dinámica es simple. Un fundador en etapa semilla que debe elegir entre una herramienta que le da tres meses de vida y una que le da dieciocho meses, tomará la misma decisión el cien por cien de las veces. No es una elección estratégica; es un imperativo de supervivencia. Esta elección, repetida por decenas de miles de fundadores en todo el mundo, crea un hecho consumado. El ochenta por ciento de startups en la cartera de a16z que adoptan modelos chinos no lo hacen como una "estrategia para China". Lo hacen como una "estrategia de supervivencia".

Este imperativo económico tiene un efecto de bola de nieve. Cada startup que sobrevive al próximo invierno de financiación será, por definición, una que ha optimizado sus costes en torno a la infraestructura de código abierto. Esto crea un ecosistema de herramientas, tutoriales y talento que se construye, por defecto, sobre la base de DeepSeek, Qwen y Yi. La infraestructura de OpenAI y Anthropic corre el riesgo de convertirse en un producto de lujo, una "isla" premium para corporaciones de Fortune 500 dispuestas a pagar precios exorbitantes por un ligero aumento de prestigio o capacidad, mientras que el "continente" de la innovación global se construye sobre una base diferente.

El dilema geopolítico de Silicon Valley

El resultado de esta divergencia es profundamente irónico desde una perspectiva geopolítica. Mientras el gobierno de Estados Unidos intenta activamente frenar el acceso de China a los chips de alta gama, los laboratorios chinos han respondido no solo creando sus propios chips, sino, lo que es más importante, creando software que es radicalmente más eficiente. Han superado la restricción de hardware con ingenio de software. Ahora, la ironía es que las propias startups estadounidenses, el motor de la innovación de Silicon Valley, se están convirtMbiendo en el mayor vector de adopción de la infraestructura de software china, no por coerción, sino por pura lógica capitalista. La economía está superando al nacionalismo.

La batalla ya no es simétrica. Los laboratorios estadounidenses están compitiendo en una carrera hacia el techo teórico, invirtiendo miles de millones para alcanzar una superinteligencia hipotética. Es una búsqueda vertical, costosa y solitaria. Los laboratorios chinos están compitiendo en una carrera de distribución horizontal, optimizando para la adopción masiva. Su objetivo no es la AGI; es la infraestructura. Están haciendo que sus herramientas sean lo suficientemente baratas y accesibles como para convertirse en el equivalente al TCP/IP, Linux o el cemento: el material base invisible sobre el que todo lo demás se construye. El análisis de Anjney Midha es sombrío: mientras Estados Unidos sigue compitiendo para construir el *mejor* modelo, China ya ha ganado la carrera para construir el modelo que *todos usan*.

Referencias y Fuentes

Análisis de las tendencias de inversión en startups y adopción de modelos de código abierto, basado en declaraciones de Anjney Midha, socio de Andreessen Horowitz (a16z).

Datos comparativos de costes de entrenamiento y precios de API de modelos como DeepSeek, Qwen (Alibaba), Yi (01.AI) frente a modelos cerrados como GPT-4 (OpenAI).

Informe del Financial Times (FT) sobre la advertencia de Sebastian Siemiatkowski sobre la posible sobreinversión en centros de datos, contextualizando la tensión entre escala y eficiencia. (Fuente contextual)

Rankings de rendimiento de modelos de código abierto (OSS) que muestran el dominio de los laboratorios chinos en benchmarks de eficiencia y codificación.

Análisis de las implicaciones económicas de la tasa de consumo ("burn rate") de las startups en función de su elección de infraestructura de modelo fundacional.