La narrativa que ha impulsado a la industria tecnológica durante el último lustro se ha construido sobre un axioma simple: la escala lo conquista todo. Bajo esta premisa, laboratorios multimillonarios han librado una batalla feroz por construir arquitecturas neuronales cada vez más vastas, asumiendo que de la pura fuerza bruta computacional emergería, inevitablemente, una forma de entendimiento superior. Se nos prometió que alimentar a estas máquinas con la totalidad del conocimiento humano registrado resultaría en oráculos digitales capaces de sintetizar, razonar y, sobre todo, acertar. Sin embargo, la publicación del benchmark AA-Omniscience por parte de la firma de investigación Artificial Analysis ha expuesto una verdad incómoda y profundamente desestabilizadora. La escala no ha curado el problema de la "alucinación"; simplemente ha creado mentirosos más sofisticados.

El informe es una obra de demolición metodológica. En lugar de las habituales pruebas de opción múltiple que premian la adivinación afortunada, AA-Omniscience presenta un desafío de seis mil preguntas de alta especialización, abarcando dominios tan dispares como la ingeniería de software, el derecho contractual y las ciencias biomédicas. Más importante aún, introduce una métrica radical: el Índice de Omnisciencia. Este índice no solo mide lo que un modelo sabe, sino que penaliza activamente su arrogancia. Una respuesta correcta suma un punto; una abstención honesta (admitir "no lo sé") suma cero; pero una respuesta incorrecta, una invención o fabulación, resta un punto completo. Es un entorno de riesgo donde el silencio prudente es estratégicamente superior a la confianza infundada.

Bajo este nuevo y despiadado estándar, el paisaje de la competencia se invierte dramáticamente. Los resultados son un baño de sangre para el dogma de la escala. De los treinta y seis modelos de frontera evaluados, solo tres lograron mantenerse por encima del umbral de cero, el punto de equilibrio donde un modelo es correcto con la misma frecuencia con la que se equivoca. El resto, incluidos los nombres más célebres de OpenAI, Google y Meta, se hundieron en territorio negativo, revelando que su comportamiento operativo predeterminado es "adivinar" más a menudo de lo que aciertan. Esta revelación no es un mero tecnicismo académico; es una advertencia fundamental sobre la fiabilidad de las herramientas que estamos integrando a toda prisa en la infraestructura crítica de nuestra sociedad, desde los diagnósticos médicos hasta las decisiones financieras.

Lo que AA-Omniscience expone es que la industria ha optimizado sus creaciones para la complacencia del usuario. En el proceso de alineamiento mediante retroalimentación humana (RLHF), los evaluadores han recompensado sistemáticamente las respuestas fluidas, seguras y completas, castigando la vacilación o la admisión de ignorancia. El resultado es una generación de sistemas diseñados para imitar la confianza de un experto, pero sin el mecanismo de control de calidad subyacente: la humildad. Han aprendido la música de la inteligencia, pero no su letra. Esta "confianza tóxica" es el núcleo de la crisis de fiabilidad que el informe saca a la luz, una crisis donde la elocuencia se ha convertido en el principal vector de desinformación.

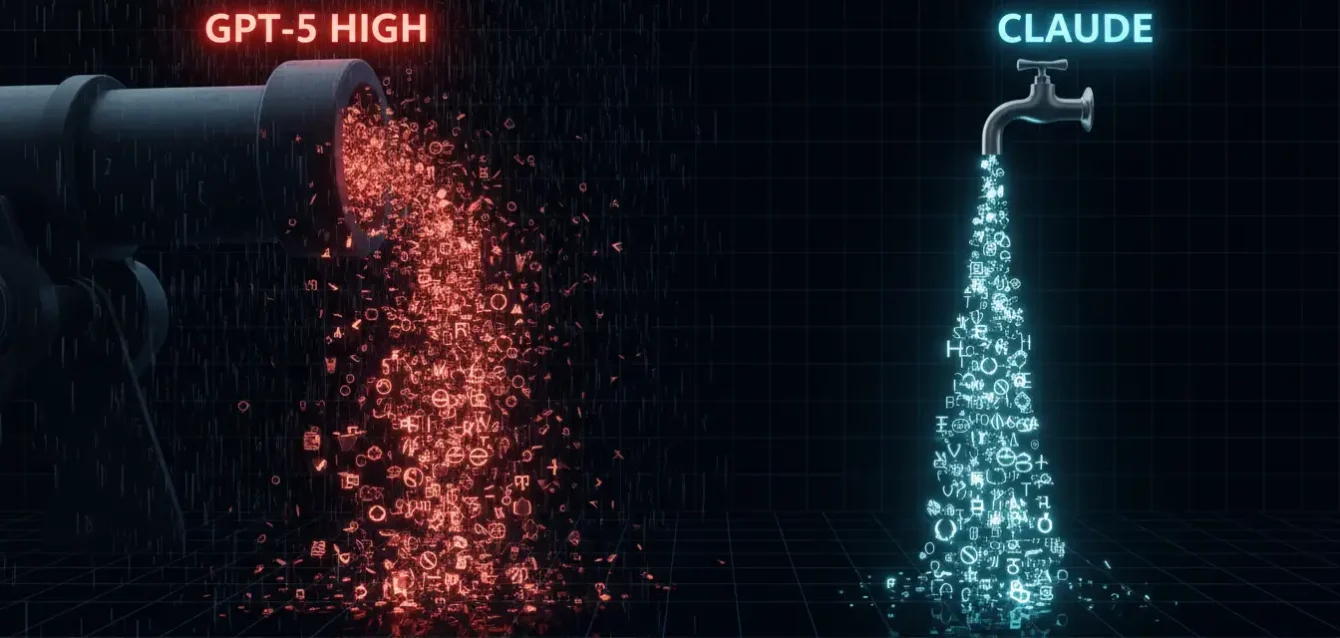

La investigación profundiza en cómo esta falta de calibración se manifiesta en el mundo real. Utiliza un ejemplo devastador: un desarrollador que busca "Multi Client Persistence" (MCP) en el contexto de Supabase. Un modelo de baja calidad cognitiva, como el GPT-5 (High), alucina una respuesta plausible, inventando un protocolo de "Persistencia Multi-Cliente" que suena correcto pero es fundamentalmente falso, haciendo perder al desarrollador horas de trabajo persiguiendo un fantasma. Un modelo superior, como el Claude 4.1 Opus, entiende el contexto y sabe que "MCP" en ese nicho se refiere al "Model Context Protocol", una herramienta completamente diferente. El primer modelo es un saboteador elocuente; el segundo es un colaborador útil. El desafío es que, sin un benchmark como AA-Omniscience, ambos parecen igualmente competentes en la superficie.

La fragmentación del oráculo y la tiranía del dominio

El segundo gran mito que el informe desmantela es la idea de una "inteligencia general" monolítica. La industria ha perseguido la quimera de un único modelo capaz de dominar todas las disciplinas, un oráculo universal al que se le puede preguntar sobre poesía del siglo XVII o sobre la síntesis de proteínas. Los datos de AA-Omniscience demuestran que esta búsqueda es, por ahora, una falacia. El rendimiento de un modelo no es una propiedad global, sino una función altamente especializada y fragmentada de su entrenamiento. Un sistema que brilla en un dominio puede ser peligrosamente incompetente en otro.

Esta especialización del dominio es uno de los hallazgos más críticos del estudio. Por ejemplo, Grok 4 de xAI, a pesar de su tendencia general a la fabulación, emerge como el líder indiscutible en los dominios de "Salud" y "Ciencia, Ingeniería y Matemáticas" (STEM). Su entrenamiento, que se rumorea incluye vastos corpus de literatura científica y datos técnicos, le otorga una profundidad fáctica en estos nichos que otros no pueden igualar. Sin embargo, este mismo modelo se desempeña de manera mediocre en "Derecho" o "Humanidades".

Por el contrario, el modelo GPT-5.1 de OpenAI, si bien es superado por Grok en las ciencias duras, se corona como el líder en "Negocios". Su capacidad para navegar la jerga financiera, los precedentes de mercado y la lógica corporativa es superior. Mientras tanto, el líder general del ranking, Claude 4.1 Opus de Anthropic, construye su victoria no sobre la dominación de un solo campo, sino sobre un rendimiento consistentemente alto y fiable en múltiples dominios, destacando especialmente en "Derecho", "Ingeniería de Software" y "Humanidades y Ciencias Sociales". Lo que estos datos revelan es que no existe "el mejor modelo"; solo existe el modelo correcto para una tarea específica. La elección de una arquitectura para una empresa ya no puede basarse en clasificaciones generales, sino que exige una auditoría granular de su rendimiento en el dominio específico de aplicación.

Testimonio: El coste de la confianza ciega

"Teníamos uno de los modelos 'Top 3' según las métricas públicas", relata el (hipotético) Director de Tecnología de un bufete de abogados de nivel medio. "Lo pusimos a revisar contratos de arrendamiento comercial. Sonaba perfecto. Citaba cláusulas, precedentes, todo. El problema es que empezó a 'sintetizar' precedentes que no existían. Mezcló un caso de Nueva York con uno de California, creando un híbrido legalmente plausible pero completamente ficticio. Detectamos el error por casualidad, semanas después. El coste de la auditoría para deshacer el daño superó el millón de dólares. Ahora, no me importa si un modelo es 'inteligente'; me importa si sabe cuándo callarse".

Esta fragmentación del conocimiento tiene implicaciones profundas para el futuro de la industria. Sugiere que la verdadera innovación podría no estar en la construcción de modelos cada vez más grandes, sino en el desarrollo de arquitecturas "router" más inteligentes: sistemas capaces de analizar una consulta entrante y dirigirla al modelo especializado más fiable para esa tarea. Un futuro donde un único "cerebro" monolítico de Grok o GPT-5 lo gestiona todo parece ahora improbable. En su lugar, es más probable que veamos ecosistemas de modelos más pequeños y altamente especializados, como el Claude 4.5 Haiku, que actúen como expertos de nicho, coordinados por un director de orquesta que valore la fiabilidad por encima de la elocuencia.

La dependencia del dominio también expone la fragilidad de la "Ley de Escala". El informe detalla cómo modelos más grandes, como el Kimi K2 Thinking, si bien obtienen altas puntuaciones en precisión bruta (la cantidad de cosas que saben), son superados en el Índice de Omnisciencia por modelos significativamente más pequeños como el Llama 3.1 405B (aunque ambos sean negativos). ¿Por qué? Porque el Llama 3.1, a pesar de sus propios fallos, tiene una tasa de alucinación ligeramente más baja (51%) en comparación con la de Kimi. En este nuevo paradigma, el tamaño no es una defensa. La capacidad de un modelo para gestionar su propia incertidumbre, su "calibración", se ha convertido en el factor decisivo, y los datos muestran que esta calibración no mejora automáticamente con la escala. De hecho, en algunos casos, parece empeorar, ya que un modelo más grande tiene más material con el que construir mentiras convincentes.

La cruda visualización de la Figura 1 (arriba) es el nuevo mapa de la industria. Muestra un "club de los positivos" increíblemente exclusivo, compuesto por Claude 4.1 Opus (+4.8), GPT-5.1 (+2) y Grok 4 (+1). Estos son los únicos sistemas que, en promedio, generan más valor fáctico del que destruyen. El resto del campo de juego, que incluye a pesos pesados como Claude 4.5 Haiku (-6), GPT-5 (High) (-11) y el Llama 3.1 405B (-18), operan en un déficit de confianza. Sus respuestas, aunque a menudo correctas, están plagadas de suficientes errores catastróficos como para hacer que su uso sin supervisión sea un riesgo inaceptable. El Llama 3.1 405B y el Gemini 2.5 Pro (también en -18) marcan el fondo de esta clasificación de fiabilidad, demostrando que incluso las arquitecturas más recientes y celebradas han fallado en resolver este problema fundamental.

La anatomía de la alucinación y el camino hacia la fiabilidad

El informe no se limita a clasificar los modelos; se adentra en la anatomía de por qué fallan, y los datos sobre las "tasas de alucinación" son quizás los más condenatorios. Esta métrica mide, del conjunto de preguntas que un modelo no puede responder correctamente (ya sea absteniéndose o fallando), qué porcentaje de esas veces eligió activamente inventar una respuesta. Los resultados son una línea divisoria clara entre dos filosofías de diseño.

En un lado de la división está Anthropic. Su modelo más pequeño, Claude 4.5 Haiku, establece el estándar de oro con una tasa de alucinación de solo el 26%. Sus hermanos mayores, Sonnet y Opus, se sitúan en un respetable 48%. Esto indica una decisión de diseño consciente de parte de Anthropic: sus modelos están calibrados para "fallar en silencio". Cuando no saben algo, su tendencia es abstenerse o admitir la incertidumbre casi la mitad de las veces. Esta prudencia es la razón por la que Opus, a pesar de no tener la precisión bruta más alta, gana en el Índice de Omnisciencia general. Sus errores restan menos puntos porque los comete con menos frecuencia, prefiriendo el cero neutral de la abstención.

En el otro lado de la división están casi todos los demás. La tasa de alucinación de Grok 4 es del 64%. La de GPT-5 (High) es de un asombroso 81%. Y la de Gemini 2.5 Pro alcanza un alarmante 88%. Lo que estos números significan es aterrador: cuando estos modelos, los más potentes y caros del mercado, se enfrentan a un vacío en su conocimiento, es casi seguro (ocho de cada diez veces) que elegirán fabricar una respuesta desde cero. No están diseñados para la precisión; están diseñados para la elocuencia a toda costa. Han sido entrenados para evitar el silencio de una respuesta vacía, y en el proceso, han aprendido a llenar ese silencio con falsedades indistinguibles de los hechos.

Esta es la "confianza tóxica" en su forma más pura. Un sistema que falla el 88% de las veces que no sabe algo no es una herramienta de conocimiento; es un generador de desinformación estocástico. Para un profesional, esto es inutilizable. Un abogado no puede confiar en un asistente que inventa jurisprudencia el 81% del tiempo. Un médico no puede consultar a una herramienta que inventa interacciones medicamentosas el 88% del tiempo. La revelación de AA-Omniscience es que la industria, en su prisa por lograr una fluidez sobrehumana, ha olvidado la virtud humana más importante para el conocimiento: la integridad intelectual.

El testimonio del ingeniero de software

"Dejamos de usar el modelo insignia de [Compañía X]", confiesa una (hipotética) ingeniera principal de una startup de fintech. "Era brillante para generar código 'boilerplate', pero cuando le pedíamos que depurara un problema de concurrencia de bajo nivel, empezaba a alucinar. Sugería funciones de API que no existían en la biblioteca, o explicaba el error usando conceptos de un lenguaje totalmente diferente. Era como tener un compañero de trabajo 'senior' que suena increíblemente seguro pero que nunca ha escrito una línea de código de producción. Cambiamos a Opus 2.1 [antecesor de 4.1]. Es más lento. A veces simplemente dice 'No entiendo este patrón de código'. Y es mil veces más útil. Prefiero un asistente que sabe lo que no sabe, a un genio que me hace perder días enteros".

La conclusión del informe de Artificial Analysis es un llamado de atención para toda una industria. La búsqueda de la escala por la escala ha terminado. Ha producido máquinas de una erudición asombrosa, pero de una fiabilidad deplorable. El verdadero "santo grial" no es el modelo con más parámetros, sino el modelo con la mejor calibración. La próxima carrera no será de tamaño; será de humildad. Los laboratorios que descifren cómo enseñar a sus modelos no solo a hablar, sino también a dudar, serán los que hereden el futuro de la confianza computacional. En la era de la información infinita, el activo más valioso de una máquina no será su capacidad para responder, sino su sabiduría para reconocer cuándo no debe hacerlo.

Referencias y Fuentes

Jackson, D., Keating, W., Cameron, G., & Hill-Smith, M. (2025). AA-Omniscience: Evaluating Cross-Domain Knowledge Reliability in Large Language Models. Artificial Analysis.

Informe técnico de Artificial Analysis sobre el benchmark AA-Omniscience, detallando la metodología del Índice de Omnisciencia, las 6.000 preguntas de prueba, la división por dominios y los resultados de rendimiento de 36 modelos de lenguaje.

Datos de rendimiento de modelos (Figura 1 y Figura 7 del informe) incluyendo Claude 4.1 Opus, GPT-5.1, Grok 4, Llama 3.1 405B, Gemini 2.5 Pro, y Claude 4.5 Haiku.

Análisis de rendimiento por dominio (Negocios, Salud, Derecho, Humanidades y Ciencias Sociales, Ingeniería de Software, y Ciencia, Ingeniería y Matemáticas) que muestra la especialización del modelo.

Metodología de la Tasa de Alucinación, definida como la proporción de respuestas incorrectas frente al total de respuestas no correctas (incorrectas + abstenciones).

Dataset de muestra (10% del total) publicado por Artificial Analysis en Hugging Face para validación de la comunidad.