La carrera de la inteligencia artificial ha estado definida, hasta ahora, por una métrica de fuerza bruta: el tamaño del preentrenamiento. El debate se centraba en quién podía construir el clúster de supercómputo más grande y costoso para entrenar el próximo modelo de lenguaje masivo. Con un anuncio estratégico, Satya Nadella, CEO de Microsoft, acaba de cambiar las reglas del juego. La compañía no está simplemente construyendo un superordenador más grande; está construyendo una "superfábrica" de IA a escala continental. El objetivo ya no es solo el preentrenamiento, sino la gestión de todo el ciclo de vida de la IA: desde el ajuste fino y el aprendizaje por refuerzo (RL) hasta la generación de datos sintéticos y la inferencia a escala planetaria.

El corazón de este anuncio es "Fairwater", un nuevo tipo de centro de datos que comienza en Atlanta y Wisconsin, diseñado para una "flota fungible". El término "fungible" es la clave de todo el anuncio: significa intercambiable. La visión de Microsoft es crear una red tan unificada y elástica que los desarrolladores puedan escalar más allá de la capacidad de un solo sitio, combinando dinámicamente diferentes generaciones de *hardware* y sistemas de IA en un único grupo de cómputo cohesivo. Ya no se trata de "islas" de poder de cómputo; se trata de un océano unificado. En el centro de esta nueva economía está un nuevo lema: "convertir cada gigawatt en el máximo número de tokens útiles", reconociendo que no todos los gigawatts se crean iguales.

La 'superfábrica' y la filosofía de la densidad

El primer pilar de esta estrategia es el propio centro de datos Fairwater. A diferencia de las vastas llanuras de servidores de una sola planta a las que estamos acostumbrados, Fairwater es un monstruo de dos pisos diseñado para una densidad de GPU sin precedentes. Microsoft explica que este diseño, combinado con sistemas de refrigeración líquida de última generación, les permite "colocar racks en tres dimensiones". Esta no es una simple decisión arquitectónica; es una ley fundamental de la física del supercómputo. La latencia, el tiempo que tarda una señal en viajar, es el enemigo. Al empaquetar las GPU de forma increíblemente densa, se minimiza la longitud de los cables, mejorando drásticamente la latencia y el ancho de banda efectivo entre las GPU. Para el entrenamiento de IA a gran escala, la velocidad de la red es tan importante como la velocidad del chip.

Estos sitios están diseñados para integrar "cientos de miles" de las últimas GPU de NVIDIA en un solo clúster coherente. Pero Nadella también señaló que más de 100.000 de los nuevos superchips GB300 de NVIDIA entrarán en funcionamiento este trimestre solo para tareas de inferencia en el resto de la flota. La escala es difícil de comprender. Fairwater proporciona la fuerza bruta para el entrenamiento y el ajuste fino más masivos, mientras que el resto de la red de Azure absorbe la carga de inferencia global. Este diseño de máxima densidad es la base física sobre la que se construye la visión de la flota fungible.

La flota fungible: un continente como un solo ordenador

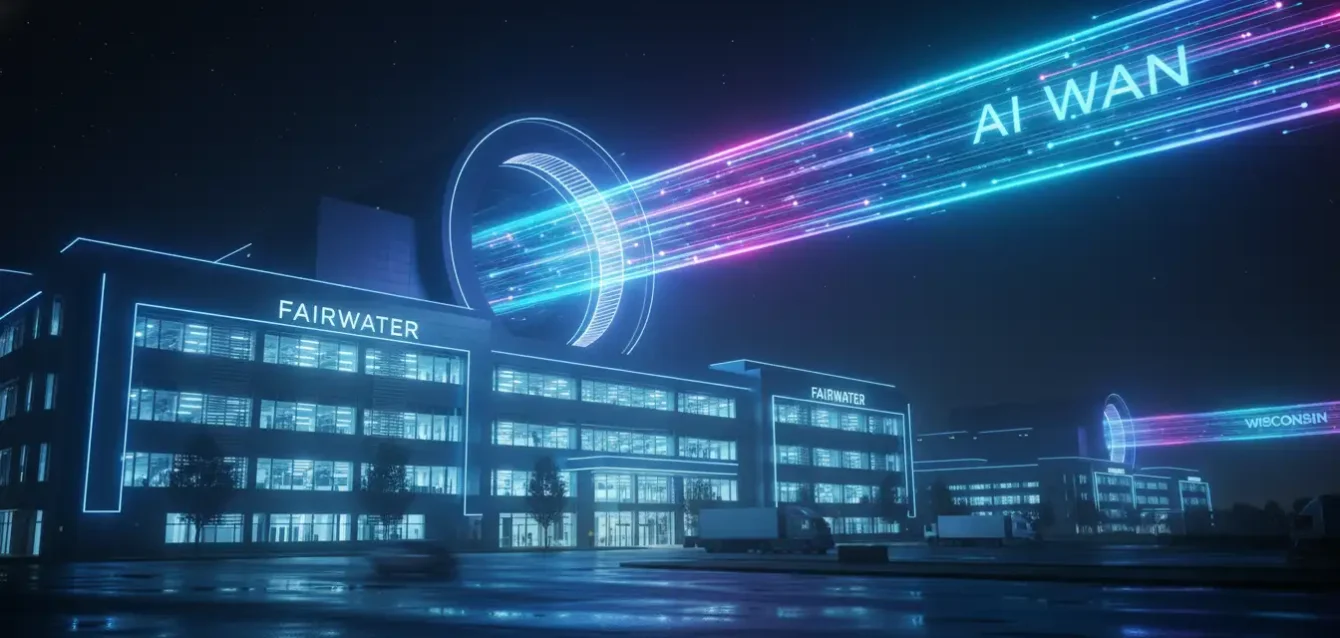

El segundo pilar, y el más revolucionario, es la "flota fungible" (fungible fleet). Un centro de datos, por muy denso que sea, sigue siendo una isla. Si un desarrollador necesita más poder del que esa isla puede ofrecer, está atascado. La solución de Microsoft es la "AI WAN", una red de área amplia que abarca todo el continente, diseñada específicamente para conectar estas superfábricas de Fairwater con las "generaciones anteriores" de supercomputadoras de IA de Azure. Esta red es el tejido conectivo que convierte todas las islas en un solo continente de cómputo.

Aquí es donde el término "fungible" cobra vida. Microsoft está unificando diferentes generaciones de silicio y sistemas de IA en un "único sistema elástico". Para un desarrollador, esto es un cambio de juego. Ya no necesitan preocuparse por *dónde* se ejecuta su carga de trabajo. Pueden "aterrizar dinámicamente las cargas de trabajo en la infraestructura adecuada". Esto significa que una tarea de entrenamiento masiva puede asignarse al clúster Fairwater de Atlanta, mientras que millones de pequeñas tareas de inferencia se distribuyen entre los chips GB300 más eficientes energéticamente en Virginia, y un trabajo de ajuste fino de bajo costo podría ejecutarse en un clúster de GPU de la generación anterior en Wisconsin. El sistema lo gestiona todo, asegurando que ningún ciclo de GPU se desperdicie.

Esta capacidad de "escalar sin fisuras" entre el entrenamiento y la inferencia es crucial. Históricamente, estos eran dos problemas diferentes que requerían dos tipos diferentes de infraestructura. Microsoft los está fusionando en un solo grupo de recursos. La compañía está construyendo una abstracción sobre su *hardware* físico, permitiendo a los desarrolladores tratar todo el continente norteamericano como una sola computadora.

| Parámetro | Enfoque de Nube Tradicional (Silos de IA) | Superfábrica 'Fairwater' (Flota Fungible) |

|---|---|---|

| Arquitectura | Clústeres aislados (islas) para tareas específicas (ej. entrenamiento). | Un solo sistema elástico (continente) conectado por una AI WAN. |

| Gestión de Carga | Estática. El desarrollador debe elegir el clúster. | Dinámica. El sistema asigna la carga a la infraestructura óptima. |

| Generaciones de Hardware | Silos por generación (Clúster A100, Clúster H100). | Generaciones múltiples (nuevas y antiguas) unificadas en un solo pool. |

| Ciclo de Vida de IA | Optimizado para una sola tarea (ej. preentrenamiento masivo). | Optimizado para el ciclo de vida completo (entrenamiento, ajuste, RL, inferencia). |

| Métrica de Eficiencia | Rendimiento máximo de un solo clúster (Petaflops). | Máximo de "tokens útiles por gigawatt" en toda la flota. |

No todos los gigawatts se crean iguales

La estrategia de Microsoft aborda directamente el problema más apremiante de la era de la IA: el consumo de energía. La construcción de modelos de IA consume una cantidad de electricidad a escala de una pequeña nación. La respuesta de Nadella es un nuevo y brillante eslogan: "¡No todos los GW (gigawatts) son creados iguales!". Este es un ataque directo a la idea de que la fuerza bruta es la única solución. Microsoft está redefiniendo la eficiencia. El objetivo no es solo tener la mayor cantidad de GPUs, sino tener la *utilización* más alta de esas GPUs.

Una flota fungible es intrínsecamente más eficiente. En un modelo de silos, un clúster de entrenamiento masivo puede estar inactivo el 80% del tiempo mientras espera la próxima gran ejecución. En el modelo de Microsoft, esas mismas GPUs pueden ser reasignadas instantáneamente para ejecutar millones de tareas de inferencia o cientos de trabajos de ajuste fino. Al garantizar que "ninguna GPU se quede innecesariamente inactiva", Microsoft maximiza el "número de tokens útiles" que puede exprimir de cada gigawatt de electricidad que consume. Esta es una optimización no solo de costo ("rendimiento por dólar"), sino también de eficiencia energética ("rendimiento por vatio").

Esta capacidad se vuelve aún más poderosa cuando se combina con el resto de los servicios en la nube de Azure. Una IA no existe en el vacío; necesita acceso a bases de datos, almacenamiento, servicios de aplicaciones y herramientas de red. Microsoft está integrando esta capacidad de IA elástica directamente en la misma plataforma que sus clientes ya utilizan para todo lo demás. La "superfábrica" no es un complemento; es el nuevo núcleo de la nube de Azure.

La nueva ventaja competitiva: la arquitectura unificada

El anuncio de Microsoft redefine la ventaja competitiva en la nube. Ya no se trata solo de quién tiene el chip más rápido de NVIDIA (aunque tener 100,000 de los últimos es una ventaja). La verdadera ventaja es la arquitectura de *software* y red que unifica ese silicio. Al crear una "flota fungible", Microsoft está construyendo un "foso" estratégico. Los competidores pueden comprar las mismas GPUs, pero no tendrán la red de área amplia (AI WAN) ni la pila de software de orquestación para fusionar generaciones de hardware dispares en un solo sistema elástico. Esta es una apuesta a que la inteligencia de la *flota* es más importante que la velocidad de la *unidad* individual.

En esencia, Satya Nadella ha presentado su plan para la industrialización de la inteligencia artificial. La era de la experimentación artesanal está terminando, y comienza la era de la producción en masa. Fairwater no es solo un centro de datos; es la primera verdadera línea de ensamblaje para la producción de "tokens", la nueva mercancía que definirá el próximo siglo. Al unificar la infraestructura a escala continental, Microsoft no solo está preparando a Azure para ganar la guerra de la nube de IA, sino que está sentando las bases para ser el sistema operativo de la inteligencia futura.

Referencias

Blog de Microsoft. "Infinite scale: The architecture behind the Azure AI superfactory". 12 de noviembre, 2025.

Satya Nadella (X/Twitter). "Anuncio del centro de datos Fairwater". 12 de noviembre, 2025.

TechCrunch. "Microsoft’s 'AI superfactory' is a two-story datacenter for maximum GPU density". 13 de noviembre, 2025.

AnandTech. "Microsoft's 'Fungible Fleet': Unifying GPUs Across Continents with AI WAN". 13 de noviembre, 2025.

NVIDIA. "NVIDIA GB300 Enters Full Production for Cloud Partners". Noviembre 2025.

YouTube. "Inside the world's most powerful datacenter (2025) — Satya Nadella". 13 de noviembre, 2025.