En lo que representa una revelación fundamental sobre la naturaleza de la inteligencia artificial contemporánea, investigadores han establecido formalmente que los grandes modelos de lenguaje (LLMs) como ChatGPT, Claude y Gemini son, en esencia, algoritmos aleatorios en el sentido clásico de la ciencia de la computación. Esta conexión, que une tecnologías de vanguardia con un campo matemático estudiado desde la década de 1940, proporciona un marco teórico sólido para comprender el comportamiento aparentemente impredecible de estos sistemas.

La comprensión de los LLMs como algoritmos aleatorios explica por qué estos sistemas pueden producir respuestas diferentes para la misma entrada y revela que esta característica no es un defecto, sino una propiedad intencional y cuidadosamente diseñada. El no determinismo de los LLMs está programado explícitamente en su arquitectura mediante una sola línea de código que instruye al modelo para seguir sus probabilidades predichas en lugar de seleccionar siempre el token más probable.

Esta perspectiva conecta directamente el trabajo de pioneros como Rajeev Motwani, ganador del premio Gödel y coautor del algoritmo original de búsqueda de Google, con los desarrolladores modernos de IA. Motwani, quien sorprendía a sus estudiantes con la afirmación de que "un algoritmo que toma decisiones aleatorias puede ser mejor que uno que toma decisiones deterministas", anticipó conceptualmente el valor de la aleatoriedad controlada que ahora define la generación de texto por IA.

Los cinco criterios fundamentales: por qué los LLMs califican como algoritmos aleatorios

El análisis técnico revela que los LLMs cumplen sistemáticamente con los cinco criterios que definen a los algoritmos aleatorios clásicos. Primero, toman pasos aleatorios durante el proceso de generación de texto, seleccionando tokens basándose en distribuciones de probabilidad en lugar de elecciones deterministas. Segundo, utilizan una fuente de aleatoriedad explícita, generalmente generadores de números pseudoaleatorios, para implementar estas decisiones estocásticas.

Tercero, sus salidas son no deterministas, produciendo diferentes respuestas para la misma entrada en diferentes ejecuciones. Cuarto, pueden analizarse utilizando el mismo marco teórico que los algoritmos aleatorios tradicionales, con garantías de rendimiento expresadas en términos probabilísticos. Quinto, y quizás más importante, esta aleatoriedad los hace robustos contra ataques adversarios, ya que ningún atacante puede forzar repetidamente el peor comportamiento del sistema.

Características de los algoritmos aleatorios aplicadas a LLMs

Pasos aleatorios: Selección de tokens basada en distribuciones de probabilidad en lugar de máximos deterministas.

Fuente de aleatoriedad: Generadores de números pseudoaleatorios que implementan la selección estocástica.

No determinismo: Diferentes salidas para la misma entrada en ejecuciones diferentes.

Análisis probabilístico: Garantías de rendimiento expresadas en términos estadísticos.

Robustez frente a adversarios: Imposibilidad de forzar repetidamente el peor caso del sistema.

El mecanismo de generación: por qué no elegir siempre el token más probable

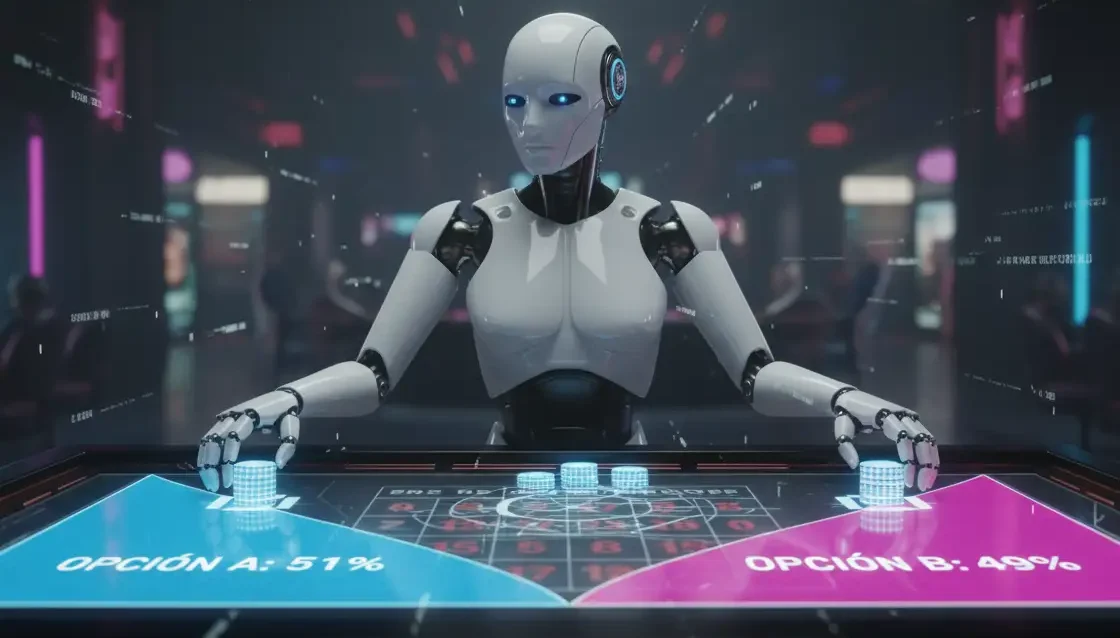

Para comprender por qué los LLMs están diseñados como algoritmos aleatorios, es esencial examinar su proceso de generación de texto. Cuando un LLM procesa una entrada como "El primer motor de vapor comercialmente viable fue creado por James _____", no simplemente selecciona la opción más probable. En cambio, genera probabilidades para diferentes continuaciones (por ejemplo, "Watt" con 80% y "Kirk" con 20%) y luego selecciona aleatoriamente según estas probabilidades.

La intuición detrás de este enfoque contraintuitivo se revela en escenarios donde las probabilidades son muy cercanas. Si un LLM enfrenta una elección donde "Kirk" tiene 51% de probabilidad y "Watt" 49%, un enfoque determinista siempre elegiría "Kirk" y siempre estaría equivocado. El enfoque aleatorio, en cambio, elegiría "Watt" 49% de las veces, siendo correcto en esos casos. Al "apostar" en lugar de estar siempre seguros, los LLMs aumentan la probabilidad de estar en lo correcto en el peor caso.

Robustez frente a adversarios: la ventaja oculta de la aleatoriedad

Uno de los beneficios más significativos de diseñar LLMs como algoritmos aleatorios es la protección contra adversarios. En evaluaciones comparativas, tanto las versiones deterministas como no deterministas de LLMs pueden mostrar tasas de error similares (digamos 27% en un conjunto de preguntas de conocimiento general) pero la distribución de estos errores difiere fundamentalmente.

El LLM determinista fallará exactamente las mismas preguntas cada vez, creando puntos ciegos predecibles que un adversario podría explotar repetidamente. El LLM no determinista también fallará aproximadamente 27% de las preguntas, pero qué preguntas falla cambia en cada ejecución. Esta variabilidad significa que ningún adversario puede hacer que el sistema falle consistentemente en las mismas consultas, proporcionando una capa inherente de seguridad.

Limitaciones en la generación de aleatoriedad de alta calidad

Investigaciones recientes revelan que, aunque los LLMs incorporan elementos aleatorios, su capacidad para generar aleatoriedad de alta calidad es limitada. Estudios que evalúan la capacidad de los LLMs para manejar tareas que requieren aleatoriedad (como generación de números aleatorios, creación de contraseñas y barajado de elementos) encuentran que su rendimiento es inconsistente y a menudo se desvía significativamente del comportamiento esperado.

Estas limitaciones tienen implicaciones importantes para aplicaciones donde la aleatoriedad de alta calidad es crucial, como criptografía, simulaciones científicas y protocolos de seguridad web. La investigación sugiere que los LLMs pueden beneficiarse del acceso a herramientas externas como generadores de números pseudoaleatorios para mejorar su capacidad de manejar tareas que requieren aleatoriedad.

Aplicaciones tradicionales de algoritmos aleatorios: un legado de cinco décadas

Los algoritmos aleatorios tienen un historial de cinco décadas de aplicaciones exitosas en diversos dominios computacionales. Han sido fundamentales en ordenación y búsqueda de datos, algoritmos de grafos y emparejamiento, algoritmos geométricos y algoritmos combinatorios.

El diseño antagónico (la idea de proteger algoritmos contra entradas maliciosamente construidas) ha sido un principio central en el desarrollo de algoritmos aleatorios. La aleatoriedad contrarresta a los adversarios haciendo impredecible qué entrada específica causará el peor rendimiento, incluso cuando el comportamiento del peor caso teórico permanece sin cambios.

El dilema de la aleatoriedad en IA: ¿característica o limitación?

La clasificación de los LLMs como algoritmos aleatorios plantea cuestiones fundamentales sobre la naturaleza de la inteligencia artificial. Por un lado, la aleatoriedad proporciona beneficios tangibles en términos de robustez y diversidad de respuestas. Por otro lado, las investigaciones actuales señalan limitaciones significativas en la capacidad de los LLMs para generar aleatoriedad de alta calidad cuando se necesita para aplicaciones específicas.

Esta dualidad refleja la naturaleza especializada de la aleatoriedad en los LLMs: mientras que su aleatoriedad incorporada es efectiva para proteger contra adversarios y generar respuestas diversas, puede ser insuficiente para tareas que requieren aleatoriedad criptográfica o estadística de alta calidad. Esta distinción es crucial para determinar aplicaciones apropiadas para LLMs en dominios donde la aleatoriedad es un requisito fundamental.

Implicaciones para el futuro del desarrollo de IA

Reconocer a los LLMs como algoritmos aleatorios proporciona un marco teórico sólido para abordar desafíos actuales en el desarrollo de IA. Este entendimiento sugiere que las técnicas y análisis desarrollados durante décadas de investigación en algoritmos aleatorios pueden aplicarse directamente para mejorar la seguridad, confiabilidad y rendimiento de los sistemas de IA.

La conexión también apunta hacia futuras direcciones de investigación, incluyendo el desarrollo de métodos para ajustar dinámicamente el nivel de aleatoriedad según el contexto de aplicación, y la integración de fuentes de aleatoriedad de mayor calidad para aplicaciones que lo requieran. Además, este marco proporciona bases matemáticas sólidas para analizar y mejorar la robustez de los LLMs contra diversos tipos de ataques.

Aplicaciones en evaluación de investigación médica

Los LLMs ya están demostrando utilidad en dominios especializados que requieren evaluación consistente. Estudios recientes han empleado LLMs para evaluar la adherencia de ensayos controlados aleatorios (ECRs) sobre intervenciones de IA con las directrices CONSORT-AI.

En estas aplicaciones, los investigadores utilizan una configuración de temperatura de 0 para garantizar respuestas deterministas, demostrando cómo el control preciso de la aleatoriedad permite adaptar el comportamiento de los LLMs a requisitos específicos de aplicación. Los modelos GPT-4 han mostrado un rendimiento particularmente fuerte en estas tareas de evaluación especializada.

Puentes entre tradición e innovación

La clasificación de los LLMs como algoritmos aleatorios representa más que una curiosidad académica: establece un puente conceptual vital entre cinco décadas de investigación en ciencia computacional y los desarrollos más avanzados en inteligencia artificial. Este entendimiento proporciona un marco teórico sólido para analizar, mejorar y garantizar estos sistemas transformadores.

Al reconocer esta conexión, los desarrolladores e investigadores pueden aprovechar el rico corpus de conocimiento sobre algoritmos aleatorios para abordar desafíos contemporáneos en IA. Desde mejorar la robustez frente a adversarios hasta refinar las propiedades estocásticas de la generación de texto, este marco ofrece herramientas matemáticas precisas para guiar el desarrollo futuro de sistemas de IA más confiables, seguros y efectivos.

Como en tantos otros avances científicos, este reconocimiento demuestra que el progreso a menudo viene no de descartar el conocimiento establecido, sino de redescubrir su relevancia en contextos nuevos y transformadores. Los algoritmos aleatorios, una vez considerados una especialidad esotérica de unos pocos académicos, han emergido como principio fundamental detrás de la tecnología de IA que está redefiniendo la relación entre humanos y máquinas.

Referencias

Towards Data Science. "LLMs Are Randomized Algorithms." Hacia la Ciencia de Datos. 13 de noviembre, 2025.

Karanjai, R. et al. "Evaluating the Quality of Randomness and Entropy in Tasks Supported by Large Language Models." arXiv. 04 de agosto, 2025.

PMC. "Using Large Language Models to Assess the Consistency of Randomized Controlled Trials with AI Interventions." Journal of Medical Internet Research. 26 de septiembre, 2025.

Xu, X. et al. "A Survey on Knowledge Distillation of Large Language Models." arXiv. 2024.

Ahmad, H. "Exploring Cutting-Edge Alternatives to Transformer-Based LLMs." Towards AI. 13 de noviembre, 2025.