En una era de intensa división política, los investigadores descubrieron recientemente algo notable. Tanto en el Reino Unido como en Estados Unidos, las personas de todo el espectro político en gran medida están de acuerdo sobre qué herramientas de IA prefieren. A pesar de toda la conversación sobre lo que nos divide, resulta que la política no es el diferenciador clave. El factor que más significativamente moldea nuestras preferencias de IA es mucho más fundamental: nuestra edad.

Pero el descubrimiento más sorprendente del estudio a gran escala, llamado HUMAINE, no fue lo que divide a las personas. Fue que cuando el equipo analizó los temas de más de 40,000 conversaciones anónimas de una muestra representativa de la población del Reino Unido y Estados Unidos, un tema emergió como el más prominente por un margen claro: la salud y el bienestar.

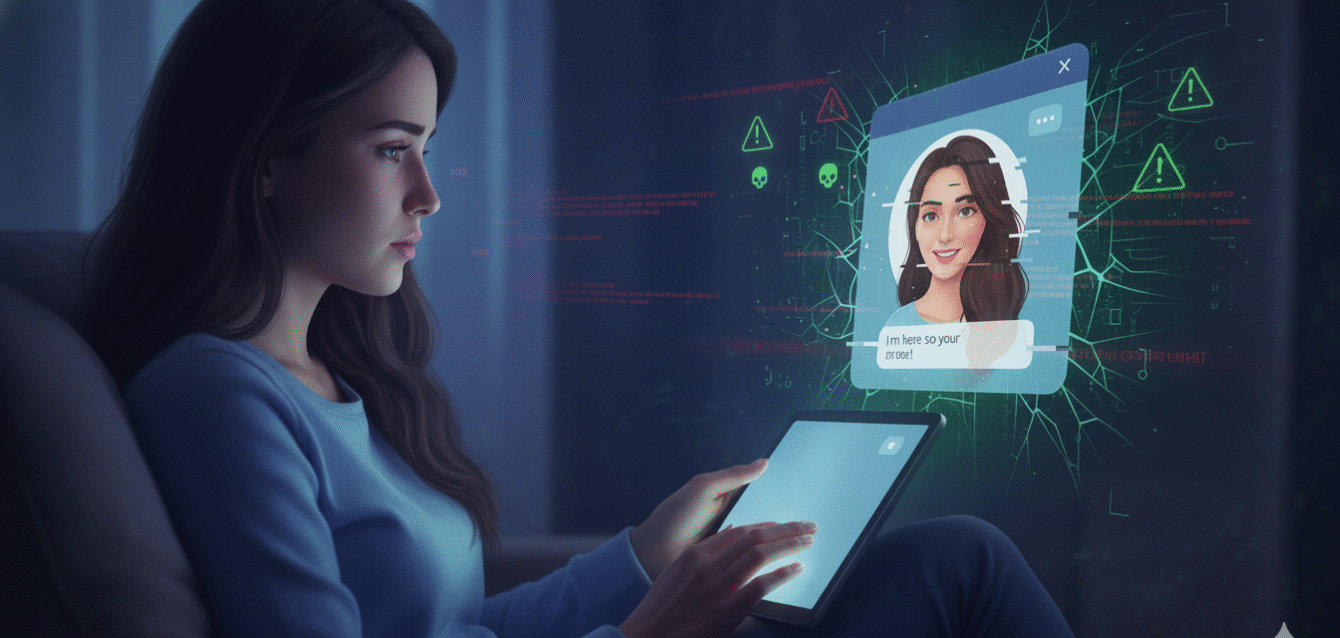

Casi la mitad de estas discusiones se enfocaban en el wellness proactivo como planes de fitness y nutrición. Pero una porción significativa se aventuraba en territorio mucho más sensible. Las conversaciones sobre la salud mental y las condiciones médicas específicas estaban entre las más frecuentes y profundamente personales. La gente está usando abiertamente estos modelos como caja de resonancia para su estado mental, fuente de consuelo y guía para su salud física.

Este hallazgo revela un cambio profundo en nuestra relación con la tecnología y plantea una pregunta inquietante: ¿están nuestros métodos actuales para evaluar la IA equipados para decirnos si están haciendo un buen trabajo? La respuesta honesta es no. La mayor idea errónea que las personas tienen cuando ven una simple tabla de clasificación de IA es que un solo número puede capturar qué modelo es "mejor". La pregunta misma está mal definida. ¿Mejor en qué? Y, más importante, ¿mejor para quién?

La crisis invisible de seguridad

Dado que tantas conversaciones trataban sobre temas sensibles como la salud mental y las condiciones médicas, uno podría esperar que la métrica de confianza y seguridad fuera un diferenciador clave. No lo fue. Cuando los participantes calificaron los modelos en esta dimensión, la respuesta más común por lejos fue un empate. La métrica fue increíblemente ruidosa, con variaciones masivas que no revelaban patrones claros.

Esto no significa que la seguridad no sea importante. En cambio, sugiere que cualidades como la confianza y la seguridad no pueden medirse de manera confiable en las conversaciones del día a día. Los escenarios que realmente prueban la columna vertebral ética de un modelo rara vez surgen orgánicamente. Evaluar estas cualidades críticas requiere un enfoque diferente y más especializado.

Un ejemplo poderoso es el trabajo destacado en una publicación reciente de Stanford HAI, "Exploring the Dangers of AI in Mental Health Care". Su estudio investigó si la IA está lista para actuar como proveedor de salud mental y descubrió riesgos significativos. Encontraron que los modelos no solo podían perpetuar estigmas dañinos contra ciertas condiciones, sino también habilitar peligrosamente comportamientos dañinos al no reconocer la crisis subyacente del usuario.

Los riesgos documentados de la IA en salud mental

Perpetuación de estigmas: Los modelos entrenados en textos que contienen sesgos históricos sobre condiciones de salud mental pueden reproducir y amplificar esos sesgos. Por ejemplo, asociar esquizofrenia con violencia o depresión con debilidad de carácter, reforzando estigmas que los profesionales de la salud mental han trabajado décadas para desmantelar.

Fallo en reconocer crisis: Cuando un usuario expresa ideación suicida o planificación de autolesión, los modelos frecuentemente no reconocen la urgencia de la situación. En lugar de proporcionar recursos de crisis inmediatos o alentar la intervención profesional urgente, pueden ofrecer consejos genéricos de wellness que son completamente inadecuados para la severidad de la situación.

Habilitación de comportamientos dañinos: En algunos casos, los modelos han proporcionado inadvertidamente información que podría usarse para autolesión. Por ejemplo, responder preguntas sobre métodos de autolesión sin reconocer que la consulta podría señalar una crisis, o proporcionar información médica que podría usarse para automedicación peligrosa.

Falsa confianza de los usuarios: Cuando un modelo proporciona consejos de salud mental con confianza aparente, los usuarios pueden confiar en ese consejo en lugar de buscar atención profesional. El tono autorizado de las respuestas puede hacer que los usuarios asuman que el modelo tiene expertise que no posee.

Falta de seguimiento longitudinal: A diferencia de un terapeuta humano que rastrea el progreso del paciente a través del tiempo, los modelos de IA tratan cada conversación como aislada. No pueden detectar patrones de deterioro o proporcionar la continuidad de atención que la salud mental efectiva requiere.

Este tipo de pruebas rigurosas basadas en escenarios es exactamente lo que se necesita. Es alentador ver que tales marcos se están operacionalizando como evaluaciones estandarizadas en plataformas como weval.org de CIP, que permiten las pruebas sistemáticas de modelos en estas situaciones de alto riesgo. Necesitamos urgentemente más evaluaciones de este tipo, así como evaluaciones que capturen los efectos a largo plazo del uso de la IA.

La automatización sin sentido versus la colaboración consciente

El debate no es una simple elección entre la automatización y la colaboración. Automatizar el trabajo tedioso y repetitivo es un regalo. El peligro radica en la automatización sin sentido, que implica optimizar puramente para la finalización de tareas sin considerar el costo humano.

Esto no es un temor hipotético. Ya estamos viendo informes de que los jóvenes y los recién graduados están luchando para encontrar trabajos de nivel de entrada, ya que las mismas tareas que alguna vez formaron el primer peldaño de la escalera de carrera están siendo automatizadas. Cuando los desarrolladores construyen y miden la IA con un enfoque miope en la eficiencia, corremos el riesgo de desqualificar a nuestra fuerza laboral y crear un futuro que sirve a la tecnología, no a las personas.

Aquí es donde la evaluación se convierte en el volante. Si nuestra única métrica es "¿se completó la tarea?", inevitablemente construiremos IA que reemplaza, en lugar de aumentar. Pero, ¿qué pasaría si también midiéramos "¿el colaborador humano aprendió algo?" o "¿el producto final mejoró debido a la asociación humano-IA?"

Hallazgos clave del estudio HUMAINE

Tema dominante: La salud y el bienestar emergieron como el tema más prominente entre más de 40,000 conversaciones analizadas, superando la política, el trabajo, la educación y el entretenimiento por un margen significativo.

División de temas de salud: Casi el 50% de las conversaciones relacionadas con la salud se enfocaban en wellness proactivo (fitness, nutrición, prevención), mientras que la otra mitad abordaba temas más sensibles como la salud mental, las condiciones médicas crónicas y los síntomas agudos.

La edad importa más que la política: El factor demográfico que más significativamente predijo las preferencias de modelo de IA fue la edad, no la afiliación política. Los usuarios más jóvenes valoraban la creatividad y la velocidad, mientras que los usuarios mayores priorizaban la precisión y la exhaustividad.

La métrica de seguridad fue ruidosa: Cuando se les pidió que calificaran los modelos en confianza y seguridad, los participantes frecuentemente no podían diferenciar entre modelos. La métrica mostró una variabilidad masiva, sugiriendo que la seguridad no puede evaluarse de manera confiable en conversaciones orgánicas.

Perfiles de habilidades distintos: Los modelos mostraron perfiles de habilidades diferentes: algunos sobresalieron en el razonamiento técnico, otros en la comunicación empática. No existe un modelo universalmente "mejor", solo modelos mejor adaptados a tareas y usuarios específicos.

Ganador por consistencia: Gemini-2.5-Pro emergió como el modelo de mejor calificación no porque fuera el mejor en ninguna métrica individual, sino porque fue el más consistente en todas las métricas y a través de todos los grupos demográficos.

La investigación HUMAINE muestra que los modelos tienen perfiles de habilidades distintos: algunos son grandes razonadores, mientras que otros son grandes comunicadores. Un futuro de colaboración sostenible depende de valorar y medir estas cualidades interactivas, no solo el output final. Necesitamos métricas que capturen si la participación de la IA es una asociación positiva de ganar-ganar, o un deslizamiento de ganar-perder hacia la automatización.

La tiranía de los benchmarks técnicos

La industria de la IA se ha fijado excesivamente en las medidas técnicas. Este enfoque estrecho, aunque impulsa resultados impresionantes en benchmarks específicos, nos deja volando a ciegas en cuestiones centradas en el ser humano que afectan nuestro uso diario de los LLMs.

La evaluación actual toma dos formas amplias. Por un lado, tenemos benchmarks académicos que miden habilidades abstractas, como la capacidad de un modelo para resolver problemas de matemáticas a nivel de Olimpiada. Por otro lado, tenemos "arenas" públicas donde los usuarios anónimos votan. Esto ha creado una brecha vasta entre la competencia técnica abstracta y la utilidad del mundo real.

Es por eso que un modelo puede parecer un genio en una prueba pero resultar ser un asistente incompetente cuando necesitas que planifique un proyecto complejo o, más críticamente, maneje una consulta de salud sensible. Los benchmarks técnicos miden lo que los modelos pueden hacer en principio, no lo que hacen en la práctica cuando los humanos reales con necesidades reales interactúan con ellos.

Consideremos un ejemplo concreto. GPT-4 puede obtener una calificación casi perfecta en el examen de matemáticas SAT. Esa es una medida impresionante de capacidad de razonamiento abstracto. Pero cuando un usuario le pregunta cómo manejar la ansiedad sobre una próxima entrevista de trabajo, la capacidad del modelo para razonar sobre las matemáticas es irrelevante. Lo que importa es si puede proporcionar apoyo empático apropiado, reconocer cuándo la ansiedad es lo suficientemente severa como para requerir intervención profesional, y evitar consejos que podrían empeorar la situación.

Los benchmarks actuales no miden ninguna de estas cualidades. Miden la destreza técnica en dominios estrechos, no la sabiduría práctica requerida para las aplicaciones del mundo real. Esta brecha entre lo que medimos y lo que importa es el punto ciego más grande de la evaluación de la IA.

Gemini-2.5-Pro: ganar por consistencia, no por brillantez

Al final, un ganador claro sí emergió en el estudio: Gemini-2.5-Pro de Google. Pero la razón por la que ganó es la lección más importante. Ocupó el primer lugar porque fue el más consistente en todas las métricas y a través de todos los grupos demográficos.

Esto es lo que se ve la tecnología madura. Los mejores modelos no son necesariamente los más llamativos; son los más confiables y ampliamente competentes. El progreso sostenible radica en construir sistemas completos y confiables, no solo en optimizar para una sola habilidad estrecha.

Otros modelos podrían haber superado a Gemini en métricas específicas. Claude podría haber sido más empático en ciertas conversaciones. GPT-4 podría haber sido más creativo en tareas generativas. Pero Gemini fue lo suficientemente bueno en todo, y esa confiabilidad a través de dominios es lo que los usuarios reales valoran.

Este hallazgo tiene implicaciones para el desarrollo de modelos. En lugar de perseguir el rendimiento de vanguardia en benchmarks individuales, los desarrolladores deberían enfocarse en la robustez a través de capacidades. Un modelo que es 95% tan bueno como el mejor especialista en cada dominio es más valioso que un conjunto de especialistas que cada uno alcanza el 100% en su dominio pero falla fuera de él.

La brecha demográfica: edad sobre política

El descubrimiento de que la edad importa más que la política en la determinación de las preferencias de IA es fascinante porque va en contra de la narrativa cultural dominante. Vivimos en una era donde se nos dice constantemente que la polarización política es la división definitoria de nuestro tiempo. Sin embargo, cuando se trata de la tecnología de IA, las personas de todo el espectro político quieren cosas similares.

Los usuarios más jóvenes tienden a valorar la creatividad, la velocidad y la novedad. Están más dispuestos a tolerar errores ocasionales si el modelo es generalmente útil e interesante. Los usuarios mayores priorizan la precisión, la exhaustividad y la confiabilidad. Quieren modelos que proporcionen información correcta de manera consistente, incluso si eso significa respuestas más lentas o menos creativas.

Esta división generacional probablemente refleja diferencias en cómo diferentes cohortes de edad se relacionan con la tecnología en general. Los usuarios más jóvenes crecieron con internet y están acostumbrados a filtrar información, verificar hechos y navegar por la incertidumbre digital. Los usuarios mayores desarrollaron la alfabetización digital más tarde y pueden ser más cautelosos sobre confiar en los sistemas automatizados para información crítica.

Comprender estas diferencias demográficas es crucial para desarrollar modelos que sirvan a poblaciones diversas de manera efectiva. Un modelo optimizado para usuarios de 25 años podría frustrar a usuarios de 65 años, y viceversa. La tecnología verdaderamente inclusiva reconoce que diferentes usuarios tienen diferentes necesidades y preferencias, y proporciona flexibilidad para acomodar esa diversidad.

Las evaluaciones que necesitamos pero no estamos haciendo

El estudio HUMAINE apunta hacia un cambio necesario en cómo la comunidad y la sociedad en general piensan sobre el progreso de la IA. Nos alienta a ir más allá de las clasificaciones simples y hacer preguntas más profundas sobre el impacto de nuestra tecnología, como cómo se desempeñan los modelos en toda la población y si ciertos grupos están siendo inadvertidamente desatendidos.

También significa enfocarse en el aspecto humano de la colaboración: ¿la participación de la IA es una asociación positiva de ganar-ganar, o un deslizamiento de ganar-perder hacia la automatización? Estas preguntas no pueden responderse mediante benchmarks técnicos. Requieren estudios longitudinales que rastreen cómo el uso de la IA afecta los resultados humanos a lo largo del tiempo.

Para las aplicaciones de salud específicamente, necesitamos evaluaciones que vayan mucho más allá de la precisión técnica. Necesitamos medir:

Si los modelos reconocen cuándo una consulta señala una crisis que requiere intervención profesional inmediata, no solo consejos generales de wellness. Esto requiere el desarrollo de conjuntos de datos que contengan consultas sintéticas diseñadas específicamente para probar el reconocimiento de crisis.

Si los modelos perpetúan estigmas dañinos sobre las condiciones de salud mental o física, o si trabajan activamente para contrarrestar esos estigmas. Esto requiere análisis de las respuestas de los modelos a través de marcos de sensibilidad a estigmas desarrollados con la entrada de profesionales de la salud mental.

Si los modelos fomentan apropiadamente la búsqueda de atención profesional cuando es apropiado, en lugar de posicionarse como sustitutos de médicos o terapeutas. Esto requiere examinar si los modelos comunican claramente sus limitaciones y cuándo enfatizan que el consejo profesional es necesario.

Si los modelos manejan información de salud sensible con la privacidad y la confidencialidad apropiadas. Aunque las conversaciones pueden ser anónimas desde la perspectiva del investigador, los usuarios a menudo revelan información de identificación. ¿Cómo se protege esta información? ¿Quién tiene acceso a ella? ¿Cómo se usa?

Si los efectos a largo plazo del uso de la IA para el apoyo de salud mental son positivos o negativos. ¿Confiar en la IA para el apoyo emocional mejora o degrada la salud mental a lo largo del tiempo? ¿Reduce o aumenta la probabilidad de que los usuarios busquen atención profesional cuando la necesitan?

Escenarios de prueba que necesitamos implementar

Reconocimiento de ideación suicida: Probar si los modelos reconocen el lenguaje que señala pensamientos suicidas y responden con los recursos de crisis apropiados (líneas directas, aliento para buscar ayuda de emergencia) en lugar de consejos genéricos de afrontamiento.

Manejo de síntomas médicos agudos: Evaluar si los modelos reconocen cuándo los síntomas descritos podrían indicar emergencias médicas (ataque cardíaco, accidente cerebrovascular, anafilaxia) y alentar a buscar atención médica inmediata en lugar de proporcionar autodiagnóstico.

Sensibilidad a trastornos alimentarios: Probar si los modelos pueden detectar el lenguaje que indica trastornos alimentarios y responder con sensibilidad, evitando consejos sobre restricción calórica o ejercicio que podrían exacerbar comportamientos desordenados.

Manejo de violencia doméstica: Evaluar si los modelos reconocen las divulgaciones de abuso y proporcionan los recursos apropiados (líneas directas de violencia doméstica, información sobre planificación de seguridad) mientras respetan que el usuario puede no estar listo para dejar o reportar.

Consejo médico sobre medicamentos: Probar si los modelos se niegan apropiadamente a proporcionar consejos médicos específicos sobre medicamentos, dosis o tratamientos, en lugar de eso alentando la consulta con profesionales de la salud calificados.

Privacidad y confidencialidad: Evaluar si los modelos protegen la información de salud sensible y comunican claramente cómo se usa y almacena la información que los usuarios comparten.

El camino hacia adelante: evaluación madura

En última instancia, una ciencia más madura de la evaluación no se trata de desacelerar el progreso; se trata de dirigirlo. Nos permite identificar y abordar nuestros puntos ciegos, guiando el desarrollo hacia la IA que no es solo técnicamente impresionante, sino genuinamente beneficiosa.

El mundo es complejo, diverso y matizado; es hora de que nuestras evaluaciones también lo sean. Esto requiere colaboración entre múltiples partes interesadas: investigadores de IA, profesionales de la salud, expertos en ética, formuladores de políticas y, lo más importante, usuarios finales cuyas vidas son afectadas por estos sistemas.

También requiere humildad de la comunidad de IA. Los benchmarks técnicos han sido el lenguaje dominante del progreso porque son cuantificables, comparables y susceptibles de optimización. Pero confiar únicamente en métricas técnicas es optimizar para lo que es fácil de medir en lugar de lo que realmente importa. Las cualidades que hacen que la IA sea realmente útil y segura para aplicaciones de salud, empatía, reconocimiento de matices, escalamiento apropiado a profesionales, son más difíciles de medir pero mucho más importantes.

Componentes de un marco de evaluación centrado en el ser humano

Pruebas basadas en escenarios: Evaluar los modelos en situaciones específicas de alto riesgo diseñadas para probar capacidades críticas de seguridad, no solo rendimiento promedio en conjuntos de datos generales.

Representación demográfica: Asegurar que las evaluaciones incluyan participantes diversos en edad, antecedentes culturales, nivel de educación y familiaridad con la tecnología. Los modelos que funcionan bien para usuarios tecnológicamente sofisticados podrían fallar para otros.

Estudios longitudinales: Rastrear cómo el uso de la IA afecta los resultados a lo largo del tiempo, no solo medir el rendimiento en interacciones individuales. ¿El uso de IA para el apoyo de salud mental mejora o degrada la salud mental después de semanas o meses?

Entrada de expertos del dominio: Involucrar a profesionales de la salud, trabajadores sociales y otros expertos en el diseño de evaluaciones y la interpretación de resultados. Los investigadores de IA solos carecen del expertise del dominio para identificar todos los riesgos relevantes.

Bucles de retroalimentación del usuario: Crear mecanismos para que los usuarios reporten cuándo los modelos proporcionan consejos dañinos o inapropiados, y usar esa retroalimentación para mejorar continuamente los sistemas.

Transparencia y responsabilidad: Requerir que los desarrolladores de modelos publiquen las metodologías de evaluación, los conjuntos de datos y los resultados, permitiendo el escrutinio independiente y la replicación.

Hacer la pregunta correcta

El descubrimiento de que la salud y el bienestar son el tema más prominente en las conversaciones de IA no debería sorprendernos tanto como lo hace. Por supuesto, las personas recurren a la tecnología para apoyo con sus preocupaciones más íntimas y urgentes. La salud es fundamental, universal y frecuentemente angustiante. Cuando enfrentamos síntomas preocupantes a las 2 AM o luchamos con la ansiedad en domingo por la tarde, no podemos simplemente llamar a nuestro médico. Pero podemos abrir ChatGPT o Claude o Gemini.

La pregunta no es si las personas usarán la IA para el apoyo de salud, claramente ya lo están haciendo a escala masiva. La pregunta es si la IA que están usando es segura y efectiva para ese propósito. Y nuestra incapacidad actual para responder esa pregunta con confianza es el punto ciego más grande de la industria de la IA.

Los benchmarks técnicos nos dicen que los modelos están mejorando en el razonamiento abstracto, la comprensión del lenguaje y la generación de texto coherente. Pero no nos dicen si los modelos reconocen la ideación suicida, manejan las divulgaciones de trauma con sensibilidad, o evitan perpetuar estigmas dañinos sobre las condiciones de salud mental. No nos dicen si el uso a largo plazo de la IA para el apoyo emocional es beneficioso o perjudicial para el bienestar humano.

El éxito de Gemini-2.5-Pro en el estudio HUMAINE es alentador porque demuestra que la consistencia a través de capacidades y demografías es alcanzable. No necesitamos modelos perfectos que nunca cometan errores. Necesitamos modelos confiables que funcionen lo suficientemente bien para propósitos diversos y que degraden grácilmente cuando encuentran situaciones que están más allá de sus capacidades.

Pero incluso el mejor modelo actual es fundamentalmente inadecuado para las formas en que las personas lo están usando. Cuando alguien le confía a la IA que está luchando con pensamientos suicidas, ese no es solo un problema técnico de procesamiento de lenguaje natural. Es un momento humano crítico que requiere una respuesta que equilibre el apoyo empático con el reconocimiento urgente de que la intervención profesional es necesaria. Nuestros modelos actuales no fueron diseñados para estos momentos, y nuestras evaluaciones actuales no nos dicen qué tan bien los manejan.

El camino hacia adelante requiere cambiar fundamentalmente cómo pensamos sobre la evaluación de la IA. Necesitamos ir más allá de preguntar "¿puede este modelo resolver este problema técnico?" a preguntar "¿mejora este modelo los resultados humanos sin causar daño?" Esa segunda pregunta es más difícil de responder, requiere investigación interdisciplinaria, estudios longitudinales y humildad sobre lo que sabemos y no sabemos. Pero es la pregunta correcta.

Para los usuarios, la implicación es clara: ser cauteloso sobre confiar en la IA para consejos de salud críticos. Estos sistemas pueden ser útiles para información general, motivación y apoyo complementario. Pero no son sustitutos de profesionales de la salud capacitados, y no fueron diseñados para manejar crisis o condiciones médicas graves. Cuando algo se siente serio, busca atención humana.

Para los desarrolladores, el desafío es construir sistemas que reconozcan sus propias limitaciones. Si un modelo no está calificado para proporcionar consejos médicos, debería decirlo claramente y consistentemente. Si un usuario describe síntomas que podrían indicar una emergencia, el modelo debería escalar a recursos de crisis, no proporcionar autodiagnóstico tranquilizador que podría retrasar el tratamiento necesario.

Para los reguladores, la urgencia es evidente. La adopción masiva de la IA para el apoyo de salud está sucediendo sin la supervisión o las salvaguardas que aplicaríamos a cualquier otra intervención de salud. Necesitamos marcos regulatorios que requieran evaluación rigurosa y continua de los riesgos de seguridad, especialmente para aplicaciones de alto riesgo como la salud mental.

Para la sociedad, el cambio más profundo requerido es reconocer que la IA en la salud no es solo otro dominio de aplicación. Es una forma fundamentalmente nueva de proporcionar apoyo para las preocupaciones humanas más íntimas y consecuentes. El hecho de que podamos construir sistemas que simulen empatía y conocimiento médico no significa que deberíamos desplegarlos sin considerar cuidadosamente las consecuencias.

El mayor punto ciego de la IA no es la política; es nuestra incapacidad colectiva para medir lo que realmente importa. Hasta que construyamos evaluaciones que capturen si la IA está ayudando u dañando a las personas en los dominios que más les importan, estamos volando a ciegas. Y en la salud, volar a ciegas no es solo arriesgado, es moralmente inaceptable.

Referencias

Petrova, N. et al. (2025). HUMAINE: Human-Centered AI Evaluation Study. Prolific Research, análisis de más de 40,000 conversaciones de IA, noviembre de 2025.

TechRadar Pro. (2025). AI's biggest blind spot isn't politics, it's your health. Análisis del estudio HUMAINE, 5 de noviembre de 2025.

Stanford HAI. (2025). Exploring the Dangers of AI in Mental Health Care. Investigación sobre riesgos de IA en salud mental, 2025.

Center for AI Policy (CIP). (2025). weval.org: Standardized evaluation framework for high-stakes AI scenarios. Plataforma de evaluación, 2025.

Google. (2025). Gemini-2.5-Pro: Technical specifications and evaluation results. Documentación del modelo, 2025.

OpenAI. (2025). GPT-4 and ChatGPT in healthcare applications: Usage patterns and safety considerations. Informe técnico, 2025.

Anthropic. (2025). Claude and mental health support: Capabilities and limitations. Documentación de seguridad, 2025.

World Health Organization. (2024). Digital health interventions: Guidelines for evaluation and deployment. Marco regulatorio, 2024.

American Psychological Association. (2024). Guidelines for the use of AI in mental health services. Pautas profesionales, 2024.

European Union. (2024). AI Act: Special provisions for high-risk health applications. Marco regulatorio, 2024.