Durante meses, millones de personas trataron a ChatGPT como si fuera omnisciente. ¿Tienes una erupción extraña en la piel? Pregúntale a ChatGPT. ¿Necesitas redactar un testamento? ChatGPT puede ayudarte. ¿Dudas sobre dónde invertir tus ahorros? El modelo tiene opiniones. Esta era de confianza ciega ha terminado oficialmente. Enfrentando presiones regulatorias masivas y el espectro de litigios costosos, las grandes tecnológicas están frenando en seco.

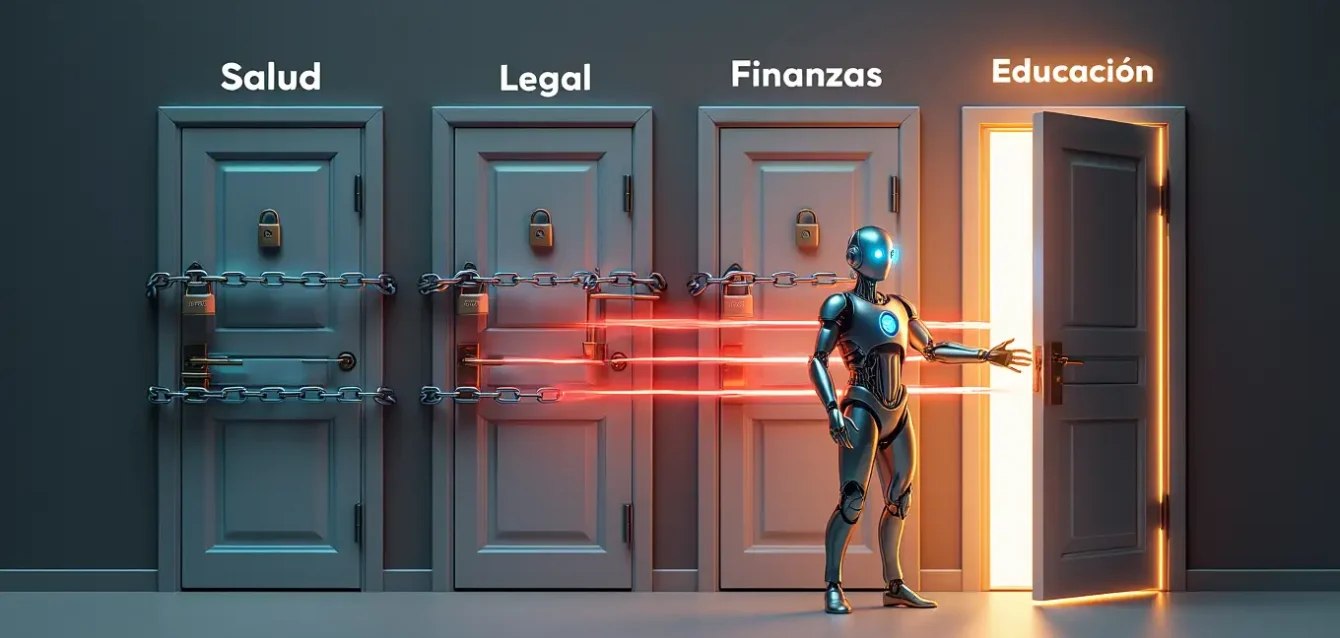

A partir del 29 de octubre de 2025, las políticas de uso de ChatGPT cambiaron de manera fundamental. El sistema ya no proporcionará consejos médicos, legales o financieros específicos. Según reportes de medios como NEXTA y Caliber, el chatbot es ahora oficialmente una herramienta educativa, no un consultor profesional. La razón es transparente: las regulaciones y el temor a responsabilidad legal apretaron el torniquete. OpenAI no quiere demandas en su plato.

Ahora, en lugar de ofrecer recomendaciones directas, el modelo explicará principios generales, delineará mecanismos básicos y te dirá que consultes con un médico, abogado o asesor financiero profesional. Esta restricción oficial solo subraya una verdad más profunda: ChatGPT es, y siempre ha sido, un maestro de las fabricaciones confiadas. Sobresale en estar convincentemente equivocado. Mientras eso es inofensivo cuando escribes un poema sobre tu gato, es un desastre para problemas del mundo real.

Pero hay una complicación en esta narrativa. Apenas horas después de que circularan noticias sobre las nuevas restricciones, ejecutivos de OpenAI salieron a desmentir parcialmente la historia. Shyamal Anadkat, director de salud de OpenAI, declaró a The Verge que la inclusión de políticas sobre asesoramiento legal y médico no es un cambio nuevo en sus términos. Las restricciones, argumenta la compañía, siempre estuvieron implícitas. Lo que cambió el 29 de octubre fue la formalización explícita de límites que ya existían en la práctica.

Las nuevas líneas rojas: salud, leyes y dinero

Las reglas reportadas por múltiples fuentes son explícitas: no más nombres de medicamentos ni dosificaciones, no más plantillas de demandas, no más consejos de inversión ni sugerencias de compra o venta. Este cierre directo aborda los temores que durante mucho tiempo han rodeado a la tecnología. La tentación de usar inteligencia artificial como atajo para expertise profesional era demasiado fuerte, y las consecuencias demasiado graves.

Considera el ámbito de la salud. Una persona podría tomar su bienestar en sus propias manos, alimentando síntomas a ChatGPT por curiosidad. Las respuestas resultantes pueden leerse como escenarios del peor caso, oscilando salvajemente desde deshidratación simple hasta diagnósticos serios como cáncer. Si un usuario ingresa que tiene un bulto en el pecho, la inteligencia artificial puede sugerir la posibilidad de malignidad.

En un escenario real, ese usuario podría descubrir posteriormente que el bulto es un lipoma, algo que un médico licenciado confirma no es cancerígeno. Esta realidad es precisamente por qué las nuevas reglas están en su lugar. La inteligencia artificial no puede ordenar análisis de laboratorio, examinar físicamente a una persona ni portar seguro contra mala praxis. No tiene licencia médica, no ha completado residencias clínicas, no ha visto miles de pacientes reales. Sus respuestas son síntesis estadísticas de patrones textuales, no juicios clínicos informados.

El caso del bromuro de sodio: cuando ChatGPT casi mata

El incidente: En agosto de 2025, un hombre de 60 años sin historial psiquiátrico previo fue hospitalizado durante tres semanas después de sustituir sal de mesa por bromuro de sodio, una sustancia química tóxica. Según reportes publicados en Annals of Internal Medicine, el hombre afirmó haber seguido información que recibió de ChatGPT.

Los síntomas: Dentro de las 24 horas de admisión, comenzó a experimentar paranoia y alucinaciones severas. Fue colocado en una retención psiquiátrica involuntaria, un protocolo reservado para pacientes que representan peligro inmediato para sí mismos o para otros.

La toxicidad del bromuro: El bromuro de sodio no es sal de cocina. Es un compuesto químico usado industrialmente como retardante de fuego y en fotografía. Su ingesta causa bromismo, una intoxicación que se manifiesta con síntomas neuropsiquiátricos: confusión, alucinaciones, irritabilidad extrema y, en casos severos, coma.

La responsabilidad difusa: ¿Quién es responsable aquí? ¿El usuario por confiar en una herramienta que no debería usarse para consejos médicos? ¿OpenAI por permitir que el sistema genere información potencialmente letal? ¿Los diseñadores del modelo que no implementaron suficientes salvaguardas? La ambigüedad legal es precisamente lo que motiva las nuevas políticas.

Esto no se trata solo de salud física. Algunas personas usan ChatGPT como sustituto de terapeuta. Mientras puede ofrecer técnicas de enraizamiento emocional, es una imitación pálida en el mejor de los casos e increíblemente arriesgada en el peor. ChatGPT no tiene experiencia vivida, no puede leer tu lenguaje corporal y posee cero capacidad para empatía genuina. Un terapeuta licenciado opera bajo mandatos legales para protegerte del daño; ChatGPT no. Si tú o alguien que amas está en crisis, marca el 988 en Estados Unidos o tu línea de ayuda local.

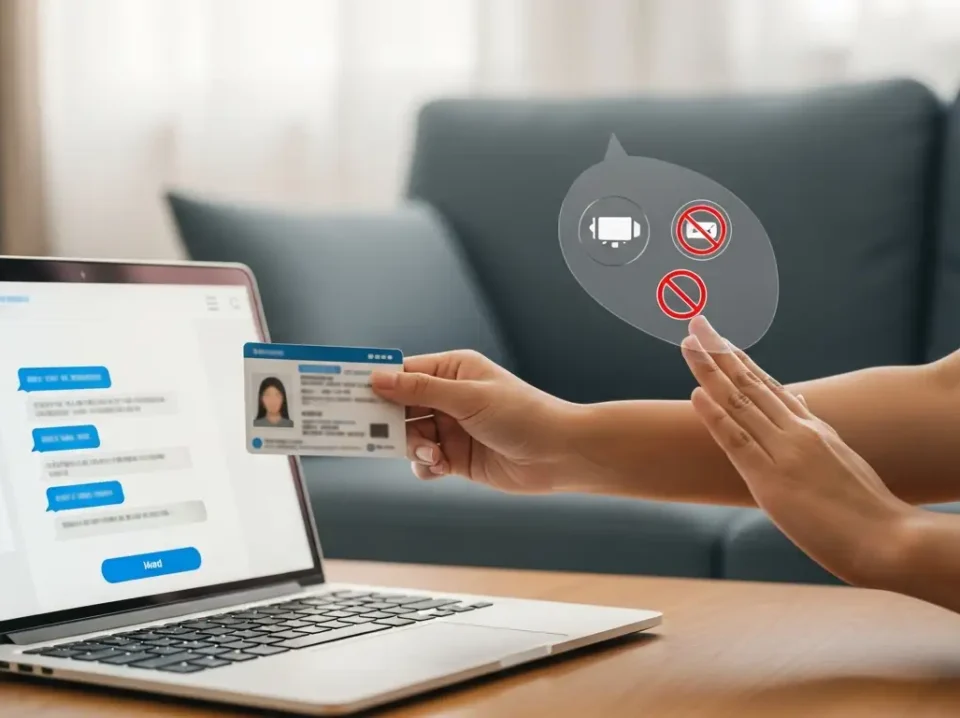

El mismo no rotundo ahora se aplica a tus finanzas y problemas legales. ChatGPT puede explicar qué es un fondo cotizado en bolsa, pero no conoce tu relación deuda-ingreso, objetivos de jubilación o apetito de riesgo. Cuando dinero real y sanciones del servicio de impuestos están en juego, llamas a un profesional. Esto también incluye un riesgo de datos importante: ten en cuenta que cualquier cosa que compartas, incluidos tus ingresos, número de seguro social o información de enrutamiento bancario, probablemente se convertirá en parte de sus datos de entrenamiento.

Del mismo modo, pedirle que redacte un testamento es lanzar los dados. Las leyes de sucesiones varían por estado, y una cláusula de notarización faltante puede hacer que tu documento completo sea desechado. Las consecuencias de un testamento mal redactado pueden ser devastadoras: herederos legítimos desplazados, activos congelados durante años en litigios, intenciones del difunto completamente frustradas. ¿Vale la pena arriesgar eso por ahorrar unos cientos de dólares en honorarios de abogado?

Por qué ChatGPT falla en tareas de alto riesgo y tiempo real

Más allá de los temas oficialmente prohibidos, ChatGPT tiene fallas fundamentales en situaciones de alto riesgo. Si tu alarma de monóxido de carbono comienza a sonar, por favor no abras ChatGPT y preguntes si estás en peligro real. Evacúa primero. Un modelo de lenguaje grande no puede oler gas ni despachar un equipo de emergencia. Trátalo como un explicador posterior al incidente, nunca como un primer respondedor.

Esta limitación se extiende a información en tiempo real. Desde que OpenAI lanzó ChatGPT Search a finales de 2024, el chatbot puede obtener páginas web frescas y cotizaciones de acciones. Sin embargo, no transmitirá actualizaciones continuas. Cada actualización necesita un nuevo mensaje, haciéndolo inútil para monitorear noticias de última hora. Si necesitas seguir un huracán, una crisis política en desarrollo o resultados electorales en vivo, las fuentes tradicionales de noticias siguen siendo superiores.

El bot también es un jugador terrible. Un usuario puede haber tenido suerte usando ChatGPT para acertar un parlay de tres vías durante un campeonato importante, pero nadie debería recomendarlo. Los usuarios han visto a ChatGPT alucinar estadísticas incorrectas de jugadores, reportar lesiones erróneamente y proporcionar registros de victorias y derrotas falsos. Cualquier resultado ganador probablemente ocurrió porque el usuario verificó cada afirmación contra probabilidades en tiempo real, e incluso entonces, la suerte estuvo involucrada. ChatGPT no puede ver el marcador de mañana, así que nadie debería confiar en él para asegurar una victoria.

Los dominios donde ChatGPT es fundamentalmente inadecuado

Emergencias físicas: Fugas de gas, síntomas de ataque cardíaco, reacciones alérgicas severas, cualquier situación que requiera intervención inmediata. La inteligencia artificial no puede llamar al 911, no puede realizar RCP, no puede administrar epinefrina. La demora causada por consultar un chatbot puede ser literalmente mortal.

Información financiera sensible: Números de cuenta bancaria, contraseñas, estrategias de inversión personalizadas que dependen de tu situación fiscal específica. Todo lo que ingresas en un prompt puede ser almacenado, analizado y potencialmente usado para entrenar futuros modelos. La privacidad financiera es inexistente.

Documentos legales vinculantes: Testamentos, contratos de divorcio, acuerdos de custodia, documentos de incorporación empresarial. Las variaciones jurisdiccionales son enormes, y ChatGPT no tiene licencia para practicar derecho en ninguna jurisdicción. Un error puede costarte años en litigios y decenas de miles en honorarios legales.

Datos confidenciales profesionales: Comunicados de prensa embargados, contratos de clientes, historiales médicos, números de pasaporte. Una vez que información sensible está en el prompt, no hay garantía de dónde se almacena o quién puede revisarla. El riesgo de filtración es real y las consecuencias profesionales pueden ser devastadoras.

La anatomía de la confianza mal depositada

¿Por qué tantas personas confían en ChatGPT para decisiones críticas? La respuesta reside en cómo el sistema comunica. Los modelos de lenguaje grandes son extraordinariamente convincentes. No titubean, no expresan incertidumbre a menos que se les solicite explícitamente, y estructuran sus respuestas con la confianza de un experto. Esta confianza simulada es producto del entrenamiento: el modelo fue optimizado para generar texto que suene autoritativo porque ese tipo de texto recibe mejores calificaciones de evaluadores humanos.

El problema es que la confianza y la corrección no están correlacionadas en estos sistemas. ChatGPT puede estar absolutamente seguro de información completamente falsa. Puede generar citas académicas que no existen, inventar precedentes legales que nunca fueron dictados, y describir tratamientos médicos que no tienen base en evidencia. La fluidez del lenguaje es independiente de la veracidad del contenido.

Este fenómeno, conocido técnicamente como alucinación, no es un error ocasional sino una característica arquitectónica de cómo funcionan estos modelos. ChatGPT no busca información en una base de datos de hechos verificados. Genera predicciones sobre qué palabras probablemente deberían venir a continuación basándose en patrones estadísticos en su corpus de entrenamiento. Cuando esos patrones son ambiguos o cuando la información solicitada es rara, el sistema llena los vacíos con invenciones plausibles.

Para un usuario sin formación técnica, distinguir entre una respuesta basada en información robusta y una fabricación convincente es virtualmente imposible. Ambas se presentan con el mismo nivel de confianza, la misma estructura narrativa pulida, el mismo tono de autoridad. La única manera de verificar es buscar fuentes externas, pero si el usuario fuera a hacer eso, probablemente no necesitaría ChatGPT en primer lugar.

Las trampas éticas: trampas académicas y arte generado

Finalmente, están las áreas grises éticas. Pedir a ChatGPT que ayude con algo ilegal es autoexplicativo. Pero ¿qué pasa con hacer trampa en trabajos escolares? Mientras algunos pueden no estar orgullosos de haber usado tecnología más antigua para espiar ecuaciones en la secundaria, la escala de la trampa moderna es significativamente diferente. Los estudiantes ahora pueden generar ensayos completos, resolver conjuntos de problemas complejos y producir proyectos de investigación sin entender nada del material.

Los detectores como Turnitin están mejorando, y los profesores ya pueden reconocer la voz de ChatGPT instantáneamente. Hay marcadores reveladores: ciertos patrones de transición, uso excesivo de conectores formales, estructura de párrafos predecible, falta de voz personal distintiva. Una persona arriesga suspensión, y solo se están estafando a sí mismos de una educación. La herramienta debe usarse como compañero de estudio, no como escritor fantasma.

Las instituciones académicas están respondiendo con políticas cada vez más estrictas. Algunas universidades ahora requieren que todos los trabajos escritos se produzcan en sesiones supervisadas en el aula. Otras implementan entrevistas orales donde los estudiantes deben defender y explicar su trabajo escrito, una prueba que rápidamente revela si realmente comprenden el material o simplemente lo generaron. El mensaje es claro: la trampa asistida por inteligencia artificial se toma tan seriamente como el plagio tradicional.

Luego está la cuestión del arte. Esta no es una verdad objetiva, solo una perspectiva, pero muchos creen que la inteligencia artificial no debería usarse para crear arte que uno luego presenta como propio. Usar ChatGPT para brainstorming de titulares o generación de ideas es suplementación, no sustitución. Pero pasar off arte generado por inteligencia artificial como creación humana original plantea cuestiones éticas profundas sobre autenticidad, valor del trabajo creativo humano y el significado mismo de la autoría.

La respuesta de OpenAI: negación y clarificación

La narrativa sobre las nuevas restricciones se complicó cuando OpenAI respondió públicamente. Shyamal Anadkat, ejecutivo de salud de la compañía, declaró a The Verge que las políticas sobre asesoramiento médico y legal no representan un cambio nuevo en los términos de servicio. Según OpenAI, estas restricciones siempre estuvieron implícitas en sus políticas de uso, y la actualización del 29 de octubre simplemente las hizo explícitas.

Esta distinción importa menos de lo que OpenAI sugiere. Ya sea que las restricciones sean nuevas o simplemente recién formalizadas, el efecto práctico es el mismo: mayor énfasis público en los límites del sistema, recordatorio más fuerte a los usuarios de que ChatGPT no es un profesional licenciado, y señal clara de que la compañía está respondiendo a presiones regulatorias y legales.

La actualización de políticas también incluye lenguaje más explícito sobre consecuencias para violaciones. Los usuarios que sistemáticamente intentan obtener consejos médicos, legales o financieros específicos pueden enfrentar desde negativas del sistema hasta bloqueo de cuentas. Esto representa un giro hacia enforcement más activo de límites que anteriormente eran más sugerencias que reglas estrictas.

Desde la perspectiva de OpenAI, esta clarificación es protección legal esencial. Conforme la inteligencia artificial se integra más profundamente en la vida diaria, las cuestiones de responsabilidad se vuelven cada vez más urgentes. Si alguien sufre daño siguiendo consejos de ChatGPT, ¿quién es legalmente responsable? ¿El usuario por confiar inapropiadamente en una herramienta automatizada? ¿OpenAI por crear un sistema capaz de generar información peligrosa? ¿Los evaluadores humanos que entrenaron el modelo sin filtrar suficientemente respuestas riesgosas?

El paisaje regulatorio en evolución

Las actualizaciones de políticas de OpenAI no ocurren en vacío. Están respondiendo a un paisaje regulatorio global cada vez más hostil hacia sistemas de inteligencia artificial sin restricciones. La Unión Europea ha liderado con el AI Act, legislación comprehensiva que clasifica sistemas de inteligencia artificial por nivel de riesgo e impone requisitos estrictos sobre aquellos considerados de alto riesgo, categoría que incluye aplicaciones médicas y legales.

En Estados Unidos, múltiples estados están considerando o han aprobado legislación que regula específicamente el uso de inteligencia artificial en atención médica. Estas leyes típicamente requieren que cualquier diagnóstico o recomendación de tratamiento generada por inteligencia artificial sea revisada por un profesional médico licenciado antes de ser comunicada al paciente. Algunos estados van más allá, prohibiendo completamente ciertos usos de inteligencia artificial en contextos clínicos sin supervisión humana directa.

El sector legal enfrenta presiones similares. Múltiples asociaciones de abogados han emitido opiniones éticas advirtiendo que usar inteligencia artificial para generar documentos legales sin revisión exhaustiva por un abogado licenciado puede constituir práctica no autorizada del derecho. Abogados que han presentado escritos legales generados por ChatGPT sin verificar las citas han enfrentado sanciones de tribunales cuando esas citas resultaron ser completamente inventadas.

Un caso notable involucró a un abogado en Nueva York que presentó un escrito citando múltiples precedentes legales que no existían. ChatGPT había generado nombres de casos que sonaban plausibles, números de reportes de tribunales realistas y resúmenes convincentes de decisiones ficticias. El abogado no verificó las citas, asumiendo que el sistema era confiable. El juez no quedó impresionado, imponiendo multas y requiriendo al abogado que notificara a los jueces citados en los casos falsos sobre el error.

Implicaciones para el futuro de la inteligencia artificial conversacional

Las restricciones en ChatGPT señalan una maduración del campo de inteligencia artificial conversacional. La era de experimentación relativamente sin restricciones está terminando, reemplazada por un enfoque más cauteloso que reconoce los riesgos reales de sistemas que suenan autoritativos pero son fundamentalmente poco confiables en dominios de alto riesgo.

Esta transición plantea preguntas sobre el futuro de estos sistemas. ¿Veremos especialización, con diferentes modelos entrenados específicamente para diferentes dominios con diferentes niveles de restricción? ¿Emergerán sistemas híbridos que combinen generación de lenguaje con acceso verificado a bases de datos de información confiable? ¿Se desarrollarán métodos de certificación donde ciertos modelos de inteligencia artificial son aprobados oficialmente para uso en contextos regulados?

Una posibilidad es la evolución hacia arquitecturas de inteligencia artificial en capas. La capa de generación de lenguaje produce contenido, pero una capa de verificación separada evalúa ese contenido contra fuentes autorizadas antes de presentarlo al usuario. Para consultas médicas, esto podría significar verificación cruzada contra bases de datos médicas curadas por profesionales. Para consultas legales, acceso a bases de datos de jurisprudencia real en lugar de síntesis estadística de patrones textuales.

Otra trayectoria es la integración más profunda de profesionales humanos en el flujo. En lugar de reemplazar médicos, abogados o asesores financieros, la inteligencia artificial podría convertirse en herramienta de asistencia que prepara borradores, identifica temas relevantes y acelera investigación, pero siempre con un profesional humano licenciado tomando decisiones finales y asumiendo responsabilidad legal.

Modelos alternativos emergentes de inteligencia artificial regulada

Sistemas de doble validación: Arquitecturas donde el output de inteligencia artificial es automáticamente verificado contra bases de datos certificadas antes de ser mostrado al usuario. Para consultas médicas, esto significaría verificación contra literatura médica peer-reviewed. Para consultas legales, validación contra bases de datos oficiales de jurisprudencia.

Inteligencia artificial como asistente, no como decisor: Modelos diseñados explícitamente para asistir a profesionales humanos en lugar de reemplazarlos. Un médico podría usar inteligencia artificial para generar diagnósticos diferenciales preliminares, pero el diagnóstico final y el plan de tratamiento siguen siendo responsabilidad humana.

Certificación y auditoría: Sistemas donde modelos específicos de inteligencia artificial son evaluados y certificados por organismos reguladores para uso en dominios particulares. Similar a cómo dispositivos médicos deben ser aprobados por la FDA, ciertos usos de inteligencia artificial podrían requerir certificación formal.

Transparencia de confianza: Interfaces que muestran explícitamente al usuario qué tan confiado está el sistema en su respuesta, basándose en cuántos datos de alta calidad tiene disponibles sobre el tema. Consultas en áreas de datos escasos vendrían con advertencias prominentes sobre confiabilidad limitada.

La responsabilidad del usuario en la era de la inteligencia artificial

Mientras las empresas tecnológicas implementan restricciones, la responsabilidad también recae en los usuarios. La alfabetización en inteligencia artificial, la comprensión de qué pueden y no pueden hacer estos sistemas, se está convirtiendo en habilidad esencial. Así como aprendimos a ser escépticos de información en internet y a verificar fuentes, necesitamos desarrollar escepticismo apropiado hacia outputs de inteligencia artificial.

Esto significa tratando ChatGPT como lo que es: una herramienta de síntesis de información que puede ser útil para exploración, educación y brainstorming, pero nunca como reemplazo de expertise profesional en dominios de alto riesgo. Significa verificando información crítica contra fuentes autorizadas. Significa reconociendo que la confianza con la que el sistema presenta información no tiene correlación con su exactitud.

Para profesionales que usan inteligencia artificial en su trabajo, significa comprender que la responsabilidad legal y ética permanece completamente con ellos. Un abogado que usa ChatGPT para redactar documentos sigue siendo responsable de cada palabra en esos documentos. Un médico que consulta inteligencia artificial para diagnósticos diferenciales sigue siendo el único responsable del diagnóstico final y el plan de tratamiento. La herramienta puede asistir, pero no puede asumir responsabilidad.

Para educadores, significa enseñando explícitamente a los estudiantes sobre las capacidades y limitaciones de estas tecnologías. En lugar de prohibir su uso completamente, cosa que es probablemente imposible de enforcar, el enfoque debería estar en enseñar uso ético y apropiado. Cómo usar inteligencia artificial como herramienta de aprendizaje en lugar de atajo, cómo verificar sus outputs, cómo reconocer cuándo un problema requiere pensamiento humano genuino en lugar de síntesis automatizada.

Reflexión conclusiva

Las nuevas restricciones en ChatGPT no son simplemente una actualización menor de políticas; son una admisión pública de sus fallas fundamentales. Enfrentada con presión legal y regulatoria, las grandes tecnológicas han degradado oficialmente el bot de consultor potencial a simple herramienta educativa. Desde diagnosticar erróneamente condiciones de salud hasta alucinar datos legales y financieros, los riesgos son demasiado altos para continuar la ficción de que estos sistemas pueden reemplazar expertise humana en dominios críticos.

El caso del hombre hospitalizado por seguir consejos químicos de ChatGPT no es aberración sino síntoma de un problema sistémico. Cuando sistemas que suenan autoritativos pero carecen de comprensión genuina se despliegan sin restricciones suficientes, las personas inevitablemente confían en ellos para decisiones que requieren expertise real. Las consecuencias pueden ser desde inconvenientes menores hasta daños graves o muerte.

La evolución de ChatGPT de oráculo aparentemente omnisciente a herramienta explícitamente limitada refleja una maduración necesaria en cómo la sociedad se relaciona con inteligencia artificial. La fase inicial de fascinación acrítica está terminando, reemplazada por comprensión más realista de capacidades y límites. Esta transición es saludable y hace tiempo que debería haber ocurrido.

Hacia adelante, el desafío es encontrar el balance apropiado. Estos sistemas tienen valor genuino para ciertos usos: exploración de ideas, educación general, asistencia con escritura no crítica, aceleración de investigación preliminar. Pero deben usarse con ojos abiertos sobre sus limitaciones. La conclusión es simple pero vital: ChatGPT es un asistente poderoso para suplementación, pero un sustituto peligroso para expertise humana en cualquier contexto donde las consecuencias reales están en juego.

Las restricciones formales son un paso positivo. Protegen tanto a usuarios de daño potencial como a OpenAI de responsabilidad legal. Pero las políticas solas no son suficientes. La verdadera solución requiere educación pública sobre alfabetización en inteligencia artificial, desarrollo de sistemas más robustos con mejor calibración de incertidumbre, e integración apropiada de profesionales humanos en flujos de trabajo donde expertise certificada es legalmente requerida o éticamente esencial. Solo entonces podremos aprovechar los beneficios de estas tecnologías mientras minimizamos sus riesgos muy reales.

Referencias

The Verge. (2025). No, ChatGPT hasn't added a ban on giving legal and medical advice. Noviembre 3, 2025.

Tech Times / IBTimes UK. (2025). ChatGPT's 'New Rules' Reportedly Ban Specific Legal, Health, Money Tips. Noviembre 2, 2025.

Caliber.az. (2025). ChatGPT stops offering medical, legal advice. Noviembre 2, 2025.

NEXTA. (2025). Reportes sobre cambios en políticas de uso de ChatGPT. Octubre 29, 2025.

Moneycontrol. (2025). ChatGPT can no longer offer medical, financial or legal guidance. Noviembre 3, 2025.

MLQ.ai. (2025). OpenAI Bans ChatGPT From Providing Medical and Legal Advice. Noviembre 2, 2025.

David Timm, LinkedIn. (2025). Analysis of OpenAI's Usage Policies update. Noviembre 2, 2025.

OpenAI. (2025). Usage Policies. Actualizado el 29 de octubre de 2025.

Annals of Internal Medicine. (2025). Case report: Sodium bromide toxicity following ChatGPT advice. Agosto 2025.

Reddit r/ChatGPT. (2025). What to take from the new Usage Policies rolled out today. Septiembre 29, 2025.

National Center for Biotechnology Information / JMIR. (2023). Ethical Considerations of Using ChatGPT in Health Care. Agosto 10, 2023.

Yahoo News. (2025). ChatGPT will no longer give health or legal advice. Reportes agregados de múltiples fuentes.

Unión Europea. (2024). AI Act: Regulación comprehensiva sobre sistemas de inteligencia artificial.

News18. (2025). Reportes sobre cambios en políticas de ChatGPT citando a NEXTA.