OpenAI anunció el miércoles 29 de octubre el lanzamiento de dos modelos de razonamiento que los desarrolladores pueden utilizar para clasificar una gama de riesgos de seguridad en línea en sus plataformas. Los modelos de inteligencia artificial se denominan gpt-oss-safeguard-120b y gpt-oss-safeguard-20b, y sus nombres reflejan sus tamaños en parámetros. La compañía liberó estos modelos como vista previa de investigación bajo licencia Apache 2.0, permitiendo a cualquier persona usarlos, modificarlos y desplegarlos libremente sin restricciones de copyleft ni riesgos de patentes. Ambos modelos pueden descargarse hoy desde Hugging Face y están disponibles para uso comercial local.

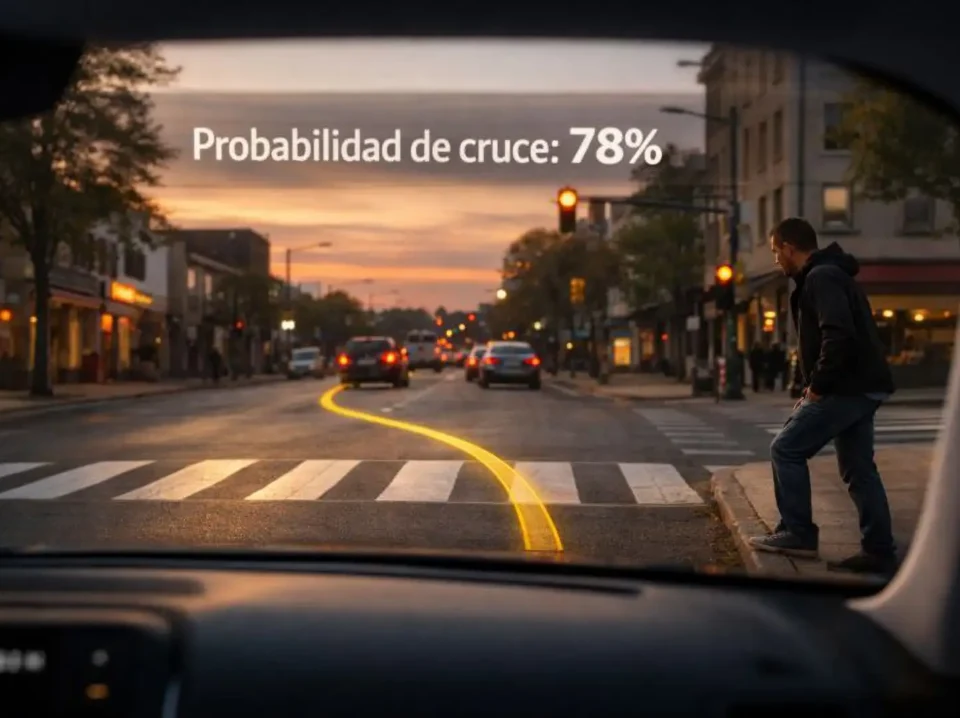

Los modelos gpt-oss-safeguard utilizan razonamiento para interpretar directamente una política proporcionada por el desarrollador en tiempo de inferencia, clasificando mensajes de usuarios, respuestas completas y conversaciones completas según las necesidades del desarrollador. El desarrollador siempre decide qué política usar, por lo que las respuestas son más relevantes y adaptadas al caso de uso específico del desarrollador. Dado que son modelos de razonamiento que muestran su trabajo, los desarrolladores tendrán una visión más directa de cómo llegan a una salida particular. Por ejemplo, un sitio de reseñas de productos podría desarrollar una política y usar los modelos gpt-oss-safeguard para filtrar reseñas que podrían ser falsas, según explicó OpenAI en su anuncio oficial.

La compañía desarrolló los modelos en asociación con Discord, SafetyKit y Robust Open Online Safety Tools (ROOST). OpenAI trabajó durante meses con ROOST para identificar las necesidades críticas de los desarrolladores, probar el modelo y producir documentación para desarrolladores. El modelo toma dos entradas simultáneamente: una política y el contenido a clasificar bajo esa política. Produce una conclusión sobre dónde cae el contenido, junto con su razonamiento. Los desarrolladores deciden cómo, si acaso, usar esas conclusiones en sus propios pipelines de seguridad. Este enfoque basado en razonamiento se desempeña especialmente bien en situaciones donde el daño potencial está emergiendo o evolucionando y las políticas necesitan adaptarse rápidamente.

❌ Clasificadores Tradicionales

Política fija en pesos: La política está codificada en los parámetros del modelo durante el entrenamiento

Cambios requieren reentrenamiento: Modificar reglas necesita nuevo conjunto de datos, nueva corrida de entrenamiento, nuevo checkpoint

Sin explicaciones: Salida típicamente es solo una etiqueta binaria o puntuación de confianza sin justificación

Una política por modelo: Diferentes productos o regiones requieren modelos separados

✓ Clasificadores con Razonamiento

Política como entrada: La política se proporciona como texto en cada inferencia, no codificada en pesos

Cambios instantáneos: Editar política es simplemente editar texto de prompt, sin reentrenamiento necesario

Con explicaciones: Salida incluye razonamiento paso a paso mostrando cómo la política llevó a la decisión

Múltiples políticas por modelo: Mismo modelo puede aplicar políticas diferentes para distintos contextos

Arquitectura: razonamiento desde política en tiempo de inferencia

El enfoque fundamental de gpt-oss-safeguard invierte la relación tradicional entre política y modelo. Los clasificadores de moderación convencionales se entrenan en una sola política fija. Cuando esa política cambia, el modelo debe reentrenarse o reemplazarse, un proceso que puede tomar semanas o meses entre recolección de datos, entrenamiento, validación y despliegue. Los modelos gpt-oss-safeguard revierten esta relación tomando la política escrita por el desarrollador como entrada junto con el contenido del usuario, luego razonan paso a paso para decidir si el contenido viola la política. Esto convierte la seguridad en una tarea de prompt y evaluación, lo cual es más adecuado para daños que cambian rápidamente o son específicos del dominio, como fraude, biología, autolesión o abuso específico de juegos.

Dado que la política es una entrada proporcionada durante la inferencia en lugar de durante el entrenamiento, los equipos pueden actualizar políticas rápidamente. Los desarrolladores pueden intercambiar políticas para diferentes productos, regiones o grupos de edad, y el mismo modelo seguirá cada una. La salida incluye una justificación breve que muestra cómo el texto de la política llevó a la decisión, lo que facilita mucho las revisiones y apelaciones. Este razonamiento transparente de cadena de pensamiento permite a los desarrolladores ver exactamente cómo el modelo llegó a cada decisión, proporcionando auditabilidad crucial para aplicaciones sensibles como moderación de contenido, filtrado de seguridad y cumplimiento regulatorio.

Internamente, OpenAI utiliza una herramienta similar llamada Safety Reasoner, que entrenaron con ajuste fino de refuerzo para recompensar juicios consistentes con la política, de modo que el modelo aprende a razonar desde el texto de la política. Esta misma estrategia les permite actualizar reglas de seguridad en producción rápidamente, comenzando estricto y luego relajando o apretando conforme aprenden, un proceso que llaman despliegue iterativo. La compañía también reporta que el razonamiento de seguridad a veces requiere cómputo real, y en algunos lanzamientos alcanzó el 16% del cómputo total para aplicar políticas cuidadosamente. Esta inversión computacional sustancial refleja el compromiso de OpenAI con seguridad robusta incluso cuando aumenta costos operacionales.

⚙️ Patrón de Arquitectura: Clasificador en Capas

Capa 1 - Filtro rápido: Un clasificador pequeño y económico procesa primero todo el contenido para filtrar el material obviamente seguro

Capa 2 - Razonamiento profundo: Solo la pequeña fracción de elementos complicados se envía al modelo de razonamiento más pesado

Ventaja de eficiencia: La mayoría del contenido se procesa con latencia mínima, reservando cómputo intensivo para casos ambiguos

Implementación interna: OpenAI usa este patrón en producción para GPT-5, ChatGPT Agent y Sora 2

Evaluación paso a paso: Safety Reasoner evalúa salidas paso a paso y bloquea generaciones inseguras en tiempo real

Clasificación taxonómica: Las mismas verificaciones en capas clasifican salidas contra taxonomía detallada, permitiendo respuestas adaptadas a categoría de riesgo específica

Especificaciones técnicas: dos tamaños para diferentes necesidades

El modelo grande, gpt-oss-safeguard-120b, tiene 117 mil millones de parámetros con 5.1 mil millones de parámetros activos y está dimensionado para caber en una sola GPU clase H100 de 80GB. El modelo más pequeño, gpt-oss-safeguard-20b, tiene 21 mil millones de parámetros con 3.6 mil millones de parámetros activos y apunta a menor latencia o GPUs más pequeñas, incluyendo configuraciones de 16GB. Ambos modelos fueron entrenados en el formato de respuesta harmony y deben usarse solo con el formato harmony, ya que no funcionarán correctamente de otra manera. Los modelos son versiones ajustadas finamente de los modelos abiertos gpt-oss de OpenAI, por lo que encajan en stacks existentes de pesos abiertos y pueden ejecutarse donde la residencia de datos o el control offline es un requisito.

Los modelos son personalizables, proporcionan cadena de pensamiento completa (CoT), pueden usarse con diferentes esfuerzos de razonamiento (bajo, medio, alto) y soportan Salidas Estructuradas. El esfuerzo de razonamiento configurable permite a los desarrolladores ajustar fácilmente el equilibrio entre latencia y profundidad analítica según su caso de uso específico y necesidades de latencia. Para casos donde la velocidad es crítica y el riesgo es bajo, el esfuerzo de razonamiento bajo puede ser suficiente. Para contenido de alto riesgo o ambiguo, el esfuerzo alto proporciona análisis más exhaustivo a costa de mayor tiempo de procesamiento. Esta flexibilidad permite a las plataformas optimizar el trade-off entre costo computacional y calidad de moderación.

La licencia Apache 2.0, la misma que los modelos padre gpt-oss, permite despliegue comercial local sin restricciones. Esto es ideal para experimentación, personalización y despliegue comercial sin preocupaciones sobre restricciones de copyleft o riesgos de patentes. Los modelos son compatibles con la API de Respuestas de OpenAI, proporcionando integración fluida para desarrolladores ya familiarizados con el ecosistema de OpenAI. Ambos modelos están disponibles para descarga inmediata desde Hugging Face, y Ollama se ha asociado con OpenAI y ROOST para traer los modelos gpt-oss-safeguard más recientes a los usuarios para tareas de clasificación de seguridad.

Evaluaciones de rendimiento: competitivo con sistemas propietarios

OpenAI evaluó los modelos en pruebas internas de múltiples políticas y en conjuntos de datos públicos. En precisión multi-política, donde un solo input debe ser correcto bajo varias políticas a la vez, gpt-oss-safeguard-120b obtuvo 46.3% y gpt-oss-safeguard-20b obtuvo 43.6%, mientras que el Safety Reasoner interno alcanzó 52.2% y gpt-5-thinking alcanzó 43.2%. Esta métrica es estricta: la precisión solo cuenta si el modelo coincide con las etiquetas de referencia a través de todas las políticas para el mismo input, por lo que es un estándar exigente que enfatiza la consistencia. El hecho de que los modelos de pesos abiertos logren precisión dentro del mismo rango que los sistemas internos propietarios es notable.

En el conjunto de moderación de 2022 de OpenAI, ambos modelos gpt-oss-safeguard alcanzaron 82.9 F1 y el Safety Reasoner interno alcanzó 82.8, lo que coloca a los modelos de pesos abiertos en el mismo nivel. En el benchmark ToxicChat, gpt-oss-safeguard-120b y 20b obtuvieron 79.3 y 79.9 F1, mientras que el Safety Reasoner interno y gpt-5-thinking obtuvieron 81.3 y 81.0, lo que sugiere que los modelos abiertos compactos son competitivos pero no superiores en esta prueba específica. Para ToxicChat, OpenAI evaluó usando un prompt breve escrito a mano adaptado de algunas de sus políticas internas. El Safety Reasoner interno nuevamente superó a gpt-5-thinking, mientras que gpt-5-thinking y Safety Reasoner ambos superaron marginalmente a gpt-oss-safeguard-120b y gpt-oss-safeguard-20b.

OpenAI espera que el tamaño relativamente pequeño de gpt-oss-safeguard aún lo haga preferible para este tipo de tarea a pesar del margen de rendimiento. El pequeño margen sobre el Safety Reasoner interno no es estadísticamente significativo, sugiriendo que los modelos de pesos abiertos proporcionan capacidades esencialmente equivalentes para la mayoría de los casos de uso prácticos. Las evaluaciones demuestran que el razonamiento desde política puede competir con clasificadores tradicionales altamente optimizados en benchmarks establecidos, al mismo tiempo que ofrece ventajas significativas en flexibilidad, explicabilidad y adaptabilidad a nuevas categorías de riesgo.

| Benchmark | gpt-oss-safeguard-120b | gpt-oss-safeguard-20b | Safety Reasoner (interno) | gpt-5-thinking |

|---|---|---|---|---|

| Precisión Multi-Política | 46.3% | 43.6% | 52.2% | 43.2% |

| Conjunto Moderación 2022 (F1) | 82.9 | 82.9 | 82.8 | N/A |

| ToxicChat (F1) | 79.3 | 79.9 | 81.3 | 81.0 |

Casos de uso: cuándo usar razonamiento versus clasificadores tradicionales

El enfoque brilla cuando los riesgos son nuevos, los datos para entrenar son escasos, el dominio es matizado, o la prioridad son etiquetas explicables de alta calidad en lugar de la menor latencia posible. Un foro puede marcar conversaciones sobre trampas usando su propia definición, y un sitio de reseñas puede filtrar testimonios falsos usando sus propios criterios, todo editando el texto de la política en lugar de recolectar miles de etiquetas. Para plataformas que enfrentan amenazas emergentes como nuevos tipos de fraude, desinformación específica de dominio o manipulación coordinada, la capacidad de actualizar políticas instantáneamente sin ciclos de reentrenamiento proporciona agilidad crítica.

Un patrón práctico que OpenAI describió de su propio stack interno es ejecutar primero un clasificador pequeño y económico para filtrar el material obviamente seguro, y solo enviar la pequeña fracción de elementos complicados al modelo de razonamiento más pesado. Safety Reasoner es ahora parte del stack de seguridad central de OpenAI para generación de imágenes y Sora 2, donde evalúa salidas paso a paso y bloquea generaciones inseguras en tiempo real. Las mismas verificaciones en capas clasifican salidas contra una taxonomía detallada a través de sistemas como GPT-5 y ChatGPT Agent, lo que permite a la plataforma adaptar la respuesta a la categoría de riesgo específica. Este enfoque en capas optimiza el equilibrio entre costo computacional y cobertura de seguridad.

El resumen para desarrolladores es directo: usar gpt-oss-safeguard cuando la política cambia mucho, las explicaciones importan y los datos etiquetados son escasos. Usar un clasificador dedicado cuando se puede permitir una corrida grande de etiquetado y se necesitan los últimos puntos de precisión. Para startups y organizaciones pequeñas que carecen de recursos para construir conjuntos de datos de entrenamiento masivos, gpt-oss-safeguard proporciona capacidades de moderación de calidad empresarial inmediatamente disponibles. Para plataformas establecidas con equipos grandes de trust and safety, los modelos ofrecen una manera de manejar casos extremos y categorías emergentes que los clasificadores tradicionales aún no han sido entrenados para detectar.

💡 Ejemplos de Casos de Uso Ideales

Limitaciones y trade-offs: cuándo los clasificadores tradicionales aún ganan

OpenAI destaca dos limitaciones principales para gpt-oss-safeguard. Primero, los clasificadores entrenados en decenas de miles de muestras etiquetadas de alta calidad aún pueden superar el razonamiento desde política en categorías difíciles. Tomar el tiempo para entrenar un clasificador dedicado puede ser preferido para mayor rendimiento en riesgos más complejos. Cuando una plataforma ha invertido años construyendo conjuntos de datos de entrenamiento masivos y refinando taxonomías de riesgo, un clasificador tradicional optimizado para esas categorías específicas probablemente proporcionará mayor precisión que un modelo de razonamiento de propósito general. La ventaja de los datos etiquetados extensos no desaparece simplemente porque el razonamiento esté disponible.

Segundo, gpt-oss-safeguard puede ser intensivo en tiempo y cómputo, lo que dificulta escalarlo a través de todo el contenido de la plataforma. Un pipeline escalonado es el patrón práctico para plataformas de alto volumen. Hay un trade-off de costo claro: el razonamiento toma más tiempo y cómputo que un clasificador pequeño, por lo que un pipeline escalonado donde un filtro rápido maneja el contenido obviamente seguro y solo los casos ambiguos van al razonador es la arquitectura práctica. Para plataformas que procesan millones de piezas de contenido por hora, ejecutar modelos de 20B o 120B parámetros en cada elemento sería prohibitivamente costoso. El enfoque en capas permite a las plataformas equilibrar cobertura de seguridad con factibilidad económica.

Hay límites claros. Un clasificador dedicado entrenado en decenas de miles de etiquetas de alta calidad aún puede superar el razonamiento desde política en categorías difíciles. También hay un trade-off de costo: el razonamiento toma más tiempo y cómputo que un clasificador pequeño, por lo que un pipeline escalonado es el patrón práctico para plataformas de alto volumen. Para plataformas establecidas con recursos sustanciales, la estrategia óptima probablemente involucra usar clasificadores tradicionales para categorías de riesgo bien definidas con datos de entrenamiento abundantes, reservando los modelos de razonamiento para riesgos emergentes, casos extremos y situaciones donde las políticas cambian frecuentemente.

⚠️ Limitaciones y Consideraciones

Clasificadores especializados aún ganan en categorías establecidas: Modelos entrenados en decenas de miles de ejemplos de alta calidad pueden superar el razonamiento en riesgos específicos bien definidos

Intensivo en cómputo: El razonamiento requiere significativamente más tiempo y recursos que clasificadores pequeños, haciendo difícil escalar a plataformas de volumen masivo

Arquitectura escalonada necesaria: Las plataformas prácticas usan filtro rápido primero, enviando solo casos ambiguos al modelo de razonamiento

Latencia mayor: El razonamiento paso a paso toma más tiempo que clasificación directa, no ideal para aplicaciones en tiempo real estricto

Formato harmony obligatorio: Los modelos deben usarse con el formato de respuesta harmony específico o el rendimiento se degradará

Requiere políticas bien escritas: La calidad del razonamiento depende críticamente de qué tan clara y completa sea la política proporcionada

Integración con ecosistema: ROOST, Ollama y comunidad open source

Los modelos gpt-oss-safeguard son socios modelo de Robust Open Online Safety Tools (ROOST) Model Community. La ROOST Model Community (RMC) es un grupo de profesionales de seguridad que exploran modelos de IA de código abierto para proteger espacios en línea. La RMC reúne a profesionales de seguridad e investigadores para compartir mejores prácticas para implementar modelos de IA de código abierto en flujos de trabajo de seguridad, incluyendo resultados de evaluación y retroalimentación de modelos. OpenAI continuará iterando con la comunidad para mejorar las herramientas de seguridad abiertas, incluyendo a través de la ROOST Model Community. Los interesados pueden visitar el repositorio GitHub de RMC para aprender más sobre esta asociación y cómo involucrarse.

Vinay Rao, CTO de ROOST, comentó: "gpt-oss-safeguard es el primer modelo de razonamiento de código abierto con un diseño de 'trae tus propias políticas y definiciones de daño'. Las organizaciones merecen estudiar, modificar y usar libremente tecnologías de seguridad críticas y poder innovar. En nuestras pruebas, fue hábil para comprender diferentes políticas, explicar su razonamiento y mostrar matices al aplicar las políticas, lo que creemos será beneficioso para constructores y equipos de seguridad." Esta afirmación subraya el compromiso con la democratización de herramientas de seguridad sofisticadas, haciéndolas accesibles a organizaciones de todos los tamaños en lugar de reservarlas solo para grandes plataformas tecnológicas.

Ollama se está asociando con OpenAI y ROOST para traer los modelos gpt-oss-safeguard de razonamiento más recientes a los usuarios para tareas de clasificación de seguridad. Esta integración facilita que los desarrolladores experimenten con los modelos localmente sin necesidad de infraestructura de nube compleja. La disponibilidad a través de múltiples canales de distribución, desde Hugging Face hasta Ollama, refleja el compromiso de OpenAI con accesibilidad amplia. Para comenzar a construir con estos modelos, los desarrolladores pueden descargarlos desde Hugging Face o accederlos a través de Ollama, con guías de prompting detalladas que proporcionan directrices para elaborar políticas y usarlas efectivamente con los modelos.

Contexto estratégico: apertura y competencia en seguridad de IA

OpenAI liberó los modelos abiertos un día después de que el proveedor se convirtiera en una corporación de beneficio público con fines de lucro y acordara nuevos términos con su socio Microsoft, que incluyeron una disposición que habilita a OpenAI desarrollar y comercializar modelos de pesos abiertos. La compañía ha sido criticada por la relativa falta de modelos abiertos en su portafolio de productos de IA generativa, conforme los modelos de código abierto y pesos abiertos se vuelven cada vez más populares entre las empresas debido a su menor costo, transparencia sobre datos de entrenamiento y sesgo del modelo, y el control que pueden dar a las organizaciones sobre sus datos internos al usar IA generativa.

OpenAI no es el primero en proporcionar este tipo de herramienta para empresas. Por ejemplo, Meta introdujo Llama Guard, un modelo de salvaguarda de entrada-salida de LLM, en 2023. Además, IBM ofrece Granite Guardian, que tiene tanto un modo de pensamiento como un modo sin pensamiento. Sin embargo, gpt-oss-safeguard se distingue por su enfoque explícito en razonamiento desde políticas proporcionadas por el usuario en lugar de políticas fijas codificadas en pesos del modelo. Este diseño proporciona flexibilidad significativamente mayor que generaciones anteriores de modelos de seguridad, permitiendo a las organizaciones adaptar comportamiento de moderación sin dependencia de proveedores de modelos para actualizaciones.

La idea más fuerte aquí es política-como-prompt con razonamiento visible, lo que desacopla las reglas de seguridad de los pesos y acorta el ciclo desde el cambio de política hasta el comportamiento de producción. Este cambio arquitectónico fundamental tiene implicaciones profundas para cómo las plataformas pueden responder a amenazas emergentes, requisitos regulatorios cambiantes y expectativas comunitarias evolutivas. En lugar de esperar semanas o meses para ciclos de reentrenamiento, los equipos de seguridad pueden iterar en políticas en tiempo real, probando y refinando reglas conforme aprenden más sobre nuevos vectores de abuso. Esta agilidad representa ventaja competitiva significativa en el panorama rápidamente cambiante de riesgos en línea.

🚀 Disponibilidad y Acceso

Licencia: Apache 2.0, permitiendo uso comercial, modificación y distribución sin restricciones de copyleft

Descarga: Disponible en Hugging Face para ambos tamaños de modelo (120b y 20b)

Integración Ollama: Acceso simplificado a través de la plataforma Ollama para experimentación local

Documentación: Guía detallada de prompting con directrices para elaborar políticas efectivas

Compatibilidad API: Funciona con API de Respuestas de OpenAI para integración fluida

Comunidad: Soporte a través de ROOST Model Community para compartir mejores prácticas

Fecha de lanzamiento: Vista previa de investigación lanzada el 29 de octubre de 2025

Referencias

OpenAI Blog, "Introducing gpt-oss-safeguard" - anuncio oficial con especificaciones técnicas completas (29 de octubre, 2025).

OpenAI, "Technical Report: Performance and baseline evaluations of gpt-oss-safeguard-120b and gpt-oss-safeguard-20b" (29 de octubre, 2025).

OpenAI, "gpt-oss-120b & gpt-oss-20b Model Card" - documentación de arquitectura y evaluaciones de seguridad (29 de octubre, 2025).

CNBC, "OpenAI introduces safety models that other sites can use to classify harms" (29 de octubre, 2025).

Help Net Security, "OpenAI's gpt-oss-safeguard enables developers to build safer AI" - análisis de casos de uso (29 de octubre, 2025).

Hugging Face, "openai/gpt-oss-safeguard-20b" - documentación técnica y guías de implementación (29 de octubre, 2025).

AI Business, "OpenAI out with two new open models" - contexto competitivo con Meta Llama Guard e IBM Granite Guardian (29 de octubre, 2025).

MarkTechPost, "OpenAI Releases Research Preview of 'gpt-oss-safeguard'" - análisis técnico detallado (31 de octubre, 2025).

Ollama Blog, "OpenAI gpt-oss-safeguard" - anuncio de asociación e integración (29 de octubre, 2025).

OpenAI Developer Community, "Introducing gpt-oss-safeguard: Open Safety Reasoning Models with Custom Policies" (29 de octubre, 2025).