Crear un videojuego triple A cuesta cientos de millones de dólares y lleva años. Una película con efectos visuales decentes requiere batallones de artistas digitales que trabajan meses para producir secuencias de segundos. Los arquitectos pasan semanas modelando edificios que todavía no existen. Esta realidad económica brutal ha establecido barreras claras: solo quienes tienen mucho dinero y mucho tiempo pueden fabricar mundos virtuales convincentes.

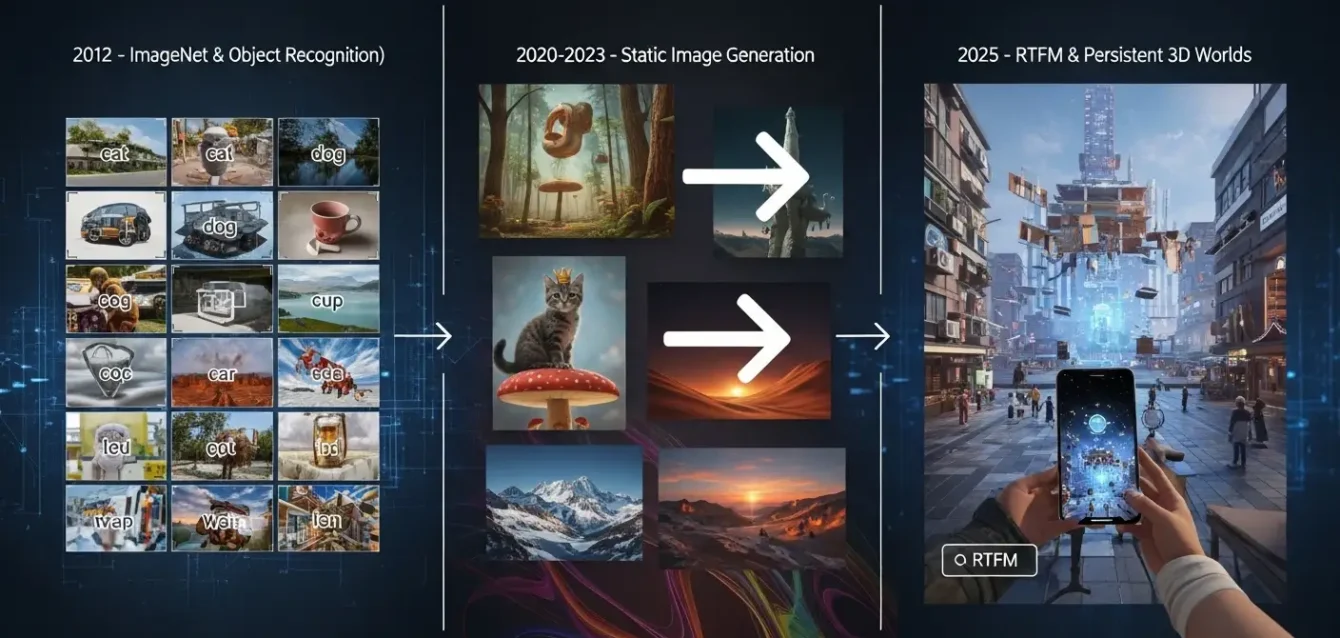

Hasta ahora. World Labs, la startup de más de mil millones de dólares que fundó Fei-Fei Li, acaba de mostrar algo que parecía imposible: convertir una simple fotografía en un escenario tridimensional donde puedes caminar, explorar y tocar objetos que se comportan como deberían. Todo ejecutándose en tiempo real dentro de tu navegador. RTFM es el nombre del sistema, y representa exactamente lo que suena: el punto donde la generación algorítmica se encuentra con la ingeniería de videojuegos.

Li lo anunció en redes sociales el 16 de octubre de 2025. «Muy emocionada de compartir nuestro último trabajo», escribió, destacando que todo funciona con una sola GPU H100 de Nvidia. Ese chip cuesta unos 30,000 dólares, una fracción de lo que antes se necesitaba. RTFM no genera videos pregrabados ni imágenes bonitas y estáticas. Construye mundos donde te mueves libremente, los objetos permanecen donde los dejaste, las superficies reflejan la luz correctamente y las sombras caen donde deben caer.

Li es profesora de Stanford, la mujer a quien llaman «madrina del aprendizaje profundo» por haber creado ImageNet, ese conjunto masivo de imágenes que revolucionó todo en 2012 cuando AlexNet lo dominó. Pero reconocer gatos en fotos es una cosa. Entender el espacio es otra completamente diferente. «Si queremos resolver de verdad el problema de la visión y conectarlo con la acción, hay un hecho simple que no podemos ignorar: el mundo es tridimensional», le dijo a IEEE Spectrum. «No vivimos en un plano».

La amnesia de las máquinas

Los modelos anteriores que intentaban simular entornos tridimensionales sufrían un problema grave: se olvidaban de lo que acababan de crear. Oasis, el sistema de Decart que intenta recrear Minecraft, pierde coherencia a los pocos segundos. La resolución es baja y el mundo se desdibuja conforme exploras. Cada cuadro que genera existe independientemente del anterior, lo que produce geometrías que no tienen sentido y objetos que se funden entre sí o desaparecen cuando mueves la cámara.

Sora de OpenAI genera videos espectaculares, pero tampoco tiene memoria espacial. No puede volver atrás para verificar si una puerta que cerraste sigue cerrada porque cada frame es una alucinación nueva, sin conexión con lo anterior.

RTFM funciona diferente. Mantiene la estructura geométrica, las posiciones de los objetos y sus apariencias mientras interactúas con el mundo. Lo que generas no se evapora cuando cambias el punto de vista. Esta continuidad transforma un truco técnico en algo potencialmente útil: los creadores pueden construir narrativas, los diseñadores evaluar propuestas arquitectónicas y los desarrolladores probar mecánicas de juego. La física básica se respeta. Los reflejos, los brillos y las sombras funcionan como en los motores comerciales de renderizado.

Claro que hay limitaciones. Solo puedes explorar áreas pequeñas antes de chocar con límites invisibles. A veces los objetos se fusionan de formas raras. Las escenas se ven un poco caricaturescas en lugar de fotorrealistas. World Labs admite que esto es apenas un «adelanto temprano» y que falta mucho por mejorar. Pero la dirección está clara: mundos virtuales que antes requerían equipos completos trabajando durante años ahora pueden emerger de instrucciones simples en cuestión de segundos.

Del garaje académico al negocio multimillonario

Justin Johnson, cofundador de World Labs, explicó la visión en un podcast de Andreessen Horowitz: «Ya sabemos crear mundos virtuales interactivos, pero cuesta cientos de millones de dólares y muchísimo tiempo. Esto va a permitir que cualquiera obtenga no solo una imagen o un video, sino un mundo completamente simulado y vivo». La compañía levantó 230 millones de dólares en dos rondas que se cerraron en 2024. Entre los inversores están a16z, NEA, Radical Ventures, Intel Capital, AMD Ventures y Eric Schmidt. Con una valuación superior a los mil millones, World Labs se ubica entre los unicornios tecnológicos más vigilados del momento.

Los mercados obvios incluyen desarrolladores de videojuegos que necesitan prototipar niveles rápido, estudios de cine que quieren previsualizar escenas complejas sin gastar fortunas, arquitectos que necesitan mostrar diseños sin hacer renders que tardan días, y educadores que buscan crear ambientes inmersivos para entrenar a sus estudiantes.

Un estudio de Deloitte de 2023 calculó que los gemelos digitales impulsados por algoritmos pueden reducir los costos de simulación hasta un 70 por ciento. Forrester proyectó en 2024 que para 2030, sistemas como este sustentarán el 40 por ciento de la creación de contenido en realidad virtual y aumentada.

Pero hay razones para ser escépticos sobre si una tecnología tan nueva va a cumplir promesas tan grandes. Los videojuegos de alto presupuesto necesitan mucho más que geometría creíble: requieren física detallada, personajes con comportamientos complejos, narrativas coherentes y optimización brutal para que funcionen en diferentes tipos de hardware. Las películas exigen control artístico absoluto sobre cada cuadro y una iluminación cinematográfica profesional que RTFM todavía no alcanza. La arquitectura necesita precisión milimétrica y cumplir con códigos de construcción. Históricamente, convertir una demo técnica impresionante en una herramienta profesional confiable lleva años de refinamiento adicional.

Aun así, la trayectoria importa más que el calendario. Li insistió en su charla principal de NeurIPS que la inteligencia espacial es la pieza fundamental que falta en los ecosistemas algorítmicos actuales. Los modelos lingüísticos masivos son brillantes manipulando texto, pero no entienden cómo los objetos ocupan espacio, cómo la gravedad afecta el movimiento o cómo la perspectiva altera lo que vemos.

Los robots que navegan entornos reales, los vehículos autónomos que esquivan obstáculos y los agentes virtuales que interactúan de forma convincente necesitan dominar estas dimensiones físicas que el texto plano no puede capturar.

World Labs reconoce la paradoja: «Los modelos mundiales generativos van a ser inevitablemente muy exigentes computacionalmente, probablemente más que los modelos lingüísticos actuales. Pero creemos que son una dirección crucial de investigación». La H100, aunque relativamente accesible comparada con clusters enteros de servidores, todavía está fuera del alcance de creadores individuales con presupuestos modestos. El consumo energético de estas GPUs plantea preguntas ambientales conforme estos sistemas se multipliquen.

Las proyecciones técnicas apuntan hacia la integración con computación en el borde para 2027, lo que reduciría la dependencia de procesadores centralizados y permitiría que todo esto funcione en dispositivos móviles. Gartner ubicó a los modelos mundiales en su ciclo de expectativas infladas de 2024, lo que sugiere que las esperanzas exageradas van a preceder inevitablemente a una desilusión antes de que llegue la adopción madura. Los competidores incluyen proyectos de OpenAI, Stability AI y varios laboratorios académicos que persiguen objetivos similares por caminos diferentes.

Pero la carrera no se trata simplemente de quién genera las escenas más bonitas más rápido. Se trata de desbloquear una modalidad completamente nueva de interacción entre humanos y computadoras, donde describir algo con palabras se traduce directamente en una experiencia espacial que puedes explorar. Si World Labs cumple su promesa, el primer producto comercial aparecerá en 2025, apenas a meses de distancia. Mientras tanto, cualquiera con un navegador web puede experimentar las demos en línea y vislumbrar un futuro donde los mundos virtuales emergen al instante, persisten indefinidamente y responden con fluidez, desafiando todo lo que creíamos saber sobre cuánto tiempo, dinero y esfuerzo humano se necesita para construir realidades alternativas convincentes.

Referencias:

- Li, Fei-Fei. Post en X/Twitter anunciando RTFM.

- Wiggers, Kyle. «World Labs’ AI can generate interactive 3D scenes from a single photo.» TechCrunch.

- Strickland, Eliza. «AI Pioneer Fei-Fei Li Has a Vision for Computer Vision.» IEEE Spectrum.

- «Fei-Fei Li’s world labs debuts groundbreaking 3D AI.» Digital Watch Observatory.

- «World Labs’ $230M Funding: Li Feifei’s AI Vision Reshapes 3D Worlds.» Medium.

- Sitio oficial: worldlabs.ai