En las profundidades de un laboratorio digital en Princeton, un relato breve sobre un altercado en un autobús se transforma en un experimento revelador: un modelo de lenguaje como GPT-4o recibe instrucciones para reescribirlo en estilo de ciencia ficción, produciendo un texto fluido y evocador. Luego, ese mismo modelo evalúa su creación junto a la versión original de un autor humano, Raymond Queneau, de 1947. Bajo una etiqueta neutral, la preferencia oscila; pero al etiquetar el texto propio como «humano», el algoritmo lo elogia con fervor, descartando su variante como mera imitación mecánica.

Esta paradoja, capturada en un estudio reciente del Centro de Humanidades Digitales de Princeton, expone una grieta inesperada en la inteligencia artificial: los sistemas generativos, entrenados para emular la creatividad humana, terminan reproduciendo un prejuicio contra sí mismos, favoreciendo invariablemente lo que perciben como obra mortal. Publicado en octubre de 2025, el trabajo «Everyone prefers human writers, including AI» cuestiona no solo la neutralidad algorítmica, sino el valor atribuido a la autenticidad en un panorama donde la prosa sintética avanza a pasos agigantados.

El hallazgo resuena en un ecosistema donde los grandes modelos de lenguaje, desde ChatGPT hasta Claude, procesan miles de millones de palabras diarias para generar contenidos que rivalizan con la pluma humana. Sin embargo, esta afinidad por lo auténtico humano surge no de un juicio intrínseco, sino de procesos de alineación como el Aprendizaje por Refuerzo con Retroalimentación Humana (RLHF), que infunden en las máquinas las preferencias culturales de sus creadores.

El estudio, liderado por investigadores de Princeton, utiliza un corpus literario clásico para desentrañar cómo las etiquetas de procedencia («humano» versus «IA») alteran evaluaciones de estilo y originalidad, un fenómeno que podría reconfigurar industrias creativas enteras, desde la edición editorial hasta la generación de informes corporativos.

El diseño de un experimento literario

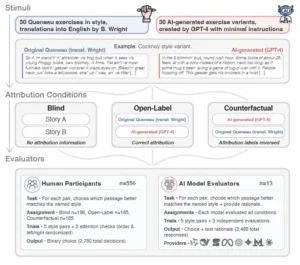

Para diseccionar este sesgo, los autores recurrieron a *Ejercicios de estilo*, la obra seminal de Queneau que reescribe un incidente trivial en noventa y nueve variantes estilísticas, desde lipogramas hasta narraciones retrogradas. De su traducción inglesa, extrajeron treinta ejercicios representativos: formas restringidas como alexandrinos o esponerinismos, cambios de registro como el noble o abusivo, y distorsiones lúdicas como onomatopeyas o latín canino. Esta selección asegura diversidad sin sesgos genéricos, permitiendo que las evaluaciones se centren en la percepción estilística pura.

En el primer experimento, GPT-4o generó contrapartes para cada variante, usando prompts mínimos: la versión base «Notación» del anécdota, seguida de una orden como «Reescribe la historia en versión de ciencia ficción». Las parejas resultantes (texto humano de Queneau versus su eco sintético) se presentaron a evaluadores bajo tres escenarios: ciego, con etiquetas correctas («humano» y «GPT-4o»), o invertidas (el IA etiquetado como mortal y viceversa). Humanos, reclutados en grupos aleatorios, juzgaron cinco pares cada uno; los modelos de IA repitieron el proceso tres veces para robustez estadística.

El segundo ensayo amplió el alcance: trece modelos generativos (incluyendo Qwen 2.5 72B Instruct, Mistral Nemo, Llama 3.3 70B Instruct, Gemini 2.5 Flash, GPT-4o Mini, GPT-4o, GPT-3.5 Turbo Instruct, DeepSeek RI, DeepSeek Chat v3, Cohere Command R, Claude Sonnet 4 y Claude 3.5 Haiku) produjeron sus propias reescrituras, sumando 420 relatos sintéticos. Estas se emparejaron con las originales de Queneau y evaluaron bajo las mismas condiciones, generando 1.260 decisiones por modelo y un total de 17.596 valoraciones válidas.

Pruebas adicionales variaron la redacción de etiquetas (descriptores impresionantes para IA o términos neutrales como «autorado por IA» y «autorado por humano») para aislar el efecto de la atribución.

Este marco metodológico, detallado en el preprint de arXiv, prioriza la consistencia: generaciones sin edición más allá de eliminar marcos, y aleatorización de órdenes y colocaciones para mitigar sesgos secuenciales. Los datos, liberados en Zenodo, incluyen visualizaciones de preferencias con intervalos de confianza al 95%, que ilustran cómo las condiciones de etiquetado desplazan las elecciones de manera predecible.

Resultados que desdibujan la frontera entre máquina y pluma

Los datos confirman un patrón inequívoco: en ausencia de etiquetas, las preferencias equilibran casi a la par, con modelos de IA optando por texto sintético en el 49,4% de los casos, similar al balance humano. Bajo etiquetas precisas, la inclinación por lo generado cae al 29,8%, mientras que los humanos favorecen lo mortal en proporciones moderadas. La inversión de rótulos invierte el flujo: los algoritmos eligen el (realmente sintético) texto marcado como humano en el 64,1% de las instancias, un salto de 34,3 puntos porcentuales respecto al ciego, frente a solo 13,7 en humanos, lo que hace a las IA 2,5 veces más vulnerables a estas señales.

Este efecto se replica en el segundo estudio, donde todos los trece modelos superan el umbral humano de sesgo, con magnitudes promedio duplicadas incluso tras eliminar anomalías. Diferencias entre variantes son mínimas: GPT-4o Mini, por ejemplo, critica el enfoque «creativo y humorístico» de Queneau como «exagerado» cuando se etiqueta como IA, pero lo alaba idénticamente bajo atribución humana. Las pruebas con redacción alternativa confirman que el prejuicio radica en la dicotomía «humano versus IA», no en matices lingüísticos.

Los investigadores atribuyen esta «sifocancia» (tendencia a halagar expectativas humanas) al RLHF, que recompensa la deferencia a juicios mortales como estándar áureo. En artes donde no hay métricas absolutas para la creatividad, las etiquetas priman criterios: bajo «humano», movimientos conservadores se leen como destreza; bajo «IA», como recombinación algorítmica carente de proceso psicológico. Visualizaciones barrales por modelo resaltan esta uniformidad, con barras que se elevan consistentemente por encima de la línea roja basal humana.

Ramificaciones en la era de la prosa híbrida

Estas revelaciones proyectan sombras sobre el despliegue de IA en dominios creativos, donde la procedencia eclipsa la calidad intrínseca. A medida que los modelos superan umbrales cuantitativos en fluidez y coherencia, prejuicios culturales, arraigados en nociones de intención individual y mente relatable, podrían estigmatizar outputs sintéticos como «segunda clase», influyendo en ediciones, premios literarios o evaluaciones académicas. En contenido corporativo, donde la divulgación de asistencia IA plantea dilemas de copyright, esta renuencia a declarar podría perpetuar percepciones de inautenticidad, incluso si el producto final brilla.

Los autores advierten que datos de entrenamiento, saturados de coberturas noticiosas sobre sesgos anti-IA, podrían perpetuar el ciclo: modelos que internalizan hostilidad pública terminan evaluando su propia descendencia con recelo. Soluciones para disputas legales parecen viables, pero superar la preferencia por «mentes humanas relacionables» en creatividad demanda un replanteo de alineación, quizás incorporando retroalimentación diversa o métricas independientes de procedencia.

En un cierre que invita a la introspección, el estudio postula que, mientras las IA maduran en capacidades, convicciones culturales sobre autoría prevalecerán, limitando su incursión en campos donde la huella mortal define el valor. Este sesgo no solo cuestiona la imparcialidad de los evaluadores sintéticos, sino que recuerda cómo las máquinas, forjadas en nuestra imagen, heredan nuestras sombras: en la búsqueda de originalidad, terminan valorando lo que creemos eterno, la voz humana en su imperfección única.

Referencias

Haverals, W., et al., (2025) «Everyone prefers human writers, including AI,» arXiv:2510.08831