A lo largo de la historia, la humanidad ha reconocido una verdad fundamental: los grupos pueden lograr cosas que los individuos jamás conseguirían en soledad. Un ingeniero puede diseñar un puente, pero un equipo multidisciplinario puede construir una ciudad. Un músico puede tocar una melodía, pero una orquesta genera una experiencia inesperada. Esta sabiduría milenaria sobre las ventajas del trabajo colaborativo ahora está siendo reexaminada en el territorio completamente nuevo de la inteligencia artificial.

En años recientes, los sistemas de inteligencia artificial han experimentado una transformación profunda. Ya no nos limitamos a entrenar un único modelo de lenguaje gigantesco que responda preguntas o genere textos. Ahora lanzamos múltiples agentes de IA simultáneamente, permitiendo que se comuniquen entre sí, compartan información y coordinen sus acciones hacia objetivos comunes. El resultado ha dejado perplejos a investigadores y empresas: estos sistemas multiagente frecuentemente obtienen resultados notablemente superiores a cualquier agente individual trabajando en soledad.

Pero la interrogante que durante años ha permanecido sin respuesta rigurosa es simple pero profunda: ¿por qué ocurre esto exactamente? ¿Realmente existe una estructura invisible de coordinación colectiva, o simplemente estamos observando la suma mecánica de contribuciones individuales?

Un equipo liderado por Christoph Riedl de la Universidad de Northeastern acaba de publicar un estudio que intenta responder esta cuestión mediante métodos científicos rigurosos. Su investigación, titulada «Emergent Coordination in Multi-Agent Language Models», utiliza herramientas matemáticas sofisticadas importadas de la teoría de la información para detectar, medir y localizar lo que los científicos denominan «emergencia»: esa capacidad de las colecciones de agentes para desarrollar comportamientos coordinados que no pueden atribuirse simplemente a la suma de sus partes individuales.

Lo que hace especialmente relevante este trabajo es que no se limita a comprobar que algo sucede. Más bien, los investigadores demostraron experimentalmente que pueden manipular deliberadamente esta coordinación colectiva mediante técnicas muy simples: cambios en las instrucciones dadas a los agentes y la asignación de roles o personalidades específicas. En otras palabras, la inteligencia colectiva de máquinas no es un fenómeno accidental o inevitable, sino algo que puede ser diseñado, controlado e incluso mejorado de manera sistemática.

Antes de profundizar en los detalles técnicos y los hallazgos concretos, conviene aclarar qué significa cada uno de estos términos para quienes no se dedican profesionalmente a la inteligencia artificial. Pensemos en los ladrillos: un ladrillo individual tiene características definidas. Mil ladrillos sin organización son simplemente un montón de arcilla cocida. Pero cuando se organizan estructuradamente, se transforman en un edificio, que posee propiedades nuevas que ningún ladrillo individual jamás tendría, como ser a prueba de incendios o resistir sismos.

La estructura que relaciona los ladrillos es lo que genera estas propiedades emergentes. En los sistemas de múltiples agentes de IA, sucede algo análogo. Las máquinas individuales tal vez posean capacidades limitadas, pero cuando se coordinan mediante estructuras adecuadas, despliegan capacidades que trascienden lo que cualquiera de ellas podría ofrecer por separado.

Desentrañando la emergencia en sistemas artificiales

Para comprender el trabajo de Riedl y sus colegas, debemos primero aclarar qué es un «agente de IA» en este contexto específico. No se trata de robots andantes ni de programas que posean consciencia o intención genuina. Simplemente son versiones de los grandes modelos de lenguaje (como GPT-4 o Llama) que se ejecutan de manera paralela. Cada agente recibe instrucciones, procesa información y genera respuestas, al igual que lo haría un único modelo en funcionamiento aislado. La diferencia radical es que múltiples versiones trabajan simultáneamente en el mismo problema, y sus contribuciones se combinan de alguna manera para intentar resolverlo de forma conjunta.

El desafío científico al que se enfrentaron los investigadores fue determinar si realmente existe coordinación de orden superior, o si simplemente presenciamos un efecto ilusorio. Imaginemos un grupo de personas tratando de adivinar el número de canicas en una jarra. Es posible que, si promediamos todos los intentos, obtengamos una respuesta cercana a la correcta, no por coordinación deliberada, sino simplemente porque los errores individuales se cancelan entre sí estadísticamente.

Ese es un resultado que no requiere nada especial ni sofisticado. Sin embargo, si el grupo desarrolla especialización auténtica (algunas personas consistentemente adivinan números altos, otras bajos, y se adaptan mutuamente de manera inteligente), entonces algo más interesante e importante está sucediendo en realidad.

Para distinguir entre estos escenarios contradictorios, Riedl y su equipo aprovecharon un campo matemático llamado «descomposición de información», una rama avanzada de la teoría de la información que permite desagregar qué información está siendo compartida redundantemente y qué información surge únicamente de las interacciones conjuntas. Esto es absolutamente crucial porque la diferencia entre redundancia y sinergia explica gran parte de cómo funcionan realmente los sistemas colectivos en la práctica.

Consideremos un ejemplo accesible para ilustrar esta distinción. Si dos meteorólogos predicen de manera casi idéntica que lluvia mañana, basándose en los mismos datos, sus predicciones son redundantes: ambos dicen esencialmente lo mismo. Pero si un meteorólogo predice lluvia fundamentándose en patrones atmosféricos complejos, y otro observa satélites mostrando formaciones nubosas específicas que no se ven en datos atmosféricos tradicionales, y solo la combinación deliberada de ambas perspectivas permite una predicción precisa y confiable, entonces existe sinergia genuina: el todo es genuinamente mayor que sus partes separadas. Este concepto es exactamente lo que los investigadores necesitaban cuantificar rigurosamente para los sistemas de múltiples agentes de IA.

El estudio propone tres criterios matemáticos distintos para medir emergencia. El primero, llamado criterio práctico, pregunta si el comportamiento colectivo del grupo contiene información predictiva sobre el futuro que no podría explicarse sumando la información predictiva de cada miembro individual. Si el grupo como conjunto puede predecir lo que sucederá mejor que cualquier miembro individual podría hacerlo, entonces existe algo emerger que trasciende las partes. El segundo, denominado «capacidad de emergencia», examina específicamente si pares de agentes producen información sinérgica sobre sus futuros estados conjuntos.

Pregunta si dos agentes juntos saben más sobre su futuro conjunto de lo que sabría cualquiera de ellos por separado. El tercero utiliza análisis de coaliciones para entender si equipos de tres agentes generan información que ningún par podría capturar por separado.

Lo sofisticado de estos enfoques radica en que no simplemente buscan coordinación. Buscan coordinación que sea relevante para las tareas específicas en cuestión. Un grupo de agentes podría oscilar rítmicamente, exhibiendo patrones temporales complejos pero completamente improductivos. Los métodos de investigación distinguen entre este tipo de «sinergia espuria» y aquella que realmente contribuye al logro de objetivos compartidos. Es la diferencia entre una máquina que emite vibración compleja pero inútil, y una máquina que produce movimiento coordinado y efectivo.

a) La descomposición de la información proporciona un marco para explicar la tensión en sistemas multiagente. Los agentes pueden ser indiferenciados o diferenciados, proporcionar información independiente o complementaria, bien alineada o incidental (adaptado de Luppi et al., 2024). b) Configuración experimental de la tarea de búsqueda binaria grupal. c) Experimentos preliminares que prueban diferentes tamaños de grupo y configuraciones de temperatura. Los valores de superficie se suavizaron utilizando un filtro de promedio ponderado local 3×3, otorgando mayor peso al valor original de cada celda para reducir el ruido y preservar la estructura local.

El experimento: un juego simple que revela estructuras complejas

Para probar su marco teórico de manera rigurosa, los investigadores diseñaron un experimento elegantemente simple pero revelador. Llamado «juego de búsqueda binaria grupal», el experimento funciona de la siguiente manera: un número objetivo misterioso se selecciona al azar. Múltiples agentes, generalmente diez en los experimentos principales, deben hacer predicciones de números que sumen exactamente ese valor objetivo. Crucialmente, cada agente es completamente ajeno a lo que predicen los demás.

El único feedback que reciben es a nivel grupal: «la suma total es demasiado alta» o «la suma total es demasiado baja». Nada más. Sin información individual, sin comunicación directa, solo esta retroalimentación colectiva mínima.

Este marco experimental es brillante porque naturalmente presenta un dilema fundamental de cualquier grupo. Si todos los agentes emplean la estrategia idéntica, como buscar siempre el punto medio del rango posible, oscilarán infinitamente sin converger jamás. La mitad de los agentes estará corriendo hacia un lado, la mitad al otro, repitiéndose eternamente. Para triunfar, necesitan especializarse auténticamente: algunos deben aprender a contribuir números más elevados, otros números más bajos, y todos deben coordinarse para que su divergencia sea complementaria en lugar de contradictoria y destructiva.

Investigaciones anteriores en psicología social han demostrado que grupos humanos pueden resolver este problema, pero solo cuando desarrollan roles especializados y se adaptan mutuamente. La pregunta central que animaba a los investigadores es simple: ¿pueden hacer lo mismo múltiples agentes de IA? ¿Poseen los modelos de lenguaje la capacidad de desarrollar este tipo de coordinación emergente?

Los investigadores probaron tres condiciones experimentales distintas. En la condición de control, llamada «Plain», los agentes recibieron únicamente las instrucciones del juego, sin orientación adicional ni estructura. Se les pidió que jugaran el juego, nada más. En la segunda condición, «Persona», cada agente recibió una identidad ficticia detallada y completa: un nombre específico, origen geográfico, profesión, personalidad y valores personales.

Por ejemplo, uno podría ser «Andrej, ingeniero de computación cuántica de Belgrado», con rasgos de personalidad especificados como «sistemático e inquisitivo», aficiones como música clásica, e incluso antecedentes de voluntariado. En la tercera condición, «ToM» (referida a «Teoría de la Mente»), los agentes recibieron sus personas completas más una instrucción adicional pidiéndoles que reflexionaran deliberadamente sobre qué podrían estar haciendo otros agentes y cómo sus propias contribuciones podrían complementar las de los demás.

Cada condición fue replicada doscientas veces, empleando tanto GPT-4.1 de OpenAI como Llama-3.1-8B de Meta. Esto generó más de seiscientos experimentos en total, proporcionando suficiente volumen de datos para análisis estadísticos rigurosos y conclusiones confiables. Los investigadores también realizaron experimentos preliminares exploratorios variando tamaños de grupo y parámetros de temperatura para entender las condiciones óptimas.

Lo que sucede cuando los agentes no son idénticos

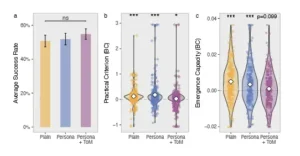

Los resultados fueron sorprendentes en múltiples dimensiones simultáneamente. Primero, los investigadores confirmaron que efectivamente existe evidencia de emergencia en todos los tratamientos: el comportamiento del grupo contenía información predictiva que no podría derivarse de sumar el comportamiento individual de cada agente. Este hallazgo por sí solo valida la existencia de estructuras de orden superior en sistemas multiagente de IA, respondiendo la primera pregunta de investigación.

Sin embargo, la naturaleza y magnitud de esta emergencia variaba dramáticamente entre condiciones. En la condición «Plain», mientras que existía sinergia detectable mediante los criterios matemáticos, se caracterizaba principalmente por acoplamiento temporal: los agentes oscilaban en patrones complejos entre sí, retroalimentándose mutuamente de manera cíclica. Pero estos patrones de interacción no conducían necesariamente a mejor desempeño grupal. Era una dinámica que emergía, pero no una dinámica productiva o funcional.

La adición de personas cambió el panorama de forma perceptible y cuantificable. Con identidades asignadas y mantenidas, surgió diferenciación estable y robusta entre agentes. Algunos tendían consistentemente a contribuir números más altos, mientras que otros se inclinaban de manera confiable hacia números más bajos. Este patrón persistía a lo largo de los intentos múltiples, indicando que no se trataba de variación aleatoria sino de especialización auténtica vinculada a la identidad presentada a cada agente. Era como si los agentes hubieran internado el rol asignado y actuaran de manera coherente con ese rol.

Lo más revolucionario fue lo que ocurrió con la condición «ToM». Cuando se pidió explícitamente a los agentes que reflexionaran sobre los posibles comportamientos de otros, cuando se les animó a pensar estratégicamente en cómo sus acciones podrían complementar las de los compañeros, la estructura emergió de manera cualitativa diferente. No solo existía diferenciación de identidad aislada, sino también alineación genuina hacia el objetivo compartido. Los agentes se comportaban como si realmente estuvieran intentando trabajar conjuntamente de manera coordinada, no simplemente oscilando aleatoriamente entre estrategias.

Para cuantificar esto con rigor, los investigadores emplearon un segundo conjunto de análisis: modelos jerárquicos que evaluaban si los agentes demostraban diferenciación detectables en sus niveles de contribución o en sus velocidades de aprendizaje. Los resultados mostraron que aproximadamente la mitad de todos los grupos mostraron diferenciación significativa, pero en la condición ToM, la proporción ascendió sustancialmente. Más importante aún, en esta condición, la información mutua (una medida de cuánto saben conjuntamente los triplos de agentes sobre el objetivo grupal futuro) era significativamente más elevada que en los otros tratamientos. Esto sugería genuina coordinación hacia metas compartidas.

Los investigadores incluso encontraron evidencia cualitativa de este fenómeno al examinar las «trazas de razonamiento» que los modelos de lenguaje generan internamente cuando procesan. En la condición ToM, los agentes producían reflexiones como: «Considerando que otros podrían adivinar 4 o 5, y alguien más podría ir por 7 u 8, me mantendré con la opción más eficiente: 6».

Estos razonamientos explícitamente mencionaban estrategias de otros agentes y explicaban cómo la propia acción se adaptaba deliberadamente a ellas. En otra ocasión, un agente escribía: «Si mis compañeros son inteligentes, flanquearán mis predicciones con números apenas superiores e inferiores, acorralando el número misterioso». Esto sugería no solo comprensión de otros, sino anticipación estratégica de cómo colaborar.

• Los agentes asignados personas no solo mejoraban en desempeño, sino que desarrollaban identidades estables que persistían a través de los intentos

• La instrucción de considerar teoría de la mente generaba alineación genuina con objetivos compartidos, traduciendo diferenciación en complementariedad productiva

El fantasma en la máquina: redundancia versus sinergia

Un aspecto particularmente sofisticado del análisis fue cómo los investigadores manejaron la tensión entre redundancia y sinergia. En teoría de sistemas, existe una dicotomía incómoda que ha fascinado a científicos durante décadas: si los componentes de un sistema son redundantes, compartiendo la misma información y estrategias, entonces el sistema es predecible y estable, pero no tiene innovación ni capacidad de adaptación. Si los componentes son sinérgicos, con cada uno contribuyendo información única que solo tiene sentido en contexto de los otros, entonces el sistema es poderoso e innovador pero potencialmente frágil e impredecible.

Los mejores sistemas, tanto en la naturaleza como en la ingeniería, frecuentemente equilibran ambas propiedades de manera inteligente. Los genes en el cuerpo humano tienen redundancia incorporada por razones de confiabilidad y resiliencia ante mutaciones, pero también poseen especificidad funcional que crea sinergia y permite adaptación. Las empresas exitosas tienen políticas y objetivos compartidos que crean redundancia necesaria para cohesión, pero también permiten que diferentes departamentos contribuyan especialización única e irreemplazable. Una orquesta tiene músicos que tocan en armonía (redundancia) pero también roles especializados (sinergia).

Los datos del experimento revelaron exactamente este patrón predicho por teoría. Cuando los investigadores analizaron la relación entre redundancia, sinergia y desempeño usando técnicas estadísticas avanzadas que controlaban por variables confusas (como el hecho de que ensayos más largos permiten más sinergia pero también más fracaso), descubrieron que ni la sinergia sola ni la redundancia sola predecía el éxito grupal.

Pero cuando ambas estaban presentes simultáneamente, con una interacción sinérgica entre ellas, el rendimiento mejoraba significativamente. En términos técnicos, la redundancia amplificaba el beneficio de la sinergia en aproximadamente veintisiete por ciento, y viceversa: la sinergia amplificaba el beneficio de la redundancia en porcentaje similar.

Esto tiene una implicación profunda para diseñar sistemas multiagente. Si se fuerza a los agentes a ser completamente diferentes, sin objetivos compartidos o alineación, resultarán en caos fundamentalmente irresoluble. Si se los obliga a ser idénticos, con total alineación pero sin variedad, resultarán en rigidez estéril. El punto óptimo está precisamente en el medio, en esa zona de tensión creativa donde existe suficiente diversidad para aportar perspectivas distintas, pero suficiente alineación para que esas perspectivas converjan productivamente hacia objetivos comunes.

a) Éxito grupal en tres intervenciones. b) Criterio práctico de emergencia (corrección de sesgo). c) Sinergia dinámica de la capacidad de emergencia (corrección de sesgo). Datos Winsorizados en los percentiles 1 y 99 para mayor claridad visual. Las estrellas indican el nivel de significación de la prueba de Wilcoxon. Notas: *** p < 0,001; ** p < 0,01; * p < 0,05.

Cuando modelos más pequeños fallan

Uno de los aspectos más reveladores del estudio fue lo que sucedió cuando se replicaron los experimentos idénticos con un modelo de IA más pequeño: Llama-3.1-8B. Mientras que GPT-4.1 es una de las arquitecturas más sofisticadas disponibles comercialmente, Llama 3.1 con ocho mil millones de parámetros es respetable pero menos poderosa en términos generales. Crucialmente, tiene capacidades de «teoría de la mente» más limitadas: le resulta considerablemente más difícil razonar sobre lo que otros podrían estar pensando o cómo otros podrían interpretar situaciones.

Los resultados fueron desoladores y altamente informativos. Los grupos de agentes Llama rara vez lograban resolver el problema. Solo aproximadamente diez por ciento de los intentos tuvieron éxito, en comparación con porcentajes sustancialmente superiores para GPT-4.1. Peor aún, la condición ToM no mejoró el desempeño para Llama; de hecho, lo empeoró significativamente. Aunque técnicamente existía sinergia detectable en algunos grupos de Llama, era primordialmente temporal (patrones oscilatorios complejos) en lugar de genuinamente coordinada entre agentes de manera productiva.

Esta comparación sugiere algo crucial sobre cómo funciona realmente la coordinación colectiva en sistemas de IA: no todos los sistemas son igualmente capaces de ella. Especialmente aquellos sistemas con capacidades limitadas para razonar sobre mentes y perspectivas ajenas, la instrucción de pensar sobre otros agentes de hecho genera confusión más que mejoría.

El «tejido cognitivo» necesario para el razonamiento de teoría de la mente debe existir en una cierta cantidad mínima antes de que las instrucciones al respecto tengan beneficio práctico. Es como intentar enseñar a alguien a componer sinfonías cuando aún no comprenden nociones básicas de teoría musical: las instrucciones avanzadas crean más confusión que claridad.

a) Diferenciación de agentes mediante la comparación jerárquica de modelos mixtos (grupos de recuento en los que al menos una prueba (intersecciones o pendientes diferentes) es inferior a p < 0,05). b) Información mutua total de tripletes con retardo temporal (I3). c) Sinergia emergente dinámica (G3). d) La condición de estímulo de la teoría de la mente (ToM) presenta sustancialmente más grupos con contenido significativo de I3 (superior a 0). En los paneles a) y d), las barras de error muestran los intervalos de confianza de Wilson para datos binarios. Las estrellas indican el nivel de significación de la prueba para proporciones iguales. Los paneles b) y c) muestran los datos brutos con la corrección de Jeffreys. Los datos están Winsorizados en los percentiles 1 y 99 para mayor claridad visual. Las estrellas indican el nivel de significación de la prueba de Wilcoxon. Notas: *** p < 0,001; ** p < 0,01; * p < 0,05.

Implicaciones y caminos hacia adelante

Los hallazgos de este estudio tienen repercusiones significativas que se extienden bastante más allá del laboratorio académico. Para empresas e investigadores desarrollando sistemas multiagente de IA en contextos prácticos, los resultados sugieren un conjunto concreto de principios de diseño que pueden optimizar la coordinación.

Primero, la adición de personas o roles diferenciados a los agentes no es meramente decorativa o lúdica. Genuinamente altera la estructura de cómo los agentes interactúan y coordinan entre sí. El rol que se asigna funciona como un atractor que moldea el comportamiento. Segundo, instruir a los agentes a considerar explícitamente las perspectivas y acciones de otros puede ser tremendamente efectivo, pero solo si los modelos poseen capacidad cognitiva suficiente para hacerlo realmente. Las instrucciones de alto nivel requieren modelos de alto nivel. Tercero, el equilibrio entre diversidad y alineación es crítico: los mejores sistemas tienen miembros especializados trabajando hacia objetivos compartidos, en lugar de idénticos o completamente desorganizados.

Esto encuentra paralelos fascinantes en investigación sobre inteligencia colectiva humana acumulada durante décadas. Estudiosos de la psicología social, gestión organizacional y teoría de grupos han observado consistentemente que los grupos más efectivos tienden a tener miembros diversos que comparten metas comunes explícitamente. La diversidad de perspectiva (la sinergia) necesita ser templada por la alineación sobre qué está siendo buscado (la redundancia). Los hallazgos en IA sugieren que estas podrían ser leyes universales de cómo la coordinación colectiva funciona, que trascienden tanto de sistemas biológicos como puramente tecnológicos.

Existen, naturalmente, limitaciones importantes a este trabajo que merece la pena reconocer honestamente. El experimento emplea una tarea única, aunque ingeniosa en su diseño. No está completamente claro cómo estos hallazgos se generalizarían a otros tipos de problemas donde la especialización de rol podría funcionar de manera diferente, o donde las tareas requieren coordinación temporal compleja. Además, la estimación de las medidas teórico-informacionales empleadas es técnicamente desafiante con conjuntos de datos pequeños. Para mitigar esto, los investigadores realizaron pruebas de robustez extensivas variando métodos, pero siempre existe cierta incertidumbre inherente.

También es importante una aclaración sobre lo que este trabajo no está reclamando. Los investigadores son deliberadamente cuidadosos en evitar atribuir cognición auténtica, conciencia, o intención genuina a estos agentes. La emergencia observada es una propiedad estructural de cómo se relacionan los comportamientos output, no necesariamente una prueba de pensamiento sofisticado o comprensión verdadera.

Es completamente posible tener sistemas simples de refuerzo, o incluso ecuaciones matemáticas no lineales, que generen patrones de emergencia similares. Lo que es notable es que los patrones de coordinación efectiva en máquinas espejo principios bien establecidos de cómo la inteligencia colectiva funciona en grupos humanos reales.

Perspectivas futuras

Este estudio abre numerosas avenidas para investigación futura que podrían transformar cómo construimos sistemas complejos. ¿Cómo se escala esto a sistemas aún más grandes, con decenas o cientos de agentes en lugar de diez? ¿Existen formas de instrucciones más sofisticadas o mecanismos de comunicación que podrían generar coordinación aún más efectiva? ¿Cómo transferirían estos hallazgos a tareas más complejas y orientadas al mundo real, más allá de juegos de adivinanzas elegantes pero abstractos?

Existe también la cuestión más amplia de fiabilidad y despliegue práctico. El documento destaca que grupos con diferentes características de coordinación exhiben diferentes niveles de varianza, estabilidad y adaptabilidad en sus comportamientos. Algunos son más predecibles pero rígidos, otros más adaptables pero menos confiables. Para aplicaciones críticas en medicina, finanzas o defensa, estos detalles sobre robustez y previsibilidad serán absolutamente cruciales.

Desde una perspectiva más profunda y filosofal, este trabajo sugiere que la coordinación colectiva efectiva no es un accidente fortuito sino algo que puede ser diseñado deliberadamente. Tiene reglas. Puede ser estimulado o inhibido mediante modificaciones apropiadas de estructura e instrucción. Esto abre la posibilidad intrigante de que sistemas de múltiples agentes de IA podrían, en teoría, ser orquestados tan deliberadamente como un director orquesta una orquesta sinfónica de cien músicos, donde cada sección tiene un papel diferenciado pero contribuye a la armonía general.

Con el creciente uso de sistemas multiagente de IA en campos que van desde investigación científica hasta programación de software hasta toma de decisiones empresariales y análisis estratégico, comprender cómo diseñar para coordinación colectiva efectiva se vuelve no solo académicamente interesante sino prácticamente urgente y económicamente relevante. Este estudio proporciona herramientas teóricas rigurosas, métodos empíricos concretos y comprobación genuina de que tal diseño es posible y predecible.

La pregunta clásica «¿dos cabezas son mejor que una?» recibe una respuesta sofisticada y matizada: depende. Depende de si esas cabezas tienen identidades distintas. Depende de si pueden reflexionar sobre las perspectivas mutuas. Depende del equilibrio entre especialización compartida y alineación en objetivos comunes. Pero cuando estas condiciones se satisfacen deliberadamente, la evidencia rigurosa sugiere que sí, múltiples máquinas pensantes pueden coordinarse de maneras que genuinamente trascienden la suma de sus partes individuales. Y crucialmente, podemos diseñar intencionalmente esas condiciones.

En el horizonte cercano, mientras que los sistemas de IA continuamente se hacen más sofisticados y ubicuos en sectores diversos, la capacidad de configurarlos para coordinación colectiva efectiva probablemente se convertirá en una habilidad central para científicos informáticos, ingenieros de software y diseñadores de sistemas complejos.

El trabajo de Riedl y colegas proporciona un mapa preliminar pero riguroso para ese territorio en gran medida inexplorado aún. A medida que la tecnología avanza y estos sistemas se despliegan en aplicaciones reales, la sabiduría acumulada sobre cómo construir equipos humanos efectivos podría transformarse en principios técnicos para construir equipos de máquinas efectivos.

La emergencia no es magia, sino estructura. Y la estructura, a diferencia de la magia, puede ser comprendida, enseñada y mejorada sistemáticamente.

Referencias

Riedl, C. (2025). Emergent Coordination in Multi-Agent Language Models. arXiv preprint arXiv:2510.05174v1.

Goldstone, R. L., Andrade-Lotero, E., Hawkins, R. D., y Roberts, R. D. (2024). The emergence of specialized roles within groups. Topics in Cognitive Science, 16(2), 257-281.

Luppi, A. I., Mediano, P. A. M., Rosas, F., Holland, N., Fryer, T. D., O’Brien, J. T., Rowe, J. T., Menon, D. K., Bor, D., y Stamatakis, A. (2022). A synergistic core for human brain evolution and cognition. Nature Neuroscience, 25(6), 771-782.

Rosas, F., Mediano, P. A. M., Jensen, H. T., Seth, A. K., Barrett, A. B., Carhart-Harris, R. L., y Bor, D. (2020). Reconciling emergences: An information-theoretic approach to identify causal emergence in multivariate data. PLoS Computational Biology, 16(12), e1008289.

Mediano, P. A. M., Rosas, F., Luppi, A. I., Jensen, H. T., Seth, A. K., Barrett, A. B., Carhart-Harris, R. L., y Bor, D. (2022). Greater than the parts: A review of the information decomposition approach to causal emergence. Philosophical Transactions of the Royal Society A, 380(2227), 20210246.

Chen, W., Su, Y., Zuo, J., Yang, C., Yuan, C., Qian, C., Chan, C. M., Qin, Y., Lu, Y., Xie, R., et al. (2023). Agentverse: Facilitating multi-agent collaboration and exploring emergent behaviors in agents. arXiv preprint arXiv:2308.10848.

Park, J. S., O’Brien, J. C., Cai, C. J., Morris, M. R., Liang, P., y Bernstein, M. S. (2023). Generative agents: Interactive simulacra of behavior. Proceedings of the 36th Annual ACM Symposium on User Interface Software and Technology, 1-22.

DeChurch, L. A., y Mesmer-Magnus, J. R. (2010). The cognitive underpinnings of effective teamwork: A meta-analysis. Journal of Applied Psychology, 95(1), 32.

Theiner, G. (2018). Groups as distributed cognitive systems. En K. Ludwig y J. Jankovic (Eds.), The Routledge Handbook of Collective Intentionality (pp. 233-248). Routledge.