La rápida integración de la inteligencia artificial (IA) generativa en funciones centrales de Recursos Humanos representa el cambio más significativo en la práctica gerencial desde el advenimiento de la comunicación digital. Si bien promete una eficiencia sin precedentes, esta tendencia introduce riesgos profundos para la confianza organizacional, la seguridad psicológica y la definición misma del liderazgo centrado en el ser humano. Este informe proporciona un análisis exhaustivo de este fenómeno, cuantificando su adopción, deconstruyendo sus mecanismos y trazando sus futuros potenciales.

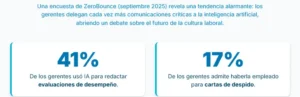

Los hallazgos clave indican que una minoría significativa y creciente de gerentes ahora utiliza IA para tareas sensibles, incluyendo evaluaciones de desempeño (41%) y notificaciones de despido (17%). Esta asistencia tecnológica está evolucionando desde la mera «escritura fantasma» hasta influir en decisiones críticas de RR.HH. sobre ascensos, aumentos y despidos, a menudo sin la supervisión o formación adecuadas. Existe una marcada desconexión entre las percepciones gerenciales de eficiencia y las experiencias de deshumanización de los empleados, lo que conduce a una erosión medible de la moral y la confianza. El panorama regulatorio está evolucionando rápidamente para exigir transparencia y rendición de cuentas, creando nuevos imperativos de cumplimiento para las organizaciones a nivel mundial.

El desafío central para el liderazgo no es aceptar o rechazar esta tecnología, sino gobernarla. Las organizaciones se encuentran en un punto de inflexión crítico donde las políticas y normas culturales que se establezcan hoy determinarán si la IA se convierte en una herramienta para aumentar la excelencia gerencial o en un catalizador para un lugar de trabajo despersonalizado e impulsado por algoritmos.

Cuantificando la infiltración de la IA en las comunicaciones de RR.HH.

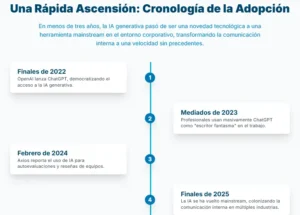

El panorama laboral de finales de 2025 marca un punto de inflexión donde los experimentos aislados con IA generativa se han convertido en un fenómeno generalizado. La trayectoria desde el lanzamiento de ChatGPT por OpenAI a finales de 2022 hasta su adopción masiva ha sido asombrosamente rápida. Acelerada por la consolidación del trabajo remoto y la digitalización de la retroalimentación, la tendencia ha pasado de ser una curiosidad tecnológica a una herramienta de gestión integrada en corporaciones de todo tipo, desde Silicon Valley hasta la banca tradicional.

Los datos cuantitativos más recientes pintan un cuadro claro de esta infiltración. Un sondeo realizado por la firma ZeroBounce en septiembre de 2025 revela la escala y el alcance de la adopción de la IA en las comunicaciones más delicadas de RR.HH. En el centro del fenómeno se encuentra la adopción por parte de los directivos: un 41% de los gerentes encuestados en Estados Unidos reconoce haber utilizado IA para redactar o pulir evaluaciones de personal. Aún más revelador es que el 17% admite haberla empleado incluso para cartas de despido. Estas cifras establecen una línea de base alarmante sobre la prevalencia de la práctica en sus formas más sensibles, confirmando que la automatización ha trascendido las tareas administrativas para entrar en el núcleo de la interacción humana en el trabajo.

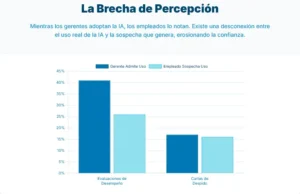

Del otro lado de la ecuación, la percepción y la sospecha de los empleados actúan como un barómetro crítico de la erosión de la confianza. Según el mismo estudio, el 26% de los empleados sospecha que su última evaluación de desempeño fue generada por una máquina. Esta cifra es un indicador clave de un contrato psicológico que se está resquebrajando. La diferencia entre el 41% de los gerentes que admiten el uso y el 26% de los empleados que lo sospechan sugiere la existencia de una «brecha de transparencia» considerable. Esto implica que una parte significativa de esta actividad se está llevando a cabo de forma encubierta o que la calidad del texto algorítmico es lo suficientemente convincente como para no ser detectada por todos. Esta falta de transparencia es más perjudicial para la confianza a largo plazo que un uso abierto y regulado por políticas claras; cuando un empleado finalmente descubre la verdad, el sentimiento de engaño puede ser mucho mayor. Por lo tanto, la tasa de sospecha del 26% debe interpretarse como un indicador temprano de una crisis de confianza mucho mayor que se gesta bajo la superficie.

El impacto de esta tendencia no es meramente conceptual; tiene consecuencias emocionales tangibles. El informe de ZeroBounce encontró que el 19% de los empleados que intuyeron la participación de la IA en comunicaciones sensibles llegaron a llorar tras leer el mensaje. Esta estadística traslada el debate del «qué» (tasas de uso) al «y qué» (impacto humano), vinculando directamente la comunicación algorítmica con resultados psicológicos y emocionales negativos. La frialdad e impersonalidad de un texto generado por una máquina, especialmente en momentos de vulnerabilidad como una evaluación o un despido, puede ser percibida como una falta fundamental de respeto y cuidado.

El sentir de la fuerza laboral sobre el rol apropiado de la IA está profundamente dividido. Un 40% de los trabajadores opina que la IA «nunca» debería asistir en la redacción de comunicaciones delicadas, defendiendo el carácter insustituible del toque humano. Sin embargo, una mayoría del 56% acepta «algo de ayuda de la IA», siempre y cuando un humano personalice y se apropie del mensaje final. Esta división ofrece una visión estratégica crucial: la resistencia no es hacia la tecnología en sí, sino hacia su autonomía sin control. Esto sugiere que el camino para una implementación exitosa no reside en la prohibición total, que podría sacrificar ganancias de eficiencia, ni en la automatización sin restricciones, que generaría una rebelión cultural. La vía más viable parece ser la definición de un proceso claro de colaboración humano-IA, donde la tecnología sirve como asistente y el humano retiene la responsabilidad final y el toque personal.

La tecnología detrás de la gestión automatizada

Para comprender plenamente las implicaciones de esta tendencia, es esencial desmitificar la tecnología que la impulsa. Herramientas como ChatGPT, Bing Chat o asistentes integrados como Microsoft 365 Copilot son Modelos de Lenguaje Grandes (LLM, por sus siglas en inglés) que funcionan como sofisticados sistemas de reconocimiento y predicción de patrones, no como entidades pensantes o sintientes. Su funcionamiento, en un contexto de RR.HH., es un proceso de ingeniería de instrucciones o prompts. Un gerente proporciona una instrucción detallada, como por ejemplo: «Redacta una evaluación de desempeño para un ingeniero de software que cumplió sus metas pero debe mejorar en trabajo en equipo». En cuestión de segundos, la IA genera un borrador de texto prediciendo la secuencia de palabras más probable estadísticamente, basándose en los vastos corpus de datos con los que fue entrenada, que incluyen desde manuales corporativos y artículos académicos hasta publicaciones de LinkedIn.

El resultado de este proceso es a menudo un texto que suena «correcto» y profesional, pero también inherentemente genérico. La razón de esta impersonalidad radica en la naturaleza misma del modelo: al optimizar para el lenguaje más común y probable asociado a un contexto empresarial, gravita naturalmente hacia la jerga corporativa neutra. Este proceso elimina la comunicación de matices personales, anécdotas específicas y el tono emocional genuino que un humano aportaría basándose en su relación y conocimiento del empleado. El gerente puede iterar, pidiendo a la IA que ajuste el tono, la longitud o que incluya ejemplos, pero la base sigue siendo una imitación estadística, no una expresión auténtica.

Esta arquitectura tecnológica conlleva limitaciones y riesgos inherentes que son críticos en el ámbito de la gestión de personas. El más fundamental es el «vacío de empatía». Estos modelos carecen de una comprensión real, de intenciones o de empatía. Pueden ser instruidos para imitar un «tono empático», pero no pueden replicar la compasión auténtica y el juicio situacional necesarios para conversaciones sensibles como un despido o una crítica constructiva.

Otro riesgo operativo crítico es el fenómeno de las «alucinaciones», donde la IA inventa detalles o hechos. En el contexto de una evaluación de desempeño, un modelo podría fabricar un «ejemplo» específico de mal trabajo en equipo que nunca ocurrió. Una inexactitud fáctica de este tipo no solo es injusta, sino que podría tener consecuencias legales catastróficas para la empresa, abriendo la puerta a demandas por difamación o despido improcedente.

Quizás el riesgo más sutil pero penetrante es la tentación de la «gestión de copiar y pegar». La facilidad de uso de la tecnología crea un poderoso incentivo para el comportamiento gerencial negligente. El estudio de ZeroBounce reveló que el 14% de los empleados han enviado mensajes sensibles generados por IA sin editar una sola palabra. Esto pone de manifiesto una profunda ironía: la herramienta diseñada para ahorrar tiempo puede fomentar la pereza intelectual y una abdicación de la responsabilidad gerencial. El diseño mismo de los LLM, que ofrece resultados instantáneos con un esfuerzo mínimo, crea un fuerte impulso conductual que aleja a los gerentes del trabajo difícil y lento del pensamiento crítico y la comunicación reflexiva. Con el tiempo, al igual que un músculo que no se utiliza, la capacidad de un gerente para elaborar una comunicación matizada, empática y estratégica puede atrofiarse, creando una dependencia a largo plazo que hace a la organización más frágil y a su liderazgo menos competente.

Esta tendencia se ve exacerbada por la integración de estos asistentes directamente en las plataformas empresariales. El cambio de usar una herramienta externa como ChatGPT a tener un asistente de IA integrado en el software oficial de RR.HH. (como Workday o SAP) es un desarrollo crucial. Esta integración «invisible» normaliza el uso de la tecnología, haciéndola parecer una parte estándar y sancionada del flujo de trabajo. Cuando un gerente debe abrir una pestaña del navegador para usar ChatGPT, hay un acto consciente de «externalización». Sin embargo, cuando el botón «Generar Evaluación» está dentro de la plataforma oficial de RR.HH., la barrera psicológica se elimina. Esto no solo acelerará la adopción, sino que también hará más difícil para los empleados, e incluso para los auditores, discernir dónde termina la aportación humana y dónde comienza la producción algorítmica, complicando enormemente la rendición de cuentas.

La proliferación de la IA en el ecosistema corporativo

El análisis de la IA en RR.HH. debe extenderse más allá de la redacción de comunicaciones para abarcar su creciente papel en la toma de decisiones estratégicas de personal. Al sintetizar datos de múltiples fuentes, emerge una imagen de una transformación más profunda y sistémica. La IA no solo está escribiendo los mensajes; cada vez más, está influyendo en las decisiones que motivan esos mensajes.

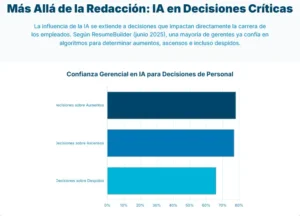

Un estudio de ResumeBuilder de junio de 2025 revela un cambio sísmico en la confianza gerencial: 6 de cada 10 gerentes ya confían en la IA para tomar decisiones sobre sus empleados. Este dato indica que la influencia de la IA ha ascendido en la cadena de valor, pasando de tareas administrativas a la gestión estratégica del talento. El desglose es aún más revelador: el 78% de los gerentes la utiliza para determinar aumentos salariales, el 77% para decidir ascensos y un alarmante 66% para identificar a quién despedir.

Para contextualizar esta rápida penetración en la gestión interna, es útil observar el precedente establecido en la contratación. Un informe de Insight Global de octubre de 2025 encontró que el 92% de los reclutadores ya emplean herramientas de IA en alguna fase del proceso de selección. Este dato sugiere que la alta tasa de adopción en el reclutamiento, una función de «entrada» en RR.HH., allanó el camino cultural para su aceptación en la gestión del talento interno. La normalización del uso de algoritmos para juzgar a candidatos externos parece haber reducido la barrera ética y psicológica para aplicar tecnologías similares a los empleados existentes, a pesar de que las consecuencias para estos últimos (progresión de carrera, sustento) son mucho más altas.

Esta proliferación se ve agravada por una alarmante falta de supervisión y gobernanza. El informe de ResumeBuilder destaca que el 21% de los gerentes permiten que la IA tome decisiones «con frecuencia» sin revisar el resultado. Este es quizás el indicador de riesgo más crítico, ya que señala un movimiento de una gestión «asistida por IA» a una «dirigida por IA», donde el juicio humano es marginado. Este comportamiento de «piloto automático» se ve exacerbado por un vacío de capacitación: dos tercios de los gerentes confiesan no haber recibido formación formal sobre el uso ético de estas herramientas. Las empresas están desplegando una tecnología potente y de alto riesgo sin equipar a sus usuarios con las competencias necesarias para gestionarla de manera responsable, lo que constituye un fallo de gobernanza masivo.

La siguiente tabla consolida las métricas clave de las diversas fuentes, ofreciendo una visión panorámica de la penetración de la IA en la gestión del lugar de trabajo en 2025. Este resumen permite visualizar no solo la profundidad de la adopción en funciones individuales, sino también la amplitud de su aplicación a lo largo de todo el ciclo de vida del empleado.

| Categoría de Métrica | Caso de Uso Específico | Porcentaje | Fuente |

| IA en la Comunicación | Gerentes que usan IA para evaluaciones de desempeño | 41% | ZeroBounce |

| Gerentes que usan IA para cartas de despido | 17% | ZeroBounce | |

| Empleados que sospechan de IA en su evaluación | 26% | ZeroBounce | |

| IA en la Toma de Decisiones | Gerentes que confían en IA para decisiones sobre empleados | 60% | ResumeBuilder |

| Uso de IA para determinar aumentos | 78% | ResumeBuilder | |

| Uso de IA para determinar ascensos | 77% | ResumeBuilder | |

| Uso de IA para determinar despidos | 66% | ResumeBuilder | |

| IA en el Reclutamiento | Reclutadores que usan IA en el proceso de contratación | 92% | Insight Global |

| Comportamientos de Riesgo | Gerentes que dejan que la IA decida sin revisión | 21% | ResumeBuilder |

| Gerentes sin formación formal en ética de IA | ~67% | ResumeBuilder |

El análisis cruzado de estos datos revela la aparición de una «cadena de automatización de decisión-comunicación». Este es un flujo de trabajo lógico pero peligroso: primero, se utiliza la IA para analizar datos y recomendar una decisión (por ejemplo, el 66% que la usa para determinar despidos) y, a continuación, se utiliza una segunda función de IA para redactar la comunicación correspondiente a esa decisión (el 17% que la usa para cartas de despido). Esto crea un proceso automatizado de extremo a extremo donde el juicio humano puede ser minimizado tanto en el punto crítico de la decisión como en el punto sensible de la comunicación. Esta cadena es mucho más peligrosa que cualquiera de los pasos por separado, ya que elimina la responsabilidad humana de todo el proceso, haciendo casi imposible que un empleado pueda apelar o entender la lógica detrás de una decisión que afecta su carrera.

Perspectivas de los stakeholders sobre la automatización de la empatía

Para comprender la dimensión humana de esta transformación tecnológica, es crucial analizar las perspectivas de los diversos actores involucrados: expertos en la industria, los propios gerentes que utilizan las herramientas y los empleados que reciben sus resultados.

Desde el ámbito de la consultoría y la gestión de talento, el consenso de los expertos es un llamado a la cautela. Stacie Haller, asesora principal de carreras en ResumeBuilder, encapsula la preocupación central con la frase: «Es esencial no perder lo ‘humano’ en los recursos humanos». Haller advierte que la IA, si bien puede aportar eficiencia, «carece de contexto, empatía y juicio», cualidades que considera imprescindibles en la gestión de personas. Subraya además que los resultados de la IA son un reflejo directo de los datos con los que fue entrenada, los cuales «pueden ser defectuosos, sesgados o incompletos».

Instituciones como la Sociedad para la Gestión de Recursos Humanos (SHRM) se hacen eco de esta postura, publicando guías que, si bien reconocen el potencial de la IA para optimizar tareas administrativas, insisten en que «la comunicación crítica con los empleados debe mantener un elemento humano». Recomiendan políticas internas claras que incluyan transparencia, revisión humana obligatoria y formación en habilidades de comunicación empática que la tecnología no puede reemplazar.

Desde la perspectiva gerencial, el panorama es más matizado, reflejando un dilema entre la eficiencia y la responsabilidad. Lee Gonzales, director de ingeniería en BetterUp, representa el caso de uso ideal y responsable. Describe el uso de ChatGPT como una «herramienta de pensamiento» para generar un «primer borrador malo» de una evaluación, que luego él revisa y personaliza a fondo. Para él, la ventaja es ahorrar tiempo en la redacción inicial para poder centrarse en el contenido y en la conversación posterior con el empleado. Su advertencia, «Nunca tomes lo que sale de estos modelos como la verdad», es un principio fundamental para un uso ético. Otros gerentes expresan alivio por cómo la IA les ayuda a superar el «terror a la página en blanco», especialmente al tener que dar feedback negativo. En este sentido, la IA actúa como un asistente que puede reducir la ansiedad del gerente y, potencialmente, permitir una comunicación que de otro modo se evitaría.

Sin embargo, esta dualidad en el uso está creando una nueva brecha de habilidades entre los gerentes. Por un lado, están aquellos como Gonzales que utilizan la IA como una palanca para mejorar su propio pensamiento y comunicación (gestores aumentados por IA). Por otro lado, están aquellos que la utilizan como una muleta para reemplazar el pensamiento crítico y la interacción personal (gestores dependientes de la IA). La salud a largo plazo de una organización dependerá de su capacidad para cultivar el primer tipo y reentrenar o gestionar la salida del segundo. Esto tiene implicaciones profundas para los programas de desarrollo de liderazgo, que ahora deben incorporar la alfabetización digital y el uso ético de la IA como competencias centrales.

Finalmente, la experiencia del empleado, en el extremo receptor de esta tecnología, oscila entre la resignación y el sentimiento de traición. Testimonios anónimos en foros laborales revelan un espectro de reacciones: desde trabajadores que «prefieren un texto con filtros corporativos a una reunión incómoda con el jefe», hasta otros que se sintieron «traicionados» al descubrir que ni siquiera su carta de despido mereció la atención personal de un superior. Esta automatización de la comunicación está reescribiendo unilateralmente el contrato psicológico, ese conjunto de expectativas no escritas entre empleado y empleador.

Tradicionalmente, este contrato incluía la expectativa de reconocimiento personal y decencia humana en momentos clave. Cuando un gerente invierte tiempo en escribir una evaluación reflexiva, está enviando la señal de que el empleado importa. Cuando utiliza la IA sin personalizarla, la señal es que la eficiencia importa más que la persona. Este cambio sutil, repetido a través de miles de interacciones, altera fundamentalmente la naturaleza de la relación laboral, transformándola de una de inversión mutua a una de intercambio transaccional e impersonal, lo cual es un conocido precursor de la desvinculación y la rotación de personal.

La creciente preocupación de los sindicatos, que empiezan a considerar la inclusión de cláusulas que limiten el uso de la IA en las evaluaciones, es un indicador adelantado de que este tema se convertirá en un punto central de conflicto en las relaciones laborales del futuro.

Ondas de choque sectoriales: Un análisis diferenciado del impacto de la IA

La adopción y las repercusiones de la IA generativa en las comunicaciones laborales no son uniformes; varían significativamente según las sensibilidades, regulaciones y dinámicas propias de cada sector. Un análisis diferenciado revela un panorama complejo donde los riesgos y oportunidades se manifiestan de manera distinta.

Educación

En escuelas y universidades, el uso de IA para redactar informes de estudiantes o feedback puede ahorrar un tiempo valioso a los docentes sobrecargados de tareas administrativas. Sin embargo, plantea un riesgo fundamental para la relación pedagógica. Un boletín escolar generado por IA puede sonar impersonal, minando la confianza de padres y alumnos, y deshumanizando un proceso que es clave para la motivación del estudiante. El peligro es que un alumno sienta que «ni mi profesor se molestó en escribirme con sus propias palabras», lo que podría afectar negativamente su compromiso y desarrollo.

Salud

En el sector sanitario, donde la empatía es un pilar fundamental, la aplicación de IA en comunicaciones de RR.HH. es extremadamente delicada. Una evaluación de desempeño generada por un algoritmo para un médico o enfermero en un entorno de alto estrés podría dañar gravemente la moral y, por extensión, la seguridad del paciente. No obstante, paradójicamente, un estudio de 2023 encontró que las respuestas de ChatGPT a consultas de pacientes fueron calificadas como más empáticas que las de médicos reales, lo que sugiere que la «empatía» comunicativa es compleja y que la profesión médica tiene áreas de mejora. Aun así, es probable que la adopción en la gestión interna sea lenta y esté fuertemente supervisada, dado el alto coste de un error en este sector.

Empresas (Sector Privado)

En el ámbito corporativo, el conflicto central es entre la ganancia de productividad a corto plazo y la erosión cultural a largo plazo. La automatización de la redacción puede liberar horas de gestión para tareas más estratégicas, pero si se implementa sin cuidado, puede fomentar una cultura de despersonalización que eleve la rotación de personal y disminuya el compromiso. Además, podría impactar en los roles de RR.HH. tradicionales, reduciendo la necesidad de personal dedicado a la comunicación interna y creando nuevos perfiles centrados en la analítica de datos y la ética de la IA.

Política y Sector Público

En el sector gubernamental, el uso de IA para evaluar a funcionarios públicos se enfrenta a desafíos de transparencia, derechos laborales y responsabilidad pública. Cualquier sesgo en el algoritmo podría traducirse en denuncias de discriminación o arbitrariedad, con un escrutinio legal y mediático mucho mayor que en el sector privado. La adopción será previsiblemente cautelosa, pero el tema ya está influyendo en la agenda regulatoria, con legisladores debatiendo leyes para obligar a la transparencia y garantizar vías de apelación humana.

Seguridad

Este sector presenta una dualidad de riesgos. Por un lado, la seguridad de la información es una preocupación mayúscula. Alimentar modelos de IA en la nube de terceros con datos de desempeño de empleados, que son confidenciales, puede violar leyes de privacidad como el GDPR en Europa. Casos como el de Samsung, donde empleados introdujeron código propietario en ChatGPT, sirven como una advertencia sobre el riesgo de filtración de datos sensibles. Esto apunta hacia una nueva categoría consolidada de riesgo corporativo: la «responsabilidad algorítmica», que combina violaciones de la privacidad de datos, demandas por decisiones sesgadas, reclamaciones por daños psicológicos y fugas de propiedad intelectual, todo derivado del uso no gobernado de la IA en la gestión.

Por otro lado, está la seguridad psicológica. Un entorno donde los empleados sienten que están siendo evaluados por un sistema algorítmico opaco erosiona la seguridad psicológica, es decir, la confianza para hablar abiertamente, proponer ideas arriesgadas o admitir errores. La percepción de un «ojo electrónico» que juzga cada métrica es antagónica a una cultura de innovación y confianza.

La velocidad y profundidad de la adopción de IA en RR.HH. probablemente estará gobernada por la «proximidad a la empatía» del sector. Aquellos sectores cuyo «producto» principal es el bienestar y desarrollo humano, como la salud y la educación, serán más lentos y cautelosos. En cambio, sectores como la tecnología o las finanzas, donde el resultado está menos ligado directamente a estados emocionales humanos, avanzarán más rápido. Esto podría crear un futuro con un paisaje fragmentado de culturas laborales, donde el «toque humano» en la gestión se convierte en un lujo concentrado en ciertos sectores, mientras que otros persiguen una hiper-eficiencia algorítmica.

Los dilemas no resueltos: Navegando el campo minado ético y operativo

El rápido ascenso de la IA en la gestión de personal ha traído consigo una serie de controversias éticas y vacíos operativos que las organizaciones apenas comienzan a abordar. Estos dilemas no resueltos representan un campo minado para la cultura corporativa y la estabilidad legal.

Una de las controversias más evidentes es la falta de empatía y calor humano. Los empleados que reciben comunicaciones críticas generadas por una máquina a menudo describen la experiencia como «deshumanizante». El problema no es solo la frialdad del tono, sino el mensaje implícito: que su situación no merecía el tiempo y la atención personal de su superior. Esta desconexión socava la confianza, un pilar fundamental de la relación laboral, y puede dañar la moral, como lo demuestra el hecho de que algunos empleados llegaran a llorar ante correos de despido impersonales.

Otro gran desafío es el sesgo algorítmico y la equidad. Los modelos de IA aprenden de datos históricos, y la historia de muchas organizaciones contiene sesgos sistémicos de género, raza o edad. Si un modelo se entrena con evaluaciones pasadas que, por ejemplo, tienden a describir a las mujeres con adjetivos menos asertivos, la IA podría replicar y amplificar este patrón, perpetuando la discriminación de manera automatizada. Sin auditorías de sesgo rigurosas y transparentes, las empresas corren el riesgo de convertir sus prejuicios históricos en un sistema aparentemente objetivo e incuestionable. La responsabilidad legal por estas decisiones discriminatorias recae en la empresa, no en el algoritmo, pero si la dirección confía ciegamente en la tecnología, la detección de estos sesgos se vuelve casi imposible.

Esto conduce directamente al problema de la responsabilidad y la rendición de cuentas. En una decisión tradicional de RR.HH., hay un ser humano identificable que puede explicar y defender sus motivos. Si la IA es la que sugiere o toma la decisión, ¿quién rinde cuentas? Existe la tentación de que los gerentes se escuden en un «lo hizo el algoritmo» para evitar conversaciones difíciles, creando un vacío de responsabilidad que genera frustración y potenciales litigios. Un empleado no puede apelar una decisión ante una «caja negra».

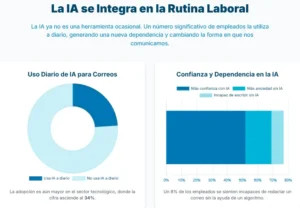

Paralelamente, emerge el riesgo de la erosión de habilidades y la dependencia tecnológica. Así como el uso generalizado de calculadoras mermó la capacidad de cálculo mental, la delegación constante de la redacción y el análisis a la IA puede atrofiar las competencias de comunicación y pensamiento crítico de los gerentes. La práctica de redactar una evaluación obliga a un gerente a reflexionar profundamente sobre el desempeño de un subordinado. Si este proceso se reduce a introducir datos en un sistema, se corre el riesgo de perder un conocimiento profundo del equipo. Ya hay señales de esta dependencia: el estudio de ZeroBounce registró que durante una caída de ChatGPT, el 10% de los empleados optaron por retrasar o no enviar un correo electrónico porque no contaban con la asistencia de la IA, lo que revela una nueva fragilidad operativa.

Muchas empresas también sufren de un vacío normativo interno. La adopción ha sido tan veloz que pocas organizaciones han establecido políticas claras. ¿Está permitido usar IA para evaluaciones? ¿Debe informarse al empleado? Sin directrices, se deja todo a la discreción individual, generando inconsistencia y riesgo.

Finalmente, subyace una controversia filosófica más profunda: ¿hasta qué punto queremos que las decisiones humanas sean mediadas o tomadas por máquinas? La gestión de personas es inherentemente compleja y contextual. Reducirla a una serie de entradas y salidas de datos es ignorar la rica dimensión humana que hace que un lugar de trabajo funcione. El debate no es si la tecnología debe ser una asistente o un reemplazo del criterio humano. La narrativa oficial de las empresas es que la IA es una asistente, pero la línea es delgada y, en la práctica, ya se está cruzando hacia la suplantación parcial, creando un vacío conceptual sobre el rol adecuado de la IA en tareas humanas sensibles.

Escenarios para el futuro de la colaboración gerencial humano-IA

La trayectoria futura de la IA en la gestión de personas es incierta y dependerá de las decisiones regulatorias, corporativas y sociales que se tomen en el presente. Es posible delinear escenarios a corto, mediano y largo plazo para explorar las posibles evoluciones de esta tendencia.

Corto plazo (1–2 años)

En el horizonte inmediato, se espera que el uso de la IA en RR.HH. continúe su crecimiento exponencial, pero también que encuentre sus primeros límites significativos. Más plataformas de RR.HH. integrarán asistentes de escritura, normalizando su uso. Sin embargo, este período también será testigo de los primeros conflictos de alto perfil. Es probable que ocurran escándalos corporativos, como un despido masivo comunicado con un texto de IA insensible que se viralice, generando una reacción pública negativa y obligando a las empresas a prometer «más intervención humana». En respuesta, las organizaciones pioneras comenzarán a desarrollar mejores prácticas, combinando el uso de IA con formación en empatía para sus líderes y estableciendo políticas internas claras sobre su aplicación.

Mediano plazo (3–5 años)

Para aproximadamente 2030, el panorama podría bifurcarse. En un escenario, la IA se institucionaliza plenamente. Las evaluaciones de desempeño se vuelven continuas y semi-automatizadas, con sistemas que generan informes en tiempo real. El rol del gerente evoluciona hacia el de un «curador» de los insights de la IA y un coach humano. En un escenario alternativo, podría surgir un retroceso consciente o una «re-humanización». Tras experimentar los efectos negativos de la automatización excesiva sobre la moral y la productividad, algunas organizaciones podrían volver a enfatizar las interacciones cara a cara y el juicio humano, utilizando el «toque personal» como un diferenciador competitivo para atraer talento. Tecnológicamente, las IA serán más sofisticadas, quizás capaces de modular el tono con mayor sensibilidad, haciendo más difícil distinguir entre un texto humano y uno algorítmico y planteando nuevos dilemas éticos.

Largo plazo (10 años o más)

Mirando hacia 2035 y más allá, los escenarios se vuelven más especulativos pero cruciales. Un escenario extremo es la «muerte del RR.HH. tradicional». La función se transforma radicalmente, con equipos de científicos de datos y especialistas en ética supervisando sistemas de IA que gestionan el reclutamiento, la formación, la evaluación e incluso la mediación de conflictos. Las jerarquías organizacionales podrían aplanarse, con menos mandos intermedios, ya que la IA permitiría a un directivo supervisar a un número mucho mayor de personas. Esto redefiniría el concepto de gestión, exigiendo a los líderes humanos aportar un valor puramente estratégico, creativo e inspirador que la IA no pueda replicar.

Un escenario contrario a largo plazo es una revalorización fundamental de lo humano. La historia muestra ciclos pendulares, y es posible que después de una década de experimentación con la automatización, surja una fuerte corriente de «humanismo digital». Las empresas más exitosas serían aquellas que mantuvieron el factor humano como su principal activo, demostrando que la confianza interpersonal y la cultura colaborativa son insustituibles para la innovación y el compromiso a largo plazo. En este futuro, la IA estaría relegada a un rol de apoyo logístico, no de gestión.

La trayectoria real probablemente se situará en un punto intermedio entre estos extremos utópicos y distópicos. Las políticas que se establezcan en la década de 2020, la respuesta de los trabajadores y los marcos regulatorios que se implementen serán los factores decisivos que determinarán si la IA será recordada como la herramienta que potenció el talento humano o como el principio del fin de la humanidad en los recursos humanos.

Un análisis de la respuesta regulatoria y de gobernanza global

El vertiginoso avance de la IA en la gestión de personas ha dejado a la regulación corriendo por detrás, pero los gobiernos y organismos normativos están comenzando a cerrar la brecha. Están surgiendo marcos legales y éticos diseñados para encauzar estas prácticas y proteger los derechos de los trabajadores.

En Estados Unidos, varias jurisdicciones han tomado la iniciativa. La ciudad de Nueva York implementó en 2023 la Ley Local 144, la primera en su tipo, que obliga a las empresas a realizar auditorías independientes de sesgo en las herramientas automatizadas de contratación. Aunque se centra en el reclutamiento, sienta un precedente crucial para cualquier sistema algorítmico utilizado en decisiones de personal. Siguiendo este ejemplo, California aprobó en 2025 un paquete de medidas que exige a las empresas notificar a los empleados cuando una decisión de ascenso, disciplina o despido involucra un sistema automatizado y proporcionar vías de apelación humana. A nivel federal, aunque no existe una ley integral, agencias como la EEOC (Comisión para la Igualdad de Oportunidades en el Empleo) han dejado claro que el uso de IA no exime a las empresas del cumplimiento de las leyes antidiscriminación.

En Europa, el debate se enmarca dentro del Reglamento de IA de la Unión Europea (AI Act), que se espera entre en vigor hacia 2026. Este reglamento clasificará el uso de la IA en recursos humanos como una aplicación de «alto riesgo». Esto obligará a los proveedores y a las empresas usuarias a cumplir con requisitos estrictos de transparencia, explicabilidad, seguridad y supervisión humana significativa. Las multas por incumplimiento podrían ser severas, similares a las del GDPR, estableciendo un estándar global de facto para las multinacionales.

En otras regiones como América Latina, la regulación es aún incipiente, pero los países observan de cerca los desarrollos en EE. UU. y Europa. Mientras tanto, la protección de los trabajadores proviene de leyes generales de privacidad y laborales que podrían ser invocadas en casos de abuso.

Más allá de la legislación, están surgiendo estándares éticos voluntarios. Consorcios internacionales trabajan en normas ISO para la gestión de RR.HH. impulsada por IA, y las grandes empresas tecnológicas han publicado sus propios principios de IA responsable. A nivel organizacional, la respuesta más común es la creación de comités de ética de IA y la adopción de políticas de «human in the loop» (humano en el ciclo), que estipulan que un ser humano siempre debe tener la capacidad de vetar o modificar una decisión algorítmica importante. La política de «lo que la IA escriba, un humano lo firma» se está convirtiendo en una práctica recomendada para asegurar que la responsabilidad final recaiga inequívocamente en una persona.

El frente judicial también jugará un papel clave. Los tribunales pronto tendrán que pronunciarse sobre casos en los que los empleados demanden a sus empresas por decisiones automatizadas que consideren injustas o discriminatorias. Estos precedentes legales terminarán de moldear las prácticas aceptables y definirán los límites de la delegación de decisiones de personal a los algoritmos. En síntesis, estamos en una fase de puesta al día regulatoria, donde el consenso ético emergente se centra en la transparencia, la no discriminación, el consentimiento informado y el control humano.

Perspectiva a futuro

La incursión de la inteligencia artificial en las evaluaciones, comunicaciones y decisiones de Recursos Humanos nos obliga a una reflexión fundamental sobre el tipo de relaciones laborales que deseamos construir en la era digital. El análisis de este fenómeno revela un panorama dual: por un lado, la promesa de ganancias en eficiencia y una supuesta objetividad; por otro, el riesgo tangible de pérdidas en humanidad, confianza y conexión. La IA puede ser programada para usar las palabras correctas, pero es incapaz de sentirlas. Esta desconexión, si se profundiza, tiene el potencial de erosionar la cultura organizacional, ese tejido invisible compuesto de credibilidad, respeto y motivación compartida.

La pregunta de si estamos ante la muerte del RR.HH. tradicional es quizás incorrecta. Sería más preciso hablar de una evolución forzada. Así como la oficina no desapareció con la llegada del correo electrónico sino que se transformó, la función de gestión humana deberá reinventarse, integrando la tecnología sin abdicar de su esencia. Lo «tradicional» que sí debería desaparecer es la burocracia inerte y el papeleo sin sentido. Si la IA puede liberar a los líderes de estas cargas para que dediquen más tiempo a guiar, mentorizar y conectar con sus equipos, su adopción será un avance inequívoco. Sin embargo, lo que no debe ni puede desaparecer es el factor humano: la conversación genuina, la empatía en momentos difíciles y la capacidad de inspirar.

De cara al futuro inmediato, es imperativo mantener una mirada crítica. No se debe ni demonizar la IA como un enemigo de los trabajadores, ni idealizarla como una solución mágica a los complejos problemas de la gestión. Los próximos años funcionarán como un vasto experimento social en tiempo real. Será crucial vigilar de cerca indicadores como la satisfacción laboral, la salud mental en el trabajo y la productividad sostenible para evaluar el verdadero impacto de esta automatización de las interacciones humanas.

En última instancia, el verdadero riesgo no es que la IA nos reemplace en la tarea de escribir correos electrónicos, sino que nos haga olvidar por qué los escribíamos en primer lugar: para comunicarnos de persona a persona. Si las organizaciones y sus líderes recuerdan este principio fundamental y utilizan estas poderosas herramientas como un apoyo para amplificar lo mejor de las capacidades humanas —creatividad, juicio y empatía—, el futuro del trabajo puede ser más eficiente y, a la vez, más humano. Si, por el contrario, se sucumbe a la comodidad de la delegación total, el resultado serán empresas eficientes pero alienantes, donde las personas cumplen funciones pero han perdido el sentido de pertenencia y propósito.

El diálogo entre la tecnología y la humanidad apenas comienza en el terreno de los recursos humanos. Nos corresponde a todos (líderes, empleados, reguladores y tecnólogos) asegurar que, al final del día, la «I» de la inteligencia artificial nunca opaque a la «H» de lo humano.

Fuentes:

TechRadar (Efosa Udinmwen). “Huge numbers of managers admit to using AI to convincingly draft or revise performance reviews – and I fear it will only accelerate the death of traditional HR.” Publicado el 5 de octubre de 2025. Disponible en: https://www.techradar.com/ai-platforms-assistants/huge-numbers-of-managers-admit-to-using-ai-to-convincingly-draft-or-revise-performance-reviews-and-i-fear-it-will-only-accelerate-the-death-of-traditional-hr

ZeroBounce. “When AI Sends the Layoff Email: Is AI Killing Compassion at Work?” (Informe blog con resultados de encuesta sobre uso de IA en comunicaciones laborales, 750 empleados y 250 gerentes en EE. UU.). ZeroBounce Blog – Newsroom, septiembre 2025. Disponible en: https://www.zerobounce.net/blog/newsroom/the-latest/ai-workplace-emails

ResumeBuilder (Sarah Saunders). “Half of Managers Use AI To Determine Who Gets Promoted and Fired.” Informe de encuesta a 1.342 gerentes en EE. UU. Última actualización: 30 de junio de 2025. Disponible en: https://www.resumebuilder.com/half-of-managers-use-ai-to-determine-who-gets-promoted-and-fired/

Fast Company (Gwen Moran). “Your AI hiring tool may be rejecting qualified candidates.” (Cita datos del reporte “2025 AI in Hiring” de Insight Global: 92% de gerentes de contratación usan IA en screening). Publicado el 6 de octubre de 2025. En: https://www.fastcompany.com/91345408/your-ai-hiring-tool-may-be-rejecting-qualified-candidates

Axios (Megan Morrone). “Managers, employees turn to ChatGPT to write performance reviews.” Axios Tecnología. Publicado el 12 de febrero de 2024. Disponible en: https://www.axios.com/2024/02/12/chatgpt-human-resources-performance-reviews

Going Concern – News Desk. “ChatGPT Is Doing Performance Reviews and Deciding Layoffs Now.” Resumen del estudio ResumeBuilder con comentarios. Publicado el 8 de julio de 2025. Disponible en: https://www.goingconcern.com/chatgpt-is-doing-performance-reviews-and-deciding-layoffs-now/

Morgan Lewis (Bufete). “New York City Issues Final Rule on AI Bias Law and Postpones Enforcement to July 2023.” LawFlash, 19 de abril de 2023. (Sobre la ley de auditoría algorítmica en NYC). Disponible en: https://www.morganlewis.com/pubs/2023/04/new-york-city-issues-final-rule-on-ai-bias-law-and-postpones-enforcement-to-july-2023

Hackler Flynn & Associates. “New AI Employment Laws: What California Employers Need to Know in 2025.” Blog legal laboral, publicado en 2025. (Resumen de legislación propuesta/aprobada en California – SB 7 “No Robo Bosses Act” y regulaciones del CRD al 1/10/25). Disponible en: https://hacklerflynnlaw.com/california-ai-employment-laws-2025-employer-guide/