La inteligencia artificial generativa ya convive con nosotros en tareas diarias que van desde redactar un correo hasta asistir una pesquisa periodística o preparar un informe técnico. Su promesa es simple y potente: responder con precisión, rapidez y claridad. Sin embargo, arrastra un defecto serio que no podemos disimular con marketing ni con metáforas edulcoradas: a veces inventa. Cuando un modelo completa huecos con datos plausibles pero falsos, hablamos de alucinación. El síntoma no es nuevo, pero su escala sí importa. Mientras más confiamos en estas herramientas, más duele cuando se equivocan con convicción.

La veracidad no es solo acertar cuando el dato está en la memoria del sistema. Implica también saber cuándo callar o reconocer incertidumbre. Aquí aparece la tensión clásica que TruthRL coloca en el centro: si solo maximizamos exactitud, el modelo se vuelve temerario y alucina más; si lo empujamos a abstenerse, corre el riesgo de convertirse en un actor excesivamente prudente que deja sin contestar preguntas que sí podría resolver. El mérito de TruthRL es encarar este dilema como un problema de objetivos mal definidos y, sobre todo, de incentivos mal puestos.

El paper que motiva este artículo propone un marco de aprendizaje por refuerzo con una recompensa ternaria. La estructura es sencilla y, justamente por eso, efectiva: premiar lo correcto, castigar lo falso y mantener neutral el acto de abstenerse. Esa señal, aplicada con consistencia mediante un algoritmo de refuerzo moderno, enseña al modelo una conducta que recuerda a la prudencia de un buen profesional: responder cuando hay fundamento suficiente y decir no lo sé cuando no lo hay. En evaluaciones de preguntas intensivas en conocimiento, los autores reportan una disminución marcada de alucinaciones y un aumento de la veracidad global sin hundir la tasa de aciertos. Dicho sin vueltas: menos inventos, más honestidad, y con productividad sostenida.

A partir de aquí, desarrollaremos el contexto del problema, desgranaremos la propuesta técnica con un lenguaje accesible, la compararemos con enfoques previos como el ajuste supervisado y el RL orientado a precisión, la pondremos en diálogo con prácticas de recuperación de información y con técnicas recientes que buscan calibrar la confianza, y cerraremos con una reflexión sobre sus implicancias sociales. Habrá ejemplos, una mirada histórica y dos cuadros para fijar ideas. Todo directo, sin humo, con foco en lo que de verdad cambia el juego.

Dónde se originan las alucinaciones

Los grandes modelos de lenguaje predicen la siguiente palabra a partir de patrones estadísticos aprendidos en corpus gigantescos. No acceden de forma nativa al mundo, sino a representaciones textuales del mundo. Cuando la pregunta cae fuera de lo que el modelo absorbió o cuando la formulación induce ambigüedad, emerge el riesgo de que priorice lo verosímil por encima de lo verdadero. Ese sesgo hacia lo plausible, en ausencia de chequeo externo o de una noción robusta de incertidumbre, impulsa salidas espectaculares pero erróneas.

A nivel de entrenamiento, hay otra fuente de problemas. El ajuste supervisado tradicional favorece respuestas que imitan ejemplos de referencia. Si el conjunto de datos de ajuste penaliza fuertemente las abstenciones o premia respuestas extensas y seguras, el modelo aprende una política de sobreconfianza. En términos prácticos, reduce la probabilidad de contestar “no lo sé”, inclusive cuando debería. La ingeniería de instrucciones y técnicas como cadenas de pensamiento pueden mejorar el razonamiento paso a paso, pero no garantizan por sí mismas que el sistema reconozca la frontera de su conocimiento.

La industria lleva años probando enfoques para domar este comportamiento. La incorporación de recuperación externa de información ayuda cuando hay fuentes confiables disponibles, y las heurísticas de temperatura o de decodificación pueden reducir desvíos. Aun así, persiste una brecha: acertar más no equivale automáticamente a ser más veraz. La veracidad requiere, además, capacidad de abstención calibrada y resistencia a preguntas cebadas para forzar alucinaciones. El diagnóstico de TruthRL coloca el énfasis en esa arquitectura de incentivos y no tanto en crecer el modelo o aumentar los datos, una decisión que resuena con discusiones contemporáneas sobre alineación factual y honestidad.

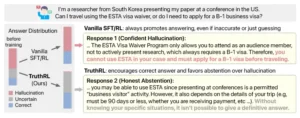

Comparación entre el ajuste fino supervisado (SFT) tradicional, el aprendizaje por refuerzo (RL) y TruthRL. En el SFT/RL tradicional, el modelo está optimizado únicamente para la precisión, recompensando implícitamente las alucinaciones en lugar de las abstenciones y, por lo tanto, siempre intentando responder o adivinar, lo que finalmente compromete la veracidad. En cambio, TruthRL no solo recompensa las respuestas correctas, sino que penaliza explícitamente las alucinaciones y trata las abstenciones de forma neutral, lo que conduce a una mayor veracidad.

Qué propone TruthRL en términos simples

TruthRL es un marco de aprendizaje por refuerzo orientado a optimizar la veracidad como objetivo explícito. En su implementación de referencia, los autores utilizan GRPO como motor de refuerzo y definen una función de recompensa con tres valores: positiva para respuestas correctas, negativa para alucinaciones, y neutra para abstenciones. No hay florituras: el núcleo es que el modelo, durante el entrenamiento, puede optar por no responder, y ese acto no es castigado ni premiado. El castigo se reserva para lo falso; el premio, para lo correcto.

La lógica conductual detrás de esta señal se parece a un concurso con regla transparente. Si los desaciertos restan y la abstención no modifica el puntaje, la mejor estrategia es responder cuando la probabilidad de acierto supera cierto umbral y abstenerse cuando la duda es razonable. Eso mismo aprende el modelo. Como resultado, cae la propensión a inventar para salir del paso y aumenta la honestidad de la salida final.

Los autores someten esta idea a pruebas en cuatro benchmarks intensivos en conocimiento y reportan dos indicadores clave: reducción de alucinaciones respecto de un RL vainilla y mejora de una métrica integrada de veracidad. También exploran variantes de recompensa con más complejidad, como incorporar conocimientos externos o fomentar razonamientos intermedios, y encuentran que la versión simple suele comportarse mejor. El mensaje es contracultural, pero contundente: un objetivo bien diseñado supera a adornos metodológicos que suman ruido.

Cuadro 1. Esquema de reforzamiento orientado a veracidad

| Tipo de salida del modelo | Recompensa | Efecto de aprendizaje esperado | Comportamiento resultante |

|---|---|---|---|

| Respuesta correcta | +1 | Refuerza la conducta de contestar cuando hay evidencia | Mayor tasa de aciertos sin sobreajuste a longitud o tono |

| Respuesta falsa o inventada | −1 | Penaliza la invención y la sobreconfianza | Disminuye la alucinación y la temeridad |

| Abstención justificada | 0 | Normaliza reconocer incertidumbre | Aumenta el “no lo sé” cuando corresponde |

Qué significa “verdad” para un LLM entrenado con TruthRL

Una pregunta sensible: ¿estamos enseñando a los modelos a ser más tímidos o verdaderamente más honestos? El paper defiende que la mejora no surge de volverlos silenciosos, sino de calibrar mejor su umbral de confianza. La señal ternaria no incentiva el silencio indiscriminado; diferencia con nitidez entre acertar y abstenerse. El sistema aprende a estimar su propia frontera de conocimiento. Concretamente, se observa resistencia frente a preguntas cebadas que buscan gatillar un tropiezo y, a la vez, seguridad cuando posee evidencia para responder. En términos de métricas, el trabajo reporta que, frente a un RL estándar, TruthRL reduce alucinaciones en torno a un tercio e incrementa la veracidad agregada en un quinto, con consistencia en distintos modelos base y con o sin recuperación externa. Es una mejora práctica con una lectura conceptual: un objetivo bien planteado produce un comportamiento más confiable.

El RLHF clásico premia respuestas preferidas por evaluadores humanos, con un sesgo natural hacia la utilidad y la fluidez. Ese sesgo no es un defecto en sí mismo, pero puede pasar por alto la distinción entre plausibilidad y verdad. La recompensa humana, si no está cuidadosamente diseñada para valorar la abstención, puede reforzar la respuesta confidente aunque sea dudosa. Lo mismo ocurre con RL binario centrado en exactitud: castigar error y premiar acierto sin la tercera vía tiende a empujar al modelo a arriesgar.

El aporte de TruthRL es insertar, explícitamente, un incentivo a reconocer límites. No pretende reemplazar el RLHF en todas sus dimensiones, pero sí completar la caja de herramientas cuando el objetivo es la veracidad factual. En escenarios de conocimiento dinámico o de riesgo reputacional, la salud del sistema depende de esta capacidad de decir no tengo base para afirmarlo. En ese sentido, TruthRL funciona como un corrector de rumbo: no busca la respuesta vistosa, sino la respuesta respaldada o la abstención sensata.

TruthRL muestra ventajas claras en dominios de preguntas factuales, sobre todo cuando el conocimiento paramétrico del modelo es insuficiente o está desactualizado. En combinación con recuperación externa, la señal de refuerzo puede orientar a pedir ayuda documental en lugar de improvisar. Cuando no hay fuentes externas confiables o el tema es ambiguo, la abstención calibrada es un beneficio y no un obstáculo.

En tareas donde la creatividad pura es central, reglas que penalizan fuertemente la invención pueden ser contraproducentes si se aplican sin matices. La clave está en separar contextos: no es lo mismo escribir un cuento que responder sobre regulaciones de salud. El diseño de producto debe habilitar políticas diferentes por modo de uso. El artículo técnico muestra que el método es robusto a preguntas cebadas y que, en promedio, no deprime la productividad. Aun así, cada caso de uso requiere su balance fino, y conviene recordar que la veracidad implica más que exactitud: incluye evitar daño por información errónea y proteger al usuario de confusiones que una redacción impecable puede camuflar.

Cómo se ve internamente un paso de TruthRL

Reducido a su esqueleto, el ciclo de entrenamiento funciona así: el modelo genera una respuesta o decide abstenerse; un evaluador determina si la respuesta es correcta, falsa o abstención; se asigna la recompensa ternaria correspondiente; el algoritmo de refuerzo ajusta los parámetros para aumentar la probabilidad de conductas premiadas y reducir la de conductas penalizadas. La pieza crucial es que “no responder” está disponible como acción. Ese detalle pragmático cambia la política aprendida porque habilita una salida no punitiva cuando la confianza no alcanza el umbral esperado.

En la implementación discutida en el paper, los autores eligen GRPO, que moderniza la tradición de políticas proximales con técnicas de estabilidad y eficiencia. Para el lector no técnico, lo sustantivo es que el motor de refuerzo es estándar y replicable, y que el secreto no está en artificios oscuros, sino en una recompensa alineada con el objetivo. También es relevante que las pruebas incluyeron distintos modelos base, incluyendo familias como Llama y Qwen, y que se midió el impacto tanto con como sin recuperación, lo que refuerza que el beneficio no depende de un único stack.

Cuadro 2. Veracidad con y sin TruthRL en términos prácticos

| Situación | Política aprendida sin abstención | Riesgo típico | Política aprendida con abstención | Resultado frecuente |

|---|---|---|---|---|

| Pregunta fuera del conocimiento | Responder igual para no “perder” | Alucinación verosímil | Preferir abstenerse | Evitar difusión de falsedades |

| Pregunta ambigua pero documentable | Responder con conjeturas | Confusión por datos imprecisos | Consultar fuente o abstenerse | Respuesta informada o espera prudente |

| Pregunta cebada para error | Caer en la trampa por sobreconfianza | Desinformación | Detectar incoherencia y abstenerse | Robustez ante provocaciones |

Ejemplos cotidianos que lo explican en un minuto

Un asistente para trámites migratorios recibe una consulta específica sobre un tipo de visado en un año en el que la política cambió. El modelo sin abstención con recompensa binaria puede completar con una regla vieja que “suena” correcta. El modelo con TruthRL, ante indicios de cambio normativo que no domina, opta por abstenerse o por solicitar verificación externa. Resultado: menos errores costosos.

Algo similar ocurre en salud. Dos modelos leen una pregunta sobre una interacción de fármacos rara. Uno, sin política de abstención, busca un atajo textual y entrega un consejo azaroso. El otro, entrenado con recompensa ternaria, se detiene y responde que no tiene base suficiente. No “cura” por arte de magia, pero evita recomendar algo que podría hacer daño. En términos de responsabilidad, es un salto cualitativo.

La investigación en veracidad para LLMs se ha movido en varias líneas convergentes. Primero, enriquecer el acceso a conocimiento mediante recuperación documental, que reduce la necesidad de improvisar. Segundo, ajustar decodificadores y temperaturas para moderar riesgos sin bloquear la fluidez. Tercero, calibrar la confianza y fomentar la negación razonada frente a lo desconocido. Cuarto, explorar recompensas más informadas que prioricen no solo la utilidad o la elegancia, sino la honestidad factual. TruthRL hereda de todas esas vetas, las ordena y les da un norte claro: optimicemos la veracidad como objetivo primario y tratemos la abstención como una primera clase de acción.

El timing del artículo no es casual. A medida que grandes actores publican trabajos sobre entrenamiento con refuerzo para postajuste, crece el consenso de que la etapa que sigue a la preentrenamiento y al ajuste supervisado es donde se fija la “personalidad” útil del modelo. Qué recompensas usamos en ese tramo define, en buena medida, su comportamiento en producción. De ese diseño dependen la prudencia o la temeridad, la densidad informativa o la palabrería ornamental, la honestidad o el espejismo.

Las gráficas y los porcentajes entusiasman, pero el resultado que importa se mide en la calle: ¿el usuario confía más en lo que dice el sistema? La confianza no es un intangible. Se construye cuando un asistente reconoce límites, pide ayuda documental cuando hace falta y no disimula lagunas con relleno literario. TruthRL pega donde tiene que pegar: en desalentar el impulso de contestar a toda costa. Esa decisión de diseño baja la tasa de errores graves y, al mismo tiempo, evita un silencio paralizante.

Para medios, educación, salud, banca o administración pública, esa combinación es crítica. Nadie quiere un sistema que responda siempre “no sé”. Tampoco uno que invente con estilo. El punto medio es veracidad operativa: contestar bien cuando corresponde y abstenerse cuando no. Si se extiende esta práctica, podremos dejar de “vigilar” cada salida del modelo y empezar a delegar con razonable seguridad tareas bien encuadradas.

Implementar TruthRL en un pipeline moderno no exige reescribir todo. Es un módulo de postajuste que puede convivir con otras técnicas. Una ruta razonable luce así: preentrenamiento, ajuste supervisado en instrucciones, refuerzo orientado a utilidad, y una capa final de refuerzo orientado a veracidad con recompensa ternaria. Para productos donde la recuperación externa es estándar, el sistema puede usar abstención como disparador para buscar documentación antes de volver a intentar. Para contextos desconectados, la abstención explícita puede materializarse en mensajes tipo no tengo información suficiente sobre X y ofrecer al usuario pasos para aportar evidencia.

Desde el punto de vista de gobierno del sistema, TruthRL sugiere políticas de auditoría más concretas. Por ejemplo, monitorear el ratio de abstenciones justificadas frente a abstenciones por comodidad, o chequear si la reducción de alucinaciones se sostiene tras actualizaciones del corpus o del motor. También puede combinarse con controles de seguridad que bloqueen respuestas en áreas de riesgo cuando el motor detecta incertidumbre alta.

Comparación argumentada con alternativas cercanas

Hay métodos que entrenan al modelo para rehusar preguntas desconocidas, enfoques que usan señales de incertidumbre para modular la salida y alineamientos explícitos para honestidad. ¿Qué añade este marco? Una receta simple, cuantificable y generalizable. Simple, porque la recompensa ternaria evita el laberinto de criterios difusos. Cuantificable, porque el efecto se mide en dos indicadores operativos: alucinación y veracidad agregada. Generalizable, porque los autores la validan en varias familias de modelos y condiciones de recuperación heterogéneas.

Esto no invalida caminos complementarios. La recuperación externa sigue siendo indispensable cuando el dato cambia rápido. La calibración de confianza aporta umbrales más finos. La evaluación humana sigue siendo un estándar de oro para casos ambiguos. TruthRL, bien entendido, es la argamasa que fija los ladrillos: hace que el modelo prefiera un buen silencio antes que una mala ocurrencia y que, cuando hable, lo haga con sustento.

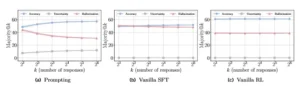

Curva de escalado de los métodos de incitación y SFT/RL estándar en el punto de referencia CRAG (Yang et al., 2024a), utilizando Llama3.1-8B-Instruct como eje central. Antes del entrenamiento, el modelo muestra un gran potencial en el escalado de la mayoría@k, con una reducción de las alucinaciones y una mayor precisión y abstenciones a medida que aumenta el número de respuestas. Sin embargo, a pesar de su precisión ligeramente mejorada, los métodos SFT y RL estándar disminuyen este potencial y conducen a alucinaciones mucho mayores, lo que subraya sus limitaciones y la necesidad de un paradigma de entrenamiento más veraz.

Limitaciones y preguntas abiertas

Ningún enfoque opera en el vacío. TruthRL asume que contamos con un mecanismo fiable para distinguir correcto de incorrecto en el entrenamiento, y con un criterio razonable para etiquetar abstenciones. Ese etiquetado puede ser caro o complejo en dominios muy técnicos. Además, la recompensa ternaria, aunque efectiva, no resuelve por sí sola ambigüedades genuinas donde dos respuestas matizadas pueden ser parcialmente válidas. Como todo refuerzo, la política aprendida depende de la calidad y diversidad de los escenarios presentados durante el entrenamiento.

Otro frente abierto es el balance entre cobertura y veracidad cuando la pregunta exige integración de múltiples pasos. La investigación reporta robustez ante preguntas cebadas, pero el ecosistema de trampas evoluciona. Habrá intentos de diseñar prompts que fuerzasen abstenciones innecesarias o, a la inversa, que “maquillen” incertidumbre. El diseño de producto deberá considerar señales adicionales y telemetrías que vigilen desviaciones.

Aun así, el avance conceptual es sólido. En vez de tratar la veracidad como un byproduct de la exactitud, TruthRL la eleva a objetivo explícito e introduce la abstención como acción de primera clase. Esa combinación, sencilla pero crucial, alinea el comportamiento del sistema con la expectativa social mínima: si no sabés, no inventes.

Para redacciones y equipos de verificación, un asistente que reduce alucinaciones y admite incertidumbre equilibra velocidad con rigor. En educación, ayuda a formar hábitos sanos de consulta al modelar conductas de humildad epistémica. En ámbitos regulados, como finanzas o salud, previene daños al cortar la cadena de errores en su eslabón más temprano. Y para usuarios comunes, disminuye la fatiga de chequear todo lo que una IA dice, una tarea que, paradójicamente, anulaba el ahorro de tiempo que prometía.

La honestidad no es un lujo. Es la base para que la IA gane licencia social. Sin veracidad, la tecnología se vuelve un show de talento inútil. Con veracidad incentivada, podemos empezar a integrarla de manera responsable en flujos críticos. Ese es el aporte pragmático del artículo técnico que analizamos.

Un vistazo operativo para equipos de producto

Cualquier equipo que se proponga adoptar un enfoque de este tipo debería considerar tres pasos operativos:

• Definir con precisión el dominio donde la abstención es preferible a una respuesta creativa y establecer umbrales de confianza que disparen esa acción.

• Construir conjuntos de evaluación que incluyan preguntas cebadas, lagunas deliberadas y escenarios con ambigüedad real, para medir veracidad de forma holística y no solo mediante exactitud.

Este par de acciones, además de las métricas clásicas, sostienen la validación de que el sistema no solo acierta más, sino que alucina menos y aprende a callar con criterio.

Una ética del dato correcta, hecha algoritmo

TruthRL no es una varita mágica que impida todo error. Es, más bien, una decisión de diseño que pone los incentivos del lado correcto. Enseña a los modelos un principio obvio que la presión por responder a todo había olvidado: la ignorancia reconocida es mejor que la mentira elegante. Cuando se vuelve objetivo de entrenamiento, esa ética mínima se traduce en comportamiento medible. Caen las alucinaciones, sube la veracidad, la confianza crece.

Por qué importa esto va más allá de un benchmark. La convivencia con sistemas generativos nos obliga a renegociar expectativas. No queremos oráculos infalibles. Queremos colaboradores que digan lo que saben con fundamentos, que pidan ayuda cuando hace falta y que no inventen para llenar el silencio. Convertir esa aspiración en una política de aprendizaje por refuerzo es un paso sensato. Si la industria lo adopta a escala, la IA que usamos a diario será menos teatrera y más útil. Una buena noticia para cualquiera que valore, antes que la retórica, los datos correctos.

Referencias

Wei, Z., Yang, X., Sun, K., Wang, J., Shao, R., Chen, S., Kachuee, M., Gollapudi, T., Liao, T., Scheffer, N., Wanga, R., Kumar, A., Meng, Y., Yih, W., & Dong, X. L. (2025). TruthRL: Incentivizing truthful LLMs via reinforcement learning. arXiv, 2509.25760.

Hugging Face Papers. (2025). TruthRL: Incentivizing truthful LLMs via reinforcement learning. Resumen y metadatos del artículo. (Hugging Face)

Rajan, K. (2025). Teaching AI to say “I don’t know”: A deep dive into TruthRL. Towards AI. Análisis de divulgación y discusión pública del enfoque. (Towards AI)