Un innovador laboratorio de inteligencia artificial con sede en Tokio ha presentado una metodología revolucionaria que utiliza los principios de la selección natural y la evolución para crear nuevos modelos de IA. Este enfoque, que se aleja radicalmente de los métodos de construcción tradicionales y de fuerza bruta de los gigantes tecnológicos, no solo ha demostrado ser órdenes de magnitud más eficiente en términos de costos y recursos, sino que también ha sido capaz de descubrir soluciones algorítmicas novedosas que los expertos humanos no habían concebido. La compañía ha liberado su sistema como una plataforma de código abierto, abriendo la puerta a una nueva era de desarrollo de IA más democrática, sostenible y creativamente impredecible, donde la inteligencia no se diseña meticulosamente, sino que se cultiva, se cría y se descubre.

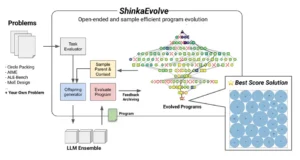

La compañía en cuestión, Sakana AI, ha bautizado su sistema con el término japonés Shinka (進化), que significa evolución. Su marco de trabajo, ShinkaEvolve, representa un cambio filosófico fundamental: pasar de ver la creación de IA como un proceso de ingeniería a verla como un proceso de jardinería. Mientras que el ingeniero diseña un artefacto complejo con un plan preestablecido, ensamblando cada componente con una precisión meticulosa, el jardinero cultiva un ecosistema donde las soluciones más aptas emergen de forma natural, a menudo de maneras inesperadas y maravillosas. En lugar de construir un único y masivo modelo desde cero, este método comienza con una población de modelos más pequeños y especializados ya existentes. A través de un proceso de «cría digital» que combina y modifica a estos «padres» mediante técnicas como la fusión de modelos y la mutación guiada por IA, el sistema genera «descendientes» que son puestos a prueba. Solo los más aptos sobreviven para reproducirse, en un ciclo de mejora continua que no solo refina las habilidades existentes, sino que tiene el potencial de descubrir capacidades completamente nuevas. Este artículo explorará en profundidad la elegante biología de este nuevo enfoque, analizará los sorprendentes resultados que ya ha producido y reflexionará sobre las inmensas implicaciones de un futuro donde las máquinas no solo aprenden, sino que evolucionan.

La catedral de silicio y sus grietas

El mantra que ha definido la última media década de investigación en inteligencia artificial fue resumido de manera sucinta y poderosa en un ensayo ya legendario: «la escala es todo lo que necesitas». Esta idea, la hipótesis de que la mayoría de los avances en la capacidad de la IA no provendrían de nuevos algoritmos ingeniosos, sino del simple y masivo escalamiento de los modelos, los datos y el poder de cómputo, se convirtió en la fuerza motriz de la industria. Demostró ser espectacularmente correcta, al menos al principio. Al expandir las redes neuronales a cientos de miles de millones, o incluso billones, de parámetros y alimentarlas con porciones cada vez mayores de la internet, surgieron de manera emergente habilidades que nadie había programado explícitamente: la capacidad de traducir idiomas, de escribir código, de razonar sobre problemas complejos y de mantener conversaciones coherentes. Los laboratorios de IA se convirtieron en constructores de catedrales de silicio, compitiendo por erigir la estructura más grande y grandiosa. Pero toda catedral, por imponente que sea, tiene un punto en el que su propio peso pone a prueba la integridad de sus cimientos. La era de la fuerza bruta, a pesar de sus triunfos, ha comenzado a mostrar sus propias y profundas grietas estructurales.

La primera y más visible de estas fisuras es el muro energético y económico. La ley de Moore, que durante décadas nos proporcionó un crecimiento exponencial en la eficiencia computacional a un costo constante, ha llegado a su fin. Hoy en día, aumentar la potencia de un modelo en un orden de magnitud requiere una inversión de recursos casi equivalente. El entrenamiento de un sistema como GPT-4 se estima en cientos de millones de dólares, con un consumo energético que rivaliza con el de una ciudad pequeña durante meses. Proyectar esta tendencia hacia el futuro revela un camino insostenible. El costo de entrenar a un hipotético GPT-5 o GPT-6 bajo el mismo paradigma podría escalar a miles de millones, un precio que solo un puñado de naciones o corporaciones en el mundo podrían permitirse, creando un futuro de centralización tecnológica extrema. La inteligencia artificial, bajo este modelo, amenaza con convertirse en un lujo energético y económico que el planeta difícilmente puede sostener.

La segunda grieta reside en la propia materia prima: los datos. La hipótesis de la escala asumía un océano infinito de datos de alta calidad en la internet, listos para ser consumidos. La realidad es que ya estamos llegando a los límites de ese océano. Los investigadores predicen que para finales de esta década, habremos agotado todo el texto de alta calidad disponible en la web para el entrenamiento de nuevos modelos. Lo que queda es un vasto mar de contenido de menor calidad, a menudo tóxico, sesgado o simplemente incorrecto. Además, a medida que la propia IA genera más y más contenido en la red, los futuros modelos corren el riesgo de entrenarse con los resultados de sus predecesores, un fenómeno conocido como «colapso del modelo», que puede llevar a una espiral degenerativa de la calidad. La idea de que simplemente «añadir más datos» seguirá produciendo mejores resultados se enfrenta a un problema de escasez y de pureza.

Finalmente, la grieta más sutil pero quizás la más importante es un posible estancamiento en la innovación conceptual. Al centrar todos los recursos y el talento en el desafío de la escala, la industria ha explorado menos activamente nuevas arquitecturas neuronales o paradigmas de aprendizaje fundamentalmente diferentes. Los avances se han vuelto más predecibles, consistiendo a menudo en versiones más grandes de las mismas ideas. Es una estrategia que perfecciona lo conocido a expensas de descubrir lo nuevo. Además, estos modelos monolíticos y generalistas, aunque impresionantes, son a menudo ineficientes y torpes para tareas específicas. Utilizar un modelo de un billón de parámetros para traducir un correo electrónico es el equivalente a usar una supercomputadora para operar una calculadora de bolsillo. Esta falta de especialización y agilidad es el problema final que la fuerza bruta por sí sola no puede resolver, y es la oportunidad que el enfoque evolutivo busca explotar.

Génesis biológica: tomando prestados 3.8 mil millones de años de I+D

Frente a las grietas que emergen en el paradigma de la fuerza bruta, el enfoque propuesto por el laboratorio de Tokio no es una simple mejora incremental, sino un salto a un plano de inspiración completamente diferente. En lugar de buscar la solución en la ingeniería de microchips o en la expansión de centros de datos, la buscaron en el libro de jugadas más exitoso, probado y creativo que existe: el de la biología. La evolución, a través de la selección natural, es el algoritmo de optimización y descubrimiento más poderoso que conocemos. Durante más de tres mil ochocientos millones de años, sin un diseñador central y a través de un proceso de experimentación paralela masiva, ha generado una diversidad y complejidad de soluciones, desde la fotosíntesis hasta la conciencia, que superan con creces cualquier cosa que la ingeniería humana haya podido concebir. La idea de tomar prestados estos principios no es nueva en la informática, pero su aplicación exitosa a la creación de modelos de lenguaje de vanguardia había sido, hasta ahora, un desafío insuperable.

El éxito de la metodología evolutiva se basa en la elegante interacción de tres principios fundamentales, pilares que sustentan toda la diversidad de la vida en la Tierra y que ahora son replicados en el silicio. El primero es la herencia, el mecanismo por el cual los rasgos de los progenitores se transmiten a su descendencia. La herencia asegura que las características exitosas, aquellas que han permitido a un organismo sobrevivir y prosperar, no se pierdan, sino que se conserven y se propaguen a través de las generaciones, sirviendo como base para futuras mejoras. Sin herencia, cada generación tendría que empezar desde cero, y el aprendizaje acumulativo sería imposible.

El segundo principio es la variación. La herencia por sí sola solo produce copias; la variación es el motor de la novedad. En la biología, esta variación surge de dos fuentes principales: la mutación, que son pequeños errores aleatorios en la copia del material genético, y la recombinación, que es la mezcla del material genético de dos padres para crear una combinación única en el descendiente. La variación es la que genera la diversidad de opciones, el abanico de nuevas posibilidades sobre el cual la selección puede actuar. Sin variación, la evolución se estancaría, incapaz de adaptarse a nuevos desafíos o de descubrir soluciones más eficientes.

El tercer y último pilar es la selección. La herencia y la variación producen una multitud de organismos con rasgos diversos, pero es la selección la que determina cuáles de esos rasgos perdurarán. En la naturaleza, el árbitro es el entorno. Los organismos con rasgos que los hacen más aptos para sobrevivir y reproducirse en su nicho ecológico particular tienen más probabilidades de transmitir esos rasgos a la siguiente generación. Este proceso, repetido a lo largo de eones, es lo que guía a las especies hacia una mayor complejidad y adaptación. La selección es la fuerza direccional, el escultor ciego que, a partir del bloque de mármol de la variación, da forma a la asombrosa complejidad de la vida. El genio del nuevo marco de trabajo reside en cómo traduce cada uno de estos principios biológicos en una operación computacional precisa y, crucialmente, cómo utiliza a la propia IA para catalizar y acelerar cada paso de este ciclo creativo.

El sistema traduce la herencia y la recombinación a través de una técnica conocida como «fusión de modelos». Este proceso es análogo a la cría selectiva, pero aplicado a las redes neuronales. En lugar de promediar simplemente las capacidades de dos modelos «padres», la fusión opera a un nivel mucho más profundo, combinando directamente los «pesos» de sus redes neuronales, que son los millones de parámetros numéricos que encapsulan su conocimiento. Es un procedimiento quirúrgico digital que permite crear un modelo «híbrido» que hereda características específicas de sus progenitores. Por ejemplo, se podría tomar un modelo con una comprensión gramatical y estilística excepcional y fusionarlo con otro que posea un razonamiento lógico matemático superior. El resultado no es un compromiso, sino un descendiente que, idealmente, puede razonar con la lógica del matemático y expresar sus conclusiones con la elocuencia del poeta. Esta capacidad de recombinar habilidades preexistentes es la clave de la eficiencia del sistema, ya que construye sobre el vasto conocimiento ya codificado en los modelos de código abierto, en lugar de intentar aprenderlo todo desde la nada.

La variación, por su parte, es introducida a través de una de las innovaciones más brillantes del sistema: la mutación guiada por LLM. La mutación puramente aleatoria, aunque funcional en la biología a lo largo de millones de años, es computacionalmente ineficiente. La probabilidad de que un cambio al azar en la arquitectura de un modelo produzca una mejora es minúscula. Para superar esto, este enfoque utiliza un modelo de lenguaje avanzado y externo como un «biólogo evolutivo» o un «estratega de mutación». Este modelo supervisor analiza la arquitectura y el rendimiento de los modelos padres y propone cambios inteligentes y de alta probabilidad de éxito para el descendiente. Podría sugerir, por ejemplo, «aumentar la capacidad de atención en esta capa específica para mejorar el manejo de contextos largos» o «introducir un nuevo tipo de neurona optimizada para el razonamiento simbólico». Es una forma de variación dirigida que acelera drásticamente el proceso evolutivo, sustituyendo el azar ciego por una exploración guiada e inteligente.

Finalmente, el principio de selección se implementa a través de evaluadores automáticos y «funciones de aptitud». Una función de aptitud es simplemente la definición del éxito, el criterio que el entorno digital utilizará para juzgar a cada nuevo modelo descendiente. Si el objetivo es crear una IA que sea una excelente programadora, la función de aptitud podría ser su puntuación en un benchmark de codificación como HumanEval. Los modelos que obtienen las puntuaciones más altas son considerados los más «aptos» y son seleccionados para convertirse en los padres de la siguiente generación. El diseño de estas funciones de aptitud es un arte en sí mismo, ya que una definición de éxito mal concebida puede guiar a la evolución por caminos indeseados. Este ciclo completo, desde la selección de padres hasta la evaluación de la descendencia, se repite de forma autónoma, generación tras generación, permitiendo que la población de modelos mejore y se adapte exponencialmente, descubriendo en el proceso combinaciones de habilidades y arquitecturas que ningún diseñador humano habría anticipado.

De la teoría a la supremacía en la resolución de problemas

Una teoría, por elegante que sea, debe ser validada en la arena de la práctica. Para demostrar el poder de su enfoque evolutivo, el equipo investigador no se limitó a describir su sistema, sino que lo puso a prueba en una serie de desafíos formidables, una especie de «Olimpiada de la IA» donde sus modelos evolucionados compitieron contra soluciones creadas por los métodos más avanzados y la propia pericia humana. Los resultados, detallados en su informe, no solo validan su enfoque, sino que en algunos casos, redefinen lo que se creía posible, demostrando que la evolución digital no solo es más eficiente, sino también más creativa.

Uno de los ejemplos más claros y visuales es el problema del «empaquetamiento de círculos», un clásico desafío de optimización matemática. El objetivo es encontrar la forma más eficiente de colocar un número determinado de círculos idénticos dentro de una forma más grande, como un cuadrado o un círculo, sin que se superpongan, de manera que ocupen el menor espacio posible. Aunque suena simple, este problema tiene aplicaciones en campos tan diversos como la logística, el diseño de materiales y las telecomunicaciones, y se vuelve exponencialmente más difícil a medida que aumenta el número de círculos. El equipo utilizó su sistema para evolucionar un programa de software que resolviera este problema. Comenzaron con una población de algoritmos de optimización conocidos y dejaron que el sistema los combinara y mutara a lo largo de varias generaciones, utilizando como función de aptitud la eficiencia con la que cada programa descendiente lograba empaquetar los círculos.

El resultado fue asombroso. El programa evolucionado no solo encontró soluciones que eran un 1% mejores que las mejores soluciones conocidas previamente, descubiertas tras décadas de investigación por matemáticos humanos, sino que para llegar a ellas descubrió una nueva heurística. Una heurística es, en esencia, una regla general o un atajo mental que guía la resolución de problemas. El sistema evolucionado, a través de su proceso de prueba y error a gran escala, descubrió una nueva «estrategia» para colocar los círculos que los expertos humanos no habían considerado. Y lo más importante, lo hizo con una eficiencia de muestreo órdenes de magnitud superior a la de otros enfoques evolutivos, necesitando muchas menos iteraciones para llegar a una solución de vanguardia. Fue una demostración contundente de que este método no solo optimiza, sino que también innova, generando conocimiento matemático genuinamente nuevo.

Otro campo de pruebas fue el de los «agentes de IA», sistemas diseñados para realizar tareas complejas en un entorno digital, como resolver problemas matemáticos de alta competición (las tareas AIME). En este dominio, la IA no solo necesita conocimiento, sino también la capacidad de planificar, de utilizar herramientas (como una calculadora simbólica) y de corregir sus propios errores. De nuevo, el equipo investigador crió una población de agentes. Un agente padre podría ser bueno en la planificación lógica, mientras que otro podría ser un experto en el uso de una herramienta de cálculo. A través de la fusión y la mutación, el sistema evolucionó un agente descendiente que heredó la capacidad de planificación del primero y la destreza con las herramientas del segundo. El resultado fue un agente especialista que superó a ambos progenitores en la resolución de problemas complejos, demostrando que el sistema podía criar IAs con un conjunto de habilidades sinérgicas. Estos éxitos demuestran dos de las promesas fundamentales del enfoque: la eficiencia, al reutilizar conocimiento preexistente, y la capacidad para la innovación genuina. El sistema no se limita a optimizar los caminos conocidos, sino que, a través de la recombinación y la mutación, puede descubrir soluciones y estrategias completamente nuevas.

La segunda génesis de la inteligencia

La aparición de metodologías como las que impulsa el laboratorio de Tokio marca un momento de profunda reflexión en el campo de la inteligencia artificial. Nos encontramos en un punto de inflexión, donde la fuerza bruta del cómputo y los datos masivos, aunque todavía dominante, comienza a mostrar sus límites. El camino hacia una inteligencia más avanzada, más eficiente y, sobre todo, más creativa, podría no residir en la construcción de fábricas de gigantes cada vez más grandes, sino en el cultivo de ecosistemas digitales donde la inteligencia pueda evolucionar. Este trabajo es una de las exploraciones más audaces y prometedoras de este nuevo paradigma.

Las implicaciones de este cambio son inmensas. A nivel tecnológico y económico, la evolución de modelos ofrece una ruta hacia la democratización de la IA de vanguardia. Abre la puerta a que equipos más pequeños y con menos recursos puedan crear modelos altamente especializados y competitivos, fomentando un ecosistema de IA más diverso y resiliente. Reduce drásticamente los costos energéticos y computacionales, abordando una de las críticas más serias al modelo de desarrollo actual y allanando el camino hacia una IA más sostenible.

A un nivel más profundo, este enfoque nos obliga a reconsiderar la naturaleza misma de la creación y el descubrimiento. El método del ingeniero, con su énfasis en el diseño y el control, nos ha traído hasta aquí. Pero el método del jardinero, el del evolutivo, con su aceptación de la emergencia, la serendipia y el descubrimiento abierto, podría ser el que nos lleve al siguiente nivel. Podríamos estar en la cúspide de una era en la que no solo construimos máquinas inteligentes, sino que creamos las condiciones para que la inteligencia, en formas que ni siquiera podemos prever, florezca. El legado de este trabajo podría no ser solo una nueva generación de modelos de lenguaje más potentes, sino una segunda génesis, el momento en que aprendimos a dejar de construir nuestras mentes digitales y, en su lugar, les dimos la libertad de evolucionar por sí mismas.

Características sobresalientes de ShinkaEvolve

- Enfoque Evolutivo: En lugar de diseñar un único modelo masivo, el sistema «cría» nuevas generaciones de IAs a partir de una población de modelos existentes, aplicando principios de selección y mutación inspirados en la naturaleza.

- Eficiencia de Recursos: Es órdenes de magnitud más eficiente en términos de cómputo y tiempo que el entrenamiento de modelos de lenguaje desde cero, al aprovechar y combinar el conocimiento de modelos ya entrenados.

- Fusión de Modelos Inteligente: Utiliza la técnica de «fusión de modelos» como un análogo a la reproducción, combinando las fortalezas de diferentes IAs «padres» para crear «descendientes» con capacidades mejoradas o novedosas.

- Mutación Guiada por LLM: Emplea a los propios modelos de lenguaje avanzados para proponer cambios y modificaciones inteligentes en la arquitectura de los nuevos modelos, actuando como un motor de «mutación» dirigido en lugar de aleatorio.

- Código Abierto: El marco de trabajo ha sido liberado bajo una licencia de código abierto (Apache 2.0), lo que permite a la comunidad global de investigadores y desarrolladores utilizarlo, modificarlo y construir sobre él, fomentando la democratización de la tecnología.

- Descubrimiento de Novedad: Ha demostrado ser capaz no solo de optimizar soluciones existentes, sino de descubrir nuevas estrategias y algoritmos (heurísticas) que no habían sido concebidos previamente por expertos humanos.

Fuentes

Sakana AI. (2025). ShinkaEvolve: Evolving New Algorithms with LLMs, Orders of Magnitude More Efficiently.

Laon, M. (2025). Mastering LLM Fine-Tuning and Model Merging: A Comprehensive Guide.

Feng, Y., et al. (2025). EvoPrompt: Connecting Large Language Models with Evolutionary Algorithms Yields Powerful Prompt Optimizers.

Sakana AI. (2024). The AI Scientist: Towards Fully Automated Open-Ended Scientific Discovery.

Robert Tjarko Lange, et al. (2025) ShinkaEvolve: Towards Open-Ended And Sample-Efficient Program Evolution. arxiv.org/pdf/2509.19349