En el vertiginoso y a menudo amurallado jardín de la inteligencia artificial de vanguardia, donde gigantes como OpenAI, Google y Anthropic cultivan sus modelos propietarios con celo, acaba de desatarse una tormenta. No llegó con el estruendo de un anuncio multimillonario en Silicon Valley, sino desde el este, con la fuerza tranquila de una innovación radical. La compañía Z.ai, anteriormente conocida como Zhipu AI, ha liberado GLM-4.5, un modelo de lenguaje que no es simplemente otra iteración en la carrera armamentística de la IA, sino un desafío directo al status quo. Al combinar un rendimiento de élite, una arquitectura novedosa y un compromiso inquebrantable con la filosofía del código abierto, GLM-4.5 se ha convertido en el catalizador de una conversación global sobre el futuro, la accesibilidad y la economía misma de la inteligencia artificial.

Este no es solo el lanzamiento de un nuevo software; es la materialización de una promesa. La promesa de que el poder computacional más avanzado del planeta no tiene por qué estar confinado a las arcas de unas pocas corporaciones. La promesa de que los desarrolladores, investigadores y empresas de todo el mundo pueden tener acceso sin restricciones a una tecnología capaz de razonar, planificar y ejecutar tareas complejas con una sofisticación que, hasta ahora, parecía reservada para los sistemas más caros y cerrados. Acompañado de una versión más ligera y eficiente, GLM-4.5-Air, este lanzamiento ha provocado una onda expansiva en la comunidad tecnológica, con reacciones que van desde el asombro técnico hasta la euforia por sus implicaciones económicas. Se habla de un rendimiento que compite cara a cara con los mejores modelos del mundo, pero con un coste operativo que es una mera fracción del de sus rivales.

Para comprender la magnitud de este acontecimiento, es necesario sumergirse en las profundidades de su tecnología, explorar el ecosistema del que emerge y analizar las consecuencias de su irrupción. Este artículo se adentra en la historia de Z.ai, la compañía que ha orquestado este golpe de timón; desglosa la innovadora arquitectura de «agente híbrido» que dota a GLM-4.5 de sus extraordinarias capacidades; examina con lupa los resultados de los benchmarks que lo coronan como el rey del código abierto; y explora la revolución que sus licencias permisivas suponen para la innovación global. Estamos ante un punto de inflexión, un momento en que la balanza de poder en el universo de la IA podría estar inclinándose de manera decisiva. Esta es la historia de cómo una tormenta perfecta de ingeniería, estrategia y filosofía abierta está redibujando el mapa de nuestro futuro digital.

El ascenso de un titán: la trayectoria de Z.ai

Para muchos en Occidente, el nombre Z.ai o Zhipu AI surgió casi de la noche a la mañana con el lanzamiento de GLM-4.5. Sin embargo, la compañía es todo menos un actor nuevo. Sus raíces se hunden profundamente en el prestigioso entorno académico de la Universidad de Tsinghua en Pekín. Fundada en 2019 por expertos del Grupo de Ingeniería del Conocimiento (KEG) de la universidad, Zhipu AI nació con un ADN académico y una ambición comercial formidable. Desde su concepción, su trayectoria ha sido una de crecimiento meteórico, impulsada por una visión clara y una capacidad asombrosa para atraer capital.

La empresa ha recaudado importantes sumas a través de múltiples rondas de financiación, atrayendo a un verdadero quién es quién de la inversión tecnológica china y global. Ha recibido más de 1.4 mil millones de dólares de fondos estatales chinos y 400 millones adicionales de inversores de Arabia Saudita. Gigantes como Alibaba, Tencent, Ant Group, Meituan y Xiaomi han apostado fuerte por la visión de Z.ai. Esta inyección masiva de capital no solo valida su enfoque tecnológico, sino que también le proporciona los recursos necesarios para competir en un campo donde el coste computacional es una barrera de entrada formidable. Con una valoración que ha superado los 20 mil millones de dólares, Z.ai se ha consolidado como uno de los «Tigres de la IA» de China, un actor destinado a jugar en la liga de los pesos pesados globales.

Desde sus inicios, Z.ai ha centrado sus esfuerzos en el desarrollo de modelos de lenguaje grandes, con un enfoque particular en la bilingüidad (chino e inglés) y, más recientemente, en la multimodalidad y la inteligencia artificial general (AGI). Su serie de modelos GLM (General Language Model) ha evolucionado rápidamente, ganando reconocimiento por su rendimiento y su progresiva apertura. Antes de GLM-4.5, la compañía ya había captado la atención con lanzamientos como ChatGLM, una serie de modelos de diálogo de código abierto, y «Ying», un impresionante modelo de texto a vídeo, demostrando su capacidad para innovar en múltiples frentes del campo generativo. Los modelos de código abierto de Zhipu, como ChatGLM, se han descargado más de 30 millones de veces en todo el mundo.

La filosofía de la compañía se centra en la consecución de una AGI capaz de autoexplicarse, autoevaluarse y autosupervisarse. Este ambicioso objetivo es lo que impulsa el desarrollo de arquitecturas cada vez más sofisticadas, que van más allá de la simple predicción de la siguiente palabra para adentrarse en el terreno del razonamiento y la planificación autónoma. El lanzamiento de GLM-4.5 no es, por tanto, un hecho aislado, sino la culminación de años de investigación focalizada y desarrollo estratégico, un paso decisivo en su hoja de ruta hacia una inteligencia artificial más general y capaz. Su origen académico, combinado con un músculo financiero de primer nivel, le ha permitido crear un ecosistema de innovación que ahora desafía abiertamente el liderazgo establecido en el sector.

Deconstruyendo a la bestia: la arquitectura de agente híbrido de GLM-4.5

Lo que realmente distingue a GLM-4.5 de sus contemporáneos no es solo su rendimiento, sino el «cómo» lo consigue. En el corazón del modelo late una arquitectura innovadora descrita como un «agente híbrido» o un sistema de «razonamiento híbrido». Este no es un mero término de marketing; representa un cambio fundamental en la forma en que el modelo procesa la información y aborda los problemas.

Tradicionalmente, los modelos de lenguaje operan en un único modo: reciben una entrada (prompt) y generan una salida (respuesta) de la manera más rápida y coherente posible. GLM-4.5, en cambio, opera con un enfoque dual. Posee dos modos de funcionamiento distintos que pueden ser controlados por el usuario: un modo de «acción» o «no pensamiento» para respuestas rápidas y un modo de «pensamiento» para razonamiento profundo.

El modo de acción (disabled) está optimizado para la eficiencia y la inmediatez. Se encarga de las tareas sencillas y las respuestas directas, aquellas que no requieren una planificación compleja. Es el equivalente a una respuesta instintiva y rápida, ideal para conversaciones fluidas o consultas informativas simples.

El modo de pensamiento (enabled), por otro lado, es donde reside la verdadera magia. Cuando el modelo se enfrenta a una tarea compleja que requiere múltiples pasos, planificación estratégica o el uso de herramientas externas, activa este modo. En lugar de generar una respuesta directa, el modelo se embarca en un proceso interno de «cadena de pensamiento» (Chain-of-Thought), descomponiendo el problema en sub-tareas, formulando un plan y ejecutándolo paso a paso. Esta capacidad es lo que le confiere sus habilidades «agénticas», transformándolo de un simple generador de texto a un solucionador de problemas autónomo. Es esta arquitectura híbrida la que le permite, por ejemplo, recibir la instrucción «crea un sitio web para mi cafetería» y proceder a planificar la estructura, escribir el código HTML/CSS, generar el contenido de texto e incluso diseñar imágenes relevantes.

Técnicamente, este rendimiento se sustenta en una arquitectura de Mezcla de Expertos (Mixture-of-Experts o MoE), una técnica que se ha vuelto cada vez más popular para construir modelos masivos de manera eficiente. En lugar de que un único y monolítico bloque de redes neuronales procese cada solicitud, un modelo MoE se compone de múltiples «expertos» (redes neuronales más pequeñas y especializadas) y un «enrutador» que decide qué experto o combinación de expertos es el más adecuado para manejar una tarea determinada.

Esto explica la distinción entre «parámetros totales» y «parámetros activos». GLM-4.5 tiene un total de 355 mil millones de parámetros, lo que lo sitúa en la categoría de los modelos más grandes del mundo. Sin embargo, para cualquier tarea dada, solo activa unos 32 mil millones de esos parámetros. De manera similar, GLM-4.5-Air tiene 106 mil millones de parámetros totales y solo 12 mil millones de activos. Esta eficiencia es revolucionaria. Permite al modelo poseer el vasto conocimiento y la capacidad de un modelo de 355B, pero con los requisitos computacionales (y por tanto, el coste y la velocidad de inferencia) de un modelo mucho más pequeño. Es, en esencia, tener lo mejor de ambos mundos: la sabiduría de un gigante y la agilidad de un atleta.

Para completar su perfil técnico, tanto GLM-4.5 como su versión Air cuentan con una ventana de contexto de 128,000 tokens. Esto significa que pueden procesar y mantener la coherencia sobre cantidades masivas de información en una sola interacción, equivalente a cientos de páginas de texto. Esta capacidad es crucial para tareas complejas como el análisis de documentos largos, la depuración de bases de código extensas o el mantenimiento de conversaciones prolongadas y detalladas. La combinación de una arquitectura de agente híbrido, un diseño MoE eficiente y una vasta ventana de contexto es la fórmula que impulsa a GLM-4.5 a la cima de la pirámide de la inteligencia artificial.

El veredicto de los benchmarks: un nuevo rey del código abierto

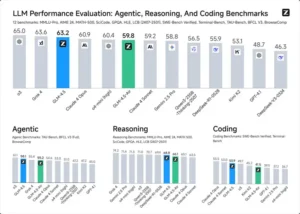

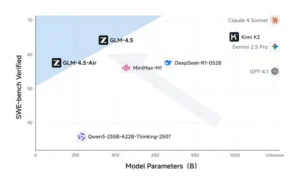

En el mundo de la IA, las afirmaciones audaces deben ser respaldadas por datos fríos y duros. Z.ai ha sometido a GLM-4.5 a una batería de los benchmarks más reconocidos de la industria, y los resultados no solo son impresionantes, sino que reordenan el ranking de los modelos más potentes. Al evaluar de manera integral 12 benchmarks representativos (incluyendo MMLU Pro, AIME24, MATH500, SciCode, entre otros), GLM-4.5 obtuvo una puntuación que lo posiciona en el tercer lugar a nivel mundial, y como el número uno entre todos los modelos de código abierto.

Lo que es aún más significativo es su dominio absoluto en el ámbito del código abierto, donde se corona como el líder indiscutible. Su versión más ligera, GLM-4.5-Air, no se queda atrás, clasificándose en un notable sexto lugar general según los datos de la compañía.

Pero, ¿dónde brilla exactamente GLM-4.5? Los resultados detallados revelan una maestría particular en las áreas que definen a la nueva generación de IA agéntica:

- Codificación y desarrollo de software: Este es, quizás, su punto más fuerte. En benchmarks de codificación, ha demostrado ser superior a otros modelos de código abierto como Qwen3 Coder. El modelo puede generar aplicaciones web completas, incluyendo la interfaz, la gestión de bases de datos y el despliegue del servidor.

- Uso de herramientas y tareas agénticas: La capacidad de interactuar con herramientas externas (APIs, bases de datos, etc.) es fundamental para los agentes de IA. En esta área, GLM-4.5 ha demostrado un rendimiento que iguala al de Claude 4 Sonnet en benchmarks como tau-bench. En el benchmark BrowseComp, que evalúa la navegación web autónoma, logra un 26.4% de precisión, superando a Claude-4-Opus (18.8%). En la comunidad, los desarrolladores han reportado que es «sorprendentemente bueno» en el uso de herramientas, incluso ejecutando código diseñado para Claude sin fallos.

- Razonamiento y matemáticas: Los problemas que requieren un razonamiento lógico de varios pasos y habilidades matemáticas siguen siendo una de las fronteras más difíciles para los LLMs. En su modo «thinking», GLM-4.5 resuelve problemas complejos con gran acierto, alcanzando un 91.0% en AIME24 y un impresionante 98.2% en MATH500.

- Capacidades multimodales: Aunque el modelo base es de lenguaje, Z.ai también ha lanzado GLM-4.5V, una versión multimodal que extiende estas capacidades al dominio visual. Este modelo puede analizar imágenes, vídeos y documentos complejos. Puede, por ejemplo, interpretar la lógica de una captura de pantalla de una página web y generar el código para replicarla, o analizar un vídeo largo para extraer eventos, personajes y relaciones lógicas. Ha demostrado un rendimiento de vanguardia en 42 benchmarks multimodales públicos y puede incluso identificar problemas de accesibilidad en diseños de interfaces con gran precisión.

La reacción de la comunidad de desarrolladores y expertos ha sido de entusiasmo ante estos resultados, validando las cifras de Z.ai con sus propias pruebas informales. Es esta combinación de rendimiento de élite, especialmente en tareas agénticas y de codificación, con una eficiencia económica sin precedentes, lo que constituye la verdadera propuesta de valor de GLM-4.5 y lo que está causando tanta agitación en el mercado.

La revolución del código abierto: más allá del rendimiento

Si el rendimiento de GLM-4.5 es el motor de la revolución, su licencia de código abierto es el combustible que la propaga. Z.ai ha tomado la decisión estratégica de lanzar sus modelos bajo las licencias MIT y Apache 2.0, dos de las licencias más permisivas y respetadas en el mundo del software. Esta elección no es un detalle menor; es una declaración de principios con implicaciones profundas para todo el ecosistema de la IA.

A diferencia de los modelos propietarios, que solo pueden ser utilizados a través de APIs controladas por la empresa creadora, las licencias MIT y Apache 2.0 otorgan a los usuarios una libertad casi total:

- Uso comercial sin restricciones: Cualquier desarrollador, startup o gran empresa puede utilizar GLM-4.5 en sus productos y servicios comerciales sin tener que pagar royalties ni pedir permiso. Esto elimina una de las mayores barreras de entrada para la creación de aplicaciones de IA avanzadas.

- Modificación y personalización (Fine-Tuning): Las empresas pueden tomar el modelo base y entrenarlo con sus propios datos para especializarlo en tareas específicas de su dominio. Esto permite crear soluciones a medida con un nivel de rendimiento y especificidad que es imposible de alcanzar con una API genérica.

- Redistribución y autoalojamiento (Self-Hosting): Los usuarios pueden alojar el modelo en su propia infraestructura, ya sea en la nube o en servidores locales. Esto proporciona un control total sobre la seguridad, la privacidad de los datos y la latencia, un factor crucial para muchas aplicaciones empresariales.

- Transparencia e investigación: La disponibilidad de los pesos del modelo permite a la comunidad académica y de investigación analizar su funcionamiento interno, identificar sesgos, desarrollar nuevas técnicas y, en general, avanzar el conocimiento colectivo en el campo de la IA.

Este enfoque contrasta radicalmente con el modelo de «jardín vallado» de los principales laboratorios de IA. Al liberar una herramienta de este calibre, Z.ai no solo está compartiendo un producto, sino que está fomentando una plataforma sobre la cual puede florecer un ecosistema global de innovación. Para los desarrolladores, esto significa la capacidad de construir la próxima generación de agentes de IA sin depender de una API que puede cambiar de precio o de políticas de la noche a la mañana. Para las empresas, representa la oportunidad de integrar la IA en el núcleo de sus operaciones de una manera segura y personalizada.

La comunidad ha recibido esta apertura con los brazos abiertos. Las discusiones en foros como Reddit y plataformas como GitHub están repletas de desarrolladores que ya están experimentando con el modelo, ejecutándolo localmente en hardware de consumo (con cuantización) y probándolo en una variedad de tareas de codificación y automatización. El hecho de que Z.ai también haya asegurado la compatibilidad con herramientas populares como vLLM y SGLang, y que su API siga la misma estructura que la de OpenAI, reduce aún más la fricción para su adopción.

En esencia, la decisión de Z.ai de optar por el código abierto radical es un movimiento estratégico que podría acelerar la innovación a un ritmo que los modelos cerrados simplemente no pueden igualar. Al poner el poder de un modelo de frontera en manos de una comunidad global, están apostando por la creatividad colectiva como el motor definitivo del progreso en la inteligencia artificial.

Impacto y conclusión: el tablero de juego ha cambiado

El lanzamiento de GLM-4.5 no es un evento aislado; es el punto culminante de una tendencia creciente que está reconfigurando el panorama de la inteligencia artificial. El impacto de su llegada se siente en múltiples dimensiones: económica, tecnológica y estratégica.

Desde el punto de vista económico, la disrupción es brutal. Uno de los aspectos más comentados es el coste operacional, considerablemente menor que el de competidores directos como DeepSeek. Los precios de su API son extremadamente bajos: la versión Air tiene un coste de 0.8 yuanes por millón de tokens de entrada y 2 yuanes por millón de salida. El modelo más potente, aunque más caro, sigue siendo muy accesible, con un coste aproximado de 0.20 dólares por millón de tokens de entrada y 1.10 por millón de salida en plataformas de terceros. Esta agresiva estrategia de precios hace que el desarrollo de aplicaciones de IA avanzadas sea mucho más asequible, democratizando el acceso y fomentando una nueva ola de innovación.

Tecnológicamente, GLM-4.5 establece un nuevo estándar para los modelos de código abierto. Demuestra que la comunidad abierta no solo puede seguir el ritmo de los laboratorios propietarios, sino que en ciertas áreas, como la codificación agéntica, puede incluso superarlos. Su arquitectura de razonamiento híbrido ofrece un nuevo paradigma para la construcción de agentes de IA, y es probable que inspire nuevas líneas de investigación y desarrollo en todo el campo.

Estratégicamente, la jugada de Z.ai es una clase magistral. Al combinar la excelencia técnica con la apertura radical del código abierto, está posicionándose no solo como un proveedor de tecnología, sino como el catalizador de un nuevo ecosistema. Mientras que los modelos cerrados crean dependencia, los modelos abiertos crean comunidades. Al nutrir a esta comunidad global, Z.ai podría asegurarse un lugar central en el futuro de la IA, un futuro que no será dictado por un puñado de empresas, sino co-creado por millones de desarrolladores en todo el mundo.

En conclusión, GLM-4.5 es mucho más que un nuevo modelo de lenguaje. Es una tormenta perfecta que combina el poder del razonamiento agéntico, la eficiencia de la arquitectura MoE y la filosofía liberadora del código abierto. Ha demostrado que es posible alcanzar un rendimiento de vanguardia sin sacrificar la accesibilidad ni la asequibilidad. Para los desarrolladores, es una invitación a construir el futuro sin ataduras. Para el mercado, es un correctivo necesario que desafía los modelos de negocio existentes. Y para el mundo, es un recordatorio contundente de que el futuro de la inteligencia artificial, en su forma más potente y prometedora, puede y debe ser abierto. El tablero de juego ha cambiado, y las reglas nunca volverán a ser las mismas.

Referencias

[1] China’s Zhipu AI claims new GLM-4.5 model beats Claude 3 Sonnet (2024) CNBCTV18. Disponible en: https://www.cnbctv18.com/technology/chinas-zhipu-ai-claims-new-glm-4-5-model-beats-claude-3-sonnet-19597148.htm

[2] Zhipu AI Unveils GLM-4.5: The New Open-Source LLM King? (2024) Zhipu AI. Disponible en: https://www.zhipuai.cn/media/company-news/669f7c02e1c936611352e821

[3] New open source agent model GLM-4.5 claims to beat Claude 3 sonnet and has hybrid reasoning (2024) Reddit r/LocalLLaMA. Disponible en: https://www.reddit.com/r/LocalLLaMA/comments/1eb5t7n/new_open_source_agent_model_glm45_claims_to_beat/

[4] GLM-4.5 RELEASED (2024) Superintelligence. Disponible en: https://getsuperintel.com/p/glm-4-5-released

[5] Hansen, K. (2024) Z.ai’s GLM-4.5: The New Open-Source LLM King, Making Other AI Subscriptions Obsolete? LinkedIn. Disponible en: https://www.linkedin.com/pulse/zais-glm-45-new-open-source-llm-king-making-other-ai-kyle-h-hansen-nbgwc

[6] Building a Custom AI Agent with Zhipu GLM-4, Python, and Timescale Vector (2024) Timescale. Disponible en: https://www.timescale.com/blog/building-a-custom-ai-agent-with-zhipu-glm-4-python-and-timescale-vector/